Intégration Deepseek R1 MCP

Intégrez FlowHunt avec le serveur Deepseek R1 MCP pour débloquer des capacités avancées de modèles de langage, un raisonnement sur de grands contextes et des wo...

Intégrez les modèles DeepSeek optimisés pour le raisonnement et les contextes étendus à vos workflows IA grâce au Serveur MCP Deepseek R1 pour des tâches linguistiques avancées et l’automatisation.

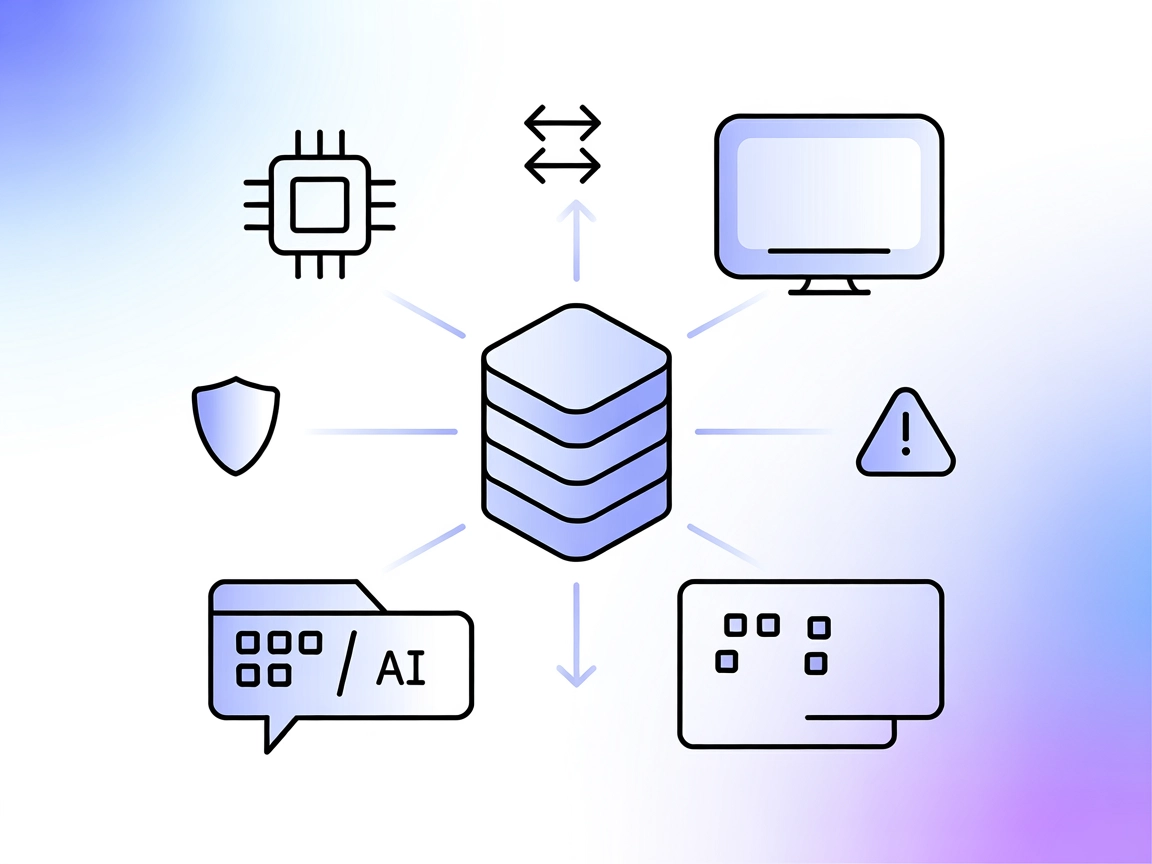

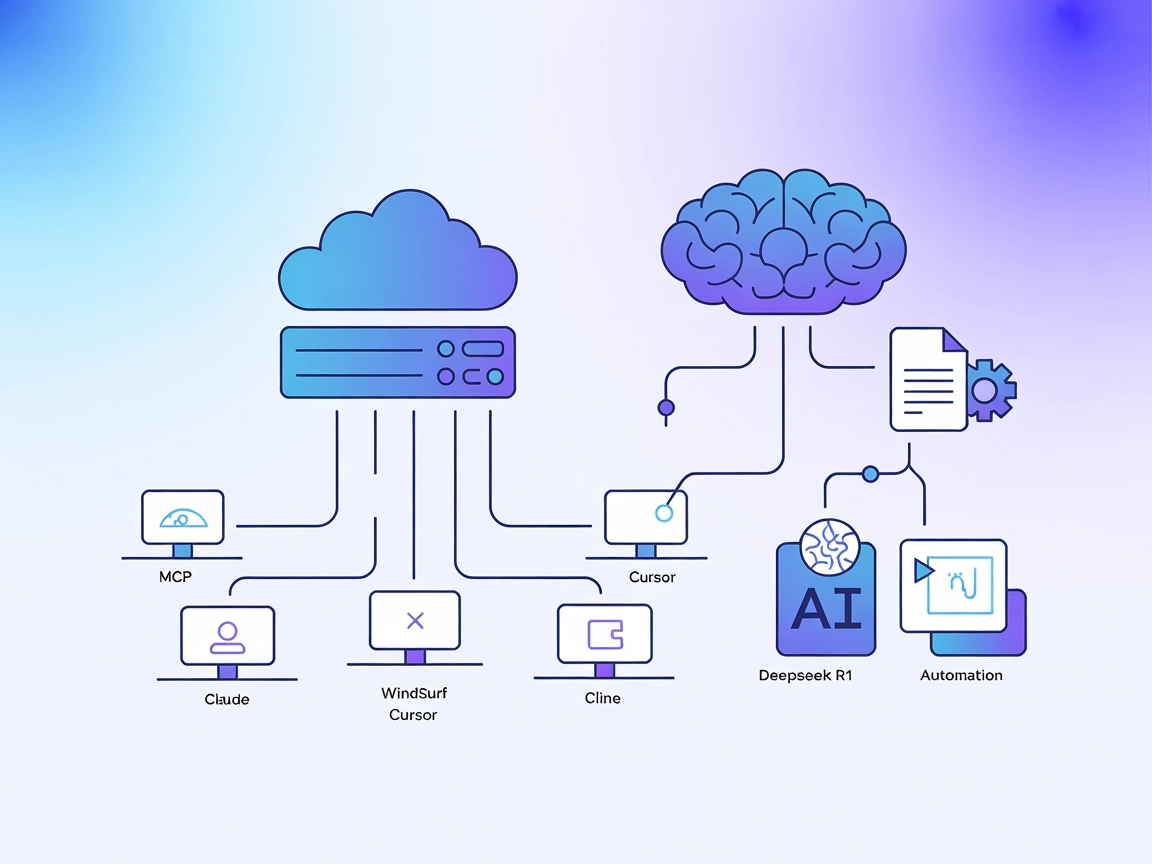

FlowHunt fournit une couche de sécurité supplémentaire entre vos systèmes internes et les outils d'IA, vous donnant un contrôle granulaire sur les outils accessibles depuis vos serveurs MCP. Les serveurs MCP hébergés dans notre infrastructure peuvent être intégrés de manière transparente avec le chatbot de FlowHunt ainsi qu'avec les plateformes d'IA populaires comme ChatGPT, Claude et divers éditeurs d'IA.

Le Serveur MCP Deepseek R1 est une implémentation du Model Context Protocol (MCP) conçue pour connecter Claude Desktop aux modèles linguistiques avancés de DeepSeek, tels que Deepseek R1 et DeepSeek V3. En faisant office de passerelle entre les assistants IA et les modèles puissants optimisés pour le raisonnement de DeepSeek (avec une fenêtre de contexte de 8192 tokens), ce serveur permet aux agents IA d’effectuer des tâches avancées de compréhension et de génération du langage naturel. Les développeurs peuvent intégrer ces modèles de façon transparente dans leurs workflows, facilitant ainsi la génération de texte avancée, le raisonnement et l’interaction avec des sources de données externes ou des API sur les plateformes compatibles. L’implémentation met l’accent sur une intégration stable, fiable et efficace en utilisant Node.js/TypeScript pour une compatibilité et une sécurité de typage optimales.

Aucun modèle de prompt n’est documenté dans le dépôt.

Aucune ressource MCP explicite n’est documentée dans le dépôt.

git clone https://github.com/66julienmartin/MCP-server-Deepseek_R1.git

cd deepseek-r1-mcp

npm install

.env.exemple en .env et renseignez votre clé API DeepSeek.{

"mcpServers": {

"deepseek_r1": {

"command": "node",

"args": ["/path/to/deepseek-r1-mcp/build/index.js"],

"env": {

"DEEPSEEK_API_KEY": "your-api-key"

}

}

}

}

{

"mcpServers": {

"deepseek_r1": {

"command": "node",

"args": ["/path/to/deepseek-r1-mcp/build/index.js"],

"env": {

"DEEPSEEK_API_KEY": "your-api-key"

}

}

}

}

{

"mcpServers": {

"deepseek_r1": {

"command": "node",

"args": ["/path/to/deepseek-r1-mcp/build/index.js"],

"env": {

"DEEPSEEK_API_KEY": "your-api-key"

}

}

}

}

{

"mcpServers": {

"deepseek_r1": {

"command": "node",

"args": ["/path/to/deepseek-r1-mcp/build/index.js"],

"env": {

"DEEPSEEK_API_KEY": "your-api-key"

}

}

}

}

Utilisez les variables d’environnement dans votre configuration pour sécuriser les clés API :

{

"mcpServers": {

"deepseek_r1": {

"command": "node",

"args": ["/path/to/deepseek-r1-mcp/build/index.js"],

"env": {

"DEEPSEEK_API_KEY": "your-api-key"

}

}

}

}

Utilisation du MCP dans FlowHunt

Pour intégrer des serveurs MCP dans votre workflow FlowHunt, commencez par ajouter le composant MCP à votre flux et reliez-le à votre agent IA :

Cliquez sur le composant MCP pour ouvrir le panneau de configuration. Dans la section de configuration système MCP, renseignez les informations de votre serveur MCP au format JSON suivant :

{

"deepseek_r1": {

"transport": "streamable_http",

"url": "https://yourmcpserver.example/pathtothemcp/url"

}

}

Une fois la configuration effectuée, l’agent IA pourra utiliser ce MCP comme un outil avec accès à toutes ses fonctions et capacités. Pensez à remplacer “deepseek_r1” par le nom réel de votre serveur MCP et l’URL par celle de votre propre serveur MCP.

| Section | Disponibilité | Détails/Remarques |

|---|---|---|

| Vue d’ensemble | ✅ | |

| Liste des prompts | ⛔ | Aucun modèle de prompt documenté |

| Liste des ressources | ⛔ | Aucune ressource MCP explicite documentée |

| Liste des outils | ✅ | Outil de génération de texte avancée |

| Sécurisation des clés API | ✅ | Utilisez les variables d’environnement en config |

| Support du sampling (moins important ici) | ⛔ | Non documenté |

| Supporte les Roots | ⛔ | Non documenté |

Au vu de la documentation disponible, le Serveur MCP Deepseek R1 propose une implémentation simple, claire, facile à configurer et à utiliser, mais ne documente ni prompts, ni ressources, ni fonctionnalités MCP avancées comme roots ou sampling. Il est donc très pratique pour la génération de texte, mais moins riche fonctionnellement pour des workflows complexes.

| Dispose d’une LICENCE | ✅ (MIT) |

|---|---|

| Au moins un outil | ✅ |

| Nombre de Forks | 12 |

| Nombre d’étoiles | 58 |

C'est un serveur Model Context Protocol (MCP) qui fait le lien entre Claude Desktop (ou d'autres plateformes) et les modèles linguistiques avancés de DeepSeek (R1, V3), permettant la génération de texte, le raisonnement et l'automatisation dans vos workflows IA.

Le serveur prend en charge Deepseek R1 et DeepSeek V3 — les deux modèles sont optimisés pour de larges fenêtres de contexte et des tâches de raisonnement complexes.

Les cas d'usage incluent la génération de texte avancée (longue, technique ou créative), le raisonnement complexe, l'amélioration d'assistants IA dans Claude Desktop, et l'automatisation de la création de contenu ou la gestion de connaissances via l'API.

Utilisez toujours des variables d'environnement dans la configuration de votre serveur MCP pour éviter toute fuite accidentelle de votre clé API DeepSeek.

Aucun modèle de prompt ni ressource MCP explicite n'est documenté dans le dépôt ; le serveur se concentre sur un accès direct au modèle et à l'intégration.

DeepSeek R1 offre une fenêtre de contexte de 8192 tokens, permettant la gestion de tâches longues et complexes.

Oui, il est sous licence MIT et disponible sur GitHub.

Débloquez la génération de texte avancée et le raisonnement en connectant FlowHunt ou Claude Desktop aux puissants modèles DeepSeek R1. Commencez à concevoir des workflows plus intelligents dès aujourd'hui.

Intégrez FlowHunt avec le serveur Deepseek R1 MCP pour débloquer des capacités avancées de modèles de langage, un raisonnement sur de grands contextes et des wo...

Le serveur MCP DeepSeek agit en tant que proxy sécurisé, connectant les modèles de langage avancés de DeepSeek aux applications compatibles MCP comme Claude Des...

Le serveur DeepSeek MCP intègre les modèles de langage avancés de DeepSeek avec des applications compatibles MCP, offrant un accès API sécurisé et anonymisé et ...

Consentement aux Cookies

Nous utilisons des cookies pour améliorer votre expérience de navigation et analyser notre trafic. See our privacy policy.