DeepSeek MCP Server

Le serveur DeepSeek MCP intègre les modèles de langage avancés de DeepSeek avec des applications compatibles MCP, offrant un accès API sécurisé et anonymisé et ...

Apportez le raisonnement transparent et les sorties IA en chaîne de Deepseek à vos assistants compatibles MCP avec prise en charge des déploiements cloud et local.

FlowHunt fournit une couche de sécurité supplémentaire entre vos systèmes internes et les outils d'IA, vous donnant un contrôle granulaire sur les outils accessibles depuis vos serveurs MCP. Les serveurs MCP hébergés dans notre infrastructure peuvent être intégrés de manière transparente avec le chatbot de FlowHunt ainsi qu'avec les plateformes d'IA populaires comme ChatGPT, Claude et divers éditeurs d'IA.

Le serveur MCP Deepseek Thinker agit comme un fournisseur Model Context Protocol (MCP), délivrant les contenus de raisonnement du modèle Deepseek aux clients IA compatibles MCP, comme Claude Desktop. Il permet aux assistants IA d’accéder aux processus de réflexion et de raisonnement de Deepseek soit via le service API Deepseek, soit à partir d’un serveur Ollama local. Grâce à cette intégration, les développeurs peuvent enrichir leurs workflows IA avec un raisonnement focalisé, en tirant parti des capacités d’inférence cloud ou locale. Ce serveur est particulièrement utile dans les situations nécessitant des chaînes de raisonnement détaillées (chain-of-thought, CoT) pour informer les tâches IA en aval, ce qui le rend précieux pour le développement avancé, le débogage et l’enrichissement d’agents IA.

Aucun modèle de prompt explicite n’est mentionné dans le dépôt ou la documentation.

Aucune ressource MCP explicite n’est détaillée dans la documentation ou le code.

originPrompt (string) — Le prompt original de l’utilisateur.windsurf_config.json).mcpServers :{

"deepseek-thinker": {

"command": "npx",

"args": [

"-y",

"deepseek-thinker-mcp"

],

"env": {

"API_KEY": "<Your API Key>",

"BASE_URL": "<Your Base URL>"

}

}

}

claude_desktop_config.json.{

"mcpServers": {

"deepseek-thinker": {

"command": "npx",

"args": [

"-y",

"deepseek-thinker-mcp"

],

"env": {

"API_KEY": "<Your API Key>",

"BASE_URL": "<Your Base URL>"

}

}

}

}

{

"mcpServers": {

"deepseek-thinker": {

"command": "npx",

"args": [

"-y",

"deepseek-thinker-mcp"

],

"env": {

"API_KEY": "<Your API Key>",

"BASE_URL": "<Your Base URL>"

}

}

}

}

{

"mcpServers": {

"deepseek-thinker": {

"command": "npx",

"args": [

"-y",

"deepseek-thinker-mcp"

],

"env": {

"API_KEY": "<Your API Key>",

"BASE_URL": "<Your Base URL>"

}

}

}

}

Pour toutes les plateformes, les clés API et les valeurs sensibles doivent être fournies via des variables d’environnement dans la section env. Exemple :

{

"mcpServers": {

"deepseek-thinker": {

"command": "npx",

"args": [

"-y",

"deepseek-thinker-mcp"

],

"env": {

"API_KEY": "<Your API Key>",

"BASE_URL": "<Your Base URL>"

}

}

}

}

Pour le mode Ollama local, définissez USE_OLLAMA à "true" dans l’objet env :

"env": {

"USE_OLLAMA": "true"

}

Utiliser MCP dans FlowHunt

Pour intégrer des serveurs MCP dans votre workflow FlowHunt, commencez par ajouter le composant MCP à votre flow et connectez-le à votre agent IA :

Cliquez sur le composant MCP pour ouvrir le panneau de configuration. Dans la section de configuration système MCP, insérez les détails de votre serveur MCP avec ce format JSON :

{

"deepseek-thinker": {

"transport": "streamable_http",

"url": "https://yourmcpserver.example/pathtothemcp/url"

}

}

Une fois configuré, l’agent IA peut désormais utiliser ce MCP comme outil avec accès à toutes ses fonctions et capacités. N’oubliez pas de remplacer “deepseek-thinker” par le nom réel de votre serveur MCP et d’indiquer la bonne URL.

| Section | Disponibilité | Détails/Remarques |

|---|---|---|

| Aperçu | ✅ | |

| Liste des Prompts | ⛔ | Aucun modèle de prompt documenté |

| Liste des Ressources | ⛔ | Aucune ressource MCP explicite trouvée |

| Liste des Outils | ✅ | Outil get-deepseek-thinker |

| Sécurisation des clés API | ✅ | Variables d’environnement dans la config |

| Support de l’échantillonnage (moins important) | ⛔ | Non mentionné |

Sur la base des deux tableaux ci-dessous, le serveur MCP Deepseek Thinker fournit un outil ciblé pour l’intégration du raisonnement, est facile à installer, mais manque de modèles de prompts détaillés et de définitions de ressources explicites. Le projet est open source, bénéficie d’une popularité modérée et prend en charge la gestion sécurisée des identifiants. Il obtient une note de 6/10 pour l’exhaustivité et l’utilité globale en tant que serveur MCP.

| Possède une LICENCE | ⛔ (Aucun fichier LICENSE détecté) |

|---|---|

| Au moins un outil | ✅ |

| Nombre de Forks | 12 |

| Nombre d’Étoiles | 51 |

C'est un serveur Model Context Protocol qui apporte le raisonnement du modèle Deepseek aux clients IA compatibles MCP, offrant des sorties en chaîne de raisonnement et une réflexion transparente du modèle pour des workflows IA avancés et le débogage.

Il propose l'outil 'get-deepseek-thinker' pour effectuer du raisonnement avec le modèle Deepseek et retourner des sorties structurées de raisonnement.

Oui, Deepseek Thinker prend en charge l'inférence basée sur le cloud et en local (Ollama). Définissez la variable d'environnement 'USE_OLLAMA' à 'true' pour le mode local.

Les clés API et les valeurs sensibles doivent être stockées dans la section 'env' de votre configuration de serveur MCP en tant que variables d'environnement, et non codées en dur dans les fichiers source.

Les limites sont déterminées par le modèle Deepseek ou l'API sous-jacente ; les dépasser peut tronquer les réponses ou générer des erreurs, adaptez donc votre configuration et vos entrées en conséquence.

Aucun modèle de prompt explicite ni ressource MCP supplémentaire n'est fourni dans la documentation actuelle du serveur MCP Deepseek Thinker.

Intégrez le serveur MCP Deepseek Thinker pour doter vos agents IA de capacités de raisonnement détaillées et booster vos workflows de développement.

Le serveur DeepSeek MCP intègre les modèles de langage avancés de DeepSeek avec des applications compatibles MCP, offrant un accès API sécurisé et anonymisé et ...

Le serveur MCP DeepSeek agit en tant que proxy sécurisé, connectant les modèles de langage avancés de DeepSeek aux applications compatibles MCP comme Claude Des...

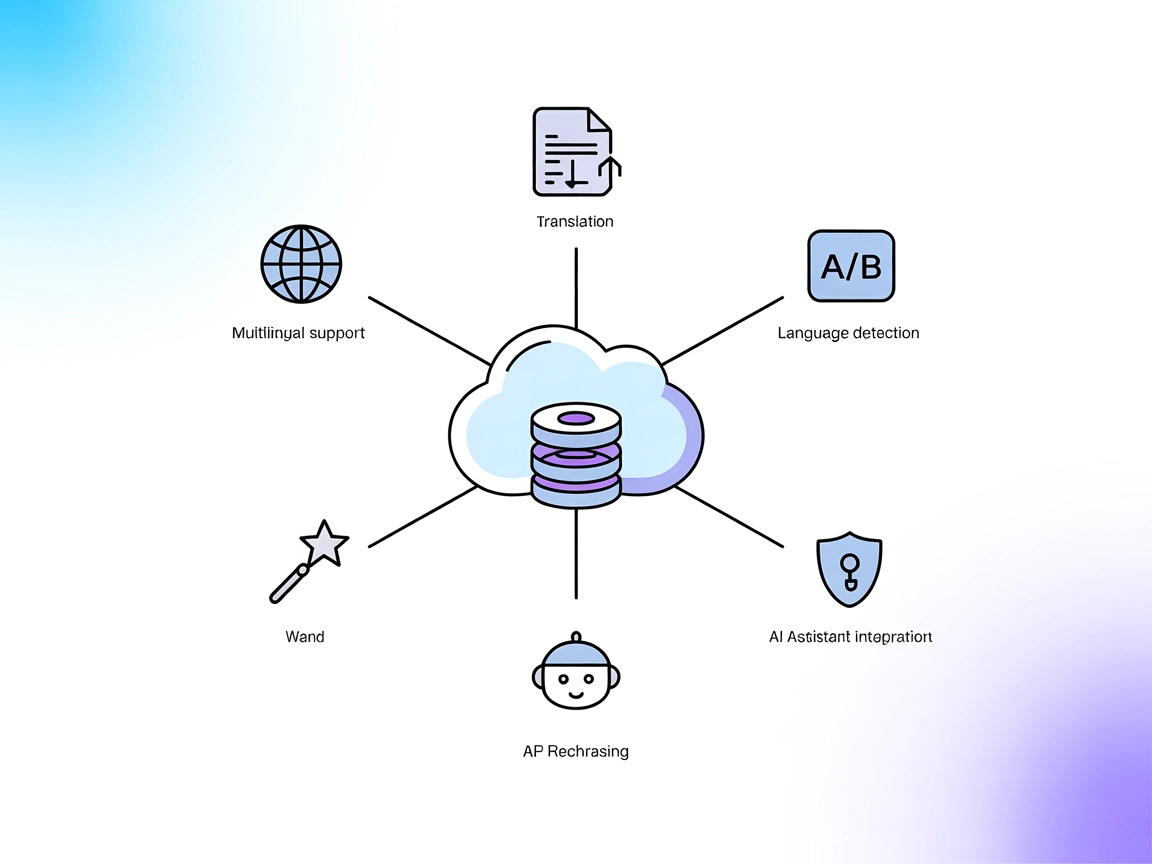

Le serveur DeepL MCP intègre la traduction avancée, la reformulation et la détection de langue dans les flux de travail IA via l’API DeepL. Il offre à FlowHunt ...

Consentement aux Cookies

Nous utilisons des cookies pour améliorer votre expérience de navigation et analyser notre trafic. See our privacy policy.