Intégration du serveur ModelContextProtocol (MCP)

Le serveur ModelContextProtocol (MCP) agit comme un pont entre les agents IA et les sources de données externes, API et services, permettant aux utilisateurs de...

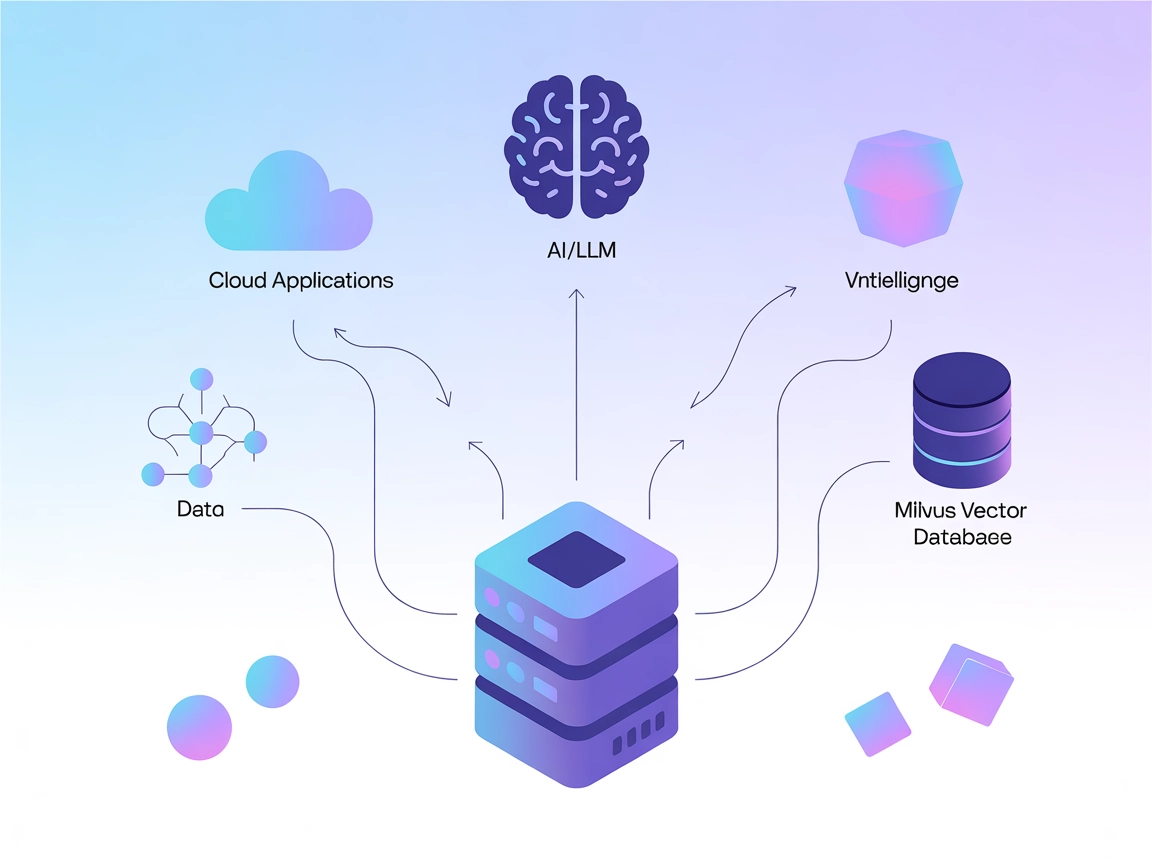

Connectez les LLM et agents IA à Milvus pour une recherche vectorielle puissante, une mémoire contextuelle et des recommandations pilotées par les données directement dans vos workflows FlowHunt.

FlowHunt fournit une couche de sécurité supplémentaire entre vos systèmes internes et les outils d'IA, vous donnant un contrôle granulaire sur les outils accessibles depuis vos serveurs MCP. Les serveurs MCP hébergés dans notre infrastructure peuvent être intégrés de manière transparente avec le chatbot de FlowHunt ainsi qu'avec les plateformes d'IA populaires comme ChatGPT, Claude et divers éditeurs d'IA.

Le serveur Milvus MCP (Model Context Protocol) connecte les assistants IA et les applications alimentées par LLM à la base de données vectorielle Milvus. Cela permet une interaction fluide entre les modèles de langage et les données vectorielles à grande échelle, fournissant un moyen standardisé d’accéder, d’interroger et de gérer Milvus depuis des workflows IA. Avec le serveur Milvus MCP, les développeurs peuvent intégrer des capacités de recherche, de récupération et de gestion de données basées sur Milvus directement dans leurs agents IA, IDE ou interfaces de chat. Le serveur prend en charge plusieurs modes de communication (stdio et Server-Sent Events), ce qui lui permet de s’adapter à divers scénarios de déploiement et environnements de développement. En faisant le lien entre les LLM et Milvus, il améliore considérablement la capacité des systèmes IA à effectuer des opérations contextuelles sur des données de grande dimension, ouvrant la voie à des expériences IA plus riches et intelligentes.

Aucune information sur les modèles de prompt n’est fournie dans le dépôt.

Aucune liste explicite de “ressources” Model Context Protocol n’est décrite dans la documentation ou le code disponibles.

Aucune liste explicite d’outils ou de noms de fonctions n’est documentée dans la documentation ou les fichiers de code disponibles, y compris server.py.

git clone https://github.com/zilliztech/mcp-server-milvus.gituv run src/mcp_server_milvus/server.py --milvus-uri http://localhost:19530{

"mcpServers": {

"milvus-mcp": {

"command": "uv",

"args": ["run", "src/mcp_server_milvus/server.py", "--milvus-uri", "http://localhost:19530"]

}

}

}

Sécurisation des clés API :

Si le serveur nécessite des informations sensibles, utilisez des variables d’environnement :

{

"env": {

"MILVUS_URI": "http://localhost:19530"

},

"inputs": {}

}

{

"mcpServers": {

"milvus-mcp": {

"command": "uv",

"args": ["run", "src/mcp_server_milvus/server.py", "--milvus-uri", "http://localhost:19530"]

}

}

}

Sécurisez les identifiants via des variables d’environnement comme ci-dessus.

uv.uv run src/mcp_server_milvus/server.py --milvus-uri http://localhost:19530{

"mcpServers": {

"milvus-mcp": {

"command": "uv",

"args": ["run", "src/mcp_server_milvus/server.py", "--milvus-uri", "http://localhost:19530"]

}

}

}

Sécurisation des clés API :

Utilisez les variables d’environnement comme montré ci-dessus.

uv.{

"mcpServers": {

"milvus-mcp": {

"command": "uv",

"args": ["run", "src/mcp_server_milvus/server.py", "--milvus-uri", "http://localhost:19530"]

}

}

}

Variables d’environnement :

{

"env": {

"MILVUS_URI": "http://localhost:19530"

}

}

Utilisation du MCP dans FlowHunt

Pour intégrer des serveurs MCP dans votre workflow FlowHunt, commencez par ajouter le composant MCP à votre flow et connectez-le à votre agent IA :

Cliquez sur le composant MCP pour ouvrir le panneau de configuration. Dans la section de configuration système MCP, insérez les détails de votre serveur MCP au format JSON suivant :

{

"milvus-mcp": {

"transport": "streamable_http",

"url": "https://yourmcpserver.example/pathtothemcp/url"

}

}

Une fois configuré, l’agent IA peut utiliser ce MCP comme un outil avec accès à toutes ses fonctions et capacités. Pensez à changer “milvus-mcp” par le nom réel de votre serveur MCP et à remplacer l’URL par celle de votre propre serveur MCP.

| Section | Disponibilité | Détails/Remarques |

|---|---|---|

| Aperçu | ✅ | |

| Liste des Prompts | ⛔ | Aucun modèle de prompt documenté |

| Liste des ressources | ⛔ | Pas de liste explicite de ressources MCP |

| Liste des outils | ⛔ | Aucun outil explicite listé dans les fichiers disponibles |

| Sécurisation des clés API | ✅ | Utilise des variables d’environnement, documenté dans les exemples |

| Prise en charge du sampling (moins important) | ⛔ | Non mentionné |

Support des Roots : Non mentionné

Support du sampling : Non mentionné

Le serveur Milvus MCP est un pont pratique et ciblé pour connecter les LLM à Milvus, avec des guides d’installation clairs pour les principaux outils de développement. Cependant, sa documentation manque de détails sur les ressources MCP, les prompts et les APIs d’outils exploitables, ce qui limite la découverte immédiate. Cela reste néanmoins une base solide pour les intégrations IA basées sur les vecteurs.

| Dispose d’une LICENCE | ✅ (Apache-2.0) |

|---|---|

| A au moins un outil | ⛔ |

| Nombre de forks | 32 |

| Nombre d’étoiles | 139 |

Global : 4/10

Le serveur est utile pour sa niche mais gagnerait beaucoup avec une documentation plus explicite sur les ressources, modèles de prompt et APIs d’outils pour une interopérabilité et une facilité d’utilisation maximales.

Le serveur Milvus MCP fait le lien entre les assistants IA et les applications LLM avec la base de données vectorielle Milvus, permettant une recherche vectorielle fluide, une mémoire contextuelle et la gestion des données pour des workflows IA avancés.

Les principaux cas d'usage incluent la recherche vectorielle, la gestion des embeddings, la mémoire contextuelle pour chatbot, les recommandations alimentées par l'IA et l'analyse de données en temps réel avec Milvus dans FlowHunt.

Utilisez des variables d'environnement (par ex. MILVUS_URI) pour stocker les informations sensibles de connexion, comme indiqué dans les guides de configuration pour chaque client supporté.

Aucun modèle de prompt explicite ni API d'outils ne sont documentés. Le serveur se concentre sur l'établissement d'un pont pour les opérations vectorielles et la gestion des embeddings.

Il s'agit d'une base solide pour connecter les LLM aux bases de données vectorielles, avec des instructions de configuration claires, mais qui gagnerait à avoir plus de documentation sur les prompts et les APIs d'outils pour une meilleure découverte et intégration.

Améliorez vos agents IA avec un accès fluide aux bases de données vectorielles, permettant des recherches plus intelligentes, des recommandations et une mémoire contextuelle. Intégrez dès maintenant le serveur Milvus MCP avec FlowHunt !

Le serveur ModelContextProtocol (MCP) agit comme un pont entre les agents IA et les sources de données externes, API et services, permettant aux utilisateurs de...

Le serveur Litmus MCP permet une intégration transparente entre les grands modèles de langage (LLMs) et Litmus Edge pour la configuration, la surveillance et la...

Découvrez ce que sont les serveurs MCP (Model Context Protocol), comment ils fonctionnent et pourquoi ils révolutionnent l'intégration de l'IA. Découvrez commen...

Consentement aux Cookies

Nous utilisons des cookies pour améliorer votre expérience de navigation et analyser notre trafic. See our privacy policy.