Serveur Model Context Protocol (MCP)

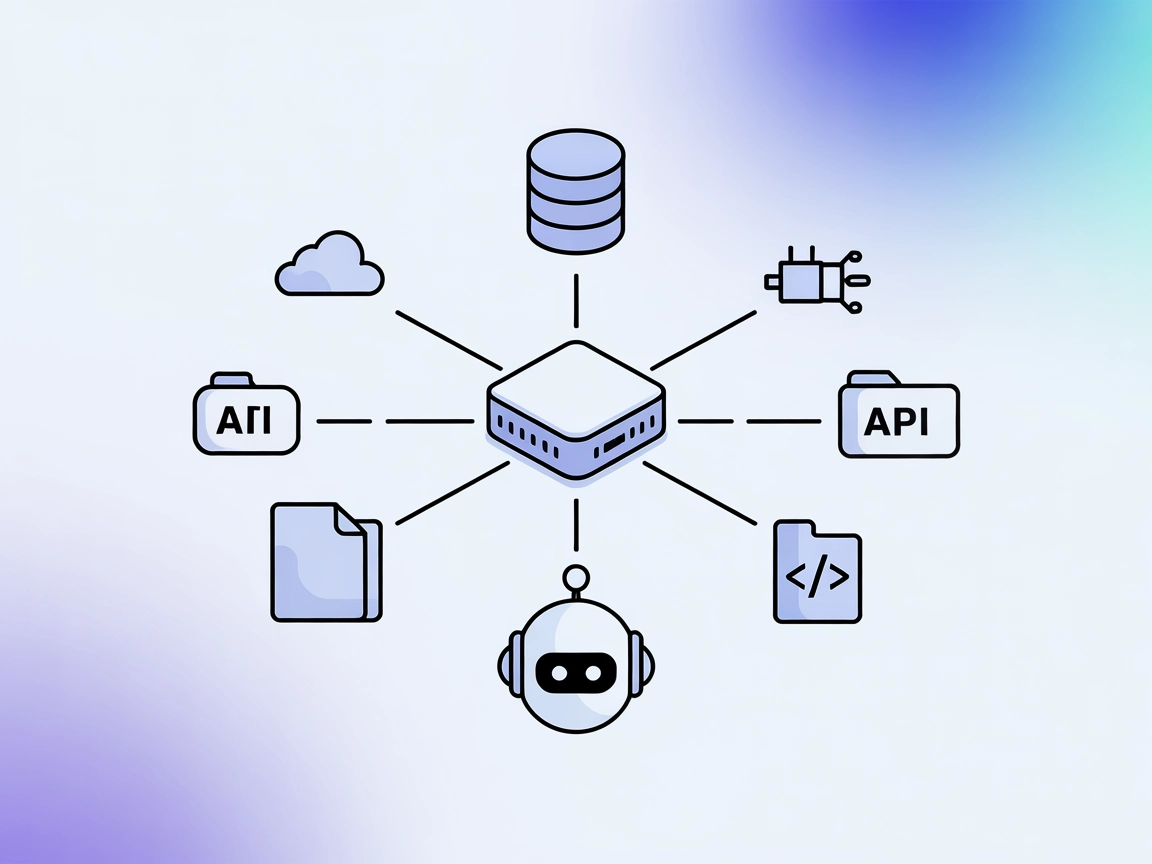

Le serveur Model Context Protocol (MCP) fait le lien entre les assistants IA et des sources de données externes, des API et des services, permettant une intégra...

Le serveur UnifAI MCP relie les agents IA à des API et services externes pour une automatisation accrue, bien que sa documentation actuelle soit limitée.

FlowHunt fournit une couche de sécurité supplémentaire entre vos systèmes internes et les outils d'IA, vous donnant un contrôle granulaire sur les outils accessibles depuis vos serveurs MCP. Les serveurs MCP hébergés dans notre infrastructure peuvent être intégrés de manière transparente avec le chatbot de FlowHunt ainsi qu'avec les plateformes d'IA populaires comme ChatGPT, Claude et divers éditeurs d'IA.

Le serveur UnifAI MCP (Model Context Protocol) fait partie de l’écosystème UnifAI SDK, conçu pour connecter les assistants IA à des sources de données externes, des API et des services afin d’améliorer les workflows de développement. En servant de passerelle, le serveur UnifAI MCP permet aux outils et agents alimentés par l’IA d’effectuer des tâches telles que des requêtes de bases de données, des opérations sur les fichiers et des interactions avec des API de manière transparente. Cela étend les capacités des assistants IA, permettant aux développeurs d’automatiser des workflows complexes, d’orchestrer des actions externes et de standardiser les interactions clés entre l’IA et les systèmes réels. Les serveurs UnifAI MCP sont disponibles en implémentations Python et TypeScript dans les SDK UnifAI.

Aucune information sur des modèles de prompts n’a été trouvée dans le dépôt.

Aucune information sur des ressources spécifiques exposées par le serveur UnifAI MCP n’a été trouvée dans le dépôt.

Aucune information sur des outils spécifiques fournis par le serveur UnifAI MCP n’a été trouvée dans le dépôt.

Aucun cas d’utilisation explicite n’a été fourni dans le dépôt. Cependant, sur la base des capacités générales d’un serveur MCP, les cas d’utilisation possibles peuvent inclure :

Aucune instruction de configuration ou exemple pour Windsurf, Claude, Cursor ou Cline n’a été trouvé dans le dépôt.

Utilisation de MCP dans FlowHunt

Pour intégrer des serveurs MCP dans votre workflow FlowHunt, commencez par ajouter le composant MCP à votre flow et connectez-le à votre agent IA :

Cliquez sur le composant MCP pour ouvrir le panneau de configuration. Dans la section configuration système MCP, insérez les détails de votre serveur MCP en utilisant ce format JSON :

{

"MCP-name": {

"transport": "streamable_http",

"url": "https://yourmcpserver.example/pathtothemcp/url"

}

}

Une fois configuré, l’agent IA est désormais capable d’utiliser ce MCP comme un outil avec accès à toutes ses fonctions et capacités. N’oubliez pas de remplacer “MCP-name” par le nom réel de votre serveur MCP (par exemple, “github-mcp”, “weather-api”, etc.) et de remplacer l’URL par celle de votre propre serveur MCP.

| Section | Disponibilité | Détails/Remarques |

|---|---|---|

| Vue d’ensemble | ✅ | Vue d’ensemble déduite du dépôt et des SDK liés |

| Liste des prompts | ⛔ | Aucun modèle de prompt trouvé |

| Liste des ressources | ⛔ | Aucune ressource trouvée |

| Liste des outils | ⛔ | Aucun outil trouvé |

| Sécurisation des clés API | ⛔ | Aucun détail trouvé |

| Support de l’échantillonnage (moins important) | ⛔ | Aucun détail trouvé |

Aucune information n’est disponible dans le dépôt concernant Roots ou le support de l’échantillonnage.

En raison du manque d’informations concrètes et de documentation dans le dépôt, l’utilisabilité du serveur UnifAI MCP est actuellement limitée du point de vue des développeurs. Le concept est prometteur, mais l’absence de détails sur les outils, prompts, ressources et configuration réduit sa valeur pratique.

| Dispose d’une LICENSE | ⛔ |

|---|---|

| Dispose d’au moins un outil | ⛔ |

| Nombre de forks | 3 |

| Nombre d’étoiles | 3 |

Dans l’ensemble, ce serveur MCP obtient une note de 2/10 pour l’utilisabilité et la documentation. L’idée de base est solide, mais le manque de détails sur la configuration, l’utilisation ou l’implémentation le rend impraticable pour les développeurs en l’état.

Le serveur UnifAI MCP fait partie du SDK UnifAI, conçu pour connecter les assistants IA à des sources de données externes, des API et des services, permettant l'automatisation et l'orchestration de workflows pour les développeurs.

Les cas d'utilisation potentiels incluent l'intégration avec des API pour la récupération de données, l'automatisation de la gestion de bases de données, l'exploration de bases de code, la gestion de fichiers, l'orchestration de workflows multi-étapes, et la standardisation des interactions avec les LLM. Cependant, aucun exemple concret n'est fourni dans la documentation actuelle.

Pour utiliser le serveur UnifAI MCP dans FlowHunt, ajoutez le composant MCP à votre flow, puis configurez-le avec l'URL de votre serveur MCP dans la configuration système MCP en utilisant le format JSON fourni. Remplacez l'exemple par les détails réels de votre serveur.

Aucun outil, ressource ou modèle de prompt spécifique n'est documenté dans le dépôt actuel, ce qui limite son utilité immédiate.

L'utilisabilité et la documentation sont actuellement jugées faibles (2/10), car il existe peu d'informations pratiques pour les développeurs souhaitant intégrer ou utiliser ce serveur.

Le serveur Model Context Protocol (MCP) fait le lien entre les assistants IA et des sources de données externes, des API et des services, permettant une intégra...

Le serveur UNS-MCP fait le lien entre les assistants IA et les flux de travail de développement avec des sources de données externes via l'API Unstructured, per...

Le serveur Unity MCP fait le lien entre l’éditeur Unity et les clients de modèles d’IA tels que Claude Desktop, Windsurf et Cursor, permettant l’automatisation,...

Consentement aux Cookies

Nous utilisons des cookies pour améliorer votre expérience de navigation et analyser notre trafic. See our privacy policy.