Google Gemini 2.5 Flash: Rivoluzione nella Generazione di Immagini AI

Scopri come il modello di immagini Gemini 2.5 Flash di Google sta trasformando le industrie creative con funzionalità avanzate di fotoritocco, estrazione 3D, re...

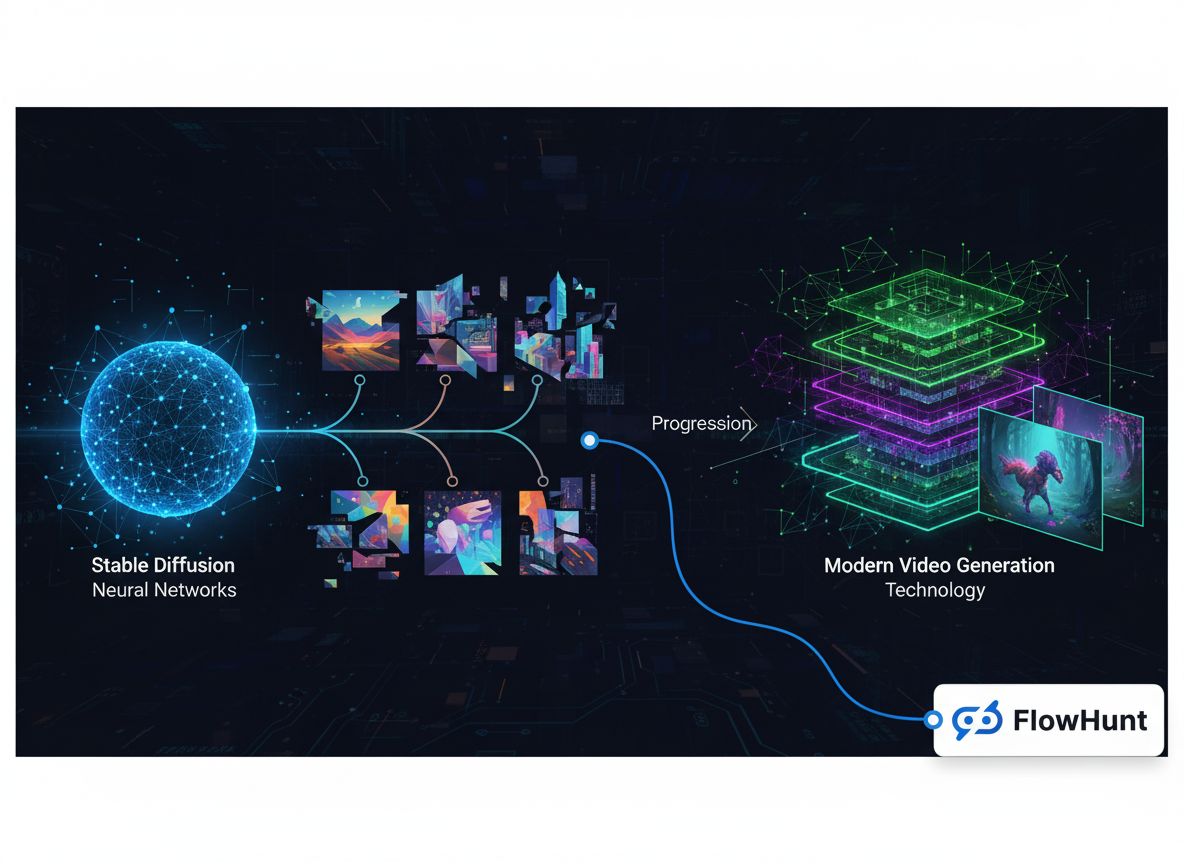

Esplora l’evoluzione tecnica delle piattaforme di media generativi, dai primi modelli di immagini alla generazione video moderna, e come l’ottimizzazione specialistica dell’inferenza sia diventata un business da oltre 100 milioni di dollari.

Il panorama dei media generativi ha subito una straordinaria trasformazione negli ultimi anni, evolvendosi da progetti di ricerca sperimentali a un mercato infrastrutturale multimiliardario. Quello che era iniziato come modelli specializzati per la generazione di immagini si è ampliato in un ecosistema completo che comprende sintesi di immagini, creazione di video, generazione audio e sofisticate capacità di editing. Questa storia tecnica esplora come aziende come FAL abbiano costruito un business con ricavi superiori ai 100 milioni di dollari riconoscendo un gap critico nel mercato: gli sviluppatori avevano bisogno di un’infrastruttura di inferenza ottimizzata e scalabile, progettata specificamente per i modelli di media generativi, non di una generica orchestrazione GPU o hosting di modelli linguistici. Il percorso da Stable Diffusion 1.5 ai moderni modelli video come Veo3 rivela lezioni importanti su posizionamento di mercato, specializzazione tecnica e requisiti infrastrutturali che permettono alle applicazioni AI di scalare dai prototipi di ricerca a sistemi di produzione al servizio di milioni di sviluppatori.

I media generativi rappresentano una categoria di intelligenza artificiale fondamentalmente diversa rispetto ai grandi modelli linguistici che hanno dominato le recenti cronache. Mentre i modelli linguistici elaborano testi e generano risposte basate su pattern appresi, i sistemi di media generativi creano contenuti visivi e audio—immagini, video, musica ed effetti sonori—a partire da descrizioni testuali, immagini esistenti o altre modalità di input. Questa distinzione va oltre la semantica; riflette profonde differenze nei requisiti tecnici, nelle dinamiche di mercato e nelle opportunità di business. I modelli di media generativi operano con vincoli computazionali diversi, richiedono tecniche di ottimizzazione specializzate e servono casi d’uso che l’infrastruttura tradizionale per modelli linguistici non può gestire in modo efficiente. L’ascesa dei media generativi ha creato una nuova categoria di aziende infrastrutturali focalizzate specificamente sull’ottimizzazione dell’inferenza per questi modelli, permettendo agli sviluppatori di integrare sofisticate capacità di generazione di immagini e video nelle proprie applicazioni senza dover gestire deployment GPU complessi o problemi di utilizzo inefficiente delle risorse.

I requisiti tecnici per l’inferenza nei media generativi differiscono significativamente dal serving dei modelli linguistici. I modelli di generazione immagini come Stable Diffusion e Flux operano tramite processi di diffusione iterativi che richiedono una gestione accurata della memoria, ottimizzazione precisa dei tempi e batch processing efficiente. La generazione video aggiunge un ulteriore livello di complessità, richiedendo coerenza temporale, sincronizzazione audio e risorse computazionali sostanzialmente più elevate. Questi requisiti non possono essere affrontati in modo efficiente da piattaforme generiche di orchestrazione GPU o servizi di inferenza per modelli linguistici. Invece, richiedono infrastrutture specializzate costruite da zero per gestire le caratteristiche uniche dei modelli di diffusione, generazione autoregressiva di immagini e sintesi video. Le aziende che hanno riconosciuto presto questo gap—e investito nella costruzione di infrastrutture dedicate—si sono posizionate per conquistare una quota significativa di mercato man mano che l’adozione dei media generativi accelerava nei vari settori.

La decisione di specializzarsi nei media generativi invece di perseguire la strada apparentemente più ovvia dell’hosting di modelli linguistici rappresenta una delle scelte strategiche più rilevanti nella recente storia dell’infrastruttura AI. Quando i fondatori di FAL valutarono le opzioni tra il 2022 e il 2023, si trovarono di fronte a un bivio critico: espandere il proprio runtime Python in una piattaforma di inferenza per modelli linguistici generica, o puntare sull’emergente spazio dei media generativi? La risposta rivela importanti insight sulle dinamiche di mercato, il posizionamento competitivo e l’importanza di scegliere battaglie dove si può vincere. L’hosting di modelli linguistici, pur apparentemente attraente per la grande attenzione e i finanziamenti che fluiscono verso i large language model, presentava un panorama competitivo impossibile. OpenAI aveva già stabilito GPT come modello dominante con un’enorme base utenti e flusso di ricavi. Anthropic stava costruendo Claude con importanti investimenti e talento tecnico. Google, Microsoft e altri giganti tech stavano investendo miliardi nelle proprie infrastrutture per modelli linguistici. Per una startup, competere in questo spazio avrebbe significato sfidare direttamente aziende con risorse immensamente superiori, posizioni di mercato consolidate e la capacità di offrire accesso ai modelli linguistici a costo, o addirittura in perdita, se ciò avesse servito i loro interessi strategici più ampi.

Il mercato dei media generativi, invece, presentava una dinamica competitiva fondamentalmente diversa. Con il rilascio di Stable Diffusion 1.5 nel 2022, si creò un bisogno immediato di infrastrutture di inferenza ottimizzate, ma nessun incumbente chiaro era ancora emerso. Il modello era open-source, il che significava che chiunque poteva scaricarlo ed eseguirlo, ma la maggior parte degli sviluppatori non aveva le competenze o le risorse per ottimizzarlo efficacemente. Si creò così l’occasione perfetta per un’azienda infrastrutturale specializzata. FAL riconobbe che gli sviluppatori volevano usare questi modelli ma non volevano gestire la complessità del deployment GPU, l’ottimizzazione del modello e la scalabilità. Concentrandosi esclusivamente sui media generativi, FAL poteva diventare l’esperto di questo dominio specifico, costruire rapporti profondi con creatori di modelli e sviluppatori e affermarsi come la piattaforma di riferimento per l’inferenza nei media generativi. Questa strategia di specializzazione si rivelò estremamente efficace, consentendo a FAL di crescere da un punto di svolta a un’azienda al servizio di 2 milioni di sviluppatori e oltre 350 modelli, con ricavi superiori ai 100 milioni di dollari annuali.

La base tecnica delle moderne piattaforme di media generativi poggia su ottimizzazioni sofisticate dell’inferenza che vanno ben oltre il semplice eseguire modelli su GPU. Quando gli sviluppatori iniziarono a usare Stable Diffusion 1.5, molti tentarono di deployarlo autonomamente su infrastrutture cloud generiche o GPU locali. Questo approccio mise in luce inefficienze critiche: i modelli non erano ottimizzati per l’hardware specifico su cui giravano, la memoria veniva sprecata da batching inefficiente e i tassi di utilizzo erano bassi perché il carico di lavoro di ogni utente era isolato. Uno sviluppatore poteva utilizzare solo il 20-30% della propria GPU, pur pagandola al 100%. Questo spreco creò l’opportunità per una piattaforma che potesse aggregare la domanda di molti utenti, ottimizzare l’inferenza per configurazioni hardware specifiche e ottenere tassi di utilizzo molto più alti tramite batching e scheduling intelligenti. L’approccio di FAL prevedeva la costruzione di kernel CUDA custom—codice GPU a basso livello ottimizzato per operazioni specifiche all’interno dei modelli generativi—che poteva migliorare drasticamente le prestazioni rispetto alle implementazioni generiche.

La sfida infrastrutturale va oltre la semplice ottimizzazione delle prestazioni. I modelli di media generativi hanno caratteristiche uniche che richiedono una gestione specialistica. I modelli di diffusione, che alimentano la maggior parte dei sistemi di generazione immagini, funzionano tramite un processo iterativo in cui il modello raffina gradualmente il rumore casuale in immagini coerenti attraverso molti step. Ogni step richiede una gestione attenta della memoria per evitare di esaurire quella GPU, e il processo deve essere sufficientemente veloce da garantire una latenza accettabile per applicazioni interattive. La generazione video aggiunge dimensioni temporali, richiedendo ai modelli di mantenere coerenza tra i frame generando contenuti di alta qualità a 24 o 30 fotogrammi al secondo. I modelli audio hanno esigenze proprie, tra cui capacità di elaborazione in tempo reale per alcune applicazioni e output ad alta fedeltà per altre. Una piattaforma che serve tutte queste modalità deve sviluppare competenze profonde in ogni dominio, comprendendo le specifiche opportunità di ottimizzazione e i vincoli di ciascun tipo di modello. Questa specializzazione è esattamente ciò che rende preziose le aziende infrastrutturali per i media generativi—accumulano conoscenze e tecniche di ottimizzazione che i singoli sviluppatori non possono facilmente replicare.

La storia dei media generativi può essere tracciata attraverso l’evoluzione dei modelli di generazione immagini, ciascuno rappresentante un importante punto di svolta nello sviluppo del mercato. Stable Diffusion 1.5, rilasciato nel 2022, è stato il catalizzatore che ha trasformato i media generativi da curiosità accademica a strumento pratico utilizzabile dagli sviluppatori. Il modello era open-source, relativamente efficiente rispetto ai precedenti modelli di diffusione e produceva immagini di qualità accettabile per un’ampia gamma di casi d’uso. Per FAL, Stable Diffusion 1.5 rappresentò il momento in cui riconobbero l’opportunità di pivotare l’intera azienda. Iniziarono a offrire una versione ottimizzata e pronta per API che gli sviluppatori potevano chiamare senza gestire infrastrutture GPU proprie. La risposta fu immediata—gli sviluppatori riconobbero subito il valore di non dover affrontare la complessità del deployment, e Stable Diffusion 1.5 divenne il primo vero driver di ricavi per FAL. Oltre al modello base, esplose l’ecosistema di fine-tuning intorno a Stable Diffusion 1.5. Gli sviluppatori crearono LoRA (Low-Rank Adaptations)—modifiche leggere del modello base per casi d’uso specifici come stili artistici particolari, volti di persone specifiche o oggetti unici. Questo ecosistema creò un circolo virtuoso: più opzioni di fine-tuning aumentavano il valore della piattaforma, attirando più sviluppatori e creando più opportunità di personalizzazione.

Stable Diffusion 2.1, rilasciato come seguito del modello originale, rappresentò una lezione sulla centralità della qualità del modello nel mercato dei media generativi. Nonostante fosse tecnicamente più avanzato sotto certi aspetti, SD 2.1 fu percepito come un passo indietro nella qualità delle immagini, specialmente per i volti umani e le scene complesse. Il modello non ottenne particolare successo e molti sviluppatori continuarono a usare la versione 1.5. Questa esperienza insegnò una lezione importante: nel mercato dei media generativi, la qualità conta più della sofisticazione tecnica. Agli utenti interessa il risultato che possono ottenere, non l’architettura sottostante o la metodologia di training. Stable Diffusion XL (SDXL), rilasciato nel 2023, rappresentò un vero salto in avanti in termini di qualità e capacità. SDXL poteva generare immagini a risoluzione più alta, con maggior dettaglio e testo più accurato. Per FAL, SDXL fu trasformativo—fu il primo modello a generare 1 milione di dollari di ricavi per la piattaforma. Il successo del modello accelerò anche l’ecosistema di fine-tuning, con migliaia di LoRA creati per personalizzare SDXL su specifiche applicazioni. Il successo di SDXL dimostrò che c’era una domanda commerciale sostanziale per la generazione di immagini di alta qualità, validando la scelta di FAL di specializzarsi in questo mercato.

Il rilascio dei modelli Flux da parte di Black Forest Labs nel 2024 segnò un altro cruciale punto di svolta. Flux rappresentò la prima generazione di modelli che potevano davvero essere definiti “commercialmente utilizzabili” e “pronti per l’impresa”. La qualità era sostanzialmente superiore rispetto ai modelli precedenti, la velocità di generazione era accettabile per applicazioni di produzione e i risultati sufficientemente consistenti da permettere alle aziende di costruirci prodotti. Per FAL, Flux fu rivoluzionario: i ricavi della piattaforma passarono da 2 a 10 milioni di dollari nel primo mese dopo il rilascio di Flux, poi a 20 milioni il mese successivo. Questa crescita esplosiva rifletteva la domanda latente di generazione immagini di alta qualità, affidabile per applicazioni commerciali. Flux veniva offerto in più versioni—Schnell (una versione distillata e veloce), Dev (versione di qualità superiore con licenza non commerciale) e Pro (che richiede collaborazione per l’hosting)—ciascuna per casi d’uso e fasce di prezzo diverse. Il successo di Flux dimostrò anche che il mercato dei media generativi era maturato al punto che le aziende erano disposte a investire significativamente nella generazione di immagini, non solo a sperimentare la tecnologia.

Mentre la generazione di immagini ha catturato molta attenzione e ricavi, l’emergere di modelli pratici per la generazione video ha rappresentato un’opportunità di mercato completamente nuova. I primi modelli text-to-video, tra cui Sora di OpenAI, dimostravano ciò che era teoricamente possibile ma erano o non ampiamente disponibili o producevano risultati interessanti per la ricerca ma non utili nella pratica. I video erano spesso senza audio, avevano incoerenze temporali e mancavano della qualità necessaria per un uso professionale. Questo cambiò radicalmente con il rilascio di modelli come Veo3 di Google DeepMind, che rappresentava una vera svolta nella qualità della generazione video. Veo3 poteva generare video con audio sincronizzato, tempistiche e ritmo corretti, perfetta sincronizzazione labiale e qualità visiva vicina agli standard professionali. Il modello era costoso da eseguire—molto più intensivo computazionalmente rispetto alla generazione di immagini—ma la qualità giustificava il costo per molte applicazioni.

L’impatto della generazione video di alta qualità sul business di FAL fu sostanziale. La generazione video creò una nuova fonte di ricavi e attrasse una diversa tipologia di clientela. Mentre la generazione immagini era usata principalmente da sviluppatori individuali, designer e piccoli team creativi, la generazione video attirava grandi imprese interessate a creare contenuti pubblicitari, video marketing e altre applicazioni professionali. FAL collaborò con diversi fornitori di modelli video, tra cui One di Alibaba, Kling di Kuaishou e altri, per offrire una suite completa di opzioni di generazione video. La crescita dei ricavi della piattaforma accelerò ulteriormente, poiché il video divenne una parte sempre più significativa dell’utilizzo totale. Le sfide tecniche della generazione video stimolarono anche l’innovazione nell’infrastruttura di FAL—i modelli video richiedevano strategie di ottimizzazione diverse rispetto ai modelli di immagini, rendendo necessari nuovi kernel custom e approcci architetturali. Il successo della generazione video validò anche la strategia di FAL di costruire una piattaforma in grado di servire più modalità. Invece di specializzarsi solo nella generazione immagini, FAL aveva costruito un’infrastruttura abbastanza flessibile da accogliere modelli di immagini, video e audio, posizionandosi come piattaforma completa per i media generativi.

Man mano che i media generativi sono diventati sempre più centrali nella creazione di contenuti e nello sviluppo di applicazioni, sono emerse piattaforme come FlowHunt per aiutare sviluppatori e team a gestire la complessità dell’integrazione di queste capacità nei loro flussi di lavoro. FlowHunt riconosce che, sebbene piattaforme come FAL abbiano risolto la sfida infrastrutturale dell’esecuzione efficiente dei modelli di media generativi, gli sviluppatori affrontano ancora notevoli difficoltà nell’orchestrare questi modelli all’interno di workflow applicativi più ampi. Una tipica applicazione di media generativi può coinvolgere più passaggi: ricezione della richiesta utente, elaborazione e validazione dell’input, chiamata di uno o più modelli generativi, post-processing dei risultati, salvataggio degli output e gestione delle analytics. FlowHunt offre strumenti per automatizzare e ottimizzare questi flussi di lavoro, consentendo agli sviluppatori di concentrarsi sulla logica applicativa piuttosto che sulla gestione infrastrutturale. Integrandosi con piattaforme come FAL, FlowHunt permette agli sviluppatori di costruire applicazioni sofisticate di media generativi senza dover gestire la complessità sottostante del serving, dell’ottimizzazione e della scalabilità dei modelli.

L’approccio di FlowHunt ai flussi di lavoro nei media generativi enfatizza automazione, affidabilità e osservabilità. La piattaforma consente agli sviluppatori di definire workflow che concatenano più operazioni di media generativi, gestiscono gli errori in modo elegante e forniscono visibilità su ciò che accade a ogni passaggio. Ad esempio, un flusso di creazione contenuti può prevedere la generazione di più variazioni di un’immagine, la selezione della migliore in base a metriche di qualità, l’applicazione di effetti di post-processing e la pubblicazione del risultato. FlowHunt permette agli sviluppatori di definire l’intero flusso in modo dichiarativo, con logica di retry automatica, gestione degli errori e monitoraggio. Questo livello di astrazione è particolarmente prezioso per i team che costruiscono applicazioni di produzione che necessitano di generare contenuti in modo affidabile su larga scala. Gestendo orchestrazione e workflow management, FlowHunt consente agli sviluppatori di concentrarsi sulla logica creativa e di business delle applicazioni, mentre la piattaforma si fa carico della complessità tecnica di coordinare le varie operazioni di media generativi.

La straordinaria crescita del business di FAL e la qualità del suo servizio si fondano su un livello di ottimizzazione tecnica sofisticata che la maggior parte degli utenti non vede mai. La piattaforma ha sviluppato oltre 100 kernel CUDA custom—codice GPU specializzato scritto nel linguaggio CUDA di NVIDIA—che ottimizza operazioni specifiche all’interno dei modelli di media generativi. Questi kernel rappresentano migliaia di ore di ingegneria dedicate a spremere il massimo delle prestazioni dall’hardware GPU. La motivazione per questo livello di ottimizzazione è semplice: ogni millisecondo di riduzione della latenza si traduce in una migliore esperienza utente e in costi infrastrutturali più bassi. Un modello che genera un’immagine il 20% più velocemente significa che la stessa GPU può servire il 20% di utenti in più, migliorando direttamente l’economia della piattaforma. Scrivere kernel custom è una sfida sostanziale. Programmare in CUDA richiede una profonda comprensione dell’architettura GPU, delle gerarchie di memoria e dei principi di calcolo parallelo. Non si tratta di qualcosa che si apprende velocemente o si applica genericamente—ogni kernel deve essere ottimizzato con cura per operazioni e configurazioni hardware specifiche.

Il processo di ottimizzazione parte dal profiling—capire dove si spende davvero il tempo nell’esecuzione del modello. Molti sviluppatori assumono che le operazioni computazionalmente più intensive siano il collo di bottiglia, ma il profiling spesso rivela risultati sorprendenti. A volte il collo di bottiglia è lo spostamento dei dati tra la memoria della GPU e le unità di calcolo, non il calcolo in sé. Altre volte è l’overhead del lancio di molte piccole operazioni GPU invece di batcharle insieme. Gli ingegneri di FAL profilano i modelli in modo approfondito, identificano i veri colli di bottiglia e scrivono kernel custom per risolverli. Ad esempio, possono scrivere un kernel personalizzato che fonde più operazioni insieme, riducendo il traffico di memoria e l’overhead di lancio dei kernel. Oppure possono scrivere un kernel ottimizzato specificamente per le dimensioni e i tipi di dati usati in un particolare modello. Questo livello di ottimizzazione è economicamente giustificato solo se si servono milioni di utenti—l’investimento nello sviluppo dei kernel custom si ripaga grazie all’efficienza migliorata e ai costi infrastrutturali ridotti.

Oltre all’ottimizzazione dei singoli kernel, FAL ha investito in miglioramenti architetturali al modo in cui i modelli vengono serviti. La piattaforma utilizza tecniche come quantizzazione dei modelli (riduzione della precisione dei pesi per usare meno memoria e calcolo), batching dinamico (raggruppamento delle richieste per migliorare l’utilizzo della GPU) e prioritizzazione delle richieste (garantendo che le richieste sensibili alla latenza abbiano la precedenza su quelle orientate al throughput). Queste tecniche richiedono implementazione accurata per mantenere la qualità migliorando l’efficienza. La quantizzazione, ad esempio, può ridurre la dimensione del modello e aumentare la velocità, ma se eseguita in modo scorretto può degradare la qualità degli output. Gli ingegneri di FAL hanno sviluppato strategie di quantizzazione sofisticate che mantengono la qualità ottenendo notevoli guadagni di efficienza. Il batching dinamico richiede la previsione della durata delle singole richieste e il loro raggruppamento per massimizzare l’uso della GPU senza introdurre troppa latenza. Questi miglioramenti architetturali, insieme all’ottimizzazione dei kernel custom, permettono a FAL di raggiungere tassi di utilizzo e prestazioni che sarebbero impossibili con un’infrastruttura generica.

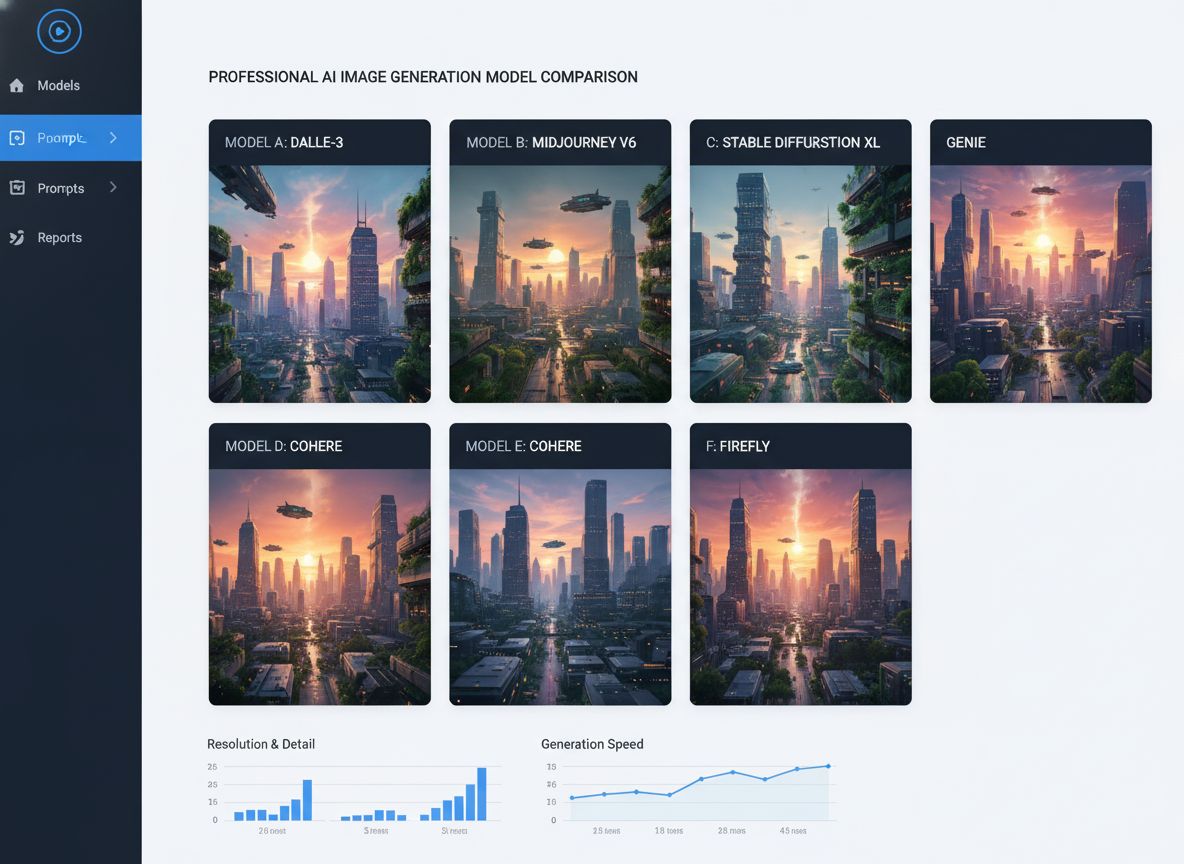

Il mercato dei media generativi si è evoluto rapidamente, con nuovi modelli e capacità che emergono costantemente. Comprendere le dinamiche competitive e la struttura del mercato è essenziale per apprezzare perché piattaforme specializzate come FAL sono diventate così preziose. Il mercato può essere suddiviso grossolanamente in vari segmenti: generazione immagini, generazione video, generazione audio e strumenti di editing/manipolazione. All’interno di ciascun segmento, diversi modelli competono su qualità, velocità, costo e capacità specifiche. Per la generazione immagini, il mercato include varianti di Stable Diffusion, modelli Flux, modelli Gemini Image di Google e altri specializzati per casi d’uso come generazione loghi o sintesi di volti umani. Per la generazione video, il panorama include Veo3, One di Alibaba, Kling di Kuaishou e altri. Questa diversità di modelli crea sia opportunità che sfide per le piattaforme infrastrutturali. L’opportunità è che nessun modello domina tutti i casi d’uso—modelli diversi eccellono in ambiti diversi, quindi una piattaforma che può servire più modelli diventa più preziosa. La sfida è che supportare molti modelli richiede uno sforzo ingegneristico significativo per ottimizzarli uno ad uno.

La strategia di FAL è stata curare una selezione di modelli che copra collettivamente i casi d’uso più importanti mantenendo alti standard qualitativi. Invece di aggiungere ogni modello rilasciato, FAL valuta attentamente i nuovi modelli e li aggiunge solo se offrono capacità uniche o qualità significativamente migliore rispetto alle opzioni esistenti. Questo approccio di curation ha diversi benefici. Primo, garantisce che la selezione di modelli della piattaforma sia di qualità e utile invece di sommergere gli utenti con troppe opzioni mediocri. Secondo, permette a FAL di concentrare gli sforzi di ottimizzazione su modelli che verranno effettivamente usati, invece di disperdere le risorse. Terzo, crea un ciclo virtuoso in cui la reputazione della piattaforma per la qualità attrae sia utenti che creatori di modelli. I creatori di modelli vogliono vedere i loro modelli su FAL perché sanno che gli utenti della piattaforma sono interessati alla qualità. Gli utenti vogliono usare FAL perché sanno che i modelli disponibili sono selezionati con cura e ben ottimizzati. Questo feedback positivo è stato cruciale per il successo di FAL.

Il panorama competitivo include anche altre piattaforme infrastrutturali che servono media generativi, così come la concorrenza diretta dei creatori di modelli che offrono il proprio hosting. Alcuni creatori di modelli, come Stability AI, hanno offerto le proprie API di inferenza. Altri, come Black Forest Labs con Flux, hanno preferito collaborare con piattaforme come FAL invece di costruire infrastruttura propria. La decisione tra partnership e sviluppo interno è strategica—costruire la propria infrastruttura richiede risorse ingegneristiche e competenze operative notevoli, mentre collaborare consente di concentrarsi sullo sviluppo dei modelli. Per la maggior parte dei creatori di modelli, collaborare con piattaforme specializzate come FAL ha più senso che costruire infrastruttura propria. Questa dinamica ha creato un ecosistema sano in cui i creatori di modelli si concentrano su ricerca e sviluppo, mentre le piattaforme infrastrutturali si concentrano su ottimizzazione e scalabilità.

Comprendere il modello di business e le metriche di FAL offre uno sguardo su come le aziende infrastrutturali nei media generativi creano valore e scalano. FAL opera con un modello di pricing a consumo, in cui i clienti pagano in base al numero di chiamate API effettuate e alle risorse computazionali utilizzate. Questo modello allinea bene gli incentivi—i clienti pagano di più se usano di più, e i ricavi di FAL crescono man mano che la piattaforma diventa più preziosa e utilizzata. Le metriche di crescita della piattaforma sono impressionanti: 2 milioni di sviluppatori, oltre 350 modelli disponibili e più di 100 milioni di dollari di ricavi annuali. Questi numeri riflettono una scala importante, ma anche lo stadio ancora iniziale del mercato dei media generativi. La penetrazione tra gli utenti potenziali è ancora relativamente bassa e molti casi d’uso restano da esplorare. La crescita dei ricavi ha subito un’accelerazione, specialmente con l’introduzione delle capacità video. I ricavi della piattaforma sono passati da 2 a 10 milioni di dollari nel primo mese dopo il rilascio di Flux, a dimostrazione dell’impatto che i modelli di alta qualità hanno sui ricavi delle piattaforme infrastrutturali.

Le metriche di business rivelano anche insight importanti sulle dinamiche di mercato. Il fatto che FAL abbia raggiunto oltre 100 milioni di dollari di ricavi annui servendo 2 milioni di sviluppatori suggerisce che il ricavo medio per utente sia relativamente modesto—circa 50-100 dollari l’anno. Ciò riflette il fatto che molti utenti stanno ancora sperimentando i media generativi o li usano su piccola scala. Tuttavia, la distribuzione è probabilmente molto sbilanciata, con una piccola percentuale di power user che genera una grande parte dei ricavi. Questi utenti sono tipicamente aziende che integrano capacità di media generativi nei propri prodotti o servizi. Man mano che il mercato matura e più aziende integrano i media generativi nelle proprie attività core, il ricavo medio per utente aumenterà sensibilmente. La traiettoria di crescita della piattaforma suggerisce che l’infrastruttura per i media generativi sia ancora nelle prime fasi di una curva di crescita a lungo termine, con ampie opportunità future.

Uno degli sviluppi più importanti nel mercato dei media generativi è stato l’emergere di capacità di fine-tuning e personalizzazione che permettono agli utenti di adattare i modelli a casi d’uso specifici. Il fine-tuning consiste nel prendere un modello pre-addestrato e addestrarlo ulteriormente su dati di dominio per migliorarne le prestazioni su compiti particolari. Per la generazione immagini, ciò si è concretizzato principalmente sotto forma di LoRA (Low-Rank Adaptations), che sono modifiche leggere del modello base per personalizzarlo senza doverlo riaddestrare completamente. Un designer può creare una LoRA che insegna al modello a generare immagini in uno stile artistico specifico. Un fotografo può creare una LoRA che cattura la propria estetica. Un’azienda può creare una LoRA che genera immagini dei propri prodotti in contesti particolari. L’ecosistema delle LoRA è diventato cruciale per il mercato dei media generativi, con migliaia di LoRA disponibili per modelli popolari come Stable Diffusion e SDXL.

L’emergere del fine-tuning ha importanti implicazioni per le piattaforme infrastrutturali come FAL. Supportare il fine-tuning richiede capacità aggiuntive oltre al semplice serving dei modelli base. La piattaforma deve offrire strumenti per creare e gestire le LoRA, archiviarle in modo efficiente e servirle insieme ai modelli base. Deve anche affrontare le sfide tecniche di combinare modelli base e LoRA in fase di inferenza, garantendo che la combinazione produca risultati di qualità senza latenza eccessiva. FAL ha investito molto in queste capacità, riconoscendo che il fine-tuning è un elemento chiave della proposta di valore per molti utenti. Il supporto al fine-tuning è stato un fattore importante nel successo della piattaforma, consentendo agli utenti di personalizzare i modelli in base alle proprie esigenze pur beneficiando dell’ottimizzazione e della scalabilità della piattaforma. Con la maturazione del mercato, fine-tuning e personalizzazione diventeranno sempre più centrali, con le aziende pronte a investire in modelli customizzati per i propri casi d’uso.

Guardando avanti, il mercato dell’infrastruttura per i media generativi continuerà probabilmente a evolversi rapidamente. Diversi trend plasmeranno il futuro. Primo, i modelli continueranno a migliorare in qualità e capacità, abilitando nuovi casi d’uso e attirando nuovi utenti. La generazione video è ancora agli inizi e, con il progresso dei modelli, è probabile che diventi ubiqua come la generazione immagini. Generazione audio e musica stanno emergendo come nuovi fronti, con modelli come PlayHD e altri che mostrano potenzialità. Secondo, il mercato tenderà a consolidarsi attorno a un numero più limitato di modelli e piattaforme dominanti, similmente

I media generativi si riferiscono ai sistemi di intelligenza artificiale che creano immagini, video e contenuti audio. A differenza dei modelli linguistici che competono con motori di ricerca e grandi aziende tech, i media generativi rappresentano un nuovo segmento di mercato con requisiti tecnici unici per l'ottimizzazione dell'inferenza e la scalabilità multi-tenant.

FAL ha riconosciuto che l'hosting di modelli linguistici avrebbe richiesto di competere contro OpenAI, Anthropic e Google—aziende con risorse enormi. I media generativi erano un mercato di nicchia in rapida crescita senza concorrenti consolidati, consentendo a FAL di definire il mercato e diventare leader nell'ottimizzazione dell'inferenza per modelli di immagini, video e audio.

Stable Diffusion 1.5 è stato il primo grande punto di svolta per FAL. Ha dimostrato che gli sviluppatori avevano bisogno di un'inferenza ottimizzata e pronta per l'API piuttosto che gestire i propri deployment. Questa consapevolezza ha portato FAL a passare da un runtime Python generico a una piattaforma specializzata per media generativi.

I modelli Flux, rilasciati da Black Forest Labs, sono stati i primi a raggiungere una qualità 'commercialmente utilizzabile e pronta per l'impresa'. Hanno portato il fatturato di FAL da 2 a 10 milioni di dollari nel primo mese, poi a 20 milioni il mese successivo, affermando i media generativi come un mercato commerciale sostenibile.

FAL ha sviluppato oltre 100 kernel CUDA custom per ottimizzare le prestazioni di inferenza per diversi modelli. Questi kernel permettono tempi di generazione più rapidi, migliore utilizzo della GPU e scalabilità multi-tenant—fattori critici per servire 2 milioni di sviluppatori e oltre 350 modelli in modo efficiente.

La generazione video, in particolare con modelli come Veo3, ha creato un nuovo segmento di mercato. I primi modelli text-to-video producevano contenuti di bassa qualità e senza audio. I modelli moderni con audio, tempistiche corrette e sincronizzazione labiale hanno reso la generazione video commercialmente valida e aperto nuovi casi d'uso in pubblicità e creazione di contenuti.

Arshia è una AI Workflow Engineer presso FlowHunt. Con una formazione in informatica e una passione per l'IA, è specializzata nella creazione di workflow efficienti che integrano strumenti di intelligenza artificiale nelle attività quotidiane, migliorando produttività e creatività.

Scopri come FlowHunt semplifica la generazione di contenuti AI, dalla selezione del modello al deployment e all'ottimizzazione.

Scopri come il modello di immagini Gemini 2.5 Flash di Google sta trasformando le industrie creative con funzionalità avanzate di fotoritocco, estrazione 3D, re...

Confronto completo tra i principali modelli di generazione di immagini AI, tra cui Qwen ImageEdit Plus, Nano Banana, GPT Image 1 e Seadream. Scopri quale modell...

Scopri come il reinforcement learning e il fine-tuning sono diventati l’approccio dominante per ottimizzare i modelli AI, dalla distillazione di GPT-4 all’asces...

Consenso Cookie

Usiamo i cookie per migliorare la tua esperienza di navigazione e analizzare il nostro traffico. See our privacy policy.