Introduzione

Costruire agenti AI efficaci richiede più che semplicemente collegare modelli linguistici agli strumenti. La vera sfida sta nel modo in cui gli agenti ragionano su problemi complessi, gestiscono grandi quantità di informazioni ed eseguono flussi di lavoro multi-step in modo efficiente. In questa guida completa esploriamo tecniche avanzate di implementazione di agenti AI, con particolare attenzione alla pianificazione—una capacità critica che distingue gli agenti ad alte prestazioni dalle implementazioni base. La pianificazione permette agli agenti AI di suddividere compiti complessi in step gestibili, superare i limiti della finestra di contesto ed eseguire i flussi di lavoro più rapidamente e in modo più economico. Che tu stia creando agenti di ricerca, sistemi di automazione o assistenti intelligenti, comprendere come implementare la pianificazione nei tuoi agenti AI ne migliorerà sensibilmente prestazioni e affidabilità.

Cosa Sono gli Agenti AI e Perché Sono Importanti?

Gli agenti di intelligenza artificiale rappresentano un cambiamento fondamentale nell’approccio alla risoluzione dei problemi con i modelli linguistici. A differenza delle applicazioni tradizionali che elaborano input e producono output in un solo passaggio, gli agenti AI operano come sistemi autonomi che possono percepire l’ambiente, prendere decisioni ed eseguire azioni in modo iterativo. Un agente AI tipicamente è composto da un modello linguistico (il “cervello”), un insieme di strumenti o funzioni che può invocare, e un ciclo di controllo che determina quando usare quale strumento. Questa architettura permette agli agenti di gestire compiti complessi e multi-step che sarebbero impossibili da realizzare con una sola chiamata LLM. Ad esempio, un agente potrebbe dover cercare informazioni sul web, elaborarle, fare calcoli e poi sintetizzare tutto in una risposta coerente. Il valore degli agenti risiede nella loro capacità di ragionare su quali step siano necessari ed eseguirli in sequenza, imparando dal risultato di ogni step per informare l’azione successiva.

L’importanza degli agenti AI è cresciuta esponenzialmente poiché le organizzazioni ne riconoscono il potenziale per automazione, ricerca, customer service e knowledge work. Le aziende implementano sempre più spesso agenti per gestire attività come analisi dati, generazione di contenuti, supporto clienti e risoluzione di problemi complessi. Tuttavia, man mano che gli agenti diventano più sofisticati e affrontano problemi più complessi, incontrano sfide significative. Una delle più critiche è la gestione dei limiti dei modelli linguistici, in particolare la loro finestra di contesto—la quantità massima di testo che possono elaborare in un’unica volta. Quando gli agenti devono lavorare con documenti lunghi, risultati di ricerca estesi o workflow multi-step complessi, si verifica rapidamente una perdita di accuratezza e problemi di performance. È qui che la pianificazione diventa essenziale.

Pronto a far crescere il tuo business?

Inizia oggi la tua prova gratuita e vedi i risultati in pochi giorni.

Comprendere il Problema della Finestra di Contesto: Perché la Pianificazione è Importante

La limitazione della finestra di contesto rappresenta una delle sfide più significative nella progettazione moderna di agenti AI. Sebbene i recenti progressi abbiano portato le finestre di contesto a 100.000 token o più, la ricerca ha rivelato un fenomeno controintuitivo: finestre di contesto più grandi non significano automaticamente prestazioni migliori. Questo fenomeno, chiamato “context rot” dai ricercatori di Chroma, dimostra che i modelli linguistici hanno difficoltà a recuperare e processare accuratamente informazioni da contesti di token enormi. In scenari pratici, quando un LLM deve trovare una specifica informazione nascosta all’interno di 10.000 token di testo, la sua accuratezza cala significativamente rispetto a quando la stessa informazione è presentata in un contesto più ristretto. Il problema è ancora più evidente quando il contesto contiene “distrattori”—informazioni correlate alla query ma che non la rispondono realmente.

Il team di ricerca di Chroma ha condotto valutazioni approfondite usando una versione migliorata del test “ago nel pagliaio”, che misura tradizionalmente la capacità dei modelli di trovare informazioni specifiche in documenti lunghi. Tuttavia, il test tradizionale aveva un difetto: non considerava scenari reali in cui i documenti contengono informazioni correlate ma fuorvianti. Introdurre i distrattori—paragrafi che trattano l’argomento ma non rispondono alla domanda specifica—ha mostrato che l’accuratezza dei modelli cala drasticamente. Ad esempio, Claude 4.5 mantiene una migliore accuratezza rispetto ad altri modelli in diversi scenari di distrattori, ma anche i migliori modelli mostrano un notevole degrado delle prestazioni all’aumentare della lunghezza del contesto. Questa ricerca ha cambiato radicalmente il modo in cui gli sviluppatori pensano la costruzione di agenti AI: invece di affidarsi agli agenti per cercare tra contesti enormi, dobbiamo aiutarli a pianificare l’approccio e suddividere i problemi in parti più gestibili.

Come la Pianificazione Risolve il Problema di Contesto

La pianificazione rappresenta un cambio di paradigma nell’architettura degli agenti AI. Invece di far rispondere reattivamente l’agente a ciascun step e cercare tra contesti enormi, la pianificazione forza l’agente a ragionare sull’intero problema in anticipo e a creare un approccio strutturato. È analogo a come gli umani risolvono problemi complessi: non iniziamo a lavorare a caso, ma prima comprendiamo il problema, lo suddividiamo in step e creiamo un piano. Quando un agente AI crea un piano prima di eseguire, può concentrarsi su sotto-compiti specifici con solo il contesto realmente rilevante per quello step. Questo riduce drasticamente il carico cognitivo sul modello linguistico e ne migliora l’accuratezza. Ad esempio, invece di chiedere a un LLM di cercare tra un documento di 50.000 token per trovare più informazioni, un agente di pianificazione prima crea un piano come: “Step 1: Trova informazioni su X, Step 2: Trova informazioni su Y, Step 3: Sintetizza entrambi i punti.” Poi, per ogni step, l’agente lavora solo con la parte di contesto rilevante, mantenendo alta l’accuratezza.

L’approccio di pianificazione permette agli agenti di gestire workflow complessi in modo più efficiente. Quando un agente ha un piano chiaro, può identificare quali step possono essere eseguiti in parallelo, quali dipendono da altri e come ottimizzare l’esecuzione complessiva. Questo è particolarmente prezioso in scenari in cui vanno invocati più strumenti o effettuate più chiamate API. Invece di fare chiamate sequenziali aspettando ogni volta il risultato, un agente ben pianificato può individuare task indipendenti ed eseguirli simultaneamente. Questa capacità di parallelizzazione può ridurre i tempi di esecuzione di 3-4 volte rispetto agli agenti reattivi tradizionali, come dimostrato da architetture avanzate come LLMCompiler. Inoltre, la pianificazione consente una migliore gestione degli errori e il recupero: quando un agente ha un piano e qualcosa va storto, può ripianificare da quel punto invece di ricominciare da capo, rendendo il sistema più robusto ed efficiente.

Iscriviti alla nostra newsletter

Ricevi gratuitamente gli ultimi consigli, tendenze e offerte.

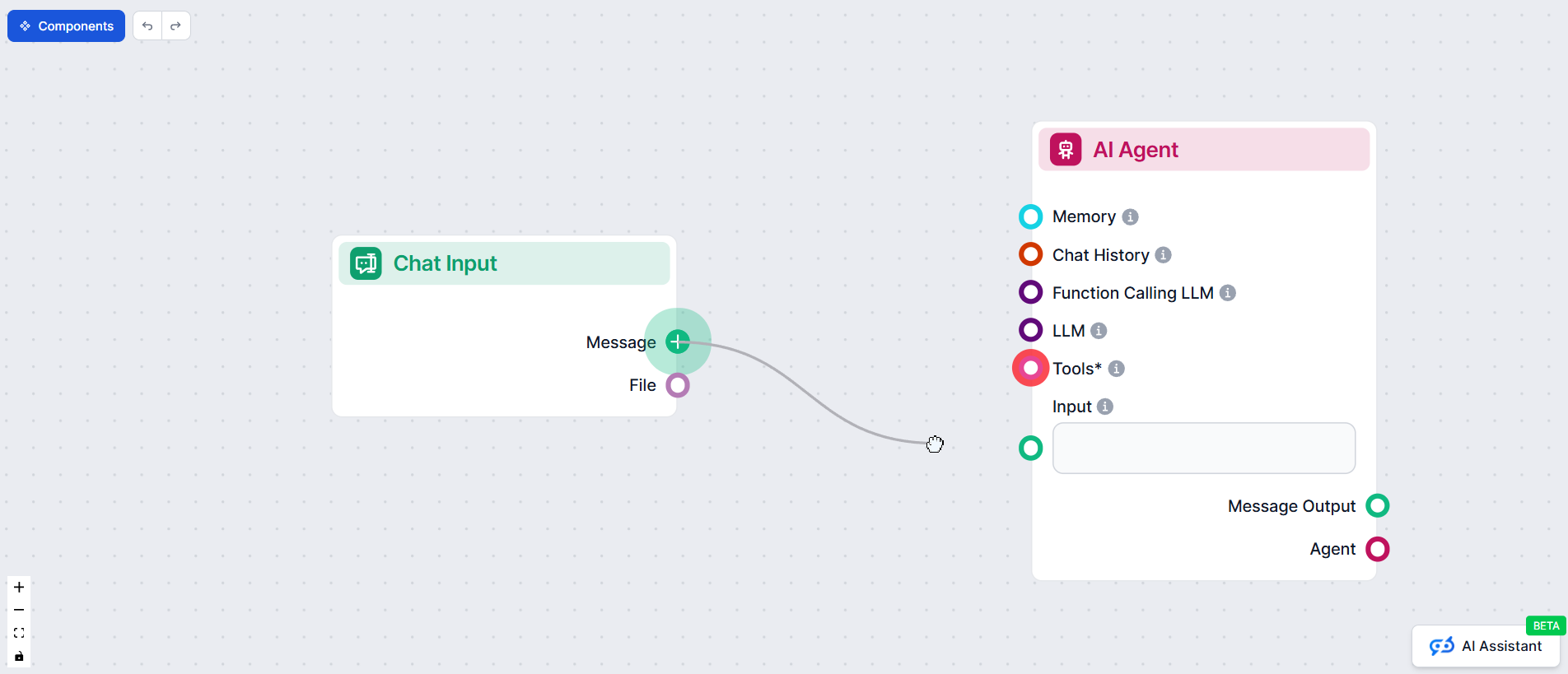

FlowHunt e l’Automazione degli Agenti AI: Semplificare Flussi Complessi

FlowHunt offre una piattaforma potente per costruire e automatizzare flussi di lavoro agenti AI senza richiedere competenze tecniche approfondite. La piattaforma consente agli utenti di progettare architetture di agenti sofisticate, inclusi agenti basati sulla pianificazione, tramite un’interfaccia no-code intuitiva. Con FlowHunt puoi definire stati dell’agente, creare step di pianificazione, configurare integrazioni con strumenti e monitorare l’esecuzione dell’agente—tutto senza scrivere codice complesso. Questo democratizza lo sviluppo di agenti AI, permettendo ai team di realizzare sistemi di automazione avanzati che tradizionalmente avrebbero richiesto risorse ingegneristiche importanti. L’approccio di FlowHunt all’automazione degli agenti si allinea perfettamente con l’architettura di pianificazione trattata in questo articolo, consentendo agli utenti di creare agenti che suddividono compiti complessi in step gestibili, mantengono l’accuratezza su grandi quantità di informazioni ed eseguono in modo efficiente.

La piattaforma offre anche monitoraggio integrato e analytics sulle prestazioni degli agenti, aiutando i team a capire dove gli agenti hanno successo e dove devono migliorare. Questo è fondamentale per iterare sul design degli agenti e ottimizzare il loro comportamento nel tempo. FlowHunt si integra con i principali provider di LLM e con ecosistemi di strumenti, rendendo facile collegare gli agenti alle risorse necessarie. Che tu stia costruendo agenti di ricerca che devono esplorare il web e sintetizzare informazioni, agenti di automazione che coordinano sistemi multipli, o agenti di customer service che gestiscono richieste complesse, FlowHunt offre l’infrastruttura per farlo in modo efficiente.

LangGraph: La Base per l’Implementazione Avanzata di Agenti AI

LangGraph è un framework specificamente progettato per costruire agenti AI stateful con architettura a macchina a stati. Alla base, LangGraph rappresenta i flussi di lavoro degli agenti come grafi orientati, dove ogni nodo rappresenta uno stato o un’azione e gli archi rappresentano le transizioni tra stati. Questo approccio basato su grafi offre diversi vantaggi rispetto alla programmazione sequenziale tradizionale: rende la logica dell’agente esplicita e visualizzabile, abilita flussi di controllo complessi inclusi loop e rami condizionali, e fornisce una struttura chiara per la gestione dello stato durante tutta l’esecuzione dell’agente. Quando costruisci un agente in LangGraph, in sostanza stai definendo una macchina a stati che l’agente seguirà per completare un compito.

Il concetto di macchina a stati è fondamentale per comprendere il funzionamento degli agenti avanzati. In un agente LangGraph, lo stato contiene tutte le informazioni necessarie all’agente per prendere decisioni ed eseguire azioni. Per un agente basato sulla pianificazione, questo stato potrebbe includere la richiesta originale dell’utente, il piano corrente, i task completati, i task in sospeso e ogni risultato dall’invocazione degli strumenti. Man mano che l’agente procede nel suo workflow, aggiorna questo stato a ogni step. Ad esempio, quando l’agente completa un task, aggiorna lo stato segnando il compito come completato e memorizzando il risultato. Quando deve decidere cosa fare dopo, esamina lo stato attuale e determina l’azione successiva più appropriata. Questo approccio garantisce che l’agente abbia sempre accesso a tutte le informazioni di cui ha bisogno e possa mantenere coerenza durante tutta l’esecuzione.

Implementare la Pianificazione in LangGraph: Il Deep Agent State

L’implementazione della pianificazione in LangGraph consiste nella creazione di uno stato strutturato che tiene traccia dell’avanzamento dell’agente nel suo piano. Il “Deep Agent State” è una struttura dati che contiene due componenti principali: todos (compiti da completare) e files (informazioni raccolte). Ogni todo nello stato rappresenta un compito specifico che l’agente deve portare a termine, con proprietà che includono la descrizione del compito e il suo stato attuale (in sospeso, in corso o completato). Questa struttura permette all’agente di mantenere un registro chiaro di cosa deve essere fatto, cosa è in corso e cosa è già stato completato. Il tracking dello stato è essenziale perché consente all’agente di comprendere i propri progressi e prendere decisioni intelligenti su cosa fare dopo.

L’implementazione include anche un pattern reducer per la gestione degli aggiornamenti dello stato, in particolare quando più compiti vengono eseguiti in parallelo. Un reducer è una funzione che prende lo stato attuale e un aggiornamento e produce un nuovo stato. Questo pattern è fondamentale in LangGraph perché garantisce che, quando più thread o esecuzioni parallele aggiornano lo stato contemporaneamente, gli aggiornamenti siano orchestrati correttamente e nessuna informazione venga persa. Ad esempio, se due task finiscono nello stesso momento e cercano entrambi di aggiornare lo stato, il reducer assicura che entrambi gli aggiornamenti siano integrati correttamente. Questo è un concetto sofisticato che distingue le implementazioni agenti di livello produttivo dai semplici prototipi. Il pattern reducer abilita anche scenari di gestione dello stato più complessi, come aggregare i risultati di task paralleli o gestire conflitti quando parti diverse dell’agente cercano di aggiornare le stesse informazioni.

Il Workflow dell’Agente di Pianificazione: Dalla Query all’Esecuzione

Un agente di pianificazione segue un workflow specifico che mostra come la pianificazione migliori le prestazioni dell’agente. Quando un utente fornisce una richiesta, l’agente entra prima in una fase di pianificazione in cui usa il modello linguistico per generare un piano completo per affrontare la query. Questo piano suddivide il compito complesso in step più piccoli e gestibili. Ad esempio, se un utente chiede “Dammi un breve riassunto di MCP (Model Context Protocol)”, l’agente potrebbe creare un piano come: “Step 1: Cerca informazioni su MCP, Step 2: Comprendi cos’è MCP e le sue caratteristiche chiave, Step 3: Sintetizza le informazioni in un riassunto conciso.” L’agente scrive questi step nella sua todo list nello stato, segnando ciascuno come in sospeso.

Una volta creato il piano, l’agente entra nella fase di esecuzione. Legge la todo list e inizia a lavorare su ciascun compito in sequenza. Per il primo task (cercare informazioni), l’agente invoca lo strumento di ricerca web con una query appropriata. I risultati vengono restituiti e memorizzati nello stato. L’agente quindi segna il compito come completato e passa al task successivo. Per il secondo task, l’agente può usare il modello linguistico per processare e comprendere i risultati della ricerca, estraendo le informazioni chiave su MCP. Anche questo risultato viene memorizzato nello stato e il compito viene segnato come completato. Infine, per il terzo task, l’agente sintetizza tutte le informazioni raccolte in un riassunto conciso che risponde direttamente alla richiesta iniziale dell’utente. Durante tutto questo processo, l’agente mantiene un registro chiaro di cosa ha fatto, cosa sta facendo e cosa resta da fare. Questo approccio strutturato assicura che l’agente non perda traccia dei progressi e possa gestire in modo affidabile compiti complessi e multi-step.

Architetture di Pianificazione Avanzata: Oltre la Pianificazione Base

Sebbene la pianificazione base rappresenti un grande miglioramento rispetto agli agenti reattivi, esistono diverse architetture avanzate che spingono la pianificazione ancora oltre. L’architettura Plan-and-Execute è l’approccio di pianificazione fondamentale, dove l’agente crea un piano e poi lo esegue step by step. Tuttavia, questa architettura ha dei limiti: esegue i task in modo sequenziale e ogni step richiede comunque una chiamata LLM. L’architettura ReWOO (Reasoning WithOut Observations) risolve alcune di queste limitazioni permettendo al planner di usare assegnazioni di variabili. In ReWOO il planner può fare riferimento ai risultati di step precedenti usando una sintassi come “#E2” (l’output del task 2), consentendo ai task di dipendere dai risultati precedenti senza richiedere di consultare il planner dopo ogni step. Questo riduce il numero di chiamate LLM e permette un’esecuzione dei task più efficiente.

L’architettura LLMCompiler rappresenta lo stato dell’arte nella progettazione di agenti basati sulla pianificazione. Introduce diverse innovazioni che migliorano drasticamente le prestazioni. Primo, il planner produce un grafo aciclico diretto (DAG) dei task invece di una semplice lista. Ogni task nel DAG include lo strumento da invocare, gli argomenti da passare e una lista di dipendenze (quali altri task devono essere completati prima di eseguire questo). Secondo, l’unità di fetching dei task riceve l’output streamato dal planner e programma l’avvio dei task non appena le dipendenze sono soddisfatte. Questo abilita una massiccia parallelizzazione: se il planner individua dieci task indipendenti, tutti possono essere eseguiti simultaneamente invece che in sequenza. Terzo, gli argomenti dei task possono essere variabili che fanno riferimento agli output di step precedenti, permettendo all’agente di lavorare ancora più rapidamente rispetto alla tradizionale esecuzione parallela degli strumenti. La combinazione di queste caratteristiche può offrire un incremento di velocità di 3,6 volte rispetto agli agenti tradizionali, secondo il paper di ricerca. Queste architetture avanzate dimostrano che la pianificazione non è una tecnica unica, ma uno spettro di approcci, ciascuno con diversi compromessi tra complessità, performance e costi.

Strumenti e Integrazione: Equipaggiare il Tuo Agente di Pianificazione

Affinché un agente di pianificazione sia efficace, deve avere accesso agli strumenti adatti per raccogliere informazioni ed eseguire azioni. Gli strumenti più comuni includono la ricerca web (per trovare informazioni online), query su database (per accedere a dati strutturati), chiamate API (per interagire con servizi esterni) e chiamate al modello linguistico (per processare e ragionare sulle informazioni). Nell’implementazione LangGraph, gli strumenti vengono forniti all’agente tramite un’interfaccia progettata con cura. L’agente può invocare strumenti generando chiamate funzione specifiche e i risultati vengono restituiti all’agente per l’elaborazione. Il segreto di un’integrazione efficace degli strumenti è assicurarsi che ogni tool sia ben definito con input e output chiari, e che l’agente comprenda quando e come usare ogni tool.

Oltre agli strumenti base, gli agenti di pianificazione avanzati includono spesso tool specializzati per la gestione del proprio stato e dei progressi. Ad esempio, uno strumento “read todos” permette all’agente di esaminare il suo piano attuale e capire quali compiti restano. Uno strumento “write todos” consente di aggiornare il piano, segnare i task come completati o aggiungere nuovi task in base a ciò che viene appreso durante l’esecuzione. Questi meta-tool (strumenti che operano sullo stato dell’agente stesso) sono essenziali per permettere all’agente di adattare il piano man mano che apprende nuove informazioni. Se durante l’esecuzione l’agente scopre che il piano originale era incompleto o errato, può usare lo strumento write todos per rivedere il piano. Questa capacità di pianificazione adattiva distingue le implementazioni agenti di livello produttivo dai prototipi semplici. La combinazione di strumenti specifici per il dominio (per il lavoro vero e proprio) e meta-tool (per la gestione del ragionamento e della pianificazione dell’agente stesso) crea un sistema potente in grado di gestire scenari complessi e imprevedibili.

Esempio Pratico: Implementare un Agente di Ricerca

Per illustrare come funziona la pianificazione nella pratica, consideriamo un agente di ricerca incaricato di raccogliere informazioni su un argomento complesso. Ricevuta la query “Fornisci una panoramica completa del Model Context Protocol (MCP) e delle sue applicazioni”, l’agente seguirà questo workflow. Prima crea un piano: “Step 1: Cerca informazioni generali su MCP, Step 2: Cerca casi d’uso e applicazioni di MCP, Step 3: Cerca dettagli tecnici sull’implementazione di MCP, Step 4: Sintetizza tutte le informazioni in una panoramica completa.” L’agente scrive questi quattro task nella sua todo list, tutti segnati come in sospeso. Inizia quindi l’esecuzione: per lo Step 1 invoca il tool di ricerca web con la query “Cos’è il Model Context Protocol MCP?” e riceve i risultati della ricerca. Segna lo Step 1 come completato e memorizza i risultati. Per lo Step 2 cerca “applicazioni e casi d’uso MCP”, memorizzando di nuovo i risultati. Per lo Step 3 cerca dettagli tecnici di implementazione. Infine, per lo Step 4, usa il modello linguistico per sintetizzare tutte le informazioni raccolte in una panoramica coerente e completa che risponda alla query originale.

Durante tutto questo processo, l’agente mantiene un registro chiaro dei progressi. Se in qualsiasi momento scopre che il piano è incompleto (ad esempio, se i risultati della ricerca non forniscono abbastanza informazioni su un aspetto specifico), può rivedere il piano aggiungendo nuovi task. Questa capacità adattiva è cruciale per gestire scenari reali dove il piano iniziale può non essere sufficiente. L’agente potrebbe scoprire che servono ulteriori dettagli su implementazioni MCP specifiche, o che deve capire come MCP si confronta con approcci alternativi. Potendo rivedere il piano durante l’esecuzione, l’agente può gestire queste scoperte in modo efficace invece di fallire o fornire informazioni incomplete. Questo esempio mostra la potenza della pianificazione: fornisce struttura e chiarezza al ragionamento dell’agente, mantenendo la flessibilità di adattarsi quando emergono nuove informazioni.

{{ cta-dark-panel

heading=“Potenzia il Tuo Flusso di Lavoro con FlowHunt”

description=“Scopri come FlowHunt automatizza i tuoi flussi di contenuti e SEO con l’AI — dalla ricerca e generazione di contenuti fino alla pubblicazione e analytics — tutto in un’unica piattaforma.”

ctaPrimaryText=“Prenota una Demo”

ctaPrimaryURL=“https://calendly.com/liveagentsession/flowhunt-chatbot-demo"

ctaSecondaryText=“Prova FlowHunt Gratis”

ctaSecondaryURL=“https://app.flowhunt.io/sign-in"

gradientStartColor="#123456”

gradientEndColor="#654321”

gradientId=“827591b1-ce8c-4110-b064-7cb85a0b1217”

}}

Ottimizzazione delle Prestazioni: Ridurre i Costi e Migliorare la Velocità

Uno dei motivi più convincenti per implementare la pianificazione negli agenti AI è il notevole miglioramento delle metriche di performance. Gli agenti in stile ReAct tradizionale richiedono una chiamata LLM per ogni azione, quindi un compito con dieci step richiederebbe dieci chiamate LLM. Gli agenti basati sulla pianificazione, al contrario, di solito richiedono solo due o tre chiamate LLM: una per la fase iniziale di pianificazione, una o più per eseguire task specifici che richiedono ragionamento, e potenzialmente una per la ripianificazione se il piano iniziale si rivela insufficiente. Questa riduzione nelle chiamate LLM si traduce direttamente in risparmi sui costi, soprattutto usando modelli costosi come GPT-4. Per le organizzazioni che eseguono migliaia di agenti ogni giorno, la differenza di costi tra agenti ReAct e agenti basati sulla pianificazione può essere sostanziale—fino a decine di migliaia di dollari risparmiati ogni mese.

Oltre al risparmio, la pianificazione consente notevoli miglioramenti di velocità. Negli agenti tradizionali ogni step deve concludersi prima che inizi il successivo, creando un collo di bottiglia sequenziale. Gli agenti di pianificazione, soprattutto quelli che usano architetture DAG come LLMCompiler, possono identificare task indipendenti ed eseguirli in parallelo. Se un task richiede una ricerca su un argomento A e un altro su un argomento B, e questi sono indipendenti, possono avvenire simultaneamente. Questa parallelizzazione può ridurre il tempo totale di esecuzione di 3-4 volte rispetto all’esecuzione sequenziale. Per le applicazioni rivolte all’utente, questo si traduce in una migliore esperienza. Per i processi batch, significa poter completare più lavoro nello stesso tempo. La combinazione di risparmio e velocità rende gli agenti basati sulla pianificazione interessanti per qualsiasi organizzazione che utilizzi agenti AI su larga scala.

Gestire la Complessità: Quando i Piani Devono Adattarsi

Gli scenari reali raramente seguono piani perfetti. Gli agenti di pianificazione devono saper gestire situazioni in cui il piano iniziale risulta insufficiente o errato. Questo richiede una sofisticata gestione degli errori e capacità di ripianificazione. Quando un agente si trova di fronte a una situazione imprevista—ad esempio uno strumento che restituisce errore, la ricerca che non produce risultati attesi, o la scoperta che il compito è più complesso del previsto—deve adattarsi. L’approccio più efficace è consentire all’agente di ripianificare in base a ciò che ha appreso. Ad esempio, se il piano iniziale prevedeva una ricerca e successiva sintesi, ma la ricerca non produce risultati, l’agente deve riconoscerlo e rivedere il piano. Potrebbe provare query diverse, cercare fonti alternative o suddividere ulteriormente il compito.

Implementare una pianificazione adattiva richiede una gestione dello stato e una logica decisionale attente. L’agente deve tracciare non solo cosa ha fatto, ma anche cosa ha appreso sul problema. Se una ricerca su “MCP” non produce risultati, l’agente dovrebbe provare “Model Context Protocol” o “protocollo MCP” prima di rinunciare. Se una chiamata a uno strumento fallisce, l’agente deve decidere se riprovare, usare uno strumento diverso o segnalare il problema. Queste decisioni richiedono che l’agente ragioni sui propri progressi e adatti la strategia di conseguenza. Qui si evidenzia il vantaggio dell’agente di pianificazione: avendo un piano esplicito, può ragionare se il piano stia funzionando e prendere decisioni informate su come adattarsi. Un agente reattivo, al contrario, non ha questa struttura e deve decidere tutto “al volo” senza una visione d’insieme.

Monitoraggio e Debug degli Agenti di Pianificazione

Man mano che gli agenti di pianificazione diventano più sofisticati, il monitoraggio e il debug diventano sempre più importanti. A differenza delle applicazioni semplici in cui è facile tracciare il percorso di esecuzione, gli agenti di pianificazione coinvolgono molteplici punti decisionali, invocazioni di strumenti e aggiornamenti dello stato. Un monitoraggio efficace richiede visibilità su diversi aspetti dell’esecuzione dell’agente: il piano creato, i task completati, i risultati di ogni tool, e le decisioni prese ad ogni step. LangGraph offre supporto integrato tramite LangSmith, una piattaforma di monitoraggio e debug che visualizza l’esecuzione dell’agente come un grafo. Puoi vedere esattamente quali nodi sono stati eseguiti, in che ordine, e quale stato è stato passato tra di essi. Questa visualizzazione è preziosa per comprendere perché un agente si sia comportato in un certo modo e dove sia possibile migliorare.

Il debug degli agenti di pianificazione richiede anche comprensione dei prompt usati per generare i piani. La qualità del piano incide direttamente sulle prestazioni dell’agente, quindi se le performance sono scarse, analizzare il prompt di pianificazione è spesso il primo passo. Potresti scoprire che il prompt non fornisce abbastanza contesto sul compito, o che non spiega chiaramente quale tipo di piano si desidera. Iterare sui prompt di pianificazione può spesso migliorare drasticamente le prestazioni dell’agente. Inoltre, monitorare i risultati degli strumenti aiuta a capire se stanno restituendo i risultati attesi o se vanno riconfigurati. Ad esempio, se la ricerca web restituisce risultati irrilevanti, potrebbe essere necessario modificare il formato della query o aggiungere filtri. Combinando la visualizzazione del grafo di esecuzione con l’analisi di prompt e risultati degli strumenti, puoi migliorare sistematicamente le prestazioni degli agenti di pianificazione.

Best Practice per Costruire Agenti di Pianificazione

Dalla ricerca e dall’esperienza pratica emergono diverse best practice per costruire agenti di pianificazione efficaci. Primo, investi tempo nella creazione di prompt di pianificazione di qualità. Il prompt deve spiegare chiaramente il compito, fornire esempi di buoni piani e specificare il formato dell’output. Un prompt ben fatto migliora notevolmente la qualità dei piani e riduce la necessità di ripianificare. Secondo, progetta con attenzione la struttura dello stato. Lo stato deve contenere tutte le informazioni necessarie all’agente per decidere, ma non così tante da diventare ingestibile. Uno stato ben progettato rende semplice per l’agente capire i propri progressi e prendere buone decisioni sugli step successivi. Terzo, fornisci strumenti chiari e ben documentati. Ogni tool deve avere uno scopo preciso, input e output definiti e una gestione degli errori. Strumenti ben progettati permettono agli agenti di usarli in modo più efficace e ottenere risultati migliori.

Quarto, implementa una gestione degli errori e una logica di ripianificazione robuste. Supponi che le cose possano andare storte: strumenti che falliscono, ricerche che restituiscono risultati inattesi, piani da rivedere. Prevedi meccanismi per far sì che l’agente rilevi queste situazioni e si adatti di conseguenza. Quinto, monitora e itera. Usa strumenti di monitoraggio per capire come si comportano i tuoi agenti, identifica colli di bottiglia e modalità di fallimento, e migliora i tuoi design. Piccoli miglioramenti nei prompt, nella progettazione degli strumenti o nella gestione dello stato possono avere impatti significativi sulle performance. Sesto, considera il compromesso tra sofisticazione della pianificazione e velocità di esecuzione. Una pianificazione più avanzata (come quella basata su DAG) può migliorare le performance ma aggiunge complessità. Parti da approcci semplici e passa a quelli più sofisticati solo se necessario. Infine, testa ampiamente prima del rilascio in produzione. Gli agenti di pianificazione possono gestire scenari complessi, ma possono anche fallire in modi inaspettati. Test approfonditi aiutano a identificare e correggere i problemi prima che impattino gli utenti.

Il Futuro della Pianificazione per Agenti AI

Il campo della pianificazione per agenti AI sta evolvendo rapidamente, con nuove architetture e tecniche che emergono regolarmente. Una direzione promettente è l’integrazione dell’apprendimento negli agenti di pianificazione. Invece di usare prompt fissi, gli agenti potrebbero imparare dalle esperienze e migliorare la pianificazione nel tempo. Un’altra direzione è lo sviluppo di algoritmi di pianificazione ancora più sofisticati, in grado di gestire scenari complessi, come la pianificazione in presenza di incertezza o obiettivi multipli in conflitto. La ricerca sulla pianificazione gerarchica—dove gli agenti creano piani ad alto livello per poi suddividerli ricorsivamente in sotto-piani dettagliati—potrebbe permettere agli agenti di affrontare compiti sempre più complessi. Inoltre, man mano che i modelli linguistici migliorano, ci si aspetta che le capacità di pianificazione vengano integrate