Dove e Come Iniziare con l'IA nell'E-commerce: Una Roadmap Pratica

Un framework pratico per implementare l'IA nell'e-commerce dal CMO di Quality Unit. Scopri da dove iniziare, le sfide comuni, le strategie di preparazione dei c...

Una guida tecnica per founder sull’implementazione dei protocolli commerce AI (UCP, ACP, AP2), la padronanza dei fondamenti del SEO tecnico e la generazione di contenuti ottimizzati sia per la ricerca tradizionale che per le citazioni AI.

Viktor Zeman ha co-fondato Quality Unit oltre due decenni fa e ha guidato lo sviluppo e la crescita globale della suite di prodotti, incluso FlowHunt. Dal 2024, si è concentrato specificamente su FlowHunt e sull’aiutare le aziende a implementare soluzioni AI pratiche, automazione e ambienti di lavoro moderni guidati dall’AI. La sua presentazione all’E-commerce Mastermind si è addentrata in profondità in tre aree critiche dell’implementazione tecnica dell’AI nell’e-commerce.

La presentazione ha dettagliato protocolli specifici, implementazioni tecniche e strategie di contenuto testate attraverso i prodotti e la base clienti di Quality Unit. Quello che segue è la roadmap tecnica di Viktor per rendere i siti e-commerce individuabili attraverso i sistemi AI, funzionali all’interno del commerce mediato dall’AI e competitivi mentre la ricerca passa dalle parole chiave alle citazioni AI.

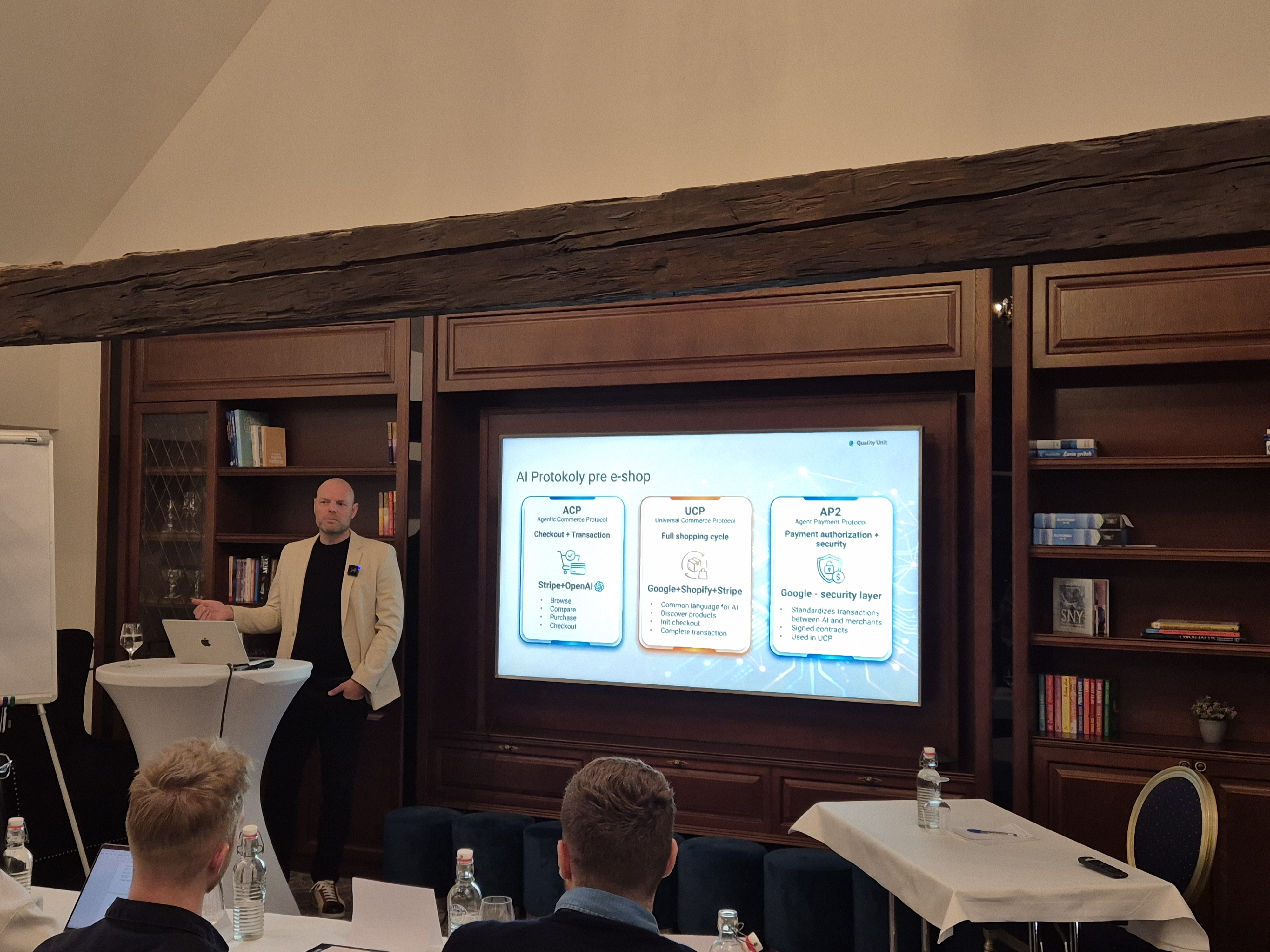

Viktor ha posto le basi introducendo i protocolli standardizzati che consentono all’AI di interagire con i sistemi e-commerce per conto degli utenti.

Piattaforme importanti come Shopify, Salesforce Commerce Cloud o BigCommerce hanno già iniziato a implementare parti di questi protocolli. Lo stesso hanno fatto i processori di pagamento Stripe, PayPal e Checkout.com. Questo dimostra chiaramente che la compatibilità con il commerce AI sta diventando una baseline competitiva.

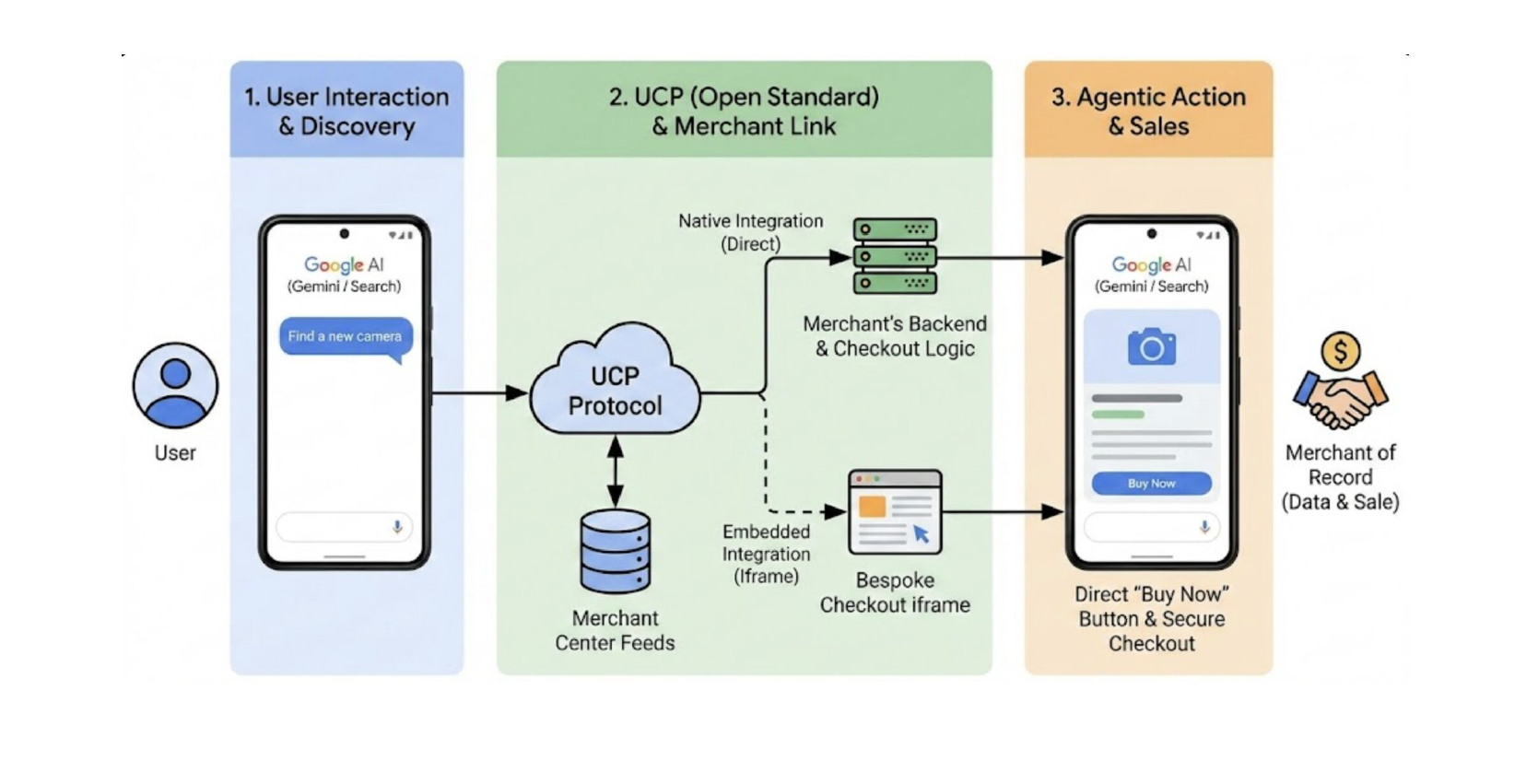

Universal Commerce Protocol (UCP) consente agli assistenti AI di scoprire prodotti, confrontare opzioni, avviare il checkout e completare transazioni senza che gli utenti abbandonino l’interfaccia AI. UCP è già implementato in Shopify, Salesforce Commerce Cloud, BigCommerce e nei principali processori di pagamento.

Agentic Commerce Protocol (ACP), una collaborazione tra Stripe e OpenAI, si concentra specificamente sulla sicurezza e semplicità delle transazioni all’interno delle interfacce conversazionali. Mentre UCP affronta il ciclo di shopping più ampio, ACP si specializza nel processo di acquisto, poiché consente il checkout direttamente all’interno delle interfacce di chat.

Agent Payment Protocol (AP2), sviluppato da Google, fornisce il framework di sicurezza che rende affidabili le transazioni mediate dall’AI attraverso la firma delle transazioni, l’autenticazione dei commercianti e l’autorizzazione dei pagamenti. AP2 si integra con UCP per fornire il layer di fiducia che rende realtà gli acquisti AI autonomi.

Perché il tuo e-shop diventi compatibile con lo shopping guidato dall’AI, e quindi raccomandato dalle piattaforme AI, devi esporre dati leggibili dalle macchine a più livelli:

I prodotti devono essere descritti utilizzando standard come:

schema.org: Fornisci all’AI dati strutturati che può leggere e comprendereQuesto consente ai sistemi AI di interpretare i prodotti senza ambiguità, incluse le varianti, i prezzi, la disponibilità e i vincoli di spedizione. È la base che i sistemi AI utilizzano per capire cosa vendi.

Gli agenti AI non valutano solo i prodotti, valutano anche se i commercianti sono affidabili e adatti all’utente. Ecco perché le informazioni chiave sulla tua attività devono essere esplicite e accessibili:

Gran parte di questi dati esiste già in sistemi come Google Merchant Center, ma deve essere completo, accurato e costantemente mantenuto.

Uno dei componenti meno visibili ma critici è il manifesto commerce. È tipicamente un file JSON ospitato sul dominio del commerciante.

Questo manifesto definisce le versioni dei protocolli supportati, i servizi disponibili, i gestori di pagamento e le capacità di checkout, aiutando gli Agenti AI a capire come funziona il tuo negozio.

Implementa tre endpoint critici:

Implementa il suddetto Agent Payment Protocol per una gestione sicura delle transazioni.

Per le piattaforme senza supporto UCP nativo, MCP fornisce un percorso di integrazione. Zeman ha enfatizzato la crescente importanza di MCP come layer di connessione tra gli agenti AI e i sistemi esistenti.

Sviluppare un server MCP personalizzato ti consente di creare prompt precisi su misura per i tuoi casi d’uso specifici e inviare chiamate API isolate con un rate limiting appropriato. In questo modo, puoi essere sicuro che la tua implementazione AI sarà sicura, controllata e il più economica possibile.

Esempio: Un chatbot integrato con MCP e-commerce e un fornitore di spedizioni (es. Chameleon) consente ai clienti di interrogare non solo lo stato dell’ordine, ma di tracciare la consegna in tempo reale, tutto all’interno di una singola conversazione.

Il secondo argomento di implementazione coperto da Viktor è stato il SEO tecnico. Ha avuto grande cura di enfatizzare che la pietra angolare del SEO non sono le parole chiave. È “un’infrastruttura a cui sia i motori di ricerca che i sistemi AI possono accedere e di cui possono fidarsi”. Perché i siti lenti e inaffidabili vengono abbandonati sia dagli utenti che dai crawler.

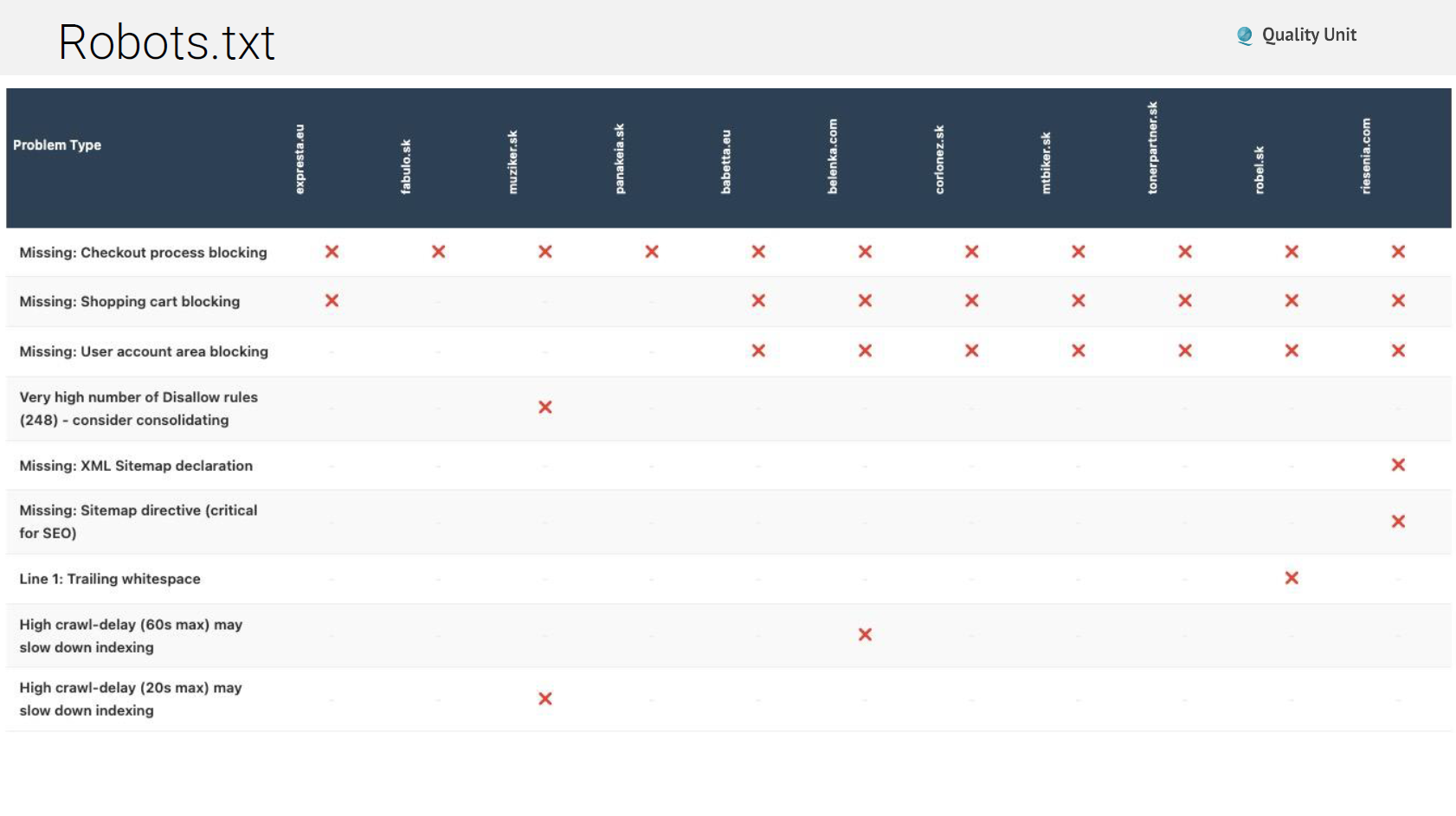

Nonostante sia uno standard di 30 anni, robots.txt rimane frequentemente mal configurato. I problemi comuni includono:

Robots.txt inesistente: Alcuni siti restituiscono pagine di errore o messaggi di manutenzione invece di file robots.txt appropriati, confondendo i crawler su cosa sia consentito.

Bot AI bloccati: Bloccare i crawler AI impedisce che i tuoi contenuti vengano citati nelle risposte AI. Anche se potresti voler bloccare alcuni bot, un blocco generale elimina la visibilità AI.

Direttive sitemap mancanti: Robots.txt dovrebbe fare riferimento alle tue sitemap XML, guidando i crawler alla scoperta completa dei contenuti.

Errori di sintassi: Virgole finali nei wildcard (Disallow: /?pv=*,) causano errori di parsing in alcuni crawler, creando blocchi involontari.

Contenuti di valore bloccati: A volte i siti bloccano contenuti che vogliono effettivamente indicizzare, solitamente attraverso regole wildcard eccessivamente ampie.

Le sitemap XML dicono ai motori di ricerca e ai sistemi AI quali contenuti esistono e come sono organizzati. I problemi comuni in quest’area includono:

Problemi con gli header di cache: Header di cache errati possono impedire l’aggiornamento corretto delle sitemap, lasciando i crawler con elenchi di contenuti obsoleti.

Copertura URL incompleta: Le sitemap generate da plugin spesso mancano tipi di post personalizzati, tassonomie o pagine dinamiche, lasciando contenuti significativi non scoperti.

Problemi di rate limiting: Alcuni siti implementano rate limiting aggressivo che blocca completamente il recupero delle sitemap, restituendo errori 429 dopo appena 10 URL.

Link a pagine 404: Le sitemap contenenti link morti sprecano il budget di crawling e segnalano una scarsa manutenzione del sito.

Gli header HTTP di cache appropriati migliorano drasticamente le performance per i visitatori di ritorno e riducono il carico del server. Eppure molti siti configurano questo completamente male. Le direttive Cache-Control sono importanti:

Viktor ha enfatizzato il controllo degli header di cache per tutti i tipi di risorse: HTML, CSS, JavaScript, immagini, font e risposte API.

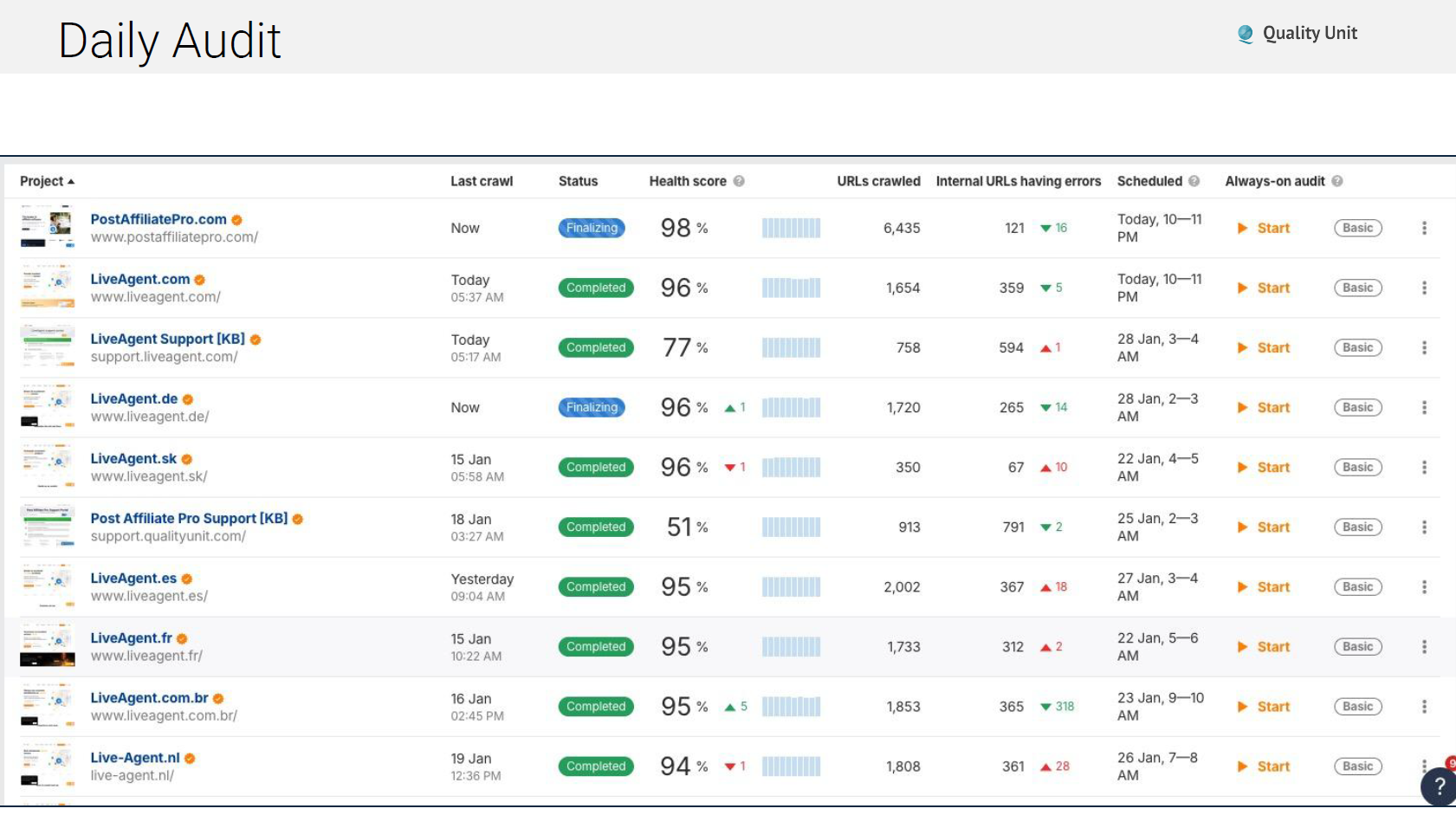

I problemi tecnici emergono costantemente ed è per questo che il nostro team esegue audit automatizzati quotidiani che verificano:

L’utilizzo di strumenti come Ahrefs per il monitoraggio automatizzato garantisce che i problemi vengano individuati e risolti prima che si accumulino in perdite di traffico importanti:

I Core Web Vitals di Google influenzano direttamente i ranking. Dovresti concentrarti principalmente su questi due strumenti critici: PageSpeed Insights fornisce dati di laboratorio che mostrano le potenziali performance in condizioni controllate. Chrome User Experience Report (CrUX) fornisce dati del mondo reale da utenti effettivi che visitano il tuo sito.

Le tre metriche critiche da monitorare sono:

Il markup Schema.org trasforma l’HTML in dati strutturati leggibili dalle macchine. Sia i motori di ricerca tradizionali che i sistemi AI si affidano allo schema per comprendere il contesto e le relazioni dei contenuti.

Tipi di schema essenziali per l’e-commerce:

Gli errori comuni nell’implementazione dello schema includono:

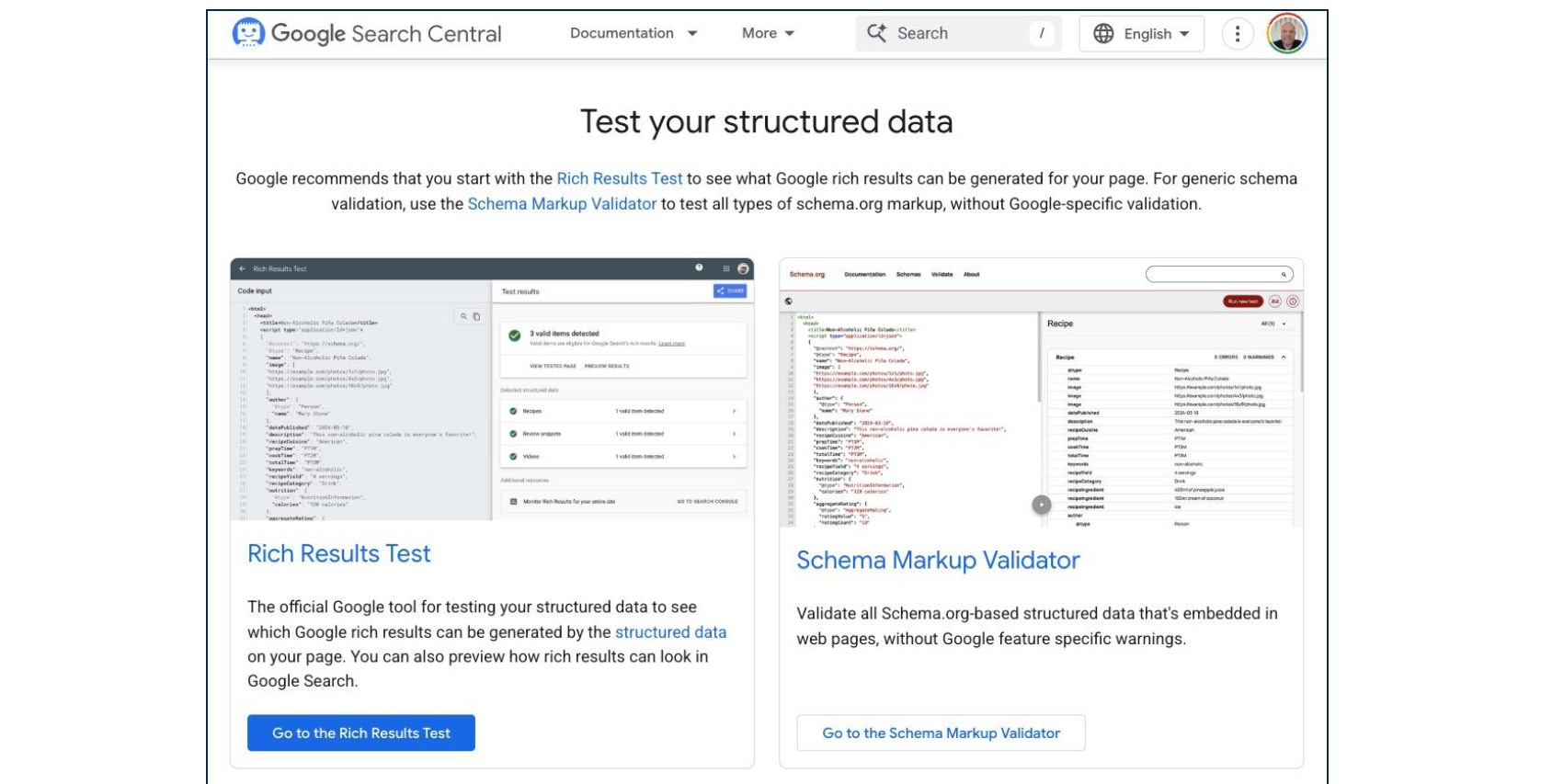

La validazione regolare attraverso il Rich Results Test di Google garantisce che lo schema rimanga correttamente strutturato e completo.

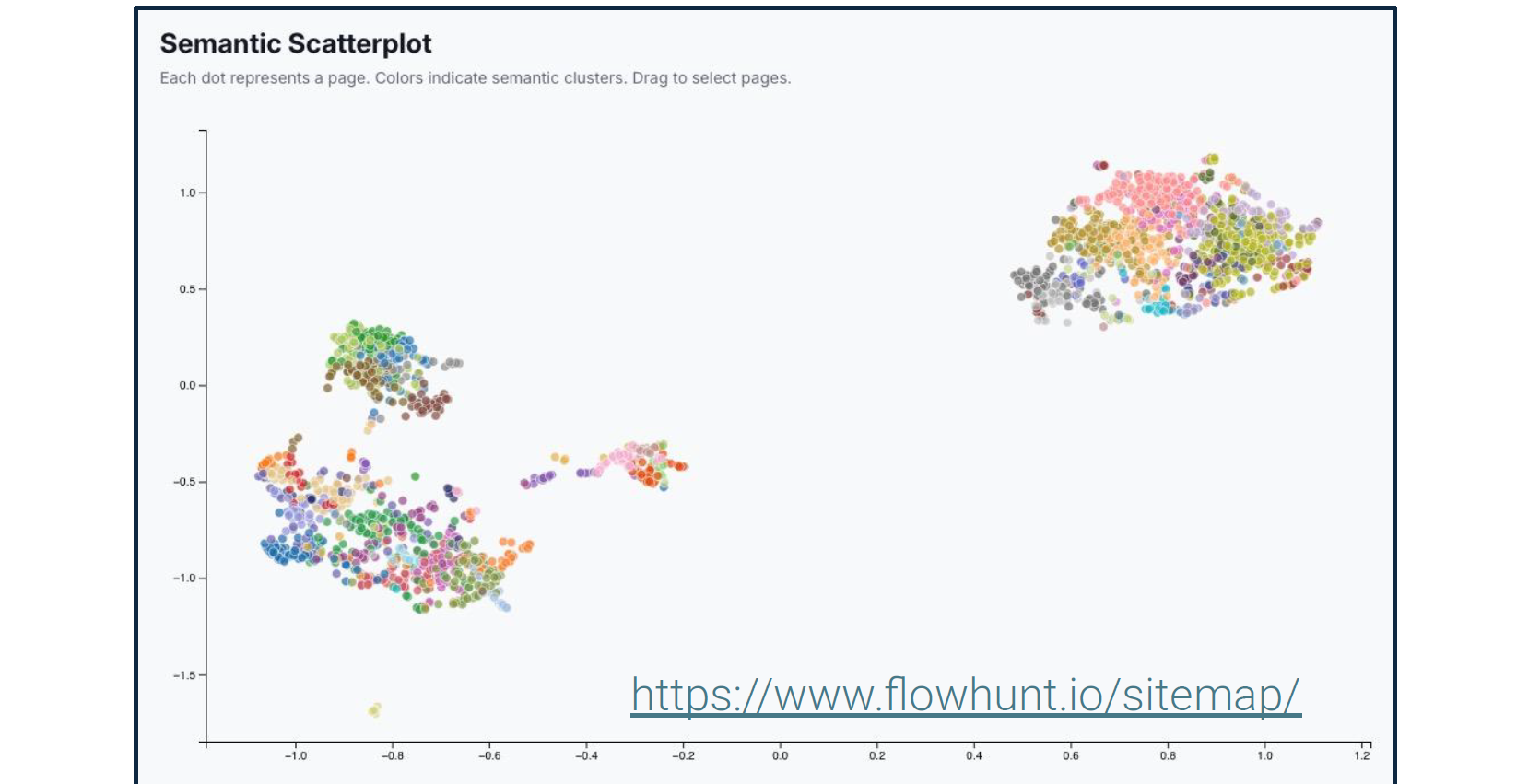

Viktor ha ripetutamente enfatizzato che il SEO non riguarda più le parole chiave. Ha dettagliato strumenti di analisi semantica che rivelano come i motori di ricerca e i sistemi AI comprendono il significato dei tuoi contenuti piuttosto che solo le parole.

Questi strumenti visualizzano le relazioni tra entità, la copertura degli argomenti e le connessioni semantiche all’interno dei tuoi contenuti. I sistemi AI utilizzano queste relazioni per determinare quando i tuoi contenuti rispondono a query specifiche, anche quando non compaiono parole chiave esatte.

Mentre il SEO tradizionale chiedeva: “Questa pagina contiene le parole chiave giuste?” Il SEO moderno chiede: “Questa pagina dimostra competenza su entità rilevanti e le loro relazioni?”

“A Google non importa se dici di essere ‘Il negozio di riparazione telefoni più veloce di Bratislava’. Chiede se il tuo sito web mostra competenza sull’entità ’telefono’ in relazione alle entità ‘riparazione’ e ‘Bratislava’. Altre fonti convalidano la competenza su queste entità? Per esempio recensioni o annunci nativi. Il comportamento dell’utente, come il tempo trascorso sul sito, segnala che il contenuto è rilevante?” - Viktor Zeman

Sottolinea ulteriormente che dovresti iniziare con vittorie rapide, come risolvere alcuni dei tuoi problemi di SEO tecnico. I risultati dovrebbero mostrarsi in poco tempo. Solo una volta che l’AI e i motori di ricerca possono leggere e comprendere correttamente il tuo sito sarà il momento di iniziare a creare contenuti ricchi di parole chiave.

Viktor ha sfidato la saggezza convenzionale sul link building, sostenendo che la struttura dei link interni merita molta più attenzione di quella che la maggior parte dei siti le dedica.

Distribuzione del PageRank: Google (e sempre più i sistemi AI) fanno fluire l’autorità attraverso i link. La tua struttura di link interni determina quali pagine ricevono quell’autorità.

Concentrazione del link juice: I link dalle pagine ad alto traffico hanno più valore dei link dalle pagine raramente visitate. Il linking interno strategico amplifica l’impatto dei tuoi contenuti più popolari.

Contesto attraverso l’anchor text: Le parole utilizzate nei link segnalano relazioni tematiche sia ai motori di ricerca che ai sistemi AI.

Gerarchia di posizionamento: I link nel contenuto principale hanno più peso dei link nel footer o nella navigazione.

Sui nostri siti web, non combattiamo contro i mulini a vento cercando di scalare e mantenere link interni manuali coerenti. Invece, abbiamo implementato un linking interno automatizzato su larga scala. Questa automazione considera:

Il risultato è una struttura completa di link interni che sarebbe impossibile mantenere manualmente garantendo al contempo che ogni pezzo di contenuto si colleghi logicamente ad argomenti correlati.

L’approccio di Viktor alla generazione di contenuti AI si concentra sulla struttura sistematica piuttosto che sulla creazione di articoli ad hoc.

Prima di generare contenuti, comprendi come i sistemi AI discutono attualmente del tuo settore: Passo 1: Genera prompt di test - Crea oltre 500 domande che rappresentano come gli utenti potrebbero interrogare i sistemi AI su argomenti nel tuo dominio. Passo 2: Analizza le risposte AI - Usa strumenti come AmICited.com per vedere quali fonti i sistemi AI citano attualmente quando rispondono a questi prompt.

Questo rivelerà:

Passo 3: Identifica le lacune - Trova domande in cui i sistemi AI forniscono risposte deboli o citano fonti scadenti. Queste rappresentano opportunità per diventare la citazione autorevole.

Le descrizioni dei prodotti ottimizzate per l’AI beneficiano tre canali critici:

Piuttosto che generici “contenuti blog”, Viktor sostiene la creazione di agenti AI specializzati per generare ogni tipo distinto di post, ciascuno con elementi e struttura definiti. Per esempio, glossario, checklist, post how-to, documentazione delle funzionalità, ma anche framework blog riutilizzabili come analisi, insights, commenti sul settore.

Mentre un Agente AI generale con un prompt davvero buono potrebbe centrare l’obiettivo al primo tentativo, non è quello di cui hai bisogno. Stai cercando scala e workflow accurati e ripetibili. Scrivere nuovi prompt per gli agenti ogni volta, sperando che funzionino, e poi salvare i prompt in un blocco note non ti darà questo. Copiare manualmente lo stesso prompt per ottenere un singolo output non scalerà.

Quello che devi fare è creare un Agente AI altamente specializzato che funzionerà in modo impeccabile in modo coerente e su larga scala. Ogni tipo di post richiede un agente AI dedicato configurato con template di prompt specifici, regole di formattazione e requisiti strutturali.

Questo include definire chiaramente ogni sezione del tipo di post. Per esempio, per l’elemento titolo Viktor raccomanda di aggiungere questa struttura al tuo prompt:

Viktor ha brevemente delineato il processo esatto che il nostro team utilizza:

Genera libreria di prompt: Crea oltre 500 prompt che rappresentano le query degli utenti nel tuo dominio utilizzando AmICited.com o strumenti simili.

Analizza i modelli di citazione: Comprendi il comportamento AI attuale per questi prompt e trova opportunità. Scopri cosa viene citato, cosa manca, cosa è debole.

Costruisci agenti specializzati: Crea agenti AI in FlowHunt (o piattaforme simili) per ogni tipo di post con elementi e vincoli definiti.

Genera sistematicamente: Produci contenuti su larga scala utilizzando agenti specializzati per ogni tipo di post, mantenendo struttura e qualità coerenti.

Implementa linking semantico: Usa algoritmi di similarità semantica per suggerire e creare automaticamente connessioni tra articoli correlati.

Monitora e perfeziona: Traccia quali contenuti vengono citati dai sistemi AI e perfeziona il tuo approccio basandoti su dati di citazione reali.

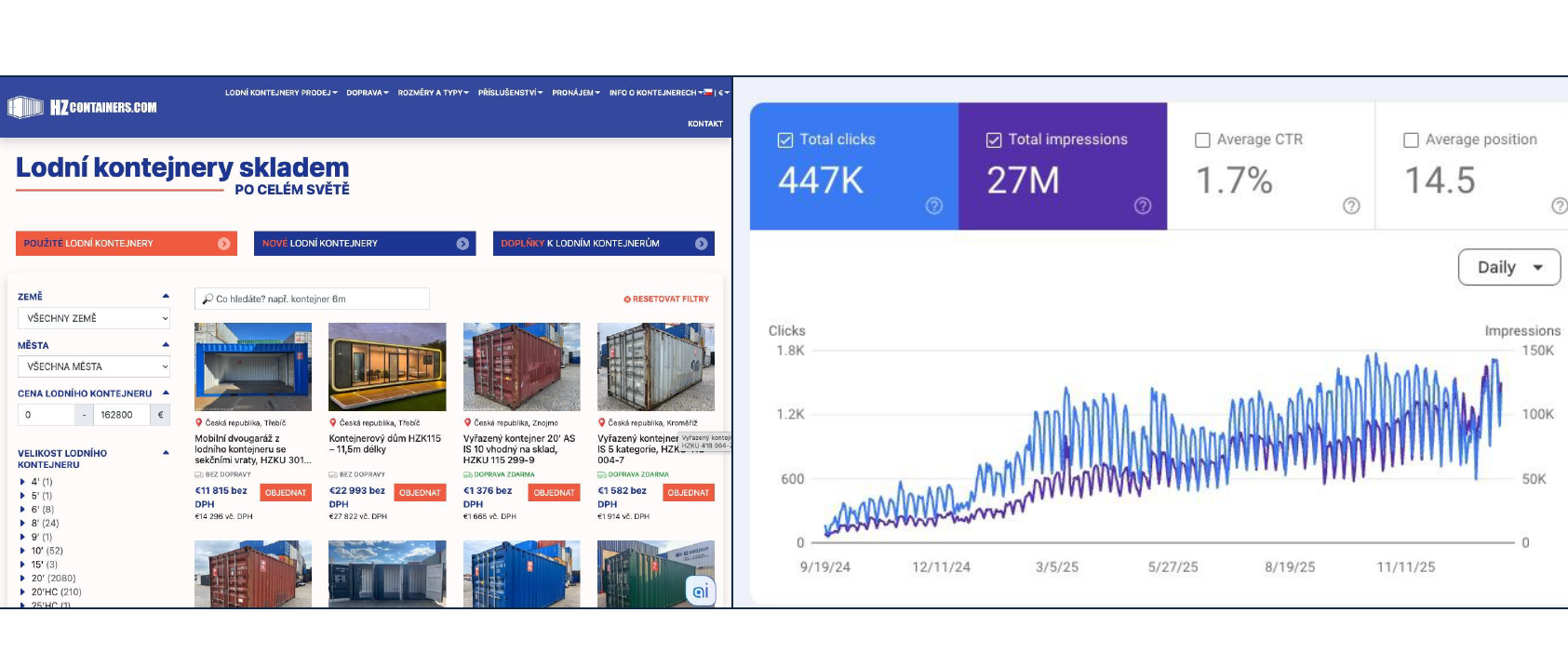

Aumento del traffico del 18.000% (180x) da gennaio a settembre 2025, consegnando 2.000 container. L’approccio è costruito su fondamenti di SEO tecnico, contenuti completi che rispondono a tutte le domande, markup schema appropriato, tipi di post strutturati e linking interno automatizzato. Nessun keyword stuffing o schema di link.

Viktor ha enfatizzato una transizione fondamentale che sta avvenendo nel modo in cui le persone trovano e valutano i prodotti online. Google considera centinaia di fattori di ranking. Ecco solo una lista parziale per illustrare la complessità:

La realtà è che ogni miglioramento contribuisce solo per promille (millesimi) di guadagno. Ottenere miglioramenti significativi nel ranking richiede mesi di ottimizzazione continua su dozzine di fattori simultaneamente. Il SEO tradizionale rimane importante ma rappresenta un approccio alla visibilità faticoso e incrementale.

La Generative Engine Optimization si concentra sull’essere citati dai sistemi AI quando gli utenti fanno domande rilevanti per la tua attività.

Differenze chiave dal SEO tradizionale:

Ecco una panoramica rapida degli strumenti chiave e della roadmap di implementazione.

Viktor ha raccomandato una sequenza specifica per l’implementazione: Fase 1: Fondazione Tecnica (Settimane 1-4) • Audit e ottimizzazione dell’infrastruttura • Configurazione di robots.txt e sitemap • Implementazione degli header di cache • Miglioramento dei Core Web Vitals • Markup schema.org per le pagine esistenti Fase 2: Struttura dei Contenuti (Settimane 5-8) • Definire i tipi di post e i loro elementi • Creare agenti AI specializzati per ogni tipo • Stabilire l’automazione del linking interno • Implementare sistemi di similarità semantica Fase 3: Generazione di Contenuti (Settimane 9-16) • Generare libreria di prompt (oltre 500 prompt) • Analizzare i modelli di citazione attuali • Iniziare la creazione sistematica di contenuti • Monitorare le performance delle citazioni AI • Perfezionare basandosi sui dati Fase 4: Implementazione dei Protocolli (In Corso) • Implementare UCP/ACP/AP2 se applicabile • Sviluppare server MCP personalizzati per le integrazioni • Testare la funzionalità commerce AI • Espandere basandosi sull’adozione

Questa non è una strategia per vittorie rapide. Il SEO tecnico, i contenuti completi e l’implementazione dei protocolli AI richiedono investimenti sostenuti per mesi.

Tuttavia, i risultati si compongono. Ogni pezzo di contenuto correttamente strutturato aumenta la tua autorità. Ogni miglioramento tecnico migliora l’efficacia di tutti i tuoi contenuti. Ogni citazione da parte dei sistemi AI aumenta la probabilità di future citazioni. La domanda non è se investire in questa infrastruttura—è se guidare la transizione o seguire più tardi quando i concorrenti hanno già stabilito autorità nella scoperta mediata dall’AI.

Per i leader tecnici dell’e-commerce, questo framework offre chiarezza. Devi iniziare a costruire fondamenta tecniche appropriate, implementando protocolli commerce AI, strutturando i contenuti sistematicamente e ottimizzando sia per la ricerca tradizionale che per le citazioni AI simultaneamente. L’infrastruttura che costruisci oggi determina la scopribilità quando gli utenti chiederanno raccomandazioni ai sistemi AI domani.

La presentazione tecnica di Viktor complementa le prospettive strategiche e operative dalle fasi precedenti della serie di conferenze.

La roadmap di implementazione di Michal Lichner ha stabilito dove concentrare l’implementazione AI e come preparare i contenuti sistematicamente. La presentazione di Zeman fornisce l’infrastruttura tecnica che rende quei contenuti individuabili e funzionali.

L’automazione del supporto di Jozef Štofira mostra l’esatto set di strumenti che utilizziamo per automatizzare il lavoro pesante del supporto, dal filtraggio e categorizzazione, all’arricchimento dei dati, assistente alle risposte e passaggio di consegne umano.

Insieme, queste tre prospettive formano un quadro completo: pianificazione strategica, infrastruttura tecnica ed esecuzione operativa per l’e-commerce in un ambiente di commerce mediato dall’AI.

I protocolli commerce AI come UCP (Universal Commerce Protocol), ACP (Agentic Commerce Protocol) e AP2 (Agent Payment Protocol) standardizzano il modo in cui i sistemi AI interagiscono con le piattaforme e-commerce. Consentono agli assistenti AI di navigare tra i prodotti, confrontare opzioni, avviare il checkout e completare le transazioni per conto degli utenti, rendendo il tuo negozio accessibile attraverso esperienze di shopping mediate dall'AI.

Il SEO (Search Engine Optimization) si concentra sul posizionamento nei motori di ricerca tradizionali come Google attraverso l'ottimizzazione delle parole chiave e i backlink. Il GEO (Generative Engine Optimization) si concentra sull'essere citati dai sistemi AI come ChatGPT e Perplexity attraverso contenuti strutturati, definizioni chiare delle entità e risposte complete. L'e-commerce moderno ha bisogno di entrambi: SEO per il traffico attuale, GEO per la futura scoperta mediata dall'AI.

I fondamenti prioritari includono: infrastruttura veloce e sicura con CDN; robots.txt e sitemap configurati correttamente; header di cache corretti; audit tecnici regolari; ottimizzazione dei Core Web Vitals; markup schema.org completo per le entità; struttura semantica dei contenuti; e linking interno automatizzato. Questi creano le fondamenta di cui hanno bisogno sia i motori di ricerca tradizionali che i sistemi AI per comprendere e indicizzare correttamente i tuoi contenuti.

Inizia generando oltre 500 prompt utilizzando strumenti come AmICited.com per capire come i sistemi AI discutono attualmente del tuo settore. Crea agenti AI specializzati per ogni tipo di contenuto (glossario, how-to, checklist, descrizioni prodotti) con elementi definiti e regole di formattazione. Usa la similarità semantica per suggerimenti di articoli correlati. Genera contenuti che rispondono in modo completo a tutte le potenziali domande dei visitatori piuttosto che puntare a parole chiave ristrette.

Arshia è una AI Workflow Engineer presso FlowHunt. Con una formazione in informatica e una passione per l'IA, è specializzata nella creazione di workflow efficienti che integrano strumenti di intelligenza artificiale nelle attività quotidiane, migliorando produttività e creatività.

Crea agenti AI che generano contenuti ottimizzati per il SEO, implementano miglioramenti SEO tecnici e creano integrazioni con protocolli AI—tutto all'interno del workflow builder visuale di FlowHunt.

Un framework pratico per implementare l'IA nell'e-commerce dal CMO di Quality Unit. Scopri da dove iniziare, le sfide comuni, le strategie di preparazione dei c...

Un'analisi tecnica di sei funzioni AI che hanno ridotto il carico di lavoro del supporto del 48,5%. Scopri i problemi specifici che ciascuna risolve, l'approcci...

Scopri come creare un manager Shopify alimentato dall'AI utilizzando l'integrazione del server MCP di FlowHunt per automatizzare la gestione dei prodotti, ordin...

Consenso Cookie

Usiamo i cookie per migliorare la tua esperienza di navigazione e analizzare il nostro traffico. See our privacy policy.