Guida allo Sviluppo di Server MCP

Scopri come costruire e distribuire un server Model Context Protocol (MCP) per collegare modelli AI con strumenti esterni e fonti di dati. Guida passo-passo per...

Scopri come sviluppare un server Model Context Protocol (MCP) che si integra senza soluzione di continuità con l’API di OpenAI, abilitando l’esecuzione di potenti strumenti AI e l’automazione intelligente.

Il Model Context Protocol (MCP) rappresenta un cambio di paradigma nel modo in cui i sistemi di intelligenza artificiale interagiscono con strumenti esterni e fonti di dati. Quando è combinato con i potenti modelli linguistici di OpenAI, un server MCP diventa un gateway per l’automazione intelligente, permettendo ai sistemi AI di eseguire operazioni complesse, recuperare dati in tempo reale e integrarsi perfettamente con la tua infrastruttura esistente. Questa guida completa ti accompagna attraverso tutto il processo di sviluppo di un server MCP collegato a OpenAI, dai concetti fondamentali fino alla messa in produzione.

Che tu stia costruendo una piattaforma di automazione per il customer service, un sistema intelligente di elaborazione dati o uno strumento avanzato di business intelligence, comprendere come progettare e implementare un server MCP è essenziale per lo sviluppo AI moderno. L’integrazione tra server MCP e OpenAI crea un ecosistema potente dove i modelli AI possono ragionare sui problemi, decidere quali strumenti utilizzare ed eseguirli con precisione—il tutto mantenendo sicurezza, affidabilità e scalabilità.

Il Model Context Protocol è uno standard aperto che definisce come i modelli AI possono scoprire e interagire con strumenti, servizi e fonti dati esterne. Invece di incorporare tutte le funzionalità direttamente in un modello AI, MCP permette agli sviluppatori di creare server specializzati che espongono capacità tramite un’interfaccia standardizzata. Questa separazione dei compiti consente una maggiore modularità, sicurezza e scalabilità nelle applicazioni AI.

Alla base, MCP opera su un principio semplice: il modello AI (in questo caso, GPT di OpenAI) agisce come un orchestratore intelligente in grado di capire quali strumenti sono disponibili, determinare quando usarli e interpretarne i risultati. Il server MCP agisce da provider di questi strumenti, esponendoli tramite una API ben definita che il modello AI può scoprire e invocare. Questo crea un contratto pulito tra il sistema AI e la tua logica di business personalizzata.

La bellezza di MCP risiede nella sua flessibilità. Il tuo server può esporre strumenti per qualsiasi cosa—query su database, chiamate API a servizi terzi, elaborazione file, calcoli o anche attivazione di workflow complessi. Il modello AI apprende queste capacità e le utilizza in modo intelligente nelle conversazioni, decidendo quali strumenti invocare in base alla richiesta dell’utente e al contesto.

L’integrazione dei server MCP con OpenAI affronta un limite fondamentale dei grandi modelli linguistici: hanno una data di aggiornamento e non possono interagire direttamente con sistemi in tempo reale o dati proprietari. Implementando un server MCP, estendi le capacità dei modelli OpenAI ben oltre il loro training di base, permettendo loro di accedere a informazioni aggiornate, eseguire logica di business e integrarsi con i tuoi sistemi esistenti.

Ecco alcuni scenari pratici in cui i server MCP risultano indispensabili:

L’architettura offre vantaggi significativi anche ai team di sviluppo. Più team possono sviluppare e mantenere i propri server MCP in modo indipendente, componendoli poi insieme per creare applicazioni AI sofisticate. Questo approccio modulare scala bene al crescere dell’organizzazione e delle esigenze AI.

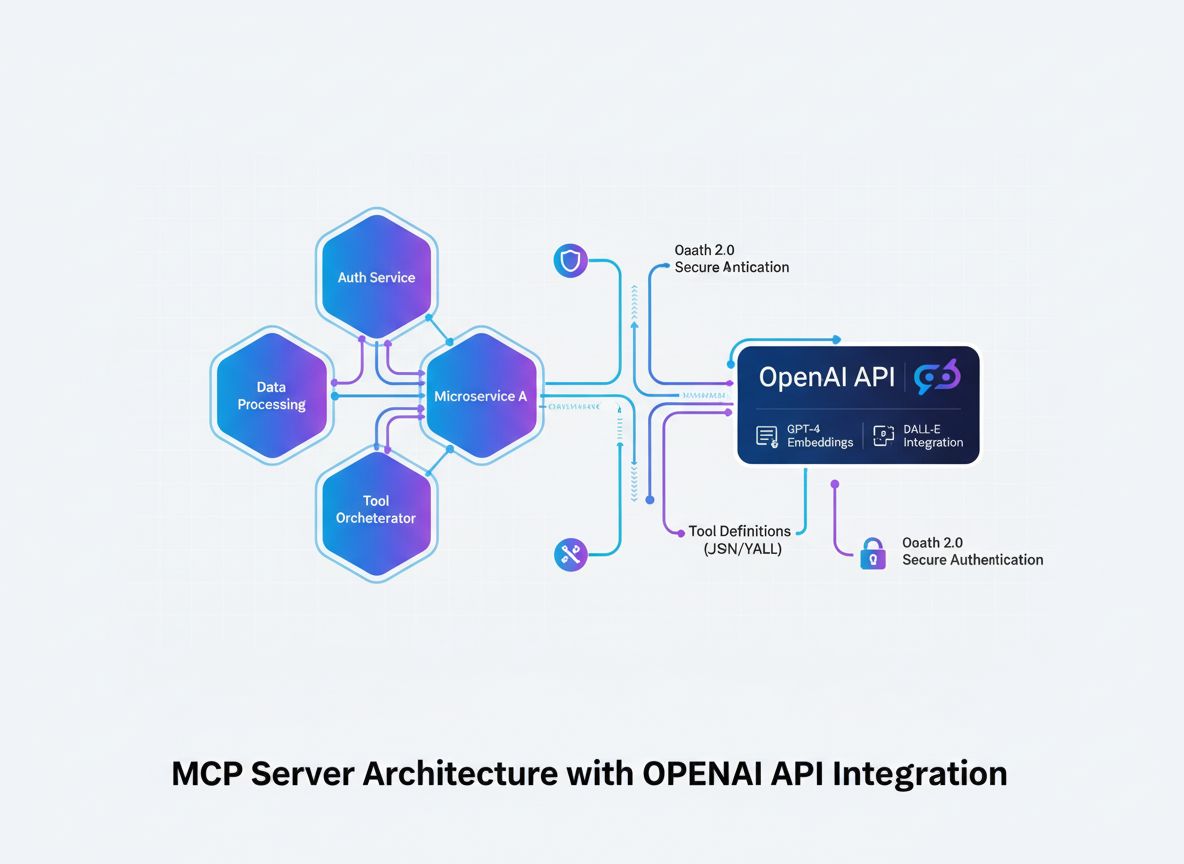

Prima di entrare nei dettagli dell’implementazione, è fondamentale comprendere il flusso architetturale di come un server MCP si integra con OpenAI. Il processo coinvolge diversi componenti chiave che lavorano in sinergia:

Il modello AI (OpenAI) avvia le conversazioni e decide quali strumenti invocare. Quando determina che è necessaria una chiamata a uno strumento, genera una richiesta strutturata contenente nome e parametri dello strumento.

Il client MCP agisce da traduttore e intermediario. Riceve le richieste di invocazione strumenti da OpenAI, le traduce nel formato atteso dal tuo server MCP, invia la richiesta al server appropriato e restituisce i risultati a OpenAI nel formato previsto dal modello.

Il server MCP è la tua applicazione personalizzata che espone strumenti e capacità. Riceve richieste dal client MCP, esegue le operazioni richieste (che possono prevedere query su database, chiamate API o calcoli complessi) e restituisce risultati strutturati.

Le definizioni degli strumenti sono i contratti che definiscono quali strumenti sono disponibili, quali parametri accettano e cosa restituiscono. Queste definizioni vengono scoperte dal client MCP e registrate con OpenAI, così il modello sa cosa può utilizzare.

Questa architettura crea una separazione netta dei compiti: OpenAI si occupa di ragionamento e decisioni, il tuo server MCP gestisce la logica di dominio e l’accesso ai dati, il client MCP si occupa del protocollo di comunicazione.

La base di un server MCP di successo è la definizione chiara degli strumenti che vuoi esporre. Non è solo un esercizio tecnico—è una decisione strategica su quali capacità il tuo sistema AI deve avere per raggiungere i suoi obiettivi.

Inizia identificando i problemi specifici che il tuo sistema AI deve risolvere. Stai costruendo un chatbot di assistenza clienti che deve consultare informazioni sugli ordini? Un assistente di data analysis che deve interrogare database? Uno strumento di content creation che deve accedere alla knowledge base aziendale? Ogni caso d’uso avrà esigenze diverse.

Per ogni strumento definisci:

get_customer_order_history, search_knowledge_base, execute_sql_query)Esempio di specifiche strumenti definite:

| Nome Strumento | Scopo | Parametri Input | Formato Output | Caso d’Uso |

|---|---|---|---|---|

get_customer_info | Recupera dettagli cliente | customer_id (string) | Oggetto JSON con nome, email, account_status | Query customer service |

search_orders | Trova ordini tramite criteri | customer_id, date_range, status | Array di oggetti ordine | Ricerca e storico ordini |

create_support_ticket | Apre un nuovo ticket supporto | customer_id, issue_description, priority | Oggetto ticket con ID e conferma | Escalation problemi |

check_inventory | Verifica disponibilità prodotto | product_id, warehouse_location | Numero inventario e dettagli posizione | Richieste stock |

process_refund | Avvia rimborso | order_id, amount, reason | Conferma transazione con riferimento | Gestione rimborsi |

Questo approccio tabellare ti aiuta a ragionare su tutto l’ecosistema degli strumenti prima di scrivere codice, assicurando coerenza, chiarezza e completezza.

La creazione di un server MCP richiede una solida base di sviluppo. Sebbene i server MCP possano essere costruiti con diversi linguaggi, ci concentreremo sugli approcci più diffusi: TypeScript/Node.js e Python, che dispongono delle librerie MCP più mature e del maggior supporto dalla community.

Per lo sviluppo in TypeScript/Node.js:

Crea un nuovo progetto Node.js e installa le dipendenze necessarie:

mkdir mcp-server-openai

cd mcp-server-openai

npm init -y

npm install @modelcontextprotocol/sdk openai dotenv express cors

npm install --save-dev typescript @types/node ts-node

Crea un file tsconfig.json per configurare TypeScript:

{

"compilerOptions": {

"target": "ES2020",

"module": "commonjs",

"lib": ["ES2020"],

"outDir": "./dist",

"rootDir": "./src",

"strict": true,

"esModuleInterop": true,

"skipLibCheck": true,

"forceConsistentCasingInFileNames": true

}

}

Per lo sviluppo in Python:

Crea un ambiente virtuale e installa le dipendenze:

python -m venv venv

source venv/bin/activate # Su Windows: venv\Scripts\activate

pip install mcp openai python-dotenv fastapi uvicorn

Indipendentemente dal linguaggio scelto, ti serviranno:

.env per conservare in sicurezza le credenziali sensibiliIl cuore del tuo server MCP è l’applicazione che espone gli strumenti tramite il protocollo MCP. Questo comporta la creazione di endpoint per la scoperta degli strumenti e per la loro esecuzione.

Implementazione TypeScript/Node.js:

Crea una struttura base del server MCP:

import { Server } from "@modelcontextprotocol/sdk/server/index.js";

import { StdioServerTransport } from "@modelcontextprotocol/sdk/server/stdio.js";

import {

CallToolRequestSchema,

ListToolsRequestSchema,

} from "@modelcontextprotocol/sdk/types.js";

const server = new Server({

name: "openai-mcp-server",

version: "1.0.0",

});

// Definisci i tuoi strumenti

const tools = [

{

name: "get_customer_info",

description: "Recupera informazioni cliente tramite ID",

inputSchema: {

type: "object",

properties: {

customer_id: {

type: "string",

description: "Identificativo univoco del cliente",

},

},

required: ["customer_id"],

},

},

// Aggiungi altri strumenti qui

];

// Gestione richiesta elenco strumenti

server.setRequestHandler(ListToolsRequestSchema, async () => {

return { tools };

});

// Gestione richiesta esecuzione strumento

server.setRequestHandler(CallToolRequestSchema, async (request) => {

const { name, arguments: args } = request.params;

if (name === "get_customer_info") {

// Logica dello strumento

const customerId = args.customer_id;

// Query su database o API

return {

content: [

{

type: "text",

text: JSON.stringify({

id: customerId,

name: "John Doe",

email: "john@example.com",

}),

},

],

};

}

return {

content: [{ type: "text", text: `Strumento sconosciuto: ${name}` }],

isError: true,

};

});

// Avvia il server

const transport = new StdioServerTransport();

server.connect(transport);

Implementazione Python:

from mcp.server import Server

from mcp.types import Tool, TextContent, ToolResult

import json

app = Server("openai-mcp-server")

# Definisci i tuoi strumenti

TOOLS = [

Tool(

name="get_customer_info",

description="Recupera informazioni cliente tramite ID",

inputSchema={

"type": "object",

"properties": {

"customer_id": {

"type": "string",

"description": "Identificativo univoco del cliente"

}

},

"required": ["customer_id"]

}

)

]

@app.list_tools()

async def list_tools():

return TOOLS

@app.call_tool()

async def call_tool(name: str, arguments: dict):

if name == "get_customer_info":

customer_id = arguments.get("customer_id")

# Logica dello strumento

result = {

"id": customer_id,

"name": "John Doe",

"email": "john@example.com"

}

return ToolResult(

content=[TextContent(type="text", text=json.dumps(result))]

)

return ToolResult(

content=[TextContent(type="text", text=f"Strumento sconosciuto: {name}")],

isError=True

)

if __name__ == "__main__":

import uvicorn

uvicorn.run(app, host="0.0.0.0", port=8000)

Il vero potere del tuo server MCP risiede nell’implementazione concreta degli strumenti. Qui connetti database, chiami API esterne, elabori dati ed esegui la logica di business.

Esempio integrazione database:

import { Pool } from "pg"; // Esempio PostgreSQL

const pool = new Pool({

connectionString: process.env.DATABASE_URL,

});

async function getCustomerInfo(customerId: string) {

try {

const result = await pool.query(

"SELECT id, name, email, account_status FROM customers WHERE id = $1",

[customerId]

);

if (result.rows.length === 0) {

return {

error: "Cliente non trovato",

status: 404,

};

}

return result.rows[0];

} catch (error) {

return {

error: "Query database fallita",

details: error.message,

status: 500,

};

}

}

Esempio integrazione API esterna:

import axios from "axios";

async function searchExternalDatabase(query: string) {

try {

const response = await axios.get(

"https://api.external-service.com/search",

{

params: { q: query },

headers: {

Authorization: `Bearer ${process.env.EXTERNAL_API_KEY}`,

},

}

);

return response.data;

} catch (error) {

return {

error: "Chiamata API esterna fallita",

details: error.message,

};

}

}

Gestione degli errori e validazione:

Una gestione robusta degli errori è fondamentale per server MCP in produzione. Implementa validazione ed error handling completi:

function validateInput(args: any, schema: any): { valid: boolean; error?: string } {

// Valida i campi richiesti

for (const required of schema.required || []) {

if (!(required in args)) {

return { valid: false, error: `Parametro richiesto mancante: ${required}` };

}

}

// Valida i tipi dei campi

for (const [key, property] of Object.entries(schema.properties || {})) {

if (key in args) {

const value = args[key];

const expectedType = (property as any).type;

if (typeof value !== expectedType) {

return {

valid: false,

error: `Il parametro ${key} deve essere di tipo ${expectedType}`,

};

}

}

}

return { valid: true };

}

Il client MCP è il ponte tra OpenAI e il tuo server MCP. Si occupa della traduzione tra il formato delle chiamate funzione di OpenAI e il protocollo del tuo server MCP.

Client MCP TypeScript/Node.js:

import { Client } from "@modelcontextprotocol/sdk/client/index.js";

import { StdioClientTransport } from "@modelcontextprotocol/sdk/client/stdio.js";

import OpenAI from "openai";

class MCPOpenAIBridge {

private mcpClient: Client;

private openaiClient: OpenAI;

private availableTools: any[] = [];

constructor() {

this.openaiClient = new OpenAI({

apiKey: process.env.OPENAI_API_KEY,

});

}

async initialize() {

// Connessione al server MCP

const transport = new StdioClientTransport({

command: "node",

args: ["dist/server.js"],

});

this.mcpClient = new Client({

name: "openai-mcp-client",

version: "1.0.0",

});

await this.mcpClient.connect(transport);

// Scoperta strumenti disponibili

const toolsResponse = await this.mcpClient.listTools();

this.availableTools = toolsResponse.tools;

}

async executeWithOpenAI(userMessage: string) {

const messages = [{ role: "user" as const, content: userMessage }];

// Conversione strumenti MCP in formato funzione OpenAI

const tools = this.availableTools.map((tool) => ({

type: "function" as const,

function: {

name: tool.name,

description: tool.description,

parameters: tool.inputSchema,

},

}));

let response = await this.openaiClient.chat.completions.create({

model: "gpt-4",

messages,

tools,

});

// Gestione chiamate agli strumenti in loop

while (response.choices[0].finish_reason === "tool_calls") {

const toolCalls = response.choices[0].message.tool_calls || [];

for (const toolCall of toolCalls) {

const toolName = toolCall.function.name;

const toolArgs = JSON.parse(toolCall.function.arguments);

// Esecuzione strumento su MCP server

const toolResult = await this.mcpClient.callTool({

name: toolName,

arguments: toolArgs,

});

// Aggiunge risultato strumento ai messaggi

messages.push({

role: "assistant",

content: response.choices[0].message.content || "",

});

messages.push({

role: "tool",

content: JSON.stringify(toolResult),

tool_call_id: toolCall.id,

});

}

// Ottiene la prossima risposta da OpenAI

response = await this.openaiClient.chat.completions.create({

model: "gpt-4",

messages,

tools,

});

}

return response.choices[0].message.content;

}

}

// Utilizzo

const bridge = new MCPOpenAIBridge();

await bridge.initialize();

const result = await bridge.executeWithOpenAI(

"Qual è la cronologia ordini per il cliente 12345?"

);

console.log(result);

La sicurezza è fondamentale quando costruisci server MCP che interagiscono con dati sensibili e API esterne. Implementa diversi livelli di sicurezza:

Gestione API Key:

import crypto from "crypto";

class APIKeyManager {

private validKeys: Set<string> = new Set();

constructor() {

// Carica chiavi API valide da ambiente o storage sicuro

const keys = process.env.VALID_API_KEYS?.split(",") || [];

this.validKeys = new Set(keys);

}

validateRequest(apiKey: string): boolean {

return this.validKeys.has(apiKey);

}

generateNewKey(): string {

return crypto.randomBytes(32).toString("hex");

}

}

Firma e verifica richiesta:

import crypto from "crypto";

function signRequest(payload: any, secret: string): string {

return crypto

.createHmac("sha256", secret)

.update(JSON.stringify(payload))

.digest("hex");

}

function verifySignature(payload: any, signature: string, secret: string): boolean {

const expectedSignature = signRequest(payload, secret);

return crypto.timingSafeEqual(

Buffer.from(signature),

Buffer.from(expectedSignature)

);

}

Rate limiting:

import rateLimit from "express-rate-limit";

const limiter = rateLimit({

windowMs: 15 * 60 * 1000, // 15 minuti

max: 100, // massimo 100 richieste per IP ogni 15 minuti

message: "Troppe richieste da questo IP, riprova più tardi.",

});

app.use("/api/", limiter);

Sanitizzazione input:

function sanitizeInput(input: string): string {

// Rimuove caratteri potenzialmente pericolosi

return input

.replace(/[<>]/g, "")

.trim()

.substring(0, 1000); // Limita la lunghezza

}

function validateCustomerId(customerId: string): boolean {

// Consenti solo alfanumerici e trattini

return /^[a-zA-Z0-9-]+$/.test(customerId);

}

Test completi assicurano che il tuo server MCP funzioni correttamente e gestisca bene i casi limite.

Esempio unit test (Jest):

import { getCustomerInfo } from "../tools/customer";

describe("Strumenti Cliente", () => {

test("restituisce info cliente per ID valido", async () => {

const result = await getCustomerInfo("cust_123");

expect(result).toHaveProperty("id");

expect(result).toHaveProperty("name");

expect(result).toHaveProperty("email");

});

test("restituisce errore per ID non valido", async () => {

const result = await getCustomerInfo("invalid");

expect(result).toHaveProperty("error");

});

test("gestisce errori database correttamente", async () => {

// Simula errore database

const result = await getCustomerInfo("cust_error");

expect(result).toHaveProperty("error");

expect(result.status).toBe(500);

});

});

Test di integrazione:

describe("Integrazione server MCP", () => {

let server: Server;

beforeAll(async () => {

server = new Server({ name: "test-server", version: "1.0.0" });

// Inizializzazione server

});

test("elenca tutti gli strumenti disponibili", async () => {

const tools = await server.listTools();

expect(tools.length).toBeGreaterThan(0);

expect(tools[0]).toHaveProperty("name");

expect(tools[0]).toHaveProperty("description");

});

test("esegue strumento e restituisce risultato", async () => {

const result = await server.callTool({

name: "get_customer_info",

arguments: { customer_id: "cust_123" },

});

expect(result).toBeDefined();

});

});

FlowHunt offre una piattaforma completa per automatizzare tutto il ciclo di vita dello sviluppo, test e deployment dei server MCP. Invece di gestire manualmente ogni fase del workflow, FlowHunt ti permette di creare flussi di automazione intelligenti che gestiscono le attività ripetitive e garantiscono coerenza in tutto il processo di sviluppo.

Testing e validazione automatizzati:

FlowHunt può orchestrare la pipeline di test, eseguendo automaticamente test unitari, di integrazione e end-to-end ad ogni commit. Così i tuoi strumenti MCP sono sempre funzionanti prima del rilascio in produzione.

Continuous Integration e Deployment:

Configura workflow FlowHunt per costruire, testare e distribuire automaticamente il server MCP a ogni push sul repository. Questo elimina step manuali e riduce il rischio di errore umano.

Monitoraggio e notifiche:

FlowHunt può monitorare la salute del server MCP, tracciare i tempi di risposta delle API e avvisarti in caso di problemi. Se uno strumento fallisce o le performance peggiorano, sarai subito informato per intervenire.

Generazione automatica della documentazione:

Genera automaticamente la documentazione API per gli strumenti MCP, mantenendola sempre aggiornata rispetto all’implementazione reale. Così gli sviluppatori hanno sempre informazioni corrette e aggiornate.

Ottimizzazione delle performance:

Le analytics di FlowHunt ti aiutano a identificare i colli di bottiglia nell’esecuzione degli strumenti. Puoi vedere quali strumenti sono più chiamati, quali hanno la maggiore latenza e dove intervenire per migliorare.

Il deployment in produzione di un server MCP richiede pianificazione ed esecuzione attente. Ecco alcune strategie consigliate:

Containerizzazione Docker:

Crea un Dockerfile per il tuo server MCP:

FROM node:18-alpine

WORKDIR /app

COPY package*.json ./

RUN npm ci --only=production

COPY dist ./dist

EXPOSE 8000

CMD ["node", "dist/server.js"]

Build e push su un container registry:

docker build -t my-mcp-server:1.0.0 .

docker push myregistry.azurecr.io/my-mcp-server:1.0.0

Deployment su Kubernetes:

Distribuisci il server MCP containerizzato su Kubernetes:

apiVersion: apps/v1

kind: Deployment

metadata:

name: mcp-server

spec:

replicas: 3

selector:

matchLabels:

app: mcp-server

template:

metadata:

labels:

app: mcp-server

spec:

containers:

- name: mcp-server

image: myregistry.azurecr.io/my-mcp-server:1.0.0

ports:

- containerPort: 8000

env:

- name: OPENAI_API_KEY

valueFrom:

secretKeyRef:

name: openai-secrets

key: api-key

- name: DATABASE_URL

valueFrom:

secretKeyRef:

name: db-secrets

key: connection-string

resources:

requests:

memory: "256Mi"

cpu: "250m"

limits:

memory: "512Mi"

cpu: "500m"

Configurazione ambiente:

Usa variabili d’ambiente per tutte le configurazioni:

# .env.production

OPENAI_API_KEY=sk-...

DATABASE_URL=postgresql://user:pass@host:5432/db

MCP_SERVER_PORT=8000

LOG_LEVEL=info

ENABLE_METRICS=true

Man mano che il tuo server MCP cresce in complessità, valuta questi pattern avanzati:

Composizione strumenti:

Crea strumenti di alto livello che compongono strumenti di livello inferiore:

async function processCustomerRefund(customerId: string, orderId: string, amount: number) {

// Ottieni info cliente

const customer = await getCustomerInfo(customerId);

// Ottieni dettagli ordine

const order = await getOrderDetails(orderId);

// Verifica appartenenza ordine-cliente

if (order.customerId !== customerId) {

throw new Error("L’ordine non appartiene al cliente");

}

// Processa rimborso

const refund = await createRefund(orderId, amount);

// Invia notifica

await sendNotification(customer.email, `Rimborso di €${amount} elaborato`);

return refund;

}

Strategie di caching:

Implementa caching per ridurre latenza e chiamate API:

import NodeCache from "node-cache";

const cache = new NodeCache({ stdTTL: 600 }); // TTL 10 minuti

async function getCustomerInfoWithCache(customerId: string) {

const cacheKey = `customer_${customerId}`;

// Prima controlla cache

const cached = cache.get(cacheKey);

if (cached) {

return cached;

}

// Recupera da database

const customer = await getCustomerInfo(customerId);

// Salva in cache

cache.set(cacheKey, customer);

return customer;

}

Elaborazione job asincroni:

Per operazioni lunghe, usa job processing asincrono:

import Bull from "bull";

const jobQueue = new Bull("mcp-jobs");

jobQueue.process(async (job) => {

const { toolName, arguments: args } = job.data;

// Esegui strumento

const result = await executeTool(toolName, args);

return result;

});

async function executeToolAsync(toolName: string, args: any) {

const job = await jobQueue.add(

{ toolName, arguments: args },

{ attempts: 3, backoff: { type: "exponential", delay: 2000 } }

);

return job.id;

}

I server MCP in produzione richiedono monitoring e logging completi:

Logging strutturato:

import winston from "winston";

const logger = winston.createLogger({

format: winston.format.json(),

transports: [

new winston.transports.File({ filename: "error.log", level: "error" }),

new winston.transports.File({ filename: "combined.log" }),

],

});

logger.info("Strumento eseguito", {

toolName: "get_customer_info",

customerId: "cust_123",

duration: 145,

status: "success",

});

Raccolta metriche:

import prometheus from "prom-client";

const toolExecutionDuration = new prometheus.Histogram({

name: "mcp_tool_execution_duration_ms",

help: "Durata esecuzione dello strumento in millisecondi",

labelNames: ["tool_name", "status"],

});

const toolExecutionCounter = new prometheus.Counter({

name: "mcp_tool_executions_total",

help: "Numero totale esecuzioni strumenti",

labelNames: ["tool_name", "status"],

});

async function executeToolWithMetrics(toolName: string, args: any) {

const startTime = Date.now();

try {

const result = await executeTool(toolName, args);

const duration = Date.now() - startTime;

toolExecutionDuration.labels(toolName, "success").observe(duration);

toolExecutionCounter.labels(toolName, "success").inc();

return result;

} catch (error) {

const duration = Date.now() - startTime;

toolExecutionDuration.labels(toolName, "error").observe(duration);

toolExecutionCounter.labels(toolName, "error").inc();

throw error;

}

}

Costruire un server MCP che si collega a OpenAI rappresenta un passo avanti decisivo nella creazione di applicazioni AI intelligenti e integrate. Seguendo i pattern architetturali, le strategie di implementazione e le best practice illustrate in questa guida, puoi creare server MCP robusti e scalabili che estendono le capacità di OpenAI ben oltre il training di base.

La chiave del successo è una pianificazione accurata delle definizioni degli strumenti, una rigorosa implementazione delle misure di sicurezza, test approfonditi e un monitoraggio continuo in produzione. Parti da un set semplice di strumenti, assicurati che funzionino con OpenAI, e amplia gradualmente le capacità del server man mano che acquisisci esperienza e fiducia.

Ricorda che il tuo server MCP non è un artefatto statico—è un sistema vivo che evolverà con le esigenze di business e con le nuove opportunità offerte dall’AI. Progetta con modularità ed estensibilità, documenta accuratamente i tuoi strumenti e mantieni una chiara separazione tra logica di business e implementazione del protocollo MCP.

La combinazione tra server MCP e i potenti modelli linguistici di OpenAI crea opportunità senza precedenti per automazione, intelligenza e integrazione. Padroneggiando questa tecnologia, tu e la tua organizzazione vi posizionate all’avanguardia dell’innovazione AI-driven.

Automate your MCP server development, testing, and deployment workflows. From continuous integration to production monitoring, FlowHunt streamlines every step of your AI development lifecycle.

Il Model Context Protocol è un framework standardizzato che consente a modelli AI come GPT di OpenAI di scoprire, comprendere ed eseguire strumenti e funzioni forniti da server esterni. Agisce come ponte tra modelli AI e logica di business personalizzata.

Hai bisogno di una chiave API OpenAI valida con i permessi appropriati. Il server MCP stesso non richiede permessi speciali da OpenAI—comunica tramite chiamate API standard. Tuttavia, dovresti implementare autenticazione e autorizzazione adeguate sul tuo server MCP.

I server MCP possono essere costruiti in qualsiasi linguaggio che supporti API HTTP/REST o connessioni WebSocket. Le scelte più comuni sono Python, TypeScript/Node.js, Java, C#/.NET e Go. La scelta dipende dalla tua infrastruttura e dalle competenze del team.

Implementa il rate limiting lato server MCP, memorizza in cache i risultati richiesti frequentemente, usa l'exponential backoff per i tentativi e monitora l'utilizzo della tua API OpenAI. Considera l'implementazione di un sistema di coda per le richieste agli strumenti per gestire efficacemente il carico.

Arshia è una AI Workflow Engineer presso FlowHunt. Con una formazione in informatica e una passione per l'IA, è specializzata nella creazione di workflow efficienti che integrano strumenti di intelligenza artificiale nelle attività quotidiane, migliorando produttività e creatività.

Semplifica sviluppo, test e deployment del tuo server MCP con la piattaforma di automazione intelligente di FlowHunt.

Scopri come costruire e distribuire un server Model Context Protocol (MCP) per collegare modelli AI con strumenti esterni e fonti di dati. Guida passo-passo per...

Scopri cosa sono i server MCP (Model Context Protocol), come funzionano e perché stanno rivoluzionando l'integrazione dell'IA. Scopri come MCP semplifica il col...

Esplora esempi completi di server MCP e scopri come costruire, distribuire e integrare server Model Context Protocol per potenziare le capacità degli agenti AI ...

Consenso Cookie

Usiamo i cookie per migliorare la tua esperienza di navigazione e analizzare il nostro traffico. See our privacy policy.