Webflow

Integra FlowHunt con Webflow MCP per automatizzare la gestione di siti e CMS, aggiornare i contenuti e orchestrare workflow intelligenti utilizzando agenti AI e...

Una guida completa per integrare l’intelligenza artificiale con applicazioni esterne tramite API e webhook, incluse autenticazione, comunicazione in tempo reale e strategie pratiche di implementazione.

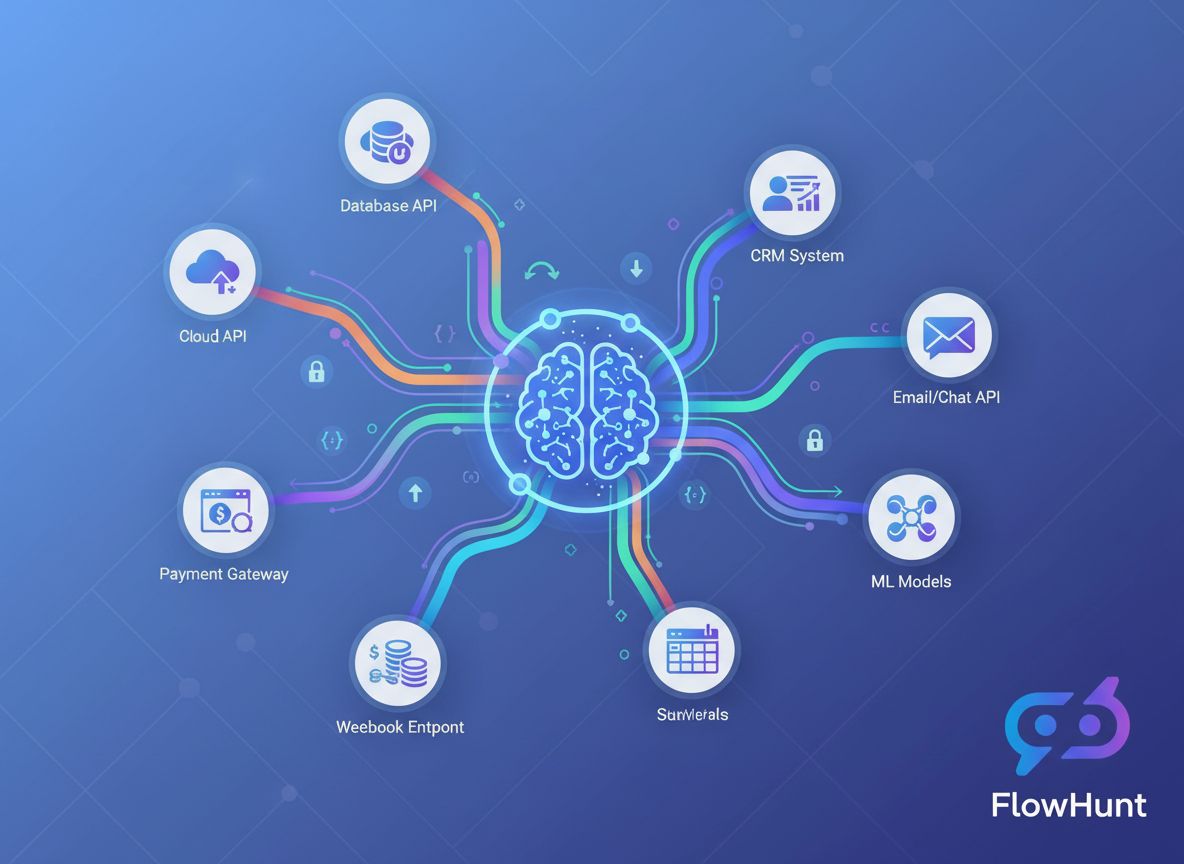

La convergenza tra intelligenza artificiale e applicazioni esterne ha trasformato radicalmente il modo in cui le aziende operano. Le imprese di oggi non lavorano più con sistemi di IA isolati, ma orchestrano integrazioni sofisticate che collegano modelli di IA a piattaforme CRM, gateway di pagamento, strumenti di comunicazione e innumerevoli altri servizi. Questa guida completa esplora gli approcci tecnici e strategici per integrare l’IA con strumenti esterni tramite API e webhook, fornendoti le conoscenze necessarie per costruire workflow IA robusti, scalabili e sicuri.

Che tu sia uno sviluppatore alle prese con la tua prima integrazione IA o un architetto aziendale impegnato nella progettazione di sistemi di automazione complessi, comprendere le sfumature dell’integrazione IA basata su API e webhook è fondamentale. Questo articolo ti accompagna in tutto il processo, dai concetti di base ai pattern avanzati di implementazione, assicurandoti di poter collegare in modo affidabile le capacità dell’IA al tuo stack tecnologico esistente.

Prima di approfondire le strategie di integrazione, è importante comprendere la differenza fondamentale tra questi due paradigmi di comunicazione. Una API (Application Programming Interface) è un insieme di protocolli e strumenti che permette a diverse applicazioni software di comunicare tra loro. Le API operano su un modello pull, cioè è la tua applicazione a richiedere attivamente dati o servizi da un sistema esterno. Quando ti serve un’informazione, invii una richiesta, attendi una risposta ed elabori i dati restituiti.

Al contrario, un webhook funziona secondo un modello push. Invece di far sì che la tua applicazione chieda costantemente aggiornamenti, i webhook permettono ai sistemi esterni di inviare dati in modo proattivo alla tua applicazione quando si verificano eventi specifici. È come la differenza tra controllare ripetutamente la cassetta della posta durante il giorno e ricevere la posta direttamente a casa quando arriva.

Le API sono tipicamente usate per operazioni su richiesta—recuperare informazioni sugli utenti, processare pagamenti, generare predizioni IA o ottenere dati in tempo reale. I webhook, invece, sono eccezionali negli scenari guidati da eventi, in cui serve una notifica immediata quando accade qualcosa: viene processato un pagamento, viene inviato un modulo, viene caricato un file o un utente compie una determinata azione.

La scelta tra API e webhook dipende spesso dal caso d’uso. Molte integrazioni sofisticate utilizzano in realtà entrambi: le API per interrogare i dati e i webhook per ricevere notifiche in tempo reale. Questo approccio ibrido garantisce la flessibilità e la reattività che le applicazioni moderne richiedono.

Il business case per integrare l’IA con strumenti esterni è convincente e sfaccettato. Le organizzazioni che implementano con successo queste integrazioni ottengono vantaggi competitivi significativi su più fronti.

Efficienza operativa e riduzione dei costi: Quando i sistemi di IA sono isolati dagli strumenti esistenti, si creano silos di dati e punti di passaggio manuali. Integrare l’IA direttamente con CRM, piattaforme email, strumenti di project management e altre applicazioni elimina questi attriti. Invece di copiare manualmente i dati tra sistemi, l’IA può processare automaticamente le informazioni, generare insight e attivare azioni su tutto lo stack tecnologico. Questa automazione riduce i costi operativi, minimizza gli errori umani e libera il team per attività strategiche a maggior valore.

Decisioni in tempo reale: I webhook permettono ai sistemi IA di rispondere istantaneamente agli eventi aziendali. Quando un cliente invia un ticket di supporto, il sistema IA può analizzare subito il sentiment e indirizzare la richiesta al team appropriato. Quando i dati di vendita si aggiornano, l’IA può ricalcolare immediatamente le previsioni. Quando le scorte scendono sotto una certa soglia, l’IA può generare automaticamente ordini di acquisto. Questa reattività in tempo reale trasforma la velocità di risposta delle organizzazioni ai cambiamenti del mercato e alle esigenze dei clienti.

Esperienza cliente potenziata: I sistemi IA integrati offrono esperienze fluide e personalizzate. Un chatbot IA integrato con il CRM può accedere alla cronologia dei clienti e fornire risposte contestuali. Un motore di raccomandazione IA integrato con l’e-commerce può proporre prodotti su misura. Un assistente IA per la pianificazione integrato con il calendario può trovare automaticamente orari per gli appuntamenti. Queste integrazioni creano esperienze senza attriti che fidelizzano i clienti.

Insight basati sui dati su larga scala: Collegando l’IA a molteplici fonti dati tramite API, le organizzazioni possono costruire sistemi di analisi completi che processano informazioni da tutta l’operatività aziendale. Questa vista unificata permette predizioni più accurate, miglior riconoscimento dei pattern e insight che sarebbero impossibili con dati isolati.

Considera questi vantaggi chiave:

Le API costituiscono l’ossatura della maggior parte delle integrazioni IA. Per integrare efficacemente l’IA con strumenti esterni, è fondamentale capire come funzionano le API e come interagirci programmaticamente.

Le API moderne si presentano in diverse forme, ciascuna con caratteristiche specifiche. Le API REST (Representational State Transfer) sono il tipo più comune che incontrerai. Utilizzano metodi HTTP standard (GET, POST, PUT, DELETE) per operare su risorse identificate da URL. Le API REST sono stateless, cioè ogni richiesta contiene tutte le informazioni necessarie per essere processata, il che le rende semplici da comprendere e implementare.

Le API GraphQL offrono un’alternativa più flessibile, permettendo ai client di richiedere esattamente i dati di cui hanno bisogno invece di ricevere risposte predefinite. Sono più efficienti per query complesse ma richiedono client più sofisticati.

Le API SOAP (Simple Object Access Protocol) sono protocolli più datati, basati su XML, ancora usati in ambito enterprise. Sono più complesse delle REST ma offrono funzionalità robuste per l’integrazione aziendale.

Le API RPC (Remote Procedure Call) consentono di chiamare funzioni su server remoti come fossero locali. Alcune API di blockchain e criptovalute seguono questo pattern.

Nella maggior parte delle integrazioni IA lavorerai con API REST, che rappresentano un ottimo compromesso tra semplicità e funzionalità.

Ogni interazione con le API richiede autenticazione per verificare che la tua applicazione abbia i permessi necessari. Comprendere i meccanismi di autenticazione è essenziale per un’integrazione IA sicura.

Chiavi API: sono il metodo più semplice. Ricevi una chiave unica quando ti registri a un servizio API e la includi nelle richieste. Sono facili da implementare ma hanno dei limiti: non scadono automaticamente e offrono accesso totale o nullo. Sono adatte per sviluppo e operazioni meno sensibili, ma non dovrebbero essere l’unico livello di sicurezza in produzione.

OAuth 2.0: è lo standard per l’autorizzazione delegata. Invece di condividere le credenziali, OAuth permette agli utenti di autorizzare la tua applicazione ad accedere ai loro dati per loro conto. È lo stesso meccanismo che incontri quando un’app chiede di “accedere al tuo account Google” o “connettersi al tuo spazio Slack”. OAuth è più complesso da implementare ma offre maggiore sicurezza e controllo all’utente.

Bearer Token e JWT (JSON Web Token): fondono la semplicità delle chiavi API con funzionalità di sicurezza aggiuntive. I JWT sono token firmati criptograficamente che contengono informazioni (claim) sull’utente o sull’applicazione. Possono includere scadenze, permessi specifici e altri metadati, ideali per microservizi e sistemi distribuiti.

Mutual TLS (mTLS): utilizza certificati per autenticare sia il client sia il server, offrendo il massimo livello di sicurezza. È spesso usato in ambienti enterprise e per operazioni sensibili.

Interagire con le API significa costruire richieste HTTP con header, parametri e corpo appropriati. Ecco un esempio pratico di chiamata a una API di IA:

import requests

import json

# Imposta l’autenticazione

headers = {

'Authorization': 'Bearer YOUR_API_KEY',

'Content-Type': 'application/json',

}

# Prepara il payload della richiesta

data = {

'model': 'gpt-4',

'messages': [

{

'role': 'user',

'content': 'Analizza questo feedback cliente per il sentiment'

}

],

'temperature': 0.7,

'max_tokens': 500,

}

# Effettua la chiamata API

response = requests.post(

'https://api.openai.com/v1/chat/completions',

headers=headers,

json=data

)

# Gestisci la risposta

if response.status_code == 200:

result = response.json()

ai_response = result['choices'][0]['message']['content']

print(f"Analisi IA: {ai_response}")

else:

print(f"Errore: {response.status_code} - {response.text}")

Questo esempio mostra il pattern fondamentale: autenticazione, costruzione della richiesta, invio all’endpoint API ed elaborazione della risposta. La maggior parte delle integrazioni API IA segue questa struttura di base, anche se parametri e formati di risposta possono variare.

Mentre le API estraggono i dati su richiesta, i webhook permettono una comunicazione push in tempo reale. Comprendere l’architettura dei webhook è essenziale per costruire sistemi IA reattivi.

Un webhook è essenzialmente un meccanismo di callback. Registri un URL presso un servizio esterno e, quando si verificano determinati eventi, quel servizio invia una richiesta HTTP POST al tuo URL con i dati dell’evento. La tua applicazione riceve questi dati, li elabora e compie le azioni necessarie.

Il flusso tipico è il seguente:

Per ricevere i webhook devi creare un endpoint HTTP che accetti richieste POST. Ecco un esempio pratico con Flask:

from flask import Flask, request, jsonify

import hmac

import hashlib

import json

app = Flask(__name__)

WEBHOOK_SECRET = 'your_webhook_secret_key'

def verify_webhook_signature(payload, signature):

"""Verifica che il webhook provenga dalla fonte attesa"""

expected_signature = hmac.new(

WEBHOOK_SECRET.encode(),

payload,

hashlib.sha256

).hexdigest()

return hmac.compare_digest(signature, expected_signature)

@app.route('/webhook/payment', methods=['POST'])

def handle_payment_webhook():

# Ottieni il payload grezzo per verificare la firma

payload = request.get_data()

signature = request.headers.get('X-Signature')

# Verifica l’autenticità del webhook

if not verify_webhook_signature(payload, signature):

return jsonify({'error': 'Firma non valida'}), 401

# Analizza i dati JSON

data = request.json

# Gestisci l’evento webhook

try:

if data['event_type'] == 'payment.completed':

# Attiva analisi IA della transazione

analyze_transaction(data['transaction_id'], data['amount'])

# Aggiorna il database

update_payment_status(data['transaction_id'], 'completed')

# Invia conferma

send_confirmation_email(data['customer_email'])

# Restituisci sempre 200 per confermare la ricezione

return jsonify({'status': 'received'}), 200

except Exception as e:

# Registra l’errore ma restituisci comunque 200 per evitare retry

log_error(f"Errore durante l’elaborazione del webhook: {str(e)}")

return jsonify({'status': 'received'}), 200

if __name__ == '__main__':

app.run(port=5000)

Questo esempio illustra alcune best practice fondamentali: verifica della firma per l’autenticità, gestione corretta degli errori e restituzione sempre di una risposta di successo per evitare retry dal servizio esterno.

I webhook introducono sfide di sicurezza uniche perché servizi esterni inviano dati alla tua applicazione. Sono essenziali alcune misure:

Verifica della firma: La maggior parte dei provider webhook include una firma negli header, calcolata tramite un segreto condiviso. Verifica sempre questa firma per assicurarti che il webhook provenga dalla fonte attesa e non sia stato alterato.

Solo HTTPS: Usa sempre HTTPS per gli endpoint webhook. Questo cripta i dati in transito e previene attacchi man-in-the-middle.

Whitelist degli IP: Se possibile, limita l’accesso solo agli IP da cui provengono i webhook. Questo impedisce a fonti non autorizzate di inviare richieste.

Rate limiting: Implementa limiti sul numero di richieste accettate dagli endpoint per evitare abusi o flood accidentali.

Idempotenza: Progetta i gestori dei webhook affinché siano idempotenti: elaborare lo stesso webhook più volte non deve produrre effetti collaterali. Questo è importante perché i provider possono ritentare la consegna se la ricezione fallisce.

Ora che abbiamo compreso i fondamenti, vediamo come integrare i modelli IA con servizi esterni. Qui emerge la vera potenza dell’integrazione IA.

Il panorama IA offre molte opzioni, ognuna con capacità, prezzi e modalità di integrazione differenti. L’API di OpenAI mette a disposizione GPT-4, GPT-3.5 e altri modelli per NLP, generazione di codice e ragionamento. Google Cloud AI offre servizi come Vertex AI, Document AI e Vision AI. AWS propone SageMaker per modelli custom e vari servizi IA preconfezionati. Claude API di Anthropic è specializzata in IA sicura e interpretabile. Hugging Face fornisce modelli open source e un model hub.

La scelta dipende da vari fattori: capacità IA richieste, budget, latenze, requisiti di privacy sui dati e preferenza tra servizio gestito o self-hosted.

Una tipica pipeline di integrazione IA include: raccolta dati da fonti esterne tramite API, pre-processing ed enrichment, inferenza del modello IA, elaborazione dei risultati e attivazione di azioni. Ecco un esempio pratico che integra più componenti:

import requests

import json

from datetime import datetime

import logging

class AIIntegrationPipeline:

def __init__(self, ai_api_key, crm_api_key):

self.ai_api_key = ai_api_key

self.crm_api_key = crm_api_key

self.logger = logging.getLogger(__name__)

def fetch_customer_data(self, customer_id):

"""Recupera dati cliente dal CRM tramite API"""

headers = {'Authorization': f'Bearer {self.crm_api_key}'}

response = requests.get(

f'https://api.crm.example.com/customers/{customer_id}',

headers=headers

)

return response.json()

def analyze_with_ai(self, text_content):

"""Invia il contenuto all’API IA per l’analisi"""

headers = {

'Authorization': f'Bearer {self.ai_api_key}',

'Content-Type': 'application/json'

}

payload = {

'model': 'gpt-4',

'messages': [

{

'role': 'system',

'content': 'Sei un analista del servizio clienti. Analizza la seguente interazione e fornisci insight.'

},

{

'role': 'user',

'content': text_content

}

],

'temperature': 0.5,

'max_tokens': 1000

}

response = requests.post(

'https://api.openai.com/v1/chat/completions',

headers=headers,

json=payload

)

if response.status_code == 200:

return response.json()['choices'][0]['message']['content']

else:

self.logger.error(f"Errore API IA: {response.status_code}")

raise Exception("Analisi IA fallita")

def update_crm_with_insights(self, customer_id, insights):

"""Aggiorna il CRM con gli insight generati dalla IA"""

headers = {

'Authorization': f'Bearer {self.crm_api_key}',

'Content-Type': 'application/json'

}

payload = {

'ai_insights': insights,

'last_analyzed': datetime.now().isoformat(),

'analysis_status': 'completed'

}

response = requests.put(

f'https://api.crm.example.com/customers/{customer_id}',

headers=headers,

json=payload

)

return response.status_code == 200

def process_customer(self, customer_id):

"""Pipeline completa: recupera, analizza, aggiorna"""

try:

# Recupera i dati cliente

customer_data = self.fetch_customer_data(customer_id)

# Prepara il contenuto per l’analisi IA

content_to_analyze = f"""

Cliente: {customer_data['name']}

Interazioni recenti: {customer_data['recent_interactions']}

Storico acquisti: {customer_data['purchase_history']}

"""

# Ottieni analisi IA

insights = self.analyze_with_ai(content_to_analyze)

# Aggiorna il CRM con gli insight

success = self.update_crm_with_insights(customer_id, insights)

if success:

self.logger.info(f"Cliente {customer_id} processato con successo")

return {'status': 'success', 'insights': insights}

else:

self.logger.error(f"Aggiornamento CRM fallito per il cliente {customer_id}")

return {'status': 'error', 'message': 'Aggiornamento CRM fallito'}

except Exception as e:

self.logger.error(f"Errore nella pipeline: {str(e)}")

return {'status': 'error', 'message': str(e)}

Questo esempio dimostra una pipeline completa: recupero dati da CRM, invio al modello IA per analisi, aggiornamento CRM con i risultati. Questo pattern è adattabile a innumerevoli scenari di business.

Diversi scenari di integrazione richiedono strategie architetturali differenti. Comprendere i pro e i contro ti aiuta a scegliere la soluzione più adatta.

| Approccio | Migliore per | Vantaggi | Svantaggi | Latenza |

|---|---|---|---|---|

| Chiamate API sincrone | Operazioni in tempo reale, funzioni rivolte all’utente | Semplice, feedback immediato, facile da debug | Più lento se il modello IA è lento, blocca l’esecuzione | Bassa-Media |

| Asincrono con webhook | Workflow guidati da eventi, elaborazione ad alto volume | Non blocca, scalabile, reattivo | Più complesso, consistenza eventuale | Media-Alta |

| Message Queue | Sistemi disaccoppiati, elaborazione batch | Consegna affidabile, bilanciamento carico, retry | Infrastruttura aggiuntiva, consistenza eventuale | Media-Alta |

| Job schedulati | Analisi periodiche, batch | Semplice, uso risorse prevedibile | Non in tempo reale, può perdere eventi urgenti | Alta |

| Integrazione streaming | Elaborazione dati real-time, analisi continua | Insight immediati, gestisce alti volumi | Infrastruttura complessa, strumenti specializzati richiesti | Molto bassa |

Ogni approccio ha il suo ambito. Un sistema di supporto clienti può usare chiamate API sincrone per risposte istantanee del chatbot e processi asincroni per analisi di sentiment più approfondite. Una piattaforma e-commerce può usare webhook per eventi d’ordine e job schedulati per analisi inventario notturne.

Gestire manualmente molte integrazioni API e webhook può diventare complesso man mano che il sistema cresce. Qui entra in gioco FlowHunt.

FlowHunt è una piattaforma completa di automazione dei workflow, pensata appositamente per le integrazioni IA. Invece di scrivere e mantenere codice di integrazione custom, FlowHunt mette a disposizione un’interfaccia visuale per collegare modelli IA, API e webhook, gestire le autenticazioni, gli errori e monitorare le performance.

Visual Workflow Builder: Progetta workflow di integrazione complessi senza scrivere codice. Collega modelli IA, API e webhook tramite drag & drop. FlowHunt gestisce le richieste HTTP, l’autenticazione e la trasformazione dei dati.

Connettori predefiniti: FlowHunt offre connettori per i principali servizi IA (OpenAI, Google Cloud AI, Anthropic) e centinaia di strumenti esterni (Salesforce, HubSpot, Slack, Stripe ecc.). I connettori gestiscono autenticazione e dettagli specifici delle API, così puoi concentrarti sulla logica di business.

Gestione webhook: FlowHunt semplifica la configurazione e la gestione dei webhook. Registra i webhook presso servizi esterni, ricevi eventi e attiva l’analisi IA direttamente dall’interfaccia di FlowHunt, senza sviluppare e mantenere ricevitori webhook.

Gestione errori e retry: Retry automatico delle chiamate API fallite con backoff esponenziale. Notifiche di errore e workflow di fallback. FlowHunt garantisce resilienza e affidabilità alle tue integrazioni.

Trasformazione dati: Trasforma i dati tra diversi formati e strutture. Mappa i campi dal CRM agli input dei modelli IA, trasforma gli output IA nei formati attesi dagli altri strumenti.

Monitoraggio e logging: Traccia ogni chiamata API, evento webhook ed esecuzione workflow. Identifica colli di bottiglia, effettua debug e ottimizza le performance con logging e analytics completi.

Rate limiting e throttling: FlowHunt gestisce automaticamente i limiti di chiamata delle API, mettendo in coda le richieste e distribuendole nel tempo per rispettare i limiti dei servizi.

Immagina di voler analizzare automaticamente i feedback dei clienti dal sistema di supporto, categorizzare il sentiment e aggiornare il CRM. In FlowHunt il workflow sarebbe:

Ciò che richiederebbe decine di righe di codice e gestione attenta degli errori in una soluzione custom diventa un workflow visuale in FlowHunt. Puoi modificarlo, aggiungere step o cambiare modello IA senza toccare codice.

Quando le esigenze di integrazione IA diventano più sofisticate, entrano in gioco pattern avanzati e best practice fondamentali.

Quasi tutte le API impongono limiti di chiamata—numero massimo di richieste per minuto o ora. Superarli porta a errori o sospensione del servizio. Gestire efficacemente i limiti è cruciale per integrazioni affidabili.

Implementa il backoff esponenziale: se raggiungi il limite, attendi prima di riprovare, aumentando il tempo di attesa a ogni tentativo. Molte API includono informazioni sui limiti negli header di risposta, permettendoti di gestire proattivamente il ritmo delle richieste.

import time

import requests

def call_api_with_backoff(url, headers, data, max_retries=5):

"""Chiama l’API con backoff esponenziale per gestire i limiti"""

for attempt in range(max_retries):

try:

response = requests.post(url, headers=headers, json=data)

# Controlla se hai raggiunto il rate limit

if response.status_code == 429:

# Estrai l’header retry-after se presente

retry_after = int(response.headers.get('Retry-After', 2 ** attempt))

print(f"Rate limit raggiunto. Attendo {retry_after} secondi...")

time.sleep(retry_after)

continue

# Gestisci altri errori

response.raise_for_status()

return response.json()

except requests.exceptions.RequestException as e:

if attempt == max_retries - 1:

raise

wait_time = 2 ** attempt

print(f"Richiesta fallita: {e}. Riprovo tra {wait_time} secondi...")

time.sleep(wait_time)

raise Exception("Superato il numero massimo di retry")

Alcune operazioni IA richiedono tempo. Invece di bloccare l’applicazione, usa pattern asincroni in cui il servizio IA restituisce un job ID e puoi effettuare polling o ricevere un webhook di completamento.

def submit_async_ai_job(content):

"""Invia contenuto per elaborazione IA asincrona"""

headers = {'Authorization': f'Bearer {AI_API_KEY}'}

response = requests.post(

'https://api.ai.example.com/async-analyze',

headers=headers,

json={'content': content}

)

job_data = response.json()

return job_data['job_id']

def check_job_status(job_id):

"""Verifica lo stato del job asincrono"""

headers = {'Authorization': f'Bearer {AI_API_KEY}'}

response = requests.get(

f'https://api.ai.example.com/jobs/{job_id}',

headers=headers

)

job_data = response.json()

if job_data['status'] == 'completed':

return {'status': 'completed', 'result': job_data['result']}

elif job_data['status'] == 'failed':

return {'status': 'failed', 'error': job_data['error']}

else:

return {'status': 'processing'}

Chiamare ripetutamente le API IA per input identici è uno spreco di risorse e aumenta i costi. Implementa cache per memorizzare i risultati delle query più comuni.

import hashlib

import json

from functools import wraps

import redis

# Connessione a Redis

cache = redis.Redis(host='localhost', port=6379, db=0)

def cache_ai_result(ttl=3600):

"""Decorator per cache dei risultati IA"""

def decorator(func):

@wraps(func)

def wrapper(content, *args, **kwargs):

# Chiave cache tramite hash del contenuto

content_hash = hashlib.md5(content.encode()).hexdigest()

cache_key = f"ai_result:{content_hash}"

# Controlla cache

cached_result = cache.get(cache_key)

if cached_result:

return json.loads(cached_result)

# Chiama API IA

result = func(content, *args, **kwargs)

# Memorizza in cache

cache.setex(cache_key, ttl, json.dumps(result))

return result

return wrapper

return decorator

@cache_ai_result(ttl=86400) # Cache 24 ore

def analyze_sentiment(text):

"""Analizza il sentiment con cache"""

# Chiamata API IA qui

pass

Le integrazioni in produzione richiedono monitoraggio avanzato. Traccia tempi di risposta, tassi di errore e successo dei webhook. Configura alert per anomalie.

import logging

from datetime import datetime

import json

class IntegrationMonitor:

def __init__(self, log_file='integration.log'):

self.logger = logging.getLogger(__name__)

handler = logging.FileHandler(log_file)

formatter = logging.Formatter(

'%(asctime)s - %(name)s - %(levelname)s - %(message)s'

)

handler.setFormatter(formatter)

self.logger.addHandler(handler)

def log_api_call(self, service, endpoint, status_code, response_time, error=None):

"""Log dei parametri chiave delle chiamate API"""

log_entry = {

'timestamp': datetime.now().isoformat(),

'service': service,

'endpoint': endpoint,

'status_code': status_code,

'response_time_ms': response_time,

'error': error

}

self.logger.info(json.dumps(log_entry))

def log_webhook_event(self, event_type, source, success, processing_time):

"""Log degli eventi webhook"""

log_entry = {

'timestamp': datetime.now().isoformat(),

'event_type': event_type,

'source': source,

'success': success,

'processing_time_ms': processing_time

}

self.logger.info(json.dumps(log_entry))

Vediamo come questi concetti si traducono in uno scenario reale di business.

La sfida: Un’azienda di e-commerce voleva migliorare l’esperienza cliente offrendo raccomandazioni personalizzate, categorizzando automaticamente le recensioni e rilevando ordini fraudolenti. Aveva diversi sistemi: uno store Shopify, una piattaforma recensioni custom, un processore pagamenti e un database clienti. Questi sistemi non comunicavano tra loro e l’analisi manuale era onerosa.

La soluzione: Hanno costruito un sistema IA integrato tramite API e webhook:

Motore raccomandazioni prodotto: Quando un cliente visualizza un prodotto (webhook da Shopify), il sistema recupera lo storico acquisti tramite API, invia i dati a un modello IA e restituisce raccomandazioni personalizzate. Il modello considera caratteristiche prodotto, preferenze cliente e trend.

Pipeline analisi recensioni: Quando viene inviata una recensione (webhook), il sistema la sottopone a un’analisi IA per sentiment, estrazione di topic e valutazione della qualità. I risultati vengono salvati sulla piattaforma recensioni via API, aiutando l’azienda a capire il sentiment su larga scala.

Sistema antifrode: Quando viene effettuato un ordine (webhook), il sistema recupera storico cliente e dettagli ordine via API, invia tutto a un modello antifrode IA e approva l’ordine o lo segnala per revisione manuale.

Risultati:

Le API sono sistemi basati su richiesta (pull), in cui richiedi dati da un servizio esterno, mentre i webhook sono sistemi basati su invio (push), in cui i servizi esterni inviano dati alla tua applicazione al verificarsi di eventi specifici. Le API sono ideali per il recupero dati su richiesta, mentre i webhook eccellono nelle notifiche di eventi in tempo reale.

Archivia le chiavi API in variabili d’ambiente, utilizza strumenti dedicati per la gestione dei segreti come HashiCorp Vault o AWS Secrets Manager, non inserire mai le chiavi nel controllo versione, ruota regolarmente le chiavi e applica il principio del privilegio minimo limitando i permessi delle chiavi alle sole operazioni necessarie.

I metodi di autenticazione più comuni includono chiavi API (token semplici), OAuth 2.0 (autorizzazione delegata), Bearer token (basati su JWT) e TLS reciproco (basato su certificato). La scelta dipende dai requisiti di sicurezza del fornitore API e dalle necessità della tua applicazione.

Implementa strategie di retry con backoff esponenziale, monitora gli header di rate limit nelle risposte API, utilizza sistemi di coda per le richieste, memorizza in cache le risposte quando possibile e valuta l’aggiornamento a piani API superiori se superi regolarmente i limiti. Molte librerie offrono meccanismi di retry integrati.

Arshia è una AI Workflow Engineer presso FlowHunt. Con una formazione in informatica e una passione per l'IA, è specializzata nella creazione di workflow efficienti che integrano strumenti di intelligenza artificiale nelle attività quotidiane, migliorando produttività e creatività.

FlowHunt semplifica l’integrazione dell’IA con strumenti esterni, automatizzando chiamate API, gestione dei webhook e elaborazione dei dati in un’unica piattaforma.

Integra FlowHunt con Webflow MCP per automatizzare la gestione di siti e CMS, aggiornare i contenuti e orchestrare workflow intelligenti utilizzando agenti AI e...

Integra WayStation di FlowHunt con i tuoi strumenti di produttività preferiti e i principali client AI per un'automazione senza codice, sicura e fluida. Collega...

Integra FlowHunt con Oat++ MCP per abilitare il supporto senza soluzione di continuità del Model Context Protocol di Anthropic per le tue API. Automatizza la ge...

Consenso Cookie

Usiamo i cookie per migliorare la tua esperienza di navigazione e analizzare il nostro traffico. See our privacy policy.