Decodifica dei modelli di agenti AI: L’analisi comparativa definitiva

Esplora il mondo dei modelli di agenti AI con un’analisi completa di 20 sistemi all’avanguardia. Scopri come pensano, ragionano e si comportano in vari compiti,...

Un’analisi approfondita del modello di ragionamento EXAONE Deep 32B di LG testato contro DeepSeek R1 e QwQ di Alibaba, esaminando le affermazioni sulle prestazioni superiori e le reali capacità di ragionamento.

Il panorama dei modelli di ragionamento nell’intelligenza artificiale è diventato sempre più competitivo, con numerose organizzazioni che dichiarano risultati rivoluzionari su compiti matematici e logici complessi. Il recente rilascio di EXAONE Deep da parte di LG, un modello di ragionamento da 32 miliardi di parametri, ha attirato molta attenzione grazie alle affermazioni di prestazioni superiori rispetto a concorrenti affermati come DeepSeek R1. Tuttavia, i test reali rivelano un quadro più sfumato rispetto alle promesse di marketing. Questo articolo offre un’analisi approfondita delle reali prestazioni di EXAONE Deep rispetto ad altri modelli di ragionamento leader, esaminando il divario tra i benchmark dichiarati e la funzionalità pratica. Attraverso test pratici e un confronto dettagliato, esploreremo cosa sono realmente in grado di fare questi modelli, come gestiscono compiti di ragionamento complessi e cosa significa questo per le organizzazioni che valutano questi strumenti per un utilizzo in produzione.

L’emergere dei modelli di ragionamento rappresenta un cambiamento fondamentale nell’approccio dell’intelligenza artificiale alla risoluzione di problemi complessi. A differenza dei modelli linguistici tradizionali che generano risposte in un unico passaggio, i modelli di ragionamento impiegano una tecnica chiamata decodifica in fase di test, che assegna rilevanti risorse computazionali durante l’inferenza per ragionare passo dopo passo. Questo approccio rispecchia il ragionamento umano, dove spesso dobbiamo considerare più angolazioni di un problema prima di arrivare a una soluzione. Il concetto è emerso con il modello o1 di OpenAI ed è stato poi adottato da diverse organizzazioni, tra cui DeepSeek, Alibaba e ora LG. Questi modelli generano quella che viene chiamata una sequenza di token di “pensiero” o “ragionamento” che gli utenti solitamente non vedono nell’output finale, ma che rappresenta il processo interno di deliberazione del modello. I token di pensiero sono fondamentali perché permettono al modello di esplorare diversi percorsi di soluzione, individuare errori e affinare il proprio approccio prima di produrre una risposta definitiva. Questo è particolarmente prezioso per problemi matematici, compiti di ragionamento logico e scenari complessi a più step, dove un singolo passaggio potrebbe trascurare dettagli importanti o portare a conclusioni errate.

Per le organizzazioni che implementano sistemi AI, i modelli di ragionamento rappresentano un grande passo avanti in termini di affidabilità e accuratezza su compiti complessi. I modelli linguistici tradizionali spesso fanno fatica con problemi matematici a più passaggi, deduzione logica e scenari che richiedono un’analisi accurata di vincoli e condizioni. I modelli di ragionamento affrontano questi limiti mostrando esplicitamente il proprio lavoro, offrendo anche trasparenza su come il modello è giunto alla conclusione. Questa trasparenza è particolarmente importante in ambito aziendale, dove le decisioni basate su suggerimenti AI devono essere verificabili e spiegabili. Il rovescio della medaglia, tuttavia, è il costo computazionale e la latenza. Poiché i modelli di ragionamento generano lunghi token di pensiero prima di produrre una risposta finale, richiedono più potenza di calcolo e rispondono più lentamente rispetto ai modelli standard. Questo rende fondamentale la scelta del modello: le organizzazioni devono comprendere non solo i punteggi di benchmark, ma anche le reali prestazioni pratiche sui loro specifici casi d’uso. La proliferazione di modelli di ragionamento da parte di diversi fornitori, ognuno dei quali afferma prestazioni superiori, rende essenziale il testing e il confronto indipendente per prendere decisioni informate sull’adozione.

L’ingresso di LG nel campo dei modelli di ragionamento con EXAONE Deep ha suscitato notevole interesse, soprattutto considerando le significative capacità di ricerca dell’azienda e la dimensione relativamente contenuta del modello da 32 miliardi di parametri. Il materiale di marketing di LG ha presentato risultati di benchmark impressionanti, affermando che EXAONE Deep ha raggiunto il 90% di accuratezza nella competizione AIME (American Invitational Mathematics Examination) con solo 64 tentativi e il 95% nei problemi MATH-500. Questi numeri, se confermati, rappresenterebbero prestazioni competitive o superiori rispetto a DeepSeek R1 e QwQ di Alibaba. L’azienda ha anche rilasciato più versioni del modello di diverse dimensioni, incluso un modello da 2,4 miliardi di parametri pensato come modello draft per la decodifica speculativa: una tecnica che usa modelli più piccoli per prevedere i token che i modelli più grandi genereranno, accelerando potenzialmente l’inferenza. Tuttavia, quando sottoposto a test pratici su problemi di ragionamento standard, EXAONE Deep ha mostrato comportamenti preoccupanti in contrasto con i benchmark dichiarati. Il modello tendeva a entrare in loop di pensiero prolungati senza giungere a conclusioni logiche, generando migliaia di token che risultavano ripetitivi o senza senso piuttosto che ragionamenti produttivi. Questo comportamento suggerisce possibili problemi nella fase di training del modello, nella metodologia di valutazione dei benchmark o nella gestione di certi tipi di prompt.

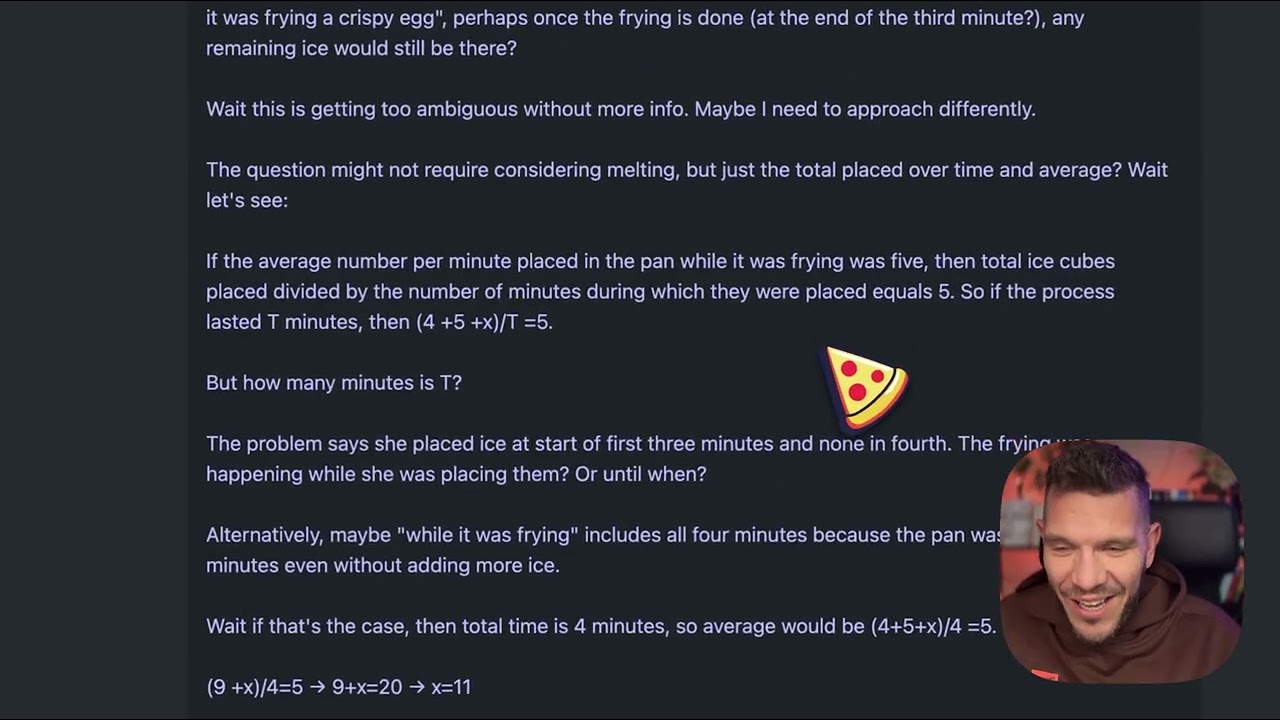

Per comprendere le differenze pratiche tra i modelli di ragionamento, consideriamo un problema apparentemente semplice che è diventato uno standard di test per la qualità di questi modelli: “Beth mette dei cubetti di ghiaccio interi in una padella. Dopo un minuto ci sono 20 cubetti di ghiaccio. Dopo due minuti ce ne sono 10. Dopo tre minuti ce ne sono 0. Quanti cubetti di ghiaccio interi si trovano nella padella alla fine del terzo minuto?” La risposta corretta è zero, poiché la domanda chiede esplicitamente dei cubetti interi alla fine del terzo minuto e il problema afferma che in quel momento ce ne sono zero. Tuttavia, il problema è progettato per ingannare i modelli che tendono a sovrappensare o si confondono con la narrazione dei cubetti che si sciolgono. Alcuni modelli potrebbero ragionare che i cubetti si sciolgono nel tempo e cercare di calcolare i tassi di scioglimento, portandoli fuori strada rispetto alla risposta diretta. Quando EXAONE Deep è stato testato su questo problema, ha generato circa 5.000 token di pensiero senza giungere a una conclusione coerente. Il processo di ragionamento del modello sembrava andare fuori controllo, con il testo generato che diventava sempre più incoerente e incapace di mostrare una risoluzione logica del problema. I token prodotti includevano frammenti che non formavano pensieri completi e il modello non ha mai articolato chiaramente un percorso di ragionamento o una risposta conclusiva. Questa prestazione è in netto contrasto con il modo in cui il problema dovrebbe essere gestito: un modello di ragionamento dovrebbe riconoscere il tranello, ragionare in modo chiaro e arrivare rapidamente alla risposta.

Quando lo stesso problema dei cubetti di ghiaccio è stato testato su DeepSeek R1 e sul modello QwQ di Alibaba, entrambi hanno mostrato prestazioni nettamente superiori. DeepSeek R1 ha generato un processo di pensiero chiaro, ha affrontato il problema in modo metodico ed è arrivato alla risposta corretta di zero. Il ragionamento del modello era trasparente e logico, mostrando come ha analizzato il problema, riconosciuto l’inganno e giunto alla risposta esatta. QwQ si è comportato in modo simile, anche se ha generato anch’esso un processo di pensiero esteso. Curiosamente, QwQ ha inizialmente considerato se i cubetti di ghiaccio avessero bisogno di tempo per sciogliersi e se il problema riguardasse la fisica o la matematica, ma alla fine è arrivato alla risposta corretta. La differenza chiave è che entrambi i modelli hanno mostrato un ragionamento coerente durante tutto il processo, anche quando esploravano più ipotesi. Hanno dimostrato la capacità di riconoscere quando avevano informazioni sufficienti per rispondere e di impegnarsi in una risposta finale. EXAONE Deep, invece, non ha mai raggiunto questo punto. Il modello ha continuato a generare token senza uno scopo apparente, senza mai decidere una risposta o mostrare una progressione logica chiara. Questo suggerisce problemi fondamentali nel modo in cui il modello gestisce i compiti di ragionamento, nonostante le affermazioni di benchmark impressionanti.

Un aspetto tecnico interessante del rilascio di EXAONE Deep è l’inclusione di varianti di modello di diverse dimensioni progettate per lavorare insieme tramite decodifica speculativa. La versione da 2,4 miliardi di parametri può fungere da modello draft che prevede i token che il modello principale da 32 miliardi genererà. Quando le previsioni del modello draft coincidono con la generazione del modello principale, il sistema può saltare il calcolo del modello maggiore e utilizzare la previsione draft, accelerando di fatto l’inferenza. Questa è una tecnica di ottimizzazione sofisticata che può ridurre significativamente la latenza e i requisiti computazionali. Nei test, l’implementazione della decodifica speculativa ha mostrato token verdi a indicare previsioni draft riuscite, suggerendo che la tecnica funzionava come previsto. Tuttavia, questa ottimizzazione non risolve il problema fondamentale della qualità del ragionamento del modello principale. Una generazione più rapida di ragionamenti scarsi resta comunque scadente. La presenza di questa funzionalità di ottimizzazione solleva anche dubbi sul fatto che i risultati dei benchmark LG siano stati ottenuti con configurazioni o tecniche che non si traducono bene nell’uso reale.

Per le organizzazioni che faticano a valutare e confrontare più modelli AI, FlowHunt offre una piattaforma di automazione completa che semplifica i processi di test e benchmarking. Invece di eseguire manualmente test su diversi modelli e confrontare i risultati, FlowHunt consente ai team di creare flussi di lavoro automatizzati che valutano sistematicamente le prestazioni dei modelli su più dimensioni. Questo è particolarmente prezioso quando si confrontano modelli di ragionamento, poiché le prestazioni possono variare notevolmente in base al tipo di problema, alla complessità e alla formulazione specifica del prompt. Le capacità di automazione di FlowHunt permettono ai team di testare i modelli su set di problemi standardizzati, monitorare le metriche di performance nel tempo e generare report di confronto completi. La piattaforma può integrarsi con diversi provider di modelli e API, rendendo possibile valutare modelli di vari fornitori all’interno di un unico workflow unificato. Per i team che valutano la messa in produzione di modelli di ragionamento come EXAONE Deep, DeepSeek R1 o QwQ, FlowHunt fornisce l’infrastruttura per prendere decisioni basate sui dati reali e non sulle affermazioni dei fornitori. L’automazione dei test ripetitivi libera inoltre risorse ingegneristiche da dedicare all’integrazione e all’ottimizzazione invece che al benchmarking manuale.

Il divario tra le prestazioni dichiarate di EXAONE Deep e il suo comportamento reale nei test evidenzia una lezione fondamentale per l’adozione dell’AI: i benchmark dei fornitori vanno sempre verificati tramite test indipendenti. I risultati dei benchmark possono essere influenzati da numerosi fattori, tra cui il set di test specifico utilizzato, la metodologia di valutazione, la configurazione hardware e i parametri di inferenza del modello. Un modello può avere buoni risultati su un particolare benchmark ma faticare su altri tipi di problemi o scenari reali. Ecco perché organizzazioni come Weights & Biases e ricercatori indipendenti svolgono un ruolo chiave nell’ecosistema AI: forniscono test e analisi imparziali che aiutano la comunità a capire cosa possono realmente fare i modelli. Quando si valutano modelli di ragionamento per la produzione, le organizzazioni dovrebbero condurre test su set di problemi rappresentativi del proprio dominio. Un modello eccellente nel ragionamento matematico potrebbe faticare con la deduzione logica o la generazione di codice. Il problema dei cubetti di ghiaccio, per quanto semplice possa sembrare, è un test diagnostico utile perché rivela se un modello sa gestire domande trabocchetto ed evitare l’overthinking. Modelli che falliscono su questi problemi probabilmente avranno difficoltà anche con compiti di ragionamento più complessi.

I loop di pensiero prolungati osservati nei test di EXAONE Deep potrebbero derivare da diversi problemi. Una possibilità è che il processo di training non abbia insegnato al modello quando fermarsi e fornire una risposta. I modelli di ragionamento richiedono una calibrazione accurata in fase di training per bilanciare i benefici del pensiero esteso con i rischi dell’overthinking e della generazione di token improduttivi. Se il training non includeva abbastanza esempi su quando fermarsi, il modello potrebbe tendere a generare token fino a raggiungere un limite massimo. Un’altra possibilità è che ci siano problemi nella gestione del prompt, in particolare su come il modello interpreta certi tipi di domande o istruzioni. Alcuni modelli sono sensibili alla formulazione del prompt e possono comportarsi diversamente a seconda di come viene posta una domanda. Il fatto che EXAONE Deep abbia generato sequenze di token incoerenti suggerisce che il modello possa entrare in uno stato in cui genera token senza contenuto semantico significativo, il che potrebbe indicare problemi nei meccanismi di attenzione o nella logica di previsione dei token. Una terza possibilità è che la metodologia di valutazione dei benchmark abbia utilizzato configurazioni o strategie di prompting diverse rispetto a quelle adottate nei test pratici, portando a un divario significativo tra i risultati dichiarati e quelli reali.

I problemi di prestazione osservati con EXAONE Deep hanno implicazioni più ampie per il mercato dei modelli di ragionamento. Con il rilascio di sempre più modelli, il rischio è una saturazione di modelli con benchmark impressionanti ma prestazioni reali discutibili. Questo crea un ambiente difficile per le organizzazioni che devono scegliere modelli per la produzione. La soluzione è un maggiore focus su test indipendenti, metodologie di valutazione standardizzate e trasparenza sui limiti dei modelli. Il settore trarrebbe beneficio da standard industriali condivisi su come valutare e confrontare questi modelli, simili a quanto avvenuto in altri ambiti dell’AI. Inoltre, le organizzazioni dovrebbero diffidare di modelli che dichiarano di superare nettamente i concorrenti affermati, soprattutto quando il divario di prestazioni sembra incoerente con l’architettura o l’approccio di training. DeepSeek R1 e QwQ hanno mostrato prestazioni costanti in diversi scenari di test, il che dà fiducia nelle loro capacità. Le prestazioni incoerenti di EXAONE Deep—benchmark eccellenti ma risultati pratici deludenti—suggeriscono problemi nel modello stesso o nella conduzione dei benchmark.

Scopri come FlowHunt automatizza i tuoi flussi di lavoro AI e SEO — dalla ricerca e generazione dei contenuti fino alla pubblicazione e all’analisi — tutto in un unico posto.

Le organizzazioni che valutano l’adozione di modelli di ragionamento dovrebbero seguire un processo strutturato di valutazione. Primo, definire un set di test rappresentativo che includa problemi del proprio dominio o caso d’uso. I benchmark generici potrebbero non riflettere le prestazioni su problemi reali. Secondo, testare più modelli sugli stessi problemi per consentire un confronto diretto. Ciò richiede la standardizzazione dell’ambiente di test, inclusi hardware, parametri di inferenza e formulazione dei prompt. Terzo, valutare non solo l’accuratezza ma anche metriche di efficienza come latenza e generazione di token. Un modello che fornisce risposte corrette ma richiede 10.000 token di pensiero potrebbe non essere pratico per usi in tempo reale. Quarto, esaminare il processo di ragionamento del modello, non solo la risposta finale. Un modello che arriva alla risposta giusta attraverso un ragionamento errato potrebbe fallire su problemi simili ma con parametri diversi. Quinto, testare casi limite e domande trabocchetto per capire come il modello gestisce scenari progettati per confonderlo. Infine, considerare il costo totale di proprietà, che comprende non solo la licenza o i costi API, ma anche le risorse computazionali richieste per l’inferenza e lo sforzo ingegneristico per l’integrazione.

La dimensione di EXAONE Deep (32 miliardi di parametri) è significativamente inferiore rispetto ad alcuni modelli di ragionamento concorrenti, il che solleva dubbi sul fatto che i problemi riscontrati siano dovuti a capacità insufficienti. Tuttavia, la sola dimensione non determina la capacità di ragionamento. QwQ, che opera in un range di parametri simile, mostra prestazioni di ragionamento solide. Questo suggerisce che i problemi di EXAONE Deep siano più probabilmente legati alla metodologia di training, al design dell’architettura o alla configurazione di inferenza, piuttosto che a limiti strutturali della dimensione. L’inclusione di un modello draft da 2,4 miliardi tra le release di EXAONE Deep mostra che LG punta all’efficienza, un aspetto positivo. Tuttavia, i guadagni di efficienza hanno valore solo se il modello produce risultati corretti. Una risposta sbagliata data rapidamente è peggio di una risposta corretta ma lenta nella maggior parte dei casi produttivi. Il mercato dei modelli di ragionamento vedrà probabilmente una crescente attenzione all’efficienza, dato che le organizzazioni vogliono implementare questi modelli su larga scala, ma questa ottimizzazione non deve andare a discapito della qualità del ragionamento.

Lo spazio dei modelli di ragionamento è ancora agli inizi e possiamo aspettarci notevoli evoluzioni nei prossimi mesi e anni. Con il rilascio di nuovi modelli e l’aumento dei test indipendenti, il mercato tenderà a consolidarsi intorno a modelli con prestazioni affidabili e costanti. Organizzazioni come DeepSeek e Alibaba hanno costruito credibilità grazie a prestazioni coerenti, mentre nuovi arrivati come LG dovranno risolvere i problemi evidenziati nei test per ottenere l’accettazione del mercato. Ci si attende anche innovazione continua nel modo in cui questi modelli vengono addestrati e valutati. L’attuale approccio di generare lunghi token di pensiero è efficace ma costoso dal punto di vista computazionale. I modelli futuri potrebbero sviluppare meccanismi di ragionamento più efficienti, raggiungendo la stessa accuratezza con meno token. Inoltre, vedremo probabilmente una maggiore specializzazione, con modelli ottimizzati per domini specifici come matematica, generazione di codice o ragionamento logico. L’integrazione dei modelli di ragionamento con altre tecniche AI, come la generazione aumentata da retrieval o l’uso di strumenti, ne espanderà ulteriormente le capacità e le applicazioni.

EXAONE Deep di LG rappresenta un ingresso ambizioso nel mercato dei modelli di ragionamento, ma i test pratici rivelano notevoli lacune tra le prestazioni dichiarate e le reali capacità del modello. Sebbene i risultati di benchmark indichino prestazioni competitive con DeepSeek R1 e QwQ di Alibaba, i test pratici su problemi di ragionamento standard mostrano che EXAONE Deep fatica anche su compiti di base, generando un eccesso di token senza raggiungere conclusioni coerenti. DeepSeek R1 e QwQ hanno entrambi dimostrato prestazioni superiori sugli stessi problemi, arrivando alle risposte corrette tramite processi di ragionamento chiari e logici. Per le organizzazioni che valutano modelli di ragionamento per la produzione, questa analisi sottolinea la fondamentale importanza dei test e della verifica indipendente. I benchmark dei fornitori devono essere considerati come punto di partenza, non come misura definitiva delle capacità del modello. Il mercato dei modelli di ragionamento beneficerà di maggiore trasparenza, metodologie di valutazione standardizzate e continui test indipendenti da parte della comunità di ricerca. Con la maturazione della tecnologia, le organizzazioni che investono nella valutazione e nel confronto rigoroso dei modelli saranno meglio posizionate per scegliere e implementare soluzioni di ragionamento che apportino reale valore ai loro casi d’uso specifici.

EXAONE Deep è un modello di ragionamento da 32 miliardi di parametri sviluppato da LG che utilizza la decodifica in fase di test per risolvere problemi complessi. A differenza dei modelli linguistici standard, assegna risorse computazionali durante l'inferenza per ragionare passo dopo passo, in modo simile ai modelli DeepSeek R1 e QwQ di Alibaba.

Nei test pratici su compiti di ragionamento come il problema dei cubetti di ghiaccio, EXAONE Deep ha mostrato notevoli problemi di overthinking e generazione di token eccessivi senza giungere a conclusioni logiche. DeepSeek R1 e QwQ si sono comportati meglio, arrivando alle risposte corrette in modo più efficiente.

La decodifica in fase di test è una tecnica in cui i modelli AI allocano più risorse computazionali durante l'inferenza per ragionare su problemi complessi. Questo permette ai modelli di mostrare il proprio processo di pensiero e arrivare a risposte più precise, anche se richiede una calibrazione attenta per evitare l'overthinking.

FlowHunt automatizza il flusso di lavoro di test, confronto e valutazione di più modelli AI, permettendo ai team di confrontare sistematicamente le prestazioni, monitorare metriche e prendere decisioni basate sui dati su quali modelli adottare per casi d'uso specifici.

Arshia è una AI Workflow Engineer presso FlowHunt. Con una formazione in informatica e una passione per l'IA, è specializzata nella creazione di workflow efficienti che integrano strumenti di intelligenza artificiale nelle attività quotidiane, migliorando produttività e creatività.

Usa FlowHunt per semplificare i flussi di lavoro di testing, confronto e monitoraggio delle prestazioni dei modelli AI con un'automazione intelligente.

Esplora il mondo dei modelli di agenti AI con un’analisi completa di 20 sistemi all’avanguardia. Scopri come pensano, ragionano e si comportano in vari compiti,...

Scopri perché Gemini 3 Flash di Google sta rivoluzionando l’AI con prestazioni superiori, costi ridotti e velocità maggiori—superando persino Gemini 3 Pro nelle...

Scopri come un minuscolo modello da 7 milioni di parametri supera Gemini, DeepSeek e Claude usando ragionamento ricorsivo e deep supervision. Approfondisci l'ap...

Consenso Cookie

Usiamo i cookie per migliorare la tua esperienza di navigazione e analizzare il nostro traffico. See our privacy policy.