Introduzione

Il percorso che porta dalla creazione di un prototipo AI funzionante al deployment di un sistema di livello produttivo è da sempre uno degli aspetti più complessi dello sviluppo di intelligenza artificiale. Quello che spesso sembra un processo lineare nelle demo—recuperare informazioni rilevanti, arricchire i prompt e generare risposte—diventa esponenzialmente più complesso quando si scala in ambienti di produzione. Questa complessità ha portato molti nel settore a parlare di “alchimia” più che di ingegneria: un processo misterioso in cui gli sviluppatori modificano configurazioni, aggiustano parametri e sperano che i sistemi continuino a funzionare in modo affidabile. L’emergere dell’ingegneria del contesto come disciplina rappresenta un cambiamento fondamentale nel modo in cui costruiamo sistemi AI, spostandosi da questa metodologia per tentativi ed errori a un approccio più sistematico e ingegneristico. In questa panoramica approfondita, analizzeremo come database vettoriali moderni e principi di ingegneria del contesto stiano trasformando lo sviluppo di applicazioni AI, consentendo ai team di costruire sistemi non solo funzionanti, ma davvero affidabili e mantenibili su larga scala.

Cos’è l’Ingegneria del Contesto e Perché è Importante

L’ingegneria del contesto è emersa come una delle discipline più critiche nello sviluppo AI moderno, ma resta ancora poco compresa da molti sviluppatori che entrano nel settore. Alla base, l’ingegneria del contesto è la pratica di gestire, organizzare e ottimizzare sistematicamente le informazioni contestuali che i sistemi AI utilizzano per prendere decisioni e generare output. A differenza del Retrieval-Augmented Generation (RAG) tradizionale, che si concentra in modo ristretto sul recupero di documenti rilevanti per arricchire un prompt prima di inviarlo a un modello linguistico, l’ingegneria del contesto adotta una visione molto più ampia dell’intera pipeline. Comprende come i dati fluiscono nel sistema, come le informazioni vengono archiviate e indicizzate, come avviene il recupero, come i risultati vengono ordinati e filtrati e, infine, come quel contesto viene presentato al modello. Questa prospettiva olistica riconosce che la qualità dell’output di un sistema AI è fondamentalmente vincolata dalla qualità e dalla rilevanza del contesto che riceve. Quando il contesto è gestito male—quando vengono recuperate informazioni irrilevanti, quando dettagli importanti vengono persi, quando la stessa informazione viene processata più volte—l’intero sistema ne risente. L’ingegneria del contesto affronta queste sfide trattando la gestione del contesto come una priorità ingegneristica, degna della stessa attenzione che riserviamo ad altre componenti infrastrutturali critiche.

L’importanza dell’ingegneria del contesto emerge chiaramente se si considera la scala a cui operano i sistemi AI moderni. Un modello linguistico può essere chiamato a processare centinaia di migliaia di documenti, sintetizzare informazioni da fonti multiple e generare risposte coerenti basate su quella sintesi. Senza una corretta ingegneria del contesto, questo processo diventa caotico. Documenti irrilevanti affollano la finestra contestuale, informazioni importanti si perdono nel rumore e le prestazioni del modello degradano. Inoltre, man mano che i sistemi AI diventano più sofisticati e vengono impiegati in applicazioni sempre più critiche—dal customer service alla diagnosi medica, fino all’analisi finanziaria—le conseguenze di una cattiva ingegneria del contesto aumentano in modo esponenziale. Un sistema che occasionalmente restituisce informazioni irrilevanti può andare bene a scopo di intrattenimento, ma diventa inaccettabile quando prende decisioni che impattano sulla vita o sul lavoro delle persone. L’ingegneria del contesto assicura che le informazioni che attraversano il sistema siano non solo abbondanti, ma realmente rilevanti, correttamente organizzate e ottimizzate per il task specifico.

Pronto a far crescere il tuo business?

Inizia oggi la tua prova gratuita e vedi i risultati in pochi giorni.

Dall’Evoluzione della Demo alla Produzione: Il Problema dell’Alchimia

Una delle sfide più persistenti nello sviluppo AI è ciò che i veterani del settore chiamano il “demo-to-production gap”. Costruire un prototipo funzionante che dimostri le capacità AI è relativamente semplice. Uno sviluppatore può assemblare rapidamente un modello linguistico, collegarlo a un sistema di recupero semplice e ottenere qualcosa che funziona bene in ambiente controllato. Tuttavia, nel momento in cui quel sistema deve gestire dati reali su larga scala, mantenere l’affidabilità nel tempo e adattarsi a requisiti in evoluzione, tutto diventa molto più difficile. Questo gap è stato storicamente colmato attraverso ciò che si può solo definire alchimia—una combinazione misteriosa di tweak alle configurazioni, aggiustamenti ai parametri ed empirico tentativo ed errore che, in qualche modo, porta a un sistema funzionante. Il problema di questo approccio è che non è riproducibile, né scalabile, né mantenibile. Quando qualcosa si rompe in produzione, spesso non è chiaro il motivo, e risolverlo richiede di ripetere lo stesso processo misterioso.

La causa principale di questo problema sta nel fatto che la maggior parte delle infrastrutture AI non sono state progettate pensando ai sistemi di produzione. I primi database vettoriali e sistemi di recupero erano costruiti soprattutto per dimostrare la fattibilità della ricerca semantica e del recupero tramite embedding. Funzionavano bene in ambienti controllati, con piccoli dataset e pattern di query prevedibili. Ma quando questi sistemi vengono scalati per gestire milioni di documenti, migliaia di utenti concorrenti e query imprevedibili, spesso vanno in crisi. La consistenza dei dati diventa un problema. Le prestazioni delle query degradano. Il sistema diventa difficile da debuggare e monitorare. Gli sviluppatori si ritrovano a gestire un artefatto complesso e fragile che funziona grazie a una combinazione di fortuna e interventi continui. È qui che entrano in gioco l’ingegneria del contesto moderna e infrastrutture progettate appositamente. Trattando il percorso dalla demo alla produzione come una reale sfida ingegneristica, e costruendo sistemi appositamente per gestire carichi di lavoro produttivi, possiamo trasformare questa alchimia misteriosa in vera pratica ingegneristica.

Comprendere l’Infrastruttura di Ricerca Moderna per l’AI

Le infrastrutture di ricerca tradizionali, come quelle che alimentano Google e altri motori di ricerca, sono state progettate con specifiche ipotesi su come sarebbe stata utilizzata la ricerca. Questi sistemi sono stati costruiti per gestire query basate su keyword da parte di utenti umani, che esaminano i risultati e decidono quali link seguire. L’infrastruttura era ottimizzata per questo caso d’uso: matching rapido delle keyword, algoritmi di ranking pensati per la rilevanza percepita dall’uomo e presentazione dei risultati sotto forma dei “dieci link blu” facilmente scansionabili. Tuttavia, i sistemi AI hanno esigenze fondamentalmente diverse. Quando un modello linguistico consuma i risultati di una ricerca, non sta guardando dieci link—può processare molti più dati. Il modello non ha bisogno di risultati formattati per la lettura umana; gli servono dati strutturati su cui ragionare. Le query non sono basate su keyword, ma su semantica, embedding e similarità vettoriale. Queste differenze fondamentali implicano che l’infrastruttura di ricerca tradizionale sia poco adatta alle applicazioni AI.

L’infrastruttura moderna per la ricerca AI affronta queste differenze in diversi modi chiave. Prima di tutto, strumenti e tecnologie utilizzati sono radicalmente diversi. Al posto di indici su keyword e algoritmi di ranking ottimizzati per la rilevanza umana, ora si usano embedding vettoriali e misure di similarità semantica. Invece di affidarsi a keyword esplicite, questi sistemi comprendono il significato e l’intento delle query. In secondo luogo, i pattern di carico di lavoro sono diversi: i sistemi di ricerca tradizionali gestiscono query relativamente semplici che restituiscono pochi risultati. I sistemi AI spesso devono recuperare grandi quantità di documenti e processarli in modo sofisticato. In terzo luogo, gli sviluppatori che usano questi sistemi hanno esigenze differenti: chi sviluppa AI necessita di sistemi facili da integrare, con buona esperienza d’uso e che non richiedano competenze approfondite nell’infrastruttura di ricerca. Infine, e forse soprattutto, i consumatori dei risultati di ricerca sono diversi: nella ricerca tradizionale sono gli umani a compiere l’ultimo passo—decidere la rilevanza, aprire i link, sintetizzare le informazioni. Nei sistemi AI, invece, è il modello linguistico a fare questo lavoro e può processare molti più dati di quanto possa un umano. Questo shift fondamentale nel consumo dei risultati cambia tutto nella progettazione dell’infrastruttura.

Iscriviti alla nostra newsletter

Ricevi gratuitamente gli ultimi consigli, tendenze e offerte.

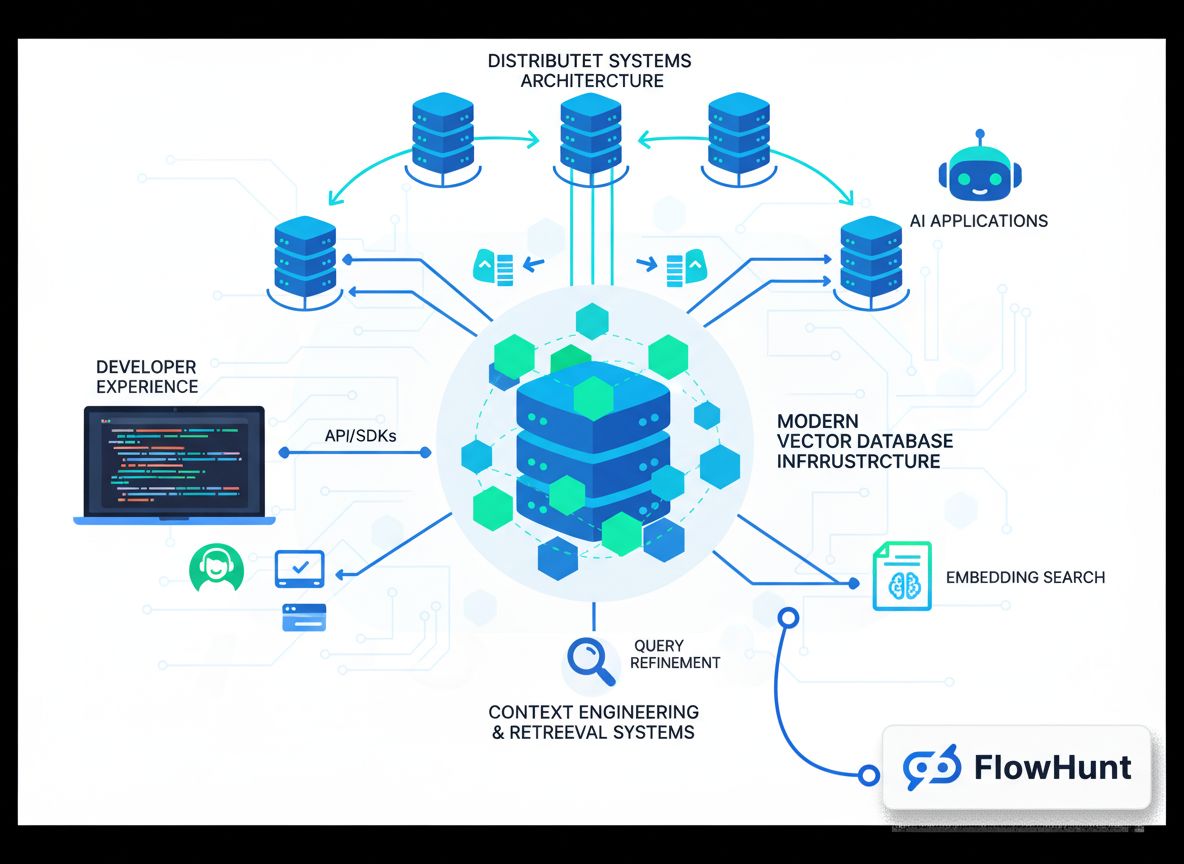

FlowHunt e il Futuro dell’Automazione dei Flussi AI

Man mano che le organizzazioni riconoscono l’importanza dell’ingegneria del contesto e dell’infrastruttura di ricerca moderna, la sfida diventa integrare queste capacità nei flussi di lavoro e nei processi di sviluppo esistenti. Qui entrano in gioco piattaforme come FlowHunt, che offrono un ambiente unificato per costruire, testare e distribuire applicazioni AI che si basano su una gestione sofisticata del contesto e sistemi di recupero avanzati. FlowHunt sa che l’ingegneria del contesto non è solo avere il database giusto—è avere gli strumenti e i workflow corretti per gestire il contesto lungo tutto il ciclo di vita dello sviluppo AI. Dall’ingestione e indicizzazione iniziale dei dati, passando per il recupero e il ranking, fino all’inferenza del modello e la generazione dell’output finale, ogni passaggio della pipeline deve essere orchestrato e monitorato con attenzione. FlowHunt offre capacità di automazione che rendono questa orchestrazione fluida, permettendo agli sviluppatori di concentrarsi sulle applicazioni piuttosto che sui dettagli dell’infrastruttura.

L’approccio della piattaforma all’automazione dell’ingegneria del contesto è particolarmente utile per i team che sviluppano più applicazioni AI o che devono gestire pipeline di recupero complesse e multi-stadio. Invece di costruire infrastrutture custom per ogni applicazione, i team possono sfruttare i componenti e i workflow pre-costruiti di FlowHunt per accelerare lo sviluppo. La piattaforma gestisce il lavoro noioso di ingestione dati, generazione di embedding, gestione degli indici e orchestrazione del recupero, liberando i developer per concentrarsi sugli aspetti unici delle proprie applicazioni. Inoltre, FlowHunt offre visibilità e strumenti di monitoring che permettono di capire come il contesto fluisce nel sistema, identificare colli di bottiglia e ottimizzare le prestazioni. Questa combinazione di automazione e visibilità trasforma l’ingegneria del contesto da processo misterioso e per tentativi a disciplina sistematica e misurabile.

L’Architettura dei Database Vettoriali Pronti per la Produzione

Costruire un database vettoriale che funziona in una demo è una cosa; costruirne uno che serve carichi produttivi in modo affidabile è tutt’altra storia. I database vettoriali pronti per la produzione devono gestire utenti concorrenti, mantenere la consistenza dei dati, garantire la persistenza affidabile e scalare elegantemente all’aumentare dei dati. Devono essere debuggabili quando qualcosa va storto, monitorabili per comprendere il comportamento del sistema e mantenibili affinché i team possano evolverli nel tempo. Questi requisiti hanno portato allo sviluppo di architetture moderne che incorporano principi dei sistemi distribuiti, già collaudati in decenni di utilizzo reale.

Uno dei principi architetturali più importanti nei database vettoriali moderni è la separazione tra storage e compute. Nei database monolitici tradizionali, storage e compute sono strettamente accoppiati: lo stesso server che memorizza i dati processa anche le query. Questo crea problemi quando si scala. Se serve più potenza di calcolo, bisogna aggiungere anche storage; se serve più capacità di storage, bisogna aggiungere calcolo. Questa inefficienza porta a sprechi di risorse e costi maggiori. Separando storage e compute, i database vettoriali moderni permettono a ciascun componente di scalare in modo indipendente. Lo storage può essere gestito tramite soluzioni di object storage come Amazon S3, mentre le risorse di calcolo vengono dimensionate in base alle richieste di query. Questa architettura offre grande flessibilità ed efficienza nei costi. Altro principio chiave è la multi-tenancy, che permette a una singola istanza di database di servire in sicurezza applicazioni o team diversi. La multi-tenancy richiede un’accurata separazione per garantire che dati e query di un tenant non interferiscano con quelli di un altro, ma se implementata correttamente, migliora notevolmente l’utilizzo delle risorse e riduce la complessità operativa.

I database vettoriali moderni incorporano inoltre principi dei sistemi distribuiti che negli ultimi dieci anni sono diventati prassi: separazione tra lettura e scrittura, replica asincrona per la durabilità dei dati senza sacrificare le prestazioni in scrittura, meccanismi di consenso distribuito per mantenere la consistenza tra i nodi. Questi principi, abbinati a linguaggi moderni come Rust che offrono performance e sicurezza, permettono ai database vettoriali di raggiungere l’affidabilità e le prestazioni necessarie ai sistemi di produzione. Il risultato è un’infrastruttura che non sembra alchimia—sembra vera ingegneria.

L’Approccio di Chroma all’Esperienza Sviluppatore

Quando Chroma è stata fondata, il team aveva una tesi chiara: il salto tra la costruzione di una demo AI funzionante e il deployment di un sistema di produzione sembrava più alchimia che ingegneria, e questo gap andava colmato. L’approccio scelto è stato quello di concentrarsi ossessivamente sull’esperienza per gli sviluppatori. Invece di puntare a costruire il sistema più ricco di funzionalità o più scalabile possibile, si sono concentrati nel renderlo incredibilmente facile da usare: bastava un solo comando pip per installarlo e iniziare subito, senza configurazioni complesse o setup infrastrutturali. Questa semplicità è stata rivoluzionaria nel mondo dei database vettoriali. La maggior parte dei database richiede set up e configurazioni laboriose già solo per eseguire una query di base. Chroma ha eliminato questo attrito, permettendo agli sviluppatori di sperimentare in pochi minuti, non in ore o giorni.

L’attenzione all’esperienza sviluppatore è andata oltre il setup iniziale. Il team di Chroma ha investito molto affinché il sistema funzionasse affidabilmente su architetture e ambienti diversi. Nei primi tempi, gli utenti riportavano di aver fatto girare Chroma su tutto, da server Linux standard ad Arduino, fino ad architetture Power PC. Invece di ignorare questi casi limite, il team si è spinto oltre per garantire la compatibilità e l’affidabilità universali. Questo impegno ha costruito fiducia nella community degli sviluppatori e favorito l’adozione rapida di Chroma. Il team ha capito che l’esperienza sviluppatore non si limita alla facilità d’uso, ma riguarda anche l’affidabilità, la coerenza e la sicurezza che il sistema funzionerà come previsto in diversi ambienti.

Quando Chroma è evoluta e il team ha iniziato a lavorare su Chroma Cloud, si è presentata una decisione critica. Avrebbero potuto lanciare rapidamente una versione hosted del prodotto single-node, per capitalizzare la domanda di servizi gestiti. Molte aziende hanno fatto questa scelta, raccogliendo capitali e guadagnando visibilità nel mercato. Chroma, invece, ha scelto diversamente. Hanno capito che offrire semplicemente il prodotto single-node come servizio non avrebbe rispettato i loro standard di esperienza sviluppatore. Un vero prodotto cloud doveva essere pensato da zero con principi cloud-native: stessa facilità d’uso e affidabilità del prodotto single-node, ma con le caratteristiche di scalabilità e affidabilità richieste dalla produzione. Questa scelta ha richiesto più tempo, ma ha portato a un prodotto che mantiene davvero la promessa di rendere l’ingegneria del contesto ingegneria vera, non alchimia.

Le Quattro Dimensioni dell’“AI” nell’Infrastruttura di Ricerca Moderna

Quando si parla di infrastrutture di ricerca moderna per l’AI, è importante riconoscere che “AI” significa cose diverse in contesti diversi. In realtà, ci sono quattro dimensioni distinte in cui queste infrastrutture differiscono da quelle tradizionali, e comprenderle è cruciale per costruire applicazioni AI efficaci. La prima dimensione è tecnologica. Gli strumenti e le tecnologie usati sono fondamentalmente diversi: invece degli indici invertiti e del matching su keyword, si usano embedding vettoriali e similarità semantica; invece di algoritmi di ranking TF-IDF, reti neurali e funzioni di ranking apprese. Queste differenze riflettono la natura dei problemi affrontati e le nuove capacità dei sistemi AI.

La seconda dimensione sono i pattern di carico di lavoro. I sistemi di ricerca tradizionali erano pensati per query semplici e stateless che restituiscono pochi risultati. I sistemi AI moderni spesso devono gestire pipeline di recupero complesse e multi-step, con vari round di ranking, filtraggio e ri-ranking, magari recuperando migliaia di documenti da processare. Questi pattern richiedono infrastrutture progettate in modo diverso per essere efficienti. La terza dimensione è lo sviluppatore. I sistemi tradizionali erano costruiti e mantenuti da ingegneri specializzati con profonda esperienza in information retrieval. Oggi gli sviluppatori AI sono spesso generalisti che non hanno conoscenze approfondite di search, ma devono comunque costruire applicazioni con capacità di recupero avanzate. L’infrastruttura moderna deve quindi essere accessibile e facile da usare, non solo potente e flessibile.

La quarta, e forse più importante, è il consumatore dei risultati di ricerca. Nei sistemi tradizionali, sono gli umani a consultare i risultati: possono digerire solo un numero limitato di link e fanno l’ultimo miglio della valutazione e della sintesi. Nei sistemi AI, invece, i modelli linguistici sono i consumatori; possono processare centinaia o migliaia di documenti e sintetizzare informazioni da tutti. Questa differenza cambia tutto: gli algoritmi di ranking possono essere ottimizzati per il consumo da parte delle macchine piuttosto che degli umani, la presentazione dei risultati può essere ottimizzata per il processamento automatico e l’intera pipeline va progettata supponendo che il lavoro finale lo faccia un sistema AI sofisticato.

Mantenere la Visione in un Mercato Rumoroso

Il mercato dei database vettoriali nel 2023 è stato tra i più caldi dell’infrastruttura AI. Le aziende raccoglievano capitali enormi, facevano scalpore con annunci e si sfidavano a chi offriva più feature. In questo contesto, sarebbe stato facile per Chroma perdere la focalizzazione, inseguire ogni tendenza e tentare di essere tutto per tutti. Invece, il team ha scelto deliberatamente di rimanere concentrato sulla propria visione: costruire un motore di recupero per applicazioni AI con un’esperienza sviluppatore eccezionale e che colmasse davvero il gap tra demo e produzione. Questa scelta ha richiesto disciplina, specialmente vedendo la concorrenza raccogliere più fondi e fare annunci più eclatanti.

La chiave di questa focalizzazione è stata avere una tesi chiara e anche un po’ controcorrente su ciò che conta davvero. Il team di Chroma credeva che non fossero il numero di feature o la quantità di capitale raccolto a fare la differenza, ma la qualità dell’esperienza sviluppatore e l’affidabilità del sistema. Credevano che, facendo una cosa sola—costruire un grande motore di recupero—al massimo livello, si sarebbero guadagnati il diritto di fare altro in futuro. Questa filosofia di focalizzazione maniacale su una competenza centrale non è unica di Chroma, ma è sempre più rara tra le startup finanziate da venture capital, dove la pressione a crescere e raccogliere fondi spesso porta a disperdere energie. Il fatto di restare fedeli a questa filosofia, anche a costo di impiegare più tempo per lanciare Chroma Cloud e perdere opportunità di breve termine, si è rivelato infine la scelta giusta.

Mantenere la visione richiede anche attenzione a hiring e team building. Le persone che assumi plasmano la cultura, e la cultura determina cosa e come costruisci. Il team di Chroma ha scelto di assumere lentamente e in modo molto selettivo. Invece di puntare a crescere rapidamente, si sono concentrati su chi fosse allineato alla visione, avesse attenzione per la qualità e l’autonomia nell’esecuzione. Questo approccio ha rallentato la crescita del team, ma ha garantito che tutti fossero davvero impegnati nella missione e capaci di contribuire in modo significativo. Un allineamento culturale di questo tipo è difficile da ottenere nelle startup in rapida crescita, ma è essenziale per mantenere focalizzazione e visione nel lungo termine.

L’Importanza di Artigianalità e Qualità nell’Infrastruttura

Uno degli aspetti più notevoli dell’approccio di Chroma è l’enfasi su artigianalità e qualità. Nell’ambito infrastrutturale è facile cadere nella trappola del “più feature, più performance, più scala è sempre meglio”. Ma il team ha capito che ciò che conta davvero è costruire sistemi affidabili, facili da usare e che risolvano concretamente i problemi degli sviluppatori. L’attenzione alla qualità si manifesta in molte scelte: dalla decisione di scrivere Chroma in Rust, che offre performance e sicurezza, invece che in linguaggi più convenienti ma meno affidabili; all’impegno di far funzionare il sistema su architetture e ambienti anche insoliti; fino alla scelta di prendersi più tempo per costruire Chroma Cloud piuttosto che lanciare rapidamente un prodotto mediocre.

Questa attenzione si estende anche al modo di affrontare il problema: invece di vedere l’ingegneria del contesto come una questione tecnica ristretta da risolvere con algoritmi brillanti, la vedono come una sfida più ampia che comprende esperienza sviluppatore, affidabilità, scalabilità e mantenibilità. Questa prospettiva olistica porta a soluzioni migliori, perché riconosce che un sistema vale quanto il suo anello più debole. Puoi avere gli algoritmi di recupero più sofisticati del mondo, ma se sono difficili da usare o inaffidabili in produzione, non risolvono il vero problema. Puntando su artigianalità e qualità a tutti i livelli, Chroma ha costruito qualcosa che funziona davvero per gli sviluppatori e colma concretamente il gap tra demo e produzione.

Implicazioni Pratiche per i Team di Sviluppo AI

Per i team che costruiscono applicazioni AI, gli insegnamenti dell’approccio Chroma hanno diverse implicazioni pratiche. Primo: l’ingegneria del contesto non è una side quest nello sviluppo AI—è parte della quest principale. La qualità del tuo sistema AI è vincolata dalla qualità del contesto che riceve, quindi investire nell’infrastruttura giusta per il contesto non è opzionale, ma essenziale. Secondo: diffida dei sistemi che promettono di fare tutto. I sistemi più affidabili ed efficaci sono spesso quelli che fanno una cosa sola davvero bene, per poi costruire da lì. Se valuti database vettoriali o sistemi di recupero, cerca quelli con focus chiaro e impegno su quell’unica cosa fatta al massimo livello. Terzo: l’esperienza sviluppatore conta. Un sistema teoricamente più potente ma difficile da usare sarà meno prezioso di uno leggermente meno potente ma facile. Perché gli sviluppatori useranno davvero quello facile e ci costruiranno sopra, mentre potrebbero abbandonare quello difficile.

Quarto: l’affidabilità e la coerenza contano più di quanto pensi. All’inizio dello sviluppo AI può essere tentante privilegiare feature e performance rispetto all’affidabilità. Ma quando i sistemi entrano in produzione e gestiscono carichi reali, l’affidabilità diventa fondamentale. Un sistema affidabile al 95% può sembrare accettabile, ma con milioni di query al giorno, quel 5% di fallimenti significa centinaia di migliaia di errori. Investire in affidabilità fin dall’inizio costa meno che correggerla dopo. Infine, pensa al percorso di lungo termine dei tuoi sistemi. L’infrastruttura che scegli oggi determinerà ciò che potrai costruire domani. Scegliere infrastrutture progettate per la produzione fin dall’inizio, che scalano bene e offrono visibilità e monitoring, ripagherà man mano che i sistemi cresceranno ed evolveranno.

{{ cta-dark-panel

heading=“Potenzia il tuo workflow con FlowHunt”

description=“Scopri come FlowHunt automatizza i tuoi flussi di lavoro AI e SEO—dalla ricerca e generazione di contenuti fino alla pubblicazione e analisi—tutto in un unico posto.”

ctaPrimaryText=“Prenota una Demo”

ctaPrimaryURL=“https://calendly.com/liveagentsession/flowhunt-chatbot-demo"

ctaSecondaryText=“Prova FlowHunt Gratis”

ctaSecondaryURL=“https://app.flowhunt.io/sign-in"

gradientStartColor="#123456”

gradientEndColor="#654321”

gradientId=“827591b1-ce8c-4110-b064-7cb85a0b1217”

}}

Una delle decisioni più importanti prese dal team Chroma è stata quella di rendere open source il prodotto core. Questa scelta ha avuto diverse conseguenze rilevanti. Prima di tutto, ha creato fiducia nella community degli sviluppatori. Quando si può vedere il codice, capire come funziona il sistema e contribuire a migliorarlo, la fiducia e l’adozione crescono. L’open source genera inoltre un circolo virtuoso: i contributi della community migliorano il prodotto, attirando più utenti, che a loro volta contribuiscono. In secondo luogo, l’open source ha creato una community forte intorno a Chroma. Gli sviluppatori che lo usano si sentono coinvolti nel suo successo e sono più propensi a contribuire, dare feedback e promuoverlo presso altri. Questa community diventa un asset prezioso, difficile da replicare dai concorrenti.

Terzo, l’open source offre un percorso naturale alla monetizzazione tramite servizi hosted. Rendendo open source il prodotto core, Chroma permette agli sviluppatori di usarlo gratuitamente in modalità self-hosted, ma molti preferiranno una versione gestita che si occupa di operatività, scaling e manutenzione. Questo è il modello rappresentato da Chroma Cloud. Offrendo un’esperienza hosted superiore ma mantenendo open source il core, Chroma serve sia la community self-hosted che il mercato dei servizi gestiti. Questo approccio si è rivelato più sostenibile e più in linea con le preferenze degli sviluppatori rispetto al mantenere il core proprietario e chiuso.

Misurare il Successo: Le Metriche che Contano

Nel valutare il successo di progetti infrastrutturali come Chroma, è importante concentrarsi sulle metriche che riflettono davvero il valore erogato. Chroma ha raggiunto numeri impressionanti: oltre 21.000 stelle su GitHub, più di 5 milioni di download mensili e oltre 60-70 milioni di download totali. Questi numeri riflettono l’adozione diffusa nella community degli sviluppatori. Ma al di là di questi dati, ciò che conta davvero è se il progetto risolve problemi concreti degli sviluppatori: rende più facile costruire applicazioni AI? Riduce il tempo e lo sforzo necessari per andare dalla demo alla produzione? Permette di costruire sistemi più affidabili? La risposta sembra sì, in base al feedback della community e all’adozione rapida del progetto.

Un’altra metrica importante è la qualità della community e la natura dei contributi. Chroma ha attirato contributi da sviluppatori di tutto il settore, incluse integrazioni con framework popolari come LangChain e Llama Index. Questa adozione trasversale e l’integrazione con altri strumenti dell’ecosistema indicano che Chroma risolve problemi reali e offre valore concreto. Il fatto che Chroma sia diventato la scelta predefinita per la funzionalità di database vettoriale in molti framework AI testimonia la qualità del prodotto e la forza della community che lo circonda. Queste metriche qualitative—adozione dalla community, integrazione con altri strumenti, feedback positivi—sono spesso più significative del semplice numero di download.

Il Futuro dell’Ingegneria del Contesto e dell’Infrastruttura AI

Man mano che i sistemi AI diventano più sofisticati e diffusi, l’importanza dell’ingegneria del contesto crescerà ancora. I sistemi che stiamo costruendo oggi sono solo l’inizio. In futuro vedremo approcci ancora più avanzati alla gestione del contesto: sistemi che adattano dinamicamente il contesto al task, che apprendono dal feedback per migliorare il recupero, che gestiscono in modo fluido dati multimodali (testo, immagini, audio, video). L’infrastruttura che supporterà questi sistemi dovrà essere ancora più sofisticata, ma i principi di fondo resteranno: attenzione all’esperienza sviluppatore, affidabilità e qualità, visione chiara dei problemi da risolvere.

Il ruolo di piattaforme come FlowHunt diventerà sempre più centrale. Con l’ingegneria del contesto al centro dello sviluppo AI, i team avranno bisogno di strumenti che rendano facile costruire, testare e distribuire pipeline di gestione del contesto sofisticate. L’approccio di FlowHunt—automazione e visibilità su tutto il ciclo di vita AI—la posiziona bene per soddisfare questa esigenza. Astrazione della complessità infrastrutturale e strumenti di alto livello consentono agli sviluppatori di concentrarsi sulle applicazioni, non sui dettagli tecnici.

Conclusione

L’ingegneria del contesto rappresenta un cambiamento fondamentale nel modo in cui costruiamo sistemi AI, passando da un approccio per tentativi e alchemico a una disciplina sistematica e ingegneristica. Database vettoriali moderni come Chroma, costruiti secondo principi di separazione tra storage e compute, multi-tenancy e architettura distribuita, forniscono le basi di questo cambiamento. Unendo questi miglioramenti infrastrutturali a un impegno verso esperienza sviluppatore, affidabilità e artigianalità, i team possono costruire sistemi AI che funzionano davvero in produzione e scalano in modo affidabile all’aumentare dei requisiti. Gli insegnamenti dall’approccio Chroma—focus sulla visione centrale, assunzione orientata all’allineamento culturale, attenzione alla qualità più che alle feature, costruzione della community tramite open source—offrono una roadmap per altri progetti infrastrutturali e per i team che costruiscono applicazioni AI. Con l’evoluzione e la maturazione dell’AI, l’importanza di una corretta ingegneria del contesto crescerà ancora, rendendola una delle aree chiave per chiunque costruisca sistemi di intelligenza artificiale.