Hugging Face Transformers

Hugging Face Transformers è una delle principali librerie Python open-source che semplifica l’implementazione di modelli Transformer per attività di machine lea...

Una guida completa alle strategie moderne di pretraining dei modelli linguistici, alle tecniche di curazione dei dati e ai metodi di ottimizzazione utilizzati da HuggingFace per realizzare modelli open source efficienti e ad alte prestazioni.

Negli ultimi anni, lo sviluppo dei modelli linguistici ha subito una trasformazione fondamentale. Mentre le grandi aziende tecnologiche continuano a spingere i limiti della scala dei modelli, la comunità open source ha scoperto che prestazioni eccezionali non richiedono modelli da trilioni di parametri. Questa guida completa esplora le tecniche e strategie all’avanguardia adottate dai ricercatori di HuggingFace per costruire modelli linguistici efficienti e performanti attraverso metodologie di pretraining rigorose. Analizzeremo come SmolLM 3, FineWeb e FinePDF rappresentano un nuovo paradigma nello sviluppo dei modelli—concentrato sul massimizzare le prestazioni entro limiti computazionali pratici, mantenendo al contempo rigore scientifico e riproducibilità. Le intuizioni qui condivise derivano da mesi di ricerca e sperimentazione, offrendo una masterclass su come affrontare il pretraining dei modelli nell’era moderna.

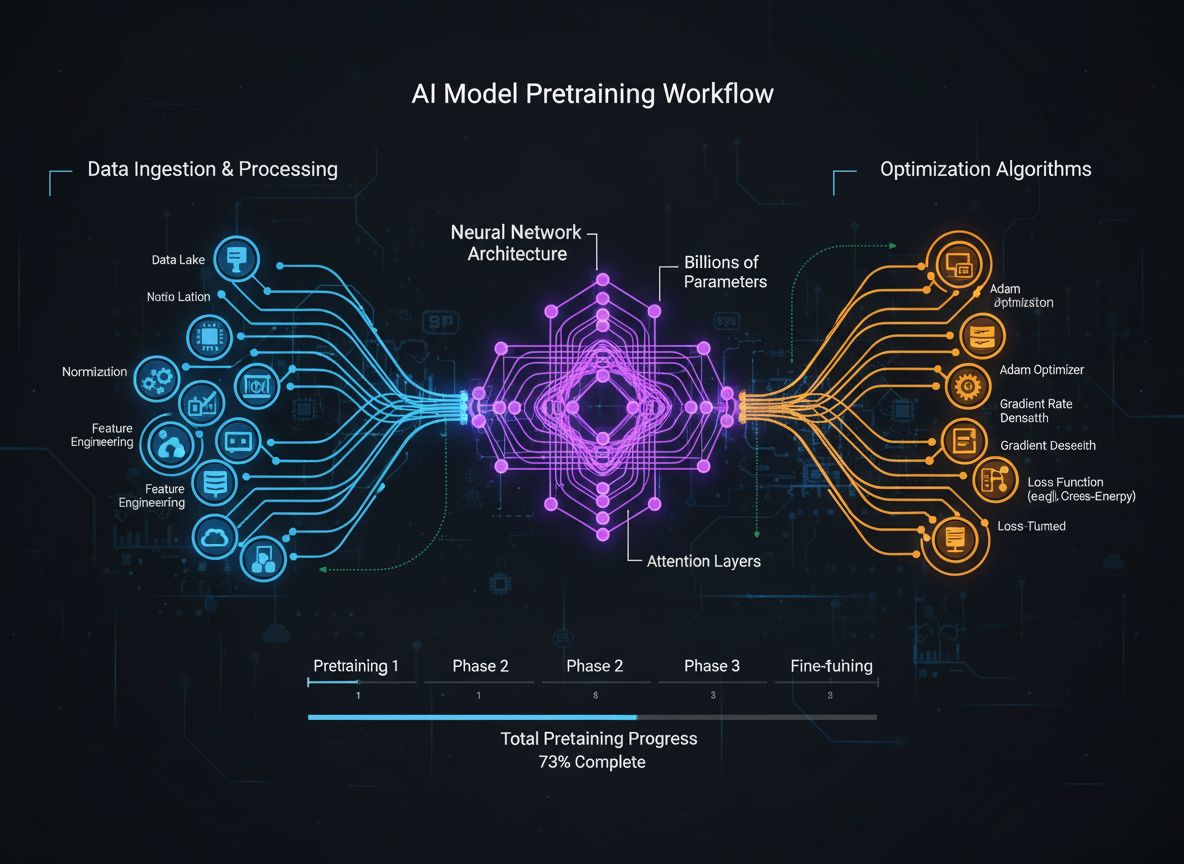

Il pretraining dei modelli linguistici si è evoluto da un processo relativamente semplice di alimentazione di testo grezzo in reti neurali a una disciplina sofisticata che coinvolge molteplici obiettivi di ottimizzazione interconnessi. Alla base, il pretraining consiste nell’esporre un modello a enormi quantità di testo, permettendogli di apprendere pattern statistici sul linguaggio tramite apprendimento auto-supervisionato. Tuttavia, l’approccio moderno riconosce che semplicemente aumentare dati e potenza di calcolo non è sufficiente. I ricercatori devono orchestrare con attenzione ogni dimensione del processo di training—dalla selezione e curazione dei dati alle scelte architetturali e agli algoritmi di ottimizzazione. Il campo è maturato al punto che la comprensione di queste sfumature distingue i modelli all’avanguardia da quelli mediocri. Questa evoluzione riflette una consapevolezza più profonda che le prestazioni di un modello sono determinate non da un singolo fattore, ma dall’attenta orchestrazione di molteplici obiettivi, in parte ortogonali, che possono essere ottimizzati in parallelo. La comunità di ricerca ha riconosciuto sempre più che il “segreto” dello sviluppo di modelli di successo non sta nella mera scalabilità, ma nelle scelte progettuali intelligenti a ogni livello della pipeline di training.

Una delle lezioni più importanti delle ricerche recenti è che la qualità e la diversità dei dati di training determinano fondamentalmente le prestazioni del modello, più della semplice quantità di dati. Questo principio, spesso riassunto come “garbage in, garbage out”, è stato sempre più convalidato da ricerche empiriche ed esperienza pratica. Quando i modelli sono addestrati su dati mal curati, duplicati o di bassa qualità, apprendono pattern spurî e non generalizzano efficacemente a nuovi compiti. Al contrario, dataset selezionati, deduplicati e filtrati con cura consentono ai modelli di apprendere in modo più efficiente e ottenere migliori risultati con meno step di training. Le implicazioni di questa intuizione sono profonde: significa che organizzazioni e ricercatori dovrebbero investire molto nella curazione dei dati e nell’assicurazione della qualità, piuttosto che semplicemente accumulare dati grezzi. Questo cambio di prospettiva ha portato all’emergere di team e strumenti specializzati interamente nella creazione e raffinamento dei dataset. Il dataset FineWeb, che contiene oltre 18,5 trilioni di token di dati web inglesi puliti e deduplicati, ne è un esempio. Invece di usare dati CommonCrawl grezzi, il team FineWeb ha implementato sofisticati filtraggi, deduplicazioni e tecniche di valutazione della qualità per creare un dataset che supera costantemente alternative più grandi e non processate. Questa rappresenta una realizzazione fondamentale nel campo: la strada verso modelli migliori passa attraverso dati migliori, non necessariamente attraverso più dati.

Il pretraining moderno dei modelli può essere compreso tramite cinque obiettivi interconnessi ma in parte ortogonali che i ricercatori devono ottimizzare simultaneamente. Comprendere questi pilastri fornisce una struttura per pensare all’intero processo di training e individuare dove apportare miglioramenti. Il primo pilastro riguarda la massimizzazione della rilevanza e qualità delle informazioni grezze nei dati di training. Ciò include sia la qualità dei singoli dati sia la diversità dell’intero dataset. Un modello addestrato su dati di alta qualità e diversificati apprenderà pattern più generalizzabili rispetto a uno addestrato su dati ristretti o di bassa qualità, indipendentemente da altre ottimizzazioni. Il secondo pilastro si concentra sulla progettazione architetturale del modello, che determina quanto efficientemente il modello può processare le informazioni e quali vincoli computazionali deve rispettare. Le scelte architetturali influiscono su velocità di inferenza, consumo di memoria, requisiti di cache KV e capacità del modello di adattarsi a specifiche configurazioni hardware. Il terzo pilastro consiste nel massimizzare le informazioni estratte dai dati di training a ogni step. Questo include tecniche come la distillazione della conoscenza, in cui modelli più piccoli apprendono dai più grandi, e la predizione multi-token, in cui i modelli prevedono più token futuri contemporaneamente. Il quarto pilastro riguarda la qualità dei gradienti e le dinamiche di ottimizzazione, includendo la scelta dell’ottimizzatore, i programmi del learning rate e le tecniche per mantenere la stabilità del training. Il quinto pilastro comprende la regolazione degli iperparametri e le strategie di scalabilità che assicurano la stabilità del training, evitando problemi come l’esplosione dei gradienti o la divergenza delle attivazioni. Questi cinque pilastri non sono indipendenti—interagiscono in modo complesso—ma considerarli separatamente aiuta a individuare le aree che necessitano attenzione e dove possono essere apportati miglioramenti significativi.

FineWeb rappresenta un momento spartiacque nella creazione di dataset per il pretraining dei modelli linguistici. Invece di accettare il risultato grezzo dei web crawler come CommonCrawl, il team HuggingFace ha implementato una pipeline completa per pulire, filtrare e deduplicare i dati web su larga scala. Il dataset risultante contiene oltre 18,5 trilioni di token di testo inglese di alta qualità, rendendolo uno dei più grandi dataset curati disponibili alla comunità open source. La creazione di FineWeb ha coinvolto molteplici fasi di elaborazione, ciascuna progettata per eliminare contenuti di bassa qualità preservando le informazioni preziose. Il team ha implementato algoritmi di deduplicazione sofisticati per eliminare contenuti ridondanti, filtri di qualità per rimuovere spam e pagine di bassa qualità e rilevamento della lingua per garantire che il dataset sia principalmente in inglese. Ciò che rende FineWeb particolarmente prezioso non è solo la sua dimensione, ma la validazione empirica che produce migliori prestazioni dei modelli rispetto ad alternative più grandi e non processate. Quando mescolato con altri dataset, FineWeb supera costantemente dataset grezzi molto più grandi, dimostrando che la qualità prevale davvero sulla quantità. Le curve di performance mostrano che i modelli addestrati su FineWeb ottengono risultati migliori su benchmark rispetto a modelli addestrati su dataset di dimensioni simili provenienti da altre fonti. Questo successo ha ispirato la comunità di ricerca a investire maggiormente nella curazione dei dati, riconoscendo che qui si possono ottenere significativi guadagni di performance. Il dataset FineWeb è liberamente disponibile per i ricercatori, democratizzando l’accesso a dati di training di alta qualità e permettendo anche a piccole organizzazioni e team accademici di addestrare modelli competitivi.

Mentre FineWeb si è concentrato sui dati web, il team HuggingFace ha riconosciuto che un’altra enorme fonte di testo di alta qualità era stata in gran parte trascurata: i documenti PDF. I PDF contengono enormi quantità di informazioni strutturate, di alta qualità, tra cui articoli accademici, documentazione tecnica, libri e report professionali. Tuttavia, l’estrazione del testo dai PDF è tecnicamente complessa e in passato non era stata esplorata sistematicamente su larga scala. FinePDF rappresenta il primo sforzo completo per estrarre, pulire e curare dati PDF per il pretraining dei modelli linguistici. Il team ha implementato una pipeline sofisticata che affronta le sfide uniche del processing PDF, tra cui la gestione di layout complessi, l’estrazione accurata del testo da documenti a più colonne e la gestione di immagini e tabelle incorporate. Un aspetto particolarmente innovativo della pipeline FinePDF è il passaggio “refetch from internet”, che risolve un problema critico: i PDF archiviati in CommonCrawl spesso sono estratti male o obsoleti. Ri-scaricando i PDF dalle fonti originali su internet, il team garantisce l’accesso alle versioni migliori dei documenti. I risultati sono impressionanti: quando miscelato con altri dataset, FinePDF mostra ottime prestazioni rispetto a baseline recenti come NeoTron B2. Il dataset offre una nuova fonte di dati di training di alta qualità che integra i dati web e permette ai modelli di apprendere da informazioni più diversificate e strutturate. Questo lavoro apre nuove possibilità nella creazione di dataset, suggerendo che altre fonti di dati finora poco esplorate potrebbero offrire benefici simili. La pipeline FinePDF viene documentata dettagliatamente tramite blog post e documentazione tecnica, consentendo ad altri ricercatori di replicare e adattare queste tecniche ad altre fonti di dati.

SmolLM 3 rappresenta la sintesi dell’applicazione di queste tecniche di curazione dati e ottimizzazione del training per creare un modello linguistico altamente efficiente. Con 3 miliardi di parametri, SmolLM 3 è molto più piccolo di molti modelli contemporanei, ma raggiunge prestazioni competitive grazie a un’ottimizzazione attenta su tutti e cinque i pilastri del training. Il modello supporta ragionamento in modalità doppia, capacità multilingue su sei lingue e comprensione di contesti lunghi, risultando estremamente versatile nonostante le dimensioni contenute. Lo sviluppo di SmolLM 3 ha coinvolto scelte architetturali mirate a massimizzare l’efficienza. Il team ha selezionato un’architettura transformer che bilancia efficienza computazionale e capacità di modellazione, implementando tecniche come la grouped query attention per ridurre il consumo di memoria e la latenza di inferenza. Il modello è stato addestrato usando un approccio di pretraining in tre fasi che aumenta progressivamente le prestazioni nei diversi domini, permettendo di ottimizzare specifiche capacità a ogni fase. Ciò che rende SmolLM 3 particolarmente significativo è che dimostra come la comunità open source sia ora in grado di produrre modelli che competono con modelli proprietari molto più grandi in molti task. Questo sfida l’assunto che “più grande è meglio” e suggerisce che il campo abbia raggiunto un plateau sui benefici della pura scala. L’attenzione si sta spostando verso efficienza, interpretabilità e capacità di deployment pratico. SmolLM 3 può girare su hardware consumer, dispositivi edge e ambienti con risorse limitate, rendendo le capacità AI avanzate accessibili a un pubblico molto più ampio. Le sue capacità multilingua e di gestione di contesti lunghi dimostrano che l’efficienza non richiede il sacrificio di funzionalità importanti.

La distillazione della conoscenza è una tecnica potente che permette ai modelli più piccoli di beneficiare delle conoscenze apprese da modelli più grandi. Invece di addestrare un modello piccolo da zero su dati grezzi, la distillazione della conoscenza prevede che il modello piccolo imiti gli output di un modello più grande e capace. Questo approccio è particolarmente prezioso durante il pretraining perché consente al modello più piccolo di apprendere pattern già scoperti dal modello più grande, accelerando l’apprendimento e migliorando le prestazioni finali. La meccanica della distillazione della conoscenza prevede che il modello studente (il più piccolo) venga addestrato a far corrispondere le distribuzioni di probabilità prodotte dal modello insegnante (il più grande). Questo avviene tipicamente minimizzando la divergenza tra la distribuzione degli output dello studente e quella dell’insegnante, spesso usando tecniche come la divergenza KL. Il parametro di temperatura controlla quanto “morbide” siano le distribuzioni di probabilità—temperature più alte rendono le distribuzioni più uniformi, fornendo più informazioni sulla confidenza relativa delle diverse predizioni. La distillazione della conoscenza si è rivelata particolarmente efficace nel pretraining dei modelli linguistici, perché consente di trasferire le conoscenze dei grandi modelli su modelli più piccoli ed efficienti. Questo è prezioso per le organizzazioni che vogliono distribuire modelli su dispositivi edge o in ambienti con risorse limitate, beneficiando comunque delle capacità dei modelli più grandi. La tecnica si è fatta via via più sofisticata, con ricerche su metodi come l’attenzione transfer, dove il modello studente apprende a replicare anche i pattern di attenzione dell’insegnante, e la distillazione feature-based, dove si fa corrispondere anche le rappresentazioni intermedie.

L’addestramento tradizionale dei modelli linguistici si concentra sulla predizione del token successivo—il modello impara a prevedere il token seguente dato tutto il contesto precedente. Tuttavia, ricerche recenti hanno dimostrato che addestrare i modelli a prevedere più token futuri simultaneamente può migliorare significativamente le prestazioni, in particolare nei compiti di programmazione e problemi di ragionamento complesso. La predizione multi-token obbliga il modello ad apprendere dipendenze a lungo raggio e a sviluppare una comprensione più profonda dei pattern nei dati. L’approccio prevede l’aggiunta di più teste di predizione al modello, ciascuna responsabile della previsione di un token a diverse posizioni future. Durante il training, il modello riceve segnali di loss da tutte queste teste contemporaneamente, incoraggiandolo a imparare rappresentazioni utili per prevedere più step nel futuro. Questo è più sfidante della predizione standard, ma porta a rappresentazioni meglio apprese. I benefici della predizione multi-token vanno oltre il solo miglioramento delle prestazioni sul compito di training. I modelli addestrati in questo modo spesso mostrano migliori risultati su task downstream, migliore generalizzazione a nuovi domini e capacità di ragionamento superiori. La tecnica è particolarmente efficace nei compiti di code generation, dove la comprensione di dipendenze a lungo raggio è cruciale per generare codice corretto sia sintatticamente che semanticamente. Le ricerche mostrano che la predizione multi-token può migliorare le prestazioni dei modelli del 5-15% su diversi benchmark, rendendola una delle tecniche di training più impattanti degli ultimi anni. L’approccio è relativamente semplice da implementare ma richiede una regolazione attenta del numero di teste di predizione e della ponderazione delle loss.

Per anni, l’ottimizzatore AdamW è stato la scelta predefinita per l’addestramento di grandi modelli linguistici. AdamW combina aggiornamenti di gradiente basati sul momentum con il weight decay, fornendo un training stabile e buone proprietà di convergenza. Tuttavia, ricerche recenti hanno mostrato che AdamW potrebbe non essere ottimale per tutti gli scenari, specialmente quando si scala verso modelli molto grandi. Nuovi ottimizzatori come Muon e King K2 stanno esplorando approcci alternativi che possono offrire dinamiche di training migliori e prestazioni superiori. L’intuizione alla base di questi nuovi ottimizzatori è che la matrice Hessiana—che cattura informazioni sulla curvatura del landscape della loss—può essere meglio approssimata usando tecniche come i metodi Newton-Schulz. Mantenendo una migliore approssimazione della Hessiana, questi ottimizzatori possono fornire aggiornamenti di gradiente più informativi che conducono a convergenza più rapida e migliori prestazioni finali. Muon, ad esempio, usa una tecnica chiamata iterazione Newton-Schulz per ortogonalizzare la matrice dei gradienti, con l’effetto di distribuire l’apprendimento su più dimensioni rispetto agli approcci tradizionali. Questo porta a un training più stabile e incoraggia il modello a esplorare nuove regioni dello spazio dei parametri invece di seguire sempre la stessa traiettoria di ottimizzazione di AdamW. King K2 adotta un approccio diverso, tracciando quantità come il massimo log per head e usando queste informazioni per adattare dinamicamente learning rate e clipping dei gradienti. Le implicazioni dell’innovazione sugli ottimizzatori sono significative. Molti professionisti continuano a usare AdamW con iperparametri ottimizzati per modelli molto più piccoli, anche quando addestrano modelli con ordini di grandezza di parametri in più. Questo suggerisce che notevoli guadagni di performance potrebbero essere ottenuti semplicemente aggiornando la scelta dell’ottimizzatore e degli iperparametri per i modelli moderni su larga scala. La comunità riconosce sempre più che la scelta dell’ottimizzatore non è un problema risolto e che l’innovazione continua in quest’area può portare miglioramenti sostanziali nell’efficienza del training e nelle prestazioni finali.

Mantenere gradienti di alta qualità durante il training è essenziale per ottenere buone prestazioni dai modelli. Man mano che i modelli scalano a miliardi o trilioni di parametri, il training diventa sempre più instabile, con gradienti soggetti a esplosione o scomparsa. Affrontare questi problemi richiede attenzione alla qualità dei gradienti e l’implementazione di tecniche che assicurino la stabilità durante tutto il training. Un approccio prevede l’uso di tecniche come il gradient clipping, che impedisce ai gradienti di diventare troppo grandi e destabilizzare il training. Tuttavia, un clipping ingenuo può eliminare informazioni preziose. Approcci più sofisticati normalizzano i gradienti in modi che preservano l’informazione evitando l’instabilità. Un’altra considerazione importante è la scelta delle funzioni di attivazione e delle tecniche di normalizzazione dei layer. Funzioni diverse hanno proprietà diverse riguardo al flusso dei gradienti, e una scelta accurata può avere un impatto significativo sulla stabilità. La layer normalization, che normalizza le attivazioni sulla dimensione delle feature, è diventata standard nei transformer perché garantisce migliori proprietà rispetto alla batch normalization. Anche il learning rate schedule gioca un ruolo cruciale: un learning rate troppo alto può causare esplosione di gradienti, uno troppo basso porta a una convergenza lenta o a rimanere bloccati in minimi locali. Il training moderno spesso usa schedule che partono con una fase di warm-up, aumentando gradualmente il learning rate per permettere al modello di stabilizzarsi, seguita da una fase di decrescita. Ottimizzare questi aspetti è fondamentale per addestrare grandi modelli con successo e rappresenta un ambito di ricerca ancora molto attivo.

La complessità del pretraining moderno—con i suoi molteplici obiettivi di ottimizzazione, pipeline di dati sofisticate e tuning attento degli iperparametri—crea sfide significative per i team che vogliono implementare queste tecniche. FlowHunt affronta queste sfide offrendo una piattaforma per automatizzare e orchestrare i flussi di training dei modelli. Invece di gestire manualmente l’elaborazione dati, il training e la valutazione, i team possono usare FlowHunt per definire flussi che gestiscono automaticamente questi compiti, riducendo errori e migliorando la riproducibilità. Le capacità di automazione di FlowHunt sono particolarmente preziose nelle fasi di curazione ed elaborazione dei dati, così critiche per le performance dei modelli. La piattaforma può implementare automaticamente pipeline come quelle di FineWeb e FinePDF, inclusi deduplicazione, filtri di qualità e conversione dei formati. Questo permette ai team di concentrarsi sulle decisioni strategiche su quali dati includere e come processarli, senza perdersi nei dettagli implementativi. Inoltre, FlowHunt aiuta a gestire tuning degli iperparametri e sperimentazione necessari per ottimizzare il training. Automatizzando l’esecuzione di molteplici esperimenti con iperparametri diversi e raccogliendo i risultati, FlowHunt consente di esplorare lo spazio dei parametri in modo efficiente e individuare rapidamente le configurazioni ottimali. La piattaforma offre anche strumenti per monitorare l’andamento del training, rilevare problemi come l’esplosione dei gradienti o la divergenza, e aggiustare automaticamente i parametri per mantenere la stabilità. Per le organizzazioni che sviluppano propri modelli linguistici o effettuano fine-tuning di modelli esistenti, FlowHunt può ridurre drasticamente il tempo e lo sforzo necessari, migliorando allo stesso tempo la qualità dei risultati.

Uno degli aspetti più sfidanti del training dei modelli è capire come scalare dai modelli piccoli a quelli grandi mantenendo stabilità e performance. La relazione tra dimensione del modello e iperparametri ottimali non è lineare—iperparametri che funzionano bene su modelli piccoli spesso devono essere adattati per modelli più grandi. Questo è particolarmente vero per i learning rate, che solitamente vanno ridotti all’aumentare delle dimensioni dei modelli. Comprendere le scaling law è cruciale per prevedere le prestazioni a varie scale e per pianificare l’impiego delle risorse. Le ricerche hanno dimostrato che le performance dei modelli seguono leggi di scaling prevedibili, migliorando come potenza di legge rispetto a dimensione, quantità di dati e risorse computazionali. Queste leggi permettono di stimare i miglioramenti attesi aumentando la dimensione del modello o la quantità di dati, consentendo decisioni più informate su dove investire. Tuttavia, le scaling law non sono universali—dipendono da architettura, procedura di training e dataset specifici. Ciò implica che i team debbano condurre esperimenti di scaling propri per capire come si comporta il loro setup. Il passaggio da modelli piccoli a grandi richiede anche attenzione alla stabilità del training: modelli più grandi sono più inclini a instabilità come esplosione dei gradienti o divergenza. Per affrontare questi problemi servono tecniche come il gradient clipping, schedule accurati del learning rate e, se necessario, modifiche all’architettura o all’ottimizzatore. La comunità di ricerca riconosce sempre più che scalare non significa solo rendere i modelli più grandi, ma anche gestire con cura il processo di training per poter addestrare modelli più grandi in modo efficace.

Il feature learning si riferisce al processo con cui i modelli imparano a estrarre feature utili dai dati grezzi durante il training. Nel pretraining dei modelli linguistici, significa che il modello impara a rappresentare concetti linguistici, relazioni semantiche e pattern sintattici nelle sue rappresentazioni interne. Massimizzare il feature learning—cioè assicurarsi che il modello estragga quante più informazioni possibili dai dati a ogni step—è uno degli obiettivi chiave del training moderno. Un modo per valutare il feature learning consiste nell’osservare quanto cambiano le rappresentazioni del modello in risposta agli aggiornamenti dei gradienti. Se il modello apprende efficacemente, ogni update dovrebbe produrre cambiamenti significativi che migliorano la capacità di predire i token futuri. Se invece l’apprendimento è inefficace, gli update apportano solo cambiamenti minimi o poco utili. Tecniche per migliorare il feature learning includono un’inizializzazione attenta dei pesi, che può influenzare molto la rapidità con cui il modello apprende feature utili nelle prime fasi del training. Un altro aspetto chiave è l’impiego di schedule per il learning rate che permettano al modello di imparare velocemente all’inizio, quando le feature fondamentali vengono acquisite, per poi rallentare man mano che si raffinano pattern più sottili. Il feature learning è strettamente collegato al fenomeno del “feature collapse”, dove i modelli imparano a ignorare certe feature o dimensioni dell’input. Questo può succedere quando il modello trova scorciatoie per ottenere buone performance senza apprendere tutto ciò che dovrebbe. Tecniche come la regolarizzazione e la progettazione accurata della funzione di perdita aiutano a prevenire il feature collapse e a garantire che i modelli apprendano feature diversificate e utili.

{{ cta-dark-panel heading=“Potenzia il tuo Workflow con FlowHunt” description=“Scopri come FlowHunt automatizza i tuoi flussi di lavoro AI per contenuti e SEO — dalla ricerca e generazione dei contenuti fino alla pubblicazione e analisi — tutto in un’unica piattaforma.” ctaPrimaryText=“Prenota una Demo” ctaPrimaryURL=“https://calendly.com/liveagentsession/flowhunt-chatbot-demo" ctaSecondaryText=“Prova FlowHunt Gratis” ctaSecondaryURL=“https://app.flowhunt.io/sign-in" gradientStartColor="#123456” gradientEndColor="#654321” gradientId=“827591b1-ce8c-4110-b064-7cb85a0b1217” }}

Per diversi anni, la narrativa dominante nella ricerca AI è stata che modelli più grandi sono modelli migliori. Questo ha portato a una corsa a costruire modelli sempre più grandi, con aziende in competizione per annunciare modelli con più parametri. Tuttavia, sviluppi recenti suggeriscono che questa narrativa sta cambiando. Il successo di SmolLM 3 e di altri modelli efficienti dimostra che prestazioni eccezionali si possono ottenere anche con modelli di ordine di grandezza più piccoli rispetto ai più grandi. Questo cambiamento riflette una comprensione più profonda per cui le prestazioni dei modelli dipendono da molteplici fattori oltre al semplice numero di parametri. Un modello da 3 miliardi di parametri addestrato su dati di alta qualità con tecniche di ottimizzazione sofisticate può superare un modello molto più grande addestrato su dati di qualità inferiore e con meno cura. Questa consapevolezza ha implicazioni profonde per il settore. Suggerisce che la ricerca più impattante potrebbe non essere nella costruzione di modelli sempre più grandi, ma nel migliorare la qualità dei dati, nello sviluppo di tecniche di training migliori e nella creazione di architetture più efficienti. Democratizza anche lo sviluppo AI, rendendo possibile a organizzazioni e team accademici più piccoli di costruire modelli competitivi senza l’accesso a risorse computazionali massive. L’abbandono della pura scala ha anche implicazioni pratiche per il deployment: modelli più piccoli funzionano su dispositivi edge, in ambienti con risorse limitate, con minore latenza e consumo energetico. Questo rende le capacità AI avanzate accessibili a una gamma molto più ampia di applicazioni e utenti. La comunità riconosce sempre più che il futuro dello sviluppo AI potrebbe coinvolgere un portafoglio di modelli a scale diverse, ciascuno ottimizzato per casi d’uso e scenari di deployment specifici, invece di un’unica corsa a costruire il modello più grande possibile.

Il tuning degli iperparametri è il processo di selezione dei valori dei parametri che controllano il training, come learning rate, batch size e weight decay. Questi parametri hanno un impatto significativo sulle prestazioni del modello, e trovare i valori ottimali è cruciale per ottenere buoni risultati. Tuttavia, il tuning degli iperparametri viene spesso trattato più come un’arte che come una scienza, con i praticanti che si affidano all’intuizione e al trial-and-error invece che a metodi sistematici. Gli approcci moderni coinvolgono una esplorazione più sistematica dello spazio degli iperparametri. Tecniche come la Bayesian optimization permettono di esplorare lo spazio dei possibili valori in modo efficiente, identificando le aree più promettenti e concentrando lì la ricerca. Grid search e random search sono alternative più semplici ma possono essere efficaci, specialmente se combinati con il calcolo parallelo per valutare più configurazioni contemporaneamente. Un’importante intuizione dalle ricerche recenti è che gli iperparametri ottimali spesso dipendono dal modello, dal dataset e dal setup di training specifico. Questo significa che parametri che funzionano bene per un modello possono non funzionare per un altro, anche se simili per dimensioni e architettura. Da qui la pratica di effettuare sweep di iperparametri per ogni nuovo modello o dataset, cosa che può essere costosa in termini computazionali ma spesso necessaria per ottenere il massimo delle prestazioni. Comprendere la relazione tra iperparametri e prestazioni è anche importante per il debugging: se il training è instabile o converge lentamente, il problema potrebbe essere una scelta subottimale degli iperparametri più che problemi fondamentali del modello o dei dati. Esplorando sistematicamente lo spazio degli iperparametri, spesso è possibile individuare e risolvere questi problemi.

Le intuizioni della ricerca sul pretraining moderno hanno importanti implicazioni pratiche per le organizzazioni che costruiscono modelli linguistici propri o effettuano fine-tuning di modelli esistenti. Prima di tutto, è fondamentale investire nella curazione dei dati e nell’assicurazione della qualità. L’evidenza è chiara: dati di alta qualità sono più preziosi di grandi quantità di dati di bassa qualità. Questo significa implementare pipeline sofisticate che includano deduplicazione, filtraggio di qualità e standardizzazione dei formati. In secondo luogo, le organizzazioni dovrebbero considerare attentamente i propri obiettivi di ottimizzazione e assicurarsi di ottimizzare per le metriche giuste. Applicazioni diverse possono richiedere compromessi differenti tra dimensione del modello, velocità di inferenza e accuratezza. Definendo chiaramente questi trade-off in anticipo, si possono prendere decisioni più informate sulle scelte architetturali e sulle procedure di training. In terzo luogo, è importante restare aggiornati sui recenti progressi nelle tecniche di training e nella progettazione degli ottimizzatori. Il campo si muove rapidamente e tecniche all’avanguardia oggi potrebbero essere superate domani. Rivedere regolarmente le pubblicazioni più recenti e sperimentare nuove tecniche ai

SmolLM 3 è un modello da 3 miliardi di parametri progettato per massimizzare l'efficienza mantenendo ottime prestazioni su più lingue e compiti di ragionamento su contesti lunghi. A differenza dei modelli più grandi, SmolLM 3 si concentra su prestazioni ottimali entro vincoli computazionali, risultando ideale per il deployment su dispositivi edge e in ambienti con risorse limitate.

Il principio 'garbage in, garbage out' è fondamentale per il machine learning. Dati di alta qualità e diversificati influenzano direttamente le prestazioni del modello molto più che avere semplicemente più dati. FineWeb e FinePDF dimostrano che una curazione attenta, la deduplicazione e il filtraggio dei dati di training producono risultati significativamente migliori rispetto a dataset grezzi e non processati.

La distillazione della conoscenza è una tecnica in cui un modello più piccolo apprende da uno più grande e capace. Durante il pretraining, questo approccio permette ai modelli più piccoli di estrarre il massimo delle informazioni dai dati di training imparando schemi già scoperti dai modelli più grandi, ottenendo così migliori prestazioni con meno parametri.

La predizione multi-token addestra i modelli a prevedere più token futuri contemporaneamente invece che solo il successivo. Questo approccio è particolarmente efficace per i compiti di programmazione e migliora la capacità del modello di comprendere dipendenze a lungo raggio, portando a prestazioni superiori su task di ragionamento complessi.

Gli ottimizzatori moderni come Muon vanno oltre il tradizionale AdamW utilizzando tecniche come i metodi Newton-Schulz per approssimare meglio la matrice Hessiana. Questo porta a un training più stabile, a gradienti di migliore qualità e a dinamiche di apprendimento ottimizzate, soprattutto quando si scalano i modelli a dimensioni maggiori.

Arshia è una AI Workflow Engineer presso FlowHunt. Con una formazione in informatica e una passione per l'IA, è specializzata nella creazione di workflow efficienti che integrano strumenti di intelligenza artificiale nelle attività quotidiane, migliorando produttività e creatività.

FlowHunt aiuta i team a ottimizzare i flussi di pretraining dei modelli, l'elaborazione dei dati e le pipeline di ottimizzazione con automazioni intelligenti.

Hugging Face Transformers è una delle principali librerie Python open-source che semplifica l’implementazione di modelli Transformer per attività di machine lea...

La Fine-Tuning Efficiente dei Parametri (PEFT) è un approccio innovativo nell’IA e nell’NLP che consente di adattare grandi modelli pre-addestrati a compiti spe...

La generazione di testo con i Large Language Models (LLM) si riferisce all'uso avanzato di modelli di machine learning per produrre testo simile a quello umano ...