Politica di Sicurezza

Scopri la politica di sicurezza completa di FlowHunt, che copre pratiche di sicurezza infrastrutturale, organizzativa, di prodotto e di privacy dei dati per gar...

Una guida completa per integrare in sicurezza le piattaforme AI con il tuo database utilizzando API gateway, crittografia, controlli di accesso e strategie di monitoraggio.

Principali pratiche di sicurezza per esporre i database all’AI:

Esporre in modo sicuro un database significa consentire ai sistemi AI di accedere ai dati necessari mantenendo un controllo rigoroso su quali dati vengono consultati, da chi (o cosa), quando avviene l’accesso e come viene monitorato e registrato. È fondamentalmente diverso dal semplicemente aprire il database a Internet o fornire credenziali dirette alle piattaforme AI.

Quando parliamo di esporre un database alle piattaforme AI, intendiamo una decisione architetturale consapevole di creare un’interfaccia controllata tra i tuoi dati e i sistemi AI esterni. Questa interfaccia agisce come checkpoint di sicurezza, imponendo autenticazione, autorizzazione, crittografia e audit logging in ogni fase. L’obiettivo è creare quello che i professionisti della sicurezza chiamano un “single choke point”—un punto centralizzato dove tutto l’accesso può essere monitorato, controllato e validato.

La sfida sta nel fatto che le piattaforme AI spesso richiedono ampio accesso a dataset eterogenei per funzionare efficacemente. Un modello di machine learning potrebbe aver bisogno di analizzare pattern di comportamento dei clienti, storici transazioni e informazioni prodotto contemporaneamente. Un sistema AI generativo potrebbe dover cercare su più tabelle per rispondere a domande complesse. Tuttavia, concedere questo accesso senza adeguate misure può esporre l’organizzazione a data breach, violazioni di conformità e minacce interne.

Il business case per esporre in sicurezza i database all’AI è forte. Le organizzazioni che integrano con successo l’AI nella propria infrastruttura dati ottengono vantaggi competitivi significativi: decisioni più rapide, insight automatizzati, customer experience migliorata ed efficienza operativa. Tuttavia, i rischi sono altrettanto rilevanti.

Le violazioni di dati che coinvolgono database esposti stanno diventando sempre più comuni e costose. Il costo medio di un data breach nel 2024 ha superato i 4,45 milioni di dollari, con incidenti relativi ai database che rappresentano una parte sostanziale di queste perdite. Quando la violazione coinvolge dati personali soggetti a regolamenti come GDPR o CCPA, i danni finanziari e reputazionali si moltiplicano. Oltre ai costi diretti, le organizzazioni affrontano interruzioni operative, perdita di fiducia dei clienti e potenziale responsabilità legale.

La sfida si accentua quando sono coinvolti sistemi AI. I modelli AI possono memorizzare inavvertitamente dati sensibili di training, rendendoli recuperabili tramite attacchi di prompt injection o tecniche di estrazione del modello. Gli agenti AI con accesso al database possono essere manipolati con prompt appositi per eseguire query non volute o esporre informazioni riservate. Questi vettori d’attacco richiedono approcci di sicurezza che vadano oltre la protezione tradizionale dei database.

Inoltre, la vigilanza normativa sull’AI sta rapidamente aumentando. Le autorità di protezione dei dati di tutto il mondo stanno pubblicando linee guida su come gestire i dati personali nell’uso di sistemi AI. La conformità a GDPR, CCPA, HIPAA e alle nuove normative AI richiede la dimostrazione di adeguate salvaguardie prima di esporre dati alle piattaforme AI.

Prima di implementare qualsiasi strategia di esposizione del database alle piattaforme AI, è necessario avere una visione chiara della propria infrastruttura di sicurezza e del panorama dati. Questa valutazione deve rispondere ad alcune domande critiche:

Quali dati possiedi effettivamente? Esegui un inventario completo dei dati e una classificazione. Categorizza i dati per livello di sensibilità: pubblici, interni, confidenziali e ristretti. Identifica quali dati contengono informazioni personali (PII), dati di pagamento (PCI), dati sanitari protetti (PHI) o altri tipi regolamentati. Questa classificazione è la base di tutte le successive decisioni di accesso.

Quali controlli di sicurezza hai attualmente? Documenta le misure di sicurezza del database esistenti: meccanismi di autenticazione, stato della crittografia (in transito e a riposo), segmentazione di rete, procedure di backup e recovery, capacità di audit logging. Individua eventuali lacune nei controlli.

Quali obblighi di conformità hai? Esamina le normative applicabili per il tuo settore e la tua area geografica. Se gestisci dati personali, la conformità GDPR sarà probabilmente obbligatoria. In ambito sanitario, si applica HIPAA. I servizi finanziari devono considerare PCI-DSS. Questi obblighi modellano l’architettura di sicurezza.

Qual è la tua tolleranza al rischio? Ogni organizzazione ha una diversa propensione al rischio. Un fornitore sanitario che gestisce dati dei pazienti ha una tolleranza molto più bassa rispetto a una SaaS che analizza metriche d’uso anonimizzate. La tua tolleranza al rischio dovrebbe guidare il livello di restrizione dei controlli di accesso.

La decisione architetturale più importante è non esporre mai il database direttamente alle piattaforme AI. Implementa invece un API gateway sicuro che si interponga tra il database e i sistemi esterni. Questo gateway diventa il punto di controllo unico per tutti gli accessi al database.

Un API gateway svolge funzioni essenziali. Prima di tutto fornisce un layer di astrazione che disaccoppia la piattaforma AI dallo schema del database. Se la struttura del database cambia, basta aggiornare l’API, senza rinegoziare l’accesso con ogni piattaforma AI. In secondo luogo, consente di applicare policy di sicurezza coerenti a tutte le richieste di accesso. Infine, crea un punto centralizzato per monitoraggio, logging e alerting di attività sospette.

Quando selezioni o sviluppi un API gateway, scegli soluzioni che supportano identity-aware proxying (IAP). Un gateway IAP autentica ogni richiesta prima che raggiunga il database, assicurando che solo i sistemi autorizzati possano accedere ai dati. Deve supportare diversi metodi di autenticazione inclusi OAuth 2.0, token JWT, mTLS e API key. Il gateway deve anche applicare rate limiting per prevenire abusi e validare le richieste per bloccare query malformate o sospette.

Le opzioni più diffuse includono soluzioni cloud-native come AWS API Gateway con integrazione IAM, Identity-Aware Proxy di Google Cloud, Azure API Management, o soluzioni specializzate come Hoop o DreamFactory. Ognuna ha i suoi punti di forza, ma tutte condividono il principio di creare un layer di accesso controllato.

Dopo aver implementato un API gateway, il passo successivo è attuare meccanismi robusti di autenticazione e autorizzazione. Questi due concetti sono spesso confusi ma hanno scopi diversi: l’autenticazione verifica chi (o cosa) effettua la richiesta, l’autorizzazione determina cosa può fare quell’entità.

Per gli utenti umani che accedono a sistemi AI che interagiscono con il database, implementa l’autenticazione a più fattori (MFA). Tipicamente combina qualcosa che conosci (password), qualcosa che possiedi (telefono o token hardware) e qualcosa che sei (dati biometrici). La MFA riduce drasticamente il rischio di compromissione dell’account, punto di ingresso di molte violazioni.

Per sistemi AI e service principal, usa credenziali forti e a rotazione automatica. Non inserire mai credenziali di database nel codice o nei file di configurazione. Usa invece variabili di ambiente, sistemi di gestione segreti (come HashiCorp Vault, AWS Secrets Manager, Azure Key Vault) o servizi cloud-native che ruotano le credenziali automaticamente.

Implementa l’autenticazione basata su certificato dove possibile. L’autenticazione mTLS, in cui sia client che server si autenticano reciprocamente tramite certificati digitali, offre maggiore sicurezza rispetto alle password. Ogni piattaforma AI o servizio riceve un certificato unico da presentare per accedere all’API gateway.

Il controllo degli accessi basato sui ruoli (RBAC) è il modello più comune. Definisci ruoli (ad es. “AI_Analytics_Reader” o “ML_Training_Agent”) e assegna permessi a tali ruoli. Ogni sistema AI riceve uno o più ruoli e può svolgere solo le operazioni consentite da tali ruoli. L’RBAC è semplice da implementare e da comprendere, ideale per la maggior parte delle organizzazioni.

Il controllo degli accessi basato su attributi (ABAC) è più sofisticato e flessibile. Invece di assegnare ruoli, definisci policy basate su attributi della richiesta: dipartimento dell’utente, livello di classificazione dei dati, orario, ubicazione geografica, scopo dell’accesso e altri fattori. L’ABAC consente un controllo più granulare ma richiede una progettazione attenta delle policy.

Applica il principio del minimo privilegio: concedi a ciascun sistema AI solo i permessi minimi necessari a funzionare. Se un sistema AI deve solo leggere nomi e email dei clienti, non dargli accesso a informazioni di pagamento o numeri di previdenza. Se deve solo leggere, non concedere permessi di scrittura o cancellazione.

Anche con autenticazione e autorizzazione forti, è necessario proteggere i dati stessi. Questo comporta due strategie complementari: crittografia e data masking.

La crittografia in transito protegge i dati durante il trasferimento tra database e piattaforma AI. Utilizza TLS 1.2 o superiore per tutte le connessioni. Così, anche se il traffico viene intercettato, i dati restano illeggibili senza chiavi di cifratura. La maggior parte degli API gateway e dei database moderni supporta TLS di default, ma verifica sempre che sia abilitato e configurato correttamente.

La crittografia a riposo protegge i dati memorizzati nel database. Anche se un attaccante accede ai file o ai backup del database, non può leggere i dati senza le chiavi. La maggior parte dei database moderni supporta la crittografia trasparente dei dati (TDE) o funzioni simili. Abilita questa funzione e assicurati che le chiavi siano gestite in modo sicuro.

La gestione delle chiavi è fondamentale. Non archiviare mai le chiavi di crittografia insieme ai dati cifrati. Usa un servizio dedicato di gestione chiavi (KMS) che controlli l’accesso alle chiavi separatamente dal database. Ruota regolarmente le chiavi di crittografia—almeno annualmente, più spesso per dati molto sensibili. Implementa il versioning delle chiavi in modo che quelle vecchie restino disponibili per decifrare dati storici.

Il data masking consiste nel sostituire i valori sensibili con valori offuscati o sintetici. Ad esempio, il codice fiscale di un cliente potrebbe essere mascherato come “XXX-XX-1234”, mostrando solo le ultime cifre. Un numero di carta di credito potrebbe essere mascherato come “--****-4567”. Questo consente ai sistemi AI di lavorare con dati dalla stessa struttura e distribuzione, ma senza esporre i valori reali.

Il data masking dinamico applica regole di mascheramento in fase di query, in base al ruolo dell’utente e alla sensibilità del dato. Un operatore customer care può vedere nomi e numeri di telefono completi, mentre un sistema di analytics AI vede solo versioni mascherate. Questo approccio è più flessibile rispetto al masking statico, poiché permette regole diverse per utenti diversi.

Implementa masking a livello di colonna per i dati più sensibili. Identifica le colonne che contengono PII, informazioni di pagamento, dati sanitari o altre informazioni regolamentate e applica regole di masking a tali colonne. Molti database lo supportano nativamente, oppure puoi implementarlo a livello di API gateway.

Vediamo come funziona l’RBAC in uno scenario pratico. Immagina un database con informazioni clienti, storici transazioni e dati di prodotto. Vuoi esporre il database a tre diversi sistemi AI: un motore di raccomandazione, un sistema antifrode e una piattaforma di analytics.

| Sistema AI | Accesso richiesto | Ruolo consigliato | Permessi specifici |

|---|---|---|---|

| Motore di raccomandazione | Profili cliente, storico acquisti | AI_RECOMMENDATIONS_READER | SELECT su tabelle clienti, ordini, prodotti; nessun accesso a metodi di pagamento o contatti personali |

| Sistema antifrode | Dettagli transazioni, storico clienti | AI_FRAUD_DETECTOR | SELECT su transazioni, clienti, account; accesso a informazioni di pagamento ma non a contatti clienti |

| Analytics | Dati aggregati clienti | AI_ANALYTICS_READER | SELECT solo su viste aggregate; nessun accesso a singoli record clienti o dettagli transazioni |

Ogni ruolo ha permessi specifici che limitano quali dati sono accessibili e quali operazioni sono consentite. Il motore di raccomandazione non vede dati di pagamento perché non necessari. Il sistema antifrode vede le transazioni ma non le email dei clienti. La piattaforma analytics vede solo dati aggregati.

Questo garantisce che, anche se un sistema AI viene compromesso, l’accesso dell’attaccante resta limitato ai soli dati necessari a quel sistema. Il raggio d’azione di un incidente viene minimizzato.

Anche con controlli preventivi solidi, è necessario rilevare e rispondere agli incidenti di sicurezza. Servono monitoraggio completo, audit logging dettagliato e rilevamento automatico delle minacce.

Abilita audit logging dettagliati per tutti gli accessi al database. Ogni query eseguita da un sistema AI deve essere registrata, includendo:

Archivia i log in una posizione sicura e immutabile separata dal database primario. I cloud provider offrono servizi di logging gestiti (come AWS CloudTrail, Google Cloud Logging, Azure Monitor) che offrono questa funzionalità. Conserva i log per almeno un anno, più a lungo per dati molto sensibili.

Implementa monitoraggio in tempo reale che rilevi pattern sospetti di accesso al database. Configura alert per:

I moderni tool di monitoraggio database possono fingerprintare le query e rilevare anomalie automaticamente. Strumenti come Imperva e Satori offrono rilevamento minacce AI-powered che imparano i pattern normali e segnalano le deviazioni.

Prepara un piano di risposta agli incidenti specifico per database e AI. Questo piano deve includere:

Per organizzazioni con dataset ampi e diversificati, valuta la segmentazione dei dati per ridurre l’esposizione. Puoi agire su più fronti:

Network segmentation: posiziona il database su una rete separata ad accesso ristretto. Solo l’API gateway può accedere direttamente al database. Le piattaforme AI accedono solo tramite il gateway, mai direttamente.

Database segmentation: se il tuo database contiene dati sensibili e non sensibili, considera di separarli in database diversi. Così, un sistema AI che ha bisogno solo di dati non sensibili riceve accesso solo a quel database.

Data sharding: per dataset molto grandi, suddividi i dati in “shard” secondo criteri (ad es. ID cliente o regione). Concedi ai sistemi AI accesso solo agli shard necessari.

Dati sintetici: per sviluppo e test, usa dati sintetici che imitano la struttura e distribuzione dei dati reali ma senza informazioni sensibili. Gli AI possono essere addestrati e testati su dati sintetici, riducendo la necessità di esporre quelli reali.

Esporre il database alle piattaforme AI ha importanti implicazioni di conformità. Diverse normative impongono requisiti differenti:

GDPR (Regolamento Generale sulla Protezione dei Dati): se processi dati personali di residenti UE, si applica il GDPR. Requisiti chiave:

CCPA (California Consumer Privacy Act): se processi dati di residenti in California, si applica il CCPA. Requisiti chiave:

HIPAA (Health Insurance Portability and Accountability Act): se gestisci dati sanitari protetti, si applica HIPAA. Requisiti chiave:

Standard di settore: in base al settore, possono applicarsi:

Prima di esporre dati alle piattaforme AI, esegui una valutazione di conformità per capire quali regolamenti si applicano e quali requisiti specifici comportano.

Gestire l’accesso sicuro ai database per le piattaforme AI significa coordinare più sistemi e applicare policy coerenti in tutta l’organizzazione. Qui le piattaforme di workflow automation come FlowHunt diventano fondamentali.

FlowHunt permette di costruire workflow automatizzati che integrano in sicurezza sistemi AI e infrastruttura database. Invece di gestire manualmente API key, monitoraggio accessi e coordinamento tra team, FlowHunt offre una piattaforma unificata per:

Orchestrazione workflow: Definisci workflow complessi che includono query database, elaborazione AI e trasformazione dati. FlowHunt gestisce l’orchestrazione, assicurando che ogni step venga eseguito in sicurezza e nell’ordine corretto.

Integrazione controllo accessi: FlowHunt si integra con sistemi identity e access management, applicando automaticamente RBAC e principio del minimo privilegio a tutti i workflow AI.

Audit e conformità: FlowHunt mantiene audit log completi di tutte le esecuzioni dei workflow, inclusi dati consultati, quando e da chi. Questi log supportano la conformità a GDPR, CCPA, HIPAA e altre normative.

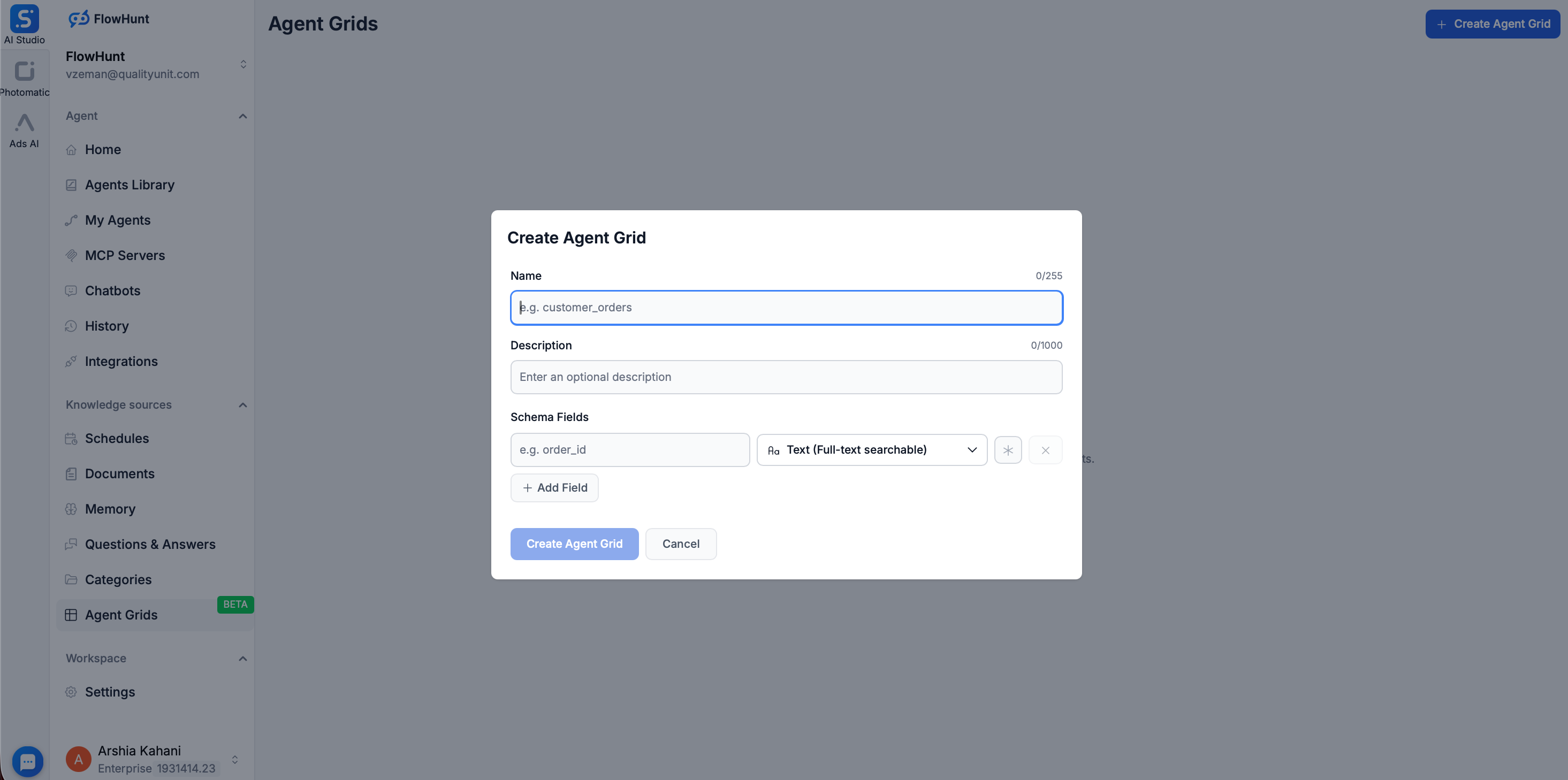

Per chi desidera un ulteriore livello di isolamento tra i modelli AI e i database di produzione, FlowHunt offre la funzionalità Grid. Il Grid consente agli utenti di creare un database ricercabile semplicemente caricando file strutturati, come CSV.

Una volta caricato un CSV nel Grid, FlowHunt utilizza Elasticsearch per indicizzare i dati, trasformando un file statico in una Knowledge Source dinamica e ad alta velocità. Questo approccio offre notevoli vantaggi di sicurezza:

Grazie a Grid e alle funzionalità di workflow di FlowHunt, riduci la complessità della gestione dei controlli di sicurezza e garantisci enforcement coerente delle policy.

Implementare l’esposizione sicura del database alle piattaforme AI è un processo articolato. Ecco una roadmap pratica:

Passo 1: Valuta lo stato attuale

Passo 2: Progetta l’architettura

Passo 3: Implementa i controlli base

Passo 4: Implementa la protezione dei dati

Passo 5: Attiva monitoraggio e auditing

Passo 6: Testa e valida

Passo 7: Operazionalizza e mantieni

Durante l’implementazione, presta attenzione a questi errori frequenti:

Esposizione diretta del database: non esporre mai il database direttamente a Internet o piattaforme AI senza un API gateway. È il rischio più grave.

Permessi troppo ampi: concedere ai sistemi AI più permessi del necessario viola il principio del minimo privilegio. Parti con permessi minimi e amplia solo se serve.

Crittografia inadeguata: cifrare solo in transito o solo a riposo lascia i dati vulnerabili. Crittografa sempre entrambi gli strati.

Gestione debole delle credenziali: inserire credenziali nel codice, archiviarle in version control o non ruotarle regolarmente produce rischi enormi.

Monitoraggio insufficiente: controlli preventivi solidi senza monitoraggio significano non sapere se sono stati aggirati.

Ignorare la conformità: non considerare i requisiti normativi fino a dopo una violazione è costoso. Integra la compliance dall’inizio.

Test inadeguati: controlli non testati potrebbero non funzionare quando servono.

Con l’evoluzione dell’AI, emergono nuovi vettori d’attacco. Due minacce particolarmente rilevanti sono prompt injection e model extraction.

Prompt Injection: un attaccante costruisce un prompt che induce il sistema AI a eseguire azioni indesiderate, ad esempio ignorare i controlli di accesso e restituire dati riservati. Difenditi così:

Model Extraction: un attaccante interagisce col modello AI per estrarre dati di training o informazioni interne. Difenditi così:

Esporre in sicurezza il database alle piattaforme AI non solo è possibile—sta diventando necessario per le organizzazioni che vogliono sfruttare le potenzialità dell’AI proteggendo il loro patrimonio informativo. La chiave è un approccio a strati che combini autenticazione e autorizzazione forti, crittografia, data masking, monitoraggio completo e test regolari.

Parti dai fondamentali: non esporre mai il database direttamente, usa sempre un API gateway, implementa autenticazione e autorizzazione robuste, cifra i dati. Da qui, aggiungi data masking, monitoraggio e controlli di conformità adeguati al rischio e ai requisiti normativi della tua organizzazione.

Ricorda che la sicurezza non è una implementazione una tantum, ma un processo continuo. Rivedi regolarmente i controlli, testa le vulnerabilità, monitora le minacce e aggiorna l’approccio man mano che emergono nuovi rischi. Considerando la sicurezza dei database come una priorità costante e non un semplice adempimento, puoi sfruttare il valore dell’AI proteggendo dati e reputazione della tua organizzazione.

Scopri come FlowHunt automatizza i workflow AI e SEO — dalla ricerca alla generazione dei contenuti, fino alla pubblicazione e analytics — tutto in un unico posto.

Sì, è sicuro se implementi adeguate misure di sicurezza tra cui API gateway, crittografia, controllo degli accessi basato sui ruoli e monitoraggio completo. La chiave è utilizzare un middleware sicuro invece di esporre direttamente il database.

Utilizza credenziali forti, a rotazione periodica, con autenticazione a più fattori (MFA) per gli utenti umani e i service principal. Implementa OAuth, token JWT o API key con rigoroso rate limiting e whitelist degli IP per gli agenti AI.

Implementa data masking, crittografia a livello di colonna, controllo degli accessi basato sui ruoli (RBAC) e separa i dati di produzione da quelli di training AI. Usa il data masking dinamico per nascondere i campi sensibili nei risultati delle query e mantieni audit trail immutabili.

A seconda del tipo di dati, considera GDPR, CCPA, HIPAA e altri regolamenti rilevanti. Assicurati di avere una corretta classificazione dei dati, policy di retention e meccanismi di consenso prima di esporre qualsiasi dato personale o sensibile.

Arshia è una AI Workflow Engineer presso FlowHunt. Con una formazione in informatica e una passione per l'IA, è specializzata nella creazione di workflow efficienti che integrano strumenti di intelligenza artificiale nelle attività quotidiane, migliorando produttività e creatività.

Ottimizza i tuoi workflow di dati alimentati dall’AI mantenendo standard di sicurezza e conformità di livello enterprise.

Scopri la politica di sicurezza completa di FlowHunt, che copre pratiche di sicurezza infrastrutturale, organizzativa, di prodotto e di privacy dei dati per gar...

La trasparenza dell'IA è la pratica di rendere comprensibili agli stakeholder i meccanismi e i processi decisionali dei sistemi di intelligenza artificiale. Sco...

Integra FlowHunt con il server Model Context Protocol (MCP) di GreptimeDB per abilitare un accesso sicuro, strutturato e potenziato dall’AI al tuo database di s...

Consenso Cookie

Usiamo i cookie per migliorare la tua esperienza di navigazione e analizzare il nostro traffico. See our privacy policy.