Sora 2: Generazione Video AI per Content Creator

Esplora le straordinarie capacità di Sora 2 nella generazione di video tramite intelligenza artificiale, dalla ricreazione realistica dei personaggi alla simula...

Scopri le straordinarie capacità di Sora 2 nella generazione video con intelligenza artificiale, dalla ricreazione realistica dei personaggi alla simulazione della fisica, e scopri come questa tecnologia sta trasformando la creazione e l’automazione dei contenuti.

Sora 2 rappresenta un salto in avanti significativo nella tecnologia di generazione video tramite intelligenza artificiale. L’ultima versione del modello di generazione video di OpenAI offre capacità senza precedenti a creator, marketer e aziende che desiderano ottimizzare il flusso di lavoro nella produzione di video. Questa guida approfondita esplora le straordinarie funzionalità di Sora 2, le sue applicazioni pratiche e le implicazioni per il futuro della creazione di contenuti. Dalla ricreazione dei personaggi di fantasia più amati alla generazione di performance umane realistiche, Sora 2 dimostra il potenziale trasformativo dell’AI generativa nella produzione multimediale visiva. Che tu sia interessato alle capacità tecniche, alle possibilità creative o agli utilizzi aziendali, qui troverai un’analisi dettagliata di ciò che rende Sora 2 una tecnologia rivoluzionaria.

La generazione video tramite intelligenza artificiale è una delle frontiere più entusiasmanti della tecnologia AI generativa. A differenza della produzione video tradizionale, che richiede telecamere, attori, attrezzature di illuminazione e un esteso lavoro di post-produzione, la generazione video AI crea video direttamente da descrizioni o prompt testuali. La tecnologia utilizza modelli di deep learning addestrati su enormi quantità di dati video per comprendere la relazione tra descrizioni linguistiche e contenuti visivi. Questi modelli imparano a riconoscere i pattern di movimento degli oggetti, come la luce interagisce con le superfici, come le persone gesticolano ed esprimono emozioni e come le scene si susseguono in modo naturale. Quando un utente fornisce un prompt testuale, il modello AI elabora queste informazioni e genera il video fotogramma per fotogramma, garantendo coerenza nell’aspetto dei personaggi, nei movimenti e nei dettagli ambientali lungo tutta la sequenza. La tecnologia di base comprende modelli di diffusione e architetture transformer adattate specificamente alla generazione video, consentendo al sistema di mantenere la coerenza temporale—ovvero, oggetti e personaggi si muovono in modo naturale e continuo tra i frame, invece di teletrasportarsi o sfarfallare.

L’importanza della generazione video AI va ben oltre la semplice novità. Questa tecnologia risolve le sfide fondamentali della produzione di contenuti: tempo, costi e scalabilità. La produzione video tradizionale può richiedere settimane o mesi e l’impiego di team di professionisti tra registi, direttori della fotografia, montatori e specialisti degli effetti visivi. La generazione video AI può produrre risultati paragonabili in pochi minuti, rendendo la produzione accessibile a piccole aziende, creator indipendenti e imprese che prima non potevano permettersi produzioni professionali. La democratizzazione della creazione video tramite AI ha profonde implicazioni per il marketing, l’istruzione, l’intrattenimento e la comunicazione aziendale. Con il continuo progresso e la maggiore accessibilità di questi sistemi, sta cambiando il modo in cui le organizzazioni concepiscono la strategia e i flussi di lavoro nella produzione di contenuti visivi.

Il business case per la generazione video AI è convincente e sfaccettato. Nell’attuale panorama digitale, i contenuti video dominano le metriche di engagement su tutte le piattaforme. Secondo i dati di settore, i video generano tassi di coinvolgimento significativamente più alti rispetto a immagini statiche o testo, con piattaforme come TikTok, YouTube e Instagram che danno priorità ai video nei loro algoritmi. Tuttavia, produrre video di alta qualità su larga scala è sempre stato proibitivo in termini di costi per la maggior parte delle organizzazioni. La generazione video AI risolve questo vincolo consentendo alle aziende di produrre infiniti video per A/B test, personalizzazione e iterazione rapida. I team marketing possono generare dozzine di demo prodotto in diversi stili e formati senza dover rigirare. Gli enti formativi possono creare contenuti personalizzati su larga scala. I reparti customer service possono produrre video formativi per nuove procedure in tempo reale. L’impatto economico è notevole: le aziende possono ridurre i costi di produzione video del 70-90% aumentando al contempo il volume di output di ordini di grandezza.

Oltre alla riduzione dei costi, la generazione video AI abilita nuove forme di creatività e sperimentazione. I content creator possono testare idee audaci senza rischiare risorse significative. Possono generare più versioni di un concept per capire cosa risuona con il pubblico. Possono creare contenuti in diversi stili, toni e formati per adattarsi a segmenti di audience o requisiti di piattaforma differenti. Questa flessibilità trasforma il video da risorsa scarsa e pianificata con attenzione a mezzo abbondante e sperimentale. Le implicazioni strategiche sono profonde: invece di pianificare poche produzioni video di alto profilo a trimestre, le organizzazioni possono adottare un modello di creazione continua, dove il video diventa routine quanto la pubblicazione di articoli sul blog. Questo cambiamento permette contenuti più tempestivi, personalizzati e coinvolgenti, meglio allineati ai bisogni del pubblico e agli obiettivi aziendali. Inoltre, la generazione video AI apre possibilità di contenuti interattivi e dinamici che si adattano allo spettatore, creando opportunità di engagement e conversione senza precedenti.

Sora 2 si basa sui modelli precedenti di generazione video con notevoli miglioramenti su più fronti. L’aspetto più evidente è il salto di qualità visiva e realismo. I video generati da Sora 2 mostrano luci più realistiche, color grading naturale, dettagli testurizzati più precisi e proprietà dei materiali convincenti. Guardando un video Sora 2, la qualità visiva raggiunge spesso standard cinematografici professionali. Il modello eccelle nel rappresentare scene complesse con più oggetti, mantenendo illuminazione coerente in tutto il frame e creando riflessi e ombre realistici. Questo livello qualitativo è fondamentale per applicazioni professionali dove output scadenti comprometterebbero credibilità e percezione del brand.

La simulazione della fisica rappresenta un altro grande passo avanti di Sora 2. I modelli precedenti spesso faticavano con la coerenza fisica—oggetti che si muovevano in modo innaturale, gravità incoerente o collisioni non rilevate correttamente. Sora 2 dimostra una comprensione molto più avanzata delle leggi fisiche e delle interazioni tra oggetti e ambiente. Se una palla viene lanciata, segue una traiettoria realistica. Se una persona cammina, il suo movimento appare naturale e credibile. Se avviene una collisione, l’interazione sembra plausibile. Questo miglioramento è essenziale per applicazioni dove l’accuratezza fisica conta davvero, come demo prodotto, contenuti educativi o intrattenimento dove gli spettatori noterebbero subito incoerenze. La migliore comprensione della fisica consente anche scene più dinamiche e complesse, prima impossibili.

La coerenza e consistenza temporale sono miglioramenti critici che rendono i video Sora 2 simili a vere registrazioni e non a semplici sequenze di frame scollegate. Il modello mantiene l’identità dei personaggi per tutto il video, garantendo che le persone appaiano sempre uguali invece di cambiare aspetto o “morfare”. I dettagli ambientali restano costanti—una pianta sullo sfondo resta nella stessa posizione e con lo stesso aspetto. Questa coerenza è essenziale per le applicazioni professionali e crea un’esperienza visiva immersiva e naturale. Il modello mostra anche una migliore comprensione del movimento e delle sequenze d’azione, generando movimenti fluidi invece di transizioni innaturali tra pose.

Una delle funzionalità più impressionanti di Sora 2 è la capacità di ricreare con precisione volti e sembianze umane tramite la scansione del volto. Gli utenti che effettuano una scansione riportano che il modello raggiunge circa il 90% di accuratezza nel replicare tratti del viso, espressioni ed elementi sottili come texture della pelle e riflessi di luce. Questo livello di accuratezza è davvero notevole e apre possibilità finora confinate alla fantascienza. Guardando un video di se stessi generato con Sora 2, l’esperienza è spiazzante—sei chiaramente tu, ma in situazioni mai vissute, compiendo azioni mai fatte. Il modello cattura non solo i tratti statici ma anche la dinamicità delle espressioni. L’illuminazione sul volto è realistica, i riflessi negli occhi e dettagli come la texture della pelle e il movimento dei capelli sono resi in modo convincente.

Le implicazioni di questa tecnologia sono sia entusiasmanti che preoccupanti. Dal lato positivo, i creator possono generare contenuti con la propria immagine senza essere fisicamente presenti. Uno youtuber può produrre molte varianti di video senza dover fare più riprese. Un docente può creare contenuti formativi personalizzati con il proprio volto. Un manager può generare video di formazione o annunci senza pianificare sessioni di ripresa. Il risparmio di tempo e costi è notevole. Tuttavia, questa funzionalità solleva questioni importanti su consenso, autenticità e possibili abusi. In teoria, la tecnologia potrebbe essere usata per creare deepfake o contenuti ingannevoli senza il permesso dei soggetti. OpenAI ha introdotto misure di sicurezza, come la possibilità per gli utenti di gestire chi può usare la propria immagine, ma il rischio di abuso rimane e dovrà essere affrontato tramite policy e regolamentazione.

Sora 2 permette applicazioni creative prima impossibili o troppo costose. Uno degli utilizzi più divertenti è la ricreazione di personaggi di fantasia in nuovi scenari. Gli utenti hanno generato video di SpongeBob SquarePants che fa drill rap, con design, animazione e sintesi vocale coerenti col personaggio. Il modello rispetta lo stile visivo distintivo e mantiene la coerenza lungo il video. Allo stesso modo sono state ricreate scene di videogiochi classici, come Halo, inclusi stile grafico, elementi UI e voce narrante. Queste applicazioni dimostrano la capacità di Sora 2 di comprendere e replicare stili visivi, design dei personaggi e convenzioni estetiche specifiche.

Le possibilità di intrattenimento si estendono anche alla creazione di nuovi contenuti nello stile di franchise esistenti. Gli utenti hanno creato episodi completi di SpongeBob concatenando più clip di Sora 2, mantenendo coerenza narrativa e stilistica. Ciò suggerisce un futuro in cui l’AI possa collaborare all’animazione, generando scene che gli animatori umani poi rifiniscono. La tecnologia potrebbe democratizzare la produzione animata, consentendo a creator indipendenti di creare animazioni senza grandi team. Anche la ricreazione di videogiochi è un’applicazione affascinante: personaggi inseriti in ambienti Minecraft o remake di classici come Mario Kart in stile fotorealistico. Questi esempi mostrano la flessibilità del modello e la sua capacità di adattamento a stili e contesti diversi.

Nonostante Sora 2 rappresenti un progresso importante, è fondamentale comprenderne i limiti attuali. I test dimostrano che, sebbene la ricreazione facciale sia generalmente accurata, a volte il modello fatica a mantenere la coerenza. Generando più video con lo stesso prompt, l’output può variare molto: talvolta il volto è perfetto, altre volte si notano effetti di morphing o incoerenze nei tratti. Questa variabilità indica che la qualità non è ancora del tutto deterministica e potrebbe essere necessario generare più versioni per trovare quella migliore. L’incoerenza si nota soprattutto in casi limite o scenari complessi.

La rappresentazione e manipolazione delle mani è una notevole limitazione negli attuali video Sora 2. Nei video con movimenti dettagliati delle mani o manipolazione di oggetti, i risultati spesso non convincono: mani distorte, dita che si muovono innaturalmente, oggetti non impugnati in modo realistico. Questo limite è evidente in attività che richiedono coordinazione fine, come suonare strumenti, interventi chirurgici o compiti manuali complessi. Riflette una sfida generale dell’AI video: comprendere e replicare la complessa biomeccanica del movimento umano, specialmente delle mani e dita. Il miglioramento di questi aspetti è tema attivo di ricerca.

Errori fisici compaiono talvolta nei video Sora 2, soprattutto in contesti complessi con più oggetti o forze. In alcuni video, auto si muovono al contrario, oggetti fluttuano o le collisioni non vengono rilevate. Questi errori sono meno frequenti rispetto al passato ma ancora rilevabili. Tipicamente emergono in casi limite o quando il prompt descrive interazioni fisiche complesse non frequenti nei dati di training. Anche la sintesi vocale necessita miglioramenti: talvolta le voci generate risultano artificiali o con artefatti digitali. La qualità varia in base alla voce sintetizzata e alla complessità del parlato.

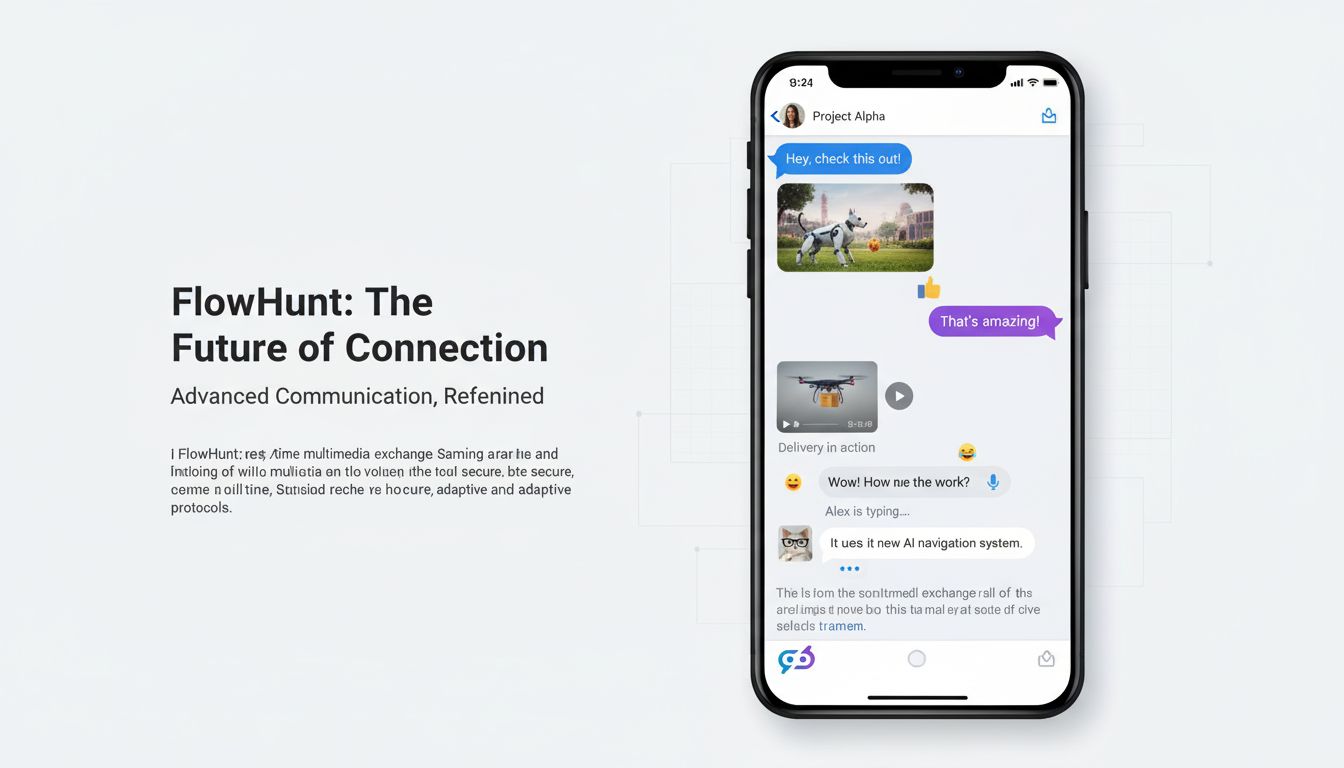

FlowHunt riconosce il potenziale trasformativo della generazione video AI e sta integrando queste capacità nella sua piattaforma di automazione per aiutare le aziende a ottimizzare la creazione di contenuti. Invece di trattare la generazione video come strumento isolato, FlowHunt la posiziona all’interno di un ecosistema di automazione dei contenuti. Questo consente alle aziende di costruire workflow end-to-end che combinano generazione video, creazione contenuti, distribuzione e analisi. Ad esempio, un team marketing può generare video demo prodotto, aggiungere automaticamente sottotitoli e branding, pubblicare su più piattaforme e tracciare le metriche di engagement—tutto senza intervento manuale.

L’integrazione di Sora 2 e modelli simili nella piattaforma FlowHunt abilita potenti scenari di automazione. I team possono impostare task ricorrenti per la generazione periodica di nuovi video. Gli e-commerce possono creare video prodotto automaticamente per ogni nuovo articolo. I marketer possono generare varianti personalizzate per diversi segmenti di pubblico. Gli enti formativi possono produrre contenuti su richiesta. I reparti customer service possono creare video istruttivi per problemi comuni. Combinando la generazione video con le capacità di automazione di FlowHunt, le organizzazioni possono raggiungere una scala e un’efficienza impensabili nella produzione video. La piattaforma gestisce orchestrazione, pianificazione e integrazione con altri sistemi, così i team possono concentrarsi su strategia e creatività invece che sulla produzione manuale.

Le applicazioni di Sora 2 spaziano virtualmente in ogni settore e funzione aziendale. Nel marketing e pubblicità, Sora 2 consente la creazione di video demo, testimonianze e contenuti promozionali su larga scala. I brand possono generare più varianti di annunci per testare messaggi, stili visivi e call-to-action. Gli e-commerce possono produrre video prodotto per migliaia di articoli senza riprese individuali. Gli agenti immobiliari possono generare tour virtuali. Le agenzie di viaggio possono creare video su destinazioni. Il risparmio di tempo e costi è rivoluzionario per i reparti marketing che prima faticavano con i colli di bottiglia nella produzione video.

Nell’istruzione e formazione, Sora 2 permette la creazione di contenuti didattici personalizzati, video istruttivi e materiali per la formazione. Gli enti formativi possono generare video con docenti in scenari diversi, spiegando concetti in modi differenti o dimostrando procedure. I reparti HR possono creare video di onboarding, formazione sulla sicurezza e sviluppo professionale. La generazione on demand permette di aggiornare rapidamente i contenuti al variare delle procedure o dell’informazione. La personalizzazione diventa scalabile: ogni studente può ricevere video adattati al proprio stile di apprendimento e conoscenze pregresse.

Nell’intrattenimento e produzione media, Sora 2 apre nuove possibilità per animazione, effetti visivi e creazione di contenuti prima limitati da tempi e budget. I creator indipendenti possono produrre animazioni senza grandi team. Le produzioni cinematografiche e televisive possono utilizzare contenuti AI per effetti visivi, elementi di sfondo o intere scene. Si possono generare videoclip musicali o contenuti originali per piattaforme di streaming in modo più efficiente. La tecnologia democratizza l’intrattenimento, permettendo anche a chi ha budget limitati di creare contenuti di qualità professionale.

Nella comunicazione aziendale e operazioni interne, Sora 2 consente di creare comunicazioni executive, annunci aziendali, video formativi e documentazione interna. I dirigenti possono generare messaggi personalizzati senza riprese. Gli HR possono produrre contenuti per nuove policy o procedure. Gli IT possono creare video istruttivi sui software aziendali. La produzione rapida e conveniente permette di comunicare più spesso ed efficacemente con dipendenti e stakeholder.

L’attuale scenario della generazione video AI è descritto da molti come un “far west del copyright”. Sora 2 può generare video con personaggi, celebrità e proprietà intellettuali protette senza autorizzazione dei titolari dei diritti. Gli utenti possono creare video con SpongeBob, Mario, Zelda e altri personaggi registrati, oppure con celebrità e figure pubbliche. Ciò solleva questioni legali ed etiche rilevanti riguardo i diritti di proprietà intellettuale, il consenso e l’uso appropriato dei contenuti generati dall’AI. La capacità di ricreare fedelmente sembianze e personaggi comporta un elevato potenziale di abuso.

OpenAI ha implementato alcune misure di sicurezza, come la possibilità per gli utenti di gestire chi può usare la propria immagine tramite le impostazioni cameo. Tuttavia, queste misure sono limitate e non risolvono la questione più ampia sulla legittimità di generare contenuti con personaggi o celebrità protetti senza permesso. Il quadro normativo è ancora in evoluzione: autorità e tribunali stanno valutando cosa costituisca fair use, violazione di copyright e i limiti appropriati per i contenuti AI. Alcuni sostengono che la generazione per uso personale rientri nel fair use, altri che ogni uso commerciale richieda consenso. La situazione è complicata dalle diverse leggi e interpretazioni internazionali sul copyright.

Le considerazioni etiche vanno oltre il copyright e toccano autenticità, consenso e potenziali abusi. Gli spettatori potrebbero dare per autentico un video con una celebrità o figura pubblica, se non esplicitamente informati del contrario, creando rischi di inganno e disinformazione. La tecnologia può essere usata per creare deepfake che danneggiano reputazioni o diffondono fake news. Sebbene le attuali limitazioni di Sora 2 rendano difficile creare deepfake perfettamente convincenti di persone specifiche in scenari specifici, la tecnologia sta rapidamente migliorando. Sarà necessario sviluppare norme, regolamenti e strumenti tecnici per prevenire abusi pur mantenendo i vantaggi legittimi dell’AI.

I miglioramenti di Sora 2 rispetto ai modelli precedenti riflettono progressi su più fronti. Il modello utilizza architetture migliorate basate su diffusione che comprendono meglio il legame tra descrizioni testuali e contenuto visivo. L’addestramento sfrutta dati video più vari e di qualità superiore, permettendo di apprendere pattern più sofisticati sul funzionamento del mondo reale. La comprensione di fisica, illuminazione e materiali è stata potenziata tramite dati migliori e funzioni di loss che penalizzano output fisicamente implausibili. La miglior coerenza temporale deriva da meccanismi avanzati per mantenere lo stato tra i frame e una migliore attenzione alle dipendenze a lungo raggio nelle sequenze video.

Le capacità di scansione facciale e ricreazione dei personaggi si basano su componenti specializzati che codificano le caratteristiche del volto e le informazioni sull’identità in modo da preservarle durante la generazione. Questi componenti probabilmente usano tecniche simili a quelle del riconoscimento facciale, ma adattate al contesto video. Il modello impara ad associare informazioni di identità a pattern visivi specifici e a mantenerle durante la generazione. I miglioramenti nella sintesi vocale derivano da modelli text-to-speech più avanzati e una migliore integrazione tra generazione video e audio. Ora il modello può generare audio più sincronizzato con i movimenti labiali e le espressioni, rendendo il risultato più credibile.

Sebbene Sora 2 rappresenti un avanzamento importante, è utile capire come si posiziona rispetto ad altri modelli presenti sul mercato. Modelli come Runway, Synthesia e soluzioni open-source hanno punti di forza e debolezza differenti. Runway, ad esempio, punta su strumenti accessibili e una solida community. Synthesia è specializzata nella generazione video con avatar per comunicazione aziendale. I modelli open-source come Stable Video Diffusion offrono flessibilità e opzioni di personalizzazione. Sora 2 si distingue per qualità visiva superiore, simulazione fisica più realistica e ricreazione dei personaggi più accurata. La capacità di generare video più lunghi e gestire scene complesse offre vantaggi in molte applicazioni.

Tuttavia, anche Sora 2 ha limitazioni rispetto ad alcune alternative. Alcuni modelli offrono generazione in tempo reale o richiedono meno risorse computazionali. Altri danno più controllo su aspetti specifici del video. Alcuni si integrano meglio con piattaforme o workflow particolari. La scelta del modello dipende da esigenze, casi d’uso e vincoli specifici. Per applicazioni che richiedono massima qualità visiva e realismo, Sora 2 è probabilmente la scelta migliore. Per necessità di generazione in tempo reale o personalizzazione avanzata, altri modelli possono essere più adatti. Il settore è in rapida evoluzione e ci si aspettano continui miglioramenti e nuovi modelli specializzati.

Scopri come FlowHunt automatizza i tuoi flussi di lavoro per contenuti e video AI—dalla ricerca e generazione alla pubblicazione e analisi—tutto in un unico posto.

La traiettoria della tecnologia di generazione video AI suggerisce che siamo solo agli inizi. Le future versioni di Sora e dei modelli concorrenti probabilmente supereranno le attuali limitazioni su destrezza delle mani, simulazione fisica e coerenza. Ci si aspettano miglioramenti in lunghezza, risoluzione e capacità di gestire scene sempre più complesse. I modelli diventeranno più efficienti, richiedendo meno risorse computazionali. L’integrazione con altri sistemi AI abiliterà workflow sofisticati, dove la generazione video si combina con altre forme di creazione e analisi dei contenuti.

Le implicazioni per la creazione di contenuti sono profonde. Con una generazione video AI sempre più accessibile e potente, il video diventerà routine quanto il testo nella comunicazione digitale. Le organizzazioni passeranno da considerare il video una risorsa scarsa e costosa a vederlo come mezzo abbondante e sperimentale. Questo cambiamento permetterà contenuti più tempestivi, personalizzati e coinvolgenti. Tuttavia, porterà anche sfide su autenticità, disinformazione e necessità di nuove regole e norme per i contenuti AI. La tecnologia cambierà profondamente le industrie creative, potenzialmente sostituendo alcuni ruoli ma creando nuove opportunità per chi saprà dirigere e curare efficacemente i contenuti AI.

Per le organizzazioni che vogliono sfruttare Sora 2 nella creazione di contenuti, alcune best practice possono massimizzare i risultati. Primo, conoscere punti di forza e limiti del modello. Sora 2 eccelle in scene realistiche con buona illuminazione e fisica, ma fatica con movimenti complessi delle mani e talvolta produce risultati incoerenti. Progetta prompt che valorizzino i punti di forza. Secondo, genera più varianti dello stesso prompt e seleziona i migliori risultati. L’output del modello varia, quindi ripetere lo stesso prompt più volte spesso dà risultati migliori del primo tentativo. Terzo, usa la scansione facciale per la ricreazione dei personaggi quando l’accuratezza è importante. La scansione migliora sensibilmente la fedeltà rispetto a semplici descrizioni testuali.

Quarto, suddividi video complessi in più clip da concatenare invece di generare tutto in un unico prompt. Questo approccio dà più controllo e spesso risultati migliori. Quinto, fornisci prompt dettagliati e specifici che descrivano non solo cosa deve accadere, ma anche stile visivo, illuminazione e atmosfera desiderati. Prompt vaghi producono risultati mediocri; quelli dettagliati, che specificano dettagli visivi, inquadrature e preferenze estetiche, danno output molto superiori. Sesto, integra la generazione video in workflow di contenuti più ampi tramite strumenti come FlowHunt che automatizzano l’intero processo, dalla generazione alla pubblicazione e analisi. Questo massimizza l’efficienza e consente di scalare la produzione video a livelli mai visti.

Con la crescente diffusione della generazione video AI, le preoccupazioni su autenticità, disinformazione e perdita di posti di lavoro sono legittime e vanno prese sul serio. Le organizzazioni dovrebbero essere trasparenti sull’uso dell’AI, soprattutto quando il pubblico potrebbe presumere che i contenuti siano autentici. Dichiarare che un contenuto è generato dall’AI costruisce fiducia e aiuta il pubblico a comprendere ciò che vede. Questa trasparenza è particolarmente importante per contenuti che possono influenzare decisioni o opinioni rilevanti. In settori regolamentati come sanità, finanza o ambiti legali, potrebbero esserci obblighi specifici di disclosure sull’uso dei contenuti AI.

Il rischio di abuso tramite deepfake e disinformazione è reale e va affrontato in modo proattivo. Salvaguardie tecniche come il watermarking possono aiutare a identificare i media sintetici. Policy e regolamentazione si evolveranno per gestire gli abusi. L’educazione alla media literacy aiuterà il pubblico a capire come funzionano i contenuti AI e a sviluppare spirito critico sull’autenticità. Le organizzazioni dovrebbero adottare policy interne sull’uso appropriato della generazione video AI e impegnarsi a utilizzarla responsabilmente. L’obiettivo deve essere sfruttare i benefici legittimi dell’AI evitando abusi e mantenendo la fiducia nei media e nella comunicazione.

Sora 2 rappresenta una svolta nella tecnologia di generazione video AI, offrendo capacità che fino a poco tempo fa appartenevano solo alla fantascienza. La possibilità di generare video realistici e fisicamente plausibili, con ricreazione accurata dei personaggi, apre opportunità inedite per creator, marketer, formatori e aziende di ogni settore. Pur persistendo limiti attuali su destrezza delle mani, coerenza fisica e variabilità dell’output, il trend di miglioramento è evidente. La tecnologia continuerà ad avanzare, diventando più potente, efficiente e accessibile. Le organizzazioni che comprenderanno punti di forza e limiti di Sora 2 e la integreranno nei propri workflow otterranno vantaggi competitivi grazie a costi di produzione ridotti, maggiore produttività e possibilità di sperimentare su vasta scala. Ma questa potenza comporta responsabilità: il rischio di abuso richiede riflessione etica, comunicazione trasparente e misure preventive. Man mano che Sora 2 e tecnologie simili ridefiniranno la creazione di contenuti, avranno successo le organizzazioni che sapranno unire tecnologia, autenticità, trasparenza e valori etici.

Sora 2 è l’ultimo modello di generazione video di OpenAI che crea video realistici e fisicamente accurati da prompt testuali. Migliora i sistemi precedenti grazie a una simulazione della fisica più avanzata, output di qualità superiore, capacità di generare video più lunghi e controlli creativi più sofisticati per gli utenti.

Sì, Sora 2 può ricreare le sembianze di persone reali con grande precisione grazie alla tecnologia di scansione del volto. Gli utenti riportano che il modello raggiunge circa il 90% di accuratezza nel replicare i tratti del viso, le espressioni e persino gli elementi di sfondo, quando vengono forniti i dati di riferimento corretti.

Nonostante sia impressionante, Sora 2 presenta ancora alcune limitazioni tra cui occasionali metamorfosi tra soggetti diversi, destrezza delle mani incoerente, errori fisici in scene complesse e qualità variabile dell’output generando lo stesso prompt più volte. Anche la sintesi vocale necessita di ulteriori miglioramenti in alcuni casi.

Le aziende possono usare Sora 2 per creare video marketing, dimostrazioni di prodotto, contenuti formativi, clip per i social media e intrattenimento. Questa tecnologia può ridurre notevolmente tempi e costi di produzione automatizzando la creazione di video a partire da descrizioni testuali, risultando preziosa per i settori del marketing, dell’istruzione e dell’intrattenimento.

Arshia è una AI Workflow Engineer presso FlowHunt. Con una formazione in informatica e una passione per l'IA, è specializzata nella creazione di workflow efficienti che integrano strumenti di intelligenza artificiale nelle attività quotidiane, migliorando produttività e creatività.

Integra la generazione video AI nella tua pipeline di contenuti e semplifica la produzione dall’ideazione alla pubblicazione.

Esplora le straordinarie capacità di Sora 2 nella generazione di video tramite intelligenza artificiale, dalla ricreazione realistica dei personaggi alla simula...

Scopri tutto ciò che c’è da sapere sull’app Sora-2: le sue capacità, i casi d’uso e il confronto con i principali generatori video AI. Impara come iniziare e ma...

L’aggiornamento di ottobre 2025 di FlowHunt introduce i rivoluzionari modelli Wan 2.2 e 2.5 per la generazione di video da testo, immagini e animazioni, oltre a...

Consenso Cookie

Usiamo i cookie per migliorare la tua esperienza di navigazione e analizzare il nostro traffico. See our privacy policy.