Introduzione

Il panorama dell’intelligenza artificiale sta vivendo un’accelerazione senza precedenti, con tecnologie dirompenti che emergono contemporaneamente in molteplici settori. Dagli occhiali AI indossabili che aumentano la percezione umana ai modelli di ragionamento che superano le capacità umane nella risoluzione di problemi complessi, la convergenza di queste innovazioni sta ridefinendo radicalmente il nostro modo di interagire con la tecnologia e automatizzare i flussi di lavoro. Questa analisi completa esamina gli sviluppi AI più significativi del 2025, tra cui gli avanzati occhiali Ray-Ban di Meta, le capacità di ragionamento sovrumano di OpenAI, la rivoluzionaria tecnologia di generazione di mondi 3D e l’infrastruttura emergente che consente agli agenti autonomi di collaborare e transare tra loro. Comprendere questi sviluppi è fondamentale per aziende e individui che vogliono sfruttare il potenziale trasformativo dell’AI nelle loro attività e nella pianificazione strategica.

Comprendere lo Stato Attuale dell’Hardware AI e dei Wearable

L’evoluzione dell’intelligenza artificiale è stata storicamente limitata dalle interfacce attraverso cui gli esseri umani interagiscono con i sistemi intelligenti. Per decenni ci siamo affidati a tastiere, mouse e schermi per comunicare con i computer, creando una disconnessione fondamentale tra i nostri modi naturali di percepire e gli strumenti digitali che utilizziamo. L’emergere dell’AI indossabile rappresenta un cambiamento di paradigma in questa relazione, spostando il calcolo da dispositivi fissi a forme che si integrano perfettamente nella nostra vita quotidiana. L’investimento di Meta negli occhiali Ray-Ban esemplifica questa transizione, basandosi su decenni di ricerca sulla realtà aumentata e sull’esperienza acquisita con la piattaforma Oculus. L’importanza di questo cambiamento non può essere sottovalutata: circa un terzo della popolazione mondiale indossa occhiali ogni giorno, rappresentando un enorme mercato potenziale per l’occhialeria potenziata dall’AI. Integrando le funzionalità AI direttamente in un dispositivo già utilizzato quotidianamente, Meta si posiziona all’incrocio tra il personal computing e l’intelligenza artificiale, creando una piattaforma in cui l’AI può osservare, comprendere e interagire con il mondo in tempo reale insieme all’utilizzatore.

Pronto a far crescere il tuo business?

Inizia oggi la tua prova gratuita e vedi i risultati in pochi giorni.

Perché i Wearable AI Sono Importanti per il Futuro del Lavoro e dell’Interazione

Le implicazioni dei wearable potenziati dall’AI vanno ben oltre la comodità per i consumatori, toccando aspetti fondamentali del nostro modo di lavorare, imparare e comunicare. Quando un sistema AI può vedere ciò che vedi, sentire ciò che senti e proiettare informazioni direttamente nel tuo campo visivo, cambia radicalmente la natura dell’interazione uomo-computer. Invece di distogliere l’attenzione per controllare un dispositivo, le informazioni scorrono naturalmente nel campo visivo. Invece di digitare domande, puoi semplicemente parlare con il tuo assistente AI mantenendo l’attenzione sull’ambiente fisico. Per applicazioni professionali, ciò rappresenta un enorme aumento di produttività: immagina un tecnico che indossa occhiali AI in grado di identificare attrezzature, recuperare procedure di manutenzione e guidare le riparazioni in tempo reale, o un chirurgo assistito dall’AI durante le operazioni con informazioni anatomiche e suggerimenti in diretta. I miglioramenti della batteria nell’ultima generazione di Ray-Ban, con una capacità aumentata del 42% per fino a cinque ore di utilizzo continuo, affrontano uno dei principali ostacoli all’adozione. Man mano che questi dispositivi diventano più pratici e potenti, è probabile che diventino diffusi quanto gli smartphone, cambiando radicalmente il modo in cui accediamo alle informazioni e interagiamo con i sistemi AI nella vita quotidiana.

La Svolta nel Ragionamento AI: Prestazioni Sovrumane all’ICPC

Uno degli sviluppi più significativi nell’intelligenza artificiale del 2025 è il raggiungimento di prestazioni sovrumane nei compiti di ragionamento complessi. L’International Collegiate Programming Contest (ICPC) World Finals rappresenta l’apice della programmazione competitiva, dove le migliori squadre universitarie mondiali risolvono problemi algoritmici estremamente difficili sotto pressione. Questi problemi richiedono non solo competenze di programmazione, ma anche profondo ragionamento matematico, creatività e capacità di gestire casi limite e vincoli complessi. Il sistema di ragionamento di OpenAI ha ottenuto un punteggio perfetto di 12 su 12 problemi alle finali mondiali ICPC 2025, superando tutti i concorrenti umani. La metodologia adottata è stata particolarmente rilevante: il sistema ha ricevuto i problemi esattamente nello stesso formato PDF dei concorrenti umani, con lo stesso limite di tempo di cinque ore e senza test harness o ottimizzazioni specifiche per la gara. Per undici dei dodici problemi, la prima risposta inviata dal sistema era corretta, dimostrando non solo capacità di risoluzione ma anche calibrazione della fiducia e verifica delle soluzioni. Per il problema più difficile, sono stati necessari nove tentativi prima di arrivare alla soluzione corretta, comunque meglio della migliore squadra umana che ne ha risolti undici su dodici.

L’approccio tecnico alla base di questo risultato prevedeva un ensemble di modelli di ragionamento, tra cui GPT-5 e un modello sperimentale, che lavoravano insieme per generare e valutare soluzioni. Questo rappresenta un cambiamento fondamentale nel modo in cui i sistemi AI affrontano i problemi complessi: invece di cercare di risolvere tutto in un’unica passata, questi sistemi utilizzano il raffinamento iterativo, l’adattamento in tempo reale e metodi ensemble per migliorare progressivamente le soluzioni. Le implicazioni sono profonde: se i sistemi AI possono ora superare i migliori programmatori umani nella soluzione di problemi algoritmici nuovi e complessi, molte attività di knowledge work ritenute fino a ieri dominio umano potrebbero essere automatizzate o potenziate con assistenza AI. L’impresa è stata validata da esperti del settore come Scott Woo, CEO di Cognition ed ex campione di matematica, che ha sottolineato la straordinaria difficoltà dell’impresa. Mark Chen, Chief Research Officer di OpenAI, ha contestualizzato il risultato in una traiettoria più ampia delle capacità AI, sottolineando che l’intelligenza di base di questi modelli è ormai sufficiente—ciò che resta è costruire l’infrastruttura per distribuire efficacemente tali capacità.

Iscriviti alla nostra newsletter

Ricevi gratuitamente gli ultimi consigli, tendenze e offerte.

Se le capacità di ragionamento rappresentano una frontiera dell’AI, la distribuzione pratica dei sistemi AI richiede una solida infrastruttura per la gestione delle informazioni e del contesto. La Retrieval Augmented Generation (RAG) è emersa come tecnologia chiave per consentire ai sistemi AI di accedere e utilizzare fonti di conoscenza esterne, come documenti aziendali, articoli di ricerca o database proprietari. I sistemi RAG tradizionali affrontano una sfida fondamentale: man mano che cresce la quantità di informazioni recuperabili, il costo computazionale della ricerca e dell’elaborazione cresce notevolmente. I Super Intelligence Labs di Meta hanno affrontato questa sfida con ReRAG, una nuova ottimizzazione che migliora la velocità della RAG di 30 volte e consente di gestire contesti 16 volte più lunghi senza sacrificare l’accuratezza. L’innovazione funziona sostituendo la maggior parte dei token recuperati con embedding di chunk precomputati e riutilizzabili, cambiando radicalmente il modo in cui le informazioni vengono archiviate e recuperate. Invece di elaborare il testo grezzo ad ogni richiesta, il sistema utilizza embedding precomputati che catturano il significato semantico dei chunk, consentendo recuperi più rapidi e un uso più efficiente della finestra di contesto del modello.

Questa ottimizzazione ha implicazioni pratiche immediate per l’adozione dell’AI in azienda. Ora le aziende possono fornire ai propri sistemi AI l’accesso a basi di conoscenza enormi senza aumenti proporzionali di costi computazionali o latenza. Un AI per il customer service potrebbe consultare milioni di pagine di documentazione e rispondere in millisecondi. Un assistente alla ricerca potrebbe esaminare librerie intere di articoli scientifici e sintetizzare i risultati senza il sovraccarico computazionale che prima avrebbe reso questi compiti impraticabili. Il miglioramento di 30 volte è particolarmente importante perché trasforma la RAG da tecnica specialistica a approccio pratico di default per ogni sistema AI che deve accedere a informazioni esterne. In combinazione con l’aumento della lunghezza della finestra di contesto, ReRAG consente ai sistemi AI di mantenere una comprensione coerente su documenti molto più lunghi e gerarchie informative più complesse, essenziale per applicazioni come analisi legali, sintesi di ricerca scientifica e business intelligence approfondita.

FlowHunt e l’Orchestrazione dei Flussi di Lavoro AI

La convergenza di capacità AI avanzate—modelli di ragionamento, sistemi di recupero informativo e agenti autonomi—crea sia opportunità sia sfide per le organizzazioni che desiderano sfruttare queste tecnologie. Il vero valore nasce non dalle capacità AI singole, ma dalla loro orchestrazione in flussi di lavoro coerenti che risolvono problemi aziendali reali. FlowHunt risponde a questa esigenza offrendo una piattaforma per creare e gestire flussi di automazione AI complessi, collegando diversi strumenti, fonti dati e modelli in processi unificati. Prendiamo un esempio pratico: convertire notizie in contenuti per i social media. Questo compito apparentemente semplice richiede in realtà l’orchestrazione di più capacità AI e strumenti esterni. Il flusso inizia acquisendo l’URL della notizia e creando record nei sistemi di project management, attivando automaticamente processi paralleli per le diverse piattaforme social. Per ciascuna piattaforma, il flusso utilizza AI per generare headline specifiche, recupera asset aggiuntivi tramite scraping web, crea immagini di copertina personalizzate con sovrapposizioni di testo e infine pubblica i contenuti sulle piattaforme di programmazione. Ogni passaggio coinvolge strumenti e modelli AI differenti che lavorano in concerto, con l’output di uno che alimenta il successivo.

Questo tipo di orchestrazione sta diventando sempre più essenziale man mano che le capacità AI si moltiplicano. Invece di sviluppare integrazioni su misura per ogni combinazione di strumenti e modelli, piattaforme come FlowHunt forniscono l’infrastruttura per uno sviluppo e una distribuzione rapida dei flussi. L’integrazione con oltre 8.000 strumenti significa che praticamente ogni processo aziendale può essere automatizzato combinando strumenti esistenti e funzionalità AI. Questo democratizza l’automazione AI, consentendo anche a organizzazioni senza team di ingegneria AI di creare flussi sofisticati. Man mano che gli agenti AI diventano più autonomi e capaci, la capacità di orchestrare le loro attività, gestire le interazioni con sistemi esterni e garantire che i risultati siano in linea con le esigenze aziendali diventa sempre più critica. L’approccio di FlowHunt, che unisce builder visuali a capacità di orchestrazione AI, lo posiziona come layer infrastrutturale strategico nella nascente economia guidata dall’AI.

L’Emersione dell’Infrastruttura per Agenti Autonomi

Oltre alle singole capacità AI, il 2025 vede l’emergere di infrastrutture specificamente progettate per consentire agli agenti autonomi di interagire tra loro e con sistemi esterni. L’annuncio di Google dell’Agent Payment Protocol (AP2) rappresenta una pietra miliare importante in questa evoluzione. Partendo dal precedente protocollo Agent-to-Agent, che permetteva la comunicazione tra agenti, AP2 ne estende le capacità includendo le transazioni finanziarie. Il protocollo offre un linguaggio comune per transazioni sicure e conformi tra agenti e commercianti, aprendo la strada a una nuova classe di attività economica autonoma. Immagina un agente AI che gestisce le operazioni aziendali e che può acquistare autonomamente servizi, negoziare contratti e gestire rapporti con i fornitori senza intervento umano. Oppure pensa all’ottimizzazione della supply chain dove agenti AI di aziende diverse possono transare tra loro per ottimizzare scorte, prezzi e consegne in tempo reale.

Il protocollo ha già attirato partner tecnologici e aziendali di rilievo come Adobe, Accenture, OnePassword, Intuit, Red Hat, Salesforce e Okta. Questo sostegno indica che le transazioni agent-to-agent non sono una capacità futuristica speculativa, ma una realtà emergente che le imprese stanno integrando nelle operazioni. Le implicazioni vanno oltre le semplici transazioni: AP2 abilita la formazione di reti di agenti in cui sistemi autonomi possono collaborare, competere e coordinarsi per raggiungere obiettivi complessi. Un agente AI nel manufacturing potrebbe procurare materie prime da agenti fornitori, coordinare la logistica con altri agenti e gestire i pagamenti tramite il protocollo, tutto senza intervento umano. Ciò rappresenta un cambiamento fondamentale nell’organizzazione dei processi aziendali, passando da flussi di lavoro guidati dall’uomo a ecosistemi coordinati dagli agenti in cui i sistemi AI operano con crescente autonomia entro parametri definiti.

Il raggiungimento di prestazioni sovrumane nella programmazione competitiva rientra in un trend più ampio di sistemi AI che eguagliano o superano le prestazioni umane in domini sempre più complessi. Il risultato ICPC si aggiunge a traguardi precedenti come il sesto posto alle International Olympiad in Informatics (IOI), la medaglia d’oro alle International Mathematical Olympiad (IMO) e il secondo posto all’AtCoder Heuristic Contest. Questa progressione dimostra che le capacità di ragionamento AI non sono limitate a domini ristretti, ma si stanno generalizzando su diversi tipi di problem-solving complesso. Le implicazioni per il lavoro intellettuale sono notevoli: se i sistemi AI possono risolvere problemi di programmazione nuovi che richiedono comprensione algoritmica profonda, possono probabilmente assistere o automatizzare molte altre attività di knowledge work con schemi di ragionamento simili.

Tuttavia è importante contestualizzare questi risultati nel panorama più ampio dello sviluppo AI. Come ha sottolineato Mark Chen, l’intelligenza di base di questi modelli è ormai sufficiente per molte attività; ciò che resta è costruire infrastrutture e processi per distribuire efficacemente queste capacità. Questa impalcatura include non solo infrastrutture tecniche come sistemi RAG e protocolli agentici, ma anche processi organizzativi, misure di sicurezza e framework di integrazione che permettano di usare l’AI in modo responsabile e efficace nelle strutture aziendali e sociali esistenti. La prossima fase dello sviluppo AI sarà probabilmente meno focalizzata sul miglioramento della capacità grezza e più sulla distribuzione pratica, l’integrazione e l’orchestrazione delle capacità esistenti.

Intelligenza Spaziale e Generazione di Mondi 3D

Se ragionamento e infrastruttura agentica rappresentano una frontiera dello sviluppo AI, l’intelligenza spaziale ne rappresenta un’altra. World Labs, fondata da Fei-Fei Li, sta guidando lo sviluppo dei Large World Models (LWM) in grado di generare e comprendere ambienti tridimensionali. La tecnologia di World Labs parte da una singola immagine e genera un intero mondo 3D interattivo che gli utenti possono esplorare e attraversare. Questo rappresenta un avanzamento fondamentale nella comprensione e rappresentazione spaziale da parte dell’AI. Invece di trattare le immagini come dati 2D statici, questi sistemi costruiscono modelli 3D coerenti che mantengono la consistenza mentre l’utente si muove nello spazio. I mondi generati includono dettagli ambientali, illuminazione e ombre realistiche e fisica naturale, offrendo esperienze immersive e coerenti.

Le applicazioni di questa tecnologia vanno ben oltre l’intrattenimento e la visualizzazione. In architettura e pianificazione urbana, i progettisti potrebbero generare ambienti 3D completi a partire da schizzi concettuali, permettendo agli stakeholder di esplorare e valutare i progetti prima della costruzione. In ambito educativo, gli studenti potrebbero esplorare siti storici, ambienti scientifici o sistemi complessi in spazio 3D immersivo. Nella formazione e simulazione, le organizzazioni potrebbero creare ambienti realistici per scenari di training senza i costi e la complessità delle strutture fisiche. La tecnologia ha anche implicazioni per la robotica e i sistemi autonomi: se l’AI può generare modelli 3D coerenti degli ambienti, può comprendere meglio le relazioni spaziali e pianificare i movimenti in spazi complessi. Con la maturazione e la maggiore accessibilità, questa tecnologia diventerà probabilmente uno strumento standard per visualizzazione, progettazione e simulazione in numerosi settori.

Agenti AI Open-Source e Benchmark Competitivi

Il panorama competitivo delle capacità AI si sta intensificando, con diverse organizzazioni impegnate nello sviluppo di sistemi avanzati di ragionamento e di agenti. Tongyi DeepResearch di Alibaba rappresenta un importante contributo open-source, raggiungendo prestazioni all’avanguardia su diversi benchmark con soli 30 miliardi di parametri, di cui solo 3 miliardi attivi in inferenza. Questa efficienza è notevole: il sistema ottiene risultati paragonabili a modelli proprietari molto più grandi usando una frazione delle risorse computazionali. Il sistema totalizza 32,9 su Humanity’s Last Exam, 45,3 su BrowseComp e 75 su XBench Deep Research, dimostrando ottime performance su compiti di ragionamento e ricerca diversificati.

La natura open-source di Tongyi DeepResearch è particolarmente rilevante perché democratizza l’accesso alle capacità AI più avanzate. Invece di essere limitati ad aziende con risorse per addestrare modelli proprietari enormi, ricercatori e sviluppatori possono ora lavorare con sistemi di ragionamento d’avanguardia. L’approccio tecnico alla base di Tongyi DeepResearch prevede una nuova strategia automatica di generazione dati multi-stadio per produrre grandi quantità di dati agentici di alta qualità senza costosi processi di annotazione umana. Questo risolve una delle principali sfide nello sviluppo AI: la necessità di grandi quantità di dati di addestramento di alta qualità. Automatizzando la generazione dei dati, Tongyi DeepResearch dimostra che è possibile raggiungere prestazioni all’avanguardia senza i massicci sforzi di annotazione che storicamente erano necessari.

Investimenti e Scalabilità dell’Infrastruttura AI

L’avanzamento rapido delle capacità AI sta guidando massicci investimenti nell’infrastruttura, soprattutto in capacità dei data center e hardware specializzato. GRQ, produttore di chip AI, ha raccolto 750 milioni di dollari in un round di finanziamento che valuta l’azienda 6,9 miliardi post-money, con piani di espansione dei data center anche nell’Asia-Pacifico. Il round, guidato da Disruptive e con la partecipazione di investitori come BlackRock e Neuberger Berman, riflette la forte competizione per la capacità di inferenza e il riconoscimento che l’infrastruttura AI sarà un collo di bottiglia critico nei prossimi anni. La domanda di capacità di inferenza—le risorse computazionali necessarie per eseguire i modelli AI addestrati—sta spingendo aziende come Nvidia, GRQ e Cerebras ad aumentare la produzione il più rapidamente possibile.

Questa espansione infrastrutturale è essenziale per realizzare il potenziale delle capacità AI avanzate. Modelli di ragionamento, large language model e agenti autonomi richiedono risorse computazionali significative per operare. Con la diffusione di questi sistemi, la domanda di capacità di inferenza aumenterà ulteriormente. L’investimento in infrastruttura non è speculativo: riflette la realtà di aziende che già distribuiscono sistemi AI su larga scala e necessitano di infrastrutture affidabili e scalabili. L’espansione geografica verso l’Asia-Pacifico riflette la natura globale dell’adozione AI e la necessità di risorse distribuite per offrire latenze accettabili e conformità alle normative locali sui dati.

Tendenze Emergenti nello Sviluppo di Modelli AI

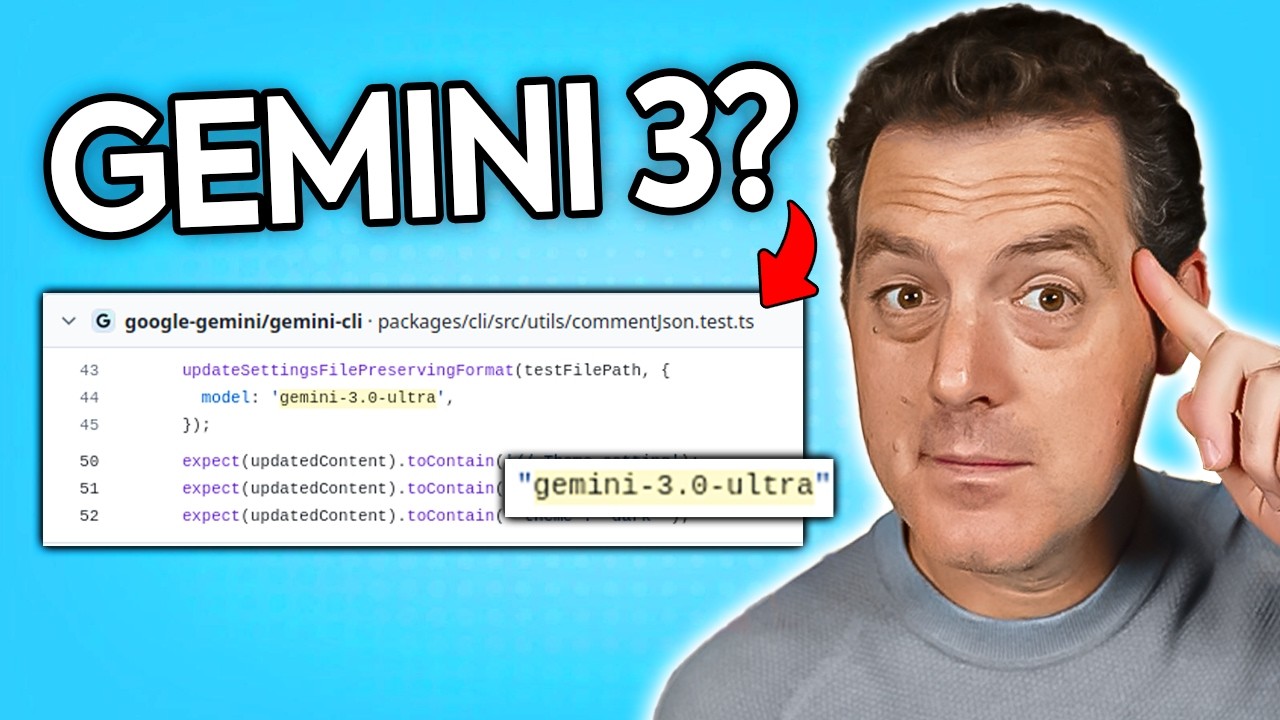

Il panorama competitivo dei modelli AI si sta evolvendo rapidamente, con diverse organizzazioni che perseguono approcci differenti all’avanzamento delle capacità. Lo sviluppo, secondo rumor, di Gemini 3.0 Ultra, individuato nel repository Gemini CLI di Google, suggerisce che sia in arrivo una nuova generazione del modello di ragionamento di punta di Google. La scoperta di riferimenti a Gemini 3.0 Ultra in codice appena aggiornato indica che i grandi rilasci sono spesso preceduti da cambiamenti infrastrutturali e lavoro di preparazione. Il pattern di versioning e rilascio suggerisce che possiamo aspettarci aggiornamenti regolari ai principali sistemi AI, con ogni generazione che porta incrementi—talvolta significativi—nelle capacità.

L’annuncio di Elon Musk dell’imminente addestramento di Grok 5 indica che anche xAI sta potenziando le proprie capacità di ragionamento. Resta in parte ambiguo cosa costituisca un incremento di versione importante nei modelli AI—se rappresenti un nuovo addestramento, cambiamenti architetturali sostanziali o soglie di capacità—ma il trend è chiaro: molte organizzazioni stanno investendo pesantemente nello sviluppo di modelli di ragionamento avanzati e possiamo aspettarci rilasci regolari di nuove versioni sempre più potenti. Questa dinamica competitiva è vantaggiosa per l’ecosistema AI nel suo complesso, poiché la competizione stimola l’innovazione e impedisce che un’unica organizzazione detenga il monopolio sulle capacità più avanzate.

Veicoli Autonomi e Distribuzione AI nel Mondo Reale

Sebbene gran parte della discussione sull’AI si concentri su modelli di ragionamento e infrastrutture agentiche, la distribuzione reale dei sistemi AI sta progredendo rapidamente in settori come i veicoli autonomi. L’approvazione del permesso pilota di Waymo per operare corse autonome all’aeroporto internazionale di San Francisco rappresenta una pietra miliare importante nella commercializzazione dei veicoli autonomi. L’approccio graduale, che parte dalle operazioni aeroportuali per poi espandersi, riflette la cautela necessaria per distribuire sistemi AI critici per la sicurezza in ambienti reali. La concorrenza di altre aziende come Zoox (di proprietà Amazon) dimostra che diversi attori stanno facendo progressi notevoli in questo campo.

La diffusione di veicoli autonomi in hub di trasporto come SFO è significativa perché rappresenta il passaggio da ambienti di test controllati a operazioni reali con clienti veri. L’ambiente aeroportuale, pur essendo più controllato rispetto a quello urbano, presenta sfide reali come variabilità meteorologica, traffico complesso e interazione con guidatori e pedoni. Il successo in questo contesto dimostra che la tecnologia dei veicoli autonomi è maturata al punto da operare in condizioni reali. Man mano che questi sistemi accumulano esperienza e dati operativi, continueranno a migliorare, consentendo col tempo una diffusione più ampia anche in ambienti urbani complessi.

Integrazione delle Capacità AI nei Processi Aziendali

La convergenza di capacità AI avanzate, infrastruttura agentica e piattaforme di automazione permette alle organizzazioni di integrare l’AI nei processi aziendali principali come mai prima. L’esempio pratico della conversione di notizie in contenuti social, apparentemente semplice, evidenzia la complessità dell’automazione AI reale. Il flusso richiede il coordinamento di più modelli AI (per generare headline e immagini), strumenti esterni (per scraping e programmazione contenuti) e logiche di business (per formattazione e tempistiche specifiche per piattaforma). L’implementazione di questi flussi richiede non solo singole capacità AI, ma anche piattaforme di orchestrazione che gestiscano le interazioni tra i diversi componenti.

L’approccio di FlowHunt, che offre builder visuali e capacità di orchestrazione AI, risponde a questa esigenza. Astrazionando la complessità tecnica dell’integrazione di strumenti e modelli diversi, queste piattaforme consentono agli utenti business di creare workflow automatizzati sofisticati senza competenze ingegneristiche AI specialistiche. Con l’aumentare delle capacità AI, l’abilità di orchestrare questi strumenti in processi aziendali coerenti diventa sempre più preziosa. Le organizzazioni che sanno integrare efficacemente l’AI nei propri flussi otterranno vantaggi competitivi in termini di efficienza, costi ridotti e rapidità di lancio sul mercato di nuovi prodotti e servizi.

Il Futuro dell’Automazione Potenziata dall’AI

Gli sviluppi analizzati in questo articolo indicano un futuro in cui i sistemi AI sono profondamente integrati nei processi aziendali e nella vita quotidiana. Invece di essere uno strumento specialistico per compiti specifici, l’AI diventa l’approccio di default per automatizzare e ottimizzare i workflow. Agenti autonomi si coordinano tra loro per gestire processi aziendali complessi. Sistemi AI con capacità di ragionamento avanzato risolvono problemi inediti e prendono decisioni strategiche. AI indossabile fornisce informazioni e assistenza in tempo reale. L’intelligenza spaziale abilita nuove forme di visualizzazione e simulazione. Questo futuro non è speculativo—le tecnologie che lo rendono possibile sono già in fase di distribuzione e perfezionamento.

Il ruolo di piattaforme come FlowHunt diventa sempre più cruciale in questo contesto. Con il moltiplicarsi e il potenziamento delle capacità AI, la possibilità di orchestrare queste capacità in workflow coerenti diventa un vantaggio competitivo chiave. Le organizzazioni che sapranno integrare efficacemente l’AI saranno meglio posizionate a competere in una economia sempre più guidata dall’automazione intelligente. Gli investimenti infrastrutturali di aziende come GRQ, i contributi open-source di realtà come Alibaba e le piattaforme commerciali come FlowHunt contribuiscono tutti a rendere le capacità AI avanzate più accessibili e pratiche per la distribuzione nel mondo reale.

Conclusione

Il panorama AI nel 2025 è caratterizzato da un avanzamento rapido su più fronti—dall’hardware indossabile che aumenta la percezione umana ai modelli di ragionamento che superano le prestazioni umane, dall’infrastruttura che abilita transazioni autonome tra agenti ai sistemi di intelligenza spaziale che generano ambienti 3D immersivi. Questi sviluppi non sono risultati isolati ma progressi interconnessi che rappresentano un cambiamento fondamentale nel modo in cui l’AI viene distribuita e integrata in azienda e nella società. La convergenza di queste capacità, abilitata da piattaforme di orchestrazione e sostenuta da massicci investimenti infrastrutturali, sta creando le basi per un futuro guidato dall’AI in cui i sistemi autonomi gestiscono compiti sempre più complessi con minimo intervento umano. Le organizzazioni e gli individui che comprenderanno questi sviluppi e sapranno posizionarsi per sfruttarli saranno i meglio preparati a prosperare nella nuova economia guidata dall’intelligenza artificiale.