Perché la leadership nell’IA conta più che mai

Scopri perché la leadership nell’IA è essenziale per il successo organizzativo, come leader forti guidano la trasformazione dell’IA e come il Workshop di Leader...

La Guida KPMG ai Rischi e ai Controlli dell’IA offre alle organizzazioni un approccio strutturato ed etico alla gestione dei rischi dell’IA, supportando una diffusione responsabile e la conformità agli standard globali.

Questa prima statistica potrebbe risalire all’anno scorso, ma non potrebbe essere più attuale. Secondo il KPMG’s 2024 U.S. CEO Outlook, ben il 68% dei CEO ha identificato l’IA come una priorità di investimento. Contano su di essa per aumentare l’efficienza, migliorare le competenze della forza lavoro e stimolare l’innovazione nelle loro aziende.

È una grande dimostrazione di fiducia nell’IA — ma solleva anche una domanda importante: con così tanto in gioco, come possono le organizzazioni assicurarsi di utilizzare l’IA in modo responsabile ed etico?

Qui entra in gioco la Guida KPMG ai Rischi e ai Controlli dell’IA. Offre un framework chiaro e pratico per aiutare le aziende a sfruttare il potenziale dell’IA gestendo al contempo i rischi reali che comporta. Nel panorama attuale, costruire un’IA affidabile non è solo una buona pratica — è fondamentale per il business.

L’intelligenza artificiale (IA) sta rivoluzionando i settori, sbloccando nuovi livelli di efficienza, innovazione e competitività. Tuttavia, questa trasformazione porta con sé una serie specifica di rischi e sfide etiche che le organizzazioni devono gestire con attenzione per mantenere la fiducia e garantire un uso responsabile. La Guida KPMG ai Rischi e ai Controlli dell’IA è progettata per supportare le organizzazioni nella navigazione di queste complessità, fornendo un approccio pratico, strutturato e guidato dai valori alla governance dell’IA.

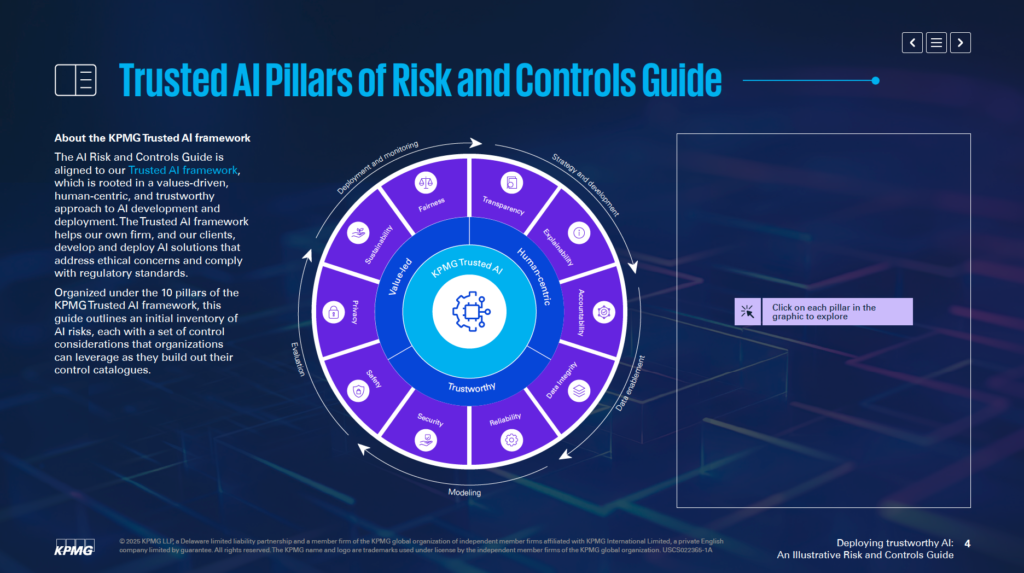

Allineata al Trusted AI Framework di KPMG, questa guida aiuta le aziende a sviluppare e implementare soluzioni IA etiche, incentrate sull’uomo e conformi agli standard regolamentari globali. È organizzata attorno a 10 pilastri fondamentali, ognuno dei quali affronta un aspetto critico della gestione dei rischi IA:

Focalizzandosi su questi pilastri, le organizzazioni possono integrare principi etici in ogni fase del ciclo di vita dell’IA—dalla strategia e sviluppo fino al deployment e monitoraggio. Questa guida non solo rafforza la resilienza ai rischi, ma promuove anche un’innovazione sostenibile, affidabile e in linea con le aspettative sociali.

Che tu sia un professionista del rischio, un leader esecutivo, un data scientist o un consulente legale, questa guida offre strumenti e approfondimenti essenziali per aiutarti a sfruttare responsabilmente la potenza dell’IA.

La Guida KPMG ai Rischi e ai Controlli dell’IA si propone come risorsa specializzata per aiutare le organizzazioni a gestire i rischi specifici legati all’intelligenza artificiale (IA). Riconosce che, nonostante l’enorme potenziale dell’IA, le sue complessità e le questioni etiche richiedono un approccio mirato alla gestione dei rischi. La guida fornisce un quadro strutturato per affrontare queste sfide in modo responsabile ed efficace.

La guida non intende sostituire i sistemi attuali, ma è pensata per integrare i processi di gestione del rischio esistenti. L’obiettivo principale è includere considerazioni specifiche dell’IA nelle strutture di governance dell’organizzazione, garantendo un allineamento fluido con le pratiche operative correnti. Questo approccio permette di rafforzare le capacità di gestione del rischio senza dover riprogettare completamente i framework esistenti.

La guida si basa sul Trusted AI framework di KPMG, che promuove un approccio guidato dai valori e incentrato sull’uomo all’IA. Integra principi derivati da standard ampiamente riconosciuti, tra cui ISO 42001, NIST AI Risk Management Framework e l’EU AI Act. Ciò garantisce che la guida sia pratica e in linea con le migliori pratiche globali e i requisiti regolatori per la governance dell’IA.

La guida offre insight concreti ed esempi pratici per affrontare i rischi legati all’IA. Invita le organizzazioni ad adattare questi esempi al proprio contesto, considerando variabili come la realizzazione interna o tramite fornitori dei sistemi IA, oltre ai tipi di dati e alle tecniche utilizzate. Questa adattabilità assicura la rilevanza della guida per diversi settori e applicazioni IA.

La guida si concentra sull’abilitare le organizzazioni a implementare tecnologie IA in modo sicuro, etico e trasparente. Affrontando aspetti tecnici, operativi ed etici dei rischi legati all’IA, aiuta a costruire fiducia tra gli stakeholder sfruttando al meglio le capacità trasformative dell’IA.

La guida agisce come risorsa per assicurare che i sistemi IA siano allineati agli obiettivi di business, mitigando al tempo stesso i rischi potenziali. Supporta l’innovazione in modo che la responsabilità e l’accountability siano sempre prioritarie.

La Guida KPMG alla Governance dell’IA è pensata per i professionisti che gestiscono l’implementazione dell’IA, assicurando che venga adottata in modo sicuro, etico ed efficace. Si applica a team di diversi ambiti aziendali, tra cui:

I dirigenti C-suite e i leader senior, come CEO, CIO e CTO, troveranno utile questa guida per gestire l’IA come priorità strategica. Secondo il KPMG’s 2024 US CEO Outlook, il 68% dei CEO considera l’IA un’area chiave di investimento. La guida consente alla leadership di allineare le strategie IA agli obiettivi organizzativi, affrontando al contempo i rischi connessi.

Ingegneri software, data scientist e altri responsabili della creazione e della diffusione di soluzioni IA possono utilizzare la guida per integrare direttamente principi etici e controlli robusti nei loro sistemi. Il focus è sull’adattare le pratiche di gestione del rischio all’architettura specifica e ai flussi di dati dei modelli IA.

La guida è adattabile sia per chi sviluppa sistemi IA in house, sia per chi li acquisisce da fornitori esterni, sia per chi utilizza dataset proprietari. È particolarmente rilevante per settori come finanza, sanità e tecnologia, dove le applicazioni IA avanzate e i dati sensibili sono elementi cruciali per le operazioni.

Diffondere l’IA senza un framework di governance chiaro può portare a rischi finanziari, regolatori e reputazionali. La guida KPMG lavora con i processi esistenti per fornire un approccio strutturato ed etico alla gestione dell’IA. Promuove responsabilità, trasparenza e pratiche etiche, aiutando le organizzazioni a utilizzare l’IA in modo responsabile e a sbloccarne il potenziale.

Le organizzazioni dovrebbero iniziare collegando i rischi specifici dell’IA alla propria tassonomia dei rischi. Una tassonomia dei rischi è un framework strutturato per identificare, organizzare e affrontare le vulnerabilità potenziali. Poiché l’IA introduce sfide uniche, le tassonomie tradizionali devono essere ampliate per includere fattori specifici dell’IA, come l’accuratezza dei flussi di dati, la logica degli algoritmi e l’affidabilità delle fonti dati. Così facendo, i rischi IA diventano parte degli sforzi di risk management dell’organizzazione e non vengono trattati separatamente.

La guida sottolinea la necessità di valutare tutto il ciclo di vita dei sistemi IA. È importante esaminare da dove provengono i dati, come vengono processati e la logica alla base del modello IA. Questa visione d’insieme aiuta a individuare dove possono sorgere vulnerabilità durante lo sviluppo e l’utilizzo dell’IA.

I sistemi IA variano in base allo scopo, ai metodi di sviluppo e al tipo di dati utilizzati. Se un modello viene creato internamente o acquisito da un fornitore esterno incide molto sui rischi. Inoltre, il tipo di dati—proprietari, pubblici o sensibili—insieme alle tecniche di sviluppo IA, richiede strategie di gestione del rischio personalizzate.

La guida suggerisce di adattare le misure di controllo alle esigenze specifiche dei sistemi IA. Ad esempio, chi utilizza dati proprietari può aver bisogno di controlli di accesso più severi. Al contrario, l’adozione di sistemi IA da fornitori esterni può richiedere valutazioni approfondite dei rischi di terze parti. Personalizzare questi controlli permette di affrontare in modo più efficace le sfide specifiche dei propri sistemi IA.

La guida raccomanda di incorporare le pratiche di risk management in ogni fase del ciclo di vita dell’IA. Ciò include la pianificazione dei rischi già nella fase di progettazione, l’implementazione di solidi sistemi di monitoraggio durante il deployment e la revisione periodica delle valutazioni di rischio man mano che il sistema IA evolve. Affrontando i rischi in ogni fase, si riducono le vulnerabilità e si garantisce che i sistemi IA siano etici e affidabili.

Compiere il primo passo di allineare i rischi IA alla tassonomia esistente e personalizzare i controlli secondo le proprie esigenze permette di gettare le basi per un’IA affidabile. Questi sforzi consentono alle organizzazioni di identificare, valutare e gestire i rischi in modo sistematico, costruendo un solido framework di governance dell’IA.

Il Trusted AI Framework di KPMG si fonda su dieci pilastri chiave che affrontano le sfide etiche, tecniche e operative dell’intelligenza artificiale. Questi pilastri guidano le organizzazioni nella progettazione, sviluppo e diffusione responsabile dei sistemi IA, garantendo fiducia e accountability lungo tutto il ciclo di vita dell’IA.

La supervisione e la responsabilità umana devono essere presenti in ogni fase del ciclo di vita dell’IA. Ciò significa stabilire chiaramente chi è responsabile della gestione dei rischi IA, assicurare la conformità a leggi e regolamenti e mantenere la possibilità di intervenire, annullare o invertire le decisioni dell’IA se necessario.

I sistemi IA dovrebbero puntare a ridurre o eliminare i bias che potrebbero avere impatti negativi su individui, comunità o gruppi. Questo comporta un’attenta analisi dei dati per garantire rappresentatività delle diverse popolazioni, l’applicazione di misure di equità in fase di sviluppo e il monitoraggio continuo dei risultati per promuovere trattamenti equi.

La trasparenza implica condividere apertamente il funzionamento dei sistemi IA e le motivazioni delle decisioni prese. Questo include la documentazione dei limiti del sistema, dei risultati delle performance e dei metodi di test. Gli utenti devono essere informati quando i loro dati vengono raccolti, i contenuti generati da IA devono essere etichettati chiaramente e le applicazioni sensibili come la categorizzazione biometrica devono fornire notifiche chiare all’utente.

I sistemi IA devono fornire motivazioni comprensibili delle proprie decisioni. Per raggiungere questo obiettivo, le organizzazioni dovrebbero documentare in modo dettagliato dataset, algoritmi e metriche di performance, consentendo agli stakeholder di analizzare e riprodurre efficacemente i risultati.

La qualità e l’affidabilità dei dati durante tutto il ciclo di vita—raccolta, etichettatura, archiviazione e analisi—sono fondamentali. Occorrono controlli per gestire rischi come la corruzione o i bias dei dati. Verifiche periodiche della qualità e regression test durante gli aggiornamenti di sistema aiutano a mantenere accuratezza e affidabilità dei sistemi IA.

Le soluzioni IA devono rispettare le leggi sulla privacy e la protezione dei dati. Le organizzazioni devono gestire correttamente le richieste degli interessati, condurre valutazioni di impatto privacy e utilizzare metodi avanzati come la privacy differenziale per bilanciare l’utilità dei dati con la protezione della privacy degli individui.

I sistemi IA devono funzionare in modo coerente rispetto agli obiettivi e all’accuratezza richiesta. Questo richiede test approfonditi, meccanismi per rilevare anomalie e feedback loop continui per validare gli output.

Le misure di safety proteggono i sistemi IA dal causare danni a persone, aziende o proprietà. Includono la progettazione di fail-safe, il monitoraggio di problemi come data poisoning o prompt injection e l’allineamento dei sistemi a standard etici e operativi.

Pratiche di sicurezza solide sono necessarie per proteggere i sistemi IA da minacce e attività malevole. Le organizzazioni dovrebbero condurre audit regolari, vulnerability assessment e utilizzare crittografia per proteggere i dati sensibili.

I sistemi IA devono essere progettati per minimizzare l’uso di energia e supportare gli obiettivi ambientali. Le considerazioni di sostenibilità vanno incluse fin dalla progettazione, monitorando costantemente consumi, efficienza ed emissioni lungo tutto il ciclo di vita dell’IA.

Seguendo questi dieci pilastri, le organizzazioni possono creare sistemi IA etici, affidabili e in linea con le aspettative sociali. Questo framework offre una struttura chiara per gestire le sfide dell’IA promuovendo un’innovazione responsabile.

L’integrità dei dati è essenziale per garantire che i sistemi IA restino accurati, equi e affidabili. Una cattiva gestione dei dati può portare a rischi come bias, inaccuratezza e risultati inaffidabili. Questi problemi possono indebolire la fiducia negli output dell’IA e causare gravi conseguenze operative e reputazionali. Il framework Trusted AI di KPMG sottolinea l’importanza di mantenere dati di alta qualità lungo tutto il ciclo di vita per assicurare il corretto funzionamento e il rispetto degli standard etici dei sistemi IA.

Senza una solida governance dei dati, i sistemi IA possono produrre risultati errati. Problemi come dati incompleti, inaccurati o irrilevanti possono portare a output bias o inaffidabili, aumentando i rischi in diverse applicazioni IA.

I dati spesso passano tra sistemi per attività come training, test o operazioni. Se questi trasferimenti non vengono gestiti correttamente, i dati possono essere corrotti, persi o degradati. Questo può influenzare le performance dei sistemi IA.

Per migliorare la governance dei dati, le organizzazioni possono:

Per ridurre i rischi durante i trasferimenti di dati, le organizzazioni dovrebbero:

L’utilizzo di sistemi di monitoraggio continuo aiuta a mantenere l’integrità dei dati lungo tutto il ciclo di vita dell’IA. Questi sistemi sono in grado di rilevare problemi come cambiamenti inattesi nella qualità dei dati o incoerenze nella gestione degli stessi, consentendo azioni correttive tempestive in caso di criticità.

Mantenere l’integrità dei dati è fondamentale per diffondere sistemi IA affidabili. Le organizzazioni possono ridurre i rischi istituendo framework di governance solidi, proteggendo le interazioni sui dati e mantenendo processi di validazione continui. Queste azioni migliorano l’affidabilità degli output IA, garantendo il rispetto degli standard etici e operativi e contribuendo a costruire fiducia nelle tecnologie IA.

Gestire le richieste relative all’accesso degli interessati ai dati è una delle principali sfide di privacy nell’IA. Le organizzazioni devono garantire che le persone possano esercitare i propri diritti di accesso, rettifica o cancellazione delle informazioni personali secondo normative come GDPR e CCPA. Se queste richieste non vengono gestite correttamente, si rischiano violazioni regolamentari, perdita di fiducia dei consumatori e danni reputazionali.

Per ridurre questo rischio, le aziende dovrebbero creare programmi per informare le persone sui loro diritti in materia di dati durante l’interazione con l’IA. I sistemi devono essere predisposti per processare queste richieste in modo rapido e trasparente. È importante anche mantenere registri dettagliati delle procedure adottate per rispondere alle richieste, così da dimostrare la conformità durante gli audit.

I sistemi IA trattano spesso informazioni personali sensibili, il che li rende bersagli appetibili per attacchi informatici. In caso di violazione, possono scattare sanzioni regolatorie, danni reputazionali e perdita di fiducia dei clienti.

Per contrastare questo rischio, il framework Trusted AI KPMG suggerisce revisioni etiche sui sistemi IA che usano dati personali, assicurando la conformità alle norme privacy. Sono necessari audit regolari e valutazioni di impatto privacy (PIA), soprattutto quando dati sensibili vengono utilizzati per l’addestramento dei modelli IA. Inoltre, metodi come la privacy differenziale, che aggiunge rumore statistico ai dati, possono aiutare ad anonimizzare le informazioni pur consentendo l’analisi.

I sistemi IA che non integrano meccanismi di privacy fin dalla progettazione possono creare problemi seri. Senza l’applicazione di principi di privacy by design, le organizzazioni rischiano di esporre dati sensibili o di non rispettare i requisiti di legge.

Le aziende dovrebbero includere misure di privacy già nelle fasi di sviluppo dei sistemi IA. Questo comporta l’aderenza alle normative su privacy e protezione dei dati tramite solide pratiche di data management. È essenziale documentare chiaramente come i dati vengono raccolti, utilizzati e conservati. Le organizzazioni devono anche ottenere il consenso esplicito degli utenti per la raccolta e l’utilizzo dei dati, soprattutto in ambiti delicati come i dati biometrici.

Quando i sistemi IA non spiegano chiaramente come vengono gestiti i dati degli utenti, possono sorgere diffidenza e scrutinio legale. Gli utenti devono sapere quando i loro dati vengono raccolti e come vengono utilizzati

La Guida KPMG ai Rischi e ai Controlli dell’IA è un framework pratico progettato per aiutare le organizzazioni a gestire i rischi specifici dell’intelligenza artificiale, garantendo una diffusione responsabile, etica e conforme dell’IA in tutti i settori.

La guida si basa su dieci pilastri chiave: Responsabilità, Equità, Trasparenza, Spiegabilità, Integrità dei dati, Affidabilità, Sicurezza, Safety, Privacy e Sostenibilità—ognuno affronta aspetti fondamentali della gestione dei rischi IA.

La guida è pensata per professionisti del rischio, team di compliance, specialisti di cybersecurity, consulenti legali, dirigenti, sviluppatori ed ingegneri IA e organizzazioni di ogni dimensione che vogliono gestire l’IA in modo responsabile.

Si allinea a standard globali come ISO 42001, NIST AI Risk Management Framework e l’EU AI Act, aiutando le organizzazioni a integrare controlli specifici per l’IA nei processi di governance esistenti e a soddisfare i requisiti normativi.

Suggerisce misure come una solida governance dei dati, privacy by design, monitoraggio continuo, trasparenza nelle decisioni IA, rilevamento delle anomalie, feedback loop e obiettivi di sostenibilità per ridurre i rischi legati all’IA.

Scopri come la Guida KPMG ai Rischi e ai Controlli dell’IA può aiutare la tua organizzazione ad abbracciare l’innovazione dell’IA assicurando un’implementazione etica, sicura e conforme.

Scopri perché la leadership nell’IA è essenziale per il successo organizzativo, come leader forti guidano la trasformazione dell’IA e come il Workshop di Leader...

Scopri le 18 migliori piattaforme AI del 2025, le loro funzionalità, i casi d’uso e i consigli su come scegliere quella giusta per le esigenze della tua azienda...

L’uso improprio dell’AI sul lavoro non è un problema dei dipendenti, ma una crisi di leadership. Scopri perché i dipendenti ricorrono all’AI di nascosto, quali ...

Consenso Cookie

Usiamo i cookie per migliorare la tua esperienza di navigazione e analizzare il nostro traffico. See our privacy policy.