Esempi di Server MCP: Costruire Integrazioni Intelligenti per Agenti AI

Esplora esempi completi di server MCP e scopri come costruire, distribuire e integrare server Model Context Protocol per potenziare le capacità degli agenti AI ...

Scopri cosa sono i server MCP (Model Context Protocol), come funzionano e perché stanno rivoluzionando l’integrazione dell’IA. Scopri come MCP semplifica il collegamento tra agenti AI, strumenti, fonti di dati e API.

La rapida evoluzione dell’intelligenza artificiale ha creato una domanda senza precedenti di integrazione fluida tra modelli AI e sistemi esterni. Tuttavia, sviluppatori e aziende si sono a lungo scontrati con una sfida fondamentale: collegare molteplici modelli di linguaggio di grandi dimensioni (LLM) a numerosi strumenti, API e fonti di dati richiede la creazione e la manutenzione di innumerevoli integrazioni personalizzate. Questa complessità ha ostacolato lo sviluppo di agenti AI realmente capaci di accedere a informazioni reali e di compiere azioni significative. Ecco che arriva il Model Context Protocol (MCP): uno standard rivoluzionario open-source che cambia radicalmente il modo in cui le applicazioni AI si connettono con il mondo circostante. In questa guida completa, esploreremo cosa sono i server MCP, come funzionano, perché sono importanti e come stanno trasformando il panorama dell’automazione e dell’integrazione AI.

Il Model Context Protocol rappresenta un cambio di paradigma nel modo in cui i sistemi di intelligenza artificiale interagiscono con dati e strumenti esterni. Alla base, MCP è uno standard open-source che fornisce un modo unificato e standardizzato per le applicazioni AI di collegarsi a sistemi esterni. Pensalo come un adattatore universale o, come viene spesso definito nel settore, una “porta USB-C per le applicazioni AI”. Proprio come la USB-C offre un connettore standard che funziona su innumerevoli dispositivi indipendentemente dal produttore, MCP offre un protocollo standardizzato che funziona su diversi modelli AI e sistemi esterni. Questa standardizzazione elimina la necessità di integrazioni personalizzate e uniche tra ogni LLM e ciascun strumento o fonte dati. Prima di MCP, gli sviluppatori affrontavano una crescita esponenziale della complessità man mano che aggiungevano nuovi modelli AI o sistemi esterni alle loro applicazioni. MCP semplifica radicalmente questa architettura creando un’unica interfaccia coerente che tutte le applicazioni AI e i sistemi esterni possono utilizzare per comunicare tra loro.

Il protocollo è stato sviluppato da Anthropic e rilasciato come iniziativa open-source per risolvere un punto dolente critico nell’ecosistema di sviluppo AI. Invece di costringere gli sviluppatori a reinventare la ruota per ogni nuova combinazione di modello AI e sistema esterno, MCP fornisce un framework standardizzato che riduce drasticamente i tempi di sviluppo, la manutenzione e la complessità delle integrazioni. Questo approccio ha riscontrato un forte consenso nella comunità degli sviluppatori perché riconosce una verità fondamentale: il futuro dell’AI non riguarda chatbot isolati, ma agenti intelligenti che possono accedere facilmente alle informazioni, interagire con i sistemi e svolgere azioni su tutto lo stack tecnologico di un’organizzazione.

Prima di approfondire il funzionamento di MCP, è essenziale comprendere il problema che risolve—una sfida che ha afflitto lo sviluppo AI sin dall’emergere dei potenti modelli linguistici. Questo problema è noto come “problema NxM”, dove N rappresenta il numero di diversi LLM disponibili e M rappresenta il numero di diversi strumenti, API e fonti di dati che le organizzazioni vogliono collegare a quei modelli. Senza un protocollo standardizzato, ogni LLM richiede codice di integrazione personalizzato per ogni strumento, risultando in N moltiplicato M punti di integrazione totali. Ciò crea una crescita esponenziale della complessità, sempre più difficile da gestire man mano che le organizzazioni espandono le iniziative AI.

Considera uno scenario pratico: un’azienda vuole usare sia Claude che ChatGPT per interagire con il proprio sito WordPress, workspace Notion, Google Calendar e database interno. Senza MCP, gli sviluppatori dovrebbero creare otto integrazioni separate—una per Claude verso WordPress, una per Claude verso Notion, una per Claude verso Google Calendar, una per Claude verso il database, e poi ripetere l’intero processo per ChatGPT. Ogni integrazione richiede codice personalizzato, test e manutenzione continua. Se in seguito l’organizzazione decide di aggiungere un terzo modello AI o una quinta fonte dati, il numero di integrazioni cresce esponenzialmente. Questa ridondanza crea diversi problemi critici: i team di sviluppo risolvono ripetutamente le stesse sfide di integrazione, la manutenzione diventa un incubo man mano che strumenti e API evolvono, e implementazioni incoerenti tra le varie integrazioni portano a comportamenti imprevedibili e a una pessima esperienza utente.

MCP risolve questo problema rompendo la relazione NxM. Invece di richiedere N×M integrazioni, MCP consente alle organizzazioni di costruire N+M connessioni. Ogni LLM si collega al protocollo MCP una sola volta, e ogni strumento o fonte dati si espone tramite un server MCP una sola volta. Questa relazione lineare riduce drasticamente la complessità e il carico di manutenzione. Quando un nuovo modello AI diventa disponibile, deve solo implementare il supporto MCP una volta per accedere a tutti i server MCP esistenti. Allo stesso modo, quando è necessario integrare un nuovo strumento o fonte dati, basta che esponga un’interfaccia server MCP per essere accessibile a tutte le applicazioni AI compatibili con MCP. Questa soluzione elegante ha profonde implicazioni su come le organizzazioni possono costruire e scalare la propria infrastruttura AI.

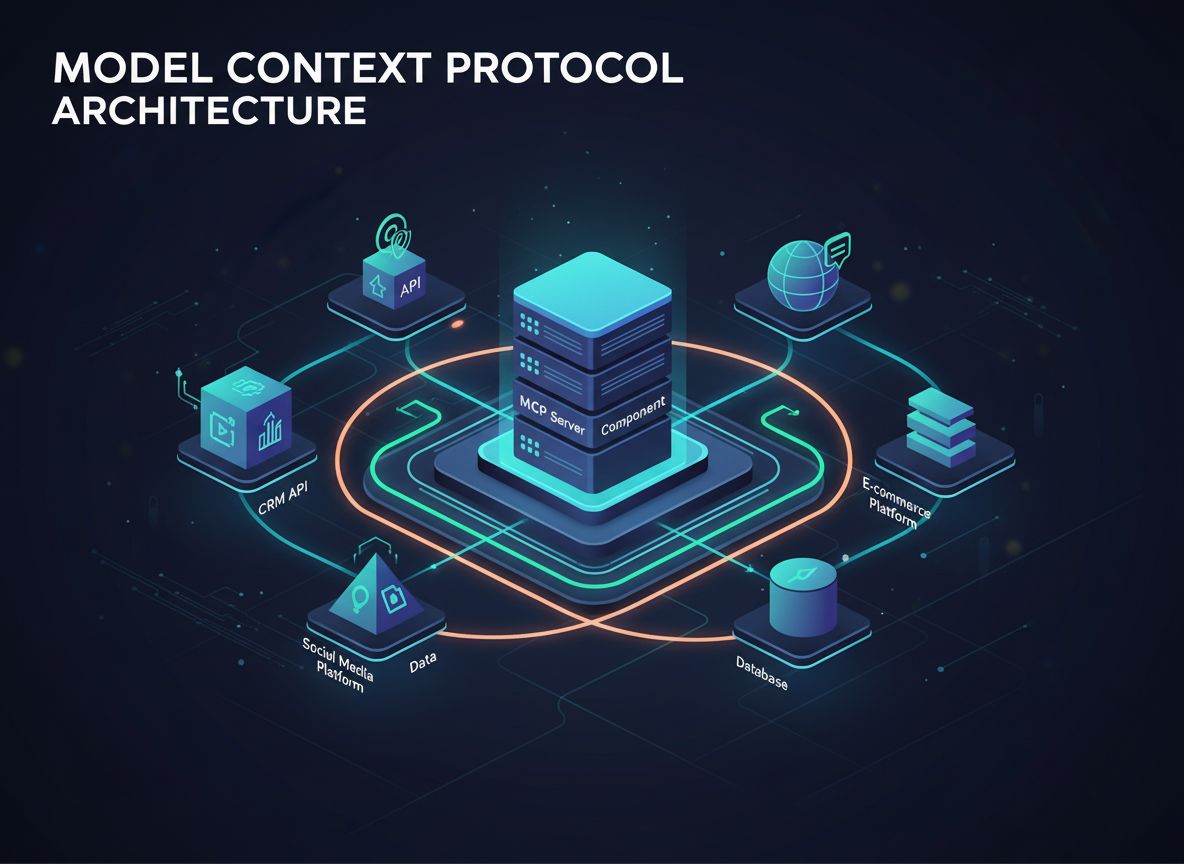

Un server MCP è fondamentalmente una raccolta di strumenti, API e knowledge base raggruppati sotto un’unica interfaccia standardizzata. Invece di richiedere a un agente AI di collegarsi a venti diversi endpoint API e gestire venti diversi schemi di autenticazione, un server MCP consolida tutto in un unico componente coerente. Questo approccio architetturale semplifica enormemente il processo di integrazione e rende gli agenti AI molto più efficienti nel trovare e utilizzare gli strumenti di cui hanno bisogno.

Per capire come funziona in pratica, considera un server MCP per WordPress. Invece che un agente AI debba conoscere e collegarsi ai vari endpoint REST API di WordPress per post, pagine, media, utenti, categorie, tag, commenti e plugin, il server MCP di WordPress espone tutte queste funzionalità tramite un’unica interfaccia. Il server MCP contiene molteplici strumenti—crea post, lista post, ottieni post, elimina post, crea pagina, lista pagine, e così via—ciascuno con un titolo e una descrizione chiara. Quando un agente AI deve eseguire un’azione, interroga il server MCP, che restituisce un elenco degli strumenti disponibili con le rispettive descrizioni. L’agente può quindi selezionare in modo intelligente lo strumento appropriato in base alla richiesta dell’utente ed eseguirlo senza dover comprendere la complessità delle API sottostanti.

L’architettura di MCP è composta da diversi elementi chiave che lavorano in sinergia. Innanzitutto, c’è il client MCP, tipicamente l’applicazione AI o l’agente che deve accedere a strumenti e dati esterni. Il client avvia le connessioni e formula richieste per strumenti e risorse. In secondo luogo, c’è il server MCP, che espone strumenti, risorse e funzionalità tramite l’interfaccia standardizzata MCP. Il server gestisce l’integrazione effettiva con i sistemi esterni e l’esecuzione degli strumenti. In terzo luogo, c’è il protocollo stesso, che definisce come client e server comunicano, incluso il formato delle richieste, delle risposte e la gestione degli errori. Questa architettura a tre parti crea una chiara separazione delle responsabilità che rende l’intero sistema più gestibile e scalabile.

Uno degli aspetti più eleganti del design MCP è il modo in cui gestisce la scoperta e l’esecuzione degli strumenti. Ogni strumento esposto tramite un server MCP include non solo lo strumento, ma anche i metadati—nome, descrizione, parametri e output attesi. Quando un agente AI si collega a un server MCP, riceve questi metadati, il che gli consente di capire quali strumenti sono disponibili e quando utilizzarli. Questo è fondamentalmente diverso rispetto all’integrazione API tradizionale, dove gli sviluppatori devono configurare manualmente ogni endpoint API e “insegnare” al modello AI le sue capacità. Con MCP, il processo di scoperta è automatico e standardizzato, rendendo molto più semplice per gli agenti AI trovare e utilizzare gli strumenti giusti per ogni compito.

FlowHunt riconosce il potenziale trasformativo dei server MCP nel panorama dell’automazione AI e offre un supporto completo per l’integrazione MCP nella propria piattaforma. Sfruttando i server MCP, FlowHunt consente agli utenti di costruire flussi di lavoro AI sofisticati che possono accedere facilmente a molteplici strumenti e fonti di dati senza la complessità tradizionale della configurazione manuale delle API. Questa integrazione rappresenta un avanzamento significativo nel modo in cui le organizzazioni possono automatizzare i processi aziendali tramite agenti AI.

All’interno di FlowHunt, gli utenti possono facilmente aggiungere server MCP ai propri flussi di lavoro, ottenendo accesso immediato a tutti gli strumenti e funzionalità esposte da quei server. Ad esempio, aggiungendo un server MCP per WordPress a un flusso FlowHunt, gli utenti ottengono subito la possibilità di creare post, gestire pagine, gestire media, gestire utenti e svolgere decine di altre operazioni WordPress—il tutto senza configurare manualmente ogni singolo endpoint API. Questo accelera drasticamente lo sviluppo dei flussi e riduce le barriere tecniche per la creazione di potenti automazioni AI. L’approccio di FlowHunt all’integrazione MCP dimostra come il protocollo stia abilitando una nuova generazione di piattaforme di automazione AI che danno priorità alla facilità d’uso e allo sviluppo rapido senza sacrificare potenza o flessibilità.

Il supporto della piattaforma per i server MCP va oltre il semplice accesso agli strumenti. FlowHunt permette agli utenti di concatenare più server MCP in flussi complessi, consentendo agli agenti AI di orchestrare azioni su più sistemi in risposta a richieste utente o trigger automatici. Questa capacità trasforma ciò che è possibile con l’automazione AI, permettendo scenari come la creazione automatica di post WordPress basati su contenuti generati da un agente AI, l’aggiornamento di database Notion con informazioni raccolte da fonti multiple o la sincronizzazione di dati su più piattaforme in tempo reale. Astrazionando la complessità dell’integrazione MCP, FlowHunt consente agli utenti di concentrarsi sulla progettazione di flussi intelligenti invece che sulle problematiche tecniche d’integrazione.

I vantaggi teorici dei server MCP si traducono in benefici concreti e misurabili nelle applicazioni reali. Le organizzazioni che adottano architetture basate su MCP riportano significative riduzioni nei tempi di sviluppo, con alcuni team che segnalano cicli di integrazione più rapidi del 50-70% rispetto agli approcci tradizionali di integrazione API personalizzata. Questa accelerazione deriva dall’eliminazione di lavori di sviluppo ridondanti e dalla natura standardizzata delle implementazioni MCP. Quando uno sviluppatore deve aggiungere un nuovo strumento a un flusso di lavoro AI, non parte più da zero con codice personalizzato; invece, sfrutta un server MCP già costruito, testato e documentato dai creatori dello strumento o dalla community.

Anche la manutenzione beneficia notevolmente di MCP. Nelle architetture tradizionali, quando un’API cambia o viene rilasciata una nuova versione, gli sviluppatori devono aggiornare il codice di integrazione personalizzato in più applicazioni e modelli AI. Con MCP, il carico di manutenzione ricade principalmente sui manutentori del server MCP, che aggiornano il server una sola volta per riflettere i cambiamenti all’API. Tutte le applicazioni che usano quel server MCP beneficiano automaticamente degli aggiornamenti senza la necessità di modificare il proprio codice. Questo modello centralizzato di manutenzione riduce drasticamente il peso operativo continuo della gestione delle integrazioni AI e permette ai team di sviluppo di concentrarsi sulla creazione di nuove funzionalità invece che sulla manutenzione di quelle esistenti.

Dal punto di vista dell’utente finale, i server MCP permettono applicazioni AI più capaci e reattive. Gli utenti possono chiedere ai propri agenti AI di svolgere compiti complessi che coinvolgono più sistemi—“Crea un nuovo post su WordPress a partire da questo documento Notion e condividilo sui social”—e l’agente può eseguire questi compiti senza soluzione di continuità perché tutti gli strumenti necessari sono disponibili tramite interfacce MCP standardizzate. Questa capacità crea un’esperienza utente più naturale e potente, in cui gli agenti AI si comportano come veri assistenti che comprendono e possono interagire con tutto l’ecosistema tecnologico dell’utente invece che strumenti isolati che operano solo in ambiti ristretti.

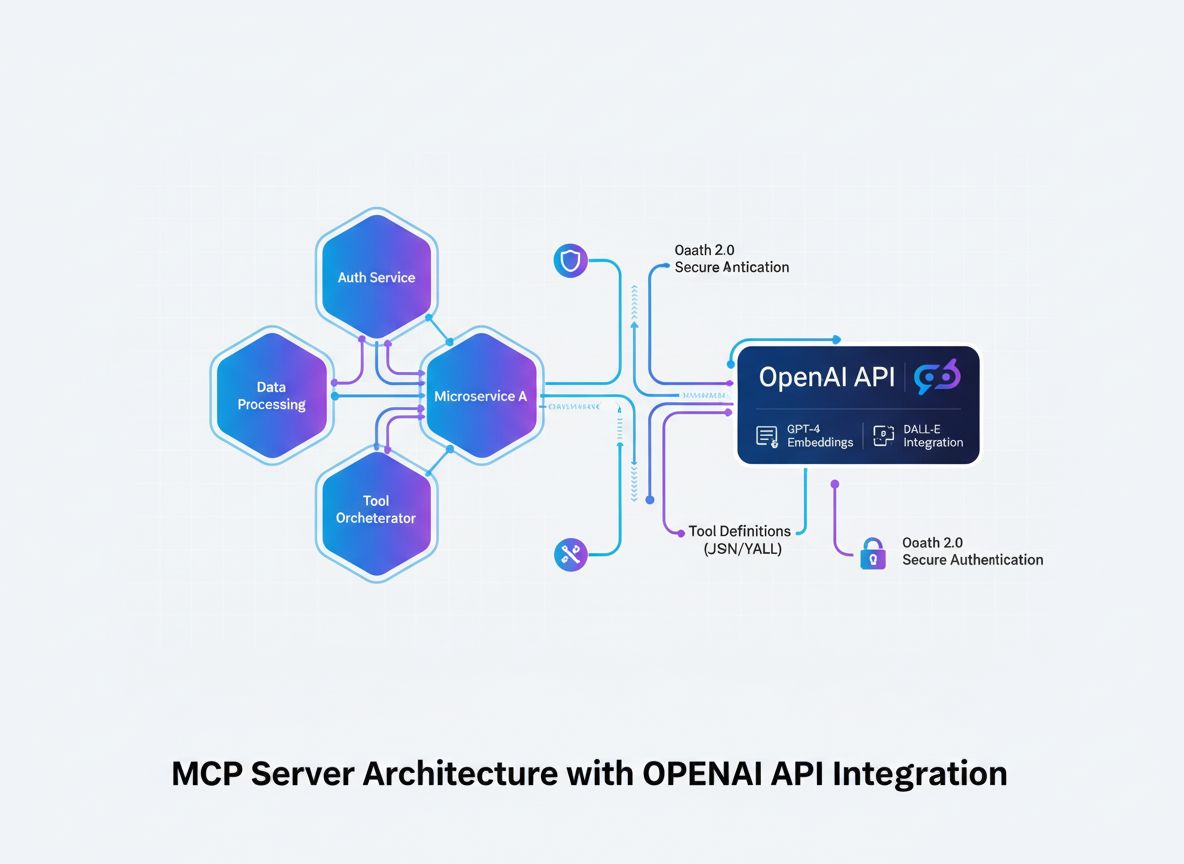

Per gli sviluppatori interessati a creare i propri server MCP, il protocollo fornisce un framework chiaro e ben documentato per esporre strumenti e risorse. Costruire un server MCP significa definire gli strumenti da esporre, specificarne i parametri e i valori restituiti, e implementare la logica che viene eseguita quando gli strumenti vengono chiamati. La specifica MCP fornisce indicazioni dettagliate su come strutturare questo codice e su come gestire la comunicazione con i client MCP. Questa standardizzazione significa che gli sviluppatori non devono inventare nuovi pattern per ogni server che costruiscono; possono invece seguire best practice consolidate e concentrarsi sull’implementazione delle funzionalità specifiche che il proprio server deve fornire.

Il modello di deployment dei server MCP è flessibile e supporta diverse architetture. I server possono essere eseguiti come processi standalone sulla macchina dello sviluppatore, distribuiti su infrastrutture cloud o incorporati in applicazioni più grandi. Questa flessibilità permette alle organizzazioni di adottare strategie di deployment coerenti con la propria infrastruttura e i propri requisiti di sicurezza. Alcune organizzazioni possono eseguire server MCP localmente per sviluppo e test, poi distribuirli su piattaforme cloud per l’uso in produzione. Altre possono incorporare direttamente server MCP nelle proprie applicazioni per fornire accesso locale agli strumenti senza necessità di chiamate di rete esterne. Questa flessibilità architetturale è uno dei motivi per cui MCP ha trovato così rapida adozione nella community degli sviluppatori.

Le considerazioni sulla sicurezza sono fondamentali nella costruzione e nel deployment dei server MCP, soprattutto quando questi espongono l’accesso a sistemi o dati sensibili. La specifica MCP include indicazioni su autenticazione, autorizzazione e comunicazione sicura tra client e server. Gli sviluppatori che realizzano server MCP devono considerare con attenzione chi deve avere accesso a quali strumenti e implementare controlli di accesso appropriati. Ad esempio, un server MCP per WordPress potrebbe limitare certe operazioni come l’eliminazione dei post o la modifica dei permessi utente solo a utenti autenticati con i giusti ruoli. Allo stesso modo, un server MCP per database potrebbe limitare le capacità di query per prevenire accessi non autorizzati ai dati. Queste considerazioni di sicurezza non sono uniche di MCP, ma la natura standardizzata del protocollo rende più facile implementare best practice di sicurezza in modo coerente su diversi server.

L’ecosistema MCP è cresciuto rapidamente dall’introduzione del protocollo, con sviluppatori e organizzazioni che hanno creato server MCP per una vasta gamma di strumenti e piattaforme. Il registro ufficiale MCP mostra server per piattaforme popolari come WordPress, Notion, Google Calendar, GitHub, Slack e molte altre. Questo ecosistema in crescita significa che spesso le organizzazioni possono trovare server MCP già pronti per gli strumenti che utilizzano abitualmente, eliminando la necessità di sviluppare integrazioni personalizzate da zero. Per gli strumenti per cui non esistono ancora server MCP, la natura standardizzata del protocollo rende semplice per gli sviluppatori crearli.

La diversità dei server MCP disponibili dimostra la versatilità del protocollo. Alcuni server offrono accesso semplice e in sola lettura ai dati—ad esempio, un server che permette agli agenti AI di cercare e recuperare informazioni da una knowledge base. Altri forniscono funzionalità CRUD complete (Creazione, Lettura, Aggiornamento, Eliminazione), permettendo agli agenti AI di apportare modifiche sostanziali ai sistemi esterni. Altri ancora offrono capacità specializzate come generazione di immagini, analisi dati o esecuzione di codice. Questa diversità riflette la realtà che organizzazioni diverse hanno esigenze diverse, e l’architettura flessibile di MCP si adatta a questa varietà mantenendo però un’interfaccia coerente.

I contributi della community hanno avuto un ruolo cruciale nello sviluppo dell’ecosistema MCP. Gli sviluppatori hanno creato server per strumenti e piattaforme di nicchia, riconoscendo che, anche se uno strumento non è ampiamente usato, avere a disposizione un server MCP rende molto più semplice per le organizzazioni che lo utilizzano integrarlo con le applicazioni AI. Questo approccio guidato dalla community ha creato un circolo virtuoso in cui la disponibilità di server MCP incoraggia più organizzazioni ad adottare architetture basate su MCP, il che a sua volta motiva più sviluppatori a creare altri server. Il risultato è un ecosistema in rapida espansione che rende MCP sempre più prezioso man mano che più strumenti e piattaforme ottengono il supporto MCP.

Man mano che le organizzazioni diventano più sofisticate nell’uso dell’AI, i server MCP rendono possibili flussi di lavoro sempre più complessi e potenti. Un caso d’uso interessante riguarda l’orchestrazione multi-sistema, dove agenti AI coordinano azioni su più piattaforme in risposta a richieste utente o trigger automatici. Ad esempio, un team marketing potrebbe utilizzare un agente AI che monitora le menzioni sui social, crea post su WordPress basati su argomenti di tendenza, aggiorna un database Notion con i calendari editoriali e programma post su più piattaforme—tutto coordinato da un unico agente AI che accede a più server MCP.

Un altro caso d’uso avanzato riguarda l’aggregazione e l’analisi dei dati. Le organizzazioni possono creare server MCP che espongono dati da diversi sistemi interni, permettendo agli agenti AI di raccogliere informazioni da fonti disparate, analizzarle e generare insight. Ad esempio, una società di servizi finanziari potrebbe creare server MCP che espongono dati dal sistema contabile, CRM e fornitori di dati di mercato, permettendo a un agente AI di analizzare la redditività dei clienti, le tendenze di mercato e le performance finanziarie in modo integrato. Questa capacità trasforma l’AI da uno strumento che lavora con dati isolati a una vera piattaforma di business intelligence in grado di sintetizzare informazioni su tutta l’organizzazione.

Personalizzazione e consapevolezza del contesto rappresentano un altro fronte per le applicazioni abilitate da MCP. Esporre dati utente, preferenze e cronologia tramite server MCP consente alle applicazioni di fornire agli agenti AI un contesto ricco sugli utenti. Questo permette agli agenti AI di offrire esperienze altamente personalizzate, ricordando preferenze, comprendendo obiettivi e adattando le risposte di conseguenza. Ad esempio, un agente AI per il customer service potrebbe accedere a server MCP che espongono la cronologia acquisti del cliente, ticket di supporto e preferenze, consentendo un’assistenza personalizzata che tiene conto della situazione e della storia unica del cliente.

Per apprezzare pienamente il valore di MCP, è utile confrontarlo con gli approcci tradizionali di integrazione tra applicazioni AI e sistemi esterni. Nelle architetture tradizionali, gli sviluppatori configurano manualmente ogni integrazione API, scrivendo codice personalizzato per gestire autenticazione, formattazione delle richieste, gestione degli errori e parsing delle risposte. Questo approccio funziona per integrazioni semplici ma diventa sempre più ingestibile man mano che cresce il numero di sistemi integrati. Ogni nuova integrazione richiede che gli sviluppatori studino la documentazione specifica dell’API, ne capiscano le particolarità e limitazioni, e scrivano codice ad hoc per gestirle.

L’integrazione API tradizionale crea anche importanti sfide di manutenzione. Quando un’API cambia, gli sviluppatori devono aggiornare il codice di integrazione personalizzato. Quando viene rilasciata una nuova versione di un’API, devono decidere se aggiornare e gestire eventuali cambiamenti incompatibili. Quando un’organizzazione vuole aggiungere un nuovo modello AI, deve ricreare tutte le integrazioni API per quel nuovo modello. Queste sfide si accumulano nel tempo, creando debito tecnico che rallenta lo sviluppo e aumenta i costi operativi.

MCP affronta queste sfide attraverso standardizzazione e astrazione. Invece di scrivere codice personalizzato per ogni API, gli sviluppatori implementano il protocollo MCP una sola volta per ogni strumento o fonte dati. Questa standardizzazione significa che tutte le applicazioni AI ottengono automaticamente accesso a tutti i server MCP senza necessità di codice di integrazione personalizzato. Quando un’API cambia, i manutentori del server MCP aggiornano il server e tutte le applicazioni che lo utilizzano beneficiano automaticamente dell’aggiornamento. Quando viene aggiunto un nuovo modello AI, basta implementare il supporto MCP una sola volta per accedere a tutti i server MCP esistenti. Questo approccio architetturale cambia radicalmente l’economia dell’integrazione AI, rendendola molto più efficiente e scalabile.

L’ecosistema MCP continua a evolversi rapidamente, con uno sviluppo continuo focalizzato su espansione delle capacità, miglioramento delle prestazioni e risposta a nuovi casi d’uso. Un’area di sviluppo attiva riguarda il potenziamento del supporto del protocollo per lo streaming dati in tempo reale e le architetture event-driven. Man mano che le applicazioni AI diventano più sofisticate, la possibilità che i server MCP inviino aggiornamenti ai client in tempo reale diventa sempre più preziosa. Immagina un agente AI che riceve notifiche in tempo reale quando si verificano determinati eventi nei sistemi esterni, permettendogli di rispondere immediatamente invece di attendere il prossimo ciclo di polling. Questa funzionalità aprirebbe nuove possibilità per flussi AI reattivi ed event-driven.

Un’altra area di sviluppo riguarda il miglioramento del supporto del protocollo per operazioni complesse e multi-step. Sebbene le implementazioni MCP attuali gestiscano bene le singole chiamate agli strumenti, cresce l’interesse per consentire ai server MCP di esporre operazioni di livello superiore che coinvolgono più step e logiche complesse. Questo permetterebbe agli agenti AI di richiedere operazioni come “migrare questo sito WordPress su un nuovo provider hosting” o “consolidare questi tre database in un unico data warehouse”, con il server MCP che gestisce tutta la complessità sottostante. Questa evoluzione astrarrebbe ulteriormente i dettagli tecnici e permetterebbe agli agenti AI di lavorare a livelli di astrazione più elevati.

Sicurezza e governance rappresentano un’altra area fondamentale su cui si sta concentrando la community MCP. Man mano che i server MCP ottengono accesso a sistemi e dati sempre più sensibili, la necessità di sicurezza robusta, logging e capacità di governance diventa critica. La community sta lavorando attivamente su standard per autenticazione, autorizzazione, crittografia e tracciabilità che consentiranno alle organizzazioni di adottare server MCP in ambienti enterprise con la massima sicurezza. Questi sviluppi saranno cruciali per l’adozione di MCP in settori altamente regolamentati come finanza, sanità e pubblica amministrazione.

Per le organizzazioni che stanno valutando l’adozione di MCP, alcune considerazioni pratiche dovrebbero guidare la strategia di implementazione. In primo luogo, valuta il tuo stack tecnologico attuale e identifica quali strumenti e sistemi trarrebbero maggior beneficio dall’integrazione MCP. Dai priorità ai sistemi frequentemente utilizzati da più applicazioni o che richiedono integrazioni complesse. Sono questi i punti dove MCP offrirà il valore più immediato. In secondo luogo, verifica se esistono già server MCP per i tuoi sistemi prioritari. In tal caso, puoi iniziare subito a usarli. In caso contrario, valuta se la creazione di server MCP personalizzati sia fattibile in base alle risorse di sviluppo e alle competenze disponibili.

In terzo luogo, considera l’architettura di deployment e i requisiti di sicurezza. Decidi se i server MCP debbano girare localmente, in cloud o essere incorporati nelle tue applicazioni. Considera come gestirai autenticazione e autorizzazione, specialmente se i server MCP accedono a sistemi o dati sensibili. In quarto luogo, pianifica un’adozione graduale invece di migrare tutta l’architettura di integrazione su MCP in una volta sola. Parti con un progetto pilota che utilizza server MCP per un workflow o caso d’uso specifico. Questo permette al tuo team di acquisire esperienza con il protocollo, identificare eventuali criticità e perfezionare l’approccio prima di allargare la portata.

Infine, investi in formazione e documentazione per il tuo team di sviluppo. Sebbene MCP sia pensato per essere developer-friendly, il tuo team trarrà beneficio dalla comprensione dell’architettura del protocollo, delle best practice per la creazione di server MCP e di come integrarli nelle applicazioni. Online sono disponibili molte risorse, incluse documentazione ufficiale, tutorial della community ed esempi di implementazione. Dedicare tempo alla costruzione di questa base di conoscenza accelererà la capacità del tuo team di sfruttare efficacemente MCP nella tua organizzazione.

Il Model Context Protocol rappresenta un cambiamento fondamentale nel modo in cui le applicazioni AI si collegano a sistemi e fonti di dati esterne. Fornendo un’interfaccia standardizzata e universale per l’integrazione AI-to-system, MCP elimina la complessità esponenziale degli approcci tradizionali basati su integrazioni API personalizzate. Il protocollo risolve il problema NxM, riduce drasticamente i tempi di sviluppo e i costi di manutenzione, e consente alle organizzazioni di costruire applicazioni AI più potenti in grado di accedere senza soluzione di continuità a tutto l’ecosistema tecnologico. Man mano che l’ecosistema MCP continua a crescere e maturare, con una gamma sempre più ampia di server disponibili e continui miglioramenti del protocollo, MCP è destinato a diventare lo standard per l’integrazione AI in tutti i settori. Le organizzazioni che adottano MCP per prime otterranno vantaggi competitivi significativi nella capacità di sviluppare e distribuire rapidamente soluzioni di automazione AI sofisticate. Che tu stia sviluppando applicazioni AI, creando strumenti e piattaforme, o gestendo l’infrastruttura tecnologica aziendale, comprendere e sfruttare i server MCP sarà sempre più importante per restare competitivi nel futuro guidato dall’AI.

Scopri come FlowHunt automatizza i tuoi flussi di lavoro AI e SEO — dalla ricerca e generazione di contenuti alla pubblicazione e all'analisi — tutto in un unico posto. Sfrutta i server MCP per collegare senza soluzione di continuità l'intero stack tecnologico.

MCP sta per Model Context Protocol. È uno standard open-source sviluppato da Anthropic che fornisce un modo standardizzato per applicazioni AI come Claude e ChatGPT di connettersi con sistemi esterni, fonti di dati e strumenti.

Il problema NxM si riferisce alla complessità di integrare N diversi LLM con M diversi strumenti e fonti di dati. MCP lo risolve fornendo uno standard universale, eliminando la necessità di integrazioni personalizzate tra ogni combinazione di LLM e strumento. Invece di N×M integrazioni, servono solo N+M connessioni.

I server MCP riducono i tempi e la complessità di sviluppo, offrono accesso a un ecosistema di fonti di dati e strumenti, eliminano sforzi di integrazione ridondanti, riducono la manutenzione e consentono applicazioni AI più capaci, in grado di accedere a dati in tempo reale ed eseguire azioni per conto degli utenti.

Sì, MCP è progettato per essere agnostico rispetto al modello. Funziona con varie applicazioni AI, tra cui Claude, ChatGPT e altri LLM. Questa compatibilità universale è uno dei principali vantaggi dello standard MCP.

I server MCP possono integrare praticamente qualsiasi sistema esterno, comprese API, database, knowledge base, file system, servizi web e strumenti specializzati. Esempi comuni includono WordPress, Google Calendar, Notion, Figma, Blender e database aziendali.

Arshia è una AI Workflow Engineer presso FlowHunt. Con una formazione in informatica e una passione per l'IA, è specializzata nella creazione di workflow efficienti che integrano strumenti di intelligenza artificiale nelle attività quotidiane, migliorando produttività e creatività.

Integra i server MCP senza soluzione di continuità nei tuoi flussi di automazione AI. Collega strumenti, fonti di dati e API senza configurazioni complesse.

Esplora esempi completi di server MCP e scopri come costruire, distribuire e integrare server Model Context Protocol per potenziare le capacità degli agenti AI ...

Scopri come sviluppare un server Model Context Protocol (MCP) che si integra senza soluzione di continuità con l'API di OpenAI, abilitando l'esecuzione di poten...

Scopri come costruire e distribuire un server Model Context Protocol (MCP) per collegare modelli AI con strumenti esterni e fonti di dati. Guida passo-passo per...

Consenso Cookie

Usiamo i cookie per migliorare la tua esperienza di navigazione e analizzare il nostro traffico. See our privacy policy.