Come Funzionano i Chatbot AI

Scopri come i chatbot AI elaborano il linguaggio naturale, comprendono le intenzioni degli utenti e generano risposte intelligenti. Approfondisci NLP, machine l...

Esplora l’infrastruttura nascosta dietro i sistemi di IA. Scopri come funzionano i data center, le loro richieste energetiche, i sistemi di raffreddamento, i tempi di costruzione e i massicci investimenti che stanno rimodellando l’infrastruttura globale.

Quando apri ChatGPT, scrivi un prompt e premi invio, non ti stai semplicemente collegando a una misteriosa nuvola. Dietro quella semplice interazione si cela una delle infrastrutture più complesse, costose ed energivore mai costruite dall’umanità. Ogni risposta dell’IA che ricevi è alimentata da enormi data center—strutture da miliardi di dollari raffreddate ad aria e acqua, che consumano abbastanza elettricità da alimentare intere città. Questi non sono concetti astratti dispersi nel cyberspazio; sono edifici fisici pieni di hardware specializzato, sofisticati sistemi di raffreddamento e sicurezza da fortezza. Comprendere cosa c’è dentro questi data center è fondamentale per capire come funziona davvero l’IA moderna e perché aziende come OpenAI, Google, Microsoft e Meta stanno investendo trilioni di dollari per costruirli. Questo articolo esplora la spina dorsale nascosta della rivoluzione dell’IA, dall’architettura di base dei data center alle complesse sfide ingegneristiche che affrontano, le enormi richieste di elettricità che generano e la corsa globale per costruire l’infrastruttura che alimenterà la prossima generazione di intelligenza artificiale.

{{ < youtubevideo videoID=“WNt_1bSODIo” title=“Cosa c’è dentro un Data Center per l’IA?” class=“rounded-lg shadow-md” > }}

I data center sono essenzialmente fabbriche di calcolo. Sebbene il termine “cloud” sia ormai onnipresente nel marketing tecnologico, è un termine improprio: la nuvola non esiste. Esistono invece enormi edifici fisici pieni di apparecchiature informatiche specializzate, infrastrutture di rete, sistemi di alimentazione e meccanismi di raffreddamento. Un data center può essere visto come una versione enormemente ingrandita di un computer personale. Proprio come il tuo laptop contiene CPU, GPU, memoria, storage e alimentazione, un data center hyperscale racchiude questi stessi componenti, ma moltiplicati per miliardi. La struttura gestisce e fornisce dati tramite sistemi interconnessi di server, acceleratori IA, array di storage e apparecchiature di rete. Questi edifici funzionano come piccole città, con sistemi propri di generazione e distribuzione di energia, generatori di backup, infrastrutture di sicurezza e controlli ambientali. Lo scopo fondamentale rimane costante, che il data center ospiti CPU per compiti informatici generici o GPU per carichi di lavoro di intelligenza artificiale: elabora, archivia e distribuisce dati su scala enorme. Tuttavia, il design, l’architettura e i requisiti operativi specifici dei data center focalizzati sull’IA sono diventati radicalmente diversi rispetto ai data center tradizionali, richiedendo approcci completamente nuovi alla gestione dell’alimentazione, al raffreddamento e alla pianificazione infrastrutturale.

L’emergere dell’IA generativa ha trasformato radicalmente l’industria dei data center, in modi che vanno ben oltre la semplice scalabilità delle infrastrutture esistenti. Prima della fine del 2022, quando ChatGPT è stato lanciato al mondo, i data center si concentravano principalmente su compiti informatici generici—hosting di siti web, gestione di database, esecuzione di applicazioni aziendali e fornitura di servizi cloud. Le richieste computazionali erano relativamente prevedibili e gestibili. Tuttavia, la crescita esplosiva dei large language model e dei sistemi di IA generativa ha creato una nuova categoria di carico di lavoro informatico, che opera secondo vincoli completamente diversi. Questi sistemi di IA si basano sulla moltiplicazione di matrici—un’operazione matematicamente semplice che va eseguita miliardi di volte al secondo. Questa esigenza ha spinto l’intero settore verso hardware GPU specializzato, in particolare i chip avanzati di Nvidia, progettati specificamente per eseguire efficientemente queste operazioni. Il cambiamento è stato così drastico da generare una vera e propria carenza di GPU, con aziende impossibilitate a procurarsi abbastanza hardware per soddisfare la domanda. Questo ha innescato una sorta di corsa agli armamenti tecnologica, con ogni grande azienda tech che investe centinaia di miliardi di dollari per assicurarsi forniture di GPU e sviluppare infrastrutture data center ottimizzate per l’IA. La scala di questa espansione è senza precedenti—OpenAI, Oracle e il progetto Stargate di SoftBank puntano da soli a investire trilioni di dollari nell’infrastruttura IA negli Stati Uniti. Non si tratta di un semplice aggiornamento incrementale dei sistemi esistenti; rappresenta una ristrutturazione fondamentale dell’infrastruttura informatica globale per supportare un nuovo paradigma tecnologico.

Il vincolo più critico all’espansione dei data center IA è l’elettricità. A differenza dei data center tradizionali che potrebbero consumare 10-15 kilowatt per rack, i moderni data center IA stanno raggiungendo oggi gli 80-120 kilowatt per rack, con i sistemi Nvidia di prossima generazione, era Ruben, che si prevede toccheranno i 600 kilowatt per rack entro la fine del decennio. Questo rappresenta un aumento di cinque o dieci volte della densità di potenza, creando sfide senza precedenti per la generazione, distribuzione e gestione dell’energia. Per mettere in prospettiva, il Dipartimento dell’Energia degli Stati Uniti stima che nel solo 2023 i data center abbiano consumato il 4,4% dell’elettricità totale, cifra che dovrebbe arrivare al 7-12% entro il 2028. L’Electric Reliability Council of Texas (ERCOT) e altri operatori di rete prevedono circa 30 gigawatt di nuova domanda di picco entro il 2030, trainata soprattutto dall’espansione dei data center. Per dare un’idea, 30 gigawatt equivalgono all’incirca al consumo elettrico di 25-30 milioni di famiglie, o alla produzione di circa 30 grandi centrali nucleari. Questo crea una sfida enorme per le utility e le reti di distribuzione, progettate e realizzate per un’epoca di domande energetiche completamente diverse. Il problema è aggravato dal fatto che il consumo di elettricità dei data center IA non è distribuito uniformemente né nello spazio né nel tempo. Queste strutture richiedono carichi costanti e ad alta densità concentrati vicino a specifiche sottostazioni, generando pressione localizzata sull’infrastruttura elettrica. Aziende come Google, Microsoft e OpenAI devono ora prendere decisioni strategiche sulla collocazione dei data center basandosi principalmente sulla disponibilità di elettricità, non solo su fattori tradizionali come il costo dei terreni o la vicinanza agli utenti. Questo ha portato a una concentrazione geografica dello sviluppo dei data center in regioni con abbondante capacità di generazione, come l’alto Midwest, i Paesi Nordici e aree con significativa produzione idroelettrica o nucleare. Il vincolo elettrico è diventato così rilevante da essere ora il principale fattore limitante nell’espansione dell’infrastruttura IA, più importante di immobili, forza lavoro o persino disponibilità di GPU.

Un moderno data center IA è organizzato in diversi sistemi interconnessi, ognuno con una funzione critica. Al centro ci sono i rack—strutture metalliche che ospitano le GPU e gli acceleratori IA specializzati che svolgono i calcoli veri e propri. Questi rack sono collegati tramite switch di rete ad alta velocità che permettono loro di comunicare a larghezza di banda elevatissima. Il data center contiene anche array di storage che custodiscono petabyte di informazioni—dati di addestramento, pesi dei modelli e dati utente necessari ai sistemi IA. Oltre all’hardware di calcolo, la struttura richiede una sofisticata infrastruttura elettrica che comprende trasformatori, quadri di distribuzione, gruppi di continuità (UPS) e generatori di backup. I sistemi di alimentazione devono essere progettati per gestire non solo il carico medio, ma anche i picchi che si verificano quando tutti i sistemi operano a piena capacità. Di pari importanza è l’infrastruttura di raffreddamento, diventata uno degli aspetti più critici e complessi del design dei data center moderni. I sistemi di raffreddamento devono rimuovere il calore generato dalle apparecchiature informatiche e mantenere temperature ottimali di esercizio per l’hardware. Questo comporta una combinazione di unità di trattamento aria, circuiti di raffreddamento a liquido, sistemi ad acqua refrigerata e in alcuni casi raffreddamento diretto a liquido, dove il liquido scorre direttamente sui chip. La struttura necessita inoltre di un’estesa infrastruttura di sicurezza, inclusi barriere fisiche, sistemi di controllo accessi, telecamere di sorveglianza e misure di cybersicurezza per proteggere sia da intrusioni fisiche che digitali. Infine, il data center deve disporre di sistemi ridondanti per le funzioni critiche—alimentazione, raffreddamento e rete di backup—per garantire che le interruzioni di servizio siano ridotte al minimo e che la struttura possa continuare a operare anche in caso di guasto di singoli componenti.

Sebbene FlowHunt sia specializzata nell’automazione dei flussi di lavoro di contenuti IA piuttosto che nella gestione dell’infrastruttura fisica, i principi di efficienza e ottimizzazione che guidano la progettazione dei data center sono direttamente applicabili a come le organizzazioni possono semplificare le proprie operazioni IA. Proprio come i data center devono ottimizzare il consumo di energia, l’efficienza del raffreddamento e la produttività computazionale, le organizzazioni che utilizzano strumenti IA devono ottimizzare i propri flussi di lavoro per massimizzare il valore estratto dai sistemi IA riducendo al minimo le risorse sprecate. FlowHunt automatizza i flussi di ricerca, generazione contenuti e pubblicazione che altrimenti richiederebbero notevole sforzo e coordinamento manuale. Automatizzando questi processi, le organizzazioni possono ridurre l’overhead computazionale delle proprie attività di content, proprio come i data center ottimizzano la propria infrastruttura. La piattaforma aiuta i team a comprendere e monitorare l’efficienza dei flussi IA, offrendo visibilità su come vengono utilizzate le risorse—proprio come gli operatori dei data center monitorano il consumo di energia e l’efficienza del raffreddamento. Per le organizzazioni che costruiscono prodotti o servizi basati su IA, comprendere i requisiti infrastrutturali e i vincoli dei data center è fondamentale per prendere decisioni informate su distribuzione, scalabilità e gestione dei costi. Le capacità di automazione di FlowHunt aiutano i team a lavorare in modo più efficiente entro questi vincoli, consentendo di generare più contenuti, condurre più ricerche e pubblicare più frequentemente senza aumentare proporzionalmente le richieste computazionali o l’overhead operativo.

Uno degli aspetti più sottovalutati delle operazioni dei data center IA è il raffreddamento. L’enorme densità di calcolo nei moderni data center IA genera quantità colossali di calore che devono essere rimosse dai chip per evitare danni termici e mantenere prestazioni ottimali. Senza un raffreddamento efficace, il silicio letteralmente si scioglierebbe e l’intera struttura si spegnerebbe. Questa sfida ha portato a un cambio di filosofia progettuale dei data center, passando dal tradizionale raffreddamento ad aria a sistemi a liquido più sofisticati. Il raffreddamento ad aria, dove le ventole soffiano aria fresca sulle apparecchiature, è l’approccio tradizionale utilizzato nella maggior parte dei data center. Tuttavia, l’aria ha una conduttività termica relativamente bassa rispetto ai liquidi, il che la rende meno efficiente nel rimuovere calore da apparecchiature densamente impacchettate. Con l’aumento della densità di potenza, il raffreddamento ad aria è diventato sempre più inadeguato. I sistemi di raffreddamento a liquido, dove acqua o fluidi speciali scorrono direttamente sopra o vicino ai chip, sono molto più efficienti nella rimozione del calore. Esistono diversi approcci al raffreddamento a liquido: sistemi a circuito chiuso, in cui il liquido circola attraverso l’attrezzatura e ritorna al refrigeratore senza contatto con l’ambiente, e sistemi a circuito aperto, dove il liquido può essere esposto alle condizioni ambientali. I sistemi a circuito chiuso sono più efficienti nel consumo d’acqua ma possono utilizzare più elettricità per il processo di raffreddamento. Quelli a circuito aperto possono essere più efficienti dal punto di vista elettrico ma consumano più acqua. La scelta dipende dalla disponibilità locale di acqua, dai costi dell’elettricità, dalle condizioni climatiche e dalle normative ambientali. L’efficacia dell’uso dell’acqua (WUE) è un parametro chiave per misurare l’efficienza del data center, calcolato come litri d’acqua usati per kilowattora di potenza IT. A livello industriale, il WUE tipico è circa 1,9 litri per kilowattora, ma le strutture con sistemi completamente a circuito chiuso possono avvicinarsi a zero consumo d’acqua. Il data center di Google a Council Bluffs, in Iowa, ad esempio, ha consumato circa un miliardo di galloni d’acqua nel 2023, evidenziando le enormi richieste idriche delle grandi strutture IA. Alcuni impianti innovativi stanno esplorando approcci alternativi, tra cui l’utilizzo del calore di scarto per sistemi di teleriscaldamento (come fa Meta in Danimarca, esportando 100-165 gigawattora di calore all’anno nelle reti locali), il free cooling dall’aria esterna in climi freddi e persino sistemi di raffreddamento a idrogeno. L’infrastruttura di raffreddamento rappresenta una parte significativa dell’investimento capitale in un data center ed è spesso la sfida ingegneristica più complessa nella fase di progettazione.

Costruire un data center IA di tipo hyperscale è un’impresa colossale che richiede pianificazione accurata, ingenti investimenti e coordinamento con molteplici stakeholder. Il tempo tipico dalla concezione iniziale all’operatività completa va da 18 a 30 mesi, suddiviso in diverse fasi. La prima è la pianificazione e valutazione di fattibilità, che dura generalmente 3-6 mesi. In questa fase si individuano potenziali siti, si valuta la disponibilità e capacità energetica locale, si analizzano le risorse idriche, si esaminano normative e vincoli urbanistici e si coinvolge la comunità. Trovare un terreno adatto non è banale—la struttura deve avere accesso ad abbondante elettricità, connessioni in fibra ottica ad alta velocità per la connettività internet, adeguate risorse idriche per il raffreddamento e il supporto delle autorità locali. La seconda fase è la progettazione e ingegneria, che richiede 6-12 mesi. Qui architetti e ingegneri sviluppano piani dettagliati per la struttura, inclusa la disposizione di rack e apparecchiature, la distribuzione dell’alimentazione, l’infrastruttura di raffreddamento, i sistemi di sicurezza e tutti gli altri impianti. Questa fase comporta ampie simulazioni per ottimizzare l’efficienza e garantire che tutti i sistemi funzionino insieme in modo efficace. La terza fase riguarda permessi e autorizzazioni, che si sovrappone alla progettazione e dura 6-18 mesi. Ciò comprende l’ottenimento dei permessi edilizi, delle autorizzazioni ambientali, degli accordi di interconnessione elettrica e di ogni altra autorizzazione necessaria dalle autorità locali, statali e federali. Questa fase può essere particolarmente lunga in aree con regolamenti ambientali severi o dove la comunità si oppone al progetto. La quarta fase è la costruzione vera e propria, che dura 1-2 anni. Comprende la realizzazione dell’edificio, l’installazione di tutte le apparecchiature, la posa degli impianti elettrici e di raffreddamento e la predisposizione della sicurezza. L’ultima fase è il collaudo e la messa in servizio, che dura 3-6 mesi. Qui si testano tutti i sistemi, si configura il software e la struttura viene gradualmente avviata. L’eccezione più famosa a questa tempistica è il progetto Colossus di XAI, completato in soli 122 giorni—un risultato senza precedenti che ha richiesto coordinamento, pianificazione preventiva e risorse straordinarie. La maggior parte dei progetti, tuttavia, segue la tempistica standard di 18-30 mesi. L’investimento richiesto è enorme. Il campus Fairwater Supercomputer di Microsoft, ad esempio, si estende su centinaia di ettari, richiede chilometri di fondamenta e l’installazione di migliaia di GPU con sofisticati sistemi di raffreddamento a liquido. L’investimento totale può facilmente raggiungere decine di miliardi di dollari. Questo investimento riflette l’importanza strategica dell’infrastruttura IA per queste aziende e la pressione competitiva per assicurarsi capacità GPU e costruire capacità IA il più rapidamente possibile.

Una volta costruiti, i data center IA funzionano con sicurezza da fortezza e procedure operative sofisticate. Queste strutture ospitano apparecchiature dal valore di miliardi di dollari e gestiscono sistemi critici per le principali aziende tecnologiche. La sicurezza fisica è fondamentale. Le strutture sono circondate da recinzioni alte e barriere anti-intrusione per impedire accessi non autorizzati con veicoli. I punti di accesso sono rigorosamente controllati, con più livelli di sicurezza tra cui badge, scanner biometrici e personale di sicurezza. I visitatori sono rari e devono essere pre-approvati; le sale server sono accessibili solo se accompagnati da personale autorizzato. Telecamere monitorano ininterrottamente tutte le aree della struttura. L’infrastruttura di sicurezza è progettata per prevenire furti e sabotaggi. La cybersicurezza è altrettanto importante. I sistemi ospitati in questi data center contengono proprietà intellettuale di valore, dati degli utenti e modelli addestrati che rappresentano anni di ricerca e miliardi di investimenti. Le misure di sicurezza informatica sono tra le più sofisticate disponibili, inclusi segmentazione di rete, sistemi di rilevamento intrusioni, crittografia e monitoraggio continuo di attività sospette. Ogni rack è di solito chiuso in una gabbia, e l’accesso ai sistemi critici è riservato a personale autorizzato. La complessità operativa di questi impianti è enorme. Gli operatori devono monitorare costantemente il consumo energetico, l’efficienza del raffreddamento, lo stato delle apparecchiature, le prestazioni di rete e la sicurezza. Devono gestire la pianificazione dei carichi per bilanciare il consumo energetico in tutta la struttura ed evitare sovraccarichi localizzati. Devono coordinare le attività di manutenzione per ridurre i tempi di inattività. Devono rispondere rapidamente a guasti ed effettuare riparazioni. Un grande impianto può impiegare decine o centinaia di persone in vari ruoli operativi, anche se, una volta completamente automatizzato, un singolo impianto può essere gestito da un team relativamente piccolo. Le procedure operative sono altamente standardizzate e documentate, con protocolli chiari per le situazioni comuni e procedure di emergenza per eventi inattesi.

La posizione dei data center IA è diventata una decisione strategica per le grandi aziende tecnologiche, guidata principalmente dalla disponibilità di elettricità ma influenzata anche da risorse idriche, clima, connettività in fibra ottica, regolamenti locali e fattori comunitari. La Virginia del Nord è diventata il più grande mercato mondiale per i data center, con tassi di vacanza vicini allo zero e gigawatt di nuova capacità in costruzione. La contea di Loudoun, in Virginia, è ormai così dipendente dalle entrate dei data center che il bilancio della contea indica esplicitamente che questi generano circa il 38% delle entrate generali. Questo ha permesso alla contea di ridurre le tasse sulla proprietà per i residenti, dimostrando il significativo beneficio economico che i data center possono portare alle comunità locali. Tuttavia, altre regioni stanno emergendo come alternative interessanti. Phoenix, Chicago, Oregon e Ohio stanno vedendo notevoli investimenti data center grazie alla combinazione di terreni disponibili, adeguata capacità di generazione elettrica e risorse idriche. Il Midwest superiore, in particolare le aree vicino a dighe idroelettriche o centrali nucleari, è molto attraente per l’abbondanza di energia pulita. I paesi nordici, soprattutto Islanda e Norvegia, sono diventati poli data center grazie all’energia idroelettrica e al clima freddo, che riduce i costi di raffreddamento. L’impatto economico dello sviluppo dei data center è complesso. Durante la fase di costruzione si genera molta occupazione—operai edili, ingegneri e project manager. Tuttavia, una volta operativo, l’impatto occupazionale è molto più contenuto. Un grande data center può impiegare solo poche decine di persone per la gestione e manutenzione, molto meno rispetto alle maestranze di costruzione. Questo è un fattore che le amministrazioni locali devono considerare valutando i progetti data center. Le entrate fiscali generate possono essere notevoli, come dimostra il caso della contea di Loudoun, ma i benefici occupazionali sono limitati. Inoltre, i data center possono generare preoccupazioni ambientali legate al consumo d’acqua, alla domanda elettrica e alla generazione di calore. I migliori progetti sono quelli trasparenti sull’impatto ambientale, che collaborano con le utility locali per garantire l’approvvigionamento energetico, implementano misure di risparmio idrico e si integrano nella comunità locale piuttosto che operare come strutture isolate.

L’infrastruttura elettrica che sostiene i data center IA è complessa quanto quella informatica. I data center necessitano non solo di un’adeguata fornitura di energia, ma anche di una fornitura affidabile e costante, in grado di gestire i carichi di picco senza interruzioni. La maggior parte dei grandi data center è collegata alla rete elettrica regionale, ma dispone anche di sistemi di generazione di backup per assicurare la continuità delle operazioni in caso di blackout. Quasi tutti i grandi data center statunitensi dispongono di enormi generatori diesel come alimentazione di emergenza. Questi generatori possono fornire abbastanza elettricità da mantenere in funzione la struttura per lunghi periodi in caso di blackout della rete. Anche se sono raramente utilizzati, quando vengono attivati producono inquinamento ed emissioni. L’impatto ambientale dei generatori diesel ha spinto gli operatori a esplorare fonti di backup alternative. Alcune strutture stanno testando sistemi di batterie collegati alla rete, che accumulano elettricità e la rilasciano durante le interruzioni. Altre stanno esplorando turbine a gas in loco, che possono generare energia in modo più pulito rispetto ai diesel. Alcuni impianti all’avanguardia stanno persino sperimentando celle a combustibile a idrogeno come fonte di backup. Guardando ancora più avanti, alcuni operatori stanno valutando la possibilità di generazione nucleare in loco, anche se questa rimane per ora largamente teorica. Il rapporto tra data center e aziende fornitrici di energia è cruciale. I data center rappresentano carichi enormi e costanti sulla rete elettrica, e le utility devono pianificare la generazione e la distribuzione per accomodarli. Aziende come Google, Microsoft e OpenAI collaborano strettamente con le utility, spesso firmando accordi di acquisto energia a lungo termine che garantiscono la fornitura a tariffe concordate. Alcune aziende investono direttamente in progetti di energia rinnovabile—parchi solari, eolici e idroelettrici—per generare la propria energia e ridurre la dipendenza dalla rete. Le decisioni infrastrutturali prese dagli operatori dei data center hanno ripercussioni su tutto il sistema elettrico regionale e possono influenzare le politiche e gli investimenti energetici a livello statale e nazionale.

La traiettoria dello sviluppo dei data center IA è chiara: la crescita proseguirà a ritmo accelerato, trainata dalla crescita esplosiva delle applicazioni IA e dalla pressione competitiva tra le aziende per assicurarsi capacità di calcolo. La domanda di elettricità continuerà a crescere, creando sfide per la generazione e la distribuzione. Le esigenze di raffreddamento continueranno a stimolare l’innovazione nelle tecnologie di gestione termica. I requisiti di sicurezza aumenteranno man mano che cresce il valore dei sistemi e dei dati ospitati. Diversi trend plasmeranno il futuro dell’infrastruttura IA. Primo, ci sarà una continua diversificazione geografica, con data center che si espandono in nuove regioni in grado di offrire energia, acqua e connettività adeguate. Secondo, proseguirà l’innovazione nel raffreddamento, con il raffreddamento a liquido che diventerà sempre più standard e nuovi approcci come immersion cooling e raffreddamento bifase in fase di test. Terzo, si punterà sempre più sulla sostenibilità, con operatori impegnati a ridurre il consumo d’acqua, le emissioni di carbonio e ad integrare energie rinnovabili. Quarto, ci sarà ulteriore consolidamento e specializzazione, con impianti ottimizzati per addestramento IA e altri per l’inferenza. Quinto, aumenterà l’automazione operativa, con sistemi IA stessi utilizzati per ottimizzare consumi, raffreddamento e utilizzo delle apparecchiature. La scala degli investimenti nell’infrastruttura IA è senza precedenti e riflette l’importanza strategica dell’IA per l’economia globale. Queste strutture rappresentano la manifestazione fisica della rivoluzione IA, la spina dorsale nascosta che rende possibili tutte le applicazioni e i servizi che stanno trasformando le industrie e la società.

{{ < cta-dark-panel heading=“Potenzia il tuo workflow con FlowHunt” description=“Scopri come FlowHunt automatizza i tuoi flussi di lavoro IA e SEO—dalla ricerca e generazione contenuti fino alla pubblicazione e analisi—tutto in un unico posto.” ctaPrimaryText=“Prenota una Demo” ctaPrimaryURL=“https://calendly.com/liveagentsession/flowhunt-chatbot-demo" ctaSecondaryText=“Prova FlowHunt Gratis” ctaSecondaryURL=“https://app.flowhunt.io/sign-in" gradientStartColor="#123456” gradientEndColor="#654321” gradientId=“827591b1-ce8c-4110-b064-7cb85a0b1217”

}}

La scala finanziaria degli investimenti nei data center IA è impressionante e riflette l’enorme valore che le aziende si aspettano di ricavare dalle capacità IA. OpenAI, Oracle e il progetto Stargate di SoftBank puntano a investire trilioni di dollari nell’infrastruttura IA negli Stati Uniti. Nvidia ha promesso di contribuire con 100 miliardi di dollari a questo obiettivo. Google, Microsoft, Meta e altri grandi player tech stanno investendo ciascuno centinaia di miliardi nell’espansione dei propri data center. Questi investimenti vengono effettuati nonostante l’incertezza sui ritorni, a dimostrazione dell’importanza strategica dell’IA e della pressione competitiva per assicurarsi capacità di calcolo. L’economia operativa dei data center è complessa. I costi in conto capitale sono enormi—decine di miliardi per una grande struttura. Anche i costi operativi sono notevoli, trainati principalmente dal consumo di elettricità. Un grande data center IA può consumare 100-300 megawatt di potenza continua, che, a tariffe tipiche di 50-100 dollari per megawattora, si traducono in 50-300 milioni di dollari all’anno solo di elettricità. A questi si aggiungono i costi di raffreddamento, manutenzione, sicurezza e personale, e i costi operativi annuali possono facilmente superare i 500 milioni per un grande impianto. Questi costi devono essere recuperati tramite i ricavi generati dalla struttura—vendendo capacità di calcolo ai clienti o utilizzando la capacità internamente per generare ricavi tramite servizi IA. Il prezzo della capacità di calcolo è competitivo, con le aziende che offrono accesso GPU a tariffe che riflettono i costi sottostanti più un margine di profitto. Man mano che cresce la disponibilità, potrebbe aumentare la pressione sui prezzi, comprimendo i margini e rendendo più difficile il recupero degli investimenti. Tuttavia, la domanda di capacità IA sembra crescere più rapidamente dell’offerta, il che suggerisce che i prezzi resteranno sostenuti ancora a lungo. Il ritorno sull’investimento per gli operatori dipende dalla capacità di mantenere l’utilizzo pieno degli impianti, gestire efficacemente i costi e mantenere il potere di prezzo in un mercato competitivo. Le aziende che possiedono data center propri e li usano internamente per generare ricavi tramite servizi IA possono avere un’economia diversa rispetto a chi opera data center come servizio, vendendo capacità ai clienti.

L’impatto ambientale dell’espansione dei data center IA è significativo e multifattoriale. L’impatto più evidente è il consumo di elettricità. Man mano che i data center consumano una quota crescente della produzione totale di energia, contribuiscono alle emissioni di carbonio (a meno che non siano alimentati da fonti rinnovabili o nucleari) e mettono sotto pressione le reti elettriche. Anche il consumo di acqua è notevole, soprattutto per le strutture che utilizzano raffreddamento ad acqua. Il calore generato dai data center, sebbene a volte riutilizzato (come nell’impianto Meta in Danimarca), viene spesso semplicemente dissipato nell’ambiente. L’impatto ambientale dell’espansione dei data center ha portato a una crescente attenzione alla sostenibilità. Molti operatori si impegnano per la neutralità carbonica o l’azzeramento delle emissioni, spesso acquistando energia rinnovabile o investendo in pro

I data center per l'IA sono ottimizzati specificamente per le operazioni di moltiplicazione di matrici richieste dai modelli di machine learning. Presentano una densità di potenza superiore (fino a 600 kW per rack), sistemi avanzati di raffreddamento a liquido e infrastrutture GPU specializzate, rispetto ai data center tradizionali che gestiscono compiti informatici generici con requisiti di potenza inferiori (10-15 kW per rack).

Nel 2023, i data center hanno utilizzato il 4,4% dell'elettricità totale degli Stati Uniti, con proiezioni che raggiungeranno il 7-12% entro il 2028. Una singola richiesta a ChatGPT consuma circa 2,9 wattora, mentre i sistemi di IA generativa consumano da 10 a 30 volte più elettricità rispetto all'IA specifica per compiti. Si prevede che gli Stati Uniti avranno bisogno di 30 gigawatt di nuova domanda di picco di elettricità entro il 2030, in gran parte a causa dei data center.

I moderni data center per l'IA impiegano sia sistemi di raffreddamento ad aria sia a liquido. Il raffreddamento diretto a liquido è più efficiente e consente di risparmiare elettricità, ma utilizza acqua. I sistemi a liquido a circuito chiuso riducono al minimo il consumo d'acqua mantenendo l'efficienza. L'efficacia dell'uso dell'acqua (WUE) si aggira in media su 1,9 litri per kilowattora, con sistemi completamente a circuito chiuso che si avvicinano a zero consumo d'acqua.

La costruzione standard di un data center hyperscale richiede da 18 a 30 mesi dall'ideazione alla messa in funzione, includendo pianificazione (3-6 mesi), progettazione e ingegneria (6-12 mesi), permessi e approvazioni (6-18 mesi), costruzione (1-2 anni) e test (3-6 mesi). Il progetto più veloce registrato è stato l'impianto Colossus di XAI, completato in soli 122 giorni.

Arshia è una AI Workflow Engineer presso FlowHunt. Con una formazione in informatica e una passione per l'IA, è specializzata nella creazione di workflow efficienti che integrano strumenti di intelligenza artificiale nelle attività quotidiane, migliorando produttività e creatività.

Scopri come FlowHunt semplifica la generazione di contenuti IA, la ricerca e la pubblicazione—sfruttando gli stessi principi infrastrutturali che alimentano i data center moderni.

Scopri come i chatbot AI elaborano il linguaggio naturale, comprendono le intenzioni degli utenti e generano risposte intelligenti. Approfondisci NLP, machine l...

Scopri come creare un chatbot AI da zero con la nostra guida completa. Trova i migliori strumenti, framework e il processo passo dopo passo per sviluppare siste...

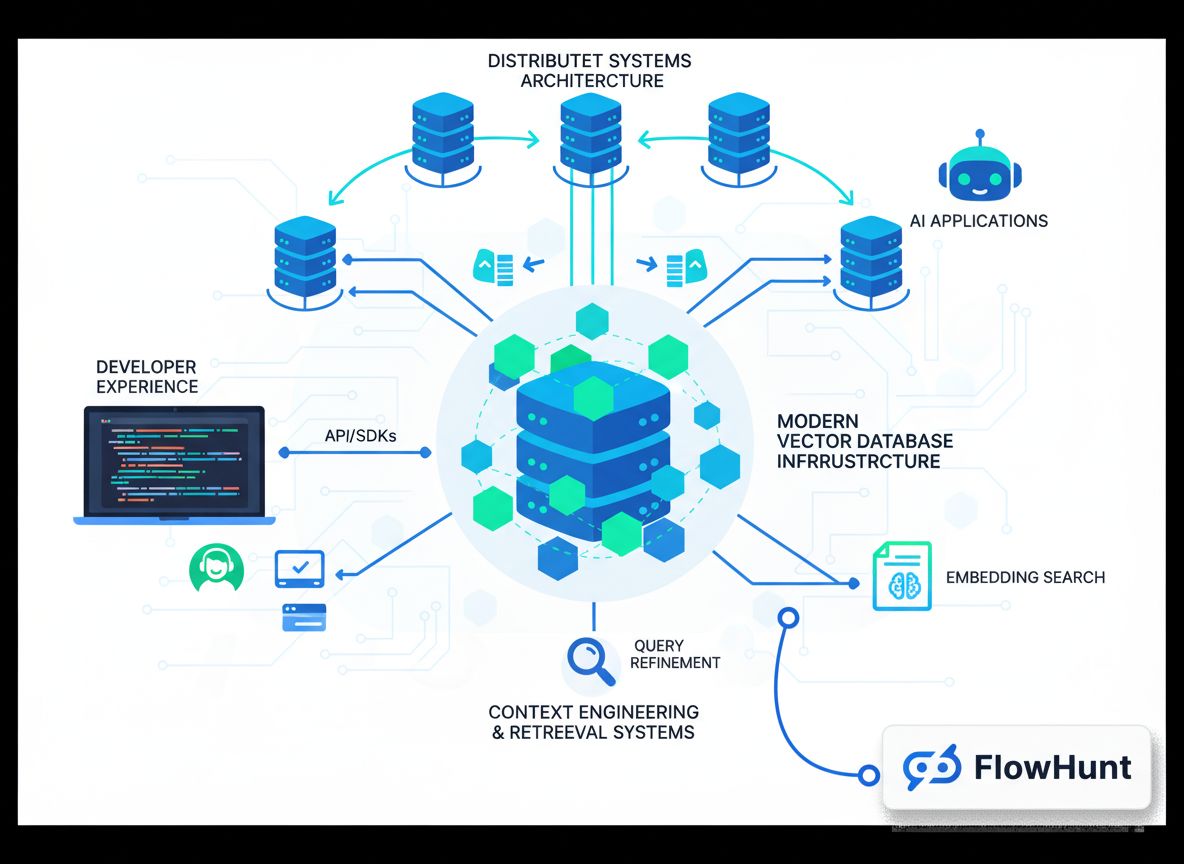

Scopri come l'ingegneria del contesto sta rivoluzionando lo sviluppo AI, l’evoluzione dal RAG ai sistemi pronti per la produzione e perché database vettoriali m...

Consenso Cookie

Usiamo i cookie per migliorare la tua esperienza di navigazione e analizzare il nostro traffico. See our privacy policy.