Come costruire un chatbot AI: Guida completa passo dopo passo

Scopri come creare un chatbot AI da zero con la nostra guida completa. Trova i migliori strumenti, framework e il processo passo dopo passo per sviluppare siste...

Scopri come i chatbot AI elaborano il linguaggio naturale, comprendono le intenzioni degli utenti e generano risposte intelligenti. Approfondisci NLP, machine learning e architettura dei chatbot con dettagli tecnici.

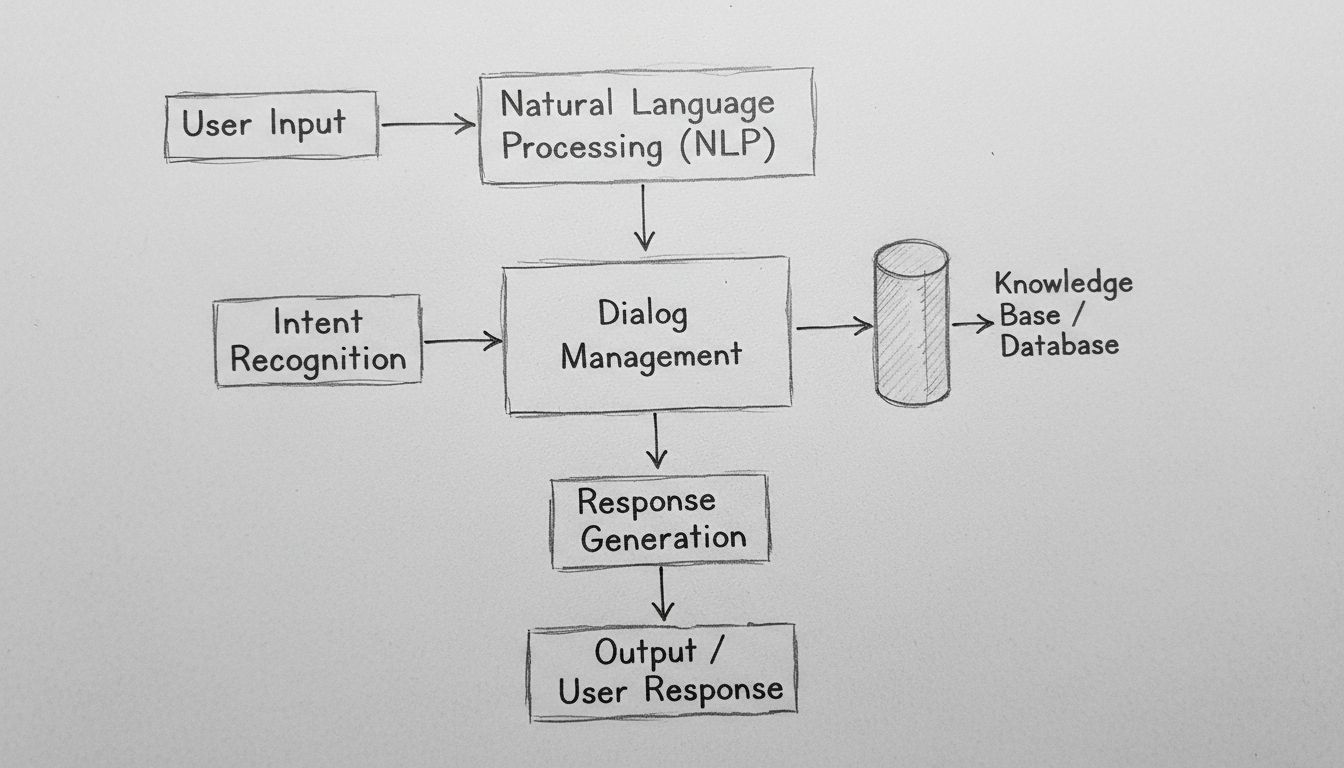

I chatbot AI funzionano elaborando l’input in linguaggio naturale tramite algoritmi NLP, riconoscendo l’intento dell’utente, accedendo a basi di conoscenza e generando risposte contestualmente rilevanti utilizzando modelli di machine learning. I chatbot moderni combinano tokenizzazione, estrazione di entità, gestione del dialogo e reti neurali per simulare conversazioni simili a quelle umane su larga scala.

I chatbot AI rappresentano una sofisticata convergenza di elaborazione del linguaggio naturale, machine learning e sistemi di gestione del dialogo che lavorano insieme per simulare una conversazione umana. Quando interagisci con un moderno chatbot AI, ti rapporti con un sistema tecnologico a più livelli che elabora il tuo input attraverso diverse fasi distinte prima di fornire una risposta. L’architettura alla base di questi sistemi si è evoluta drasticamente da semplici alberi decisionali basati su regole a reti neurali complesse in grado di comprendere il contesto, le sfumature e persino il sentimento. Comprendere come funzionano questi sistemi richiede di esaminare ogni componente della pipeline e riconoscere come interagiscono per creare esperienze conversazionali fluide.

Il percorso di ogni messaggio utente attraverso un chatbot AI inizia con l’elaborazione dell’input, una fase critica che trasforma il testo grezzo in dati strutturati che il sistema può analizzare. Quando scrivi un messaggio come “Devo reimpostare la mia password”, il chatbot non comprende immediatamente la tua intenzione: deve prima scomporre il messaggio in componenti gestibili. Questo processo, chiamato tokenizzazione, divide la frase in singole parole o unità significative chiamate token. Il sistema trasforma “Devo reimpostare la mia password” in token: [“Devo”, “reimpostare”, “la”, “mia”, “password”]. Questo passaggio apparentemente semplice è fondamentale perché consente al chatbot di analizzare ogni elemento linguistico in modo indipendente, mantenendo allo stesso tempo consapevolezza delle loro relazioni all’interno della struttura della frase.

Dopo la tokenizzazione, il sistema applica la normalizzazione, che standardizza il testo convertendolo in minuscolo, rimuovendo la punteggiatura e correggendo le varianti ortografiche comuni. In questo modo, “Reimpostazione Password,” “reimpostazione password” e “reimpostazion password” vengono tutte riconosciute come riferite allo stesso concetto. Il chatbot rimuove anche le stop word—parole comuni come “il,” “è,” “e,” e “di” che hanno poco significato semantico. Filtrandole, il sistema concentra le risorse computazionali sulle parole che veicolano realmente significato. Inoltre, il sistema esegue il tagging delle parti del discorso, identificando se ciascuna parola è un sostantivo, un verbo, un aggettivo o un’altra categoria grammaticale. Questa comprensione grammaticale aiuta il chatbot a riconoscere che “reimpostare” è un verbo d’azione nel tuo messaggio, fondamentale per determinare cosa vuoi realmente ottenere.

L’Elaborazione del Linguaggio Naturale (NLP) rappresenta il fondamento tecnologico che permette ai chatbot di comprendere il linguaggio umano a livello semantico. L’NLP comprende diverse tecniche interconnesse che lavorano insieme per estrarre significato dal testo. Il Named Entity Recognition (NER) identifica specifiche entità nel messaggio—nomi propri, date, luoghi, nomi di prodotti e altre informazioni importanti. Nell’esempio del reset password, il NER identificherebbe “password” come entità di sistema rilevante per la base di conoscenza del chatbot. Questa capacità diventa ancora più potente in scenari complessi: se scrivi “Voglio prenotare un volo da Roma a Londra il 15 dicembre”, il NER estrae la città di partenza, quella di destinazione e la data—tutte informazioni essenziali per soddisfare la richiesta.

L’analisi del sentimento rappresenta un altro componente chiave dell’NLP, permettendo ai chatbot di rilevare il tono emotivo del messaggio. Un cliente che dice “Aspetto da tre ore e non ho ancora ricevuto il mio ordine” esprime frustrazione, che il chatbot dovrebbe riconoscere per adattare il tono della risposta e dare priorità al problema. Le moderne analisi del sentimento utilizzano modelli di machine learning addestrati su migliaia di esempi per classificare il testo come positivo, negativo o neutro, e sempre più spesso per rilevare emozioni sfumate come frustrazione, confusione o soddisfazione. Questa intelligenza emotiva permette ai chatbot di rispondere con empatia e urgenza adeguate, migliorando significativamente la soddisfazione dei clienti.

Dopo aver elaborato il testo grezzo, il chatbot deve determinare cosa vuole realmente l’utente: la sua intenzione. Il riconoscimento delle intenzioni è una delle funzioni più critiche nell’architettura dei chatbot perché colma il divario tra ciò che gli utenti dicono e ciò che intendono ottenere. Il sistema utilizza classificatori di machine learning addestrati su migliaia di conversazioni di esempio per mappare le espressioni degli utenti su intenzioni predefinite. Ad esempio, le frasi “Ho dimenticato la password”, “Come reimposto la password?”, “Non riesco ad accedere” e “Il mio account è bloccato” possono tutte essere ricondotte alla stessa intenzione “reset_password”, anche se sono formulate in modo diverso.

Contemporaneamente, il sistema esegue l’estrazione delle entità, identificando dati specifici nel messaggio dell’utente rilevanti per soddisfare la richiesta. Se un cliente dice “Voglio passare al piano premium”, il sistema estrae due entità chiave: l’azione (“passare”) e l’obiettivo (“piano premium”). Queste entità estratte diventano parametri che guidano la generazione della risposta del chatbot. I chatbot avanzati utilizzano il dependency parsing per comprendere le relazioni grammaticali tra le parole, riconoscendo quali sostantivi sono soggetti, quali oggetti e come si relazionano a verbi e modificatori. Questa comprensione sintattica più profonda consente al chatbot di gestire frasi complesse e ambigue che confonderebbero sistemi più semplici.

La gestione del dialogo rappresenta il “cervello” del chatbot, responsabile del mantenimento del contesto della conversazione e della determinazione delle risposte appropriate. A differenza dei semplici sistemi di lookup, i gestori di dialoghi sofisticati mantengono uno stato di conversazione che traccia ciò che è stato discusso, quali informazioni sono state raccolte e qual è l’obiettivo attuale dell’utente. Questa consapevolezza contestuale consente conversazioni naturali e fluide in cui il chatbot ricorda gli scambi precedenti e può farvi riferimento in modo appropriato. Se chiedi “Che tempo fa a Milano?” e poi “E domani?”, il gestore del dialogo capisce che “domani” si riferisce alle previsioni per Milano, non per un’altra località.

Il gestore del dialogo implementa la gestione del contesto memorizzando informazioni rilevanti in un formato strutturato durante tutta la conversazione. Questo può includere le informazioni sull’account dell’utente, richieste precedenti, preferenze e l’argomento attuale della conversazione. I sistemi avanzati utilizzano macchine a stati o reti di attività gerarchiche per modellare i flussi conversazionali, definendo quali stati sono raggiungibili da altri e quali transizioni sono valide. Ad esempio, un chatbot per il servizio clienti può avere stati per “saluto”, “identificazione del problema”, “troubleshooting”, “escalation” e “risoluzione”. Il gestore del dialogo assicura che la conversazione progredisca logicamente attraverso questi stati, evitando salti casuali.

I chatbot AI moderni non generano risposte solo dai dati di addestramento: accedono a basi di conoscenza che contengono informazioni aggiornate e specifiche per l’organizzazione. Questa integrazione è fondamentale per garantire accuratezza e pertinenza. Quando un cliente chiede “Quanto è il saldo del mio conto?”, il chatbot deve interrogare davvero il sistema bancario per recuperare il saldo corrente, invece di generare un numero plausibile. Allo stesso modo, se viene chiesto “Quali sono gli orari del vostro negozio?”, il chatbot accede al database delle informazioni aziendali per fornire orari aggiornati e precisi.

Il Retrieval-Augmented Generation (RAG) rappresenta un approccio sofisticato all’integrazione della conoscenza, diventato sempre più importante nel 2025. I sistemi RAG prima recuperano documenti o informazioni rilevanti dalla base di conoscenza in base alla query dell’utente, quindi usano queste informazioni per generare una risposta contestualmente appropriata. Questo processo in due fasi migliora drasticamente l’accuratezza rispetto agli approcci puramente generativi. Ad esempio, se un cliente chiede una specifica funzione di un prodotto, il sistema RAG recupera la documentazione del prodotto, estrae la sezione rilevante e genera una risposta basata su quella reale, invece di affidarsi a informazioni potenzialmente inventate. Questo approccio è particolarmente prezioso negli ambienti enterprise dove accuratezza e conformità sono fondamentali.

Dopo aver compreso l’intento dell’utente e raccolto le informazioni necessarie, il chatbot deve generare una risposta appropriata. La generazione della risposta può seguire diversi approcci, ciascuno con vantaggi e limiti specifici. La generazione basata su template utilizza modelli di risposta predefiniti con slot variabili che vengono riempiti con informazioni specifiche. Ad esempio, un template può essere “Il tuo ordine #[ORDER_ID] arriverà il [DELIVERY_DATE].” Questo metodo è molto affidabile e prevedibile, ma limitato in flessibilità e naturalezza.

La generazione basata su regole applica regole linguistiche specifiche per costruire risposte in base all’intento e alle entità estratte. Queste regole possono specificare che, per l’intento “reset_password”, la risposta deve includere un messaggio di conferma, un link alla pagina di reset e istruzioni per i passaggi successivi. Questo approccio offre maggiore flessibilità rispetto ai template mantenendo affidabilità, ma richiede molta progettazione di regole per scenari complessi.

La generazione basata su reti neurali, alimentata da grandi modelli linguistici (LLM), rappresenta lo stato dell’arte nella generazione delle risposte. Questi sistemi utilizzano architetture di deep learning come i Transformer per generare risposte nuove, contestualmente appropriate e straordinariamente simili a quelle umane. Gli LLM moderni sono addestrati su miliardi di token di testo, apprendendo schemi statistici su come funziona il linguaggio e come i concetti si relazionano tra loro. Durante la generazione di una risposta, questi modelli predicono la parola successiva più probabile dato tutto il testo precedente, ripetendo il processo per costruire frasi complete. Il vantaggio della generazione neurale è la flessibilità e naturalezza; lo svantaggio è che questi sistemi possono talvolta “allucinare”—ovvero generare informazioni plausibili ma errate.

Il machine learning rappresenta il meccanismo grazie al quale i chatbot migliorano nel tempo. Piuttosto che essere sistemi statici con regole fisse, i chatbot moderni apprendono da ogni interazione, perfezionando gradualmente la comprensione dei pattern linguistici e delle intenzioni degli utenti. Il supervised learning prevede l’addestramento del chatbot su esempi etichettati dove gli umani hanno annotato l’intento corretto e le entità per migliaia di messaggi. L’algoritmo apprende a riconoscere pattern che distinguono un’intenzione dall’altra, costruendo un modello capace di classificare nuovi messaggi con alta accuratezza.

Il reinforcement learning consente ai chatbot di ottimizzare le risposte in base al feedback degli utenti. Quando un utente indica soddisfazione per una risposta (tramite feedback esplicito o segnali impliciti come la prosecuzione della conversazione), il sistema rafforza i pattern che hanno portato a quella risposta. Al contrario, quando gli utenti esprimono insoddisfazione o abbandonano la conversazione, il sistema apprende a evitare pattern simili in futuro. Questo ciclo di feedback crea un circolo virtuoso in cui le prestazioni del chatbot migliorano costantemente. I sistemi avanzati implementano l’apprendimento con l’uomo nel loop, in cui agenti umani revisionano conversazioni complesse e forniscono correzioni che il sistema assimila, accelerando notevolmente il miglioramento rispetto all’apprendimento puramente automatico.

I Grandi Modelli Linguistici (LLM) hanno trasformato radicalmente le capacità dei chatbot dal 2023. Questi modelli, addestrati su centinaia di miliardi di token di testo, sviluppano una comprensione sofisticata del linguaggio, del contesto e della conoscenza specifica di dominio. Modelli come GPT-4, Claude e Gemini possono sostenere conversazioni sfumate, comprendere istruzioni complesse e generare risposte coerenti e contestuali su una vasta gamma di argomenti. La potenza degli LLM deriva dalla loro architettura transformer, che utilizza meccanismi di attenzione per comprendere le relazioni tra parole distanti in una frase, consentendo al modello di mantenere il contesto anche in conversazioni lunghe.

Tuttavia, gli LLM hanno limiti che le organizzazioni devono affrontare. Possono allucinare—ovvero generare con sicurezza informazioni false ma plausibili. Possono avere difficoltà con informazioni molto recenti non presenti nei dati di addestramento. Possono mostrare bias presenti nei dati di partenza. Per affrontare questi limiti, le organizzazioni adottano sempre più il fine-tuning per adattare i LLM generici a domini specifici e il prompt engineering per guidare i modelli verso comportamenti desiderati. L’approccio di FlowHunt alla costruzione di chatbot sfrutta questi modelli avanzati fornendo al contempo guardrail e integrazione con fonti di conoscenza per garantire accuratezza e affidabilità.

| Aspetto | Chatbot Basati su Regole | Chatbot AI | Chatbot Basati su LLM |

|---|---|---|---|

| Tecnologia | Alberi decisionali, pattern matching | NLP, algoritmi ML, riconoscimento intenzioni | Grandi modelli linguistici, transformer |

| Flessibilità | Limitata alle regole predefinite | Si adatta a variazioni di fraseggio | Altissima, gestisce input nuovi |

| Accuratezza | Alta per scenari definiti | Buona con training adeguato | Eccellente, ma richiede guardrail |

| Apprendimento | Nessuna capacità di apprendere | Impara dalle interazioni | Impara da fine-tuning e feedback |

| Rischio Allucinazioni | Nessuno | Minimo | Richiede strategie di mitigazione |

| Tempo di Implementazione | Rapido | Moderato | Rapido con piattaforme come FlowHunt |

| Manutenzione | Alta (aggiornamento regole) | Moderata | Moderata (update modelli, monitoring) |

| Costo | Basso | Moderato | Moderato-alto |

| Migliori Casi d’Uso | FAQ semplici, routing base | Assistenza clienti, qualificazione lead | Ragionamento complesso, generazione contenuti |

I chatbot moderni sfruttano l’architettura Transformer, un design di rete neurale che ha rivoluzionato l’elaborazione del linguaggio naturale. I Transformer utilizzano meccanismi di attenzione che consentono al modello di concentrarsi sulle parti rilevanti dell’input durante la generazione di ogni parola dell’output. Quando si elabora “Il direttore della banca era preoccupato per l’erosione della riva del fiume”, il meccanismo di attenzione aiuta il modello a capire che la prima “banca” si riferisce a un istituto finanziario mentre la seconda indica la riva del fiume, in base al contesto. Questa comprensione contestuale è molto superiore agli approcci precedenti che processavano il testo in sequenza senza questa consapevolezza.

L’attenzione multi-head estende questo concetto, permettendo al modello di focalizzarsi su diversi aspetti dell’input contemporaneamente. Una testa di attenzione può concentrarsi sulle relazioni grammaticali, un’altra su quelle semantiche, un’altra ancora sulla struttura discorsiva. Questa elaborazione parallela di fenomeni linguistici consente al modello di costruire rappresentazioni ricche e sfumate del significato. Il positional encoding nei Transformer permette al modello di comprendere l’ordine delle parole pur processando tutti i token in parallelo, capacità cruciale per comprendere un linguaggio dove l’ordine delle parole porta significato.

FlowHunt rappresenta un approccio moderno allo sviluppo di chatbot che astrae gran parte della complessità tecnica mantenendo l’accesso a potenti capacità AI. Invece di richiedere ai team di costruire da zero l’infrastruttura dei chatbot, FlowHunt offre un builder visuale in cui anche utenti non tecnici possono progettare flussi conversazionali collegando componenti che rappresentano diverse funzioni del chatbot. La piattaforma gestisce l’NLP sottostante, il riconoscimento delle intenzioni e la generazione delle risposte, consentendo ai team di concentrarsi sulla progettazione dell’esperienza conversazionale e sull’integrazione con i sistemi aziendali.

La funzione Knowledge Sources di FlowHunt permette ai chatbot di accedere in tempo reale a informazioni da documenti, siti web e database, implementando i principi RAG per garantire accuratezza. La funzionalità AI Agents della piattaforma consente di costruire sistemi autonomi capaci di agire oltre la conversazione—aggiornando database, inviando email, programmando appuntamenti o attivando workflow. Questo rappresenta un’evoluzione significativa rispetto ai chatbot tradizionali che si limitano a fornire informazioni: i sistemi basati su FlowHunt possono realmente svolgere compiti per conto degli utenti. Le capacità di integrazione della piattaforma collegano i chatbot a sistemi CRM, helpdesk e applicazioni aziendali, permettendo un flusso dati e azioni senza soluzione di continuità.

Un deployment efficace di chatbot richiede il monitoraggio di metriche chiave che indicano se il sistema sta raggiungendo gli obiettivi aziendali. L’accuratezza nel riconoscimento delle intenzioni misura quale percentuale di messaggi degli utenti viene classificata correttamente nella categoria prevista. L’accuratezza nell’estrazione delle entità valuta se il sistema identifica correttamente i dati rilevanti. Gli score di soddisfazione degli utenti, raccolti tramite survey post-conversazione, indicano se gli utenti hanno trovato utile l’interazione. Il tasso di completamento delle conversazioni misura la percentuale di conversazioni che si concludono con la risoluzione del problema senza escalation a un operatore umano.

La latenza della risposta misura quanto rapidamente il chatbot genera le risposte—fondamentale per l’esperienza utente, poiché ritardi superiori a pochi secondi riducono drasticamente la soddisfazione. Il tasso di escalation indica la percentuale di conversazioni che necessitano il passaggio a operatori umani; tassi più bassi generalmente segnalano migliori prestazioni del chatbot. Il costo per conversazione misura l’efficienza economica del chatbot, confrontando il costo dell’elaborazione AI rispetto a quello di un operatore umano. Le organizzazioni dovrebbero stabilire metriche di baseline prima del deployment e monitorarle costantemente per individuare opportunità di miglioramento e garantire che il chatbot continui a generare valore man mano che evolvono i pattern di utilizzo.

I chatbot gestiscono frequentemente informazioni sensibili, tra cui dati personali, finanziari e dettagli aziendali riservati. La crittografia dei dati garantisce che le informazioni trasmesse tra utenti e sistemi chatbot siano protette da intercettazioni. I meccanismi di autenticazione verificano l’identità degli utenti prima di fornire accesso a informazioni sensibili. I controlli di accesso assicurano che i chatbot accedano solo ai dati strettamente necessari per la loro funzione, seguendo il principio del minimo privilegio. Le organizzazioni devono implementare audit log per mantenere traccia di tutte le interazioni dei chatbot a fini di conformità e sicurezza.

I principi di privacy by design devono guidare lo sviluppo dei chatbot, garantendo che la raccolta dei dati personali sia minimizzata, la conservazione dei dati sia limitata allo stretto necessario e che gli utenti abbiano visibilità su quali dati vengono raccolti e come vengono utilizzati. La conformità alle normative come GDPR, CCPA e requisiti di settore come HIPAA o PCI-DSS è essenziale. Le organizzazioni dovrebbero condurre security assessment dei propri sistemi chatbot per identificare vulnerabilità e implementare adeguate contromisure. La responsabilità per la sicurezza va oltre la piattaforma chatbot stessa e include anche le basi di conoscenza, le integrazioni e i sistemi backend cui il chatbot accede.

L’evoluzione della tecnologia chatbot continua ad accelerare. I chatbot multimodali che elaborano e generano testo, voce, immagini e video contemporaneamente rappresentano la prossima frontiera. Oltre alle interazioni testuali, gli utenti potranno sempre più spesso interagire con i chatbot tramite la modalità preferita—voce per scenari hands-free, immagini per domande visive sui prodotti, video per dimostrazioni complesse. L’intelligenza emotiva nei chatbot andrà oltre il semplice rilevamento del sentimento, arrivando a comprendere in modo sfumato lo stato emotivo degli utenti e rispondere con empatia adeguata. I chatbot riconosceranno quando gli utenti sono frustrati, confusi o soddisfatti e adatteranno di conseguenza stile di comunicazione e risposte.

L’assistenza proattiva rappresenta un’altra capacità emergente, in cui i chatbot anticipano i bisogni degli utenti prima ancora che questi li esprimano esplicitamente. Invece di attendere domande, i chatbot identificheranno pattern che indicano potenziali problemi e offriranno assistenza proattivamente. La personalizzazione diventerà sempre più sofisticata, con chatbot che adattano stile comunicativo, raccomandazioni e assistenza in base alle preferenze, alla storia e al contesto dell’utente. L’integrazione con sistemi autonomi permetterà ai chatbot di coordinarsi con RPA, dispositivi IoT e altri sistemi automatizzati per svolgere compiti complessi che coinvolgono più sistemi e richiedono orchestrazione.

Comprendere come funzionano i chatbot AI spiega perché sono diventati strumenti essenziali per le aziende di ogni settore. L’interazione sofisticata tra NLP, machine learning, gestione del dialogo e integrazione della conoscenza permette ai chatbot di gestire compiti sempre più complessi mantenendo interazioni naturali e simili a quelle umane. Le organizzazioni che implementano efficacemente i chatbot—utilizzando piattaforme come FlowHunt che astraggono la complessità tecnica ma mantengono potenti funzionalità—ottengono vantaggi competitivi significativi grazie a una maggiore soddisfazione dei clienti, riduzione dei costi operativi e tempi di risposta più rapidi.

La tecnologia continua a evolversi rapidamente, con i progressi nei grandi modelli linguistici, nelle capacità multimodali e negli agenti autonomi che espandono le possibilità. Le organizzazioni dovrebbero considerare l’implementazione dei chatbot non come un progetto una tantum, ma come una capacità continua che migliora nel tempo attraverso apprendimento, ottimizzazione e arricchimento costanti. Le implementazioni di maggior successo combinano tecnologia AI avanzata con una progettazione attenta delle conversazioni, guardrail adeguati per garantire accuratezza e sicurezza, e integrazione con i sistemi aziendali che consentono ai chatbot di agire concretamente. Nel 2025 e oltre, i chatbot diventeranno sempre più l’interfaccia principale tra clienti, dipendenti e organizzazioni, rendendo strategico l’investimento in questa tecnologia per il successo aziendale.

Smetti di gestire manualmente richieste clienti ripetitive. Il builder no-code di chatbot AI di FlowHunt ti permette di creare chatbot intelligenti e autonomi che gestiscono assistenza clienti, generazione lead e supporto 24/7. Distribuisci in pochi minuti, non settimane.

Scopri come creare un chatbot AI da zero con la nostra guida completa. Trova i migliori strumenti, framework e il processo passo dopo passo per sviluppare siste...

Scopri come costruire un chatbot AI per Discord con istruzioni passo passo, metodi di integrazione API, gestione degli errori, best practice di sicurezza e opzi...

Scopri i modi migliori per salutare i chatbot AI e ottimizzare le tue interazioni. Tecniche di saluto, suggerimenti di prompt engineering e strategie di comunic...

Consenso Cookie

Usiamo i cookie per migliorare la tua esperienza di navigazione e analizzare il nostro traffico. See our privacy policy.