Osservabilità di FlowHunt in PowerBI

Scopri come integrare FlowHunt con PowerBI, configurare le impostazioni di osservabilità e visualizzare le metriche del tuo workspace FlowHunt direttamente nei ...

Questo articolo spiega come collegare FlowHunt a Langfuse per un’osservabilità completa, tracciare le prestazioni dei workflow AI e sfruttare le dashboard di Langfuse per monitorare e ottimizzare il tuo workspace FlowHunt.

Quando i tuoi workflow AI in FlowHunt crescono, capire cosa accade dietro le quinte diventa fondamentale. Domande come “Perché questo workflow è lento?”, “Quanti token sto consumando?” o “Dove si verificano gli errori?” richiedono una visibilità dettagliata sul sistema.

Senza una corretta osservabilità, il debug dei workflow AI è come volare alla cieca: vedi i risultati ma ti perdi il percorso. Strumenti di tracciamento come Langfuse risolvono questo problema catturando ogni passaggio dell’esecuzione del workflow, offrendo approfondimenti granulari su prestazioni, costi e comportamento.

Questo articolo spiega come collegare in modo semplice FlowHunt a Langfuse, abilitando un’osservabilità completa su tutti i tuoi workflow AI. Imparerai a tracciare i percorsi di esecuzione, monitorare l’uso dei token, individuare colli di bottiglia e visualizzare metriche di performance — tutto in una dashboard centralizzata.

Alla fine, avrai visibilità totale sul tuo workspace FlowHunt, potendo ottimizzare i workflow, ridurre i costi e garantire l’affidabilità.

L’osservabilità è la pratica di strumentare il sistema per comprenderne lo stato interno tramite output esterni — principalmente tracciamenti, metriche e log.

Per gli utenti FlowHunt che gestiscono workflow AI, l’osservabilità garantisce visibilità su:

Senza osservabilità, la diagnosi dei problemi diventa reattiva e dispendiosa in termini di tempo. Con essa, ottieni insight proattivi che permettono ottimizzazione continua e risoluzione rapida dei problemi.

Langfuse è una piattaforma open-source per osservabilità e analisi progettata specificamente per applicazioni LLM. Cattura tracciamenti dettagliati delle esecuzioni dei workflow AI, fornendo a sviluppatori e team le informazioni necessarie per effettuare il debug, monitorare e ottimizzare i sistemi AI.

Le principali funzionalità di Langfuse includono:

Collegando Langfuse a FlowHunt, trasformi i dati grezzi di esecuzione in informazioni utili — identificando cosa funziona, cosa no e dove concentrare gli sforzi di ottimizzazione.

Seguendo questa guida, sarai in grado di:

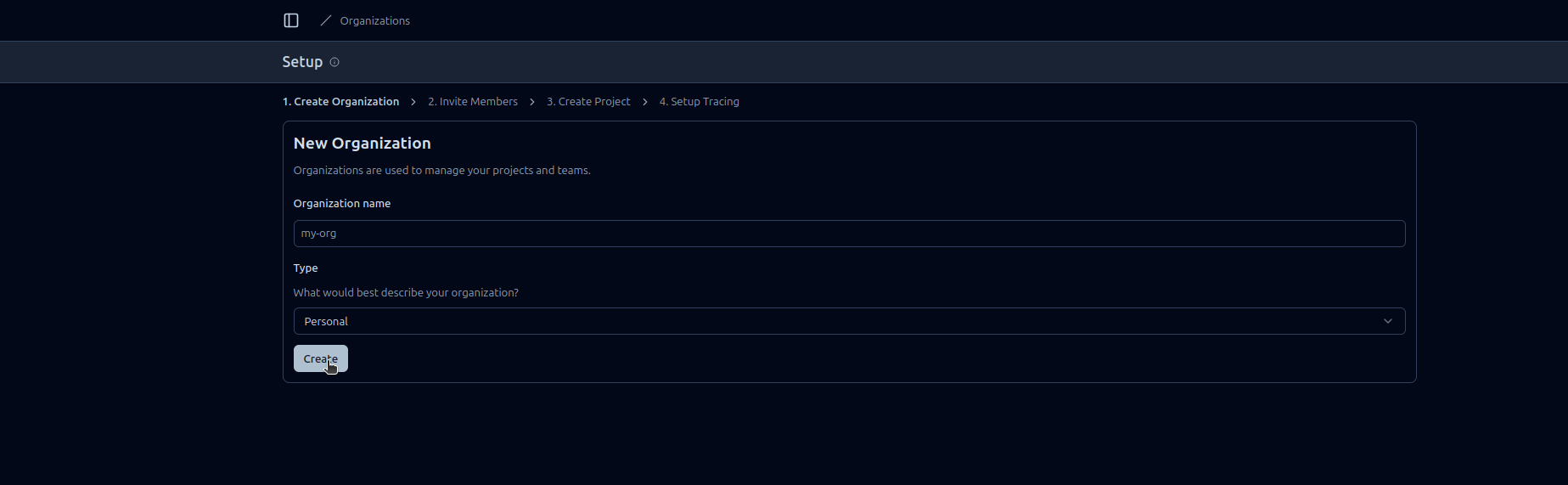

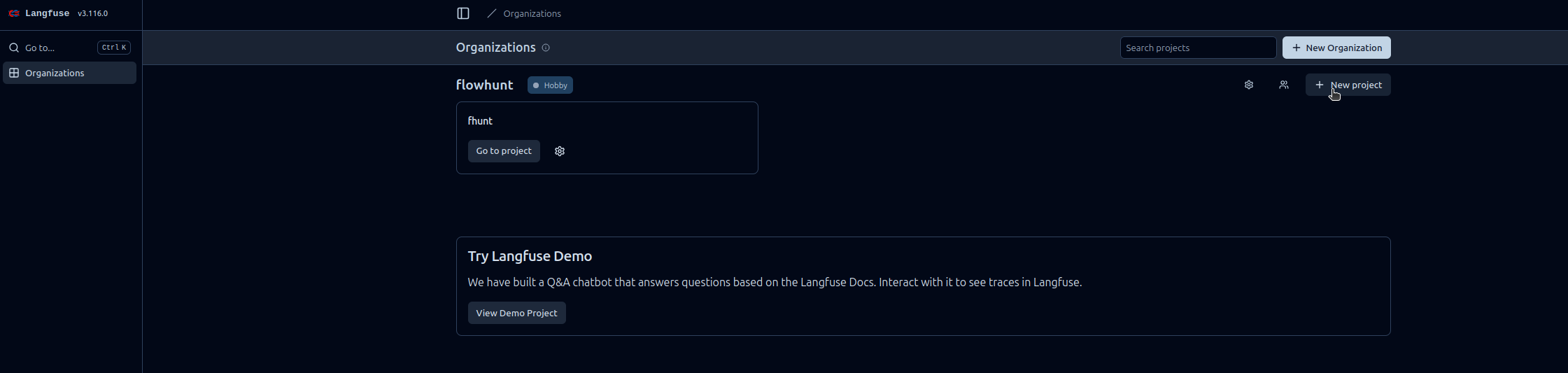

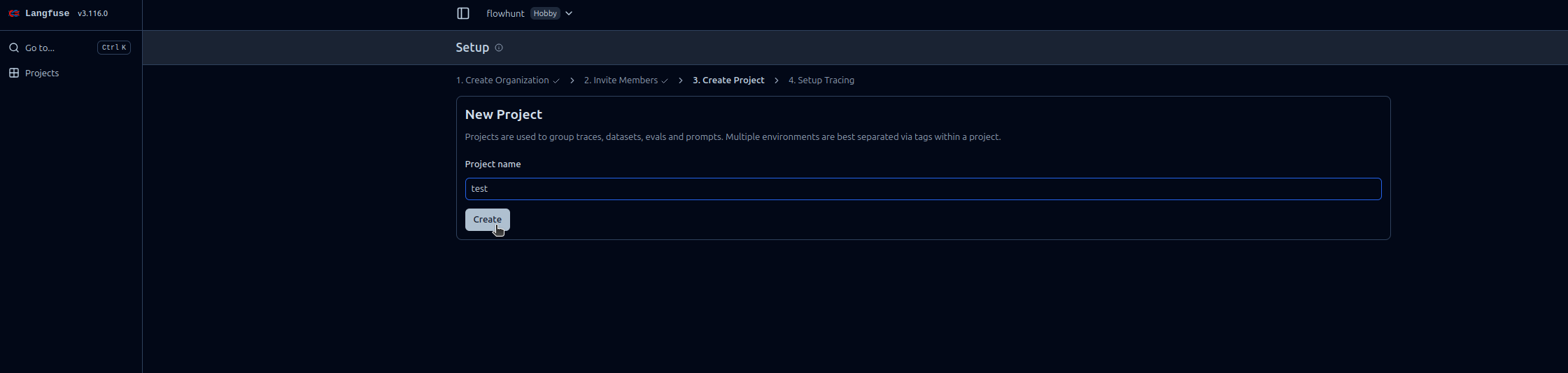

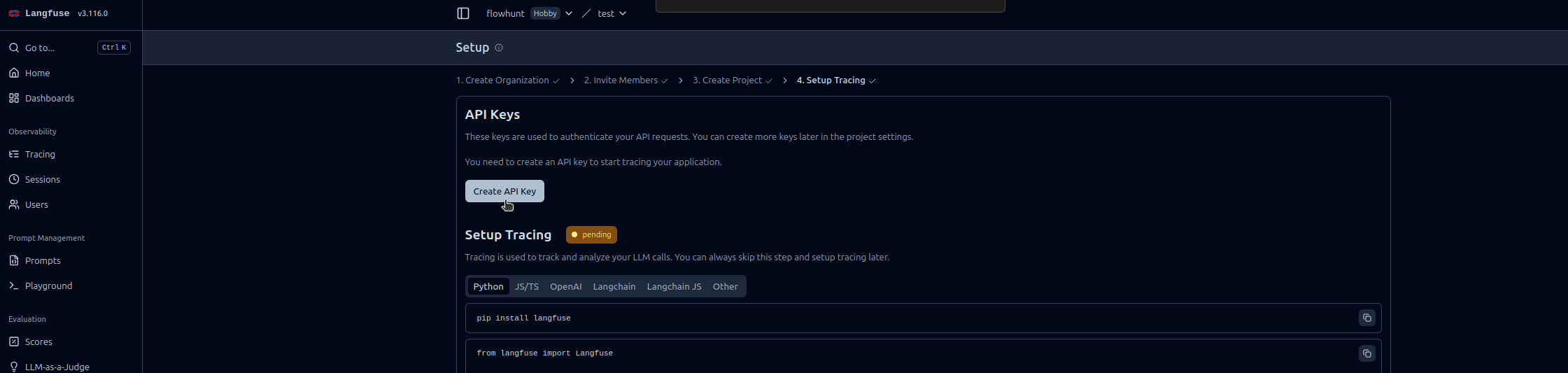

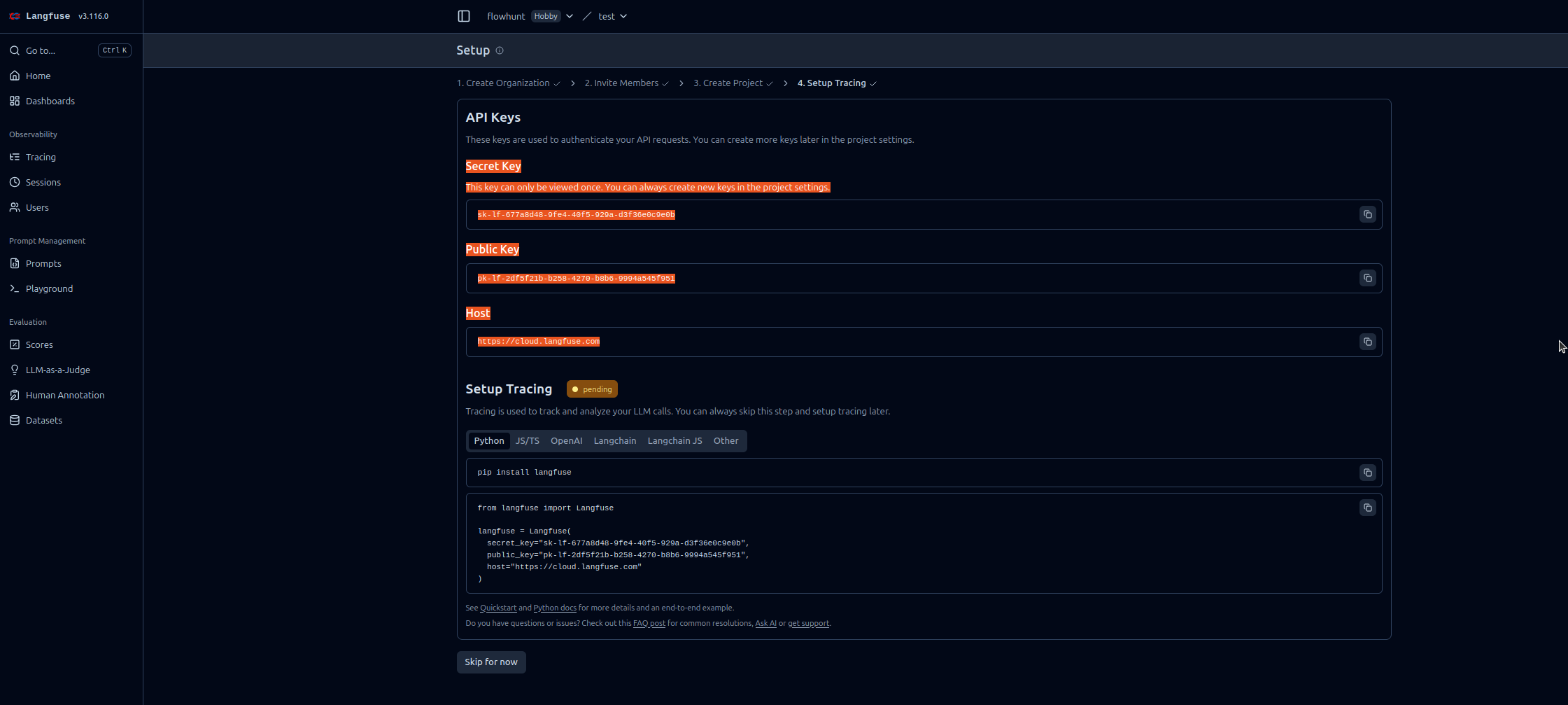

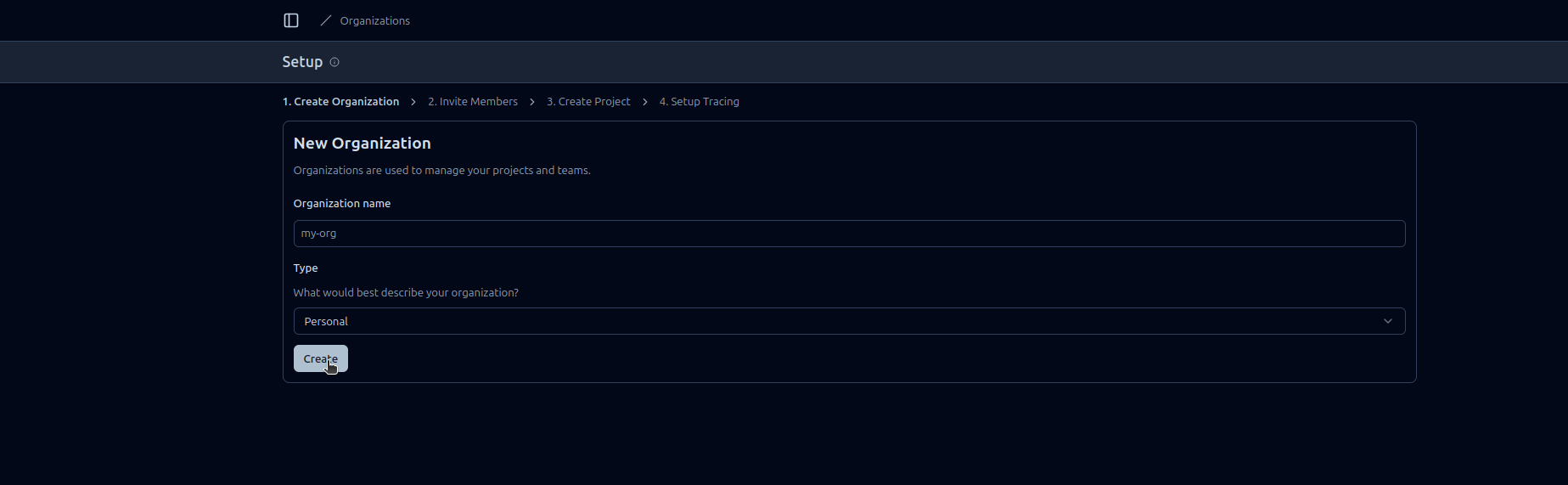

Segui queste istruzioni passo-passo per abilitare l’Osservabilità di FlowHunt in Langfuse:

https://cloud.langfuse.com)

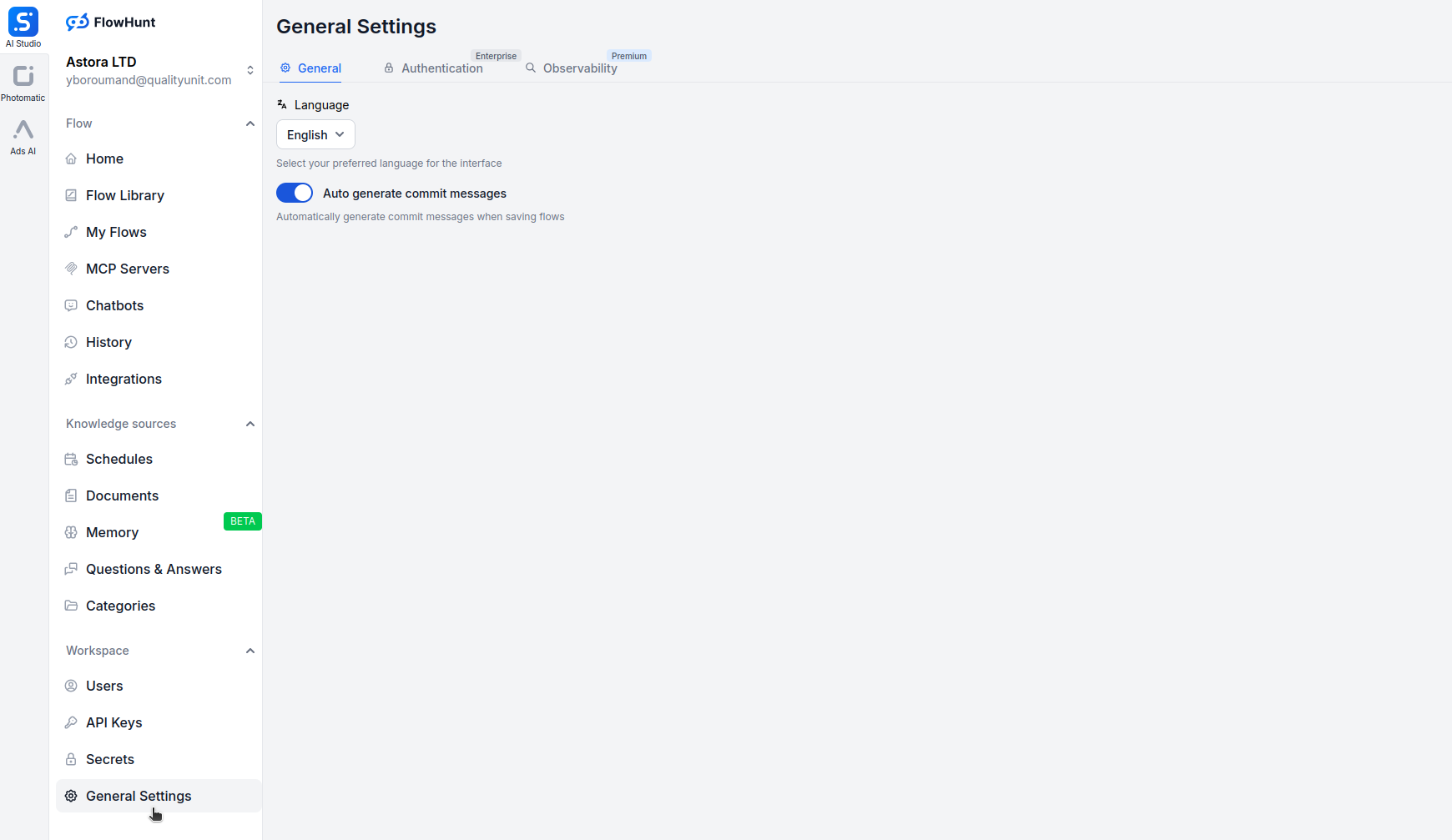

Apri app.flowhunt.io nel browser.

Vai su Impostazioni generali (di solito accessibili dalla sidebar o dal menu in alto).

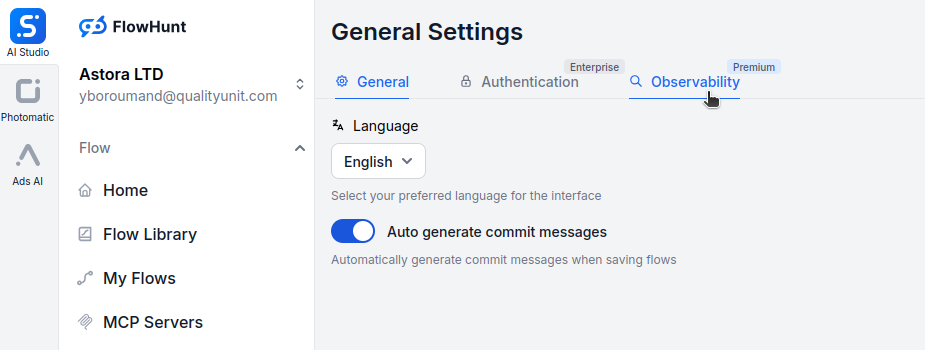

Scorri in fondo e clicca sulla scheda Osservabilità.

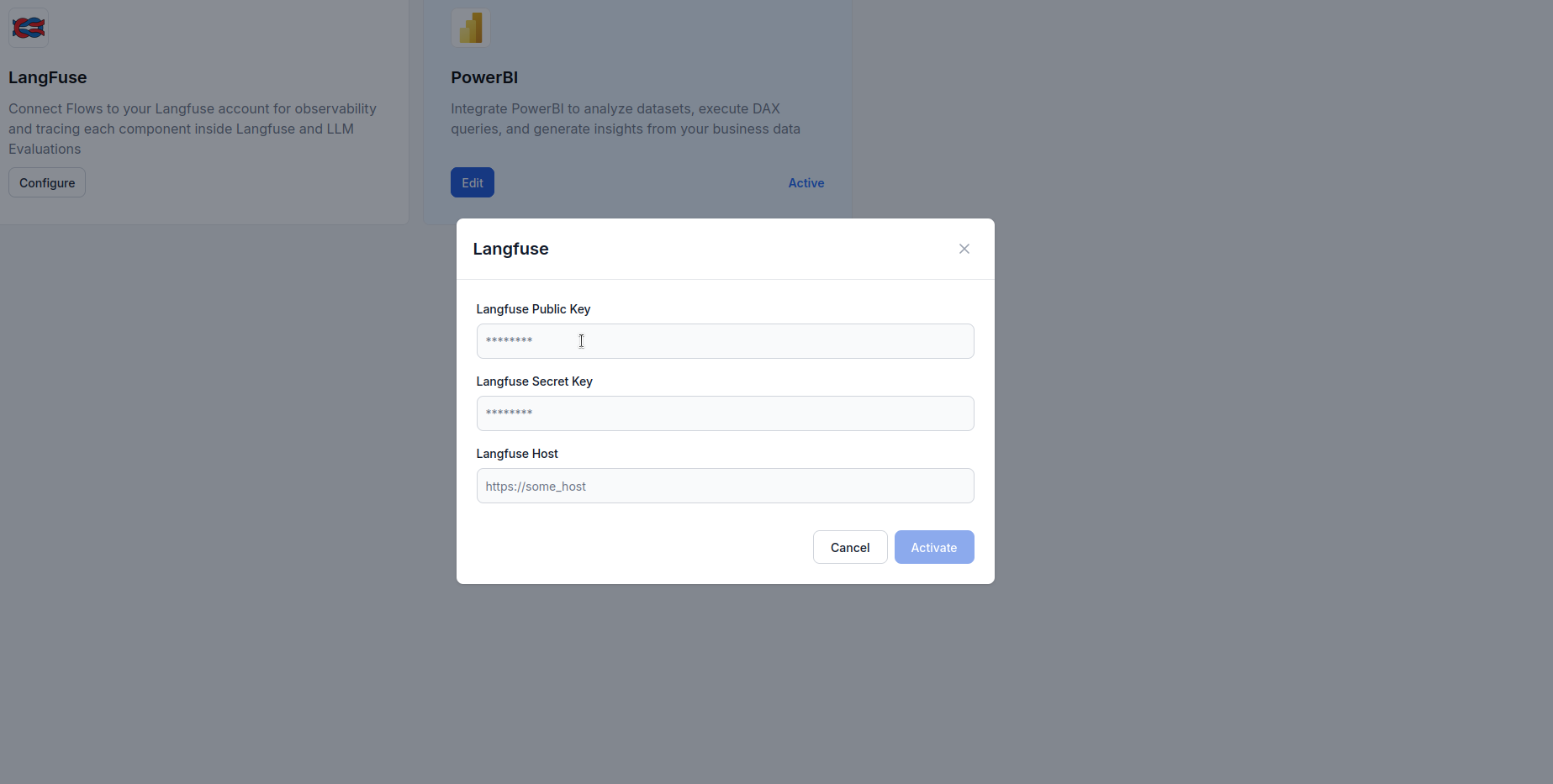

Trova il box Langfuse e clicca su Configura.

https://cloud.langfuse.com)

Una volta che FlowHunt è collegato a Langfuse, hai accesso a potenti capacità di visualizzazione e analisi. Ecco alcuni esempi di insight che puoi generare:

Visualizza una timeline dettagliata di ogni esecuzione del workflow, mostrando:

Questo aiuta a individuare colli di bottiglia e comprendere il comportamento del workflow a livello granulare.

Monitora il consumo di token nei workflow:

Questo consente di ottimizzare i costi identificando le operazioni più dispendiose in token.

Tieni traccia dei principali indicatori di performance:

Queste metriche aiutano a mantenere gli SLA e ottimizzare l’esperienza utente.

Individua e diagnostica i guasti:

Questo accelera la risoluzione dei problemi e migliora l’affidabilità.

Per agenti AI conversazionali, monitora:

Questo aiuta a ottimizzare il comportamento degli agenti e l’esperienza utente.

Confronta le prestazioni tra diversi provider LLM:

Questi dati guidano le decisioni di selezione dei modelli in base all’uso reale.

Integrare FlowHunt con Langfuse trasforma i tuoi workflow AI da scatole nere a sistemi trasparenti e ottimizzabili. Grazie al tracciamento completo, ottieni visibilità su ogni step di esecuzione, potendo prendere decisioni basate sui dati su prestazioni, costi e affidabilità.

L’integrazione di osservabilità Langfuse rende il monitoraggio semplice: da una rapida configurazione con chiave API alle dashboard ricche e utili che mostrano esattamente come si comportano i tuoi workflow in produzione.

Ora che il tuo workspace FlowHunt è collegato a Langfuse, hai le basi per un miglioramento continuo: individua i colli di bottiglia, ottimizza l’uso dei token, riduci la latenza e assicurati che i tuoi sistemi AI offrano il massimo valore con piena fiducia.

L'osservabilità in FlowHunt si riferisce alla capacità di monitorare, tracciare e analizzare come i workflow AI, gli agenti e le automazioni si comportano in tempo reale. Aiuta gli utenti a rilevare colli di bottiglia, monitorare l'uso dei token, misurare la latenza e prendere decisioni di ottimizzazione basate sui dati.

Langfuse è una piattaforma open-source per l'ingegneria LLM progettata per tracciare, monitorare e analizzare applicazioni AI. Integrandolo con FlowHunt, offre approfondimenti dettagliati su esecuzione dei workflow, consumo di token, prestazioni dei modelli e tracciamento degli errori.

No, l'integrazione è semplice. Basta creare un account Langfuse, generare le chiavi API e incollarle nelle impostazioni di osservabilità di FlowHunt. Non sono richieste competenze di programmazione.

Una volta collegato, puoi tracciare i tracciamenti di esecuzione, l'uso dei token, i costi dei modelli, le metriche di latenza, i tassi di errore, le prestazioni dei workflow nel tempo e analisi dettagliate passo-passo delle interazioni degli agenti AI.

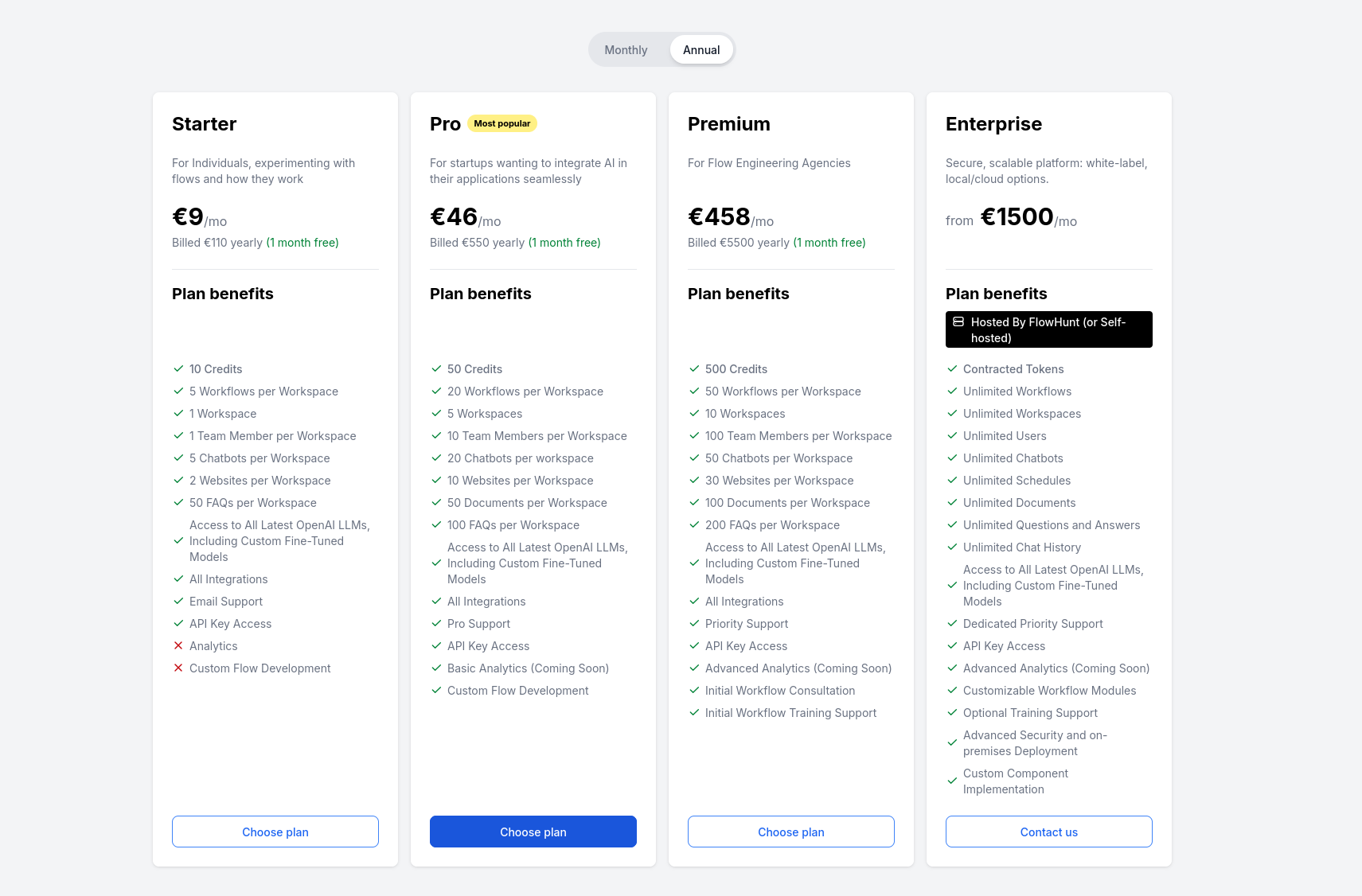

Langfuse offre un piano gratuito che include funzionalità base di tracciamento e osservabilità. Per team più grandi e analitiche avanzate, Langfuse propone piani a pagamento con capacità aggiuntive.

Scopri come integrare FlowHunt con PowerBI, configurare le impostazioni di osservabilità e visualizzare le metriche del tuo workspace FlowHunt direttamente nei ...

Una guida completa alla tariffazione di FlowHunt, inclusa la spiegazione di come funzionano i crediti e le interazioni, come la complessità incide sui costi e c...

Esplora l'importanza della registrazione nei flussi di lavoro AI, come FlowHunt consente log dettagliati per chiamate di strumenti e task, e le migliori pratich...

Consenso Cookie

Usiamo i cookie per migliorare la tua esperienza di navigazione e analizzare il nostro traffico. See our privacy policy.