Integrazione del Server Kibela MCP

Il Server Kibela MCP collega gli assistenti AI agli spazi di lavoro Kibela, consentendo una ricerca documentale senza interruzioni, gestione della conoscenza e ...

Collega direttamente la tua piattaforma dati Keboola agli strumenti AI, automatizza pipeline ETL, gestisci i metadati ed esegui trasformazioni SQL ovunque ti trovi con il Keboola MCP Server.

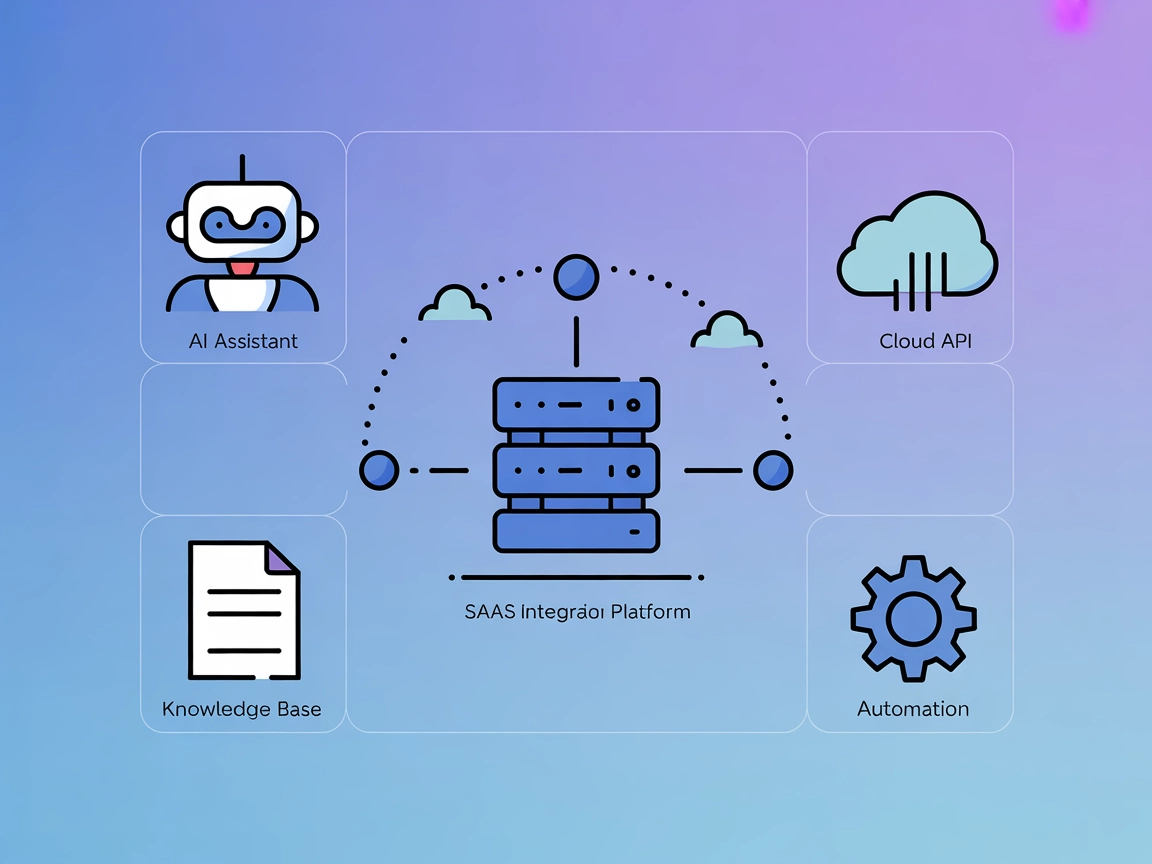

FlowHunt fornisce un livello di sicurezza aggiuntivo tra i tuoi sistemi interni e gli strumenti AI, dandoti controllo granulare su quali strumenti sono accessibili dai tuoi server MCP. I server MCP ospitati nella nostra infrastruttura possono essere integrati perfettamente con il chatbot di FlowHunt così come con le piattaforme AI popolari come ChatGPT, Claude e vari editor AI.

Keboola MCP Server agisce come un bridge open-source tra il tuo progetto Keboola e strumenti di intelligenza artificiale moderni. Collega assistenti AI e client MCP (come Claude, Cursor, Windsurf, VS Code e altri) alla piattaforma Keboola, esponendo funzionalità come accesso allo storage, trasformazioni SQL, gestione componenti e attivazione di job come strumenti richiamabili. Questa integrazione permette a modelli e agenti AI di interrogare tabelle, gestire configurazioni, eseguire job e interagire con i metadati direttamente dal loro ambiente. In questo modo, semplifica i flussi di lavoro di sviluppo, elimina il codice di collegamento e garantisce che dati e funzionalità giuste siano disponibili agli agenti AI quando necessario, aumentando la produttività e abilitando scenari di automazione complessi.

In base alle funzionalità del repository e alla documentazione disponibile, i seguenti strumenti sono forniti dal Keboola MCP Server:

uv installati.{

"mcpServers": {

"keboola-mcp": {

"command": "uv",

"args": ["pip", "run", "--", "keboola-mcp-server"]

}

}

}

{

"mcpServers": {

"keboola-mcp": {

"command": "uv",

"args": ["pip", "run", "--", "keboola-mcp-server"],

"env": {

"KBC_STORAGE_TOKEN": "${KBC_STORAGE_TOKEN}",

"KBC_WORKSPACE_SCHEMA": "${KBC_WORKSPACE_SCHEMA}"

},

"inputs": {

"KBC_STORAGE_TOKEN": "env",

"KBC_WORKSPACE_SCHEMA": "env"

}

}

}

}

uv siano installati.{

"mcpServers": {

"keboola-mcp": {

"command": "uv",

"args": ["pip", "run", "--", "keboola-mcp-server"]

}

}

}

uv.{

"mcpServers": {

"keboola-mcp": {

"command": "uv",

"args": ["pip", "run", "--", "keboola-mcp-server"]

}

}

}

uv siano installati.{

"mcpServers": {

"keboola-mcp": {

"command": "uv",

"args": ["pip", "run", "--", "keboola-mcp-server"]

}

}

}

Nota: Proteggi le credenziali sensibili come i token API utilizzando variabili d’ambiente come mostrato nell’esempio Windsurf sopra.

Utilizzo di MCP in FlowHunt

Per integrare MCP server nel tuo workflow FlowHunt, inizia aggiungendo il componente MCP al tuo flow e collegandolo al tuo agente AI:

Clicca sul componente MCP per aprire il pannello di configurazione. Nella sezione di configurazione MCP di sistema, inserisci i dettagli del tuo server MCP usando questo formato JSON:

{

"keboola-mcp": {

"transport": "streamable_http",

"url": "https://yourmcpserver.example/pathtothemcp/url"

}

}

Una volta configurato, l’agente AI può usare questo MCP come strumento con accesso a tutte le sue funzioni e capacità. Ricorda di cambiare “keboola-mcp” con il nome effettivo del tuo MCP server e sostituire l’URL con quello del tuo server MCP.

| Sezione | Disponibilità | Dettagli/Note |

|---|---|---|

| Panoramica | ✅ | Sommario e funzionalità disponibili da README.md |

| Elenco dei Prompt | ⛔ | Nessun template di prompt esplicito trovato |

| Elenco delle Risorse | ⛔ | Nessuna risorsa MCP esplicita menzionata |

| Elenco degli Strumenti | ✅ | Storage, Componenti, SQL, Job, Metadati descritti nelle funzionalità |

| Protezione Chiavi API | ✅ | Modello di variabile d’ambiente mostrato in README |

| Supporto Sampling (meno importante in valutazione) | ⛔ | Nessuna menzione al supporto sampling |

La mia valutazione: Il Keboola MCP Server offre un set robusto di strumenti e istruzioni di configurazione chiare, ma manca di template di prompt documentati e definizioni esplicite di risorse MCP. Il suo focus sull’abilitare agenti AI ad accedere a workflow dati complessi è solido. Sampling e supporto roots non sono documentati. Nel complesso, è un MCP molto pratico e pronto per la produzione, con qualche lacuna documentale su prompt/risorse.

| Ha una LICENSE | ✅ (MIT) |

|---|---|

| Ha almeno uno strumento | ✅ |

| Numero di Fork | 12 |

| Numero di Star | 64 |

Il Keboola MCP Server è un bridge open-source che collega il tuo progetto Keboola a client e assistenti AI, esponendo funzionalità come accesso allo storage, trasformazioni SQL, gestione componenti e orchestrazione dei job come strumenti richiamabili. Questo permette l’automazione avanzata e flussi di lavoro AI-driven direttamente da ambienti come FlowHunt, Claude, Cursor e altri.

Keboola MCP Server mette a disposizione strumenti per: interrogare e gestire tabelle nello storage Keboola, creare ed eseguire trasformazioni SQL tramite linguaggio naturale, gestire extractor, writer e app dati, eseguire e monitorare job e gestire i metadati del progetto.

Si raccomanda di utilizzare variabili d’ambiente per memorizzare informazioni sensibili come i token API. Gli esempi di configurazione sopra mostrano come referenziare le credenziali tramite variabili d’ambiente in ogni client supportato.

Puoi automatizzare pipeline ETL, permettere agli agenti AI di interrogare e modificare dati, orchestrare job, gestire configurazioni, eseguire trasformazioni SQL e aggiornare documentazione/metadati di progetto—tutto direttamente dal tuo strumento AI o di sviluppo preferito.

Aggiungi il componente MCP nel tuo flow di FlowHunt, configurandolo con i dettagli del tuo Keboola MCP Server (nome e URL) e collegalo al tuo agente AI. Questo abilita automazione AI e accesso ai dati all’interno dei tuoi flussi.

Dai ai tuoi agenti AI la possibilità di accedere, trasformare e orchestrare dati in Keboola. Prova il Keboola MCP Server con FlowHunt per semplificare i flussi di lavoro e automatizzare le tue operazioni dati.

Il Server Kibela MCP collega gli assistenti AI agli spazi di lavoro Kibela, consentendo una ricerca documentale senza interruzioni, gestione della conoscenza e ...

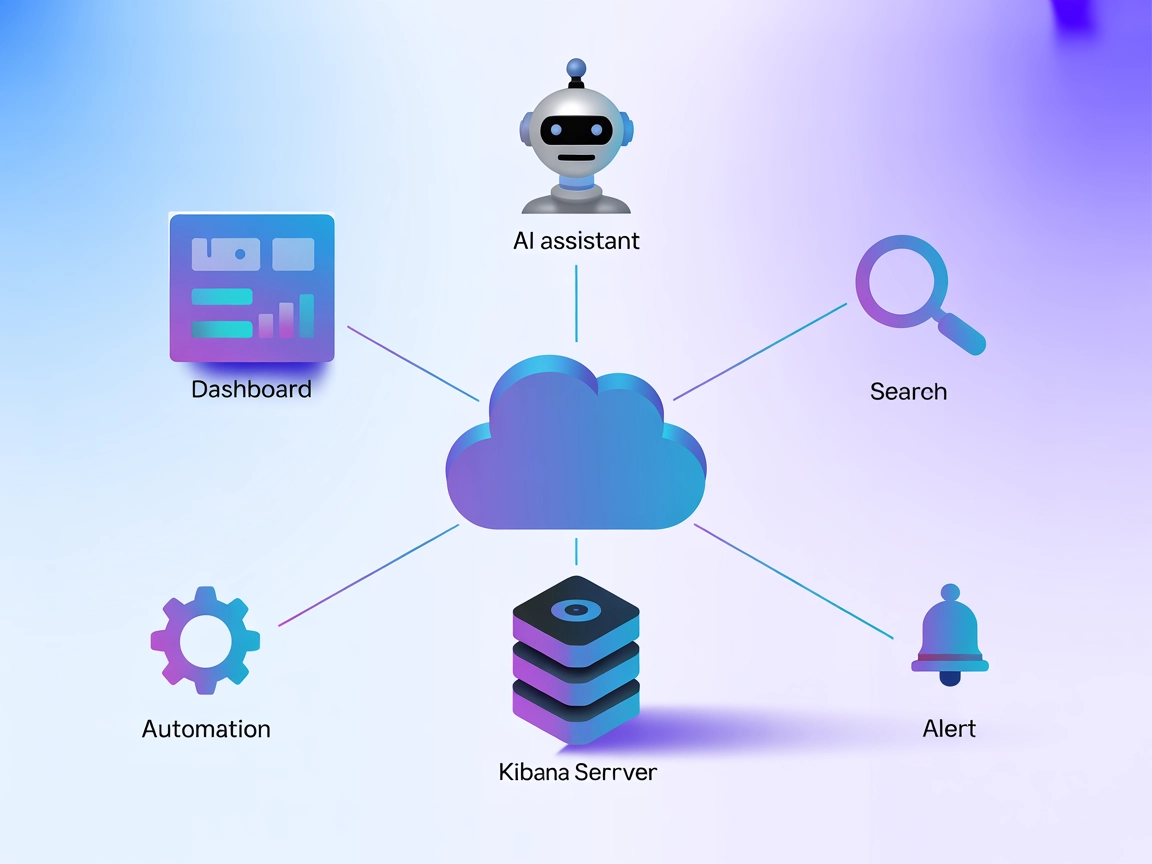

Il Server MCP Kibana collega assistenti AI con Kibana, abilitando ricerca automatizzata, gestione delle dashboard, monitoraggio degli alert e reporting tramite ...

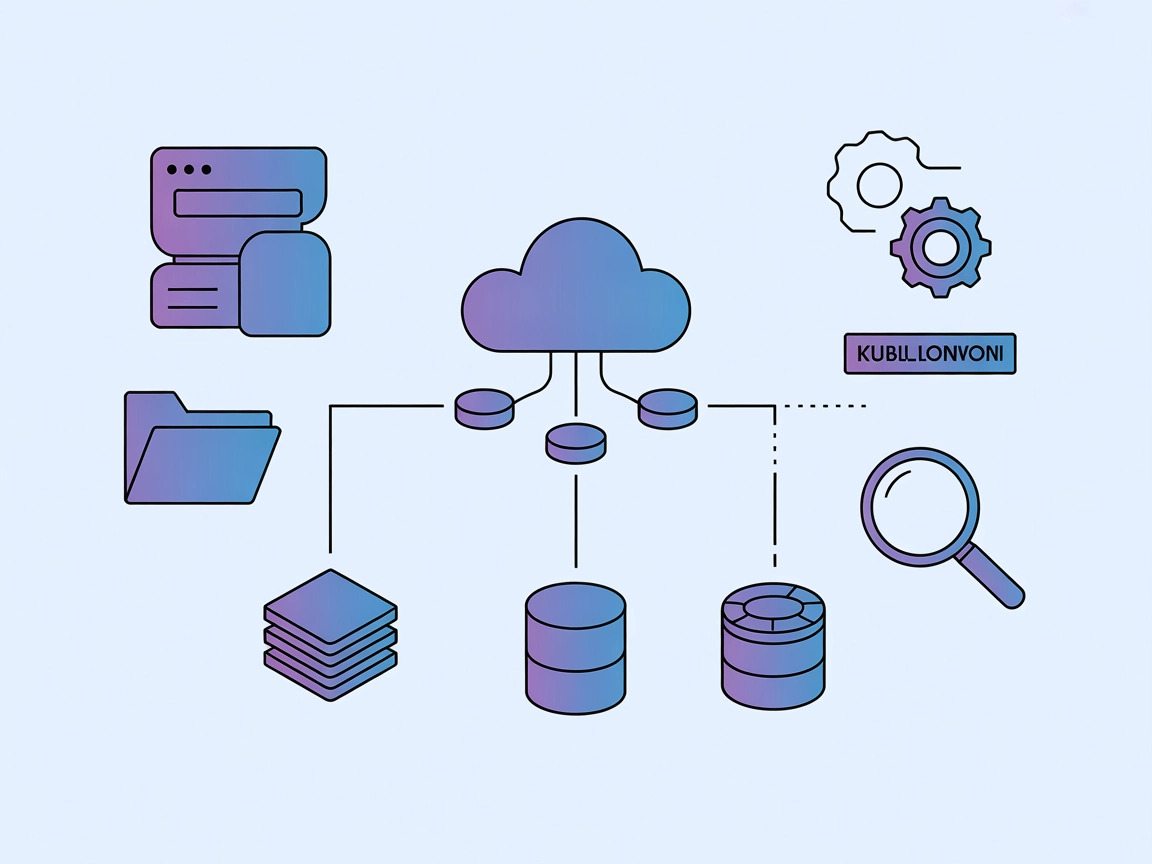

Il Kubernetes MCP Server fa da ponte tra assistenti AI e cluster Kubernetes/OpenShift, abilitando la gestione programmata delle risorse, le operazioni sui pod e...

Consenso Cookie

Usiamo i cookie per migliorare la tua esperienza di navigazione e analizzare il nostro traffico. See our privacy policy.