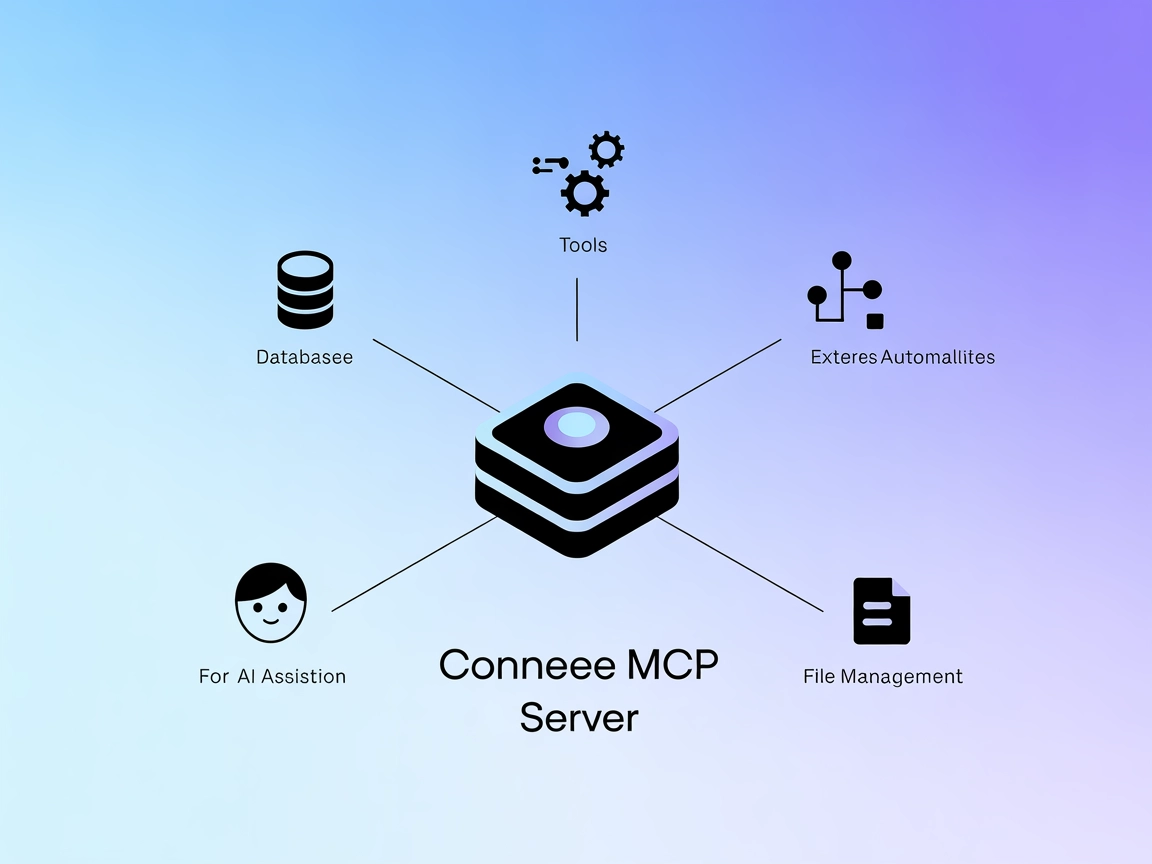

Integrazione del Server ModelContextProtocol (MCP)

Il Server ModelContextProtocol (MCP) funge da ponte tra agenti AI e fonti dati esterne, API e servizi, consentendo agli utenti FlowHunt di costruire assistenti ...

Collega i tuoi agenti AI ad API e risorse esterne tramite il server lingo.dev MCP, semplificando l’accesso e standardizzando le interazioni in FlowHunt.

FlowHunt fornisce un livello di sicurezza aggiuntivo tra i tuoi sistemi interni e gli strumenti AI, dandoti controllo granulare su quali strumenti sono accessibili dai tuoi server MCP. I server MCP ospitati nella nostra infrastruttura possono essere integrati perfettamente con il chatbot di FlowHunt così come con le piattaforme AI popolari come ChatGPT, Claude e vari editor AI.

Il server lingo.dev MCP (Model Context Protocol) funge da ponte tra assistenti AI e un’ampia gamma di fonti dati esterne, API e servizi. Esponendo risorse strutturate, template di prompt e strumenti eseguibili, permette ai modelli AI di svolgere attività avanzate come interrogare database, gestire file e interagire con API. Questo server migliora i workflow degli sviluppatori facilitando la standardizzazione e la condivisione delle interazioni LLM (Large Language Model), semplificando tutto: dall’esplorazione del codice alla raccolta dati in tempo reale in ambienti guidati dall’AI.

Utilizzo di MCP in FlowHunt

Per integrare i server MCP nel tuo workflow su FlowHunt, inizia aggiungendo il componente MCP al tuo flow e collegandolo al tuo agente AI:

Clicca sul componente MCP per aprire il pannello di configurazione. Nella sezione di configurazione MCP di sistema, inserisci i dettagli del tuo server MCP utilizzando questo formato JSON:

{

"MCP-name": {

"transport": "streamable_http",

"url": "https://yourmcpserver.example/pathtothemcp/url"

}

}

Una volta configurato, l’agente AI potrà utilizzare questo MCP come strumento con accesso a tutte le sue funzioni e capacità. Ricorda di cambiare “MCP-name” con il vero nome del tuo server MCP (ad es. “github-mcp”, “weather-api”, ecc.) e sostituire l’URL con quello del tuo server MCP.

| Sezione | Disponibilità | Dettagli/Note |

|---|---|---|

| Panoramica | ✅ | |

| Elenco prompt | ⛔ | |

| Elenco risorse | ⛔ | |

| Elenco strumenti | ⛔ | |

| Sicurezza delle API Key | ⛔ | |

| Supporto sampling (meno rilevante in valutazione) | ⛔ |

Tra le informazioni disponibili e le sezioni mancanti, questa documentazione MCP offre solo una panoramica molto breve, senza dettagli tecnici, prompt, strumenti o risorse elencati.

Sulla base delle informazioni disponibili nel file fornito, la documentazione del repository lingo.dev MCP è minima e manca dei contenuti pratici e tecnici necessari agli sviluppatori per comprendere, configurare o utilizzare rapidamente il server MCP. Il livello di utilità, quindi, è piuttosto basso.

| Ha una LICENSE | |

|---|---|

| Ha almeno uno strumento | |

| Numero di Fork | |

| Numero di Star |

Il server lingo.dev MCP funge da ponte tra gli assistenti AI e fonti di dati esterne, API e servizi, esponendo risorse e strumenti strutturati per workflow LLM avanzati.

Aggiungi il componente MCP al tuo flow su FlowHunt, apri il pannello di configurazione e inserisci i dettagli del tuo server MCP nella sezione di configurazione MCP di sistema utilizzando il formato JSON appropriato.

I casi d’uso tipici includono query su database, gestione di file e interazione con API in ambienti AI, migliorando e standardizzando i workflow degli sviluppatori.

No, la documentazione attuale è minimale e non contiene contenuti tecnici come prompt, elenco strumenti o risorse.

Consulta le best practice per la gestione delle variabili d’ambiente per conservare in modo sicuro le informazioni sensibili, poiché la documentazione fornita non tratta questo aspetto.

Potenzia le capacità dei tuoi agenti AI collegandoli a risorse e API esterne tramite il server lingo.dev MCP all’interno di FlowHunt.

Il Server ModelContextProtocol (MCP) funge da ponte tra agenti AI e fonti dati esterne, API e servizi, consentendo agli utenti FlowHunt di costruire assistenti ...

Il server LLM Context MCP collega gli assistenti AI a progetti di codice e testo esterni, abilitando flussi di lavoro contestuali per revisione del codice, gene...

Il Cognee MCP (Model Context Protocol) Server collega assistenti AI con fonti di dati esterne, API e servizi, consentendo flussi di lavoro semplificati, automaz...

Consenso Cookie

Usiamo i cookie per migliorare la tua esperienza di navigazione e analizzare il nostro traffico. See our privacy policy.