OpenAPI Schema Explorer MCP Server

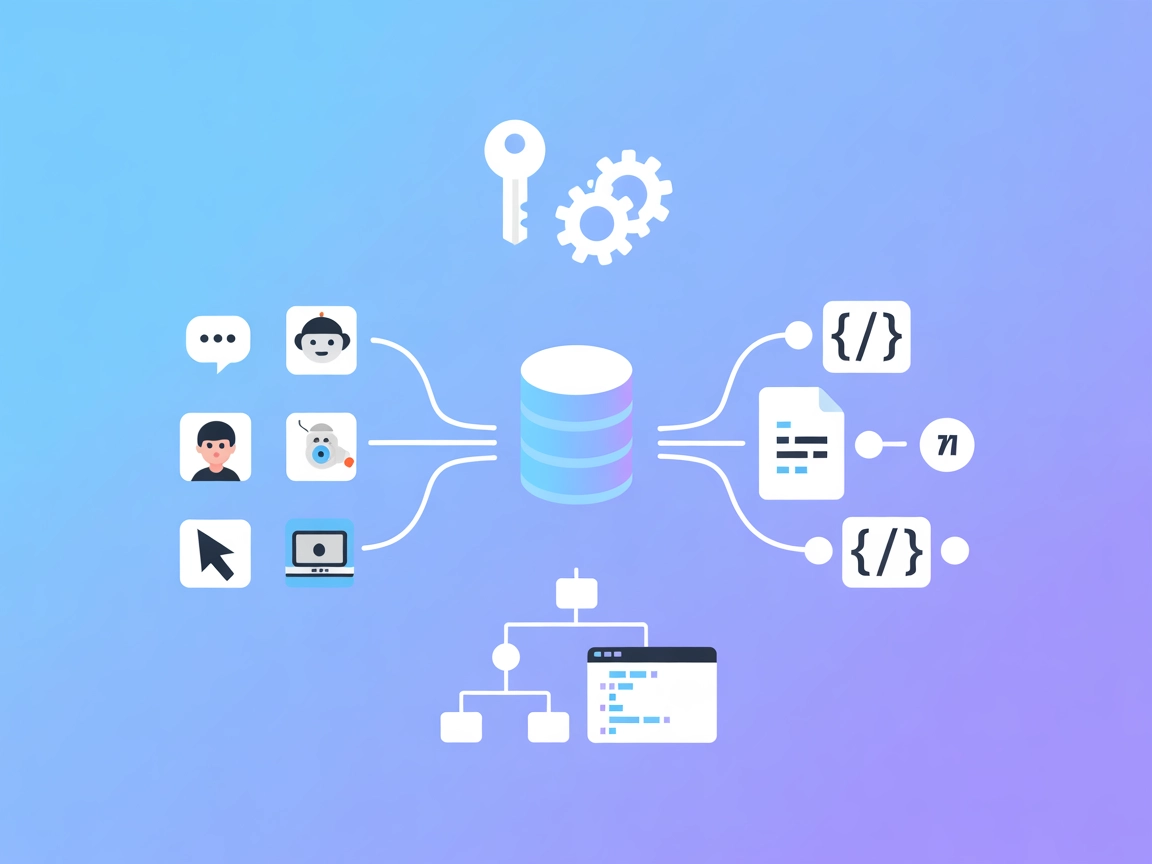

L'OpenAPI Schema Explorer MCP Server consente un accesso efficiente e strutturato alle specifiche OpenAPI/Swagger come risorse MCP, facendo da ponte tra assiste...

Esporre e cercare schemi OpenAPI con gli LLM. Elenca istantaneamente endpoint, recupera schemi e migliora i flussi di lavoro API con il Server MCP Schema OpenAPI.

FlowHunt fornisce un livello di sicurezza aggiuntivo tra i tuoi sistemi interni e gli strumenti AI, dandoti controllo granulare su quali strumenti sono accessibili dai tuoi server MCP. I server MCP ospitati nella nostra infrastruttura possono essere integrati perfettamente con il chatbot di FlowHunt così come con le piattaforme AI popolari come ChatGPT, Claude e vari editor AI.

Il Server MCP Schema OpenAPI è un server Model Context Protocol (MCP) progettato per esporre le informazioni degli schemi OpenAPI ai Large Language Models (LLM) come Claude. Fornendo un accesso strutturato alle specifiche OpenAPI, questo server permette agli assistenti AI di esplorare e comprendere le API, inclusi endpoint, parametri, schemi di richiesta e risposta, e altro ancora. Ciò consente a sviluppatori e strumenti AI di interrogare le strutture API, cercare tra le specifiche e recuperare definizioni di schema dettagliate, migliorando i flussi di lavoro che coinvolgono integrazione API, documentazione e generazione di codice. Il server supporta il caricamento di file OpenAPI in formato JSON o YAML e fornisce i risultati in YAML per una migliore comprensione da parte degli LLM.

Nessun template di prompt esplicito è documentato nel repository.

Nessuna risorsa esplicita è descritta nel repository.

Il Server MCP Schema OpenAPI offre i seguenti strumenti per gli LLM:

Nessuna istruzione di configurazione fornita per Windsurf.

npx siano installati.~/Library/Application Support/Claude/claude_desktop_config.json$env:AppData\Claude\claude_desktop_config.jsonmcpServers:{

"mcpServers": {

"OpenAPI Schema": {

"command": "npx",

"args": ["-y", "mcp-openapi-schema", "/ABSOLUTE/PATH/TO/openapi.yaml"]

}

}

}

Nessuna istruzione di configurazione fornita per Cursor.

npx siano installati.claude mcp add openapi-schema npx -y mcp-openapi-schema

claude mcp add petstore-api npx -y mcp-openapi-schema ~/Projects/petstore.yaml

claude mcp list

claude mcp get openapi-schema

claude mcp remove openapi-schema

Nessuna informazione fornita sulla protezione delle API key o sull’uso delle variabili d’ambiente.

Utilizzo di MCP in FlowHunt

Per integrare i server MCP nel tuo flusso di lavoro FlowHunt, inizia aggiungendo il componente MCP al tuo flusso e collegandolo al tuo agente AI:

Fai clic sul componente MCP per aprire il pannello di configurazione. Nella sezione di configurazione MCP di sistema, inserisci i dettagli del tuo server MCP usando questo formato JSON:

{

"MCP-name": {

"transport": "streamable_http",

"url": "https://yourmcpserver.example/pathtothemcp/url"

}

}

Una volta configurato, l’agente AI sarà in grado di utilizzare questo MCP come strumento con accesso a tutte le sue funzioni e capacità. Ricorda di cambiare “MCP-name” con il nome effettivo del tuo server MCP (es. “github-mcp”, “weather-api”, ecc.) e di sostituire l’URL con quello del tuo server MCP.

| Sezione | Disponibilità | Dettagli/Note |

|---|---|---|

| Panoramica | ✅ | |

| Elenco dei Prompt | ⛔ | Nessun template di prompt documentato |

| Elenco delle Risorse | ⛔ | Nessuna risorsa esplicita documentata |

| Elenco degli Strumenti | ✅ | 10 strumenti documentati per l’accesso OpenAPI |

| Protezione API Key | ⛔ | Non menzionato |

| Supporto Sampling (meno importante in valutazione) | ⛔ | Non menzionato |

In base alla documentazione disponibile, il Server MCP Schema OpenAPI è altamente specializzato per l’esplorazione OpenAPI tramite LLM, offrendo un robusto set di strumenti ma privo di dettagli su prompt, risorse, gestione delle API key e funzionalità MCP avanzate. Per i casi d’uso OpenAPI è solido; per le funzionalità MCP più ampie, è limitato.

| Ha una LICENZA | ⛔ |

|---|---|

| Ha almeno uno strumento | ✅ |

| Numero di Fork | 9 |

| Numero di Stelle | 30 |

Valutazione:

Darei a questo server MCP un 6/10. Sebbene sia ben definito per l’esplorazione degli schemi OpenAPI e offra una suite di strumenti solida, manca di documentazione per i template di prompt MCP, definizioni esplicite delle risorse, best practice di sicurezza e non menziona il supporto per root o sampling. Anche l’assenza di una LICENZA rappresenta un limite rilevante per la collaborazione aperta.

È un server Model Context Protocol che fornisce ai Large Language Models un accesso strutturato alle specifiche OpenAPI, abilitando l’esplorazione avanzata delle API, la documentazione e la generazione di codice.

Offre strumenti per elencare gli endpoint, recuperare schemi di endpoint e componenti, ottenere schemi di richieste e risposte, elencare gli schemi di sicurezza, cercare tra gli schemi e ottenere esempi — tutto accessibile in modo programmato dagli LLM.

I casi d’uso includono esplorazione API, generazione automatica di codice, documentazione API, revisione della sicurezza, ricerca e analisi degli schemi, e supporto agli strumenti di test delle API.

Sì, il server può caricare file OpenAPI sia in formato JSON che YAML e restituisce i risultati in YAML per una migliore comprensione da parte degli LLM.

No, l’attuale documentazione non fornisce template di prompt o definizioni esplicite di risorse.

No, la documentazione attuale non tratta la protezione delle API key o l’uso delle variabili d’ambiente.

Manca di template di prompt, documentazione esplicita delle risorse, gestione delle API key, supporto al sampling e non specifica una licenza, limitando la collaborazione aperta.

Permetti ai tuoi agenti AI di comprendere, documentare e testare le API in modo programmato. Integra il Server MCP Schema OpenAPI nei tuoi flussi per un accesso e un'automazione API senza soluzione di continuità.

L'OpenAPI Schema Explorer MCP Server consente un accesso efficiente e strutturato alle specifiche OpenAPI/Swagger come risorse MCP, facendo da ponte tra assiste...

L'OpenAPI MCP Server collega gli assistenti AI con la possibilità di esplorare e comprendere le specifiche OpenAPI, offrendo contesto dettagliato sulle API, rie...

Collega assistenti AI come Claude a qualsiasi API con una specifica OpenAPI (Swagger). L'Any OpenAPI MCP Server consente la scoperta semantica degli endpoint e ...

Consenso Cookie

Usiamo i cookie per migliorare la tua esperienza di navigazione e analizzare il nostro traffico. See our privacy policy.