Integrazione del Server ModelContextProtocol (MCP)

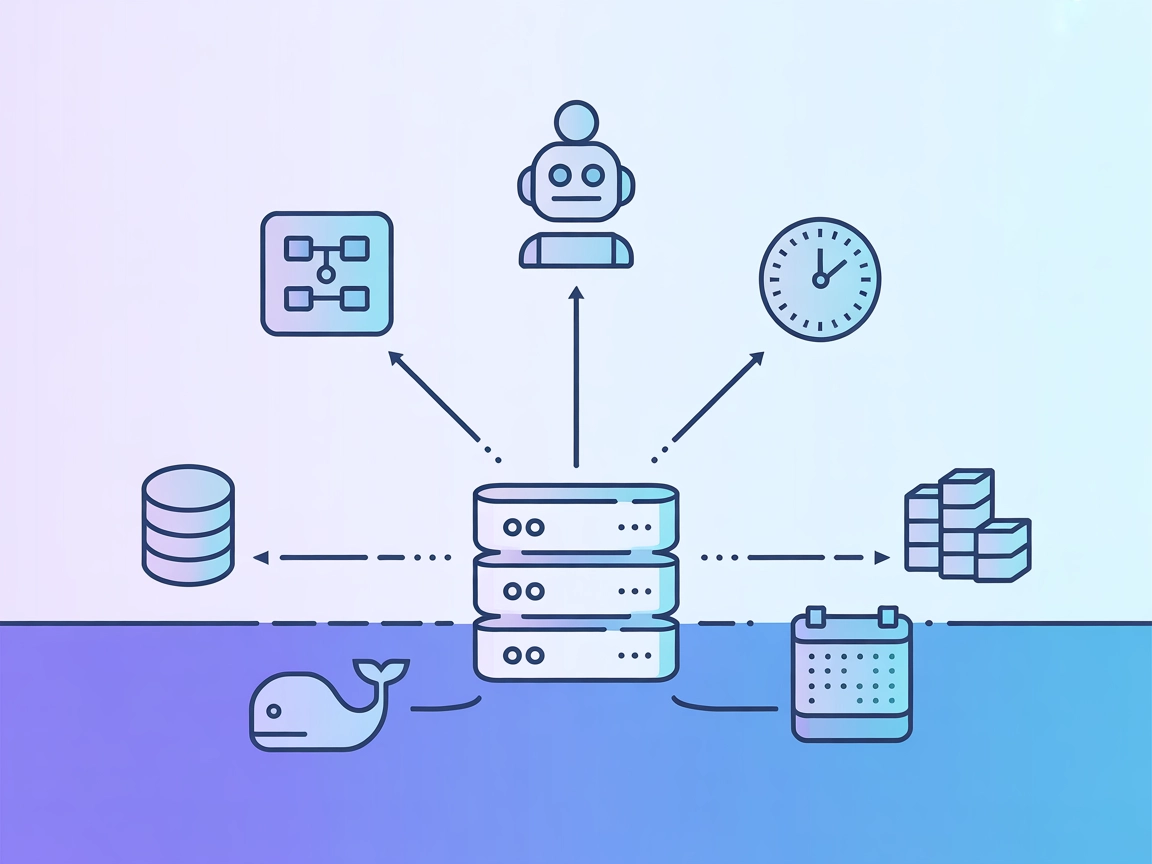

Il Server ModelContextProtocol (MCP) funge da ponte tra agenti AI e fonti dati esterne, API e servizi, consentendo agli utenti FlowHunt di costruire assistenti ...

Collega la piattaforma di orchestrazione workflow di Prefect a FlowHunt e altri agenti AI tramite il Prefect MCP Server, abilitando la gestione automatizzata dei flussi, il controllo dei deployment e il monitoraggio in tempo reale tramite linguaggio naturale.

FlowHunt fornisce un livello di sicurezza aggiuntivo tra i tuoi sistemi interni e gli strumenti AI, dandoti controllo granulare su quali strumenti sono accessibili dai tuoi server MCP. I server MCP ospitati nella nostra infrastruttura possono essere integrati perfettamente con il chatbot di FlowHunt così come con le piattaforme AI popolari come ChatGPT, Claude e vari editor AI.

Il Prefect MCP (Model Context Protocol) Server funge da ponte tra assistenti AI e la piattaforma Prefect per l’orchestrazione dei workflow. Espone le API di Prefect tramite MCP, consentendo ai client AI di gestire, monitorare e controllare i workflow Prefect e le risorse correlate tramite comandi in linguaggio naturale. Questa integrazione permette la gestione automatizzata dei flussi, la pianificazione dei deployment, il monitoraggio dei task e altro ancora—tutto tramite interfacce guidate dall’AI. Il Prefect MCP Server migliora i flussi di lavoro di sviluppo offrendo strumenti per interrogare gli stati dei workflow, avviare deployment, gestire variabili e interagire con tutti i principali componenti di Prefect in modo programmato o tramite agenti conversazionali.

Nessun template di prompt è menzionato o incluso nel repository o nella documentazione.

Nessuna “risorsa” MCP esplicita è elencata o descritta nella documentazione o codice disponibile. Il server espone le entità di Prefect (flussi, esecuzioni, deployment, ecc.) tramite le sue API, ma nessun primitivo di risorsa è documentato.

export PREFECT_API_URL="http://localhost:4200/api"

export PREFECT_API_KEY="your_api_key"

{

"mcpServers": {

"mcp-prefect": {

"command": "mcp-prefect",

"args": ["--transport", "sse"],

"env": {

"PYTHONPATH": "/path/to/your/project/directory"

},

"cwd": "/path/to/your/project/directory"

}

}

}

docker compose upProtezione delle API Key:

Utilizza variabili d’ambiente come sopra (vedi env nella configurazione JSON) per proteggere le informazioni sensibili.

{

"mcpServers": {

"mcp-prefect": {

"command": "mcp-prefect",

"args": ["--transport", "sse"],

"env": {

"PYTHONPATH": "/path/to/your/project/directory"

},

"cwd": "/path/to/your/project/directory"

}

}

}

{

"mcpServers": {

"mcp-prefect": {

"command": "mcp-prefect",

"args": ["--transport", "sse"],

"env": {

"PYTHONPATH": "/path/to/your/project/directory"

},

"cwd": "/path/to/your/project/directory"

}

}

}

docker compose upPREFECT_API_URL e PREFECT_API_KEY.Esempio di protezione delle API Key con variabili d’ambiente:

{

"mcpServers": {

"mcp-prefect": {

"command": "mcp-prefect",

"args": ["--transport", "sse"],

"env": {

"PREFECT_API_URL": "http://localhost:4200/api",

"PREFECT_API_KEY": "your_api_key"

}

}

}

}

Utilizzo di MCP in FlowHunt

Per integrare i server MCP nel tuo workflow FlowHunt, inizia aggiungendo il componente MCP al tuo flusso e collegandolo al tuo agente AI:

Clicca sul componente MCP per aprire il pannello di configurazione. Nella sezione di configurazione MCP di sistema, inserisci i dettagli del tuo server MCP usando questo formato JSON:

{ “mcp-prefect”: { “transport”: “streamable_http”, “url”: “https://yourmcpserver.example/pathtothemcp/url" } }

Una volta configurato, l’agente AI potrà utilizzare questo MCP come strumento con accesso a tutte le sue funzioni e capacità. Ricorda di cambiare “mcp-prefect” con il vero nome del tuo server MCP e di sostituire l’URL con quello del tuo server MCP.

| Sezione | Disponibilità | Dettagli/Note |

|---|---|---|

| Panoramica | ✅ | Panoramica e funzionalità chiaramente documentate |

| Elenco dei Prompt | ⛔ | Nessun template di prompt elencato |

| Elenco delle Risorse | ⛔ | Nessuna risorsa MCP esplicita elencata |

| Elenco degli Strumenti | ✅ | Strumenti per tutte le principali API Prefect |

| Protezione API Key | ✅ | Descritta tramite variabili d’ambiente in config |

| Supporto sampling (meno rilevante) | ⛔ | Non menzionato |

Il Prefect MCP Server offre una copertura API completa per le operazioni Prefect e istruzioni di configurazione chiare. Tuttavia, manca la documentazione per funzionalità MCP avanzate come template di prompt, risorse esplicite, root o sampling. La sicurezza della configurazione è solida, ma l’assenza di definizioni di prompt e risorse ne riduce la completezza MCP.

| Ha una LICENSE | ⛔ (Nessuna LICENSE trovata) |

|---|---|

| Ha almeno uno strumento | ✅ |

| Numero di Fork | 2 |

| Numero di Stelle | 8 |

Valutazione complessiva:

Data la documentazione chiara e la copertura degli strumenti ma la mancanza di supporto a risorse e prompt, e l’assenza di una LICENSE, valutiamo questo MCP a 6/10 per completezza e prontezza all’uso in produzione.

Il Prefect MCP Server espone le API di orchestrazione workflow di Prefect agli assistenti AI tramite il Model Context Protocol. Consente la gestione in linguaggio naturale di flussi, deployment, variabili e altro ancora usando FlowHunt o agenti AI compatibili.

Permette la gestione AI-driven di flussi, deployment, esecuzioni di flusso, esecuzioni di task, code di lavoro, blocchi, variabili e informazioni sugli workspace, tutto tramite la API di Prefect.

No, il Prefect MCP Server non fornisce template di prompt o definizioni di risorse MCP esplicite nella sua documentazione.

Utilizza variabili d'ambiente (come PREFECT_API_URL e PREFECT_API_KEY) nei file di configurazione per mantenere sicure le credenziali delle API.

Basandosi sulla documentazione e sugli strumenti, ma mancando il supporto per risorse e template di prompt, il Prefect MCP Server ottiene un punteggio di 6/10 per completezza e prontezza.

Potenzia la tua automazione dei workflow: gestisci, deploya e monitora i flussi Prefect direttamente da FlowHunt o dal tuo assistente AI preferito.

Il Server ModelContextProtocol (MCP) funge da ponte tra agenti AI e fonti dati esterne, API e servizi, consentendo agli utenti FlowHunt di costruire assistenti ...

Il Server MCP di Azure DevOps funge da ponte tra le richieste in linguaggio naturale e l’API REST di Azure DevOps, consentendo ad assistenti AI e strumenti di a...

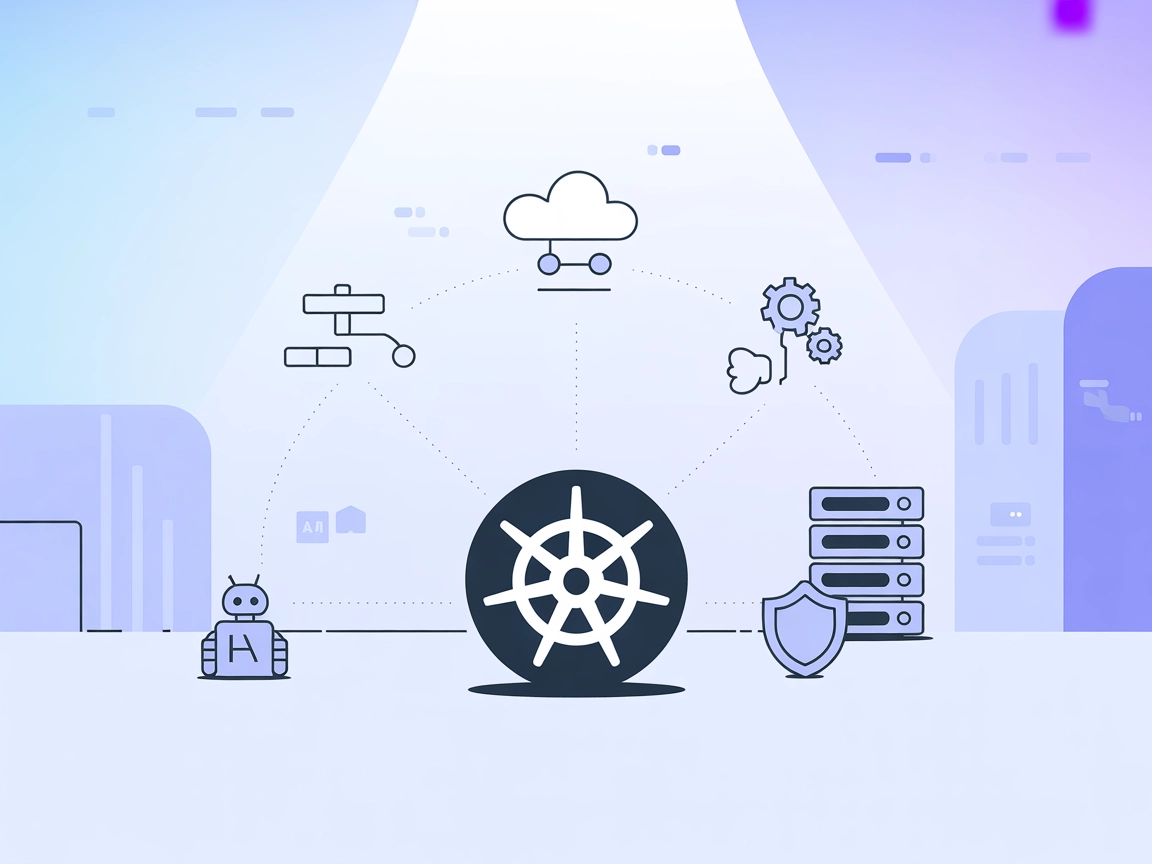

Il server MCP Kubernetes fa da ponte tra assistenti AI e cluster Kubernetes, abilitando automazione guidata dall'AI, gestione delle risorse e flussi DevOps attr...

Consenso Cookie

Usiamo i cookie per migliorare la tua esperienza di navigazione e analizzare il nostro traffico. See our privacy policy.