Introductie

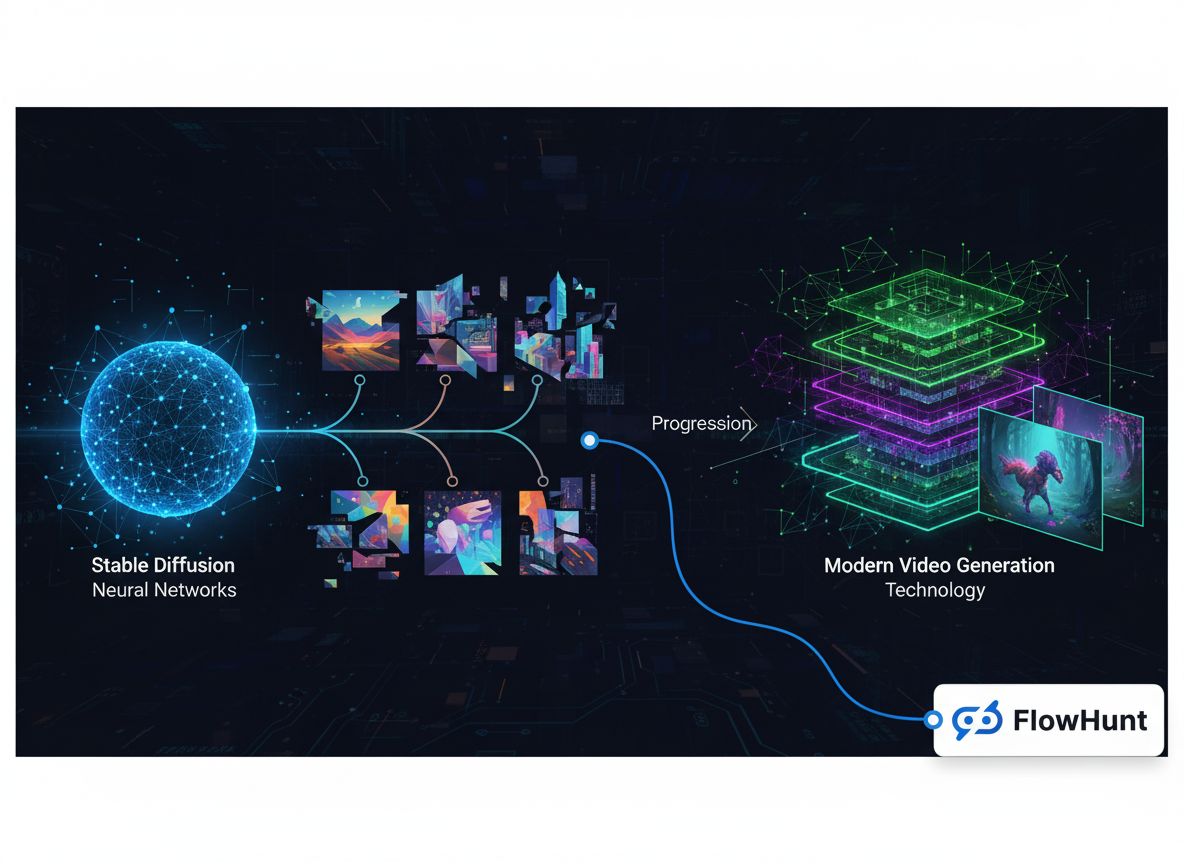

Het landschap van generatieve media heeft de afgelopen jaren een opmerkelijke transformatie ondergaan, en is geëvolueerd van experimentele onderzoeksprojecten tot een miljardenmarkt voor infrastructuur. Wat begon als gespecialiseerde beeldgeneratiemodellen is uitgegroeid tot een uitgebreid ecosysteem dat beeldsynthese, videocreatie, audiogeneratie en geavanceerde bewerkingsmogelijkheden omvat. Deze technische geschiedenis laat zien hoe bedrijven als FAL een omzet van meer dan $100 miljoen wisten te realiseren door een cruciale leemte in de markt te herkennen: ontwikkelaars hadden behoefte aan geoptimaliseerde, schaalbare inference-infrastructuur, specifiek ontworpen voor generatieve mediatoepassingen, niet aan generieke GPU-orkestratie of het hosten van taalmodellen. De reis van Stable Diffusion 1.5 tot moderne videomodellen zoals Veo3 onthult belangrijke lessen over marktpositionering, technische specialisatie en de infrastructuurvereisten die het mogelijk maken AI-toepassingen te laten opschalen van onderzoeksprototypes tot productiesystemen die miljoenen ontwikkelaars bedienen.

Generatieve media vertegenwoordigen een fundamenteel andere categorie kunstmatige intelligentie vergeleken met de grote taalmodellen die recentelijk de headlines domineerden. Terwijl taalmodellen tekst verwerken en reacties genereren op basis van aangeleerde patronen, creëren generatieve mediasystemen visuele en audio-inhoud — beelden, video’s, muziek en geluidseffecten — op basis van tekstbeschrijvingen, bestaande afbeeldingen of andere inputmodaliteiten. Dit onderscheid is meer dan semantiek; het weerspiegelt diepgaande verschillen in technische vereisten, marktdynamiek en zakelijke kansen. Generatieve mediatoepassingen werken onder andere computationele randvoorwaarden, vereisen gespecialiseerde optimalisatietechnieken en bedienen use-cases die traditionele taalmodel-infrastructuur niet efficiënt aankan. De opkomst van generatieve media heeft een geheel nieuwe categorie infrastructuurbedrijven gecreëerd, die zich specifiek richten op het optimaliseren van inference voor deze modellen, zodat ontwikkelaars geavanceerde beeld- en videogeneratie in hun applicaties kunnen integreren zonder zelf complexe GPU-uitrol te hoeven beheren of inefficiënt met resources om te gaan.

De technische eisen voor inference bij generatieve media verschillen aanzienlijk van het serveren van taalmodellen. Beeldgeneratiemodellen zoals Stable Diffusion en Flux werken via iteratieve diffusieprocessen die zorgvuldig geheugenbeheer, precieze timingoptimalisatie en efficiënte batchverwerking vereisen. Videogeneratie voegt daar nog een extra laag complexiteit aan toe, zoals temporele consistentie, audiosynchronisatie en aanzienlijk hogere rekenkracht. Deze eisen kunnen niet efficiënt worden opgevangen door generieke GPU-platforms of inference-services voor taalmodellen. In plaats daarvan is gespecialiseerde infrastructuur nodig, van de grond af opgebouwd om de unieke kenmerken van diffusie- en autoregressieve beeldgeneratie en videosynthese aan te kunnen. Bedrijven die deze leemte vroeg herkenden — en investeerden in doelgerichte infrastructuur — hebben zich kunnen positioneren om een aanzienlijk marktaandeel te veroveren naarmate de adoptie van generatieve media in verschillende sectoren versnelde.

Klaar om uw bedrijf te laten groeien?

Start vandaag uw gratis proefperiode en zie binnen enkele dagen resultaten.

De keuze om te specialiseren in generatieve media in plaats van de ogenschijnlijk meer voor de hand liggende route van taalmodellenhosten te volgen, is een van de meest bepalende strategische beslissingen in de recente AI-infrastructuurgeschiedenis. Toen de oprichters van FAL hun opties evalueerden rond 2022-2023, stonden ze voor een cruciaal keuzemoment: moesten ze hun Python-runtime uitbreiden naar een algemeen inferenceplatform voor taalmodellen, of juist vol inzetten op de opkomende markt voor generatieve media? Het antwoord onthult belangrijke inzichten over marktwerking, concurrentiepositie en het belang van strategisch kiezen voor markten waar je echt kunt winnen. Het hosten van taalmodellen leek aantrekkelijk vanwege de enorme aandacht en financiering, maar het concurrentiespeelveld was ondoenlijk. OpenAI had GPT al gevestigd als dominant model met een enorme gebruikersbasis en omzetstroom. Anthropic bouwde met veel middelen aan Claude. Google, Microsoft en andere techgiganten investeerden miljarden in hun eigen taalmodelinfrastructuur. Voor een startup zou concurreren in dit domein betekenen dat je het direct opneemt tegen partijen met oneindig veel meer middelen en gevestigde marktposities.

De generatieve mediamarkt daarentegen bood een fundamenteel andere dynamiek. Toen Stable Diffusion 1.5 in 2022 werd uitgebracht, ontstond direct behoefte aan geoptimaliseerde inference-infrastructuur, maar er was nog geen dominante speler. Het model was open source, waardoor iedereen het kon downloaden en draaien, maar de meeste ontwikkelaars ontbeerden de kennis of middelen om het effectief te optimaliseren. Dit creëerde een uitgelezen kans voor een gespecialiseerd infrastructuurbedrijf. FAL zag dat ontwikkelaars deze modellen wilden gebruiken, maar niet de complexiteit van GPU-uitrol, modeloptimalisatie en schaalbaarheid wilden beheren. Door zich volledig op generatieve media te richten, kon FAL uitgroeien tot expert in dit specifieke domein, diepe relaties opbouwen met modelontwikkelaars en een toonaangevend platform worden voor generatieve media-inference. Deze specialisatiestrategie bleek bijzonder succesvol: FAL groeide van een strategisch keerpunt naar een bedrijf met 2 miljoen ontwikkelaars, meer dan 350 modellen en een omzet van meer dan $100 miljoen per jaar.

De technische basis van moderne generatieve mediaplatformen rust op geavanceerde inference-optimalisatie, die veel verder gaat dan het simpelweg draaien van modellen op GPU’s. Toen ontwikkelaars voor het eerst Stable Diffusion 1.5 gingen gebruiken, probeerden velen het zelf te deployen op generieke cloudinfrastructuur of lokale GPU’s. Deze aanpak bracht grote inefficiënties aan het licht: modellen waren niet geoptimaliseerd voor de specifieke hardware, geheugen werd verspild door inefficiënte batching, en de benutting was laag omdat elke gebruiker zijn eigen geïsoleerde workload had. Een ontwikkelaar gebruikte misschien slechts 20-30% van de GPU-capaciteit, terwijl hij voor 100% betaalde. Deze verspilling bood een kans voor een platform dat de vraag van veel gebruikers kon bundelen, inference kon optimaliseren voor specifieke hardwareconfiguraties en via intelligente batching en scheduling veel hogere benuttingsgraden kon halen. FAL’s aanpak bestond uit het bouwen van custom CUDA-kernels — low-level GPU-code, geoptimaliseerd voor specifieke bewerkingen binnen generatieve modellen — die de prestaties aanzienlijk konden verbeteren ten opzichte van generieke implementaties.

De infrastructuuruitdaging gaat verder dan alleen prestatieoptimalisatie. Generatieve mediatoepassingen hebben unieke eigenschappen die speciale behandeling vereisen. Diffusiemodellen, die de meeste beeldgeneratiesystemen aandrijven, werken via een iteratief proces waarbij het model ruis in talloze stappen verfijnt tot samenhangende beelden. Elke stap vereist zorgvuldig geheugenbeheer om GPU-geheugen te besparen en moet snel genoeg zijn voor interactieve toepassingen. Videogeneratie voegt temporele dimensies toe, waarbij modellen consistentie tussen frames moeten bewaren en tegelijkertijd hoogwaardige content op 24 of 30 beelden per seconde moeten genereren. Audiomodellen hebben weer eigen eisen, zoals realtime verwerking of hoge outputkwaliteit. Een platform dat al deze modaliteiten ondersteunt, moet diepgaande expertise ontwikkelen in elk domein, en de specifieke optimalisatiemogelijkheden en beperkingen per modeltype kennen. Deze specialisatie maakt generatieve mediainfrastructuurbedrijven waardevol — ze bouwen kennis en optimalisatietechnieken op die individuele ontwikkelaars niet snel kunnen evenaren.

Schrijf u in voor onze nieuwsbrief

Ontvang gratis de nieuwste tips, trends en aanbiedingen.

De Evolutie van Beeldgeneratiemodellen: Van Stable Diffusion tot Flux

De geschiedenis van generatieve media is te volgen via de evolutie van beeldgeneratiemodellen, die elk een belangrijk kantelpunt in de markt vertegenwoordigen. Stable Diffusion 1.5, uitgebracht in 2022, was de katalysator die generatieve media transformeerde van academische curiositeit tot een praktisch hulpmiddel voor ontwikkelaars. Het model was open source, relatief efficiënt ten opzichte van eerdere diffusie-modellen en leverde redelijke kwaliteit voor uiteenlopende toepassingen. Voor FAL betekende Stable Diffusion 1.5 het moment waarop men de kans zag om het bedrijf volledig om te vormen. Ze boden een geoptimaliseerde, API-klare versie van het model aan die ontwikkelaars konden gebruiken zonder zelf GPU-infrastructuur te hoeven beheren. De respons was overweldigend — ontwikkelaars zagen direct de waarde van het niet hoeven beheren van uitrolcomplexiteit, en Stable Diffusion 1.5 werd FAL’s eerste grote omzetmotor. Daarnaast explodeerde het ecosysteem rond fine-tuning: ontwikkelaars maakten LoRA’s (Low-Rank Adaptations) — lichte modelaanpassingen waarmee het basismodel getraind kon worden voor specifieke stijlen, gezichten of objecten. Dit ecosysteem zorgde voor een vliegwieleffect: meer fine-tuning-opties maakten het platform waardevoller, wat weer meer ontwikkelaars aantrok.

Stable Diffusion 2.1, de opvolger van het oorspronkelijke model, was een waarschuwing over het belang van kwaliteit in de generatieve mediabranche. Ondanks enige technische verbeteringen werd SD 2.1 algemeen gezien als een stap terug qua beeldkwaliteit, vooral bij mensen en complexe scènes. Het model kreeg weinig tractie, en veel ontwikkelaars bleven de oudere 1.5-versie gebruiken. De les: in de generatieve mediamarkt is outputkwaliteit belangrijker dan technische verfijning. Gebruikers geven om het resultaat, niet om de achterliggende architectuur of trainingsmethode. Stable Diffusion XL (SDXL), uitgebracht in 2023, betekende wél een echte sprong voorwaarts: SDXL kon beelden met hogere resolutie, betere details en accuratere tekstrendering genereren. Voor FAL was SDXL transformerend — het was het eerste model dat $1 miljoen omzet binnenbracht voor het platform. De populariteit van SDXL versnelde bovendien het fine-tuning-ecosysteem, met duizenden LoRA’s voor specifieke toepassingen. Het succes van SDXL liet zien dat er substantiële commerciële vraag is naar hoogwaardige beeldgeneratie, en bevestigde FAL’s specialisatiekeuze.

De introductie van Flux-modellen door Black Forest Labs in 2024 markeerde opnieuw een kritisch kantelpunt. Flux was de eerste generatie modellen die daadwerkelijk “commercieel bruikbaar” en “enterprise-ready” waren. De kwaliteit was aanzienlijk hoger dan bij eerdere modellen, de snelheid voldeed aan de eisen voor productieapplicaties, en de resultaten waren consistent genoeg voor bedrijven om er producten op te bouwen. Voor FAL was Flux transformerend: de omzet steeg van $2 miljoen naar $10 miljoen in de eerste maand na de release, en vervolgens naar $20 miljoen de maand erna. Deze explosieve groei weerspiegelde de opgebouwde vraag naar hoogwaardige beeldgeneratie die betrouwbaar commercieel inzetbaar was. Flux kwam in verschillende versies — Schnell (een snelle, gedistilleerde versie), Dev (hogere kwaliteit met niet-commerciële licentie), en Pro (waarvoor samenwerking vereist is voor hosting) — elk voor andere toepassingen en prijssegmenten. Het succes van Flux toonde aan dat de generatieve mediamarkt volwassen werd: bedrijven waren bereid serieus te investeren in beeldgeneratie, niet alleen te experimenteren.

De Versch shift naar Video: Een Nieuw Marktsegment

Hoewel beeldgeneratie veel aandacht en omzet trok, betekende de opkomst van praktische videogeneratiemodellen een geheel nieuwe marktkans. Vroege tekst-naar-video-modellen, waaronder OpenAI’s Sora, lieten zien wat theoretisch mogelijk was, maar waren niet breed beschikbaar of leverden vooral resultaten die interessant waren voor onderzoek, niet voor praktische toepassingen. Video’s waren vaak geluidloos, met temporele inconsistenties en onvoldoende kwaliteit voor professioneel gebruik. Dit veranderde drastisch met de komst van modellen als Veo3 van Google DeepMind, die een echte doorbraak betekenden in videogeneratiekwaliteit. Veo3 kon video’s met gesynchroniseerd geluid, correcte timing en pacing, accurate lip-sync en een visuele kwaliteit dicht bij professioneel niveau genereren. Het model was duur in gebruik — veel intensiever dan beeldgeneratie — maar de kwaliteit rechtvaardigde de kosten voor veel toepassingen.

De impact van hoogwaardige videogeneratie op FAL’s business was aanzienlijk. Videogeneratie creëerde een geheel nieuwe inkomstenstroom en trok een ander type klanten aan. Waar beeldgeneratie vooral werd gebruikt door individuele ontwikkelaars, ontwerpers en kleine creatieve teams, trok videogeneratie grotere bedrijven aan die reclamecontent, marketingvideo’s en andere professionele toepassingen wilden maken. FAL werkte samen met diverse videomodelproviders, waaronder Alibaba’s One, Kuaishou’s Kling en anderen, om een volledig aanbod van videogeneratie te bieden. De omzetgroei van het platform versnelde verder naarmate video een steeds groter deel van het gebruik werd. De technische uitdagingen van videogeneratie stimuleerden ook innovatie binnen FAL’s infrastructuur — videomodellen vereisten andere optimalisatiestrategieën dan beeldmodellen, met nieuwe custom kernels en architecturale benaderingen. Het succes van videogeneratie bevestigde tevens FAL’s strategie om een platform te bouwen dat meerdere modaliteiten bedient. In plaats van alleen beeldgeneratie, had FAL een infrastructuur ontwikkeld die flexibel genoeg is voor beeld, video en audio, en zich daarmee positioneert als het allesomvattende generatieve mediaplatform.

Nu generatieve media steeds centraler staat in contentcreatie en applicatieontwikkeling, zijn platforms als FlowHunt ontstaan om ontwikkelaars en teams te helpen de integratie van deze technologieën te stroomlijnen. FlowHunt erkent dat hoewel infrastructuurplatforms als FAL het draaien van generatieve mediatoepassingen efficiënt hebben gemaakt, ontwikkelaars nog altijd grote uitdagingen hebben in het orkestreren van deze modellen binnen grotere workflows. Een typische generatieve media-applicatie omvat meerdere stappen: een gebruikersverzoek ontvangen, input verwerken en valideren, één of meer generatieve modellen aanroepen, de resultaten nabewerken, outputs opslaan en analytics beheren. FlowHunt biedt tools om deze workflows te automatiseren en te optimaliseren, zodat ontwikkelaars zich kunnen richten op de applicatielogica en niet op infrastructuurbeheer. Door integratie met platforms als FAL stelt FlowHunt ontwikkelaars in staat geavanceerde generatieve media-applicaties te bouwen zonder de onderliggende complexiteit van modeluitrol, optimalisatie en schaalbaarheid te hoeven beheren.

FlowHunt’s aanpak van generatieve mediaworkflows legt de nadruk op automatisering, betrouwbaarheid en inzichtelijkheid. Het platform stelt ontwikkelaars in staat workflows te definiëren die meerdere generatieve media-operaties aan elkaar koppelen, fouten gracieus afhandelen en inzicht bieden in elke stap. Een contentcreatie-workflow kan bijvoorbeeld bestaan uit het genereren van meerdere beeldvarianten, het selecteren van de beste op basis van kwaliteitscriteria, het toepassen van nabewerkingen en vervolgens het publiceren van het resultaat. FlowHunt maakt het mogelijk om deze hele workflow declaratief te definiëren, met automatische retry-logica, foutafhandeling en monitoring. Deze abstractielaag is met name waardevol voor teams die productieapplicaties bouwen die op schaal betrouwbaar content moeten genereren. Door de orkestratie en workflowmanagement uit handen te nemen, kunnen ontwikkelaars zich focussen op de creatieve en zakelijke logica, terwijl het platform de technische complexiteit van het coördineren van verschillende generatieve media-operaties afhandelt.

De Technische Diepgang: Custom Kernels en Prestatieoptimalisatie

De opmerkelijke groei van FAL’s business en de kwaliteit van haar dienstverlening zijn gebouwd op een fundament van geavanceerde technische optimalisatie waar de meeste gebruikers nooit iets van merken. Het platform heeft meer dan 100 custom CUDA-kernels ontwikkeld — gespecialiseerde GPU-code in NVIDIA’s CUDA-taal — die specifieke bewerkingen binnen generatieve mediatoepassingen optimaliseert. Deze kernels vertegenwoordigen duizenden uren engineeringwerk gericht op het maximaal benutten van GPU-hardware. De motivatie is helder: elke milliseconde minder latency betekent een betere gebruikerservaring en lagere infrastructuurkosten. Een model dat 20% sneller een beeld kan genereren, betekent dat dezelfde GPU 20% meer gebruikers kan bedienen, wat direct de economie van het platform verbetert. Het schrijven van custom kernels is een flinke uitdaging. CUDA-programmeren vereist diepgaande kennis van GPU-architectuur, geheugenhiërarchieën en parallelle computingprincipes. Het is niet iets dat je snel leert of generiek kunt toepassen — elke kernel moet nauwkeurig worden afgestemd op specifieke bewerkingen en hardware.

Het optimalisatieproces begint met profiling — inzicht krijgen in waar de tijd daadwerkelijk wordt besteed bij het uitvoeren van het model. Veel ontwikkelaars veronderstellen dat de meest rekenintensieve bewerkingen de bottleneck zijn, maar profiling levert vaak verrassingen op. Soms is het de dataverplaatsing tussen GPU-geheugen en rekenunits, niet de berekening zelf. Soms is het de overhead van het starten van veel kleine GPU-operaties in plaats van ze te batchen. FAL’s engineers profileren modellen uitgebreid, identificeren de echte bottlenecks en schrijven dan custom kernels om deze weg te nemen. Bijvoorbeeld door een kernel te schrijven die meerdere bewerkingen samenvoegt, waardoor geheugentraffic en kernel-launch-overhead worden verminderd. Of door een kernel specifiek te optimaliseren voor de dimensies en datatypes van een bepaald model. Dit niveau van optimalisatie is economisch alleen rendabel bij miljoenen gebruikers — de investering betaalt zich uit in verbeterde efficiëntie en lagere operationele kosten.

Naast individuele kerneloptimalisatie heeft FAL geïnvesteerd in architecturale verbeteringen voor modelserving. Het platform gebruikt technieken als modelquantisatie (het verlagen van de precisie van modelgewichten om minder geheugen en rekenkracht te gebruiken), dynamisch batchen (verzoeken groeperen om GPU’s beter te benutten) en verzoekprioritering (zorgen dat latency-gevoelige verzoeken prioriteit krijgen boven throughput-georiënteerde). Deze technieken moeten zorgvuldig worden geïmplementeerd om kwaliteit te behouden en efficiëntie te verhogen. Quantisatie kan bijvoorbeeld modelsnelheid en -grootte verbeteren, maar verkeerd uitgevoerd kan het de outputkwaliteit verslechteren. FAL’s engineers hebben geavanceerde quantisatiestrategieën ontwikkeld die kwaliteit behouden en toch efficiëntie winnen. Dynamisch batchen vereist voorspellen hoe lang elk verzoek duurt en groeperen om GPU-benutting te maximaliseren zonder te veel latency toe te voegen. Deze architecturale verbeteringen, in combinatie met kerneloptimalisatie, stellen FAL in staat benuttingsgraden en prestaties te behalen die met generieke infrastructuur onmogelijk zouden zijn.

Marktdynamiek en het Concurrentielandschap

De markt voor generatieve media ontwikkelt zich razendsnel, met voortdurend nieuwe modellen en mogelijkheden. Inzicht in de concurrentiedynamiek en marktstructuur is essentieel om te begrijpen waarom gespecialiseerde platforms als FAL zo waardevol zijn geworden. De markt is grofweg te verdelen in segmenten: beeldgeneratie, videogeneratie, audiogeneratie en bewerkingstools. Binnen elk segment concurreren meerdere modellen op kwaliteit, snelheid, kosten en specifieke functionaliteit. Voor beeldgeneratie omvat de markt Stable Diffusion-varianten, Flux-modellen, Google’s Gemini Image-modellen en diverse gespecialiseerde modellen, bijvoorbeeld voor logo’s of gezichtsynthese. Voor videogeneratie zijn er Veo3, Alibaba’s One, Kuaishou’s Kling en anderen. Deze diversiteit aan modellen biedt zowel kansen als uitdagingen voor infrastructuurplatforms. De kans is dat geen enkel model alle use-cases domineert — verschillende modellen blinken uit in verschillende dingen, waardoor een platform dat meerdere modellen ondersteunt waardevoller wordt. De uitdaging is dat het ondersteunen van veel modellen veel engineering vereist om elk model te optimaliseren.

FAL’s strategie is om een selectie van modellen te cureren die samen de belangrijkste use-cases dekken en een hoge kwaliteitsstandaard hebben. In plaats van elk nieuw model toe te voegen, evalueert FAL zorgvuldig of een model unieke functionaliteit of aanzienlijk betere kwaliteit biedt dan bestaande opties. Deze curatieaanpak heeft meerdere voordelen. Ten eerste zorgt het voor een aanbod dat hoogwaardig en bruikbaar is, in plaats van gebruikers te overweldigen met middelmatige keuzes. Ten tweede stelt het FAL in staat optimalisatie-inspanningen te richten op modellen die daadwerkelijk gebruikt worden. Ten derde creëert het een positieve feedbackloop: het kwaliteitsimago trekt zowel gebruikers als modelontwikkelaars aan. Modelbouwers willen hun modellen op FAL vanwege het kwaliteitsbewuste publiek, en gebruikers kiezen FAL vanwege het geoptimaliseerde aanbod. Deze dynamiek is cruciaal geweest voor FAL’s succes.

Het concurrentielandschap omvat ook andere infrastructuurplatforms voor generatieve media, en directe concurrentie van modelontwikkelaars die hun eigen hosting aanbieden. Sommige ontwikkelaars, zoals Stability AI, bieden een eigen inference-API. Anderen, zoals Black Forest Labs met Flux, kiezen ervoor samen te werken met platforms als FAL in plaats van eigen infrastructuur te bouwen. De keuze tussen partnerschap en zelf bouwen is strategisch: zelf infrastructuur bouwen vereist veel engineering en operationele kennis, partnerschap stelt je in staat je te focussen op modelontwikkeling. Voor de meeste modelontwikkelaars is samenwerken met gespecialiseerde platforms als FAL aantrekkelijker. Dit heeft geleid tot een gezond ecosysteem met een duidelijke scheiding tussen R&D door modelbouwers en optimalisatie/schaling door infrastructuurpartijen.

Het Verdienmodel en Bedrijfsmetrics

Het verdienmodel en de metrics van FAL geven inzicht in hoe generatieve mediainfrastructuur waarde creëert en opschaalt. FAL hanteert een gebruiksgebaseerd prijsmodel: klanten betalen per API-call en gebruikte rekenkracht. Dit zorgt voor aligned incentives — meer gebruik betekent meer omzet, en de groei van FAL weerspiegelt de toenemende waarde en adoptie van het platform. De groeicijfers zijn indrukwekkend: 2 miljoen ontwikkelaars, 350+ modellen en meer dan $100 miljoen jaaromzet. Dit laat zien dat het platform op schaal draait, maar dat de markt voor generatieve media nog in een vroeg stadium verkeert. De penetratie onder potentiële gebruikers is laag, en veel toepassingen zijn nog niet ontdekt. De omzetgroei is versneld met de toevoeging van videogeneratie. De omzet steeg van $2 miljoen naar $10 miljoen in de eerste maand na de introductie van Flux, wat het effect van hoogwaardige modellen op platformomzet aantoont.

De metrics laten ook belangrijke marktinzichten zien. Het feit dat FAL $100M+ jaaromzet haalt met 2 miljoen ontwikkelaars, suggereert dat de gemiddelde omzet per gebruiker relatief bescheiden is — misschien $50-100 per jaar. Dit komt doordat veel gebruikers experimenteren of kleinschalig werken. De verdeling is waarschijnlijk scheef, met een kleine groep grootgebruikers die het grootste deel van de omzet realiseert, meestal bedrijven die generatieve media in hun product of dienst integreren. Naarmate de markt volwassen wordt en meer bedrijven generatieve media centraal in hun bedrijfsvoering opnemen, zal de gemiddelde omzet per gebruiker waarschijnlijk sterk stijgen. De groeicurve van FAL suggereert dat generatieve mediainfrastructuur nog aan het begin staat van een lange groeifase, met veel kansen in het verschiet.

Geavanceerde Inzichten: De Rol van Fine-Tuning en Aanpassing

Een van de belangrijkste ontwikkelingen in de generatieve mediamarkt is de opkomst van fine-tuning en aanpassingsmogelijkheden, waarmee gebruikers modellen op maat kunnen maken voor specifieke toepassingen. Fine-tuning houdt in dat een voorgetraind model verder wordt getraind op domeinspecifieke data om prestaties op bepaalde taken te verbeteren. Voor beeldgeneratie gebeurt dit vooral via LoRA’s (Low-Rank Adaptations), lichte modelaanpassingen waarmee het basismodel zonder volledige hertraining kan worden aangepast. Een ontwerper kan bijvoorbeeld een LoRA maken voor een bepaalde tekenstijl, een fotograaf voor een specifieke esthetiek, of een bedrijf voor productafbeeldingen in hun eigen context. Het LoRA-ecosysteem is uitgegroeid tot een cruciaal onderdeel van de markt, met duizenden LoRA’s voor populaire modellen als Stable Diffusion en SDXL.

Fine-tuning heeft grote implicaties voor infrastructuurplatforms als FAL. Het ondersteunen van fine-tuning vereist extra mogelijkheden: tools om LoRA’s te maken en beheren, ze efficiënt op te slaan en samen met het basismodel te serveren. Daarnaast moet de technische uitdaging worden opgelost om LoRA’s op inference-tijd te combineren met het basismodel, met behoud van kwaliteit en zonder te veel vertraging. FAL heeft fors geïnvesteerd in deze mogelijkheden, omdat fine-tuning voor veel gebruikers een belangrijk onderdeel van de waardepropositie is. De ondersteuning voor fine-tuning is een belangrijke succesfactor gebleken, omdat gebruikers zo modellen kunnen aanpassen aan hun behoeften én profiteren van de optimalisatie en schaalbaarheid van het platform. Naarmate de markt groeit, wordt fine-tuning en maatwerk waarschijnlijk nog belangrijker, met bedrijven die investeren in custom modellen voor hun specifieke use-cases.

Vooruitkijkend zal de markt voor generatieve mediainfrastructuur zich snel blijven ontwikkelen. Diverse trends zullen de toekomst bepalen. Ten eerste zullen modellen blijven verbeteren in kwaliteit en mogelijkheden, waardoor nieuwe toepassingen ontstaan en nieuwe gebruikers worden aangetrokken. Videogeneratie staat nog aan het begin; naarmate modellen verbeteren, zal videogeneratie waarschijnlijk even alledaags worden als beeldgeneratie. Audiogeneratie en muziekcreatie zijn opkomende domeinen, met modellen als PlayHD die veelbelovend zijn. Ten tweede zal de markt waarschijnlijk consolideren rond een kleiner aantal dominante modellen en platforms, vergelijkbaar met hoe beeldgeneratie zich concentreert rond Stable Diffusion-varianten en Flux. Deze consolidatie biedt kansen voor gespecialiseerde platforms om nog waardevoller te worden door te optimaliseren voor de dominante modellen. Ten derde zal generatieve media steeds verder geïntegreerd raken in reguliere applicaties en workflows. In plaats van een losse functionaliteit zal generatieve media ingebed worden in ontwerptools, contentmanagementsystemen en andere toepassingen voor dagelijkse creatie.

Ook de infrastructuurvereisten zullen blijven evolueren. Naarmate modellen groter en krachtiger worden, zullen ze meer rekenkracht vragen, waardoor efficiënte inference-optimalisatie belangrijker wordt. De komst van nieuwe hardwareversnellers naast GPU’s — zoals gespecialiseerde AI-chips van diverse fabrikanten — biedt nieuwe optimalisatiemogelijkheden en uitdagingen. Platforms die efficiënt modellen kunnen serveren op verschillende hardware, krijgen een groot voordeel. De markt zal ook steeds meer eisen stellen aan betrouwbaarheid, latency en kostenoptimalisatie, nu generatieve media steeds centraler wordt in bedrijfsprocessen. Waar early adopters incidentele fouten of hoge latency tolereerden, zal de vraag naar betrouwbaarheid en lage latency stijgen naarmate de technologie bedrijfskritisch wordt. Dit zal verdere investeringen in infrastructuur- en betrouwbaarheidstechniek stimuleren.

Conclusie

De technische geschiedenis van generatieve media laat zien hoe een markt in enkele jaren van experimenteel onderzoek tot een miljardenkans voor infrastructuur kon uitgroeien. De reis van Stable Diffusion 1.5 tot moderne videogeneratiemodellen illustreert hoe snelle innovatie in AI-modellen kansen creëert voor gespecialiseerde infrastructuurplatforms. Het succes van FAL, dat $100M+ omzet realiseerde door zich uitsluitend te richten op generatieve mediainfrastructuur — en niet te concurreren in de overvolle markt voor taalmodellen — onderstreept het belang van strategische marktpositionering en technische specialisatie. De investering in custom CUDA-kerneloptimalisatie, ondersteuning voor meerdere modaliteiten en de curatie van hoogwaardige modellen hebben geleid tot een waardevolle dienst waar miljoenen ontwikkelaars op vertrouwen. Naarmate generatieve media blijft evolueren en steeds centraler wordt in contentcreatie en applicatieontwikkeling, zullen de infrastructuurplatforms die deze markt bedienen steeds belangrijker worden. De combinatie van betere modellen, meer toepassingen en groeiende zakelijke adoptie suggereert dat generatieve mediainfrastructuur zich nog altijd in een vroeg stadium van een lange groeicurve bevindt, met volop kansen voor platforms die betrouwbare, efficiënte en innovatieve diensten kunnen leveren aan hun gebruikers.

{{ cta-dark-panel

heading=“Geef Uw Workflow een Boost met FlowHunt”

description=“Ervaar hoe FlowHunt uw AI-content- en SEO-workflows automatiseert — van research en contentcreatie tot publicatie en analytics — alles op één plek.”

ctaPrimaryText=“Boek een Demo”

ctaPrimaryURL=“https://calendly.com/liveagentsession/flowhunt-chatbot-demo"

ctaSecondaryText=“Probeer FlowHunt Gratis”

ctaSecondaryURL=“https://app.flowhunt.io/sign-in"

gradientStartColor="#123456”

gradientEndColor="#654321”

gradientId=“827591b1-ce8c-4110-b064-7cb85a0b1217”

}}