Introductie

Effectieve AI-agenten bouwen betekent meer dan alleen taalmodellen aan tools koppelen. De echte uitdaging zit in hoe agenten redeneren over complexe problemen, grote hoeveelheden informatie beheren en meerstapsworkflows efficiënt uitvoeren. In deze uitgebreide gids verkennen we geavanceerde technieken voor AI-agentimplementatie, met speciale aandacht voor planning—een essentiële vaardigheid die high-performance agenten onderscheidt van eenvoudige toepassingen. Planning stelt AI-agenten in staat om complexe taken op te delen in beheersbare stappen, beperkingen van het contextvenster te overwinnen en workflows sneller en kostenefficiënter uit te voeren. Of je nu onderzoeksagenten, automatiseringssystemen of intelligente assistenten bouwt, inzicht in hoe je planning implementeert in je AI-agenten zal hun prestaties en betrouwbaarheid aanzienlijk verbeteren.

Wat zijn AI-agenten en waarom zijn ze belangrijk?

Kunstmatige intelligentie-agenten vormen een fundamentele verschuiving in hoe we probleemoplossing met taalmodellen benaderen. In tegenstelling tot traditionele toepassingen die input verwerken en direct output genereren, werken AI-agenten als autonome systemen die hun omgeving kunnen waarnemen, beslissingen nemen en acties herhalen. Een AI-agent bestaat meestal uit een taalmodel (het “brein”), een set tools of functies die het kan aanroepen, en een control-loop die bepaalt wanneer welke tool gebruikt wordt. Deze architectuur stelt agenten in staat om complexe, meerstaps taken uit te voeren die voor een enkel LLM-verzoek onmogelijk zouden zijn. Zo kan een agent bijvoorbeeld informatie op het internet zoeken, deze verwerken, berekeningen maken en alles samenvoegen tot een samenhangend antwoord. De kracht van agenten zit in hun vermogen om te redeneren over welke stappen nodig zijn en deze op volgorde uit te voeren, waarbij ze leren van de resultaten van elke stap om het volgende te bepalen.

Het belang van AI-agenten is exponentieel gegroeid nu organisaties hun potentieel voor automatisering, onderzoek, klantenservice en kenniswerk inzien. Bedrijven zetten steeds vaker agenten in voor taken als data-analyse, contentcreatie, klantenondersteuning en complexe probleemoplossing. Maar naarmate agenten geavanceerder worden en complexere problemen aanpakken, nemen ook de uitdagingen toe. Eén van de grootste uitdagingen is het omgaan met de beperkingen van taalmodellen, in het bijzonder hun contextvenster—de maximale hoeveelheid tekst die ze in één keer kunnen verwerken. Wanneer agenten moeten werken met grote documenten, uitgebreide zoekresultaten of complexe meerstapsworkflows, lopen ze al snel tegen verminderde nauwkeurigheid en prestatieproblemen aan. Hier wordt planning essentieel.

Klaar om uw bedrijf te laten groeien?

Start vandaag uw gratis proefperiode en zie binnen enkele dagen resultaten.

Het contextvensterprobleem begrijpen: waarom planning belangrijk is

De beperking van het contextvenster is een van de grootste uitdagingen in moderne AI-agentontwerpen. Hoewel recente ontwikkelingen contextvensters tot 100.000 tokens of meer hebben uitgebreid, wijst onderzoek op een tegengesteld probleem: grotere contextvensters leiden niet automatisch tot betere prestaties. Dit fenomeen, “context rot” genoemd door Chroma-onderzoekers, laat zien dat taalmodellen moeite hebben om informatie uit enorme contexten nauwkeurig terug te vinden en te verwerken. In de praktijk geldt: wanneer een LLM een specifiek stukje informatie moet vinden in 10.000 tokens tekst, daalt de nauwkeurigheid flink in vergelijking met wanneer diezelfde informatie in een kleinere context wordt aangeboden. Het probleem wordt nog duidelijker als de context afleiders bevat—informatie die gerelateerd is aan de vraag, maar er geen antwoord op geeft.

Het onderzoeksteam van Chroma voerde uitgebreide evaluaties uit met een verbeterde versie van de “speld in een hooiberg”-test, die traditioneel meet hoe goed modellen specifieke informatie in grote documenten kunnen vinden. Echter, deze test hield geen rekening met realistische scenario’s waarin documenten gerelateerde maar misleidende informatie bevatten. Door afleiders toe te voegen—paragrafen die over het onderwerp gaan maar de specifieke vraag niet beantwoorden—ontdekten onderzoekers dat de modelnauwkeurigheid dramatisch daalt. Zo behoudt Claude 4.5 betere nauwkeurigheid dan andere modellen in verschillende afleiderscenario’s, maar zelfs de beste modellen laten duidelijke prestatieafname zien naarmate de context langer wordt. Dit onderzoek veranderde fundamenteel hoe ontwikkelaars AI-agenten bouwen: in plaats van agenten te laten zoeken in enorme contexten, moeten we ze helpen hun aanpak te plannen en problemen op te splitsen in kleinere, beter beheersbare stukken.

Hoe planning het contextprobleem oplost

Planning betekent een paradigmaverschuiving in AI-agentarchitecturen. In plaats van dat een agent reactief op elke stap ingaat en zoekt in enorme contexten, dwingt planning de agent om het hele probleem vooraf te doordenken en een gestructureerde aanpak te maken. Dit is vergelijkbaar met hoe mensen complexe problemen oplossen: we beginnen niet zomaar, maar begrijpen eerst het probleem, delen het op in stappen en maken een plan. Wanneer een AI-agent een plan maakt vóór de uitvoering, kan hij zich per stap richten op specifieke subtaken met alleen de relevante context. Dit vermindert de cognitieve belasting van het taalmodel drastisch en verhoogt de nauwkeurigheid. In plaats van een LLM bijvoorbeeld te vragen om in een document van 50.000 tokens meerdere stukjes informatie te zoeken, zou een plannende agent eerst een plan maken: “Stap 1: Zoek informatie over X, Stap 2: Zoek informatie over Y, Stap 3: Synthetiseer beide stukken.” Voor elke stap hoeft de agent dan alleen met het relevante deel van de context te werken, waardoor de nauwkeurigheid behouden blijft.

De planningsaanpak maakt het ook mogelijk om complexe workflows efficiënter uit te voeren. Met een duidelijk plan kan een agent bepalen welke stappen parallel kunnen worden uitgevoerd, welke afhankelijk zijn van anderen en hoe de uitvoering geoptimaliseerd kan worden. Dit is vooral waardevol als meerdere tools of API-aanroepen nodig zijn. In plaats van sequentieel te werken en na elke stap te wachten, kan een goed geplande agent onafhankelijke taken identificeren en deze gelijktijdig uitvoeren. Deze parallelisatie kan de uitvoeringstijd 3-4 keer verkorten ten opzichte van traditionele reactieve agenten, zoals aangetoond door geavanceerde architecturen als LLMCompiler. Bovendien maakt planning betere foutafhandeling en herstel mogelijk: als er iets misgaat tijdens een plan, kan de agent vanaf dat punt herplannen in plaats van helemaal opnieuw te moeten beginnen. Dit maakt het systeem robuuster en efficiënter.

Schrijf u in voor onze nieuwsbrief

Ontvang gratis de nieuwste tips, trends en aanbiedingen.

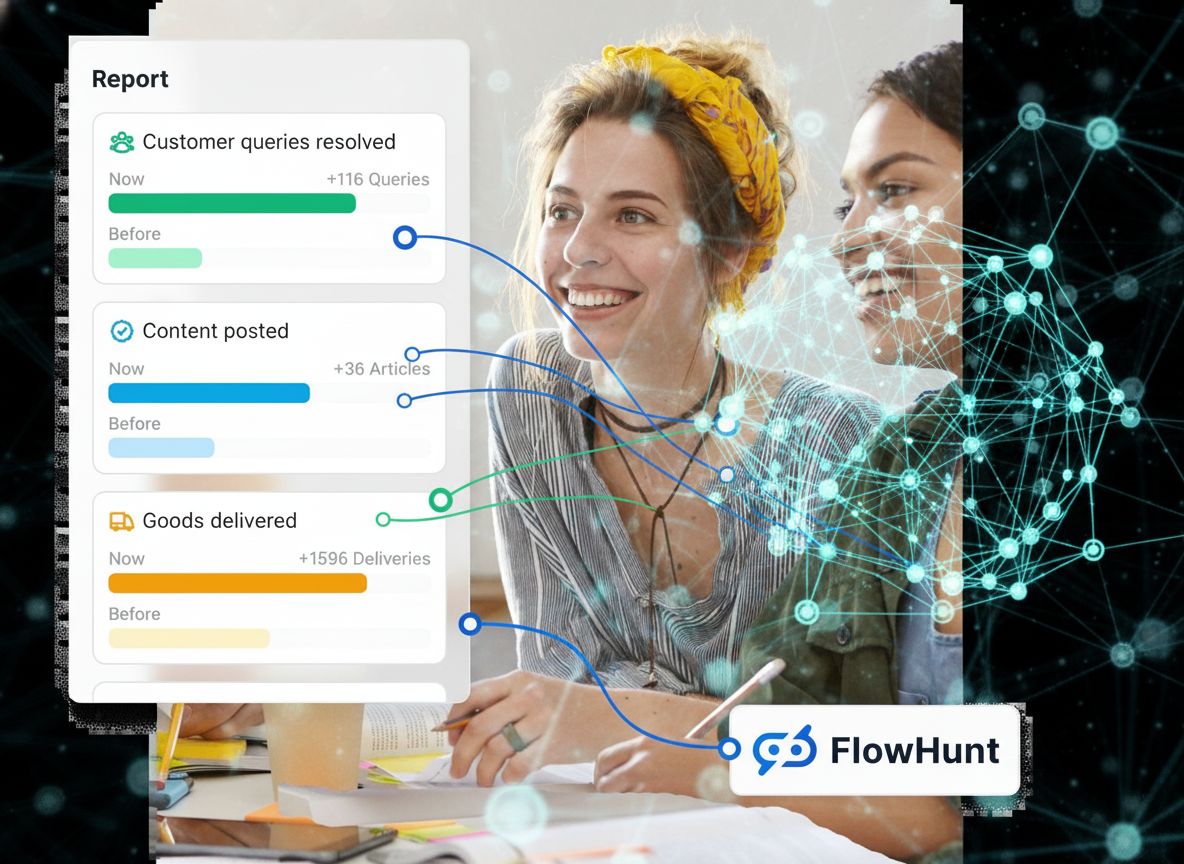

FlowHunt en AI-agentautomatisering: complexe workflows vereenvoudigen

FlowHunt biedt een krachtig platform om AI-agentworkflows te bouwen en automatiseren zonder diepgaande technische kennis. Het platform stelt gebruikers in staat om geavanceerde agentarchitecturen te ontwerpen, waaronder planning-gebaseerde agenten, via een intuïtieve no-code interface. Met FlowHunt kun je agenttoestanden definiëren, planningsstappen creëren, toolintegraties configureren en de uitvoering van agenten monitoren—zonder ingewikkelde code te schrijven. Dit democratisert AI-agentontwikkeling, zodat teams geavanceerde automatiseringssystemen kunnen bouwen die traditioneel veel engineering zouden vergen. De aanpak van FlowHunt sluit perfect aan bij de planning-gebaseerde architectuur uit dit artikel, waarmee gebruikers agenten kunnen maken die complexe taken opdelen in beheersbare stappen, nauwkeurig blijven bij grote informatiestromen en efficiënt uitvoeren.

Het platform biedt ook ingebouwde monitoring en analyses van agentprestaties, zodat teams kunnen zien waar hun agenten goed presteren en waar verbetering mogelijk is. Dit is cruciaal voor het itereren op agentontwerpen en het optimaliseren van hun gedrag. FlowHunt integreert met populaire LLM-leveranciers en toolecosystemen, zodat je eenvoudig jouw agenten kunt koppelen aan de benodigde bronnen. Of je nu onderzoeksagenten bouwt die het web moeten doorzoeken en informatie synthetiseren, automatiseringsagenten die meerdere systemen coördineren of klantenserviceagenten die complexe vragen beantwoorden, FlowHunt biedt de infrastructuur voor efficiënte realisatie.

LangGraph: de basis voor geavanceerde AI-agentimplementatie

LangGraph is een framework dat speciaal is ontworpen voor het bouwen van stateful AI-agenten met behulp van toestandsmachines. In de kern beschrijft LangGraph agentworkflows als gerichte grafen, waarbij elk knooppunt een toestand of actie voorstelt en de verbindingen de overgangen tussen toestanden zijn. Deze grafgebaseerde aanpak biedt verschillende voordelen boven traditionele, sequentiële programmering: de logica van de agent is expliciet en visueel, maakt complexe control flow inclusief lussen en conditionele vertakkingen mogelijk en biedt een duidelijke structuur voor toestandsbeheer gedurende de uitvoering. Bij het bouwen van een agent in LangGraph definieer je in feite een toestandsmachine die de agent volgt tijdens het uitvoeren van een taak.

Het concept van toestandsmachines is essentieel om te begrijpen hoe geavanceerde agenten werken. Bij een LangGraph-agent bevat de toestand alle informatie die de agent nodig heeft om beslissingen te nemen en acties uit te voeren. Voor een planning-gebaseerde agent kan de toestand onder andere de originele gebruikersvraag, het actuele plan, afgeronde taken, openstaande taken en alle resultaten van toolacties bevatten. Terwijl de agent het workflow doorloopt, wordt deze toestand bij elke stap bijgewerkt. Als de agent een taak voltooit, markeert hij deze als afgerond en slaat het resultaat op. Wanneer de agent moet bepalen wat hij vervolgens doet, onderzoekt hij de huidige toestand en kiest de juiste actie. Deze aanpak zorgt ervoor dat de agent altijd toegang heeft tot de benodigde informatie en consistentie behoudt gedurende de uitvoering.

Planning implementeren in LangGraph: de Deep Agent State

De implementatie van planning in LangGraph omvat het creëren van een gestructureerde toestand die de voortgang van de agent bijhoudt. De “Deep Agent State” is een datastructuur met twee primaire onderdelen: todos (te voltooien taken) en files (verzamelde informatie). Elk todo-item in de toestand staat voor een specifieke taak die de agent moet volbrengen, met eigenschappen zoals taakbeschrijving en huidige status (open, bezig of afgerond). Dankzij deze structuur kan de agent duidelijk bijhouden wat er nog moet gebeuren, waar hij aan werkt en wat er al afgerond is. Het bijhouden van de status is cruciaal omdat de agent zo zijn voortgang begrijpt en slimme beslissingen kan nemen over vervolgstappen.

De implementatie bevat ook een reducer-patroon voor toestandsupdates, vooral wanneer meerdere taken parallel worden uitgevoerd. Een reducer is een functie die de huidige toestand en een update ontvangt en een nieuwe toestand oplevert. Dit patroon is essentieel in LangGraph, omdat het ervoor zorgt dat wanneer meerdere threads of parallelle processen tegelijk de toestand bijwerken, de updates correct worden gecoördineerd en er geen informatie verloren gaat. Bijvoorbeeld: als twee taken tegelijk klaar zijn en beiden de toestand willen bijwerken, zorgt de reducer ervoor dat beide updates goed worden verwerkt. Dit is een geavanceerd concept dat productieklare agentimplementaties onderscheidt van simpele prototypes. Het reducer-patroon maakt ook complexere toestandsbeheer mogelijk, zoals het samenvoegen van resultaten uit verschillende parallelle taken of het oplossen van conflicten bij gelijktijdige toestandsupdates.

De workflow van de plannende agent: van vraag tot uitvoering

Een plannende agent volgt een specifieke workflow die laat zien hoe planning de prestaties verbetert. Wanneer een gebruiker een vraag stelt, gaat de agent eerst de planningsfase in, waarin hij het taalmodel gebruikt om een uitgebreid plan te genereren voor de vraag. Dit plan deelt de complexe taak op in kleinere, beheersbare stappen. Vraagt een gebruiker bijvoorbeeld “Geef me een korte samenvatting van MCP (Model Context Protocol)”, dan kan de agent een plan maken als: “Stap 1: Zoek informatie over MCP, Stap 2: Begrijp wat MCP is en de belangrijkste kenmerken, Stap 3: Synthetiseer de informatie tot een korte samenvatting.” De agent zet deze stappen op zijn todo-lijst in de toestand en markeert ze als open.

Na het maken van het plan begint de agent met uitvoeren. Hij leest de todo-lijst en werkt de taken een voor een af. Voor de eerste taak (informatie zoeken) gebruikt de agent de webzoektool met een geschikte zoekopdracht. De zoekresultaten worden opgeslagen in de toestand en de taak wordt als afgerond gemarkeerd. Bij de tweede taak kan de agent het taalmodel gebruiken om de zoekresultaten te verwerken en de kerninformatie over MCP te extraheren. Ook dit resultaat wordt opgeslagen en de taak wordt als afgerond gemarkeerd. Tot slot synthetiseert de agent bij de derde taak alle verzamelde informatie tot een korte samenvatting die direct antwoord geeft op de oorspronkelijke vraag. Gedurende dit proces houdt de agent duidelijk bij wat al gedaan is, waar hij mee bezig is en wat nog moet gebeuren. Deze gestructureerde aanpak zorgt ervoor dat de agent het overzicht behoudt en ook complexe, meerstaps taken betrouwbaar kan uitvoeren.

Geavanceerde planningsarchitecturen: verder dan basisplanning

Hoewel basisplanning al een grote verbetering is ten opzichte van reactieve agenten, zijn er diverse geavanceerde architecturen die planning nog verder brengen. De Plan-and-Execute-architectuur is de fundamentele planningsaanpak, waarbij een agent een plan maakt en dit stap voor stap uitvoert. Toch kent deze architectuur beperkingen: taken worden sequentieel afgewerkt en elke taak vereist een LLM-oproep. De ReWOO (Reasoning WithOut Observations)-architectuur pakt enkele van deze beperkingen aan door de planner variabelen te laten toewijzen. In ReWOO kan de planner eerdere taakuitkomsten refereren met syntaxis als “#E2” (de output van taak 2), zodat taken afhankelijk kunnen zijn van eerdere resultaten zonder dat de planner na elke stap opnieuw bevraagd hoeft te worden. Dit vermindert het aantal LLM-oproepen en maakt efficiëntere taakuitvoering mogelijk.

De LLMCompiler-architectuur is de nieuwste ontwikkeling in planning-gebaseerde agentontwerpen en introduceert innovaties die de prestaties sterk verbeteren. Ten eerste genereert de planner een gerichte acyclische graaf (DAG) van taken, in plaats van een eenvoudige lijst. Elke taak in de DAG bevat de tool die moet worden aangeroepen, de te leveren argumenten en een lijst met afhankelijkheden (welke andere taken afgerond moeten zijn voordat deze taak kan starten). Ten tweede ontvangt de taakophaalunit de gestreamde output van de planner en plant taken zodra hun afhankelijkheden zijn vervuld. Dit maakt grootschalige parallelisatie mogelijk: als de planner tien onafhankelijke taken identificeert, kunnen deze allemaal tegelijk worden uitgevoerd in plaats van achter elkaar. Ten derde kunnen taakargumenten variabelen zijn die verwijzen naar eerdere taakresultaten, waardoor de agent nog sneller kan werken dan met traditionele parallelle toolcalls. De combinatie van deze eigenschappen zorgt volgens het onderzoek voor een 3,6x snellere uitvoering dan bij traditionele agenten. Deze geavanceerde architecturen tonen aan dat planning niet één techniek is, maar een spectrum aan benaderingen met elk hun eigen balans tussen complexiteit, prestaties en kosten.

Opdat een plannende agent effectief is, moet hij beschikken over de juiste tools om informatie te verzamelen en acties uit te voeren. De meest gebruikte tools zijn webzoek (voor informatie op internet), databasequeries (voor gestructureerde data), API-aanroepen (voor interactie met externe diensten) en taalmodelcalls (voor verwerking en redeneren over informatie). In de LangGraph-implementatie krijgt de agent tools aangeboden via een doordachte interface. De agent kan tools aanroepen door specifieke functie-oproepen te genereren, waarna de resultaten terug aan de agent worden geleverd voor verwerking. Effectieve toolintegratie vereist dat elke tool goed gedefinieerd is met duidelijke input en output, en dat de agent begrijpt wanneer en hoe hij elke tool moet gebruiken.

Naast basistools beschikken geavanceerde planningsagenten vaak over gespecialiseerde tools om hun eigen toestand en voortgang te beheren. Bijvoorbeeld, een “lees todos”-tool laat de agent zijn huidige plan inspecteren en zien welke taken nog open staan. Met een “schrijf todos”-tool kan de agent zijn plan bijwerken, taken afronden of nieuwe taken toevoegen op basis van wat hij tijdens de uitvoering leert. Deze metatools (tools die op de eigen toestand werken) zijn essentieel om de agent zijn plan te laten aanpassen terwijl hij nieuwe informatie opdoet. Ontdekt de agent tijdens de uitvoering dat zijn oorspronkelijke plan niet compleet of juist was, dan kan hij via de schrijf todos-tool het plan wijzigen. Deze adaptieve planningscapaciteit onderscheidt productieklare agenten van simpele prototypes. De combinatie van domeinspecifieke tools (voor het echte werk) en metatools (voor het plannings- en redeneerproces van de agent zelf) creëert een krachtig systeem dat complexe, onvoorspelbare scenario’s aankan.

Praktisch voorbeeld: een onderzoeksagent implementeren

Om te laten zien hoe planning in de praktijk werkt, nemen we een onderzoeksagent die informatie moet verzamelen over een complex onderwerp. Bij de vraag “Geef een uitgebreid overzicht van Model Context Protocol (MCP) en de toepassingen ervan”, volgt de agent deze workflow. Eerst maakt hij een plan: “Stap 1: Zoek algemene informatie over MCP, Stap 2: Zoek MCP-toepassingen en use cases, Stap 3: Zoek technische details over MCP-implementatie, Stap 4: Synthetiseer alle informatie tot een compleet overzicht.” De agent noteert deze vier taken als openstaande todos. Vervolgens start hij de uitvoering. Voor stap 1 zoekt hij met de webzoektool naar “Wat is Model Context Protocol MCP?” en slaat de resultaten op. Daarna zoekt hij voor stap 2 naar “MCP-toepassingen en use cases”, weer met opslag van de resultaten. Voor stap 3 zoekt hij technische implementatiedetails. Tot slot gebruikt hij het taalmodel bij stap 4 om alle verzamelde informatie samen te voegen tot een samenhangend, volledig overzicht dat de oorspronkelijke vraag beantwoordt.

Gedurende het proces houdt de agent zijn voortgang nauwkeurig bij. Als hij onderweg ontdekt dat het plan niet compleet is (bijvoorbeeld als de zoekresultaten onvoldoende informatie opleveren over een specifiek aspect), kan hij het plan aanpassen door extra taken toe te voegen. Deze adaptieve mogelijkheid is cruciaal voor realistische scenario’s, waar het initiële plan vaak niet volstaat. De agent kan ontdekken dat hij meer informatie nodig heeft over specifieke MCP-implementaties of dat hij MCP moet vergelijken met alternatieven. Doordat hij het plan halverwege kan aanpassen, kan de agent deze ontdekkingen soepel verwerken in plaats van te falen of onvolledige antwoorden te geven. Dit voorbeeld toont de kracht van planning: het geeft structuur en duidelijkheid aan het redeneerproces van de agent, terwijl het flexibel blijft voor nieuwe inzichten.

{{ cta-dark-panel

heading=“Versnel je workflow met FlowHunt”

description=“Ervaar hoe FlowHunt je AI-content- en SEO-workflows automatiseert—van onderzoek en contentcreatie tot publicatie en analyse—alles op één plek.”

ctaPrimaryText=“Boek een demo”

ctaPrimaryURL=“https://calendly.com/liveagentsession/flowhunt-chatbot-demo"

ctaSecondaryText=“Probeer FlowHunt gratis”

ctaSecondaryURL=“https://app.flowhunt.io/sign-in"

gradientStartColor="#123456”

gradientEndColor="#654321”

gradientId=“827591b1-ce8c-4110-b064-7cb85a0b1217”

}}

Prestatie-optimalisatie: kosten verlagen en snelheid verhogen

Eén van de meest overtuigende redenen om planning te implementeren in AI-agenten is de sterke verbetering van prestatiecijfers. Traditionele ReAct-agenten vereisen een LLM-oproep voor elke actie, dus een taak met tien stappen vraagt tien LLM-oproepen. Planning-gebaseerde agenten hebben doorgaans maar twee of drie LLM-oproepen nodig: één voor de initiële planningsfase, één of meer voor specifieke redenerende taken, en eventueel één voor herplanning als het oorspronkelijke plan onvoldoende blijkt. Deze reductie in LLM-oproepen vertaalt zich direct in kostenbesparing, vooral bij het gebruik van dure modellen als GPT-4. Voor organisaties die dagelijks duizenden agentuitvoeringen draaien, kan het verschil tussen ReAct- en planning-gebaseerde agenten flink oplopen—tientallen duizenden euro’s per maand aan besparing.

Naast kostenbesparing zorgen planning en parallelisatie voor een aanzienlijke snelheidswinst. Bij traditionele agenten moet elke stap voltooid zijn voordat de volgende begint, wat een bottleneck vormt. Planning-agenten, vooral die met DAG-gebaseerde architecturen zoals LLMCompiler, kunnen onafhankelijke taken identificeren en parallel uitvoeren. Wanneer er bijvoorbeeld informatie over onderwerp A én B nodig is, en deze losstaan, kunnen beide zoekopdrachten tegelijk plaatsvinden. Dit kan de totale uitvoeringstijd met 3-4 keer verkorten ten opzichte van sequentiële uitvoering. Voor eindgebruikers betekent deze snelheidsverbetering een betere ervaring. Voor batchverwerking levert het meer werk in dezelfde tijd op. De combinatie van kostenverlaging en snelheid maakt planning-gebaseerde agenten aantrekkelijk voor vrijwel elke organisatie die AI-agenten op schaal gebruikt.

Omgaan met complexiteit: als plannen moeten worden aangepast

De praktijk verloopt zelden volgens een perfect plan. Planning-agenten moeten kunnen omgaan met situaties waarin het oorspronkelijke plan niet voldoende of onjuist blijkt. Dit vereist geavanceerde foutafhandeling en herplanningsmogelijkheden. Als een agent een onverwachte situatie tegenkomt—zoals een tool die een foutmelding geeft, zoekresultaten die niet voldoen of een taak die complexer is dan gedacht—moet hij zich kunnen aanpassen. De beste aanpak is dat de agent herplant op basis van wat hij geleerd heeft. Als een agent bijvoorbeeld had gepland op informatie te zoeken en deze te synthetiseren, maar de zoekopdracht levert niets op, moet hij dit herkennen en zijn plan herzien. Misschien probeert hij andere zoektermen, alternatieve bronnen, of splitst hij de taak anders op.

Adaptieve planning vereist zorgvuldig toestandsbeheer en beslislogica. De agent moet niet alleen bijhouden wat hij gedaan heeft, maar ook wat hij geleerd heeft over het probleem. Als een zoekopdracht naar “MCP” geen resultaten oplevert, zou de agent “Model Context Protocol” of “MCP protocol” moeten proberen vóór hij opgeeft. Als een tool faalt, moet de agent besluiten of hij het opnieuw probeert, een andere tool probeert of het probleem escaleert. Deze beslissingen vragen van de agent dat hij redeneert over zijn voortgang en zijn strategie aanpast. Hier komt het voordeel van een plannende agent duidelijk naar voren: omdat er een expliciet plan is, kan de agent beoordelen of het plan werkt en geïnformeerde keuzes maken over bijsturen. Een reactieve agent heeft die structuur niet en moet ad hoc beslissingen nemen zonder het totaaloverzicht.

Monitoring en debugging van plannende agenten

Naarmate plannende agenten geavanceerder worden, wordt monitoring en debugging steeds belangrijker. In tegenstelling tot simpele toepassingen waarbij je het pad eenvoudig kunt volgen, kennen plannende agenten meerdere beslissingspunten, toolaanroepen en toestandsupdates. Effectieve monitoring vraagt inzicht in verschillende aspecten van de agentuitvoering: het gemaakte plan, de voltooide taken, de resultaten van elke toolactie en de beslissingen die de agent bij elke stap nam. LangGraph biedt hiervoor geïntegreerde ondersteuning via LangSmith, een monitoring- en debugplatform dat de uitvoering van de agent als een graaf visualiseert. Je ziet precies welke knooppunten zijn uitgevoerd, in welke volgorde en welke toestand telkens werd doorgegeven. Deze visualisatie is onmisbaar om te begrijpen waarom een agent zich op een bepaalde manier gedroeg en waar verbetering mogelijk is.

Debuggen vereist ook inzicht in de prompts die gebruikt zijn om plannen te genereren. De kwaliteit van het plan bepaalt direct de prestaties van de agent, dus als een agent slecht presteert, begin dan met het analyseren van de planningsprompt. Mogelijk biedt de prompt te weinig context over de taak of legt hij niet duidelijk uit welke plannen verwacht worden. Het itereren op de planningsprompt kan agentprestaties vaak sterk verbeteren. Ook het monitoren van toolresultaten helpt bij het vaststellen of tools leveren wat verwacht wordt of aanpassing nodig hebben. Geeft een webzoektool bijvoorbeeld irrelevante resultaten, dan kun je het zoekopdrachtformaat aanpassen of filters toevoegen. Door de uitvoeringgraaf te visualiseren en prompts en toolresultaten te analyseren, kun je planning-agenten systematisch verbeteren.

Best practices voor het bouwen van plannende agenten

Gebaseerd op onderzoek en praktijkervaring zijn er verschillende best practices voor effectieve plannende agenten. Allereerst: investeer tijd in het maken van hoogwaardige planningsprompts. De prompt moet de taak duidelijk uitleggen, voorbeelden van goede plannen geven en het formaat van het planoutput specificeren. Een goede planningsprompt verbetert de kwaliteit van plannen en vermindert de noodzaak tot herplannen. Ten tweede: ontwerp je toestandsstructuur zorgvuldig. De toestand moet alle informatie bevatten die de agent nodig heeft voor beslissingen, maar niet zoveel dat het onoverzichtelijk wordt. Een goede toestand laat de agent eenvoudig zijn voortgang begrijpen en goede keuzes maken voor vervolgstappen. Ten derde: bied duidelijke, goed gedocumenteerde tools. Iedere tool moet een duidelijk doel, goed gedefinieerde input/output en foutafhandeling hebben. Goed ontworpen tools stellen agenten in staat ze effectiever te gebruiken en betere resultaten te behalen.

Ten vierde: implementeer robuuste foutafhandeling en herplanning. Ga ervan uit dat dingen misgaan—tools falen, zoekopdrachten leveren onverwachte resultaten op en plannen moeten worden aangepast. Bouw mechanismen in waarmee de agent deze situaties herkent en zich aanpast. Ten vijfde: monitor en verbeter. Gebruik monitoringtools om de prestaties van je agenten te begrijpen, knelpunten en faalpatronen te ontdekken en je ontwerpen te verbeteren. Kleine verbeteringen aan prompts, tools of toestandsbeheer kunnen grote impact hebben op de prestaties. Ten zesde: weeg de balans tussen planningscomplexiteit en uitvoersnelheid. Complexere planning (zoals DAG-gebaseerd) levert betere prestaties, maar verhoogt de complexiteit. Begin met eenvoudige planning en ga pas naar geavanceerdere vormen als het echt nodig is. Tot slot: test uitgebreid vóór productie. Plannende agenten kunnen complexe scenario’s aan, maar kunnen ook op onverwachte manieren falen. Grondig testen helpt problemen te identificeren en te verhelpen vóór ze de gebruikers raken.

De toekomst van AI-agentplanning

Het vakgebied van AI-agentplanning ontwikkelt zich razendsnel, met steeds nieuwe architecturen en technieken. Een veelbelovende richting is het integreren van leren in plannende agenten. In plaats van vaste planningsprompts zouden agenten kunnen leren van hun ervaringen en hun planning gaandeweg verbeteren. Een andere ontwikkeling is de opkomst van geavanceerdere planningsalgoritmen die nog complexere scenario’s aankunnen, zoals plannen met onzekerheid of meerdere, conflicterende doelen. Onderzoek naar hiërarchische planning—waarbij agenten eerst globale plannen maken en die vervolgens steeds gedetailleerder uitwerken—kan agenten in staat stellen steeds ingewikkelder taken aan te pakken. Daarnaast mogen we, naarmate taalmodellen blijven verbeteren, steeds betere planningsmogelijkheden direct in de modellen zelf verwachten, waardoor externe planningsmechanismen minder nodig zijn.

De integratie van planning met andere AI-technieken is ook een actief onderzoeksgebied. Zo zou de combinatie van planning met retrieval-augmented generation (RAG) agenten in staat kunnen stellen hun informatiezoekstrategie te plannen, wat de nauwkeurigheid en efficiëntie verder verhoogt. Het combineren van planning met reinforcement learning zou agenten in staat stellen optimale planningsstrategieën voor specifieke domeinen te leren. Naarmate deze technieken rijpen en toegankelijker worden via platforms als FlowHunt, zal planning-gebaseerde agentarchitectuur de standaard worden voor complexe AI-automatiseringsoplossingen. De toekomst van AI-agenten draait niet om steeds krachtigere individuele modellen, maar om slimme systemen die complexe problemen begrijpen, hun aanpak plannen en efficiënt uitvoeren.

Conclusie

Planning betekent een fundamentele verschuiving in hoe we AI-agenten bouwen: van reactieve, stap-voor-stap benaderingen naar proactieve, gestructureerde redenering. Door agenten te dwingen taken vooraf te doordenken en expliciete plannen te maken, overwinnen we beperkingen van het contextvenster, verlagen we kosten, verhogen we de snelheid en kunnen we beter omgaan met complexe scenario’s. De implementatie van planning in frameworks als LangGraph biedt praktische tools voor het bouwen van deze geavanceerde agenten, terwijl platforms als FlowHunt geavanceerde agentcapaciteiten toegankelijk maken voor teams zonder diepgaande technische kennis. Of je nu onderzoeksagenten, automatiseringssystemen of intelligente assistenten bouwt, het opnemen van planning in je agentarchitectuur zal prestaties en betrouwbaarheid sterk verbeteren. Naarmate het vakgebied zich verder ontwikkelt, zullen planning-gebaseerde agenten centraal staan in de manier waarop organisaties AI inzetten voor complexe probleemoplossing en automatisering.