Waar en hoe te beginnen met AI in E-commerce: Een praktische routekaart

Een praktisch raamwerk voor het implementeren van AI in e-commerce van Quality Unit's CMO. Leer waar te beginnen, veelvoorkomende uitdagingen, strategieën voor ...

Een technische gids voor oprichters over het implementeren van AI-handelsprotocollen (UCP, ACP, AP2), het beheersen van technische SEO-fundamenten en het genereren van content die geoptimaliseerd is voor zowel traditioneel zoeken als AI-citaten.

Viktor Zeman richtte meer dan twee decennia geleden Quality Unit op en heeft de ontwikkeling en wereldwijde groei van de productsuite geleid, inclusief FlowHunt. Sinds 2024 richt hij zich specifiek op FlowHunt en helpt hij bedrijven bij het implementeren van praktische AI-oplossingen, automatisering en moderne AI-gedreven werkomgevingen. Zijn E-commerce Mastermind-presentatie ging diep in op drie kritieke gebieden van technische implementatie van AI in e-commerce.

De presentatie beschreef specifieke protocollen, technische implementaties en contentstrategieën die getest zijn binnen Quality Unit’s producten en klantenbestand. Wat volgt is Viktor’s technische routekaart voor het vindbaar maken van e-commercesites via AI-systemen, functioneel binnen door AI bemiddelde handel en concurrerend terwijl zoeken verschuift van keywords naar AI-citaten.

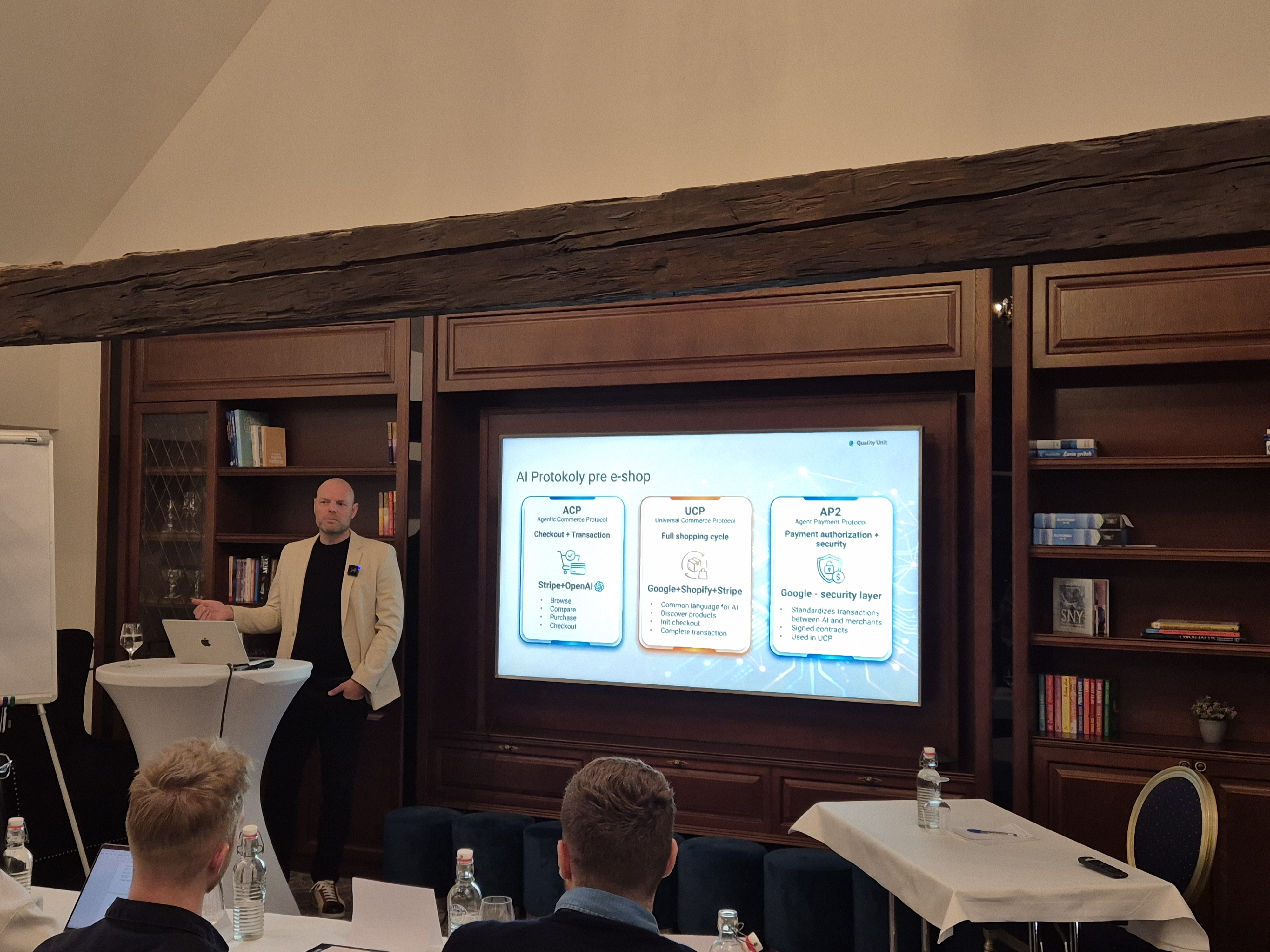

Viktor legde de basis door de gestandaardiseerde protocollen te introduceren die AI in staat stellen om namens gebruikers te communiceren met e-commercesystemen.

Grote platforms zoals Shopify, Salesforce Commerce Cloud of BigCommerce zijn al begonnen met het implementeren van delen van deze protocollen. Dat geldt ook voor de betalingsverwerkers Stripe, PayPal en Checkout.com. Dit laat duidelijk zien dat AI-handelscompatibiliteit een competitieve baseline wordt.

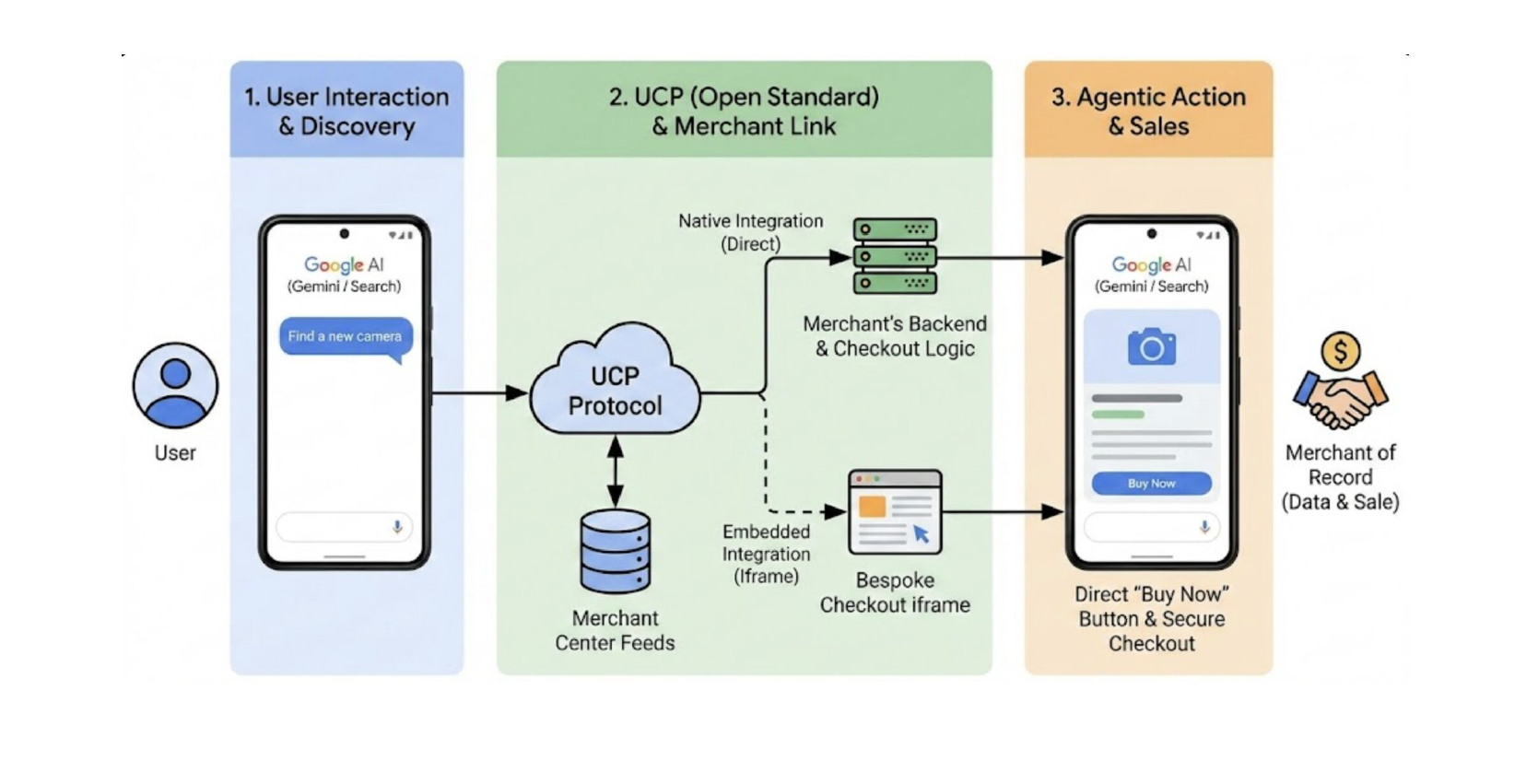

Universal Commerce Protocol (UCP) stelt AI-assistenten in staat om producten te ontdekken, opties te vergelijken, het afrekenproces te starten en transacties te voltooien zonder dat gebruikers de AI-interface verlaten. UCP is al geïmplementeerd in Shopify, Salesforce Commerce Cloud, BigCommerce en grote betalingsverwerkers.

Agentic Commerce Protocol (ACP), een samenwerking tussen Stripe en OpenAI, richt zich specifiek op transactieveiligheid en eenvoud binnen conversationele interfaces. Terwijl UCP de bredere winkelcyclus aanpakt, specialiseert ACP zich in het aankoopproces, omdat het afrekenen mogelijk maakt binnen chatinterfaces.

Agent Payment Protocol (AP2), ontwikkeld door Google, biedt het beveiligingsraamwerk dat door AI bemiddelde transacties betrouwbaar maakt door middel van transactieondertekening, handelaarautenticatie en betalingsautorisatie. AP2 integreert met UCP om de vertrouwenslaag te bieden die autonome AI-aankopen tot realiteit maakt.

Om uw e-shop compatibel te maken met AI-gedreven winkelen, en dus aanbevolen te worden door AI-platforms, moet u machineleesbare data op meerdere niveaus beschikbaar stellen:

Producten moeten beschreven worden met standaarden zoals:

schema.org: Geef AI gestructureerde data die het kan lezen en begrijpenDit stelt AI-systemen in staat om producten zonder dubbelzinnigheid te interpreteren, inclusief de varianten, prijzen, beschikbaarheid en verzendingsbeperkingen. Het is de basis die AI-systemen gebruiken om te begrijpen wat u verkoopt.

AI-agents evalueren niet alleen de producten, ze evalueren ook of de handelaren betrouwbaar zijn en goed passen bij de gebruiker. Daarom moet belangrijke informatie over uw bedrijf expliciet en toegankelijk zijn:

Veel van deze data bestaat al in systemen zoals Google Merchant Center, maar het moet compleet, accuraat en consistent onderhouden worden.

Een van de minder zichtbare maar kritieke componenten is het handelsmanifest. Het is meestal een JSON-bestand dat gehost wordt op het domein van de handelaar.

Dit manifest definieert ondersteunde protocolversies, beschikbare diensten, betalingshandlers en afrekeningsmogelijkheden, waardoor AI-agents begrijpen hoe uw winkel werkt.

Implementeer drie kritieke eindpunten:

Implementeer het eerder genoemde Agent Payment Protocol voor veilige transactieverwerking.

Voor platforms zonder native UCP-ondersteuning biedt MCP een integratiepad. Zeman benadrukte het groeiende belang van MCP als de verbindingslaag tussen AI-agents en bestaande systemen.

Het ontwikkelen van een aangepaste MCP-server stelt u in staat om precieze prompts te creëren die zijn afgestemd op uw specifieke use cases en geïsoleerde API-aanroepen te verzenden met goede rate limiting. Op deze manier kunt u er zeker van zijn dat uw AI-implementatie veilig, gecontroleerd en zo goedkoop mogelijk zal zijn.

Voorbeeld: Een chatbot geïntegreerd met e-commerce MCP en een verzendprovider (bijv. Chameleon) stelt klanten in staat om niet alleen de orderstatus op te vragen, maar ook de levering in realtime te volgen, allemaal binnen één gesprek.

Het tweede implementatieonderwerp dat Viktor behandelde was technische SEO. Hij benadrukte dat de hoeksteen van SEO geen keywords zijn. Het is “een infrastructuur die zowel zoekmachines als AI-systemen kunnen benaderen en vertrouwen”. Want langzame en onbetrouwbare sites worden verlaten door zowel gebruikers als crawlers.

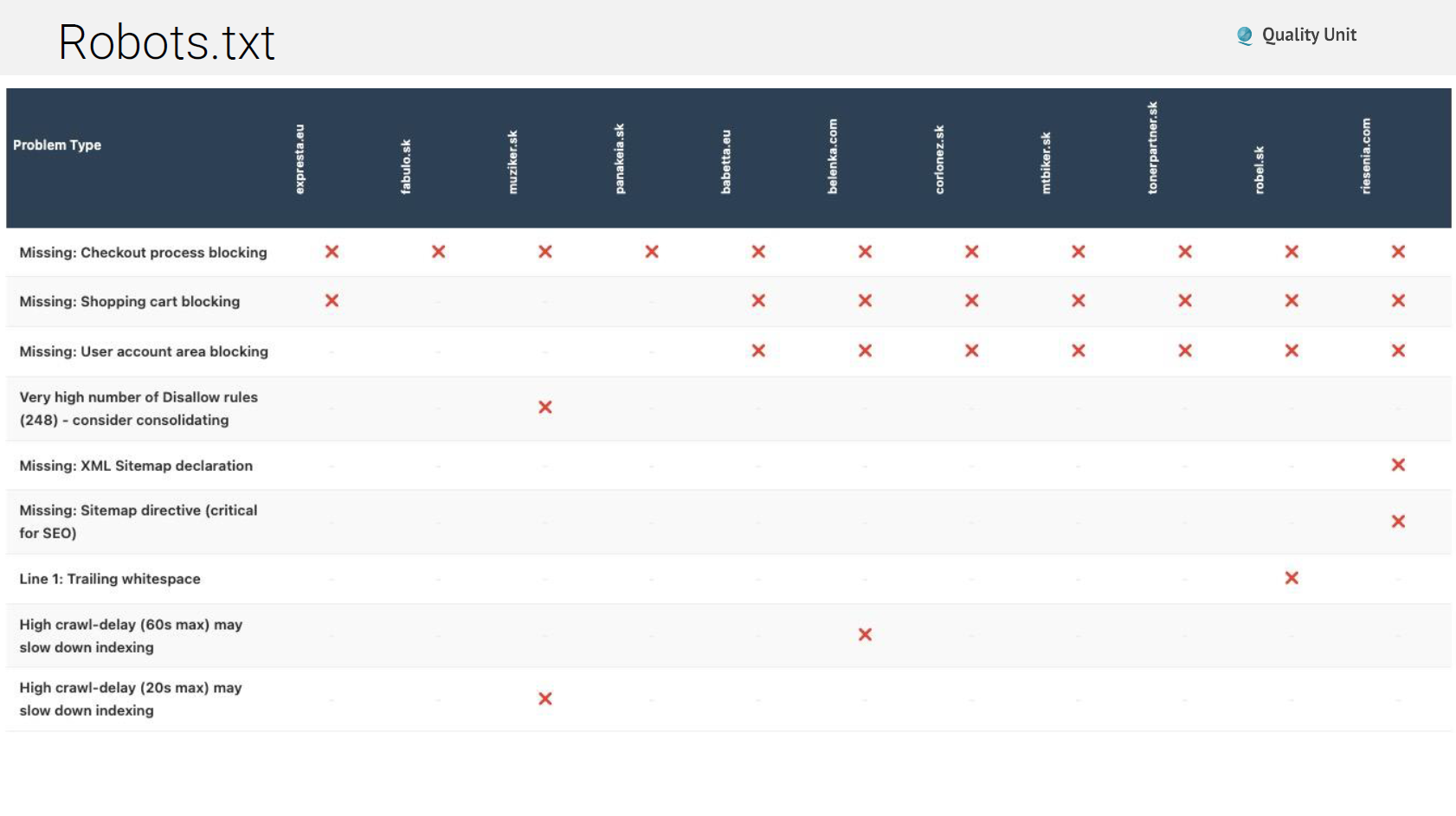

Ondanks dat het een 30 jaar oude standaard is, wordt robots.txt nog steeds vaak verkeerd geconfigureerd. De veelvoorkomende problemen zijn:

Niet-bestaande robots.txt: Sommige sites retourneren foutpagina’s of onderhoudsmeldingen in plaats van correcte robots.txt-bestanden, waardoor crawlers in verwarring raken over wat toegestaan is.

Geblokkeerde AI-bots: Het blokkeren van AI-crawlers voorkomt dat uw content geciteerd wordt in AI-antwoorden. Hoewel u sommige bots misschien wilt blokkeren, elimineert algeheel blokkeren AI-zichtbaarheid.

Ontbrekende sitemap-richtlijnen: Robots.txt moet verwijzen naar uw XML-sitemaps en crawlers begeleiden naar volledige contentontdekking.

Syntaxfouten: Afsluitende komma’s in wildcards (Disallow: /?pv=*,) veroorzaken parseerfouten in sommige crawlers, wat leidt tot onbedoeld blokkeren.

Geblokkeerde waardevolle content: Soms blokkeren sites content die ze eigenlijk geïndexeerd willen hebben, meestal door te brede wildcard-regels.

XML-sitemaps vertellen zoekmachines en AI-systemen welke content bestaat en hoe deze is georganiseerd. Veelvoorkomende problemen op dit gebied zijn:

Cache header-problemen: Onjuiste cache headers kunnen voorkomen dat sitemaps correct worden bijgewerkt, waardoor crawlers achterhaalde contentlijsten krijgen.

Onvolledige URL-dekking: Door plugins gegenereerde sitemaps missen vaak aangepaste post types, taxonomieën of dynamische pagina’s, waardoor aanzienlijke content onontdekt blijft.

Rate limiting-problemen: Sommige sites implementeren agressieve rate limiting die het ophalen van sitemaps volledig blokkeert en 429-fouten retourneert na slechts 10 URL’s.

Links naar 404-pagina’s: Sitemaps met dode links verspillen crawlerbudget en signaleren slecht siteonderhoud.

Correcte HTTP cache headers verbeteren de prestaties voor terugkerende bezoekers dramatisch en verminderen de serverbelasting. Toch configureren veel sites dit volledig verkeerd. Cache-Control-richtlijnen zijn belangrijk:

Viktor benadrukte het controleren van cache headers voor alle asset types: HTML, CSS, JavaScript, afbeeldingen, lettertypen en API-antwoorden.

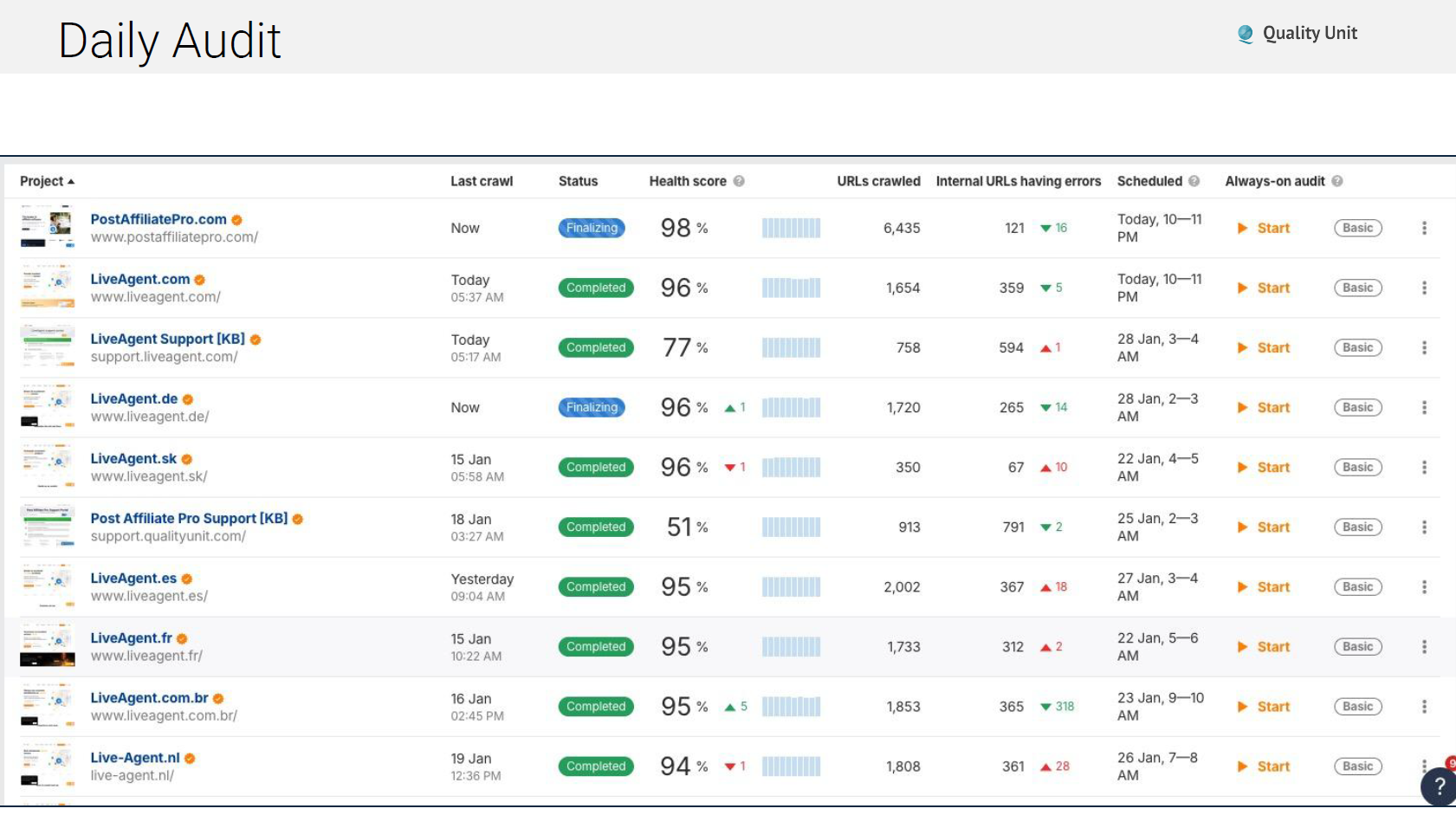

Technische problemen ontstaan constant en daarom voert ons team geautomatiseerde dagelijkse audits uit die controleren op:

Het gebruik van tools zoals Ahrefs voor geautomatiseerde monitoring zorgt ervoor dat problemen worden gevonden en opgelost voordat ze zich ophopen tot grote verkeersverliezen:

Google’s Core Web Vitals beïnvloeden rankings direct. U moet zich vooral richten op deze twee kritieke tools: PageSpeed Insights biedt labdata die potentiële prestaties onder gecontroleerde omstandigheden toont. Chrome User Experience Report (CrUX) biedt real-world data van echte gebruikers die uw site bezoeken.

De drie kritieke metrieken om op te letten zijn:

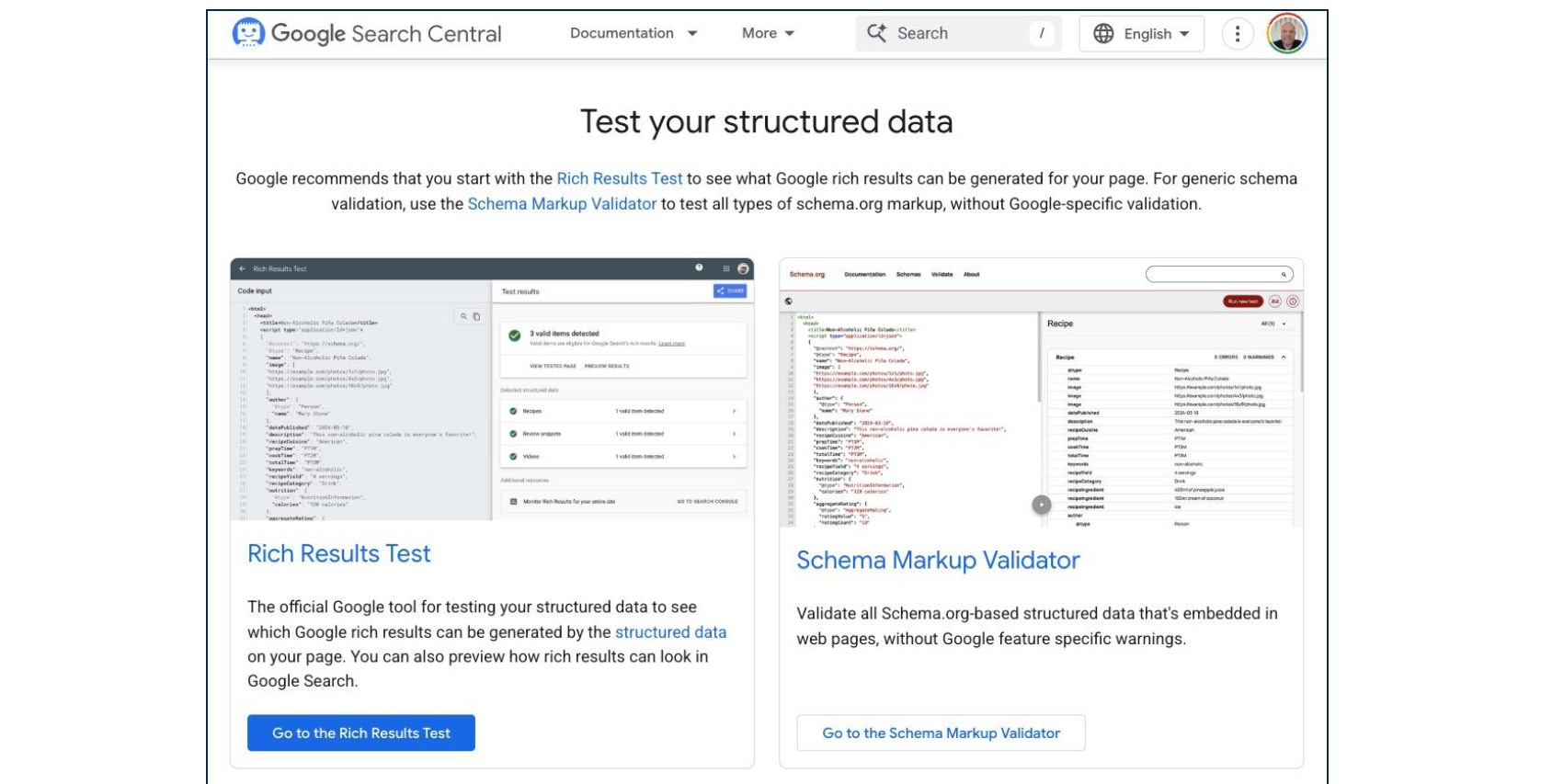

Schema.org-markup transformeert HTML in machineleesbare gestructureerde data. Zowel traditionele zoekmachines als AI-systemen vertrouwen op schema om contentcontext en relaties te begrijpen.

Essentiële schema-types voor e-commerce:

Veelvoorkomende schema-implementatiefouten zijn:

Regelmatige validatie via Google’s Rich Results Test zorgt ervoor dat schema correct gestructureerd en compleet blijft.

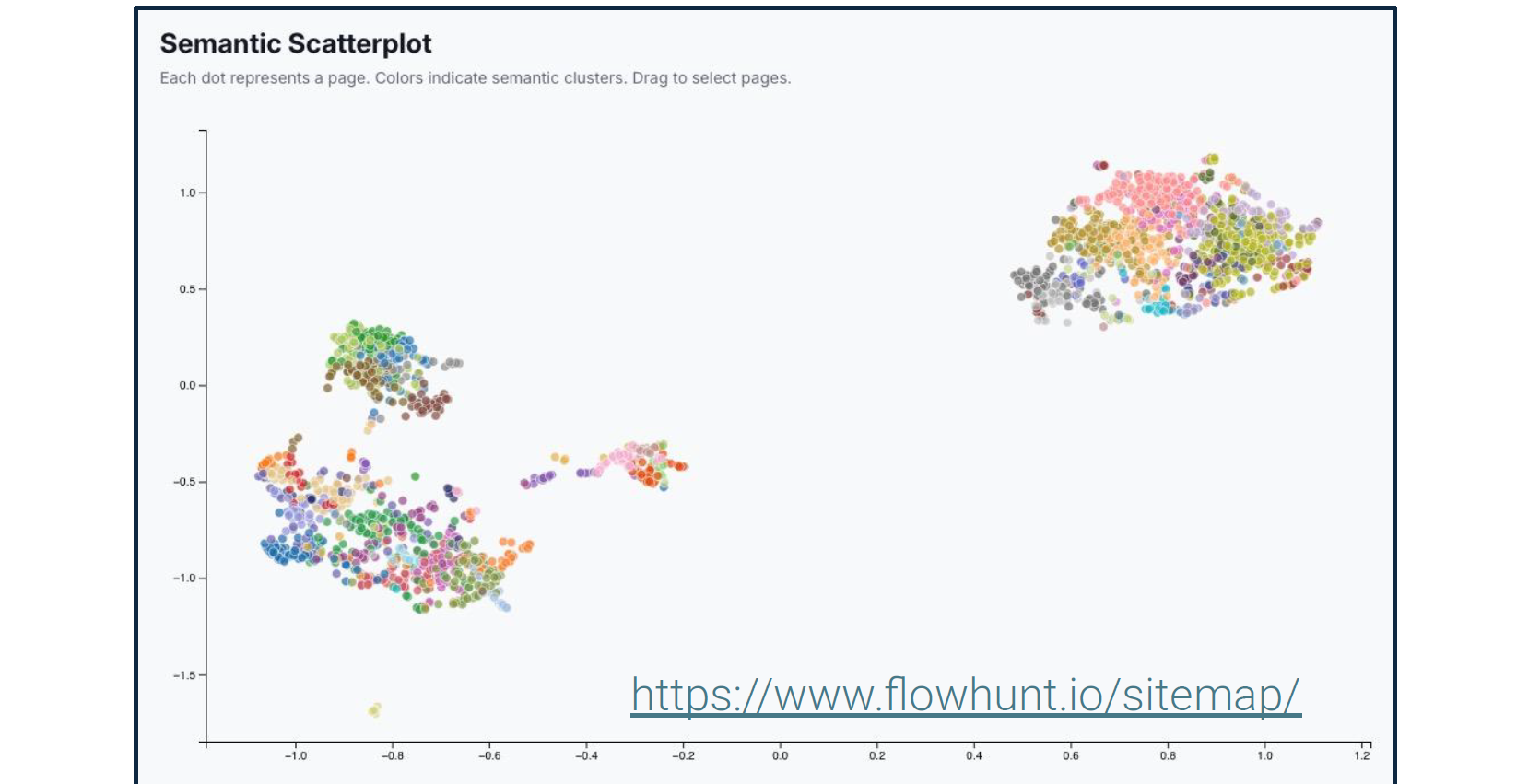

Viktor benadrukte herhaaldelijk dat SEO niet langer over keywords gaat. Hij beschreef semantische analysetools die onthullen hoe zoekmachines en AI-systemen de betekenis van uw content begrijpen in plaats van alleen de woorden.

Deze tools visualiseren entiteitsrelaties, onderwerpdekking en semantische verbindingen binnen uw content. AI-systemen gebruiken deze relaties om te bepalen wanneer uw content specifieke vragen beantwoordt, zelfs wanneer exacte keywords niet verschijnen.

Terwijl traditionele SEO vroeg: “Bevat deze pagina de juiste keywords?” vraagt moderne SEO: “Toont deze pagina expertise over relevante entiteiten en hun relaties?”

“Google geeft er niet om of je zegt dat je ‘De snelste telefoonreparatiewinkel in Bratislava’ bent. Het vraagt of je website expertise toont over de entiteit ’telefoon’ in relatie tot de entiteiten ‘reparatie’ en ‘Bratislava’. Valideren andere bronnen expertise over deze entiteiten? Bijvoorbeeld reviews of native ads. Signaleert gebruikersgedrag, zoals tijd doorgebracht op de site, dat de content relevant is?” - Viktor Zeman

Hij benadrukt verder dat u moet beginnen met snelle overwinningen, zoals het oplossen van enkele van uw technische SEO-problemen. De resultaten zouden snel zichtbaar moeten zijn. Pas als AI en zoekmachines uw site correct kunnen lezen en begrijpen, is het tijd om te beginnen met het creëren van keyword-rijke content.

Viktor daagde conventionele wijsheid over linkbuilding uit en betoogde dat interne linkstructuur veel meer aandacht verdient dan de meeste sites eraan geven.

PageRank-distributie: Google (en in toenemende mate AI-systemen) stromen autoriteit door links. Uw interne linkstructuur bepaalt welke pagina’s die autoriteit ontvangen.

Link juice-concentratie: Links van pagina’s met veel verkeer dragen meer waarde dan links van zelden bezochte pagina’s. Strategische interne linking versterkt de impact van uw populairste content.

Context door ankertekst: De woorden die in links worden gebruikt signaleren onderwerprelaties aan zowel zoekmachines als AI-systemen.

Plaatsingshiërarchie: Links in hoofdcontent dragen meer gewicht dan footer- of navigatielinks.

Op onze websites vechten we niet tegen windmolens door te proberen handmatige interne links op schaal te behouden. In plaats daarvan hebben we geautomatiseerde interne linking op schaal geïmplementeerd. Deze automatisering houdt rekening met:

Het resultaat is een uitgebreide interne linkstructuur die onmogelijk handmatig te onderhouden zou zijn, terwijl wordt gegarandeerd dat elk stuk content logisch verbonden is met gerelateerde onderwerpen.

Viktor’s benadering van AI-contentgeneratie richt zich op systematische structuur in plaats van ad-hoc artikelcreatie.

Voordat u content genereert, begrijp hoe AI-systemen momenteel uw branche bespreken: Stap 1: Genereer testprompts - Creëer 500+ vragen die representeren hoe gebruikers AI-systemen kunnen bevragen over onderwerpen in uw domein. Stap 2: Analyseer AI-antwoorden - Gebruik tools zoals AmICited.com om te zien welke bronnen AI-systemen momenteel citeren bij het beantwoorden van deze prompts.

Dit zal onthullen:

Stap 3: Identificeer hiaten - Vind vragen waar AI-systemen zwakke antwoorden geven of slechte bronnen citeren. Deze vertegenwoordigen kansen om de gezaghebbende citatie te worden.

AI-geoptimaliseerde productbeschrijvingen zijn gunstig voor drie kritieke kanalen:

In plaats van generieke “blogcontent” pleit Viktor voor het creëren van gespecialiseerde AI-agents om elk afzonderlijk posttype te genereren, elk met gedefinieerde elementen en structuur. Bijvoorbeeld woordenlijst, checklists, how-to posts, featuredocumentatie, maar ook herbruikbare blogframeworks zoals analyse, inzichten, branchecommentaar.

Hoewel een algemene AI-agent met een echt goede prompt de eerste keer goud kan vinden, is dat niet wat u nodig heeft. U zoekt naar schaal en herhaalbare nauwkeurige workflows. Elke keer nieuwe prompts voor agents schrijven, hopen dat ze werken en vervolgens de prompts in een notitieblok opslaan, geeft u dat niet. Handmatig dezelfde prompt kopiëren om één enkele output te krijgen schaalt niet.

Wat u moet doen is een zeer gespecialiseerde AI-agent creëren die consequent en op schaal foutloos zal presteren. Elk posttype vereist een toegewijde AI-agent geconfigureerd met specifieke prompttemplates, opmaakregels en structurele vereisten.

Dit omvat het duidelijk definiëren van elke sectie van het posttype. Voor het titelelement beveelt Viktor bijvoorbeeld aan om deze structuur aan uw prompt toe te voegen:

Viktor schetste kort het exacte proces dat ons team gebruikt:

Genereer promptbibliotheek: Creëer 500+ prompts die gebruikersvragen binnen uw domein vertegenwoordigen met behulp van AmICited.com of vergelijkbare tools.

Analyseer citatiepatronen: Begrijp huidig AI-gedrag voor deze prompts en vind kansen. Ontdek wat geciteerd wordt, wat ontbreekt, wat zwak is.

Bouw gespecialiseerde agents: Creëer AI-agents in FlowHunt (of vergelijkbare platforms) voor elk posttype met gedefinieerde elementen en beperkingen.

Genereer systematisch: Produceer content op schaal met gespecialiseerde agents voor elk posttype, met behoud van consistente structuur en kwaliteit.

Implementeer semantische linking: Gebruik semantische gelijkenisalgoritmen om automatisch gerelateerde artikelverbindingen voor te stellen en te creëren.

Monitor en verfijn: Volg welke content geciteerd wordt door AI-systemen en verfijn uw aanpak op basis van echte citatiedata.

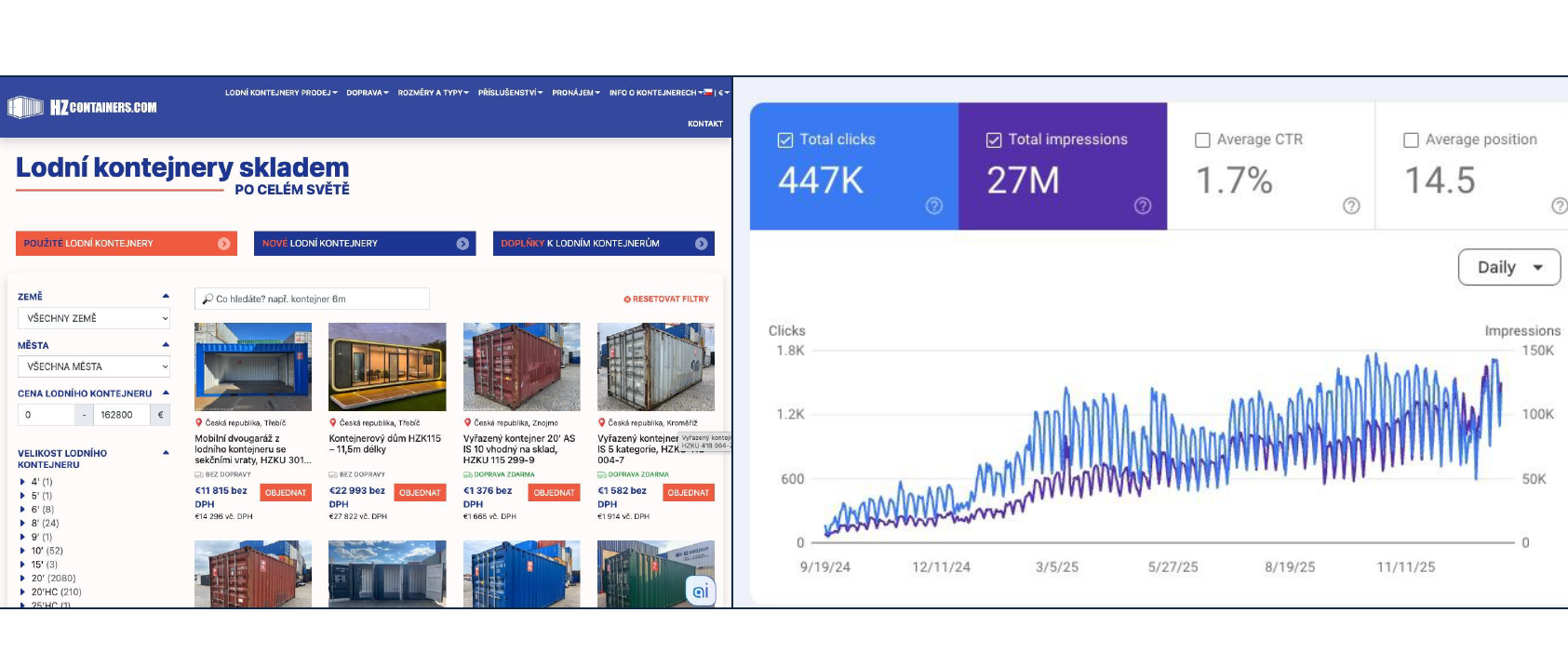

18.000% verkeerstoename (180x) van januari-september 2025, met levering van 2.000 containers. De aanpak is gebouwd op technische SEO-fundamenten, uitgebreide content die alle vragen beantwoordt, correcte schema-markup, gestructureerde posttypes en geautomatiseerde interne linking. Geen keyword stuffing of linkschema’s.

Viktor benadrukte een fundamentele transitie die plaatsvindt in hoe mensen producten online vinden en evalueren. Google houdt rekening met honderden rankingfactoren. Hier is slechts een gedeeltelijke lijst om de complexiteit te illustreren:

De realiteit is dat elke verbetering slechts promille (duizendsten) van winst bijdraagt. Het bereiken van betekenisvolle rankingverbeteringen kost maanden van continue optimalisatie over tientallen factoren tegelijk. Traditionele SEO blijft belangrijk maar vertegenwoordigt een slopende, incrementele benadering van zichtbaarheid.

Generative Engine Optimization richt zich op geciteerd worden door AI-systemen wanneer gebruikers vragen stellen die relevant zijn voor uw bedrijf.

Belangrijkste verschillen met traditionele SEO:

Hier is een kort overzicht van de belangrijkste tools en implementatieroutekaart.

Viktor adviseerde een specifieke volgorde voor implementatie: Fase 1: Technische Basis (Weken 1-4) • Infrastructuuraudit en optimalisatie • Robots.txt en sitemap-configuratie • Cache header-implementatie • Core Web Vitals-verbetering • Schema.org-markup voor bestaande pagina’s Fase 2: Contentstructuur (Weken 5-8) • Definieer posttypes en hun elementen • Creëer gespecialiseerde AI-agents voor elk type • Stel geautomatiseerde interne linking in • Implementeer semantische gelijkenissystemen Fase 3: Content Generatie (Weken 9-16) • Genereer promptbibliotheek (500+ prompts) • Analyseer huidige citatiepatronen • Begin systematische contentcreatie • Monitor AI-citatieprestaties • Verfijn op basis van data Fase 4: Protocolimplementatie (Doorlopend) • Implementeer UCP/ACP/AP2 indien van toepassing • Ontwikkel aangepaste MCP-servers voor integraties • Test AI-handelsfunctionaliteit • Breid uit op basis van adoptie

Dit is geen snelle-winststrategie. Technische SEO, uitgebreide content en AI-protocolimplementatie vereisen aanhoudende investering over maanden.

De resultaten stapelen zich echter op. Elk stuk correct gestructureerde content verhoogt uw autoriteit. Elke technische verbetering verhoogt de effectiviteit van al uw content. Elke citatie door AI-systemen verhoogt de waarschijnlijkheid van toekomstige citaties. De vraag is niet of u in deze infrastructuur moet investeren—het is of u de transitie wilt leiden of later wilt volgen wanneer concurrenten al autoriteit hebben gevestigd in AI-bemiddelde ontdekking.

Voor technische leiders in e-commerce biedt dit raamwerk duidelijkheid. U moet beginnen met het bouwen van goede technische fundamenten, het implementeren van AI-handelsprotocollen, het systematisch structureren van content en het optimaliseren voor zowel traditioneel zoeken als AI-citaten tegelijkertijd. De infrastructuur die u vandaag bouwt bepaalt de vindbaarheid wanneer gebruikers morgen AI-systemen om aanbevelingen vragen.

Viktors technische presentatie complementeert de strategische en operationele perspectieven van eerder in de conferentieserie.

Michal Lichner’s implementatieroutekaart stelde vast waar AI-implementatie op te richten en hoe content systematisch voor te bereiden. Zeman’s presentatie biedt de technische infrastructuur die die content vindbaar en functioneel maakt.

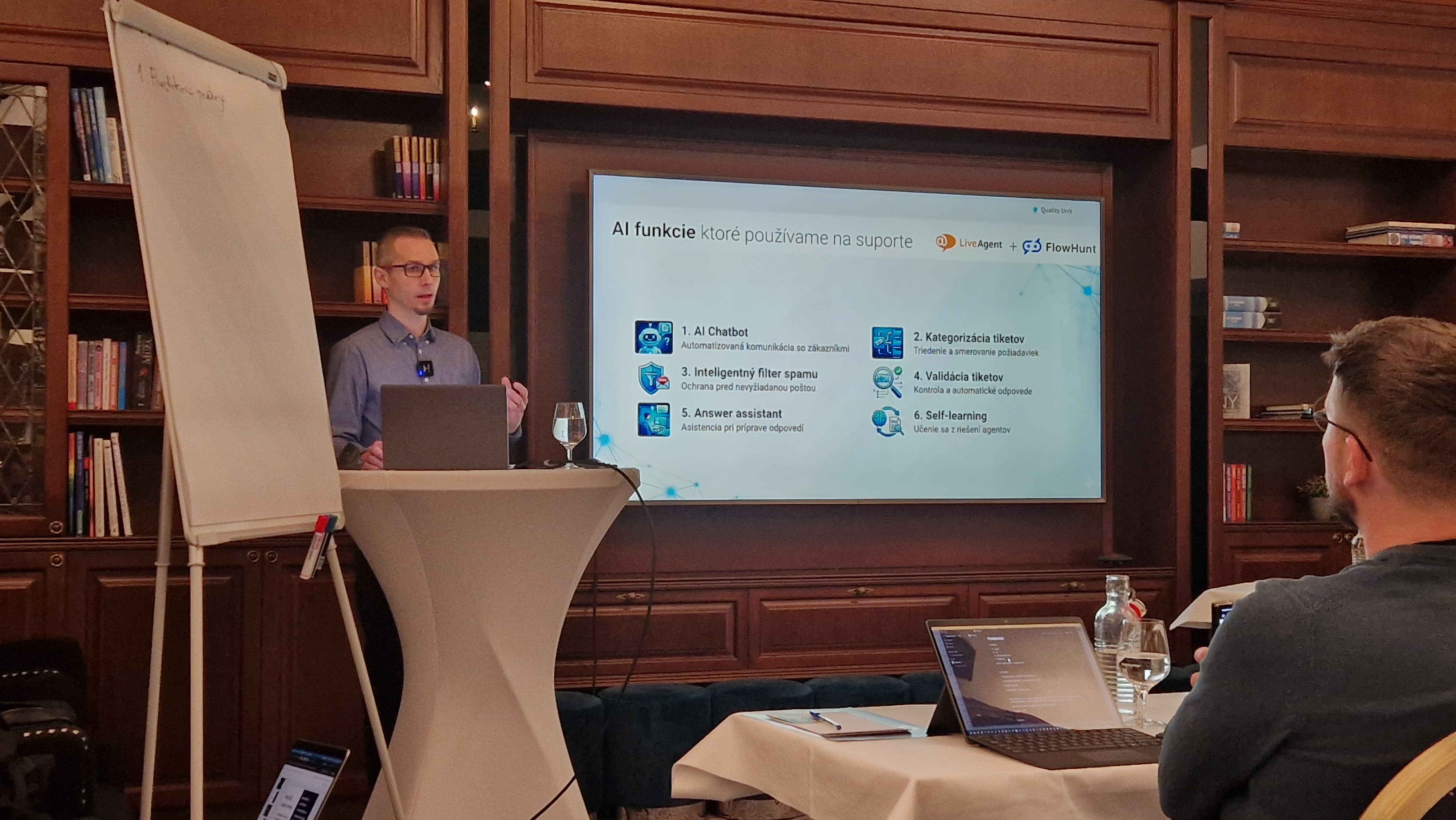

Jozef Štofira’s support-automatisering toont de exacte set tools die we gebruiken om support-karweitjes te automatiseren, van filteren en categoriseren tot dataverrijking, antwoordassistent en menselijke overdracht.

Samen vormen deze drie perspectieven een compleet beeld: strategische planning, technische infrastructuur en operationele uitvoering voor e-commerce in een door AI bemiddelde handelsomgeving.

AI-handelsprotocollen zoals UCP (Universal Commerce Protocol), ACP (Agentic Commerce Protocol) en AP2 (Agent Payment Protocol) standaardiseren hoe AI-systemen omgaan met e-commerceplatforms. Ze stellen AI-assistenten in staat om producten te bekijken, opties te vergelijken, het afrekenproces te starten en transacties namens gebruikers te voltooien, waardoor uw winkel toegankelijk wordt via door AI bemiddelde winkelervaring.

SEO (Search Engine Optimization) richt zich op ranking in traditionele zoekmachines zoals Google door middel van keyword-optimalisatie en backlinks. GEO (Generative Engine Optimization) richt zich op geciteerd worden door AI-systemen zoals ChatGPT en Perplexity door middel van gestructureerde content, duidelijke entiteitsdefinities en uitgebreide antwoorden. Moderne e-commerce heeft beide nodig: SEO voor huidig verkeer, GEO voor toekomstige AI-bemiddelde ontdekking.

Prioriteitsfundamenten omvatten: snelle, veilige infrastructuur met CDN; correct geconfigureerde robots.txt en sitemaps; correcte cache-headers; regelmatige technische audits; Core Web Vitals-optimalisatie; uitgebreide schema.org-markup voor entiteiten; semantische contentstructuur; en geautomatiseerde interne linking. Deze creëren de basis die zowel traditionele zoekmachines als AI-systemen nodig hebben om uw content correct te begrijpen en te indexeren.

Begin met het genereren van 500+ prompts met tools zoals AmICited.com om te begrijpen hoe AI-systemen momenteel uw branche bespreken. Creëer gespecialiseerde AI-agents voor elk contenttype (woordenlijst, how-to, checklists, productbeschrijvingen) met gedefinieerde elementen en opmaakregels. Gebruik semantische gelijkenis voor suggesties voor gerelateerde artikelen. Genereer content die alle potentiële vragen van bezoekers uitgebreid beantwoordt in plaats van te richten op smalle keywords.

Arshia is een AI Workflow Engineer bij FlowHunt. Met een achtergrond in computerwetenschappen en een passie voor AI, specialiseert zij zich in het creëren van efficiënte workflows die AI-tools integreren in dagelijkse taken, waardoor productiviteit en creativiteit worden verhoogd.

Bouw AI-agents die SEO-geoptimaliseerde content genereren, technische SEO-verbeteringen implementeren en AI-protocolintegraties creëren—allemaal binnen FlowHunt's visuele workflow builder.

Een praktisch raamwerk voor het implementeren van AI in e-commerce van Quality Unit's CMO. Leer waar te beginnen, veelvoorkomende uitdagingen, strategieën voor ...

Leer hoe je een AI-aangedreven Shopify manager maakt met FlowHunt's MCP server integratie om productbeheer, bestellingen, klanten en voorraadbeheer te automatis...

Een technische uiteenzetting van zes AI-functies die de ondersteuningswerkdruk met 48,5% hebben verminderd. Leer welke specifieke problemen elk oplost, de imple...

Cookie Toestemming

We gebruiken cookies om uw browse-ervaring te verbeteren en ons verkeer te analyseren. See our privacy policy.