In het hoofd van Llama 3.3 70B Versatile 128k als AI-agent

Ontdek de geavanceerde mogelijkheden van Llama 3.3 70B Versatile 128k als AI-agent. Deze diepgaande review onderzoekt het redeneervermogen, probleemoplossend ve...

Ontdek hoe Jamba 3B van AI21 transformer-attentie combineert met state space modellen om ongeëvenaarde efficiëntie en lange contextmogelijkheden op edge-apparaten te bereiken, en daarmee de toekomst van grote taalmodellen herdefinieert.

Het landschap van grote taalmodellen is de afgelopen jaren drastisch veranderd, waarbij onderzoekers en bedrijven voortdurend zoeken naar manieren om de efficiëntie te verbeteren zonder in te leveren op prestaties. De introductie van Jamba 3B door AI21 markeert een belangrijke mijlpaal in deze evolutie—een hybride model dat de kracht van transformer-attentie combineert met state space modellen om ongekende efficiëntiewinsten te realiseren. Deze doorbraak komt op een cruciaal moment, nu de computationele eisen voor het trainen en inzetten van grote taalmodellen wereldwijd een belangrijke bottleneck vormen voor organisaties. In deze uitgebreide gids verkennen we de technische innovaties achter Jamba 3B, begrijpen we waarom hybride architecturen de toekomst van taalmodellen vertegenwoordigen, en bekijken we hoe deze benadering de mogelijkheden voor AI-implementatie in diverse computeromgevingen herdefinieert.

AI21 werd meer dan zeven jaar geleden opgericht door Ori Levy, Yoav Shoham en Amnon Shashua met een visionair uitgangspunt dat al hun volgende werk zou sturen: deep learning, hoe krachtig en nuttig ook, is op zichzelf niet voldoende. De filosofie van het bedrijf richtte zich op het overbruggen van klassieke kunstmatige intelligentie met moderne deep learning benaderingen, en zo systemen te creëren die de sterktes van beide paradigma’s konden benutten. Deze missie bleek vooruitziend, aangezien het bedrijf zijn werk begon vlak voor de release van GPT-3, waardoor ze perfect gepositioneerd waren om de revolutionaire veranderingen die de hele AI-industrie zouden hervormen, te observeren en eraan deel te nemen. Vanaf de eerste dagen in 2018 zette AI21 zich in om modellen te trainen met een dubbele focus op zowel wetenschappelijke nauwkeurigheid als praktische toepassingen. Deze gebalanceerde aanpak zou een onderscheidend kenmerk van het bedrijf worden, waarmee ze zich onderscheidden van concurrenten die vaak puur onderzoek of directe commercialisering vooropstelden.

Door de geschiedenis heen heeft AI21 deze toewijding aan het combineren van geavanceerd onderzoek met toepassingen in de echte wereld behouden. Het bedrijf ontwikkelde Wordtune, een applicatie die zorgde voor belangrijke markttractie en diende als testomgeving voor hun taalmodelonderzoek. Toen GPT-3 verscheen, reageerde AI21 door hun eigen model, Jurassic-1, te trainen, dat vergelijkbare of iets betere prestaties behaalde dan het model van OpenAI. Dit vroege succes vestigde AI21 als een serieuze speler in het domein van grote taalmodellen, maar de ambities van het bedrijf reikten verder dan het evenaren van bestaande modellen. Het team realiseerde zich dat de toekomst van AI niet alleen grotere modellen zou vereisen, maar vooral slimmere architecturen die betere prestaties met meer efficiëntie konden leveren. Dit inzicht zou uiteindelijk leiden tot de ontwikkeling van Jamba, hun baanbrekende hybride modellijn die de conventionele wijsheid over de bouw van taalmodellen ter discussie zou stellen.

Hybride taalmodellen vertegenwoordigen een fundamentele breuk met de pure transformerarchitectuur die het veld domineerde sinds de release van GPT-2 en latere modellen. Traditionele transformer-gebaseerde taalmodellen vertrouwen volledig op attentiemechanismen, waarbij elke token in een sequentie aandacht kan geven aan elke andere token. Hoewel deze aanpak zeer effectief is gebleken voor taalbegrip en -generatie, brengt het een aanzienlijke computationele last met zich mee: het attentiemechanisme heeft kwadratische complexiteit ten opzichte van de sequentielengte, wat betekent dat het verdubbelen van het contextvenster de computationele vereisten verviervoudigt. Daarnaast groeit de key-value cache die nodig is voor attentie lineair met de sequentielengte, waardoor geheugenknelpunten ontstaan die steeds problematischer worden naarmate contextvensters groter worden. Deze beperkingen zijn kritieke obstakels geworden voor moderne toepassingen, vooral voor toepassingen die lange contextverwerking, personalisatie, geheugenretentie en agentisch redeneren vereisen.

Hybride modellen pakken deze beperkingen aan door transformer-attentie te combineren met state space modellen, met name Mamba, dat lineaire complexiteit biedt ten opzichte van de sequentielengte. In plaats van attentie volledig te vervangen—wat zou betekenen dat de redeneercapaciteiten waarop transformers zo effectief zijn verloren gaan—gebruiken hybride architecturen attentie selectief, meestal in een 1:8 verhouding waarbij slechts één op de acht lagen volledige attentie gebruikt en de overige lagen de efficiëntere state space model aanpak hanteren. Deze strategische combinatie behoudt het vermogen van het model om complexe redeneertaken uit te voeren die globale contextbewustheid vereisen, terwijl de computationele kosten en geheugenvereisten voor het grootste deel van de verwerking drastisch worden verminderd. Het resultaat is een model dat op de meeste benchmarks gelijkwaardige of zelfs betere prestaties levert, terwijl het aanzienlijk minder computationele bronnen verbruikt tijdens zowel training als inferentie. Deze efficiëntiewinst is niet slechts een marginale verbetering—het betekent een fundamentele verschuiving in wat mogelijk wordt voor AI-implementaties, waardoor modellen kunnen draaien op edge-apparaten, in geheugengerelateerde omgevingen en op schalen die voorheen onhaalbaar werden geacht.

Het pad naar Jamba’s hybride architectuur was niet vooraf bepaald, maar kwam voort uit zorgvuldig experimenteren en de bereidheid om onconventionele benaderingen te verkennen. Het team van AI21 werkte aanvankelijk aan J3, de derde versie van hun Jurassic modellijn, met plannen om een mixture-of-experts (MoE) architectuur te implementeren. De belangrijkste motivatie voor MoE was eenvoudig: het zou de trainingskosten aanzienlijk verlagen door de berekening te verdelen over meerdere expertnetwerken, waardoor het trainingsbudget beter beheersbaar werd. Tegelijkertijd wilde het team ervoor zorgen dat hun model efficiënt kon worden ingezet tijdens inferentie, dus ontwierpen ze J3 met meerdere versies—één die op een enkele GPU met 80 gigabyte geheugen zou passen (zoals een A100 of H100) en een grotere versie die in een enkele pod zou passen. Deze focus op inferentie-efficiëntie vanaf het begin zou cruciaal blijken voor hun uiteindelijke doorbraak.

Tijdens de ablatietestfase van de modelontwikkeling kwam Barak Lenz, de CTO van AI21, de Mamba-paper tegen, die hem was aanbevolen door verschillende collega’s. In tegenstelling tot eerdere state space model papers die weinig perspectief boden, viel de Mamba-paper op door de rigoureuze aanpak van vergelijking en evaluatie. In plaats van te vergelijken met verouderde baselines, vergeleken de auteurs Mamba direct met de nieuwste attentie-architecturen, met name de verbeteringen geïntroduceerd door Llama, die aanzienlijke optimalisaties had aangebracht in layer-normalisatie, activatiefuncties en andere architectuurelementen die trainingsinstabiliteiten voorkwamen. De Mamba-paper vergeleek niet alleen eerlijk met deze state-of-the-art baselines, maar bracht ook aangepaste kernels en code uit, en toonde daarmee een echte toewijding aan praktische implementatie. Geïntrigeerd door deze grondigheid, moedigde Lenz zijn engineeringteam aan om met Mamba te experimenteren en te zien hoe het presteerde op hun bestaande evaluatiedashboard, dat inmiddels honderden uiteenlopende taken en benchmarks bevatte.

De eerste resultaten waren veelbelovend, maar lieten belangrijke beperkingen zien. Mamba presteerde competitief met attentiegebaseerde modellen op perplexity-metrics en de meeste taken, maar er waren specifieke gebieden waar het minder presteerde, met name bij few-shot learning taken die snelle aanpassing aan nieuwe patronen vereisten. Uit onderzoek concludeerde het team dat deze tekortkomingen voortkwamen uit het ontbreken van attentiemechanismen bij Mamba—bepaalde soorten redeneer- en patroonherkenningstaken profiteren van de globale contextbewustheid die attentie biedt. In plaats van deze beperking te accepteren, begon het team te experimenteren met hybride architecturen, waarbij attentielagen werden afgewisseld met Mamba-lagen om te kijken of ze de voordelen van beide benaderingen konden combineren. De resultaten overtroffen hun verwachtingen: niet alleen verdween de prestatiedaling die te zien was bij pure Mamba-modellen, maar het hybride model liet ook verbeteringen zien ten opzichte van standaard transformerarchitecturen. Deze ontdekking vormde de katalysator voor de ontwikkeling van Jamba.

De ontwikkeling van Jamba vereiste het oplossen van talloze technische uitdagingen die nooit eerder op deze schaal waren aangepakt. Toen AI21 begon met het trainen van Jamba Mini, het eerste model in hun hybride lijn, was Mamba nooit opgeschaald tot meer dan 3 miljard parameters. Hun hybride model zou uiteindelijk uitkomen op 13 miljard actieve parameters met ongeveer 52 miljard totale parameters als de mixture-of-experts componenten worden meegerekend. Dit betekende een enorme schaaluitdaging, waarbij het team het model moest debuggen en optimaliseren op manieren die nooit eerder waren geprobeerd. Het optimalisatieproces zelf werd een fascinerende engineeringuitdaging—het team moest het modelgedrag nauwgezet analyseren, knelpunten identificeren en oplossingen implementeren die het mogelijk maakten de hybride architectuur efficiënt te trainen op deze ongekende schaal.

Een van de meest cruciale beslissingen in de architectuur van Jamba was het bepalen van de optimale verhouding van attentie tot state space lagen en de positie van deze lagen binnen het model. Door uitgebreide ablatietests ontdekte AI21 dat een 1:8 verhouding—waarbij één op de acht lagen attentie gebruikt en de resterende zeven Mamba—de optimale balans bood tussen prestaties en efficiëntie. Opvallend was dat ook de plaatsing van de attentielagen veel uitmaakte. Het team testte het plaatsen van attentielagen aan het begin, in het midden en aan het eind van het model, en ontdekte dat plaatsing in het midden van de architectuur aanzienlijk betere resultaten opleverde dan plaatsing aan de uiteinden. Hoewel nog agressievere verhoudingen zoals 1:6 marginaal betere resultaten opleverden, vielen deze winsten binnen de standaarddeviatie van de resultaten en rechtvaardigden ze niet de extra computationele kosten van meer attentielagen, vooral omdat elke transformerlaag kwadratische kosten toevoegt aan de key-value cache bij lange contextverwerking.

De efficiëntiewinsten van deze architectuur zijn aanzienlijk en veelzijdig. Tijdens het trainen vermindert de hybride aanpak de computationele vereisten ten opzichte van pure transformer modellen, waardoor het kosteneffectiever wordt om modellen op schaal te trainen. Tijdens inferentie worden de voordelen nog duidelijker, vooral voor lange contexttoepassingen. Hoewel Mamba een grotere vaste kost voor kortere sequenties heeft in vergelijking met attentie, verdwijnt dit nadeel en keert het zich zelfs om naarmate de sequentielengte toeneemt. Voor toepassingen die lange context vereisen—zoals agentgebaseerde use cases, enterprise retrieval-augmented generationsystemen, personalisatie met geheugen en vele andere opkomende toepassingen—biedt de hybride architectuur aanzienlijk betere prestatiekenmerken. De lineaire geheugenschaalbaarheid van Mamba betekent dat het verdubbelen van het contextvenster de geheugeneisen verdubbelt, terwijl dit bij pure attentie een verviervoudiging betekent. Dit fundamentele verschil wordt steeds belangrijker naarmate toepassingen langere contextvensters eisen om samenhangend redeneren en geheugen over langere interacties te behouden.

Nu organisaties steeds meer geavanceerde taalmodellen zoals Jamba 3B inzetten, wordt de uitdaging om deze modellen in productie-workflows te integreren steeds belangrijker. FlowHunt pakt deze uitdaging aan met een allesomvattend platform voor het automatiseren van AI-workflows, van modelselectie en testen tot implementatie en monitoring. De efficiëntiewinsten die hybride modellen zoals Jamba 3B opleveren, komen pas echt tot hun recht als ze worden gecombineerd met intelligente workflowautomatisering die optimaliseert hoe deze modellen worden ingezet, getest en bewaakt in productieomgevingen. FlowHunt stelt teams in staat om geavanceerde AI-systemen te bouwen die profiteren van modellen zoals Jamba 3B, terwijl ze zicht en controle behouden over de volledige pipeline. Door routinematige aspecten van modelimplementatie en monitoring te automatiseren, kunnen teams zich richten op de strategische aspecten van AI-integratie, zodat de computationele efficiëntiewinsten van geavanceerde architecturen daadwerkelijk vertaald worden in bedrijfswaarde.

De combinatie van efficiënte modellen en intelligente workflowautomatisering creëert een krachtige synergie. Teams kunnen Jamba 3B met vertrouwen inzetten op edge-apparaten of in geheugengerelateerde omgevingen, wetende dat de monitoring- en optimalisatietools van FlowHunt zorgen voor consistente prestaties. Voor ondernemingen die AI-systemen bouwen die lange contextverwerking, personalisatie en agentisch redeneren vereisen, biedt FlowHunt de infrastructuur om deze complexe workflows efficiënt te beheren. Dankzij de mogelijkheid van het platform om testen, implementatie en monitoring te automatiseren, kunnen organisaties snel itereren op hun AI-systemen, experimenteren met verschillende modelconfiguraties en implementatiestrategieën zonder handmatige overhead. Dit is vooral waardevol voor organisaties die de mogelijkheden van hybride modellen verkennen, omdat het hen in staat stelt verschillende architecturen en configuraties te benchmarken om de optimale balans voor hun specifieke toepassingen te vinden.

De introductie van Jamba 3B is een belangrijke mijlpaal in het toegankelijk maken van geavanceerde AI-capaciteiten voor een breder scala aan toepassingen en implementatiescenario’s. In tegenstelling tot eerdere modellen in de Jamba-lijn, die waren ontworpen voor maximale prestaties op grotere schaal, is Jamba 3B specifiek geoptimaliseerd voor edge-apparaten en geheugengerelateerde omgevingen. De aanduiding “3B” verwijst naar de omvang van het model—ongeveer 3 miljard parameters—waardoor het klein genoeg is om te draaien op consumentenhardware, terwijl het toch profiteert van de efficiëntie van de hybride architectuur. Dit is een cruciale ontwikkeling omdat het geavanceerde taalmodelcapaciteiten democratiseert en toepassingen mogelijk maakt die voorheen onmogelijk waren door computationele beperkingen. Ontwikkelaars kunnen nu geavanceerde taalmodellen inzetten op mobiele apparaten, IoT-apparaten, embedded systemen en andere edge computing platforms zonder in te leveren op redeneercapaciteit en lange contextverwerking—de eigenschappen die moderne taalmodellen zo waardevol maken.

Het belangrijkste kenmerk van Jamba 3B is zijn vermogen om lange contextvensters te verwerken terwijl het inzetbaar blijft op edge-apparaten. Deze combinatie was voorheen onmogelijk met pure transformerarchitecturen—de kwadratische complexiteit van attentie betekende dat het verlengen van contextvensters op edge-apparaten al snel al het beschikbare geheugen zou opsouperen. De hybride architectuur van Jamba 3B verandert deze vergelijking fundamenteel. Dankzij de lineaire complexiteit van Mamba-lagen kan de context worden verlengd zonder de exponentiële geheugenexplosie die pure attentiemodellen teistert. Voor toepassingen die personalisatie, geheugenretentie, retrieval-augmented generation en agentisch redeneren vereisen, is deze mogelijkheid transformerend. Een edge-apparaat dat Jamba 3B draait, kan samenhangende context behouden over langere interacties, waardoor geavanceerde toepassingen mogelijk worden die voorheen alleen haalbaar waren met cloudgebaseerde modellen. Deze verschuiving heeft grote gevolgen voor privacy, latency en kosten—toepassingen kunnen nu gevoelige gegevens lokaal verwerken zonder deze naar cloudservers te sturen, direct reageren op gebruikersvragen met minimale vertraging en opereren zonder cloudcomputingkosten.

Wanneer we het landschap van mini-modellen op de markt bekijken, steekt Jamba 3B eruit als het enige hybride model in zijn omvangscategorie. De meeste bestaande mini-modellen vertrouwen op pure transformerarchitecturen, waardoor ze dezelfde efficiëntiebeperkingen hebben als hun grotere tegenhangers. De hybride aanpak van Jamba 3B geeft het een duidelijk voordeel qua lange contextmogelijkheden en computationele efficiëntie. Het model bereikt deze onderscheidende positie niet via architectonische compromissen die de capaciteit verminderen, maar juist door de fundamentele efficiëntiewinsten van de hybride benadering. Dit maakt Jamba 3B tot een ideale keuze voor toepassingen die een balans vereisen tussen modelgrootte en prestaties, vooral als lange contextverwerking op edge-apparaten vereist is.

Ondanks de duidelijke voordelen van hybride modellen blijven er aanzienlijke obstakels voor brede acceptatie. De AI-industrie heeft jaren besteed aan het optimaliseren van hardware en software specifiek voor transformer-attentiemechanismen. Elk groot hardwareplatform—van NVIDIA GPU’s tot gespecialiseerde AI-accelerators—heeft aangepaste kernels en optimalisaties voor attentiebewerkingen. Deze optimalisaties zijn het resultaat van jaren van engineering en vertegenwoordigen substantiële investeringen om attentie zo efficiënt mogelijk te maken op specifieke hardware. In tegenstelling hiermee zijn state space modellen zoals Mamba relatief nieuw, en hoewel er aangepaste kernels beschikbaar zijn, zijn deze optimalisaties minder volwassen en minder breed beschikbaar op verschillende hardwareplatforms. Dit creëert wat Barak Lenz de “hardwareloterij” noemt—de efficiëntievoordelen van hybride modellen kunnen aanzienlijk afnemen als het hardwareplatform geen geoptimaliseerde implementaties van state space modeloperaties heeft.

Deze hardwareoptimalisatiekloof vormt een reële barrière voor adoptie, maar is niet onoverkomelijk en zal waarschijnlijk in de loop van de tijd kleiner worden. Naarmate meer bedrijven de waarde van hybride modellen en state space architecturen erkennen, krijgen hardwarefabrikanten sterkere prikkels om te investeren in optimalisaties voor deze operaties. NVIDIA is al begonnen met het uitbrengen van hybride modellen, en andere bedrijven volgen, wat suggereert dat de industrie het langetermijnbelang van deze architecturen onderkent. Bovendien zijn de efficiëntievoordelen van hybride modellen zo groot dat ze, zelfs zonder perfecte hardwareoptimalisatie, vaak beter presteren dan pure attentiemodellen. De kwadratische complexiteit van attentie vormt zo’n fundamentele beperking dat het, zelfs na jaren optimalisatie, de lineaire complexiteit van state space modellen bij lange contexttoepassingen niet kan evenaren. Naarmate de sequentielengtes toenemen—wat een onvermijdelijke trend is nu toepassingen meer context eisen voor beter redeneren en personalisatie—zullen de voordelen van hybride modellen steeds onmiskenbaarder worden.

Naast het werk van AI21 aan hybride modellen ontstaat er in de industrie een bredere trend om attentie selectiever in te zetten in plaats van in elke laag. Zelfs bedrijven die geen volledige hybride architecturen implementeren, erkennen dat volledige attentie in elke laag onnodig en verspilling is. Veel recente modellen gebruiken sliding window attentie, waarbij elke token alleen aandacht kan geven aan een beperkt venster van omringende tokens in plaats van aan de volledige sequentie. Deze aanpak verlaagt de complexiteit van attentie van kwadratisch naar lineair met betrekking tot de venstergrootte, hoewel het nog steeds meer berekening vereist dan state space modellen. Dat onderzoekers zoals Noam Shazir onafhankelijk tot vergelijkbare conclusies zijn gekomen over optimale attentieverhoudingen—specifiek de 1:8 verhouding van lokale tot globale attentie—suggereert dat dit geen toevallige bevinding is, maar een fundamentele eigenschap van hoe taalmodellen zouden moeten worden opgebouwd.

Deze convergentie van bevindingen over verschillende onderzoeksgroepen en bedrijven wijst erop dat de industrie zich beweegt naar een nieuwe consensus over optimale modelarchitectuur. In plaats van de pure transformerbenadering die sinds GPT-2 overheerst, zal de toekomst waarschijnlijk modellen omvatten die attentie selectief inzetten, hetzij via hybride architecturen zoals Jamba, hetzij via andere benaderingen zoals sliding window attentie. De specifieke implementatiedetails kunnen variëren, maar het onderliggende principe blijft hetzelfde: volledige attentie in elke laag is inefficiënt en onnodig. Deze verschuiving betekent een volwassenwording van het vakgebied, waarbij men verder kijkt dan het initiële succes van transformers en een genuanceerder begrip ontwikkelt van wanneer en waar attentie echt nodig is. Voor ontwikkelaars en organisaties die AI-systemen bouwen, heeft deze verschuiving belangrijke gevolgen—het suggereert dat de modellen die ze in de toekomst bouwen en inzetten waarschijnlijk efficiënter zullen zijn dan de huidige, waardoor nieuwe toepassingen mogelijk worden die nu nog onhaalbaar zijn vanwege computationele beperkingen.

Ervaar hoe FlowHunt je AI-content- en SEO-workflows automatiseert — van onderzoek en contentgeneratie tot publicatie en analytics — allemaal op één plek.

Naast individuele modellen is AI21 een pionier in het ontwikkelen van AI-systemen die verder gaan dan eenvoudige inferentie met taalmodellen. Het bedrijf bracht Jarvis uit, een vroege AI-systeem dat probeerde tools en externe bronnen te gebruiken om de mogelijkheden van het taalmodel uit te breiden. Dit werk ging vooraf aan de brede adoptie van toolgebruik in taalmodellen en was invloedrijk bij het inspireren van latere frameworks zoals LangChain. Het fundamentele inzicht achter AI-systemen is dat taalmodellen, hoewel ze krachtig zijn, niet toereikend zijn voor veel toepassingen uit de echte wereld. Om de kloof tussen deep learning en klassieke AI te overbruggen, moeten systemen externe tools kunnen aanroepen, databases kunnen raadplegen, code kunnen uitvoeren en andere bewerkingen uitvoeren die meer nauwkeurigheid en determinisme vereisen dan pure neurale netwerk-inferentie kan bieden.

Maestro, het enterprise-aanbod van AI21, vertegenwoordigt de evolutie van dit denken naar een productierijp systeem ontworpen voor zakelijke toepassingen. In plaats van simpelweg een taalmodel te implementeren en te hopen dat het nuttige output genereert, biedt Maestro een framework om AI-systemen te bouwen die betrouwbaar complexe taken kunnen uitvoeren door taalmodelmogelijkheden te combineren met toolgebruik, retrieval en andere klassieke AI-technieken. Deze aanpak is vooral belangrijk voor zakelijke toepassingen waar betrouwbaarheid, nauwkeurigheid en controleerbaarheid cruciale vereisten zijn. Een taalmodel kan plausibel klinkende maar onjuiste informatie genereren, terwijl een AI-systeem dat zijn output kan verifiëren aan externe databronnen en tools kan inzetten voor specifieke taken, veel hogere betrouwbaarheid kan bieden. De adoptie van AI-systemen in bedrijfsomgevingen gaat trager dan sommigen hadden voorspeld, maar dat verandert nu organisaties de waarde van AI voor het automatiseren van complexe workflows en besluitvormingsprocessen steeds meer onderkennen.

De timing van deze verschuiving richting AI-systemen is van belang. Toen generatieve AI voor het eerst een mainstream technologie werd, richtten veel organisaties zich op eenvoudige toepassingen zoals contentgeneratie en klantenservice-chatbots. Deze toepassingen konden vaak adequaat worden bediend door een taalmodel met minimale extra infrastructuur. Maar naarmate organisaties meer ervaring opdeden met AI en geavanceerdere use cases identificeerden, werden de beperkingen van pure taalmodellen duidelijk. Toepassingen die lange contextverwerking, personalisatie, geheugenretentie en agentisch redeneren vereisen, profiteren allemaal van de gestructureerde aanpak die AI-systemen bieden. Bovendien maken de efficiëntiewinsten van modellen zoals Jamba 3B het steeds praktischer om geavanceerde AI-systemen op edge-apparaten en in omgevingen met beperkte middelen te implementeren. De convergentie van efficiëntere modellen en geavanceerdere systeemarchitecturen creëert nieuwe mogelijkheden voor AI-implementatie in het bedrijfsleven.

Voor ontwikkelaars en organisaties die overwegen hoe ze geavanceerde taalmodellen in hun toepassingen kunnen inzetten, heeft de opkomst van Jamba 3B en hybride architecturen verschillende belangrijke implicaties. Ten eerste suggereert het dat het tijdperk van pure transformermodellen mogelijk op zijn einde loopt, althans voor nieuwe ontwikkelingen. Terwijl bestaande transformermodellen nog steeds gebruikt en verbeterd zullen worden, zullen nieuwe modellen waarschijnlijk vaker hybride architecturen of selectieve attentiemechanismen bevatten. Dit betekent dat ontwikkelaars zich vertrouwd moeten maken met deze nieuwe architecturen en hun eigenschappen, voordelen en beperkingen moeten leren kennen. Ten tweede maken de efficiëntiewinsten van hybride modellen het mogelijk om geavanceerde taalmodellen in scenario’s in te zetten die voorheen onmogelijk waren—op edge-apparaten, in mobiele toepassingen en in andere omgevingen met beperkte middelen. Dit opent nieuwe mogelijkheden voor toepassingen die lokaal data kunnen verwerken, privacy kunnen waarborgen en met minimale latency kunnen reageren.

Ten derde maken de lange contextmogelijkheden van modellen zoals Jamba 3B nieuwe applicatiepatronen mogelijk die voorheen onpraktisch waren. Toepassingen kunnen nu samenhangende context behouden over langere interacties, waardoor meer geavanceerde personalisatie, geheugenretentie en agentisch redeneren mogelijk worden. Dit is vooral waardevol voor zakelijke toepassingen waar het behouden van context over meerdere interacties en integratie met externe systemen essentieel is. Ten vierde creëert de combinatie van efficiënte modellen en intelligente workflowautomatiseringsplatforms zoals FlowHunt nieuwe mogelijkheden voor snelle iteratie en experimentatie. Organisaties kunnen nu verschillende modelconfiguraties, implementatiestrategieën en systeemarchitecturen testen zonder onoverkomelijke computationele kosten. Deze democratisering van AI-experimentatie zal innovatie waarschijnlijk versnellen en leiden tot nieuwe toepassingen en use cases die we ons nu nog niet kunnen voorstellen.

De aanwijzingen stapelen zich op dat hybride modellen geen tijdelijke trend zijn, maar juist de toekomstige richting van taalmodelontwikkeling vertegenwoordigen. De efficiëntievoordelen zijn simpelweg te groot om te negeren, en de prestatiekenmerken zijn op de meeste benchmarks gelijkwaardig of beter dan pure transformermodellen. Naarmate hardwarefabrikanten investeren in optimalisaties voor state space modellen en andere efficiënte architecturen, zullen de praktische voordelen van hybride modellen alleen maar toenemen. Bovendien geeft de bredere industrieontwikkeling richting selectieve attentie—via hybride architecturen, sliding window attentie of andere benaderingen—aanduiding van een fundamentele verschuiving in het denken over modelarchitectuur. De pure transformerbenadering die de afgelopen jaren domineerde, maakt plaats voor meer genuanceerde architecturen die verschillende mechanismen voor verschillende doeleinden inzetten.

Voor organisaties die AI-systemen bouwen, heeft deze verschuiving belangrijke strategische implicaties. Investeren in kennis van en werken met hybride modellen positioneert organisaties om te profiteren van de efficiëntie- en capaciteitswinsten die deze modellen bieden. De combinatie van efficiënte modellen zoals Jamba 3B met geavanceerde AI-systemen en intelligente workflowautomatisering vormt een krachtige basis voor het bouwen van de volgende generatie AI-toepassingen. Naarmate het vakgebied zich verder ontwikkelt, zijn de organisaties die investeren in het begrijpen van deze nieuwe architecturen en het bouwen van systemen eromheen het best gepositioneerd om te profiteren van de kansen die ontstaan. De toekomst van AI draait niet alleen om grotere modellen of meer data—het draait om slimmere architecturen die betere prestaties met meer efficiëntie leveren, waardoor nieuwe toepassingen en use cases mogelijk worden die voorheen onmogelijk waren.

De ontwikkeling van Jamba 3B en de bredere beweging richting hybride modellen betekenen een volwassenwording van het vakgebied van grote taalmodellen. In plaats van bestaande architecturen simpelweg op te schalen, denken onderzoekers en praktijkmensen nu zorgvuldiger na over het ontwerpen van modellen die zowel krachtig als efficiënt zijn. Deze doordachte benadering van architectuurontwerp, gecombineerd met rigoureuze evaluatie en de bereidheid om conventionele wijsheid ter discussie te stellen, zal naar verwachting de komende jaren tot aanzienlijke vooruitgang in AI leiden. De hybride modellen die AI21 en andere bedrijven vandaag ontwikkelen, zullen waarschijnlijk de standaardbenadering worden voor het bouwen van taalmodellen in de toekomst, net zoals transformers de standaard werden na hun introductie. Voor iedereen die werkt met of geïnteresseerd is in taalmodellen, is inzicht in deze nieuwe architecturen en hun implicaties essentieel om bij te blijven in dit snel evoluerende vakgebied.

Een hybride LLM combineert transformer-attentie mechanismen met state space modellen zoals Mamba. In tegenstelling tot pure transformer modellen die volledig leunen op attentie (met kwadratische computationele complexiteit), gebruiken hybride modellen attentie selectief—meestal in een 1:8 verhouding—terwijl ze voor het grootste deel van de lagen profiteren van de lineaire complexiteit van state space modellen. Deze aanpak behoudt de prestatiekwaliteit terwijl de computationele kosten en het geheugenverbruik aanzienlijk worden verlaagd.

Jamba 3B is geoptimaliseerd voor edge-apparaten omdat het lange contextverwerkingsmogelijkheden biedt, terwijl het klein genoeg blijft om te draaien in omgevingen met beperkte geheugencapaciteit. Dankzij de efficiëntie van de hybride architectuur kan het model op enkele GPU's of edge-apparaten draaien zonder in te boeten aan het vermogen om uitgebreide contextvensters te verwerken, waardoor het ideaal is voor AI-toepassingen op het apparaat zelf.

Uitgebreide ablatietests van AI21 tonen aan dat het gebruiken van attentie in slechts 1 van de 8 lagen (met Mamba in de overige 7 lagen) de optimale balans biedt tussen prestaties en efficiëntie. Attentielagen zijn strategisch in het midden van het model geplaatst, niet aan het begin of eind, wat empirisch betere resultaten opleverde. Deze verhouding minimaliseert de kwadratische kosten van attentie terwijl het model het vermogen behoudt om complexe redeneertaken aan te kunnen.

Hybride modellen bieden verschillende belangrijke voordelen: aanzienlijk lagere trainingskosten dankzij verminderde computationele vereisten, betere efficiëntie bij lange contexttoepassingen, lineaire geheugenschaalbaarheid in plaats van kwadratisch, en gelijkblijvende of verbeterde prestaties op de meeste benchmarks. Ze maken ook implementatie mogelijk op edge-apparaten en in omgevingen met beperkte middelen, terwijl de redeneercapaciteiten die grote taalmodellen waardevol maken behouden blijven.

Arshia is een AI Workflow Engineer bij FlowHunt. Met een achtergrond in computerwetenschappen en een passie voor AI, specialiseert zij zich in het creëren van efficiënte workflows die AI-tools integreren in dagelijkse taken, waardoor productiviteit en creativiteit worden verhoogd.

Stroomlijn je AI-model implementatie, testen en optimalisatie met FlowHunt's intelligente automatiseringsplatform.

Ontdek de geavanceerde mogelijkheden van Llama 3.3 70B Versatile 128k als AI-agent. Deze diepgaande review onderzoekt het redeneervermogen, probleemoplossend ve...

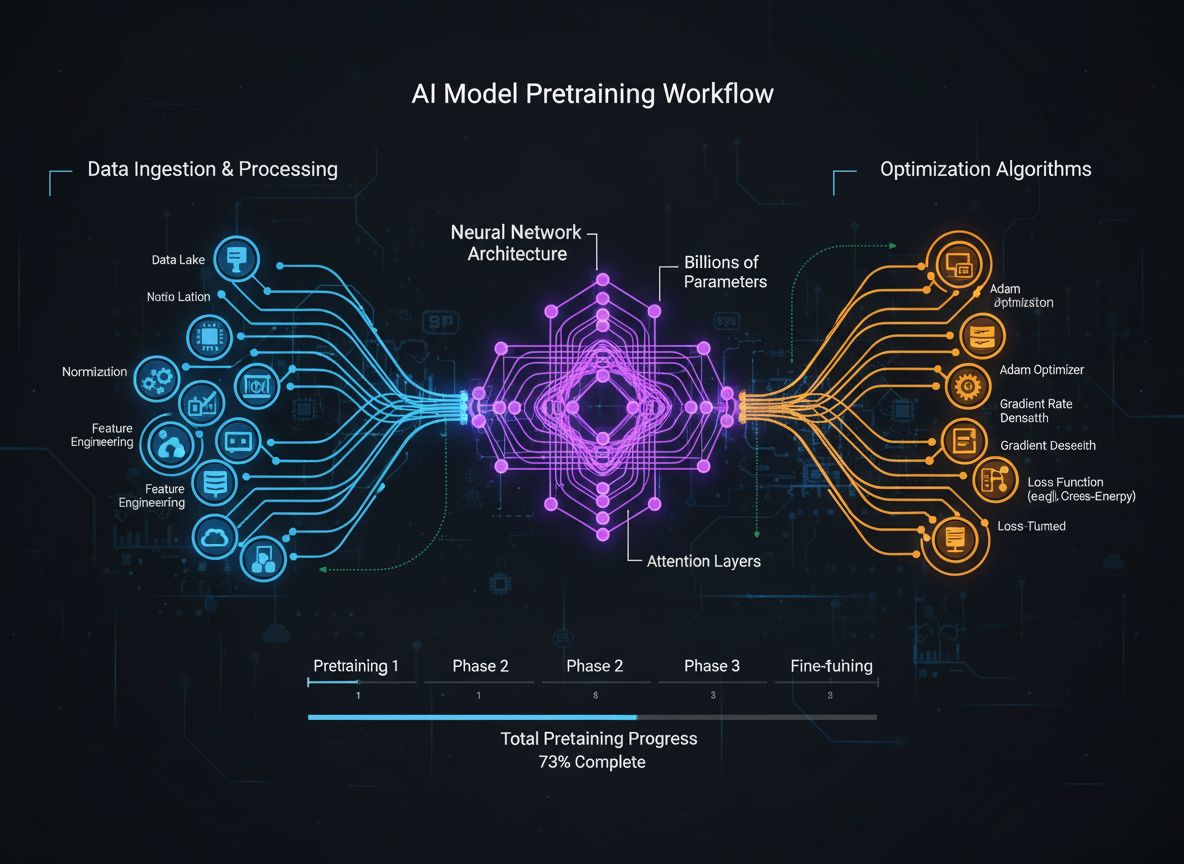

Een uitgebreide gids over moderne strategieën voor pretraining van taalmodellen, technieken voor datacuratie en optimalisatiemethoden die HuggingFace gebruikt o...

Ontdek waarom Google's Gemini 3 Flash een revolutie teweegbrengt in AI met superieure prestaties, lagere kosten en snellere snelheid—zelfs beter dan Gemini 3 Pr...

Cookie Toestemming

We gebruiken cookies om uw browse-ervaring te verbeteren en ons verkeer te analyseren. See our privacy policy.