Ontwikkelingsgids voor MCP-servers

Leer hoe je een Model Context Protocol (MCP) server bouwt en implementeert om AI-modellen te verbinden met externe tools en databronnen. Stapsgewijze handleidin...

Leer hoe je een Model Context Protocol (MCP) server ontwikkelt die naadloos integreert met de API van OpenAI, waardoor krachtige AI-gestuurde tooluitvoering en intelligente automatisering mogelijk zijn.

Het Model Context Protocol (MCP) betekent een paradigmaverschuiving in de manier waarop artificiële intelligentiesystemen communiceren met externe tools en databronnen. In combinatie met de krachtige taalmodellen van OpenAI wordt een MCP-server een toegangspoort tot intelligente automatisering, waarmee AI-systemen complexe operaties kunnen uitvoeren, realtime data kunnen ophalen en naadloos kunnen integreren met je bestaande infrastructuur. Deze uitgebreide gids neemt je mee door het hele proces van het ontwikkelen van een MCP-server die verbinding maakt met OpenAI, van de basisconcepten tot een productieklare implementatie.

Of je nu een platform voor klantenservice-automatisering bouwt, een intelligent dataverwerkingssysteem of een geavanceerde business intelligence-tool, inzicht in hoe je een MCP-server ontwerpt en implementeert is essentieel voor moderne AI-ontwikkeling. De integratie tussen MCP-servers en OpenAI creëert een krachtig ecosysteem waarin AI-modellen problemen kunnen analyseren, beslissen welke tools ze gebruiken en deze tools nauwkeurig uitvoeren—terwijl ze veiligheid, betrouwbaarheid en schaalbaarheid behouden.

Het Model Context Protocol is een open standaard die bepaalt hoe AI-modellen externe tools, diensten en databronnen kunnen ontdekken en ermee kunnen interacteren. In plaats van alle functionaliteit direct in een AI-model te stoppen, kunnen ontwikkelaars met MCP gespecialiseerde servers bouwen die mogelijkheden aanbieden via een gestandaardiseerde interface. Deze scheiding van verantwoordelijkheden zorgt voor betere modulariteit, veiligheid en schaalbaarheid van AI-applicaties.

MCP werkt volgens een eenvoudig principe: het AI-model (in dit geval OpenAI’s GPT) fungeert als een intelligente orkestrator die begrijpt welke tools beschikbaar zijn, bepaalt wanneer hij ze moet gebruiken en hun resultaten interpreteert. De MCP-server fungeert als aanbieder van deze tools en biedt ze aan via een goed gedefinieerde API die het AI-model kan ontdekken en aanroepen. Dit creëert een duidelijke contractuele scheiding tussen het AI-systeem en je eigen bedrijfslogica.

De kracht van MCP zit in de flexibiliteit. Je server kan tools aanbieden voor alles—databasequery’s, API-aanroepen naar externe diensten, bestandsverwerking, berekeningen of zelfs het starten van complexe workflows. Het AI-model leert deze mogelijkheden kennen en gebruikt ze intelligent binnen gesprekken, waarbij het beslist welke tools te gebruiken op basis van het verzoek van de gebruiker en de context van het gesprek.

De integratie van MCP-servers met OpenAI lost een fundamentele beperking van grote taalmodellen op: ze hebben een kennisafkapdatum en kunnen niet rechtstreeks met realtime systemen of bedrijfsdata communiceren. Door een MCP-server te implementeren, breid je de mogelijkheden van OpenAI’s modellen ver voorbij hun basiskennis uit—ze krijgen toegang tot actuele informatie, kunnen bedrijfslogica uitvoeren en integreren met jouw systemen.

Praktische scenario’s waarin MCP-servers van onschatbare waarde zijn:

De architectuur biedt ook grote voordelen voor ontwikkelteams. Meerdere teams kunnen hun eigen MCP-servers onafhankelijk ontwikkelen en onderhouden, die vervolgens worden gecombineerd tot geavanceerde AI-applicaties. Deze modulaire aanpak schaalt goed mee naarmate je organisatie groeit en je AI-capaciteit complexer wordt.

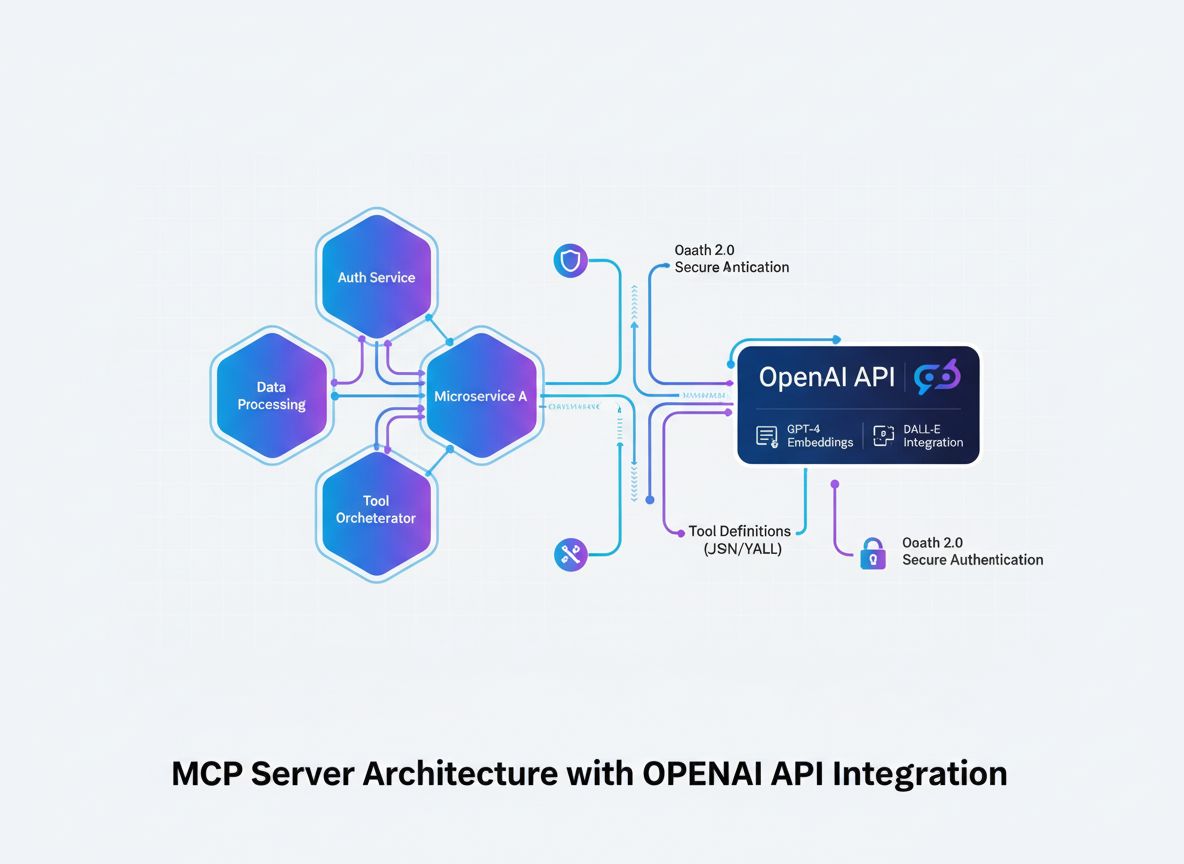

Voordat we in de implementatiedetails duiken, is het belangrijk om de architectuurflow te begrijpen van hoe een MCP-server integreert met OpenAI. Het proces omvat verschillende sleutelcomponenten die samenwerken:

Het AI-model (OpenAI) start gesprekken en beslist welke tools moeten worden aangeroepen. Wanneer het model bepaalt dat een tool nodig is, genereert het een gestructureerd verzoek met de naam van de tool en de parameters.

De MCP-client fungeert als vertaler en tussenpersoon. Het ontvangt toolverzoeken van OpenAI, zet ze om in het formaat dat je MCP-server verwacht, stuurt het verzoek naar de juiste server en geeft de resultaten terug aan OpenAI in het verwachte formaat.

De MCP-server is jouw eigen applicatie die tools en functionaliteiten aanbiedt. Het ontvangt verzoeken van de MCP-client, voert de gevraagde operaties uit (zoals databasequeries, API-aanroepen of complexe berekeningen) en retourneert gestructureerde resultaten.

Tooldefinities zijn contracten die bepalen welke tools beschikbaar zijn, welke parameters ze accepteren en wat ze teruggeven. Deze definities worden door de MCP-client ontdekt en geregistreerd bij OpenAI zodat het model weet wat er beschikbaar is.

Deze architectuur creëert een heldere scheiding van verantwoordelijkheden: OpenAI doet de redenering en besluitvorming, jouw MCP-server handelt domeinspecifieke logica en datatoegang af, en de MCP-client verzorgt het communicatieprotocol.

De basis van elke succesvolle MCP-server is een heldere definitie van de tools die je wilt aanbieden. Dit is niet alleen een technische oefening—het is een strategische keuze over welke functionaliteiten je AI-systeem nodig heeft om zijn doelen te bereiken.

Begin met het identificeren van de specifieke problemen die je AI-systeem moet oplossen. Bouw je een klantenservice-chatbot die bestelinformatie moet opzoeken? Een data-analyse-assistent die databases moet bevragen? Een contentcreatietool die toegang moet hebben tot je bedrijfskennisbank? Elke use case vereist andere tools.

Voor elke tool definieer je:

get_customer_order_history, search_knowledge_base, execute_sql_query)Voorbeeld van goed gedefinieerde toolspecificaties:

| Toolnaam | Doel | Invoerparameters | Uitvoerformaat | Use case |

|---|---|---|---|---|

get_customer_info | Klantgegevens opvragen | customer_id (string) | JSON-object met naam, e-mail, account_status | Klantenservicevragen |

search_orders | Bestellingen zoeken op criteria | customer_id, date_range, status | Array van orderobjecten | Orderopvraging en geschiedenis |

create_support_ticket | Nieuw supportticket aanmaken | customer_id, issue_description, priority | Ticketobject met ID en bevestiging | Escalatie van problemen |

check_inventory | Voorraad opvragen | product_id, warehouse_location | Voorraad en locatiegegevens | Voorraadinformatie |

process_refund | Terugbetaling starten | order_id, amount, reason | Transactiebevestiging met referentienummer | Terugbetalingsverwerking |

Met deze tabelmethode denk je het hele toolecosysteem door vóórdat je code schrijft. Dit zorgt voor consistentie, duidelijkheid en volledigheid.

Voor het bouwen van een MCP-server heb je een solide ontwikkelbasis nodig. MCP-servers kunnen in verschillende talen worden gebouwd, maar we focussen op de populairste opties: TypeScript/Node.js en Python, vanwege de volwassen MCP-bibliotheken en communitysupport.

Voor TypeScript/Node.js-ontwikkeling:

Maak een nieuw Node.js-project aan en installeer de benodigde afhankelijkheden:

mkdir mcp-server-openai

cd mcp-server-openai

npm init -y

npm install @modelcontextprotocol/sdk openai dotenv express cors

npm install --save-dev typescript @types/node ts-node

Maak een tsconfig.json aan om TypeScript te configureren:

{

"compilerOptions": {

"target": "ES2020",

"module": "commonjs",

"lib": ["ES2020"],

"outDir": "./dist",

"rootDir": "./src",

"strict": true,

"esModuleInterop": true,

"skipLibCheck": true,

"forceConsistentCasingInFileNames": true

}

}

Voor Python-ontwikkeling:

Maak een virtuele omgeving en installeer de afhankelijkheden:

python -m venv venv

source venv/bin/activate # Op Windows: venv\Scripts\activate

pip install mcp openai python-dotenv fastapi uvicorn

Ongeacht je taalkeuze heb je nodig:

.env-bestand aan om gevoelige gegevens veilig op te slaanDe kern van je MCP-server is de applicatie die je tools via het MCP-protocol aanbiedt. Dit omvat het aanmaken van endpoints voor toolontdekking en tooluitvoering.

TypeScript/Node.js-implementatie:

Maak een basisstructuur voor de MCP-server:

import { Server } from "@modelcontextprotocol/sdk/server/index.js";

import { StdioServerTransport } from "@modelcontextprotocol/sdk/server/stdio.js";

import {

CallToolRequestSchema,

ListToolsRequestSchema,

} from "@modelcontextprotocol/sdk/types.js";

const server = new Server({

name: "openai-mcp-server",

version: "1.0.0",

});

// Definieer je tools

const tools = [

{

name: "get_customer_info",

description: "Haal klantinformatie op via ID",

inputSchema: {

type: "object",

properties: {

customer_id: {

type: "string",

description: "De unieke klantidentificatie",

},

},

required: ["customer_id"],

},

},

// Voeg hier meer tools toe

];

// Afhandeling voor tooloverzicht

server.setRequestHandler(ListToolsRequestSchema, async () => {

return { tools };

});

// Afhandeling voor toolexecutie

server.setRequestHandler(CallToolRequestSchema, async (request) => {

const { name, arguments: args } = request.params;

if (name === "get_customer_info") {

// Implementeer je tool-logica hier

const customerId = args.customer_id;

// Query je database of API

return {

content: [

{

type: "text",

text: JSON.stringify({

id: customerId,

name: "John Doe",

email: "john@example.com",

}),

},

],

};

}

return {

content: [{ type: "text", text: `Onbekende tool: ${name}` }],

isError: true,

};

});

// Start de server

const transport = new StdioServerTransport();

server.connect(transport);

Python-implementatie:

from mcp.server import Server

from mcp.types import Tool, TextContent, ToolResult

import json

app = Server("openai-mcp-server")

# Definieer je tools

TOOLS = [

Tool(

name="get_customer_info",

description="Haal klantinformatie op via ID",

inputSchema={

"type": "object",

"properties": {

"customer_id": {

"type": "string",

"description": "De unieke klantidentificatie"

}

},

"required": ["customer_id"]

}

)

]

@app.list_tools()

async def list_tools():

return TOOLS

@app.call_tool()

async def call_tool(name: str, arguments: dict):

if name == "get_customer_info":

customer_id = arguments.get("customer_id")

# Implementeer je tool-logica

result = {

"id": customer_id,

"name": "John Doe",

"email": "john@example.com"

}

return ToolResult(

content=[TextContent(type="text", text=json.dumps(result))]

)

return ToolResult(

content=[TextContent(type="text", text=f"Onbekende tool: {name}")],

isError=True

)

if __name__ == "__main__":

import uvicorn

uvicorn.run(app, host="0.0.0.0", port=8000)

De echte kracht van je MCP-server zit in de daadwerkelijke implementatie van je tools. Hier verbind je met databases, roep je externe API’s aan, verwerk je data en voer je bedrijfslogica uit.

Voorbeeld database-integratie:

import { Pool } from "pg"; // PostgreSQL-voorbeeld

const pool = new Pool({

connectionString: process.env.DATABASE_URL,

});

async function getCustomerInfo(customerId: string) {

try {

const result = await pool.query(

"SELECT id, name, email, account_status FROM customers WHERE id = $1",

[customerId]

);

if (result.rows.length === 0) {

return {

error: "Klant niet gevonden",

status: 404,

};

}

return result.rows[0];

} catch (error) {

return {

error: "Databasequery mislukt",

details: error.message,

status: 500,

};

}

}

Voorbeeld externe API-integratie:

import axios from "axios";

async function searchExternalDatabase(query: string) {

try {

const response = await axios.get(

"https://api.external-service.com/search",

{

params: { q: query },

headers: {

Authorization: `Bearer ${process.env.EXTERNAL_API_KEY}`,

},

}

);

return response.data;

} catch (error) {

return {

error: "Externe API-aanroep mislukt",

details: error.message,

};

}

}

Foutafhandeling en validatie:

Robuuste foutafhandeling is cruciaal voor productie-MCP-servers. Implementeer grondige validatie en foutafhandeling:

function validateInput(args: any, schema: any): { valid: boolean; error?: string } {

// Valideer verplichte velden

for (const required of schema.required || []) {

if (!(required in args)) {

return { valid: false, error: `Verplicht veld ontbreekt: ${required}` };

}

}

// Valideer veldtypes

for (const [key, property] of Object.entries(schema.properties || {})) {

if (key in args) {

const value = args[key];

const expectedType = (property as any).type;

if (typeof value !== expectedType) {

return {

valid: false,

error: `Parameter ${key} moet van type ${expectedType} zijn`,

};

}

}

}

return { valid: true };

}

De MCP-client is de brug tussen OpenAI en je MCP-server. Deze verzorgt de vertaling tussen OpenAI’s functieaanroepprotocol en het protocol van je MCP-server.

TypeScript/Node.js MCP-client:

import { Client } from "@modelcontextprotocol/sdk/client/index.js";

import { StdioClientTransport } from "@modelcontextprotocol/sdk/client/stdio.js";

import OpenAI from "openai";

class MCPOpenAIBridge {

private mcpClient: Client;

private openaiClient: OpenAI;

private availableTools: any[] = [];

constructor() {

this.openaiClient = new OpenAI({

apiKey: process.env.OPENAI_API_KEY,

});

}

async initialize() {

// Verbind met MCP-server

const transport = new StdioClientTransport({

command: "node",

args: ["dist/server.js"],

});

this.mcpClient = new Client({

name: "openai-mcp-client",

version: "1.0.0",

});

await this.mcpClient.connect(transport);

// Ontdek beschikbare tools

const toolsResponse = await this.mcpClient.listTools();

this.availableTools = toolsResponse.tools;

}

async executeWithOpenAI(userMessage: string) {

const messages = [{ role: "user" as const, content: userMessage }];

// Zet MCP-tools om naar OpenAI-functieformaat

const tools = this.availableTools.map((tool) => ({

type: "function" as const,

function: {

name: tool.name,

description: tool.description,

parameters: tool.inputSchema,

},

}));

let response = await this.openaiClient.chat.completions.create({

model: "gpt-4",

messages,

tools,

});

// Verwerk toolaanroepen in een lus

while (response.choices[0].finish_reason === "tool_calls") {

const toolCalls = response.choices[0].message.tool_calls || [];

for (const toolCall of toolCalls) {

const toolName = toolCall.function.name;

const toolArgs = JSON.parse(toolCall.function.arguments);

// Voer tool uit op MCP-server

const toolResult = await this.mcpClient.callTool({

name: toolName,

arguments: toolArgs,

});

// Voeg toolresultaat toe aan berichten

messages.push({

role: "assistant",

content: response.choices[0].message.content || "",

});

messages.push({

role: "tool",

content: JSON.stringify(toolResult),

tool_call_id: toolCall.id,

});

}

// Haal volgend antwoord op bij OpenAI

response = await this.openaiClient.chat.completions.create({

model: "gpt-4",

messages,

tools,

});

}

return response.choices[0].message.content;

}

}

// Gebruik

const bridge = new MCPOpenAIBridge();

await bridge.initialize();

const result = await bridge.executeWithOpenAI(

"Wat is de bestelhistorie van klant 12345?"

);

console.log(result);

Beveiliging is essentieel bij het bouwen van MCP-servers die werken met gevoelige data en externe API’s. Implementeer meerdere beveiligingslagen:

API-sleutelbeheer:

import crypto from "crypto";

class APIKeyManager {

private validKeys: Set<string> = new Set();

constructor() {

// Laad geldige API-sleutels uit de omgeving of beveiligde opslag

const keys = process.env.VALID_API_KEYS?.split(",") || [];

this.validKeys = new Set(keys);

}

validateRequest(apiKey: string): boolean {

return this.validKeys.has(apiKey);

}

generateNewKey(): string {

return crypto.randomBytes(32).toString("hex");

}

}

Request signing en verificatie:

import crypto from "crypto";

function signRequest(payload: any, secret: string): string {

return crypto

.createHmac("sha256", secret)

.update(JSON.stringify(payload))

.digest("hex");

}

function verifySignature(payload: any, signature: string, secret: string): boolean {

const expectedSignature = signRequest(payload, secret);

return crypto.timingSafeEqual(

Buffer.from(signature),

Buffer.from(expectedSignature)

);

}

Rate limiting:

import rateLimit from "express-rate-limit";

const limiter = rateLimit({

windowMs: 15 * 60 * 1000, // 15 minuten

max: 100, // max 100 requests per windowMs per IP

message: "Te veel verzoeken vanaf dit IP, probeer het later opnieuw.",

});

app.use("/api/", limiter);

Invoersanering:

function sanitizeInput(input: string): string {

// Verwijder potentieel gevaarlijke tekens

return input

.replace(/[<>]/g, "")

.trim()

.substring(0, 1000); // Limiteer lengte

}

function validateCustomerId(customerId: string): boolean {

// Alleen alfanumeriek en streepjes toegestaan

return /^[a-zA-Z0-9-]+$/.test(customerId);

}

Grondig testen zorgt ervoor dat je MCP-server correct werkt en uitzonderingen netjes afhandelt.

Voorbeeld unittests (Jest):

import { getCustomerInfo } from "../tools/customer";

describe("Customer Tools", () => {

test("geeft klantinfo bij geldig ID", async () => {

const result = await getCustomerInfo("cust_123");

expect(result).toHaveProperty("id");

expect(result).toHaveProperty("name");

expect(result).toHaveProperty("email");

});

test("geeft fout bij ongeldig ID", async () => {

const result = await getCustomerInfo("invalid");

expect(result).toHaveProperty("error");

});

test("verwerkt databasefouten netjes", async () => {

// Mock databasefout

const result = await getCustomerInfo("cust_error");

expect(result).toHaveProperty("error");

expect(result.status).toBe(500);

});

});

Integratietests:

describe("MCP Server Integratie", () => {

let server: Server;

beforeAll(async () => {

server = new Server({ name: "test-server", version: "1.0.0" });

// Initialiseer server

});

test("geeft alle beschikbare tools weer", async () => {

const tools = await server.listTools();

expect(tools.length).toBeGreaterThan(0);

expect(tools[0]).toHaveProperty("name");

expect(tools[0]).toHaveProperty("description");

});

test("voert tool uit en geeft resultaat", async () => {

const result = await server.callTool({

name: "get_customer_info",

arguments: { customer_id: "cust_123" },

});

expect(result).toBeDefined();

});

});

FlowHunt biedt een compleet platform om het hele traject van MCP-serverontwikkeling, testen en deployment te automatiseren. In plaats van elke stap handmatig te beheren, kun je met FlowHunt intelligente automatiseringsflows creëren die repetitieve taken afhandelen en zorgen voor consistentie in je ontwikkelproces.

Automatisch testen en valideren:

FlowHunt kan je testpipeline orkestreren, zodat unittests, integratietests en end-to-end tests automatisch worden uitgevoerd bij elke code-commit. Zo weet je zeker dat je MCP-servertools altijd correct functioneren voordat ze naar productie gaan.

Continue integratie en deployment:

Richt FlowHunt-workflows in om automatisch je MCP-server te bouwen, testen en uit te rollen wanneer er wijzigingen worden gepusht naar je repository. Dit elimineert handmatige deploymentstappen en verkleint de kans op menselijke fouten.

Monitoring en waarschuwingen:

FlowHunt monitort de gezondheid van je MCP-server, volgt API-responstijden en waarschuwt bij problemen. Als een tool uitvalt of de prestaties afnemen, krijg je direct een melding zodat je actie kunt ondernemen.

Documentatiegeneratie:

Genereer automatisch API-documentatie voor je MCP-servertools, zodat je documentatie altijd actueel blijft bij je implementatie. Zo beschikken ontwikkelaars altijd over nauwkeurige informatie over beschikbare tools.

Prestatieoptimalisatie:

De analyses van FlowHunt helpen je knelpunten in je tooluitvoering te identificeren. Je ziet welke tools het meest worden aangeroepen, welke de hoogste latency hebben en waar optimalisatie het meeste oplevert.

Het uitrollen van een MCP-server naar productie vereist zorgvuldige planning en uitvoering. Overweeg de volgende deploymentstrategieën:

Docker-containerisatie:

Maak een Dockerfile voor je MCP-server:

FROM node:18-alpine

WORKDIR /app

COPY package*.json ./

RUN npm ci --only=production

COPY dist ./dist

EXPOSE 8000

CMD ["node", "dist/server.js"]

Bouw en push naar een container registry:

docker build -t my-mcp-server:1.0.0 .

docker push myregistry.azurecr.io/my-mcp-server:1.0.0

Kubernetes-deployment:

Zet je gecontaineriseerde MCP-server uit op Kubernetes:

apiVersion: apps/v1

kind: Deployment

metadata:

name: mcp-server

spec:

replicas: 3

selector:

matchLabels:

app: mcp-server

template:

metadata:

labels:

app: mcp-server

spec:

containers:

- name: mcp-server

image: myregistry.azurecr.io/my-mcp-server:1.0.0

ports:

- containerPort: 8000

env:

- name: OPENAI_API_KEY

valueFrom:

secretKeyRef:

name: openai-secrets

key: api-key

- name: DATABASE_URL

valueFrom:

secretKeyRef:

name: db-secrets

key: connection-string

resources:

requests:

memory: "256Mi"

cpu: "250m"

limits:

memory: "512Mi"

cpu: "500m"

Omgevingsconfiguratie:

Gebruik omgevingsvariabelen voor alle configuratie:

# .env.production

OPENAI_API_KEY=sk-...

DATABASE_URL=postgresql://user:pass@host:5432/db

MCP_SERVER_PORT=8000

LOG_LEVEL=info

ENABLE_METRICS=true

Naarmate je MCP-server complexer wordt, overweeg deze geavanceerde patronen:

Toolcompositie:

Maak hogere-ordetools die meerdere basistools combineren:

async function processCustomerRefund(customerId: string, orderId: string, amount: number) {

// Haal klantinfo op

const customer = await getCustomerInfo(customerId);

// Haal orderdetails op

const order = await getOrderDetails(orderId);

// Controleer of order bij klant hoort

if (order.customerId !== customerId) {

throw new Error("Order hoort niet bij klant");

}

// Verwerk terugbetaling

const refund = await createRefund(orderId, amount);

// Verstuur notificatie

await sendNotification(customer.email, `Terugbetaling van €${amount} verwerkt`);

return refund;

}

Cachingstrategie:

Implementeer caching om latency en het aantal API-aanroepen te reduceren:

import NodeCache from "node-cache";

const cache = new NodeCache({ stdTTL: 600 }); // 10 minuten TTL

async function getCustomerInfoWithCache(customerId: string) {

const cacheKey = `customer_${customerId}`;

// Eerst cache checken

const cached = cache.get(cacheKey);

if (cached) {

return cached;

}

// Ophalen uit database

const customer = await getCustomerInfo(customerId);

// Opslaan in cache

cache.set(cacheKey, customer);

return customer;

}

Asynchrone jobverwerking:

Voor langlopende operaties, implementeer asynchrone jobverwerking:

import Bull from "bull";

const jobQueue = new Bull("mcp-jobs");

jobQueue.process(async (job) => {

const { toolName, arguments: args } = job.data;

// Voer tool uit

const result = await executeTool(toolName, args);

return result;

});

async function executeToolAsync(toolName: string, args: any) {

const job = await jobQueue.add(

{ toolName, arguments: args },

{ attempts: 3, backoff: { type: "exponential", delay: 2000 } }

);

return job.id;

}

Productie-MCP-servers vereisen uitgebreide monitoring en logging:

Gestructureerd loggen:

import winston from "winston";

const logger = winston.createLogger({

format: winston.format.json(),

transports: [

new winston.transports.File({ filename: "error.log", level: "error" }),

new winston.transports.File({ filename: "combined.log" }),

],

});

logger.info("Tool uitgevoerd", {

toolName: "get_customer_info",

customerId: "cust_123",

duration: 145,

status: "success",

});

Metrieken verzamelen:

import prometheus from "prom-client";

const toolExecutionDuration = new prometheus.Histogram({

name: "mcp_tool_execution_duration_ms",

help: "Duur van toolexecutie in milliseconden",

labelNames: ["tool_name", "status"],

});

const toolExecutionCounter = new prometheus.Counter({

name: "mcp_tool_executions_total",

help: "Totaal aantal toolexecuties",

labelNames: ["tool_name", "status"],

});

async function executeToolWithMetrics(toolName: string, args: any) {

const startTime = Date.now();

try {

const result = await executeTool(toolName, args);

const duration = Date.now() - startTime;

toolExecutionDuration.labels(toolName, "success").observe(duration);

toolExecutionCounter.labels(toolName, "success").inc();

return result;

} catch (error) {

const duration = Date.now() - startTime;

toolExecutionDuration.labels(toolName, "error").observe(duration);

toolExecutionCounter.labels(toolName, "error").inc();

throw error;

}

}

Het bouwen van een MCP-server die verbinding maakt met OpenAI is een grote stap richting het creëren van intelligente, geïntegreerde AI-applicaties. Door de architectuurpatronen, implementatiestrategieën en best practices uit deze gids te volgen, kun je robuuste, schaalbare MCP-servers maken die de mogelijkheden van OpenAI ver voorbij hun basiskennis uitbreiden.

Het succes ligt in een zorgvuldige planning van je tooldefinities, een grondige implementatie van beveiligingsmaatregelen, uitgebreid testen en continue monitoring in productie. Begin met een eenvoudige set tools, valideer dat deze goed werken met OpenAI en breid geleidelijk de mogelijkheden van je server uit terwijl je meer ervaring opdoet.

Onthoud dat je MCP-server geen statisch artefact is—het is een levend systeem dat meegroeit met je bedrijfsbehoeften en naarmate je nieuwe manieren ontdekt om AI in je organisatie toe te passen. Bouw met modulariteit en uitbreidbaarheid in gedachten, documenteer je tools grondig en houd de scheiding tussen bedrijfslogica en MCP-protocolimplementatie helder.

De combinatie van MCP-servers en de krachtige taalmodellen van OpenAI creëert ongekende kansen voor automatisering, intelligentie en integratie. Door deze technologie te beheersen, positioneer je jezelf en je organisatie aan het front van AI-gedreven innovatie.

Automatiseer je MCP-serverontwikkeling, testing en deployment-workflows. Van continue integratie tot monitoring in productie: FlowHunt stroomlijnt elke stap van je AI-ontwikkeltraject.

Het Model Context Protocol is een gestandaardiseerd framework dat AI-modellen zoals OpenAI's GPT in staat stelt om tools en functies van externe servers te ontdekken, begrijpen en uitvoeren. Het fungeert als een brug tussen AI-modellen en aangepaste bedrijfslogica.

Je hebt een geldige OpenAI API-sleutel nodig met de juiste machtigingen. De MCP-server zelf vereist geen speciale rechten van OpenAI—de communicatie verloopt via standaard API-aanroepen. Wel moet je de juiste authenticatie en autorisatie op je MCP-server implementeren.

MCP-servers kunnen worden gebouwd in elke taal die HTTP/REST API's of WebSocket-verbindingen ondersteunt. Populaire keuzes zijn Python, TypeScript/Node.js, Java, C#/.NET en Go. De keuze van de taal hangt af van je bestaande infrastructuur en teamkennis.

Implementeer rate limiting aan de kant van je MCP-server, cache veelgevraagde resultaten, gebruik exponentiële backoff voor herhaalde pogingen, en monitor je OpenAI API-gebruik. Overweeg het implementeren van een wachtrijsysteem voor toolaanvragen om de belasting effectief te beheren.

Arshia is een AI Workflow Engineer bij FlowHunt. Met een achtergrond in computerwetenschappen en een passie voor AI, specialiseert zij zich in het creëren van efficiënte workflows die AI-tools integreren in dagelijkse taken, waardoor productiviteit en creativiteit worden verhoogd.

Stroomlijn de ontwikkeling, het testen en de uitrol van je MCP-server met FlowHunt's intelligente automatiseringsplatform.

Leer hoe je een Model Context Protocol (MCP) server bouwt en implementeert om AI-modellen te verbinden met externe tools en databronnen. Stapsgewijze handleidin...

Ontdek wat MCP (Model Context Protocol) servers zijn, hoe ze werken en waarom ze AI-integratie revolutioneren. Leer hoe MCP het koppelen van AI-agenten aan tool...

Ontdek uitgebreide voorbeelden van MCP-servers en leer hoe je Model Context Protocol-servers bouwt, uitrolt en integreert om AI-agentmogelijkheden te versterken...

Cookie Toestemming

We gebruiken cookies om uw browse-ervaring te verbeteren en ons verkeer te analyseren. See our privacy policy.