Introductie

Context engineering is uitgegroeid tot een van de meest cruciale disciplines bij het bouwen van effectieve AI-agents. Naarmate taalmodellen krachtiger worden en agents steeds complexere, meerstaps taken uitvoeren, draait het niet alleen om een capabel model—het gaat juist om het strategisch beheren van de informatie die je aan het model aanbiedt. Elke token telt. In deze uitgebreide gids verkennen we wat context engineering is, waarom het essentieel is voor de prestaties van AI-agents, en welke specifieke technieken toonaangevende AI-onderzoeksorganisaties en platforms hanteren om optimale agents te bouwen. Of je nu klantservicebots, data-analyse-agents of autonome workflows bouwt, inzicht in context engineering zal fundamenteel verbeteren hoe je AI-systemen presteren.

Wat is Context Engineering?

Context engineering betekent een fundamentele verandering in de manier waarop we naar het bouwen met grote taalmodellen (LLM’s) kijken. In plaats van het LLM te zien als een black box die alleen goede instructies nodig heeft, behandelt context engineering het model als een systeem met eindige cognitieve middelen dat zorgvuldig moet worden aangestuurd. In de kern is context engineering het bewust weten welke context je aan een AI-agent aanbiedt – bij elke token die door een LLM-call gaat, doelbewust nadenken om de optimale omstandigheden te creëren waarin de agent kan slagen.

Dit concept is gepopulariseerd door onderzoekers als Andrej Karpathy en is steeds belangrijker geworden nu AI-agents zijn geëvolueerd van simpele chatbots tot geavanceerde systemen die autonoom kunnen redeneren en handelen. Het fundamentele inzicht is dat LLM’s, net als mensen, een beperkte werkgeheugen- en aandachtscapaciteit hebben. Net zoals een mens zich maar op een bepaalde hoeveelheid informatie tegelijk kan concentreren voordat hij het overzicht of belangrijke details verliest, nemen de redeneervaardigheden van taalmodellen af wanneer ze met overmatige context worden geconfronteerd. Dit betekent dat de kwaliteit van de context veel belangrijker is dan de kwantiteit.

Context engineering gaat verder dan traditionele prompt engineering, dat vooral gericht was op het maken van de perfecte systeemprompt of instructie. Het omvat juist het hele ecosysteem van informatie dat een agent ter beschikking heeft over meerdere interacties—waaronder systeemprompts, tooldefinities, voorbeelden, berichtgeschiedenis, opgehaalde data en dynamisch geladen informatie. Het doel is een slank, hoogwaardig contextvenster te behouden dat de agent precies geeft wat hij nodig heeft om goede beslissingen te nemen, zonder hem te overladen met irrelevante informatie.

Klaar om uw bedrijf te laten groeien?

Start vandaag uw gratis proefperiode en zie binnen enkele dagen resultaten.

Waarom Context Engineering Essentieel is voor Capabele AI-Agents

Het belang van context engineering kan niet genoeg benadrukt worden bij het bouwen van productieklare AI-agents. Onderzoek toont voortdurend aan dat LLM’s last hebben van zogenaamde “context rot”—een meetbare afname in prestaties naarmate het contextvenster groter wordt. Studies met needle-in-a-haystack benchmarks hebben aangetoond dat naarmate het aantal tokens in de context toeneemt, het vermogen van het model om die informatie accuraat te herinneren en te beredeneren afneemt. Dit is geen klein effect; het is een fundamentele architecturale beperking van transformer-gebaseerde taalmodellen.

De oorzaak van deze degradatie ligt in de transformer-architectuur zelf. In transformers kan elke token elke andere token in de context ‘zien’, waardoor er n² parenrelaties ontstaan voor n tokens. Naarmate de contextlengte groeit, wordt het aandachtsmechanisme van het model steeds dunner uitgespreid, omdat het die relaties over een steeds groter geheel moet onderhouden. Bovendien zijn taalmodellen hoofdzakelijk getraind op kortere sequenties, dus ze hebben minder ervaring en minder gespecialiseerde parameters om met zeer lange afhankelijkheden om te gaan. Dit creëert een natuurlijke spanning tussen contextgrootte en redeneervermogen—modellen blijven bruikbaar bij langere contexten maar tonen verminderde precisie bij informatieopvraag en langetermijnredenering vergeleken met hun prestaties op kortere contexten.

Naast de architecturale beperkingen is er ook een praktische realiteit: LLM’s hebben een “aandachtsbudget” dat bij elke nieuwe token verder opraakt. Elk stukje informatie dat je aan de context toevoegt, gebruikt een deel van dit budget en verhoogt de cognitieve belasting van het model. Daarom is doordachte context engineering essentieel. Door zorgvuldig te selecteren welke informatie het model bereikt, optimaliseer je niet alleen voor efficiëntie—je verbetert direct de kwaliteit van het redeneren en de besluitvorming van de agent. Een agent met een slank, goed georganiseerd contextvenster neemt betere beslissingen, herstelt effectiever van fouten en behoudt een consistente prestatie over langere interacties dan een agent die verdrinkt in irrelevante informatie.

Context Engineering versus Prompt Engineering

Hoewel context engineering en prompt engineering aan elkaar verwant zijn, vertegenwoordigen ze verschillende abstractieniveaus bij het werken met taalmodellen. Prompt engineering, dat overheerste in de vroege fase van LLM-toepassingen, richt zich specifiek op het schrijven van effectieve prompts en systeeminstructies. De primaire zorg is het formuleren van de juiste woorden en zinnen om gewenst gedrag bij het model op te roepen voor een bepaalde taak. Deze aanpak werkt goed voor discrete, enkelvoudige taken zoals classificatie, samenvatting of eenmalige tekstgeneratie.

Context engineering daarentegen is de logische evolutie van prompt engineering voor het tijdperk van meerstaps, autonome agents. Waar prompt engineering vraagt “Hoe schrijf ik de perfecte instructie?”, stelt context engineering de bredere vraag: “Wat is de optimale configuratie van alle beschikbare informatie die het gewenste gedrag genereert?” Dit omvat niet alleen de systeemprompt, maar ook de tools waarover de agent beschikt, de gegeven voorbeelden, de berichtgeschiedenis van eerdere beurten, opgehaalde data en metadata die helpen de omgeving van de agent te begrijpen.

De verschuiving van prompt engineering naar context engineering weerspiegelt een fundamentele verandering in de manier waarop AI-toepassingen worden gebouwd. In de beginjaren waren de meeste use-cases buiten gewone chat enkelvoudige prompts voor eenmalige taken. Vandaag de dag verschuift het veld naar capabelere agents die over meerdere inference-beurten en langere tijdshorizonnen opereren. Deze agents genereren steeds meer data die mogelijk relevant is voor toekomstige beslissingen, en deze informatie moet cyclisch worden verfijnd en gecureerd. Context engineering is de discipline die dit gehele, zich ontwikkelende informatie-ecosysteem beheert, zodat de agent op elk moment van zijn redeneervolgorde precies de juiste informatie heeft om goede beslissingen te nemen.

Schrijf u in voor onze nieuwsbrief

Ontvang gratis de nieuwste tips, trends en aanbiedingen.

De Vier Kerntechnieken van Context Engineering

Toonaangevende AI-onderzoeksorganisaties en platforms zijn uitgekomen op vier primaire technieken voor effectieve context engineering. Elke techniek pakt een ander aspect aan van het beheren van beperkte contextvensters en het behouden van de prestaties van agents. Inzicht in deze technieken en hoe je ze kunt toepassen is essentieel voor het bouwen van productieklare AI-agents.

Techniek 1: Offloading – Samenvatten en Referentiebeheer

Offloading is het samenvatten van informatie en het opslaan van volledige data in externe referenties, zodat de agent alleen gedetailleerde informatie ophaalt wanneer dat nodig is. Wanneer een AI-agent een toolaanroep doet—bijvoorbeeld een database raadplegen of een externe API aanroepen—krijgt hij vaak een forse reactie. In plaats van de volledige reactie in het contextvenster te dumpen, vat offloading de belangrijkste informatie samen en biedt een referentie waar de agent de volledige data kan ophalen indien nodig.

Een praktisch voorbeeld hiervan komt van Manus AI, een onderzoeksorganisatie die werkt aan geavanceerde AI-agents. Als hun agent een toolaanroep doet en een antwoord ontvangt, nemen ze niet de volledige reactie op in de context. In plaats daarvan geven ze een beknopte samenvatting van de reactie en slaan het volledige toolresultaat op in een bestand of database met een referentie. Als de agent later besluit dat hij meer details nodig heeft, kan hij de opgeslagen data raadplegen zonder extra contexttokens te gebruiken in het hoofdgesprek. Deze aanpak lijkt op hoe mensen werken—wij onthouden ook niet elk detail van een gesprek, maar houden aantekeningen en referenties bij die we kunnen raadplegen als dat nodig is.

Cognition, een andere toonaangevende AI-onderzoeksorganisatie, heeft een vergelijkbare aanpak geïmplementeerd met eigen samenvattingssystemen. In plaats van generieke samenvattingen gebruiken ze gespecialiseerde logica die de meest relevante informatie voor hun specifieke use-cases extraheert. Dit toont een belangrijk principe aan: de beste offloading-strategie is vaak taakgericht. Wat een nuttige samenvatting is, hangt af van het doel van de agent. Door de samenvatting af te stemmen op het specifieke domein en de taak, behoud je een hoogwaardige context bij aanzienlijk lagere tokenconsumptie.

Techniek 2: Reduction – Context in de Tijd Comprimeren

Reduction is het verkorten en comprimeren van context om het totale aantal tokens te verminderen, terwijl de essentiële informatie behouden blijft. Naarmate een agent over meerdere beurten werkt, groeit de gespreksgeschiedenis. Zonder actief beheer kan deze geschiedenis al snel het hele contextvenster opslokken, waardoor er weinig ruimte overblijft voor nieuwe informatie of redenering. Reduction pakt dit probleem aan door de conversatie periodiek samen te vatten of te comprimeren tot een meer beknopte vorm.

Anthropic heeft dit geïmplementeerd via een techniek die ze “compacting” van het gesprek noemen. In plaats van de volledige geschiedenis van elk bericht te bewaren, wordt de gespreksgeschiedenis periodiek samengevat of gecomprimeerd. Dit is belangrijk omdat onderzoek laat zien dat een lange context het voor AI-agents juist moeilijker maakt om effectief te redeneren. Te veel context kan leiden tot “context poisoning”—waarbij het redeneerproces van de agent wordt verstoord door irrelevante informatie in de context, waardoor het afwijkt van het optimale pad.

Deze techniek is gebaseerd op een fundamenteel inzicht over taalmodellen: ze redeneren niet beter met meer informatie. Vaak is het tegenovergestelde waar. Een slanke, goed georganiseerde context met alleen de meest relevante informatie leidt meestal tot beter redeneren en betrouwbaarder gedrag van de agent. Daarom werken veel organisaties actief aan het reduceren van de contextgrootte, ook als er theoretisch meer informatie beschikbaar zou kunnen zijn. Door het contextvenster gericht en beheersbaar te houden, behouden ze het vermogen van de agent om helder te redeneren en goede beslissingen te nemen.

Techniek 3: Retrieval (RAG) – Dynamisch Context Laden

Retrieval-Augmented Generation, ofwel RAG, is een techniek waarbij relevante informatie dynamisch wordt opgehaald en tijdens runtime in de context geladen, in plaats van alles vooraf te laden. Deze aanpak is steeds populairder geworden naarmate agents geavanceerder zijn geworden. In plaats van te proberen alle informatie die een agent nodig zou kunnen hebben vooraf te laden, stellen RAG-systemen agents in staat om actief informatie te zoeken en op te halen zodra ze die nodig achten.

Het voordeel hiervan is aanzienlijk. Ten eerste vermindert het de initiële contextbelasting drastisch—de agent begint met een slank contextvenster en voegt alleen informatie toe als dat nodig is. Ten tweede maakt het progressieve onthulling mogelijk, waarbij de agent stapsgewijs relevante context ontdekt door verkenning. Elke interactie levert nieuwe informatie op die de volgende beslissing beïnvloedt. Zo kan een agent bijvoorbeeld starten met het zoeken van relevante bestanden, ontdekken dat sommige bestanden belangrijker zijn op basis van hun naam of tijdstempel, en dan specifiek die bestanden ophalen voor analyse. Deze gelaagde aanpak is veel efficiënter dan alles vooraf laden.

Anthropic’s Claude Code is een uitstekend voorbeeld van RAG in de praktijk. In plaats van een hele codebase in context te laden, houdt Claude Code lichte identificaties zoals bestandsnamen bij en gebruikt tools als grep en glob om relevante bestanden dynamisch op te halen. De agent kan gerichte queries schrijven, resultaten opslaan en command-line tools gebruiken om grote hoeveelheden data te analyseren zonder ooit de volledige dataobjecten in context te laden. Dit weerspiegelt menselijke cognitie—wij onthouden ook geen complete informatiestromen, maar gebruiken externe organisatiesystemen zoals bestandsstructuren en zoektools om relevante informatie op te halen wanneer nodig.

Techniek 4: Isolation – Sub-Agents en Taakscheiding

Isolation is het inzetten van sub-agents voor specifieke taken, zodat verschillende agents aan afzonderlijke problemen werken zonder overlap in context. Deze techniek erkent dat het soms het beste is om complexe problemen op te splitsen in kleinere, meer gerichte subproblemen, elk behandeld door een aparte agent met een eigen contextvenster.

Er zijn twee hoofdparadigma’s voor isolation. Cognition, een toonaangevende AI-onderzoeksorganisatie, raadt het gebruik van sub-agents af tenzij taken volledig gescheiden zijn zonder overlap. Hun filosofie is dat sub-agents extra complexiteit en faalpunten toevoegen en alleen moeten worden gebruikt als het absoluut noodzakelijk is. Andere organisaties, zoals Cloud Code, hebben sub-agents juist omarmd als kernonderdeel van hun architectuur. In Cloud Code kun je sub-agents aanmaken voor verschillende aspecten van een grotere taak, met een manager-agent die de coördinatie verzorgt.

Het belangrijkste inzicht bij isolation is dat het een afweging is. Aan de ene kant helpt het inzetten van sub-agents bij het beheren van context door het probleemgebied op te delen—elke agent heeft een gericht contextvenster dat relevant is voor zijn specifieke taak. Aan de andere kant introduceren sub-agents coördinatie-overhead en potentiële faalpunten waar informatie tussen agents moet worden overgedragen. De juiste aanpak hangt af van je specifieke situatie. Voor zeer complexe taken met duidelijke subproblemen kan isolation effectief zijn. Voor taken waarbij verschillende aspecten sterk samenhangen, is één agent met goed beheerde context wellicht geschikter.

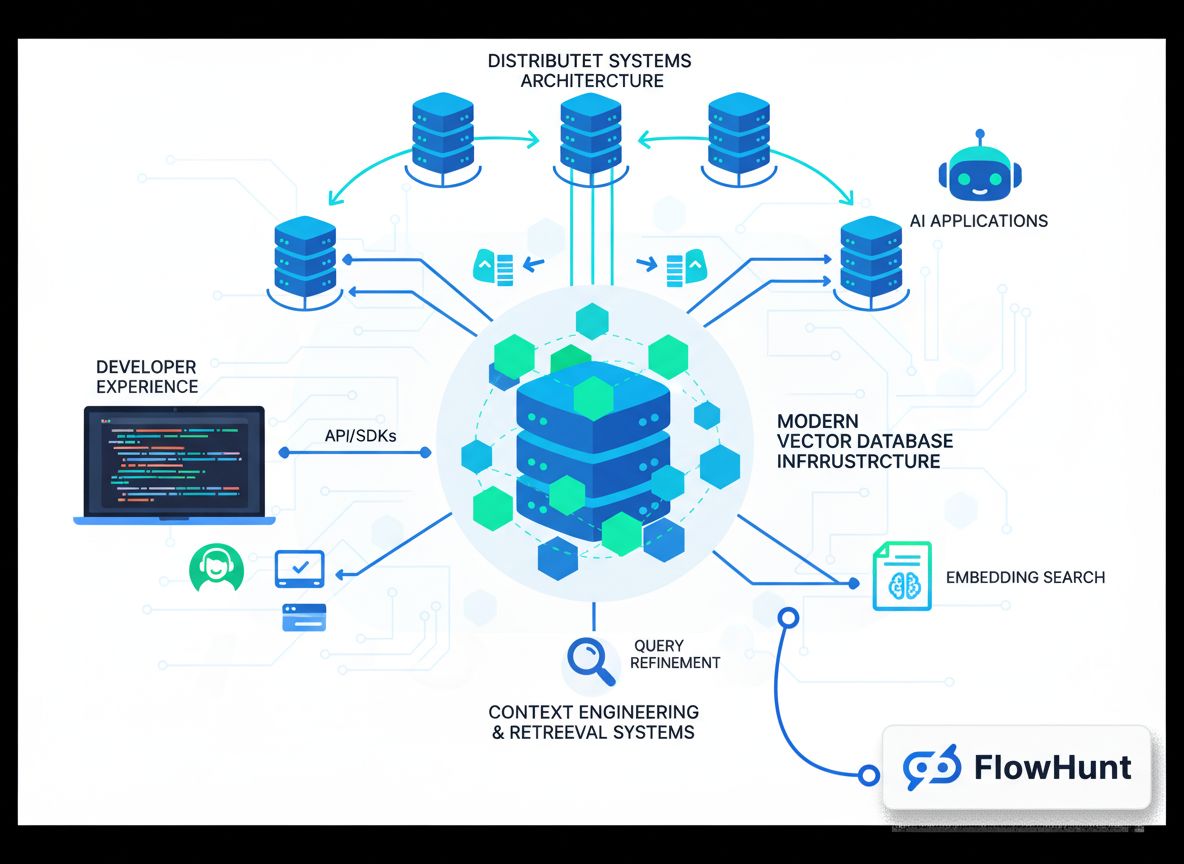

Context Engineering Implementatie in FlowHunt

FlowHunt biedt een uitgebreid no-code platform voor het implementeren van alle bovenstaande context engineering technieken. In plaats van maatwerkoplossingen te moeten bouwen, kunnen teams met FlowHunt geavanceerde contextmanagementstrategieën toepassen via een intuïtieve visuele interface. Dit democratiseert context engineering en maakt het toegankelijk voor teams zonder diepgaande machine learning-kennis.

Binnen FlowHunt kun je isolation toepassen via zelfbeherende teams. Een zelfbeherend team bestaat uit meerdere AI-agents met een manager-agent die de coördinatie verzorgt. De manager-agent ontvangt de initiële taak, splitst deze op in subtaken en delegeert deze aan gespecialiseerde agents. Elke agent behoudt een eigen, gericht contextvenster dat relevant is voor zijn specifieke verantwoordelijkheid. Zodra de sub-agents hun werk afronden, synthetiseert de manager-agent de resultaten. Met deze aanpak kun je complexe problemen aanpakken door ze op te delen in beheersbare stukken, elk met een optimaal ingerichte context.

FlowHunt ondersteunt tevens sequentiële taakflows, waarbij meerdere agents in volgorde aan een probleem werken, waarbij de output van de ene agent de input is voor de volgende. Dit is vooral nuttig bij workflows waar taken duidelijke afhankelijkheden hebben. In een contentgeneratieworkflow kan bijvoorbeeld één agent onderzoek doen, een tweede een outline maken en een derde het uiteindelijke stuk schrijven. Elke agent heeft een contextvenster met alleen de relevante informatie voor zijn stap.

Daarnaast stelt FlowHunt je in staat om intelligente retrievalsystemen direct in je flows te bouwen. In plaats van alle informatie vooraf te laden, kun je agents configureren om relevante data dynamisch op te halen. Dit kan bestaan uit het bevragen van databases, zoeken in kennisbanken of het ophalen van bestanden op basis van het redeneren van de agent over welke informatie hij nodig heeft. Door deze mogelijkheden te combineren, kun je via FlowHunt context engineering op ondernemingsniveau implementeren zonder dat je een regel code hoeft te schrijven.

Geavanceerde Context Engineering Strategieën en Toepassingen

Naast de vier kerntechnieken gebruiken toonaangevende organisaties diverse geavanceerde strategieën om de grenzen van context engineering te verleggen. Deze benaderingen combineren vaak meerdere technieken en vereisen zorgvuldige afstemming op specifieke use-cases.

Een geavanceerde strategie is hybride contextbeheer, waarbij organisaties een combinatie van vooraf geladen context en just-in-time retrieval gebruiken. In plaats van alles vooraf of alleen dynamisch op te halen, laden hybride benaderingen enkele kritische informatie vooraf voor snelheid en betrouwbaarheid, terwijl extra informatie waar nodig wordt opgehaald. Claude Code gebruikt deze hybride aanpak—CLAUDE.md-bestanden worden vooraf in context geladen omdat ze klein zijn en belangrijke configuratie bevatten, terwijl grotere bestanden en data just-in-time worden opgehaald met tools als grep en glob.

Een andere strategie is metadata-gedreven contextselectie. In plaats van alleen naar de inhoud van informatie te kijken, gebruiken geavanceerde systemen metadata zoals bestandsnamen, tijdstempels, mappenstructuren en andere organisatorische signalen om intelligent te bepalen welke informatie relevant is. Een agent die in een bestandssysteem werkt, kan bijvoorbeeld veel afleiden uit de aanwezigheid van een bestand test_utils.py in een tests-map versus hetzelfde bestand in src/core_logic/. Deze metadatasignalen helpen agents te begrijpen hoe en wanneer informatie te gebruiken, waardoor het laden en verwerken van volledige content vaak niet nodig is.

Context poisoning-mitigatie is nog een essentiële geavanceerde strategie. Zoals eerder besproken, ontstaat context poisoning wanneer irrelevante informatie in de context het redeneerproces van de agent verstoort. Geavanceerde systemen werken actief om potentieel schadelijke context te identificeren en te verwijderen. Dit kan inhouden dat het redeneerpad van de agent wordt geanalyseerd om te bepalen waar het misging, waarna de context die tot die afwijking leidde wordt verwijderd of herformuleerd. Op termijn ontstaat zo een feedbackloop die de contextkwaliteit continu verbetert.

De Toekomst van Context Engineering en AI-Agentontwikkeling

Naarmate AI-agents geavanceerder worden en in steeds complexere praktijksituaties worden ingezet, wordt context engineering alleen maar belangrijker. Het vakgebied ontwikkelt zich snel, met voortdurend nieuwe technieken en best practices. Verschillende trends zullen de toekomst van context engineering bepalen.

Ten eerste zullen er waarschijnlijk meer geavanceerde systemen voor geautomatiseerde contextcuratie komen. In plaats van handmatig te bepalen welke context moet worden opgenomen, zullen toekomstige systemen machine learning gebruiken om de optimale context voor elke agent en taak automatisch te bepalen. Deze systemen kunnen leren van performance-data om te herkennen welke contextwaardevol is en welke juist risico op poisoning inhoudt.

Ten tweede wordt context engineering steeds meer geïntegreerd in het ontwerp van agentarchitecturen. In plaats van contextmanagement als bijzaak te behandelen, worden toekomstige agentsystemen vanaf de basis ontworpen met contextefficiëntie in gedachten. Dit kan resulteren in nieuwe agentarchitecturen die inherent beter zijn in het beheren van beperkte contextvensters of nieuwe manieren van informatie representatie die zuiniger omgaan met tokens.

Ten derde zal context engineering waarschijnlijk uitgroeien tot een apart professioneel vakgebied, met gespecialiseerde tools, frameworks en best practices. Net zoals prompt engineering zich ontwikkelde van een ad-hoc praktijk tot een erkende discipline met vaste technieken, volgt context engineering een vergelijkbaar pad. Organisaties zullen investeren in gespecialiseerde teams en tools die zich specifiek richten op contextoptimalisatie.

{{ cta-dark-panel

heading=“Versnel je workflow met FlowHunt”

description=“Ervaar hoe FlowHunt je AI-content- en SEO-workflows automatiseert — van onderzoek en contentgeneratie tot publicatie en analyse — alles op één plek.”

ctaPrimaryText=“Boek een Demo”

ctaPrimaryURL=“https://calendly.com/liveagentsession/flowhunt-chatbot-demo"

ctaSecondaryText=“Probeer FlowHunt Gratis”

ctaSecondaryURL=“https://app.flowhunt.io/sign-in"

gradientStartColor="#123456”

gradientEndColor="#654321”

gradientId=“827591b1-ce8c-4110-b064-7cb85a0b1217”

}}

Praktische Implementatie: Je Eerste Context-Engineerde Agent Bouwen

Om je op weg te helpen met context engineering, doorlopen we een praktisch voorbeeld van het bouwen van een context-engineerde agent voor een veelvoorkomend use-case: onderzoek en contentgeneratie. Dit voorbeeld laat zien hoe je de besproken technieken toepast in een echte situatie.

Begin met het duidelijk definiëren van de kerntaak van je agent. In dit geval is de taak van de agent om een onderwerp te onderzoeken en een uitgebreid artikel te genereren. In plaats van alles in één agent met een massief contextvenster te proppen, gebruik je isolation om een multi-agent systeem te maken. De eerste agent is een onderzoeker die informatie over het onderwerp verzamelt. De tweede agent is een schrijver die het artikel op basis van het onderzoek maakt. Een manager-agent coördineert tussen beiden.

Voor de onderzoeker-agent implementeer je retrieval-gebaseerd contextbeheer. In plaats van alle beschikbare informatie over het onderwerp vooraf te laden, krijgt de onderzoeker-agent tools om databases te doorzoeken, API’s te bevragen en relevante documenten op te halen. Naarmate hij informatie ontdekt, vat hij de belangrijkste bevindingen samen en slaat referenties naar volledige bronnen op. Zo blijft het contextvenster van de onderzoeker slank, maar is alle noodzakelijke informatie toch beschikbaar.

Voor de schrijver-agent pas je offloading toe. De onderzoeker geeft een samenvatting van de bevindingen aan de schrijver, samen met referenties naar de volledige bronnen. De context van de schrijver bevat de samenvatting en de mogelijkheid om de volledige bronmateriaal op te halen indien nodig. Zo kan de schrijver efficiënt werken zonder overspoeld te worden door ruwe onderzoeksdata.

Monitor tijdens het proces op context poisoning. Als je merkt dat de agent slechte beslissingen maakt of afdwaalt, analyseer dan het redeneertraject om te achterhalen welke context dit veroorzaakt. Verwijder of herformuleer die context en test opnieuw. Na verloop van tijd ontwikkel je zo een gevoel voor welke context het beste werkt voor jouw specifieke situatie.

Context Engineering Prestaties Meten en Optimaliseren

Effectieve context engineering vereist meting en continue optimalisatie. Je moet metrics bepalen waarmee je kunt zien of je context engineering-initiatieven daadwerkelijk de prestaties van agents verbeteren. Enkele belangrijke metrics zijn het volgen waard.

Ten eerste: meet token-efficiëntie—de verhouding tussen nuttige output en gebruikte tokens. Een agent die hoogwaardige resultaten levert met minder tokens is efficiënter. Volg deze metric in de tijd terwijl je context engineering technieken toepast. Door offloading, reduction en retrieval toe te passen, zou je verbetering moeten zien.

Ten tweede: meet redeneerkwaliteit. Dit kan betekenen dat je de redeneerketens van de agent analyseert op samenhang en logica, of de kwaliteit van de output afzet tegen een gouden standaard. Naarmate je context engineering verbetert, moet ook de redeneerkwaliteit omhoog gaan omdat de agent minder wordt afgeleid door irrelevante informatie.

Ten derde: meet foutherstel. Hoe goed herstelt de agent als hij een fout maakt? Betere context engineering leidt tot beter foutherstel omdat de agent helderder inzicht heeft in wat er misging en wat hij moet doen.

Ten vierde: meet latency en kosten. Hoewel context engineering vooral over kwaliteitsverbetering gaat, levert het ook efficiëntievoordelen op. Agents met beter beheerde contextvensters hebben doorgaans een lagere latency (omdat ze minder tokens verwerken) en lagere kosten (omdat ze minder tokens verbruiken). Volg deze metrics om het volledige effect van je context engineering-inspanningen te begrijpen.

Veelvoorkomende Valkuilen en Hoe Ze te Voorkomen

Bij het implementeren van context engineering zijn er een aantal veelvoorkomende valkuilen. Door hiervan op de hoogte te zijn, kun je kostbare fouten voorkomen.

De eerste valkuil is over-optimalisatie. Het is verleidelijk om elk mogelijk token uit je contextvenster te persen, maar daardoor kan de context te mager worden om nog nuttig te zijn. Vergeet niet dat het doel is om het optimale evenwicht te vinden—genoeg informatie voor effectieve redenering, maar niet zoveel dat de agent verward raakt. Start met een redelijke hoeveelheid context en reduceer pas als je ziet dat de agent goed presteert.

De tweede valkuil is het negeren van taakspecifieke eisen. Context engineering is geen one-size-fits-all. Wat werkt voor een klantservice-agent, werkt mogelijk niet voor een data-analyse-agent. Neem de tijd om je specifieke use-case te begrijpen en pas je context engineering-strategie daarop aan.

De derde valkuil is het nalaten van monitoring en iteratie. Context engineering is geen eenmalige activiteit. Naarmate je agent nieuwe situaties tegenkomt en je eisen veranderen, moet je de prestaties continu monitoren en je contextstrategie bijstellen. Bouw monitoring en iteratie vanaf het begin in je ontwikkelproces.

De vierde valkuil is het onderschatten van het belang van metadata. Veel teams richten zich op de inhoud van hun context, maar vergeten de metadata die agents helpt begrijpen hoe ze die inhoud moeten gebruiken. Bestandsnamen, tijdstempels, mappenstructuren en andere organisatorische signalen zijn vaak waardevoller dan je denkt. Let goed op hoe je informatie organiseert en labelt.

Conclusie

Context engineering markeert een fundamentele verschuiving in hoe we AI-agents bouwen: van het zoeken naar perfecte prompts naar het strategisch beheren van alle beschikbare informatie om de agentprestaties te optimaliseren. Door de vier kerntechnieken—offloading, reduction, retrieval en isolation—te begrijpen en toe te passen, samen met geavanceerde strategieën zoals hybride contextbeheer en metadata-gedreven selectie, kun je agents bouwen die capabeler, betrouwbaarder en efficiënter zijn. Platforms als FlowHunt maken deze geavanceerde technieken toegankelijk via no-code interfaces en democratiseren zo context engineering voor teams van elke omvang. Weet dat context engineering een iteratief proces is dat continue meting en optimalisatie vereist. Begin met de basis, meet je resultaten en voeg geleidelijk meer geavanceerde technieken toe naarmate je expertise groeit. De organisaties die context engineering beheersen, bouwen de meest capabele en betrouwbare AI-agents en behalen zo een aanzienlijk concurrentievoordeel in een steeds meer door AI gedreven wereld.