Introductie

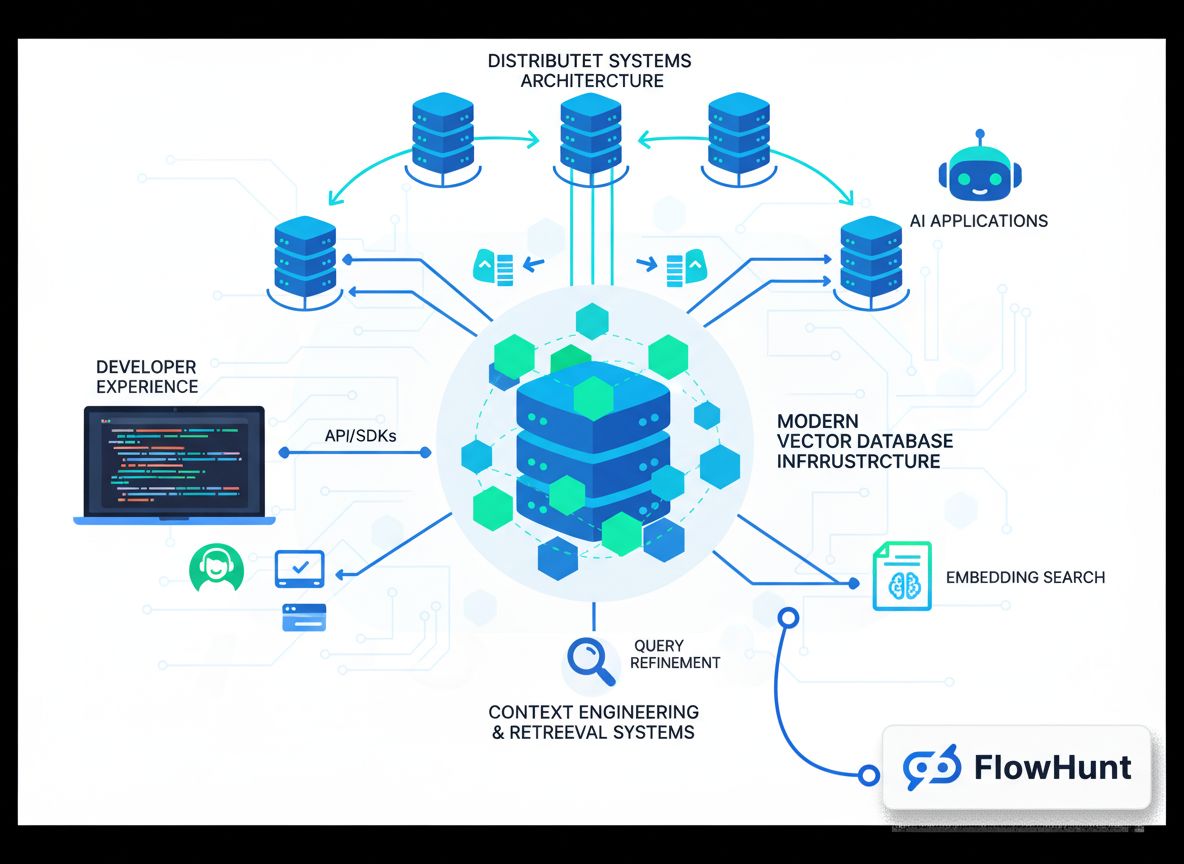

De reis van het bouwen van een werkend AI-prototype naar het uitrollen van een productieklare oplossing is al lange tijd een van de grootste uitdagingen binnen AI-ontwikkeling. Wat in demo’s vaak een eenvoudig proces lijkt—relevante informatie ophalen, prompts aanvullen en antwoorden genereren—wordt exponentieel complexer wanneer het opgeschaald wordt naar productieomgevingen. Deze complexiteit heeft ertoe geleid dat velen in de sector spreken over “alchemie” in plaats van engineering: een mysterieus proces waarbij ontwikkelaars aan configuraties sleutelen, parameters aanpassen en hopen dat hun systemen betrouwbaar blijven werken. De opkomst van context engineering als discipline betekent een fundamentele verschuiving in hoe we AI-systemen bouwen: we stappen af van deze trial-and-error methodiek en bewegen richting een meer gestructureerde, ingenieursmatige aanpak. In deze uitgebreide verkenning bekijken we hoe moderne vectordatabases en context engineering-principes het landschap van AI-toepassingsontwikkeling veranderen, waardoor teams systemen kunnen bouwen die niet alleen functioneren, maar daadwerkelijk betrouwbaar en onderhoudbaar zijn op schaal.

Wat is Context Engineering en waarom is het belangrijk?

Context engineering is uitgegroeid tot een van de meest essentiële disciplines binnen moderne AI-ontwikkeling, maar het wordt door veel ontwikkelaars nog slecht begrepen. In de kern is context engineering het systematisch beheren, organiseren en optimaliseren van de contextuele informatie die AI-systemen gebruiken voor het nemen van beslissingen en genereren van output. In tegenstelling tot traditionele Retrieval-Augmented Generation (RAG), dat zich beperkt tot het ophalen van relevante documenten ter aanvulling van een prompt voordat deze naar een taalmodel wordt gestuurd, kijkt context engineering veel breder naar de gehele pijplijn. Het omvat hoe data door het systeem stroomt, hoe informatie wordt opgeslagen en geïndexeerd, hoe retrieval plaatsvindt, hoe resultaten worden gerankt en gefilterd, en uiteindelijk hoe die context aan het model wordt aangeboden. Dit holistische perspectief erkent dat de kwaliteit van de output van een AI-systeem fundamenteel wordt beperkt door de kwaliteit en relevantie van de context die het ontvangt. Wanneer de context slecht beheerd wordt—wanneer irrelevante informatie wordt opgehaald, belangrijke details worden gemist of dezelfde informatie meerdere keren wordt verwerkt—gaat de kwaliteit van het hele systeem achteruit. Context engineering pakt deze uitdagingen aan door contextmanagement als een primaire engineeringopgave te behandelen, die dezelfde aandacht en zorg verdient als andere essentiële infrastructuurcomponenten.

Het belang van context engineering wordt direct duidelijk als je kijkt naar de schaal waarop moderne AI-systemen opereren. Een taalmodel kan gevraagd worden om honderdduizenden documenten te verwerken, informatie uit verschillende bronnen te synthetiseren en samenhangende antwoorden te genereren op basis van die synthese. Zonder goede context engineering wordt dit proces chaotisch. Irrelevante documenten verstoppen het contextvenster, belangrijke informatie raakt verloren in de ruis en de prestaties van het model gaan achteruit. Bovendien, naarmate AI-systemen geavanceerder worden en worden ingezet voor meer kritische toepassingen—van klantenservice tot medische diagnoses en financiële analyses—worden de gevolgen van slechte context engineering steeds groter. Een systeem dat af en toe irrelevante informatie teruggeeft is misschien acceptabel voor entertainment, maar niet als het gaat om beslissingen die levens of inkomens beïnvloeden. Context engineering zorgt ervoor dat de informatie in het systeem niet alleen overvloedig is, maar vooral relevant, goed georganiseerd en geoptimaliseerd voor de taak.

Klaar om uw bedrijf te laten groeien?

Start vandaag uw gratis proefperiode en zie binnen enkele dagen resultaten.

De evolutie van demo naar productie: het alchemie-probleem

Een van de meest hardnekkige uitdagingen in AI-ontwikkeling is wat branche-experts de “demo-naar-productie-kloof” noemen. Het bouwen van een werkend prototype dat AI-mogelijkheden demonstreert is relatief eenvoudig. Een ontwikkelaar kan snel een taalmodel samenstellen, koppelen aan een simpel retrieval-systeem en iets maken dat in een gecontroleerde omgeving indrukwekkend werkt. Maar zodra dat systeem echte data op schaal moet verwerken, betrouwbaarheid over tijd moet behouden en zich moet aanpassen aan veranderende eisen, wordt alles veel moeilijker. Deze kloof werd historisch overbrugd door wat alleen maar als alchemie omschreven kan worden—een mysterieuze mix van configuratie-aanpassingen, parameter-tweaks en trial-and-error die uiteindelijk tot een werkend systeem leidt. Het probleem met deze aanpak is dat hij niet reproduceerbaar, niet schaalbaar en niet onderhoudbaar is. Als er iets stukgaat in productie, is het vaak onduidelijk waarom en moet je opnieuw door datzelfde mysterieuze proces.

De kern van het alchemie-probleem ligt in het feit dat de meeste AI-infrastructuur niet ontworpen is met productie in gedachten. Vroege vectordatabases en retrieval-systemen waren vooral bedoeld om de haalbaarheid van semantische zoektoepassingen en retrieval op basis van embeddings aan te tonen. Ze werkten prima in gecontroleerde omgevingen met kleine datasets en voorspelbare querypatronen. Maar als je deze systemen opschaalt naar miljoenen documenten, duizenden gelijktijdige gebruikers en onvoorspelbare query’s, storten ze vaak in. Dataconsistentie wordt een probleem, query-prestaties nemen af, het systeem wordt lastig te debuggen en te monitoren. Ontwikkelaars bevinden zich in een situatie waarin ze niet echt een systeem engineeren, maar een complex, fragiel artefact beheren dat door geluk en constante interventie werkt. Hier komen moderne context engineering en doelgerichte infrastructuur om de hoek kijken. Door de reis van demo naar productie te behandelen als een legitieme engineeringuitdaging en systemen te bouwen die specifiek zijn ontworpen voor productieworkloads, transformeren we deze mysterieuze alchemie tot echte engineering.

Moderne zoekinfrastructuur voor AI begrijpen

Traditionele zoekinfrastructuur, zoals die Google en andere zoekmachines aandrijft, is ontworpen met specifieke aannames over hoe zoekopdrachten gebruikt worden. Deze systemen zijn gebouwd voor keyword-based queries van menselijke gebruikers die zelf de resultaten beoordelen en beslissen welke links ze willen volgen. De infrastructuur is geoptimaliseerd voor dat gebruik: snelle keyword-matching, ranking-algoritmen voor menselijke relevantiebeoordeling en presentatie van resultaten als “tien blauwe links” die makkelijk te scannen zijn. Maar AI-systemen hebben fundamenteel andere behoeften. Een taalmodel dat zoekresultaten consumeert kijkt niet naar tien links—het kan veel meer informatie verwerken. Het model heeft geen resultaten nodig die geformatteerd zijn voor mensen, maar gestructureerde data waarover het kan redeneren. De queries zijn niet keyword-gebaseerd, maar semantisch, gebaseerd op embeddings en vectorvergelijkingen. Deze fundamentele verschillen betekenen dat traditionele zoekinfrastructuur slecht aansluit bij AI-toepassingen.

Moderne zoekinfrastructuur voor AI speelt hier op verschillende manieren op in. Ten eerste zijn de gebruikte tools en technologieën fundamenteel anders. In plaats van keyword-indexen en ranking-algoritmen geoptimaliseerd voor mensen, gebruiken moderne systemen vector-embeddings en semantische similariteit. In plaats van expliciete keywords begrijpen ze de betekenis en intentie achter queries. Ten tweede zijn de workloadpatronen anders. Klassieke zoeksystemen verwerken eenvoudige queries met een klein aantal resultaten. AI-systemen moeten vaak grote aantallen documenten ophalen en die op geavanceerde manieren verwerken. Ten derde: de ontwikkelaars hebben andere behoeften. AI-ontwikkelaars willen systemen die makkelijk te integreren zijn, een goede developer experience bieden en waarvoor je geen deep search-expert hoeft te zijn. En misschien wel het belangrijkst: de consument van zoekresultaten is anders. In traditionele search doet de mens het ‘laatste stukje werk’—relevantie bepalen, tabbladen openen, informatie synthetiseren. In AI-systemen doet het taalmodel dat werk, en dat kan veel meer informatie verwerken dan mensen ooit kunnen. Deze verschuiving in wie de resultaten consumeert, verandert alles aan het ontwerp van de infrastructuur.

Schrijf u in voor onze nieuwsbrief

Ontvang gratis de nieuwste tips, trends en aanbiedingen.

FlowHunt en de toekomst van AI-workflowautomatisering

Nu organisaties het belang van context engineering en moderne zoekinfrastructuur erkennen, is de uitdaging hoe je deze mogelijkheden integreert in bestaande workflows en ontwikkelprocessen. Hier komen platformen als FlowHunt in beeld, die een uniforme omgeving bieden voor het bouwen, testen en uitrollen van AI-toepassingen die afhankelijk zijn van geavanceerd contextmanagement en retrieval-systemen. FlowHunt begrijpt dat context engineering niet alleen draait om de juiste database—het gaat om de juiste tools en workflows om context door de hele AI-levenscyclus te beheren. Van data-inname en indexering, via retrieval en ranking, tot aan de eindinvoer en outputgeneratie van het model: elke stap moet zorgvuldig georkestreerd en gemonitord worden. FlowHunt biedt automatiseringsmogelijkheden die deze orkestratie naadloos maken, zodat ontwikkelaars zich kunnen richten op het bouwen van sterke AI-toepassingen en niet hoeven worstelen met infrastructuurdetails.

De aanpak van context engineering-automatisering is vooral waardevol voor teams die meerdere AI-toepassingen bouwen of complexe, meertraps retrieval-pijplijnen moeten beheren. In plaats van voor elke toepassing eigen infrastructuur te ontwikkelen, kunnen teams gebruikmaken van de kant-en-klare componenten en workflows van FlowHunt om de ontwikkeling te versnellen. Het platform verzorgt het tijdrovende werk van data-inname, embeddinggeneratie, indexbeheer en retrieval-orkestratie, zodat ontwikkelaars zich kunnen concentreren op de unieke aspecten van hun toepassing. Bovendien biedt FlowHunt inzicht en monitoring, waardoor het makkelijk is te begrijpen hoe context door het systeem stroomt, knelpunten te vinden en prestaties te optimaliseren. Door deze combinatie van automatisering en inzicht verandert context engineering van een mysterieus trial-and-error proces naar een systematische, meetbare discipline.

De architectuur van productieklare vectordatabases

Een vectordatabase bouwen die werkt in een demo is één ding; er een bouwen die betrouwbaar productieworkloads aankan, is iets heel anders. Productieklare vectordatabases moeten meerdere gelijktijdige gebruikers aankunnen, dataconsistentie handhaven, betrouwbare persistentie bieden en soepel opschalen naarmate de datavolumes groeien. Ze moeten te debuggen zijn als er iets misgaat, te monitoren zijn om het gedrag te begrijpen en onderhoudbaar blijven zodat teams het systeem kunnen doorontwikkelen. Deze eisen hebben geleid tot moderne vectordatabase-architecturen die principes uit de gedistribueerde systemen toepassen, die zich in de praktijk al decennia bewezen hebben.

Een van de belangrijkste architectuurprincipes bij moderne vectordatabases is de scheiding van opslag en rekenkracht. In traditionele monolithische databases zijn opslag en compute sterk gekoppeld—dezelfde server slaat data op én verwerkt queries. Dit zorgt voor problemen op schaal. Als je meer rekenkracht nodig hebt, moet je ook opslag toevoegen. Als je meer opslag nodig hebt, moet je ook rekenkracht uitbreiden. Deze inefficiëntie leidt tot verspilling en hogere kosten. Door opslag en compute te scheiden, kunnen moderne vectordatabases beide onafhankelijk opschalen. Opslag kan worden beheerd met kosteneffectieve object storage zoals Amazon S3, terwijl rekenkracht naar behoefte kan worden opgeschaald. Dit biedt enorme flexibiliteit en kostenvoordeel. Een ander cruciaal principe is multi-tenancy, waarmee één database meerdere onafhankelijke applicaties of teams veilig kan bedienen. Multi-tenancy vereist zorgvuldige isolatie zodat data en queries van de ene tenant de andere niet beïnvloeden, maar als het goed wordt geïmplementeerd, verbetert het resourcebenutting en verlaagt het de operationele complexiteit.

Moderne vectordatabases nemen ook principes over uit de gedistribueerde systemen die de afgelopen tien jaar standaard zijn geworden. Denk aan read-write-separatie, waarbij lees- en schrijfbewerkingen door verschillende componenten worden afgehandeld die hiervoor geoptimaliseerd zijn; asynchrone replicatie voor dataduurzaamheid zonder in te leveren op schrijfsnelheid; en gedistribueerde consensusmechanismen voor consistentie over meerdere nodes. Deze principes, samen met moderne programmeertalen als Rust die zowel prestatie als veiligheid bieden, maken vectordatabases betrouwbaar en performant genoeg voor productie. Het resultaat is infrastructuur die niet voelt als alchemie—maar als echte engineering.

Chroma’s aanpak van Developer Experience

Toen Chroma werd opgericht, had het team een duidelijke visie: de kloof tussen een werkende AI-demo en een productiesysteem voelde meer als alchemie dan als engineering, en die kloof moest worden gedicht. Het team koos voor een obsessieve focus op developer experience. In plaats van direct het meest feature-rijke of schaalbare systeem te bouwen, wilden ze het voor ontwikkelaars extreem eenvoudig maken om aan de slag te gaan met vectordatabases en semantische zoektoepassingen. Dit leidde tot een van Chroma’s meest kenmerkende eigenschappen: de mogelijkheid om het met één pip-commando te installeren en direct te gebruiken, zonder complexe configuratie of opzet. Deze eenvoud was revolutionair in de vectordatabasewereld. De meeste databases vereisen veel opzet en configuratie voordat je een simpele query kan draaien. Chroma elimineerde die drempel, waardoor ontwikkelaars in minuten in plaats van uren of dagen konden experimenteren met vectordatabases en semantische search.

De toewijding aan developer experience ging verder dan alleen het eerste gebruik. Chroma’s team investeerde veel in de betrouwbaarheid van het systeem op verschillende architecturen en deploymentomgevingen. In de beginperiode draaiden gebruikers Chroma op alles van standaard Linux-servers tot Arduinos en Power PC-architecturen. In plaats van deze toepassingen als randgevallen af te doen, deed het team extra moeite om te zorgen dat het overal betrouwbaar werkte. Deze toewijding aan universele compatibiliteit en betrouwbaarheid bouwde vertrouwen op bij de ontwikkelaarscommunity en droeg bij aan de snelle adoptie van Chroma. Het team besefte dat developer experience niet alleen om gebruiksgemak draait—maar ook om betrouwbaarheid, consistentie en het vertrouwen dat het systeem werkt zoals verwacht, ongeacht de omgeving.

Toen Chroma verder groeide en het team Chroma Cloud begon te bouwen, stonden ze voor een cruciale keuze. Ze hadden snel een gehoste versie van het single-node product kunnen uitbrengen om mee te liften op de vraag naar managed vectordatabase-diensten. Veel bedrijven in deze markt maakten die keuze, wat hen in staat stelde veel kapitaal op te halen en grote indruk te maken. Maar het Chroma-team koos anders. Ze beseften dat alleen het hosten van het single-node product niet voldeed aan hun standaard voor developer experience. Een echt goed cloudproduct moest vanaf de basis cloud-native zijn ontworpen. Het moest net zo gebruiksvriendelijk en betrouwbaar zijn als het single-node product, maar met de schaalbaarheid en betrouwbaarheid die productie vereist. Deze keuze betekende dat Chroma Cloud meer tijd kostte om te bouwen, maar leverde een product op dat echt waarmaakt dat context engineering engineering is, en geen alchemie.

De vier dimensies van “AI” in moderne zoekinfrastructuur

Als we het over moderne zoekinfrastructuur voor AI hebben, is het belangrijk te beseffen dat “AI” in verschillende contexten iets anders betekent. Er zijn zelfs vier duidelijke dimensies waarop moderne zoekinfrastructuur verschilt van traditionele zoeksystemen—en deze begrijpen is cruciaal voor effectieve AI-toepassingen. De eerste dimensie is technologisch. De tools en technologie in moderne zoekinfrastructuur verschillen fundamenteel van die in traditionele systemen. Waar traditionele systemen werken met inverted indices en keyword matching, gebruiken moderne systemen vector-embeddings en semantische similariteit. In plaats van TF-IDF-ranking gebruiken ze neurale netwerken en lerende rankingfuncties. Deze technologische verschillen weerspiegelen de aard van het probleem en de mogelijkheden van moderne AI.

De tweede dimensie is het workloadpatroon. Klassieke zoeksystemen zijn gebouwd voor simpele, stateless queries met een beperkt aantal resultaten. Moderne AI-systemen moeten vaak complexe, meertraps retrieval-pijplijnen aansturen met meerdere rondes van ranking, filtering en her-ranking. Ze kunnen duizenden documenten moeten ophalen en geavanceerd verwerken. De workload is fundamenteel anders, dus de infrastructuur moet ook anders ontworpen worden. De derde dimensie is de ontwikkelaar. Traditionele zoeksystemen werden doorgaans gebouwd en beheerd door gespecialiseerde search engineers met diepe expertise. Moderne AI-ontwikkelaars zijn vaak generalisten zonder die specialistische kennis, maar ze moeten wel toepassingen bouwen die op geavanceerde retrieval steunen. Moderne zoekinfrastructuur moet daarom vooral gebruiksvriendelijk en toegankelijk zijn.

De vierde en misschien wel belangrijkste dimensie is de consument van zoekresultaten. In traditionele systemen zijn dat mensen. Mensen kunnen maar een beperkt aantal resultaten verwerken—meestal een stuk of tien links—en doen het laatste stukje werk, namelijk het bepalen van relevantie en het synthetiseren van informatie. In moderne AI-systemen zijn taalmodellen de consumenten, en zij kunnen vele malen meer informatie verwerken dan mensen. Een taalmodel kan moeiteloos honderden of duizenden documenten verwerken en daaruit informatie synthetiseren. Dit fundamentele verschil verandert alles aan het ontwerp van de infrastructuur: ranking kan worden geoptimaliseerd voor machineverwerking, de presentatie van resultaten voor machine-invoer, en de gehele pijplijn kan gebouwd worden met het uitgangspunt dat een geavanceerd AI-systeem het laatste werk doet.

Visie behouden in een rumoerige markt

De vectordatabasemarkt in 2023 was een van de populairste categorieën binnen AI-infrastructuur. Bedrijven haalden enorme bedragen op, maakten veel indruk en streden om de meeste features te bieden. In zo’n omgeving was het voor Chroma makkelijk geweest om focus te verliezen, elke trend na te jagen en alles voor iedereen te willen zijn. In plaats daarvan koos het team bewust voor focus op hun kernvisie: een retrieval-engine bouwen voor AI-toepassingen met een uitzonderlijke developer experience, die daadwerkelijk de kloof tussen demo en productie overbrugt. Deze focus vroeg om discipline en overtuiging, vooral toen andere bedrijven grotere investeringen binnenhaalden en grotere aankondigingen deden.

De sleutel tot deze focus was een duidelijke, eigenzinnige visie op wat écht belangrijk is. Het Chroma-team geloofde dat het niet ging om het aantal features of de hoeveelheid opgehaald kapitaal, maar om de kwaliteit van de developer experience en de betrouwbaarheid van het systeem. Ze waren ervan overtuigd dat door één ding—een goede retrieval-engine—op wereldniveau te doen, ze later het recht zouden verdienen om meer te bouwen. Deze filosofie van extreme focus op één kerncompetentie is niet uniek voor Chroma, maar vrij zeldzaam in startups die door investeerders worden gedreven, waar de druk om snel te groeien en veel geld op te halen bedrijven vaak tot overhaaste keuzes brengt. De toewijding van Chroma aan deze filosofie, zelfs als dat betekende dat Chroma Cloud later uitkwam en ze mogelijk kortetermijnkansen misten, bleek uiteindelijk juist.

Visie behouden vraagt ook om zorgvuldig werven en teamopbouw. De mensen die je aanneemt vormen de cultuur van je organisatie, en de cultuur bepaalt wat en hoe je bouwt. Het Chroma-team zag dit en koos ervoor om langzaam en selectief te werven. In plaats van zo snel mogelijk te groeien, richtten ze zich op mensen die de visie deelden, veel waarde hechtten aan vakmanschap en kwaliteit, en zelfstandig op hoog niveau konden werken. Dit zorgde ervoor dat het team langzamer groeide, maar ook dat iedereen aan boord zich echt aan de missie committeerde en daaraan kon bijdragen. Zulke culturele fit is moeilijk in snelgroeiende startups, maar essentieel om focus en visie op de lange termijn te behouden.

Het belang van vakmanschap en kwaliteit in infrastructuur

Een van de meest opvallende aspecten van Chroma’s aanpak is de nadruk op vakmanschap en kwaliteit. In de infrastructuurwereld is het makkelijk te denken dat meer features, meer prestaties of meer schaalbaarheid altijd beter zijn. Maar het Chroma-team begreep dat het vooral draait om systemen die betrouwbaar werken, makkelijk te gebruiken zijn en echte problemen van ontwikkelaars oplossen. Deze focus op vakmanschap en kwaliteit uit zich op veel manieren. Het is zichtbaar in de keuze om Chroma in Rust te schrijven—een taal die zowel prestaties als veiligheid biedt—en niet in een makkelijkere maar minder betrouwbare taal. Het blijkt ook uit de inzet om het systeem op verschillende architecturen en omgevingen te laten werken, zelfs op ongebruikelijke of exotische plekken. En het is te merken aan de keuze om meer tijd te nemen voor Chroma Cloud, in plaats van gehaast een inferieur product te lanceren.

Deze aandacht voor vakmanschap en kwaliteit geldt ook voor hoe het team naar het probleem kijkt. In plaats van context engineering te zien als een technisch trucje dat je met slimme algoritmes oplost, ziet het team het als een bredere uitdaging die developer experience, betrouwbaarheid, schaalbaarheid en onderhoudbaarheid omvat. Dit holistische perspectief leidt tot betere oplossingen, omdat het erkent dat een systeem slechts zo sterk is als de zwakste schakel. Een systeem kan de meest geavanceerde retrieval-algoritmes ter wereld hebben, maar als het moeilijk te gebruiken is of onbetrouwbaar in productie, los je het probleem niet echt op. Door op alle fronten te focussen op vakmanschap en kwaliteit, heeft Chroma iets gebouwd dat daadwerkelijk werkt voor ontwikkelaars en echt de kloof tussen demo en productie overbrugt.

Praktische implicaties voor AI-ontwikkelteams

Voor teams die AI-toepassingen bouwen, zijn er uit Chroma’s aanpak verschillende praktische lessen te trekken. Ten eerste: context engineering is geen zijmissie binnen AI-ontwikkeling—het is een hoofdmissie. De kwaliteit van je AI-systeem wordt fundamenteel beperkt door de kwaliteit van de context, dus investeren in degelijke context engineering-infrastructuur is niet optioneel, maar essentieel. Ten tweede: wees kritisch op systemen die beloven alles te kunnen. De meest betrouwbare en effectieve systemen doen vaak één ding echt goed, en bouwen daar vervolgens op voort. Als je vectordatabases of retrieval-systemen evalueert, zoek dan naar oplossingen met een duidelijke focus en een commitment om dat ene goed te doen. Ten derde: developer experience doet ertoe. Een systeem dat theoretisch krachtiger is, maar moeilijk te gebruiken, zal uiteindelijk minder waardevol zijn dan een iets minder krachtig systeem dat makkelijk in gebruik is. Ontwikkelaars gebruiken nu eenmaal het systeem dat makkelijk werkt en bouwen daar betere dingen mee, terwijl ze met een lastig systeem afhaken.

Ten vierde: betrouwbaarheid en consistentie zijn belangrijker dan je denkt. In de beginfase van AI-ontwikkeling is het verleidelijk om features en prestaties te prioriteren boven betrouwbaarheid. Maar zodra systemen in productie komen en echte workloads draaien, wordt betrouwbaarheid essentieel. Een systeem dat 95% betrouwbaar is lijkt acceptabel, maar bij miljoenen queries per dag betekent dat honderdduizenden mislukte queries. Investeren in betrouwbaarheid vanaf het begin is veel goedkoper dan het later proberen te repareren. Tot slot: denk na over de lange termijn. De infrastructuur die je vandaag kiest, bepaalt wat je morgen kunt bouwen. Kiezen voor infrastructuur die vanaf het begin ontworpen is voor productie, die soepel schaalt en goede monitoring biedt, betaalt zich later dubbel en dwars terug.

{{ cta-dark-panel

heading=“Versnel je workflow met FlowHunt”

description=“Ervaar hoe FlowHunt jouw AI-content- en SEO-workflows automatiseert — van research en contentgeneratie tot publicatie en analyse — alles op één plek.”

ctaPrimaryText=“Boek een demo”

ctaPrimaryURL=“https://calendly.com/liveagentsession/flowhunt-chatbot-demo"

ctaSecondaryText=“Probeer FlowHunt gratis”

ctaSecondaryURL=“https://app.flowhunt.io/sign-in"

gradientStartColor="#123456”

gradientEndColor="#654321”

gradientId=“827591b1-ce8c-4110-b064-7cb85a0b1217”

}}

Een van de belangrijkste beslissingen die het Chroma-team nam, was het open source maken van het kernproduct. Deze keuze had verschillende grote gevolgen. Ten eerste bouwde het vertrouwen op bij de ontwikkelaarscommunity. Als ontwikkelaars de code kunnen inzien, snappen hoe het systeem werkt en verbeteringen kunnen bijdragen, zullen ze het sneller vertrouwen en adopteren. Open source creëert ook een positieve vicieuze cirkel waarin community-bijdragen het product verbeteren, wat meer gebruikers aantrekt, wat weer tot meer bijdragen leidt. Ten tweede ontstond er door open source een sterke community rond Chroma. Ontwikkelaars die het product gebruiken, raken betrokken bij het succes en dragen sneller bij, geven feedback en bevelen het aan bij anderen. Deze community is een waardevol bezit dat lastig te kopiëren is door concurrenten.

Ten derde biedt open source een natuurlijk pad naar inkomsten via hosted diensten. Door de kern open source te maken, creëerde Chroma een situatie waarin ontwikkelaars het gratis kunnen gebruiken als ze het zelf willen hosten, maar waar velen liever kiezen voor een beheerde, gehoste versie die zich ontfermt over beheer, schaalbaarheid en onderhoud. Dit is het model achter Chroma Cloud. Door een betere hosted ervaring te bieden en de kern open source te houden, kan Chroma zowel de self-hosted community als de managed service-markt bedienen. Deze aanpak is duurzamer en sluit beter aan op de wensen van ontwikkelaars dan een gesloten, proprietary kern.

Succes meten: de metrics die ertoe doen

Bij het beoordelen van het succes van infrastructuurprojecten als Chroma is het belangrijk te kijken naar metrics die echt waarde weerspiegelen. Chroma heeft indrukwekkende cijfers: meer dan 21.000 GitHub-sterren, meer dan 5 miljoen maandelijkse downloads en meer dan 60-70 miljoen downloads in totaal. Deze cijfers laten de brede adoptie binnen de ontwikkelaarscommunity zien. Maar belangrijker is of het project de problemen van ontwikkelaars oplost. Maakt het AI-applicaties bouwen makkelijker? Vermindert het de tijd en moeite om van demo naar productie te gaan? Maakt het betrouwbaardere systemen mogelijk? Op basis van community-feedback en snelle adoptie lijkt het antwoord op al deze vragen ‘ja’.

Een andere belangrijke metric is de kwaliteit van de community en de aard van de bijdragen. Chroma heeft bijdragen gekregen van ontwikkelaars uit de hele industrie, waaronder integraties met populaire frameworks als LangChain en Llama Index. Deze brede adoptie en integratie met andere tools is een teken dat Chroma echte problemen oplost en waarde biedt. Dat Chroma de standaardkeuze is geworden voor vectordatabase-functionaliteit in veel AI-frameworks, getuigt van de kwaliteit van het product en de kracht van de community. Deze kwalitatieve metrics—community-adoptie, integratie met andere tools en positieve gebruikersfeedback—zijn vaak waardevoller dan alleen downloadcijfers.

De toekomst van context engineering en AI-infrastructuur

Nu AI-systemen steeds geavanceerder en breder ingezet worden, zal het belang van context engineering alleen maar toenemen. De systemen die nu gebouwd worden zijn pas het begin. In de toekomst zullen we waarschijnlijk nog geavanceerdere benaderingen van contextmanagement zien, waaronder systemen die context dynamisch aanpassen aan de taak, systemen die leren van feedback om retrieval te verbeteren, en systemen die moeiteloos meerdere datamodaliteiten (tekst, beeld, audio, video) verwerken. De infrastructuur die deze systemen mogelijk maakt, zal nog geavanceerder moeten zijn, maar de principes blijven hetzelfde: focus op developer experience, zet in op betrouwbaarheid en kwaliteit, en behoud een heldere visie op de echte problemen die je oplost.

De rol van platformen als FlowHunt wordt ook steeds belangrijker. Naarmate context engineering centraler komt te staan in AI-ontwikkeling, hebben teams tools nodig waarmee ze eenvoudig geavanceerde contextmanagement-pijplijnen kunnen bouwen, testen en uitrollen. FlowHunt’s aanpak, waarbij automatisering en inzicht over de hele AI-levenscyclus geboden worden, sluit hier goed op aan. Door de complexiteit van context engineering-infrastructuur te abstraheren en high-level tools te bieden voor het bouwen van AI-applicaties, maken platformen als FlowHunt het mogelijk dat ontwikkelaars zich kunnen focussen op wat echt telt.

Conclusie

Context engineering betekent een fundamentele verschuiving in hoe we AI-systemen bouwen: van trial-and-error en alchemie naar een gestructureerde, ingenieursmatige discipline. Moderne vectordatabases als Chroma, gebouwd op principes als de scheiding van opslag en compute, multi-tenancy en een gedistribueerde architectuur, vormen de basis voor deze verschuiving. Door deze infrastructuurverbeteringen te combineren met aandacht voor developer experience, betrouwbaarheid en vakmanschap, kunnen teams AI-systemen bouwen die daadwerkelijk werken in productie en betrouwbaar opschalen. De inzichten uit Chroma’s aanpak—focus houden op de kernvisie, werven op culturele fit, kwaliteit boven features stellen en community opbouwen via open source—bieden een roadmap voor andere infrastructuurprojecten en teams die AI-applicaties bouwen. Naarmate het AI-veld zich verder ontwikkelt, wordt het belang van goede context engineering alleen maar groter—en daarmee is dit een van de belangrijkste focusgebieden voor iedereen die AI-systemen bouwt.