Gegevensvalidatie

Gegevensvalidatie in AI verwijst naar het proces van het beoordelen en waarborgen van de kwaliteit, nauwkeurigheid en betrouwbaarheid van data die gebruikt word...

Een uitgebreide gids voor het veilig integreren van AI-platforms met uw database met behulp van API-gateways, versleuteling, toegangscontroles en monitoringstrategieën.

Belangrijkste beveiligingsmaatregelen voor het blootstellen van databases aan AI:

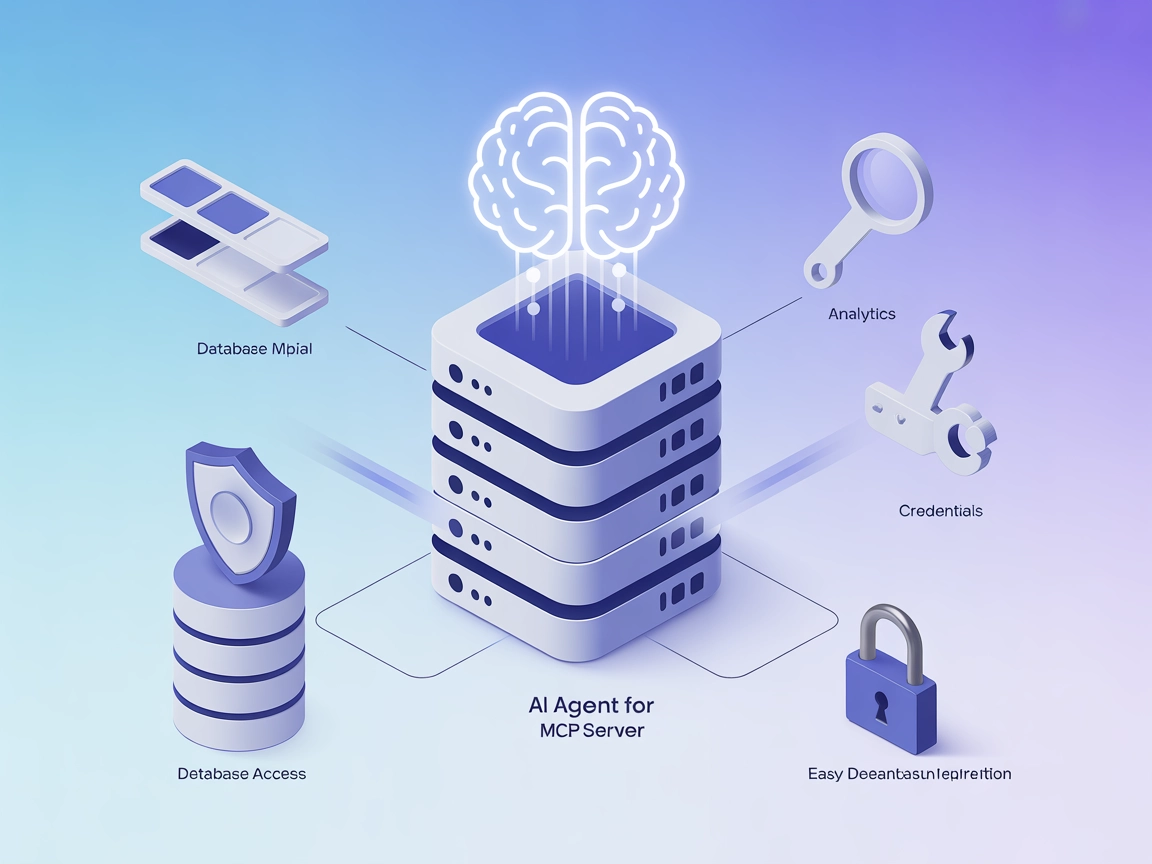

Veilige databaseblootstelling betekent dat AI-systemen toegang krijgen tot de gegevens die ze nodig hebben, terwijl u strikte controles handhaaft over welke gegevens worden benaderd, wie (of wat) toegang heeft, wanneer toegang plaatsvindt en hoe die toegang wordt gemonitord en gelogd. Dit is fundamenteel anders dan simpelweg uw database openstellen voor het internet of AI-platforms directe database-inloggegevens geven.

Wanneer we het hebben over het blootstellen van een database aan AI-platforms, bedoelen we een weloverwogen architecturale keuze om een gecontroleerde interface te creëren tussen uw data en externe AI-systemen. Deze interface fungeert als een beveiligingscheckpoint die authenticatie, autorisatie, versleuteling en auditlogs afdwingt bij elke stap. Het doel is om wat beveiligingsprofessionals een ‘single choke point’ noemen te creëren—een centrale plek waar alle toegang gemonitord, gecontroleerd en gevalideerd wordt.

De uitdaging is dat AI-platforms vaak brede toegang tot uiteenlopende datasets nodig hebben om effectief te kunnen werken. Een machine learning-model moet mogelijk klantgedrag, transactiegeschiedenis en productinformatie tegelijkertijd analyseren. Een generatief AI-systeem moet mogelijk over meerdere tabellen zoeken om complexe vragen te beantwoorden. Maar toegang verlenen zonder de juiste waarborgen kan uw organisatie blootstellen aan datalekken, compliance-overtredingen en insider threats.

De businesscase voor het veilig blootstellen van databases aan AI is overtuigend. Organisaties die AI succesvol integreren met hun datainfrastructuur verkrijgen een aanzienlijk concurrentievoordeel: snellere besluitvorming, geautomatiseerde inzichten, verbeterde klantervaringen en operationele efficiëntie. Maar de risico’s zijn even groot.

Datalekken waarbij blootgestelde databases betrokken zijn, komen steeds vaker voor en zijn kostbaar. In 2024 bedroegen de gemiddelde kosten van een datalek meer dan $4,45 miljoen, waarbij database-gerelateerde incidenten een aanzienlijk deel van deze verliezen uitmaakten. Wanneer het lek persoonlijke gegevens betreft die onder regelgeving als GDPR of CCPA vallen, nemen de financiële en reputatieschade dramatisch toe. Naast de directe kosten zijn er operationele verstoringen, verlies van klantvertrouwen en potentiële juridische aansprakelijkheid.

De uitdaging wordt groter wanneer AI-systemen betrokken zijn. AI-modellen kunnen per ongeluk gevoelige trainingsdata onthouden, waardoor deze terug te halen zijn via prompt injection-aanvallen of model extractie-technieken. AI-agenten met database-toegang kunnen gemanipuleerd worden via slim opgestelde prompts om onbedoelde queries uit te voeren of vertrouwelijke informatie prijs te geven. Deze nieuwe aanvalsvectoren vereisen beveiligingsaanpakken die verder gaan dan traditionele databasebescherming.

Bovendien neemt de regelgevende controle op AI snel toe. Databeschermingsautoriteiten wereldwijd geven richtlijnen uit over hoe organisaties moeten omgaan met persoonsgegevens bij het gebruik van AI-systemen. Naleving van GDPR, CCPA, HIPAA en opkomende AI-specifieke regelgeving vereist dat u kunt aantonen dat u passende waarborgen hebt voordat u data aan AI-platforms blootstelt.

Voordat u een strategie implementeert om uw database aan AI-platforms bloot te stellen, moet u een duidelijk beeld hebben van uw huidige beveiligingsinfrastructuur en datalandschap. Deze beoordeling moet een aantal kritische vragen beantwoorden:

Welke data heeft u eigenlijk? Voer een uitgebreide data-inventarisatie en classificatie uit. Categoriseer uw data naar gevoeligheidsniveau: openbaar, intern, vertrouwelijk en beperkt. Identificeer welke data persoonlijk identificeerbare informatie (PII), betaalkaartinformatie (PCI), beschermde gezondheidsinformatie (PHI) of andere gereguleerde gegevens bevat. Deze classificatie vormt de basis voor alle volgende toegangscontrolebeslissingen.

Welke beveiligingsmaatregelen heeft u momenteel? Documenteer uw bestaande databasebeveiliging: authenticatiemechanismen, versleutelingsstatus (zowel tijdens transport als in rust), netwerksegmentatie, back-up- en herstelprocedures en auditlogmogelijkheden. Identificeer waar controles ontbreken of verouderd zijn.

Aan welke compliance-verplichtingen moet u voldoen? Bekijk de relevante regelgeving voor uw sector en regio. Als u persoonsgegevens verwerkt, is GDPR-compliance waarschijnlijk verplicht. In de zorg geldt HIPAA. Financiële instellingen moeten rekening houden met PCI-DSS. Inzicht in deze verplichtingen bepaalt uw beveiligingsarchitectuur.

Wat is uw risicotolerantie? Verschillende organisaties hebben verschillende risicoprofielen. Een zorginstelling met patiëntgegevens tolereert minder risico dan een SaaS-bedrijf dat geanonimiseerde gebruiksstatistieken analyseert. Uw risicotolerantie bepaalt hoe restrictief uw toegangscontroles moeten zijn.

De belangrijkste architecturale keuze die u maakt, is uw database nooit direct bloot te stellen aan AI-platforms. Implementeer in plaats daarvan een veilige API-gateway tussen uw database en externe systemen. Deze gateway wordt het centrale controlepunt voor alle database-toegang.

Een API-gateway vervult meerdere essentiële functies. Ten eerste biedt het een abstractielaag die het AI-platform loskoppelt van uw databaseschema. Als uw databasestructuur verandert, hoeft u alleen de API aan te passen, niet met elk AI-platform opnieuw toegang te onderhandelen. Ten tweede kunt u hiermee consistente beveiligingsbeleid afdwingen voor alle toegangsverzoeken. Ten derde creëert het een gecentraliseerde plek voor monitoring, logging en het alarmeren op verdachte activiteiten.

Kies bij het selecteren of bouwen van een API-gateway voor oplossingen die identity-aware proxying (IAP) ondersteunen. Een IAP-gateway authenticeert elk verzoek voordat het uw database bereikt, zodat alleen geautoriseerde systemen toegang krijgen. Het moet meerdere authenticatiemethoden ondersteunen, waaronder OAuth 2.0, JWT-tokens, mutual TLS (mTLS) en API-sleutels. De gateway moet ook rate limiting afdwingen om misbruik te voorkomen en verzoekvalidatie om onjuiste of verdachte queries te blokkeren.

Populaire opties zijn cloud-native oplossingen als AWS API Gateway met IAM-integratie, Google Cloud’s Identity-Aware Proxy, Azure API Management of gespecialiseerde database-oplossingen zoals Hoop of DreamFactory. Elke oplossing heeft sterke punten, maar allemaal werken ze volgens het basisprincipe van een gecontroleerde toegangslag.

Als u eenmaal een API-gateway hebt, is de volgende cruciale laag het implementeren van robuuste authenticatie- en autorisatiemechanismen. Deze twee concepten worden vaak verward maar dienen verschillende doelen: authenticatie verifieert wie (of wat) een verzoek doet, terwijl autorisatie bepaalt wat die entiteit mag doen.

Voor menselijke gebruikers die toegang hebben tot AI-systemen die met uw database werken, implementeer multi-factor authenticatie (MFA). Dit combineert meestal iets dat u weet (een wachtwoord), iets dat u heeft (een telefoon of hardwaretoken) en iets dat u bent (biometrische gegevens). MFA vermindert het risico van accountcompromittering aanzienlijk, wat de ingang is voor veel datalekken.

Voor AI-systemen en serviceprincipals gebruikt u sterke, automatisch geroteerde inloggegevens. Hardcode nooit database-inloggegevens in applicatiecode of configuratiebestanden. Gebruik in plaats daarvan omgevingsvariabelen, secrets management-systemen (zoals HashiCorp Vault, AWS Secrets Manager of Azure Key Vault) of cloud-native credential-systemen die inloggegevens automatisch roteren volgens schema.

Implementeer waar mogelijk certificaatgebaseerde authenticatie. Mutual TLS (mTLS)-authenticatie, waarbij zowel client als server elkaar authenticeren met digitale certificaten, biedt sterkere beveiliging dan op wachtwoorden gebaseerde authenticatie. Elk AI-platform of service krijgt een uniek certificaat dat moet worden aangeboden bij toegang tot de API-gateway.

Role-Based Access Control (RBAC) is het meest gebruikte autorisatiemodel. U definieert rollen (zoals “AI_Analytics_Reader” of “ML_Training_Agent”) en wijst machtigingen toe aan die rollen. Elk AI-systeem krijgt één of meer rollen toegewezen en mag alleen de acties uitvoeren die bij die rollen horen. RBAC is eenvoudig te implementeren en te begrijpen, en daarom ideaal voor de meeste organisaties.

Attribute-Based Access Control (ABAC) is geavanceerder en flexibeler. In plaats van rollen toe te wijzen, definieert u beleid op basis van attributen van het verzoek: de afdeling van de gebruiker, het classificatieniveau van de data, het tijdstip, de geografische locatie van het verzoek, het doel van de toegang en andere factoren. ABAC biedt fijnmazigere controle, maar vereist zorgvuldiger beleidsontwerp.

Implementeer het principe van least privilege: geef elk AI-systeem alleen de minimale rechten die het nodig heeft om te functioneren. Als een AI-systeem alleen klantnamen en e-mailadressen hoeft te lezen, geef dan geen toegang tot betalingsgegevens of burgerservicenummers. Heeft het alleen leestoegang nodig, geef dan geen schrijf- of verwijderrechten.

Zelfs met sterke authenticatie en autorisatie moet u de data zelf beschermen. Dit doet u met twee complementaire strategieën: versleuteling en datamasking.

Versleuteling tijdens transport beschermt data terwijl deze tussen uw database en het AI-platform wordt verzonden. Gebruik TLS 1.2 of hoger voor alle verbindingen. Zo blijft data onleesbaar als netwerkverkeer wordt onderschept zonder de juiste sleutels. De meeste moderne API-gateways en databases ondersteunen TLS standaard, maar controleer of dit correct is ingeschakeld.

Versleuteling in rust beschermt opgeslagen data in uw database. Zelfs als een aanvaller ongeautoriseerde toegang verkrijgt tot databasebestanden of back-ups, kan hij de data niet lezen zonder de sleutels. Moderne databases ondersteunen vaak transparante data-encryptie (TDE) of vergelijkbare functies die data automatisch versleutelen. Schakel deze functie in en zorg dat sleutels veilig worden beheerd.

Sleutelbeheer is cruciaal. Sla nooit encryptiesleutels op dezelfde plek op als de versleutelde data. Gebruik een aparte key management service (KMS) die toegang tot sleutels apart van de database beheert. Roteer sleutels regelmatig—minimaal jaarlijks, en vaker voor zeer gevoelige data. Implementeer sleutelversies zodat oude sleutels beschikbaar blijven voor het decoderen van historische data.

Datamasking vervangt gevoelige waarden door versluierde of synthetische waarden. Zo kan een burgerservicenummer worden gemaskeerd als “XXX-XX-1234” (alleen de laatste vier cijfers zichtbaar). Een creditcardnummer als “--****-4567”. Hierdoor kunnen AI-systemen werken met data die qua structuur lijkt op echte data, zonder gevoelige waarden te onthullen.

Dynamische datamasking past maskingregels toe op querytijd, afhankelijk van de rol van de gebruiker en de gevoeligheid van de data. Een medewerker klantenservice ziet volledige namen en telefoonnummers, terwijl een AI-analysesysteem alleen gemaskeerde versies ziet. Deze aanpak is flexibeler dan statische masking omdat u verschillende maskingregels op verschillende gebruikers kunt toepassen.

Implementeer masking op kolomniveau voor uw meest gevoelige data. Identificeer kolommen met PII, betalingsinformatie, gezondheidsdata of andere gereguleerde informatie, en pas maskingregels toe op die kolommen. Veel databases ondersteunen dit standaard, of u kunt het implementeren in de API-gatewaylaag.

Laten we bekijken hoe RBAC in de praktijk werkt. Stel u heeft een database met klantinformatie, transactiegeschiedenis en productdata. U wilt deze database blootstellen aan drie verschillende AI-systemen: een aanbevelingsengine, een fraudedetectiesysteem en een klantanalyseplatform.

| AI-systeem | Vereiste toegang | Aanbevolen rol | Specifieke machtigingen |

|---|---|---|---|

| Aanbevelingsengine | Klantprofielen, aankoopgeschiedenis | AI_RECOMMENDATIONS_READER | SELECT op customers, orders, products-tabellen; geen toegang tot betaalmethoden of persoonlijke contactinfo |

| Fraudebestrijdingssysteem | Transactiedetails, klantgeschiedenis | AI_FRAUD_DETECTOR | SELECT op transacties, klanten, accounts; toegang tot betalingsinformatie maar niet tot klantcontactgegevens |

| Analyseplatform | Geaggregeerde klantdata | AI_ANALYTICS_READER | SELECT op geaggregeerde views; geen toegang tot individuele klantrecords of transactiedetails |

Elke rol heeft specifieke rechten die bepalen welke data toegankelijk is en welke handelingen mogen worden uitgevoerd. De aanbevelingsengine kan geen betalingsinformatie zien omdat dat niet nodig is. Het fraudedetectiesysteem ziet transacties maar geen e-mailadressen. Het analyseplatform ziet alleen geaggregeerde data, geen individuele records.

Zo zorgt u ervoor dat als één AI-systeem wordt gecompromitteerd, de toegang van de aanvaller beperkt blijft tot alleen de data die dat systeem nodig heeft. De impact van een beveiligingsincident wordt geminimaliseerd.

Zelfs met sterke preventieve maatregelen moet u beveiligingsincidenten kunnen detecteren en erop reageren. Hiervoor zijn uitgebreide monitoring, gedetailleerde auditing en geautomatiseerde dreigingsdetectie vereist.

Schakel gedetailleerde auditlogging in voor alle database-toegang. Elke query die door een AI-systeem wordt uitgevoerd, moet worden gelogd, inclusief:

Bewaar auditlogs op een veilige, onveranderbare locatie, los van uw primaire database. Cloudproviders bieden beheerde loggingdiensten (zoals AWS CloudTrail, Google Cloud Logging of Azure Monitor) die deze functionaliteit bieden. Bewaar auditlogs minstens één jaar, langer voor zeer gevoelige data.

Implementeer realtime monitoring die verdachte patronen in database-toegang detecteert. Stel waarschuwingen in voor:

Moderne database monitoringtools kunnen queries fingerprinten en automatisch afwijkingen detecteren. Tools zoals Imperva, Satori en anderen bieden AI-gedreven dreigingsdetectie die normale toegangspatronen leert en afwijkt op afwijkingen.

Ontwikkel een incident response-plan specifiek voor databasebeveiligingsincidenten met AI-systemen. Dit plan moet bevatten:

Voor organisaties met grote, diverse datasets kan segmentatie van data de blootstelling verkleinen. Dit kan op verschillende manieren:

Netwerksegmentatie: Plaats uw database op een apart netwerksegment met beperkte toegang. Alleen de API-gateway mag direct verbinding maken met de database. AI-platforms hebben alleen via de API-gateway toegang.

Databasesegmentatie: Als uw database zowel gevoelige als niet-gevoelige data bevat, overweeg dan aparte databases. Heeft een AI-systeem alleen niet-gevoelige data nodig, dan krijgt het alleen toegang tot die database.

Datasharding: Voor zeer grote datasets splitst u de data in kleinere stukken (shards) op basis van een criterium (zoals klant-ID of regio). Geef AI-systemen alleen toegang tot de shards die ze nodig hebben.

Synthetische data: Gebruik voor ontwikkeling en testen synthetische data die de structuur van echte data nabootst, maar geen gevoelige informatie bevat. AI-systemen kunnen hiermee worden getraind en getest zonder echte data bloot te stellen.

Het blootstellen van uw database aan AI-platforms heeft grote compliance-implicaties. Verschillende regels stellen verschillende eisen:

GDPR (Algemene Verordening Gegevensbescherming): Als u persoonsgegevens van EU-burgers verwerkt, geldt de GDPR. Belangrijke vereisten:

CCPA (California Consumer Privacy Act): Als u persoonsgegevens van Californische inwoners verwerkt, geldt de CCPA. Belangrijke vereisten:

HIPAA (Health Insurance Portability and Accountability Act): Als u werkt met beschermde gezondheidsinformatie, geldt HIPAA. Belangrijke vereisten:

Branche-specifieke standaarden: Afhankelijk van uw sector kunnen extra standaarden gelden:

Voordat u data blootstelt aan AI-platforms, voert u een compliance-assessment uit om te bepalen welke regels op uw data van toepassing zijn en welke eisen ze stellen.

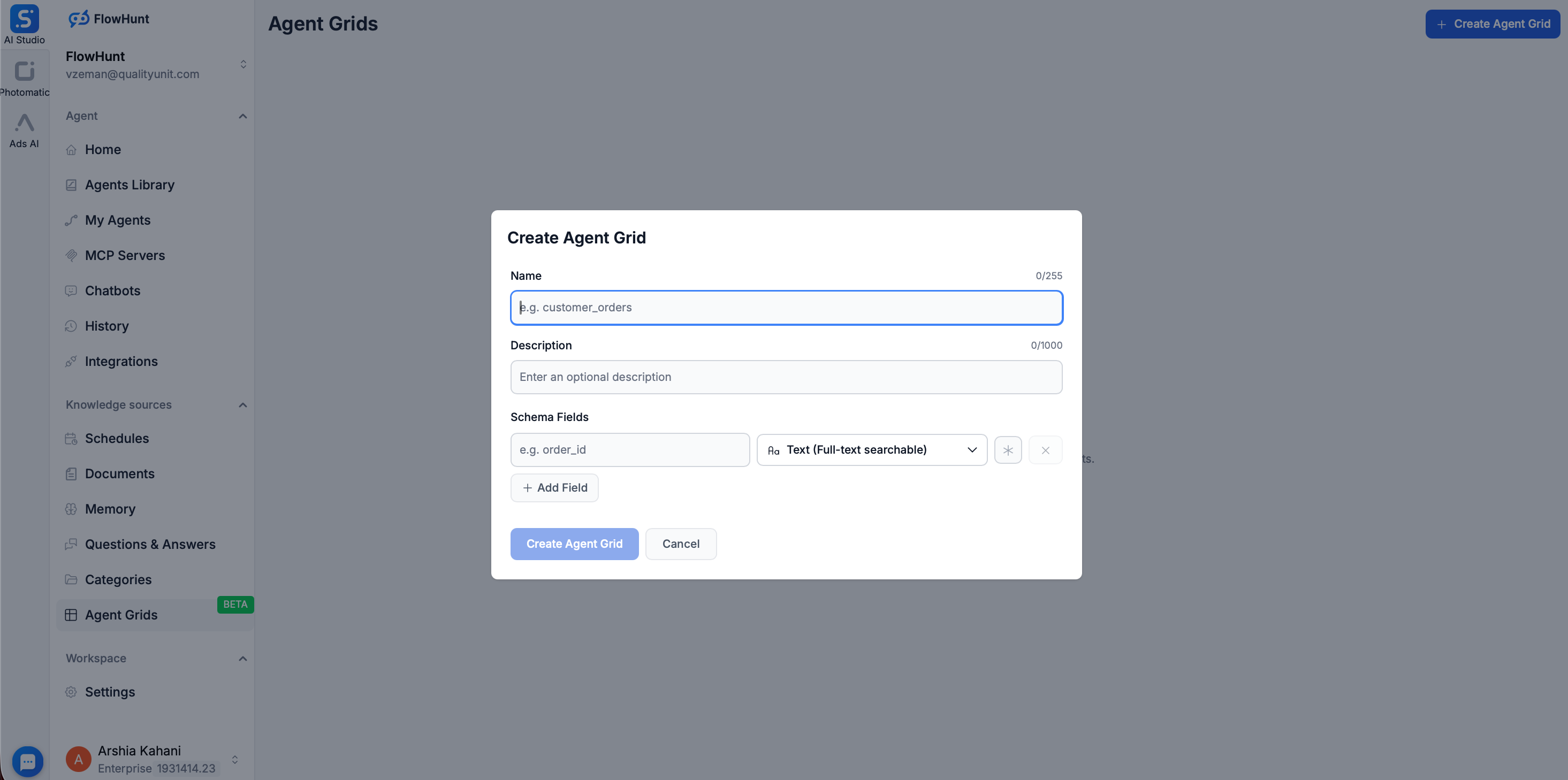

Het beheren van veilige database-toegang tot AI-platforms vereist coördinatie van meerdere systemen en het afdwingen van consistente regels in de hele organisatie. Hier zijn workflow-automatiseringsplatformen als FlowHunt van onschatbare waarde.

Met FlowHunt bouwt u geautomatiseerde workflows die AI-systemen veilig integreren met uw database-infrastructuur. In plaats van handmatig API-sleutels te beheren, toegang te monitoren en teams te coördineren, biedt FlowHunt een uniform platform voor:

Workfloworkestratie: Definieer complexe workflows met databasequeries, AI-verwerking en datatransformatie. FlowHunt orkestreert dit veilig en in de juiste volgorde.

Toegangscontrole-integratie: FlowHunt integreert met uw identity & access management-systemen en dwingt automatisch RBAC- en least-privilege-principes af voor alle AI-workflows.

Audit en compliance: FlowHunt houdt uitgebreide auditlogs bij van alle workflow-uitvoeringen, inclusief wie welke data wanneer heeft benaderd. Deze logs ondersteunen compliance met GDPR, CCPA, HIPAA en andere regelgeving.

Voor organisaties die een extra isolatielaag zoeken tussen hun AI-modellen en productiedatabases, biedt FlowHunt de Grid-functie. Met de Grid kunt u eenvoudig een doorzoekbare database creëren door gestructureerde bestanden, zoals CSV’s, te uploaden.

Zodra een CSV is geüpload naar de Grid, gebruikt FlowHunt Elasticsearch om de data te indexeren, waardoor een statisch bestand verandert in een dynamische, razendsnelle Knowledge Source. Dit biedt aanzienlijke beveiligingsvoordelen:

Met FlowHunts Grid en workflowmogelijkheden vermindert u de complexiteit van beveiligingsbeheer en zorgt u voor consistente handhaving van beleid in uw organisatie.

Beveiligde databaseblootstelling aan AI-platforms vraagt om een meerstapsproces. Hier is een praktisch stappenplan:

Stap 1: Bepaal uw huidige situatie

Stap 2: Ontwerp uw architectuur

Stap 3: Implementeer kernmaatregelen

Stap 4: Implementeer databescherming

Stap 5: Monitoring en auditing

Stap 6: Test en valideer

Stap 7: Operationaliseren en onderhouden

Let tijdens de implementatie van veilige databaseblootstelling op deze valkuilen:

Directe databaseblootstelling: Stel uw database nooit direct bloot aan internet of AI-platforms zonder API-gateway. Dit is het grootste beveiligingsrisico.

Te brede permissies: AI-systemen te brede rechten geven, schendt het least-privilege-principe. Begin met minimale rechten en breid alleen uit als dat nodig is.

Onvoldoende versleuteling: Alleen versleutelen tijdens transport of alleen in rust laat uw data kwetsbaar. Implementeer versleuteling op beide lagen.

Zwak credentialbeheer: Inloggegevens hardcoden in code, opslaan in versiebeheer of niet tijdig roteren brengt groot risico met zich mee.

Onvoldoende monitoring: Sterke preventieve maatregelen zonder monitoring betekent dat u niet weet of controles worden omzeild.

Compliance negeren: Achteraf pas aan compliance denken is kostbaar. Bouw compliance vanaf het begin in uw architectuur.

Onvoldoende testen: Beveiligingsmaatregelen implementeren zonder grondig te testen betekent dat ze mogelijk niet werken als het erop aankomt.

Naarmate AI-systemen geavanceerder worden, ontstaan nieuwe aanvalsvectoren. Twee belangrijke bedreigingen zijn prompt injection en model extractie.

Prompt Injection: Een aanvaller maakt een prompt die een AI-systeem misleidt om onbedoelde acties uit te voeren. Bijvoorbeeld een prompt die het AI-systeem zijn normale toegangscontroles laat negeren en data laat teruggeven waar het geen toegang toe zou mogen hebben. Verdediging tegen prompt injection:

Model Extractie: Een aanvaller probeert via interactie met een AI-model informatie over de trainingsdata of interne structuur te achterhalen. Verdedigen tegen model extractie:

Uw database veilig blootstellen aan AI-platforms is niet alleen mogelijk—het is steeds noodzakelijker voor organisaties die AI willen benutten en tegelijkertijd hun waardevolste bezit willen beschermen. De sleutel is een gelaagde aanpak: sterke authenticatie en autorisatie, versleuteling, datamasking, uitgebreide monitoring en regelmatige testen.

Begin bij de basis: stel uw database nooit direct bloot, gebruik altijd een API-gateway, implementeer sterke authenticatie en autorisatie en versleutel uw data. Breid uit met datamasking, uitgebreide monitoring en compliance-controls passend bij uw risicoprofiel en regelgeving.

Onthoud dat beveiliging geen eenmalige implementatie is, maar een doorlopend proces. Evalueer regelmatig uw maatregelen, test op kwetsbaarheden, monitor op dreigingen en pas uw aanpak aan bij nieuwe risico’s. Door databasebeveiliging als een continu speerpunt te behandelen in plaats van een afvinklijst, kunt u de waarde van AI veilig ontsluiten en de data en reputatie van uw organisatie beschermen.

Ervaar hoe FlowHunt uw AI-content- en SEO-workflows automatiseert — van research en contentgeneratie tot publicatie en analyse — allemaal op één plek.

Ja, het is veilig wanneer u de juiste beveiligingsmaatregelen implementeert, waaronder API-gateways, versleuteling, op rollen gebaseerde toegangscontrole en uitgebreide monitoring. De sleutel is het gebruik van een beveiligde middlewarelaag in plaats van directe databaseblootstelling.

Gebruik sterke, op rotatie gebaseerde inloggegevens met multi-factor authenticatie (MFA) voor menselijke gebruikers en serviceprincipals. Implementeer OAuth, JWT-tokens of API-sleutels met strikte rate limiting en IP-whitelisting voor AI-agenten.

Implementeer datamasking, kolomniveauversleuteling, op rollen gebaseerde toegangscontrole (RBAC) en scheid productiegegevens van AI-trainingsdata. Gebruik dynamische datamasking om gevoelige velden in queryresultaten te verbergen en onderhoud onveranderbare audittrails.

Afhankelijk van uw gegevenstype moet u rekening houden met GDPR, CCPA, HIPAA en andere relevante regelgeving. Zorg dat u over de juiste dataclassificatie, bewaarbeleid en toestemmingsmechanismen beschikt voordat u persoonlijke of gevoelige gegevens blootstelt.

Arshia is een AI Workflow Engineer bij FlowHunt. Met een achtergrond in computerwetenschappen en een passie voor AI, specialiseert zij zich in het creëren van efficiënte workflows die AI-tools integreren in dagelijkse taken, waardoor productiviteit en creativiteit worden verhoogd.

Stroomlijn uw door AI aangedreven dataworkflows en behoud tegelijkertijd beveiliging en compliance op ondernemingsniveau.

Gegevensvalidatie in AI verwijst naar het proces van het beoordelen en waarborgen van de kwaliteit, nauwkeurigheid en betrouwbaarheid van data die gebruikt word...

Integreer FlowHunt met de Model Context Protocol (MCP) server van GreptimeDB om AI-gestuurde, veilige en gestructureerde toegang tot uw tijdreeksdatabase mogeli...

Integreer FlowHunt met OceanBase via de OceanBase MCP Server om veilige, AI-gedreven database-automatisering, analyses en verkenning mogelijk te maken. Sta AI-a...

Cookie Toestemming

We gebruiken cookies om uw browse-ervaring te verbeteren en ons verkeer te analyseren. See our privacy policy.