Sora 2: AI Videogeneratie voor Contentmakers

Ontdek de baanbrekende mogelijkheden van Sora 2 op het gebied van AI-videogeneratie, van realistische karakterrecreatie tot fysicasimulatie, en ontdek hoe deze ...

Ontdek de baanbrekende mogelijkheden van Sora 2 op het gebied van AI-videogeneratie, van realistische karakterrecreatie tot fysicasimulatie, en ontdek hoe deze technologie contentcreatie en automatisering transformeert.

Sora 2 betekent een enorme sprong voorwaarts in kunstmatige intelligentie voor videogeneratie. De nieuwste versie van OpenAI’s videogeneratiemodel brengt ongekende mogelijkheden naar contentmakers, marketeers en bedrijven die hun videoproductieworkflows willen stroomlijnen. Deze uitgebreide gids verkent de opmerkelijke functies van Sora 2, de praktische toepassingen en de gevolgen voor de toekomst van contentcreatie. Van het opnieuw tot leven brengen van geliefde fictieve personages tot het genereren van realistische menselijke prestaties: Sora 2 toont het transformatieve potentieel van generatieve AI voor visuele mediaproductie. Of je nu geïnteresseerd bent in de technische mogelijkheden, creatieve toepassingen of zakelijke inzet, dit artikel biedt een diepgaande blik op wat Sora 2 tot zo’n revolutionaire technologie maakt.

Kunstmatige intelligentie voor videogeneratie is een van de meest opwindende fronten binnen generatieve AI. In tegenstelling tot traditionele videoproductie, waarbij camera’s, acteurs, belichting en uitgebreide postproductie nodig zijn, creëert AI-videogeneratie video’s direct vanuit tekstomschrijvingen of prompts. De technologie gebruikt deep learning-modellen die zijn getraind op enorme hoeveelheden videodata om de relatie tussen taal en visuele inhoud te begrijpen. Deze modellen leren patronen herkennen in objectbeweging, lichtinval, menselijke gebaren en emoties, en natuurlijke scèneovergangen. Wanneer een gebruiker een tekstprompt invoert, verwerkt het AI-model deze informatie en genereert het beeld voor beeld een video, met consistente karakteruitstraling, bewegingen en omgevingsdetails gedurende de hele sequentie. De onderliggende technologie bestaat uit diffusie- en transformerarchitecturen die zijn aangepast voor videogeneratie. Hierdoor kan het systeem temporele samenhang behouden—zodat objecten en personages natuurlijk en consistent bewegen in plaats van te teleporteren of te flikkeren.

Het belang van AI-videogeneratie reikt veel verder dan louter nieuwigheid. Deze technologie pakt fundamentele uitdagingen aan in contentproductie: tijd, kosten en schaalbaarheid. Traditionele videoproductie kan weken of maanden duren en vereist teams van specialisten zoals regisseurs, cameramensen, editors en VFX-experts. AI-videogeneratie kan vergelijkbare resultaten in minuten produceren, waardoor het toegankelijk wordt voor kleine bedrijven, zelfstandigen en organisaties die voorheen niet konden investeren in professionele videoproductie. De democratisering van videoproductie via AI heeft ingrijpende gevolgen voor marketing, onderwijs, entertainment en bedrijfscommunicatie. Naarmate deze systemen geavanceerder en toegankelijker worden, veranderen ze fundamenteel hoe organisaties omgaan met visuele contentstrategie en productieprocessen.

De zakelijke voordelen van AI-videogeneratie zijn overtuigend en veelzijdig. In het huidige digitale landschap domineert videocontent de engagementstatistieken op alle platformen. Volgens branchegegevens zorgt video voor veel hogere betrokkenheid dan statische beelden of tekst, met platforms als TikTok, YouTube en Instagram die video’s prioriteren in hun algoritmes. Toch was het produceren van hoogwaardige video’s op grote schaal tot nu toe voor de meeste organisaties onbetaalbaar. AI-videogeneratie lost deze beperking op door bedrijven in staat te stellen onbeperkt videovarianten te produceren voor A/B-testen, personalisatie en snelle iteratie. Marketingteams kunnen tientallen productdemonstratievideo’s in verschillende stijlen en formaten genereren zonder opnieuw op te nemen. Onderwijsinstellingen kunnen gepersonaliseerde leercontent op grote schaal creëren. Klantenserviceteams kunnen realtime trainingsvideo’s maken voor nieuwe procedures. Het economische effect is aanzienlijk: bedrijven kunnen de videoproductiekosten met 70-90% verlagen én tegelijkertijd de output exponentieel verhogen.

Naast kostenbesparing maakt AI-videogeneratie nieuwe vormen van creativiteit en experimenteren mogelijk. Contentmakers kunnen gedurfde ideeën testen zonder grote investeringen. Ze kunnen meerdere versies van een concept genereren en kijken wat aanslaat bij het publiek. Ze kunnen content maken in verschillende stijlen, tonen en formaten voor verschillende doelgroepen of platformen. Deze flexibiliteit transformeert video van een schaars, zorgvuldig gepland middel tot een overvloedig, experimenteel medium. De gevolgen voor contentstrategie zijn groot. In plaats van enkele, grootschalige videoproducties per kwartaal te plannen, kunnen organisaties overgaan op een model van doorlopende contentcreatie, waarbij video net zo routinematig wordt als het publiceren van blogs. Dit maakt snellere, persoonlijkere en relevantere content mogelijk die beter aansluit bij de behoeften van het publiek en de bedrijfsdoelstellingen. Bovendien opent AI-videogeneratie de deur naar interactieve en dynamische content die zich aanpast aan individuele kijkers, wat ongekende mogelijkheden biedt voor engagement en conversie.

Sora 2 bouwt voort op eerdere videogeneratiemodellen met aanzienlijke verbeteringen op meerdere fronten. De meest in het oog springende is de sterke toename in visuele kwaliteit en realisme. Door Sora 2 gegenereerde video’s tonen veel betere belichting, natuurlijkere kleurcorrectie, hogere detaillering in texturen en geloofwaardige materiaaleigenschappen. Bij het bekijken van een Sora 2-video benadert de beeldkwaliteit in veel gevallen die van professionele cinematografie. Het model blinkt uit in het weergeven van complexe scènes met meerdere objecten, het behouden van consistente belichting in het hele frame en het creëren van realistische reflecties en schaduwen. Dit kwaliteitsniveau is van cruciaal belang voor professionele toepassingen waar slechte output de geloofwaardigheid en merkperceptie zou schaden.

Fysicasimulatie vormt een ander belangrijk speerpunt in Sora 2. Eerdere videogeneratiemodellen worstelden vaak met fysische consistentie—objecten bewogen onnatuurlijk, zwaartekracht werkte inconsistent of botsingen werden niet goed weergegeven. Sora 2 toont een veel beter begrip van natuurwetten en hoe objecten interacteren met hun omgeving. Als een bal wordt gegooid, volgt deze een realistisch traject. Als iemand loopt, is het gewicht en de beweging natuurlijk. Als objecten botsen, ziet de interactie er fysiek plausibel uit. Deze verbetering is vooral belangrijk voor toepassingen waar fysica nauw luistert, zoals productdemonstraties, educatie of entertainment waarbij kijkers onrealistische fysica direct zouden opmerken. Door het verbeterde fysicabewustzijn zijn dynamischere scènes mogelijk die eerder onmogelijk waren.

Temporele consistentie en samenhang zijn essentieel om Sora 2-video’s als echte opnamen te laten aanvoelen in plaats van losse, onsamenhangende beelden. Het model behoudt karakteridentiteit gedurende de video’s, zodat mensen er van begin tot eind hetzelfde uitzien en niet van uiterlijk veranderen. Omgevingsdetails blijven consistent—als er aan het begin van een video een plant op de achtergrond staat, blijft die daar gedurende de hele scène. Deze consistentie is essentieel voor professionele toepassingen en zorgt voor een natuurlijke, meeslepende kijkervaring. Het model begrijpt acties en bewegingen beter, waardoor soepele en natuurlijke overgangen ontstaan in plaats van schokkerige of onrealistische houdingen.

Een van de meest opvallende functies van Sora 2 is het nauwkeurig kunnen nabootsen van menselijke gezichten en gelijkenissen via gezichtsherkenning. Gebruikers die een gezichtsherkenning uitvoeren, melden dat het model ongeveer 90% nauwkeurig is in het repliceren van gelaatstrekken, expressies en subtiele details als huidtextuur en lichtreflecties. Deze nauwkeurigheid is werkelijk opmerkelijk en opent mogelijkheden die eerder tot sciencefiction behoorden. Wanneer je een door Sora 2 gegenereerde video van jezelf bekijkt, is de ervaring bijna onwerkelijk—het is duidelijk jij, maar in situaties en handelingen die je nooit eerder hebt gedaan. Het model vangt niet alleen statische trekken, maar ook hoe je gezicht beweegt en emoties uitdrukt. De belichting op je gezicht is realistisch, reflecties zijn zichtbaar in je ogen en details als huidtextuur en haarbeweging worden overtuigend weergegeven.

De implicaties van deze technologie zijn zowel spannend als zorgwekkend. Positief is dat makers nu content met zichzelf kunnen genereren zonder fysiek aanwezig te zijn bij de opname. Een YouTuber kan tientallen video’s van zichzelf genereren zonder elke keer op te nemen. Een docent kan gepersonaliseerde lesvideo’s maken met zichzelf als instructeur. Een bedrijf kan trainingsvideo’s of aankondigingen genereren zonder opnamesessies te plannen. Dit levert aanzienlijke tijd- en kostenbesparing op. Maar deze mogelijkheid roept ook vragen op rond toestemming, authenticiteit en mogelijk misbruik. In theorie kan de technologie worden gebruikt om deepfakes of misleidende content te maken met echte mensen zonder hun toestemming. OpenAI heeft waarborgen ingebouwd, zoals de mogelijkheid voor gebruikers om te bepalen of hun gelijkenis door anderen mag worden gebruikt, maar het risico op misbruik blijft een belangrijk aandachtspunt dat beleidsmatig moet worden geadresseerd.

Sora 2 maakt creatieve toepassingen mogelijk die voorheen onmogelijk of onbetaalbaar waren. Eén van de meest vermakelijke toepassingen is het nabootsen van geliefde fictieve personages in nieuwe scenario’s. Gebruikers hebben met succes video’s gegenereerd van SpongeBob SquarePants die drillrap uitvoert, compleet met accuraat karakterontwerp, animatiestijl en spraaksynthese. Het model weet de kenmerkende stijl van het personage te vangen en consistent te houden gedurende de hele video. Op vergelijkbare wijze zijn klassieke videogamescènes gerecreëerd, zoals de iconische Halo-game, inclusief de visuele stijl, UI-elementen en vertellerstem. Deze toepassingen laten zien dat Sora 2 in staat is specifieke visuele stijlen, karakterontwerp en esthetische conventies te herkennen en te repliceren.

De entertainmentmogelijkheden strekken zich uit tot het creëren van geheel nieuwe content in de stijl van bestaande franchises. Gebruikers hebben volledige SpongeBob-afleveringen gegenereerd door meerdere Sora 2-clips te combineren tot een samenhangend verhaal, met behoud van karakterconsistentie en visuele stijl. Dit wijst op toekomstige mogelijkheden waarin AI animatieproductie kan ondersteunen, bijvoorbeeld door het genereren van belangrijke scènes of varianten die vervolgens door menselijke animatoren worden verfijnd. De technologie kan animatieproductie democratiseren, zodat onafhankelijke makers animaties kunnen produceren zonder een heel team van animatoren. Ook videogamerecreatie is een boeiend domein: personages zijn geplaatst in Minecraft-omgevingen of klassieke games als Mario Kart zijn fotorealistisch nagebootst. Dit toont de flexibiliteit van het model en het vermogen zich aan te passen aan verschillende stijlen en contexten.

Hoewel Sora 2 een grote vooruitgang betekent, is het belangrijk de huidige beperkingen te begrijpen. Tests laten zien dat gezichtsherkenning meestal accuraat is, maar dat het model soms moeite heeft met consistentie. Bij het herhaaldelijk genereren van video’s met dezelfde prompt kan de output flink variëren. Soms is het gezicht vrijwel perfect, andere keren zijn er subtiele vervormingen of inconsistenties in de gelaatstrekken. Dit wijst erop dat de outputkwaliteit van het model nog niet helemaal deterministisch is en gebruikers soms meerdere pogingen moeten doen om een goed resultaat te krijgen. Vooral in randgevallen of complexe situaties is deze variatie merkbaar.

Handbewegingen en manipulaties zijn een opvallende beperking in de huidige Sora 2-video’s. Bij video’s met gedetailleerde handbewegingen of objectmanipulatie zijn de resultaten vaak niet overtuigend. Handen kunnen vervormd zijn, vingers bewegen onnatuurlijk of objecten worden niet realistisch vastgehouden. Dit is vooral zichtbaar bij activiteiten die fijne motoriek vereisen, zoals muziek maken, opereren of precieze handelingen uitvoeren. Deze beperking weerspiegelt een bredere uitdaging binnen AI-videogeneratie: het begrijpen en nabootsen van de complexe biomechanica van menselijke beweging, in het bijzonder van handen en vingers. Het verbeteren hiervan is een actief onderzoeksgebied.

Fysicafouten komen soms nog voor in Sora 2-video’s, vooral bij complexe scènes met meerdere objecten of krachten. In sommige video’s rijden auto’s achteruit als ze vooruit zouden moeten gaan, zweven objecten of worden botsingen niet correct weergegeven. Deze fouten komen minder vaak voor dan bij eerdere modellen, maar zijn nog steeds zichtbaar, vooral bij prompts met complexe fysieke interacties waar het model weinig trainingsdata over heeft. Ook spraaksynthese behoeft soms verbetering, met gegenereerde stemmen die onnatuurlijk klinken of digitale artefacten vertonen. De kwaliteit hiervan varieert per stem en de complexiteit van de tekst.

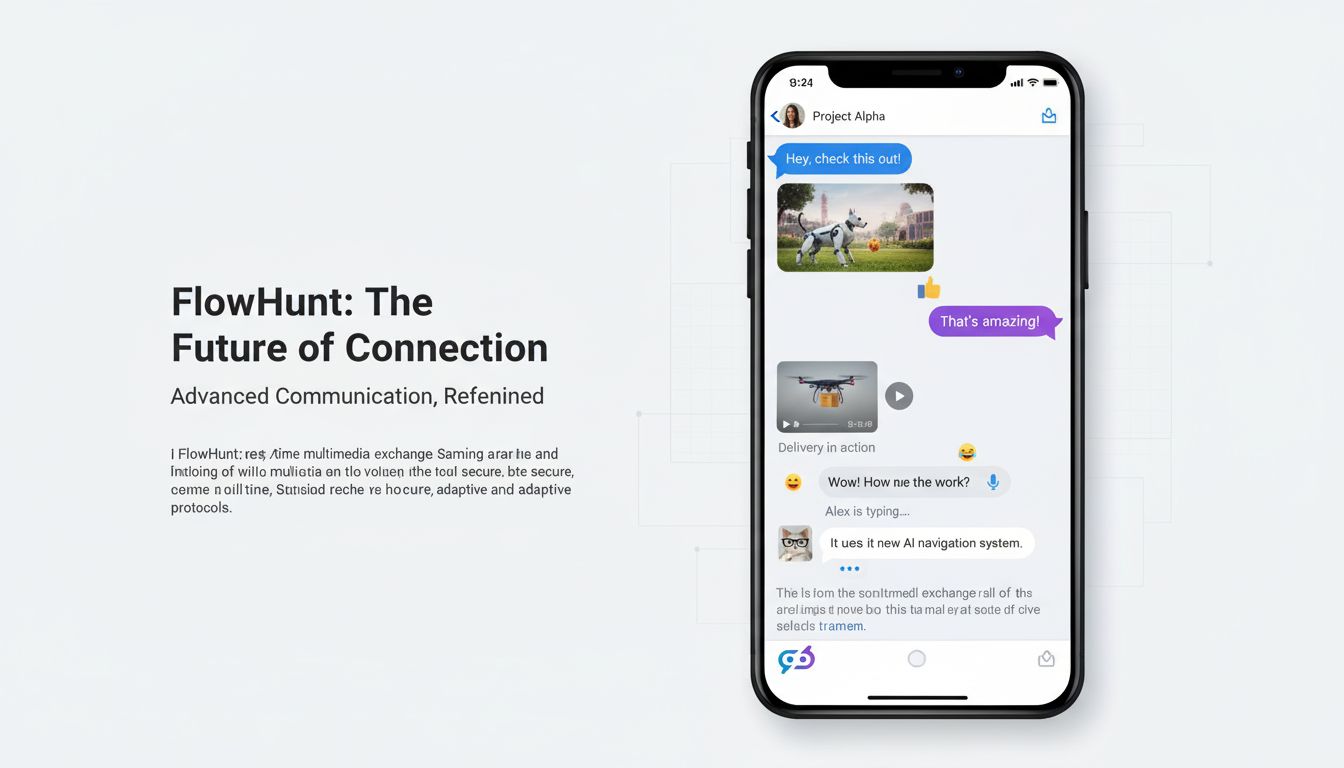

FlowHunt ziet het transformerende potentieel van AI-videogeneratie en integreert deze mogelijkheden in zijn automatiseringsplatform om bedrijven te helpen hun contentcreatieprocessen te stroomlijnen. In plaats van videogeneratie als losstaande tool te behandelen, positioneert FlowHunt AI-videogeneratie als onderdeel van een compleet contentautomatiserings-ecosysteem. Hierdoor kunnen bedrijven end-to-end workflows creëren die videogeneratie combineren met andere vormen van contentcreatie, distributie en analyse. Zo kan een marketingteam een workflow opzetten die productvideo’s genereert, automatisch ondertiteling en branding toevoegt, publiceert op meerdere platformen en de engagement meet—alles zonder handmatige tussenkomst.

De integratie van Sora 2 en vergelijkbare modellen in FlowHunt’s platform maakt krachtige automatiseringsscenario’s mogelijk. Contentteams kunnen terugkerende videoproductietaken instellen die automatisch nieuwe content genereren. E-commercebedrijven kunnen productvideo’s genereren voor nieuw assortiment. Marketingteams kunnen gepersonaliseerde videovariaties maken voor verschillende doelgroepen. Onderwijsinstellingen kunnen op aanvraag trainingscontent creëren. Klantenserviceafdelingen kunnen instructievideo’s maken voor veelvoorkomende vragen. Door videogeneratie te combineren met FlowHunt’s workflowautomatisering bereiken organisaties ongekende schaal en efficiëntie in videoproductie. Het platform regelt de orkestratie, planning en integratie met andere systemen, zodat teams zich kunnen richten op strategie en creativiteit in plaats van handmatige taken.

De praktische toepassingen van Sora 2 beslaan vrijwel elke sector en bedrijfsfunctie. In marketing en reclame maakt Sora 2 het mogelijk productvideo’s, testimonials en promotiemateriaal op schaal te creëren. Merken kunnen meerdere varianten van advertenties genereren om verschillende boodschappen, stijlen en call-to-actions te testen. E-commercebedrijven kunnen productvideo’s maken voor duizenden artikelen zonder afzonderlijke opnamesessies. Makelaars kunnen virtuele rondleidingen maken. Reisorganisaties kunnen bestemmingsvideo’s creëren. De kostenbesparing en snelheid zijn revolutionair voor marketingafdelingen die eerder worstelden met productiebottlenecks.

In educatie en training maakt Sora 2 gepersonaliseerde lescontent, instructievideo’s en trainingsmateriaal mogelijk. Onderwijsinstellingen kunnen video’s genereren met docenten in verschillende scenario’s, uitleggen op diverse manieren of procedures demonstreren. Corporate trainingsafdelingen kunnen onboardingvideo’s, veiligheidsinstructies en ontwikkelingsmateriaal maken. Dankzij on-demand contentgeneratie kunnen trainingsmaterialen snel worden bijgewerkt als procedures veranderen of nieuwe informatie beschikbaar komt. Personalisatie wordt mogelijk op grote schaal—verschillende leerlingen kunnen video’s ontvangen die aansluiten bij hun leerstijl, tempo en voorkennis.

In entertainment en mediaproductie opent Sora 2 mogelijkheden voor animatie, visuele effecten en contentcreatie die voorheen werden beperkt door budgetten en tijd. Onafhankelijke makers kunnen animaties produceren zonder een team van animatoren. Film- en televisieproducties kunnen AI-generatie inzetten voor VFX, achtergrondbeelden of zelfs complete scènes. Muziekvideo’s kunnen worden gegenereerd bij nummers. Streamingdiensten kunnen efficiënter originele content maken. De technologie democratiseert entertainmentproductie, waardoor makers met een klein budget professionele content kunnen produceren.

In bedrijfscommunicatie en interne processen maakt Sora 2 het mogelijk om directieboodschappen, bedrijfsmededelingen, trainingsvideo’s en interne documentatie te genereren. Bestuurders kunnen gepersonaliseerde berichten aan medewerkers maken zonder opnamesessies. HR kan trainingsmateriaal voor nieuwe procedures maken. IT kan instructievideo’s genereren voor softwaresystemen. Door snel en kostenefficiënt content te genereren, kunnen organisaties vaker en effectiever communiceren met medewerkers en stakeholders.

Het huidige landschap van AI-videogeneratie wordt vaak omschreven als het “copyright wilde westen”. Sora 2 kan video’s genereren met auteursrechtelijk beschermde personages, beroemdheden en intellectueel eigendom zonder expliciete toestemming van rechthebbenden. Gebruikers kunnen video’s maken van SpongeBob, Mario, Zelda en andere beschermde karakters. Ze kunnen video’s maken met beroemdheden en publieke figuren. Dit roept belangrijke juridische en ethische vragen op over intellectueel eigendom, toestemming en het juiste gebruik van AI-gegenereerde content. De nauwkeurigheid waarmee gelijkenissen en personages worden gerecreëerd, vergroot het risico op misbruik aanzienlijk.

OpenAI heeft enkele waarborgen ingebouwd, zoals de mogelijkheid voor gebruikers om in te stellen of hun gelijkenis mag worden gebruikt door anderen via cameo-instellingen. Toch zijn deze waarborgen beperkt en lossen ze niet de bredere vraag op of AI-systemen content mogen genereren met beschermde personages of beroemdheden zonder toestemming. Het juridische landschap is nog in beweging, met rechters en toezichthouders die worstelen met vragen over fair use, auteursrechtschending en de grenzen van AI-content. Sommigen stellen dat content met beschermde personages voor persoonlijk gebruik onder fair use valt, anderen vinden dat elk commercieel gebruik toestemming vereist. Verschillende rechtsgebieden hanteren verschillende wetten en interpretaties rondom auteursrecht.

De ethische kant gaat verder dan copyright en raakt aan authenticiteit, toestemming en mogelijk misbruik. Kijkers die een video van een beroemdheid zien, kunnen aannemen dat die authentiek is, tenzij expliciet anders vermeld. Dit maakt misleiding en desinformatie mogelijk. De technologie kan worden ingezet voor deepfakes die reputaties schaden of valse informatie verspreiden. Hoewel Sora 2 met zijn huidige beperkingen het nog moeilijk maakt volkomen overtuigende deepfakes te maken, ontwikkelt de technologie zich snel. De samenleving zal normen, regelgeving en technische waarborgen moeten ontwikkelen om misbruik te voorkomen en tegelijkertijd de legitieme voordelen te behouden.

De verbeteringen van Sora 2 ten opzichte van eerdere modellen zijn het resultaat van vooruitgang op meerdere technische gebieden. Het model gebruikt verbeterde op diffusie gebaseerde architecturen die de relatie tussen tekstomschrijvingen en visuele content beter begrijpen. Het trainingsproces bevat meer diverse en kwalitatief hoogwaardige videodata, waardoor het model fijnere patronen leert over hoe de wereld werkt. Het begrip van fysica, belichting en materiaaleigenschappen is versterkt door betere trainingsdata en verbeterde verliesfuncties die fysiek onrealistische output bestraffen. De temporele samenhang is verbeterd door mechanismen die de toestand over frames heen beter bewaren en aandachtmechanismen die het model helpen lange-afstandsverbanden in videosequenties te herkennen.

De gezichtsherkenning en karakterrecreatie zijn gebaseerd op gespecialiseerde componenten die gelaatstrekken en identiteit kunnen coderen en deze informatie behouden tijdens videogeneratie. Deze componenten gebruiken waarschijnlijk vergelijkbare technieken als gezichtsherkenningssystemen, maar aangepast aan videogeneratie. Het model leert identiteit te koppelen aan specifieke visuele patronen en houdt deze koppeling vast tijdens het genereren. De verbeteringen in spraaksynthese zijn te danken aan betere tekst-naar-spraakmodellen en een betere integratie tussen video- en audiogeneratie. Hierdoor wordt audio gegenereerd die beter past bij de lipbewegingen en expressies in de video, wat tot overtuigender resultaat leidt.

Hoewel Sora 2 een grote vooruitgang betekent, is het belangrijk te vergelijken met andere modellen op de markt. Andere modellen als Runway, Synthesia en diverse open source-alternatieven hebben hun eigen sterke en zwakke punten. Runway richt zich bijvoorbeeld op toegankelijke tools voor makers en heeft een sterke community. Synthesia specialiseert zich in avataar-gebaseerde video’s voor bedrijfscommunicatie. Open source modellen zoals Stable Video Diffusion bieden flexibiliteit en maatwerk voor ontwikkelaars. Sora 2 onderscheidt zich door superieure visuele kwaliteit, betere fysicasimulatie en nauwkeuriger karakterrecreatie. De mogelijkheid om langere video’s en complexere scènes te genereren geeft vaak een voorsprong.

Tegelijk heeft Sora 2 ook beperkingen ten opzichte van sommige alternatieven. Sommige modellen bieden betere realtime generatie of lagere rekeneisen. Sommige geven meer gedetailleerde controle over specifieke aspecten van de video. Sommige hebben betere integratie met bepaalde platformen of workflows. De keuze hangt af van de eisen, het gebruik en de context. Voor maximale visuele kwaliteit en realisme is Sora 2 waarschijnlijk de beste keuze. Voor realtime generatie of maatwerk kunnen andere modellen geschikter zijn. Naarmate het veld zich verder ontwikkelt, zullen alle modellen blijven verbeteren en zullen er nieuwe gespecialiseerde oplossingen ontstaan.

Ervaar hoe FlowHunt je AI-content en videogeneratie automatiseert — van onderzoek en creatie tot publicatie en analyse — allemaal op één plek.

De ontwikkeling van AI-videogeneratie staat pas aan het begin van wat mogelijk is. Toekomstige versies van Sora en concurrenten zullen waarschijnlijk huidige beperkingen op gebied van handbewegingen, fysicasimulatie en consistentie oplossen. We mogen verbeteringen verwachten in videolengte, resolutie en het vermogen om steeds complexere scènes aan te kunnen. De modellen worden efficiënter, met minder rekenkracht nodig voor generatie. Integratie met andere AI-systemen maakt nog geavanceerdere workflows mogelijk, waarin videogeneratie wordt gecombineerd met andere vormen van contentcreatie en -analyse.

De bredere impact op contentcreatie is groot. Naarmate AI-videogeneratie capabeler en toegankelijker wordt, zal video net zo alledaags worden als tekst in digitale communicatie. Organisaties zullen video niet langer zien als schaars en zorgvuldig gepland, maar als een overvloedig en experimenteel medium. Dit maakt snellere, persoonlijkere en meer betrokken content mogelijk. Tegelijk brengt dit uitdagingen rond authenticiteit, misinformatie en de noodzaak voor nieuwe normen en regels rondom AI-content. De technologie zal creatieve sectoren grondig veranderen, mogelijk banen verdringen, maar ook nieuwe kansen bieden voor wie AI-creatie kan aansturen en cureren.

Voor organisaties die Sora 2 willen inzetten voor contentcreatie zijn er enkele best practices om maximaal resultaat te halen. Ten eerste: begrijp de sterke en zwakke punten van het model. Sora 2 blinkt uit in realistische scènes met goede belichting en fysica, maar heeft moeite met complexe handbewegingen en levert soms inconsistente resultaten. Ontwerp prompts die aansluiten op deze sterke punten. Ten tweede: genereer meerdere variaties van dezelfde prompt en kies de beste resultaten. Omdat de output varieert, levert het herhaaldelijk uitvoeren van dezelfde prompt vaak betere resultaten op dan het eerste resultaat te accepteren. Ten derde: gebruik gezichtsherkenning voor karakterrecreatie waar nauwkeurigheid belangrijk is. De gezichtsherkenning verbetert de nauwkeurigheid aanzienlijk ten opzichte van alleen tekstomschrijvingen.

Ten vierde: splits complexe video’s op in meerdere clips en verbind deze, in plaats van alles in één keer te genereren. Dit geeft meer controle en vaak betere resultaten dan alles tegelijk proberen te maken. Ten vijfde: geef gedetailleerde, specifieke prompts die niet alleen beschrijven wat er moet gebeuren, maar ook de visuele stijl, belichting en sfeer. Vage prompts leiden tot matige resultaten; gedetailleerde prompts met visuele details, camerahoeken en esthetische voorkeuren geven veel betere resultaten. Ten zesde: integreer videogeneratie in bredere contentworkflows met tools als FlowHunt die het hele proces van generatie tot publicatie en analyse kunnen automatiseren. Zo maximaliseer je efficiëntie en kun je videoproductie opschalen tot ongekende niveaus.

Naarmate AI-videogeneratie meer voorkomt, zijn zorgen over authenticiteit, misinformatie en baanverlies legitiem en verdienen ze aandacht. Organisaties die AI-content gebruiken, moeten hier transparant over zijn, zeker waar kijkers kunnen aannemen dat de content authentiek is. Vermelden dat content door AI is gemaakt, bouwt vertrouwen en helpt het publiek begrijpen wat ze zien. Dit is vooral belangrijk bij content die invloed kan hebben op belangrijke keuzes of overtuigingen. In gereguleerde sectoren als zorg, financiën of juridische dienstverlening kunnen zelfs specifieke eisen gelden voor de vermelding van AI-content.

Het risico op misbruik via deepfakes en desinformatie is reëel en vraagt om proactieve maatregelen. Technische waarborgen zoals het watermerken van AI-content kunnen helpen synthetische media te herkennen. Beleid en regelgeving zullen zich verder ontwikkelen om misbruik tegen te gaan. Mediawijsheid helpt het publiek te begrijpen hoe AI-content werkt en kritisch te kijken naar authenticiteit. Organisaties kunnen interne richtlijnen opstellen voor het juiste gebruik van AI-videogeneratie en zich committeren aan verantwoord gebruik. Het doel moet zijn om de legitieme voordelen van AI-videogeneratie te benutten, misbruik te voorkomen en het vertrouwen in media te behouden.

Sora 2 betekent een mijlpaal in AI-videogeneratie en biedt mogelijkheden die eerder tot sciencefiction behoorden. Het vermogen om realistische, fysiek plausibele video’s te genereren met accurate karakterrecreatie opent ongekende kansen voor contentmakers, marketeers, opleiders en bedrijven in elke sector. Hoewel er nog beperkingen zijn op het gebied van handbewegingen, fysieke consistentie en outputvariatie, is de verbeteringslijn duidelijk. De technologie zal blijven verbeteren, capabeler, efficiënter en toegankelijker worden. Organisaties die Sora 2’s mogelijkheden en beperkingen begrijpen en het integreren in hun workflows, zullen een duidelijk concurrentievoordeel behalen: lagere productiekosten, hogere output en de mogelijkheid om grootschalig te experimenteren met content. Maar deze kracht brengt verantwoordelijkheid met zich mee—het risico op misbruik vraagt om doordachte ethische afwegingen, transparante communicatie over AI-content en proactieve maatregelen om schade te voorkomen. Terwijl Sora 2 en soortgelijke technologieën de wereld van contentcreatie hervormen, zullen de organisaties die slagen degenen zijn die de kracht van de technologie benutten met behoud van authenticiteit, transparantie en ethiek.

Sora 2 is het nieuwste videogeneratiemodel van OpenAI dat realistische, fysiek nauwkeurige video’s creëert op basis van tekstprompts. Het verbetert eerdere systemen met betere fysicasimulatie, hogere outputkwaliteit, langere video’s en geavanceerdere creatieve controle voor gebruikers.

Ja, Sora 2 kan met hoge nauwkeurigheid het uiterlijk van echte mensen recreëren via gezichtsherkenningstechnologie. Gebruikers melden dat het model ongeveer 90% nauwkeurigheid behaalt bij het repliceren van gelaatstrekken, gezichtsuitdrukkingen en zelfs achtergrondkenmerken, mits er goede referentiegegevens zijn aangeleverd.

Hoewel indrukwekkend, heeft Sora 2 nog steeds beperkingen zoals incidenteel vervormen tussen meerdere personen, inconsistente handbewegingen, fysische fouten in complexe scènes en variabele uitvoerkwaliteit bij herhaling van dezelfde prompt. Ook spraaksynthese vereist in sommige gevallen nog verdere verfijning.

Bedrijven kunnen Sora 2 gebruiken voor het maken van marketingvideo’s, productdemonstraties, trainingscontent, socialmediaclips en entertainment. De technologie kan de productietijd en -kosten aanzienlijk verlagen door videoproductie op basis van tekst te automatiseren, wat waardevol is voor de marketing-, opleidings- en entertainmentsector.

Arshia is een AI Workflow Engineer bij FlowHunt. Met een achtergrond in computerwetenschappen en een passie voor AI, specialiseert zij zich in het creëren van efficiënte workflows die AI-tools integreren in dagelijkse taken, waardoor productiviteit en creativiteit worden verhoogd.

Integreer AI-videogeneratie in je contentpipeline en stroomlijn de productie van concept tot publicatie.

Ontdek de baanbrekende mogelijkheden van Sora 2 op het gebied van AI-videogeneratie, van realistische karakterrecreatie tot fysicasimulatie, en ontdek hoe deze ...

Ontdek alles wat je moet weten over de Sora-2 app—haar mogelijkheden, toepassingen en hoe deze zich verhoudt tot toonaangevende AI-videogenerators. Leer hoe je ...

Integreer FlowHunt met Creatify MCP Server om AI-avatarvideogeneratie te automatiseren, videowerkstromen te stroomlijnen en contentcreatie te verbeteren met beh...

Cookie Toestemming

We gebruiken cookies om uw browse-ervaring te verbeteren en ons verkeer te analyseren. See our privacy policy.