Ongestructureerde data

Ontdek wat ongestructureerde data is en hoe het zich verhoudt tot gestructureerde data. Leer over de uitdagingen en tools die worden gebruikt voor ongestructure...

Ontdek hoe integratie en governance van ongestructureerde data bedrijfsdata transformeren tot AI-klare datasets, die nauwkeurige RAG-systemen en intelligente agenten op schaal aandrijven.

Het succes van moderne AI-agenten hangt af van een cruciale, maar vaak over het hoofd geziene factor: de kwaliteit en toegankelijkheid van de data die ze aandrijven. Terwijl organisaties zwaar investeren in geavanceerde taalmodellen en complexe algoritmen, ligt de echte bottleneck in de manier waarop ze bedrijfsdata verwerken. Meer dan 90% van alle bedrijfsdata bestaat uit ongestructureerde formaten—contracten, PDF’s, e-mails, transcripties, afbeeldingen, audio en video—maar minder dan 1% van deze data vindt daadwerkelijk zijn weg naar generatieve AI-projecten. Dit is zowel een enorme uitdaging als een buitengewone kans. Het verschil tussen AI-systemen die hallucineren en onnauwkeurige antwoorden geven versus systemen die betrouwbare, contextbewuste antwoorden leveren, komt vaak neer op hoe goed organisaties hun ongestructureerde data kunnen integreren, beheren en benutten. In deze uitgebreide gids verkennen we hoe integratie en governance van ongestructureerde data samenwerken om de goudmijn van bedrijfsdata te ontsluiten. Zo kunnen organisaties AI-agenten en retrieval-augmented generation (RAG)-systemen bouwen die niet alleen intelligent, maar ook betrouwbaar en compliant zijn.

Het fundamentele probleem waar bedrijven vandaag de dag voor staan, is dat het grootste deel van hun waardevolle data bestaat in formaten die traditionele systemen nooit aankonden. In tegenstelling tot gestructureerde data in databases—waar informatie netjes in rijen en kolommen is georganiseerd—ligt ongestructureerde data verspreid over meerdere systemen, is inconsistent van formaat en bevat vaak gevoelige informatie. Een contract kan bijvoorbeeld persoonsgegevens (PII) bevatten, vermengd met belangrijke zakelijke voorwaarden. Een e-mailthread kan belangrijke beslissingen bevatten, begraven in informele conversatie. Transcripties van klantenservicegesprekken kunnen sentiment en tevredenheidsniveaus onthullen die verborgen zijn in natuurlijke taal. Deze diversiteit en complexiteit maken ongestructureerde data tegelijkertijd het meest waardevolle én het moeilijkste bezit voor bedrijven om te benutten. Wanneer data-engineeringteams proberen deze content handmatig te verwerken, kost dat wekenlang monnikenwerk: het doorspitten van uiteenlopende documenten, identificeren en verwijderen van gevoelige details, en het aan elkaar knopen van maatwerkscripts om data geschikt te maken voor AI-systemen. Deze handmatige aanpak is niet alleen tijdrovend, maar ook foutgevoelig, waardoor knelpunten ontstaan die organisaties belemmeren hun AI-initiatieven op te schalen. De uitdaging wordt nog groter door compliance-eisen—organisaties moeten ervoor zorgen dat gevoelige informatie correct wordt behandeld, dat herkomst wordt gevolgd voor auditdoeleinden en dat gebruikers en AI-agenten alleen toegang hebben tot informatie waarvoor ze bevoegd zijn.

De meeste organisaties denken dat AI-agenten falen door zwakke onderliggende modellen of onvoldoende rekenkracht. In werkelijkheid is de belangrijkste boosdoener een tekortschietende datainfrastructuur. Een geavanceerd taalmodel is slechts zo goed als de informatie waar het toegang toe heeft. Wanneer een AI-agent geen toegang heeft tot hoogwaardige, goed georganiseerde bedrijfsdata, moet deze vertrouwen op algemene kennis uit het trainingsmateriaal of, erger nog, zelf gokjes wagen die vaak tot hallucinaties leiden. Publieke data—informatie van het internet—is al opgenomen in foundation models, dus het echte concurrentievoordeel voor bedrijven zit in het ontsluiten en benutten van eigen, domeinspecifieke data. Stel een AI-agent voor klantenservice moet vragen beantwoorden over bedrijfsbeleid, productspecificaties of klantgeschiedenis. Zonder toegang tot goed geïntegreerde en beheerde interne documenten, kan de agent geen accurate, contextuele antwoorden geven. Het kan dan aannemelijk klinkende maar foutieve informatie genereren, wat het vertrouwen van klanten en de reputatie van het merk schaadt. Evenzo heeft een AI-systeem dat compliance-risico’s in contracten moet identificeren of operationele patronen in veldrapporten moet analyseren, toegang nodig tot schone, goed georganiseerde, en correct geclassificeerde data. Het verschil tussen data hebben en bruikbare data hebben is waar de meeste bedrijven struikelen. Hier worden integratie en governance van ongestructureerde data niet zomaar leuke extra’s, maar essentiële onderdelen van elke serieuze AI-strategie.

Vector databases vormen een fundamentele verschuiving in de manier waarop organisaties informatie opslaan en ophalen voor AI-toepassingen. In tegenstelling tot traditionele databases die vertrouwen op exacte trefwoordovereenkomst, werken vector databases met embeddings—hoog-dimensionale numerieke representaties van tekst, afbeeldingen of andere content die semantische betekenis vastleggen. Wanneer een document wordt omgezet naar een embedding, wordt het een punt in een multi-dimensionale ruimte waar vergelijkbare documenten bij elkaar clusteren. Dit maakt semantisch zoeken mogelijk: informatie vinden op basis van betekenis in plaats van exacte trefwoorden. Zo kan een zoekopdracht naar “werknemersvoordelen” documenten opleveren over “beloningspakketten” of “zorgverzekeringen”, omdat deze concepten semantisch verwant zijn, ook al komen de trefwoorden niet overeen. Vector databases vormen de motor achter retrieval-augmented generation (RAG)-systemen, die de gouden standaard zijn geworden voor AI-agenten die toegang nodig hebben tot bedrijfskennis. In een RAG-systeem zoekt het systeem, wanneer een gebruiker een vraag stelt, eerst de vector database af naar relevante documenten of passages, en geeft vervolgens deze context aan een taalmodel om een nauwkeurig, onderbouwd antwoord te genereren. Dit tweestapsproces—eerst ophalen, dan genereren—verbetert de nauwkeurigheid aanzienlijk ten opzichte van het alleen laten antwoorden op basis van trainingsdata. De vector database fungeert als extern geheugen van de organisatie, waardoor AI-agenten toegang hebben tot en kunnen redeneren over actuele, eigen informatie zonder het onderliggende model opnieuw te hoeven trainen. Deze architectuur is van onschatbare waarde gebleken voor het bouwen van domeinspecifieke assistenten, klantenservicebots en interne kennissystemen die up-to-date moeten blijven met snel veranderende informatie.

Integratie van ongestructureerde data is het proces waarbij rommelige, ruwe, ongestructureerde content wordt omgezet in gestructureerde, machine-leesbare datasets die AI-systemen kunnen voeden. Zie het als het uitbreiden van de bekende principes van ETL (Extract, Transform, Load)-pipelines—al lang de ruggengraat van datawarehousing—naar een nieuw domein: documenten, e-mails, chats, audio en video. Net zoals traditionele ETL-pipelines de opname, verwerking en voorbereiding van gestructureerde data uit databases en API’s automatiseren, verwerken pipelines voor ongestructureerde data de complexiteit van uiteenlopende contentformaten op schaal. De kracht van deze aanpak zit in de automatisering en herhaalbaarheid. Wat voorheen weken handmatig scripten en onderhouden vergde, kan nu in minuten worden uitgevoerd met kant-en-klare connectors en operators. De typische pipeline voor integratie van ongestructureerde data kent drie hoofdfasen: opname, transformatie en laden.

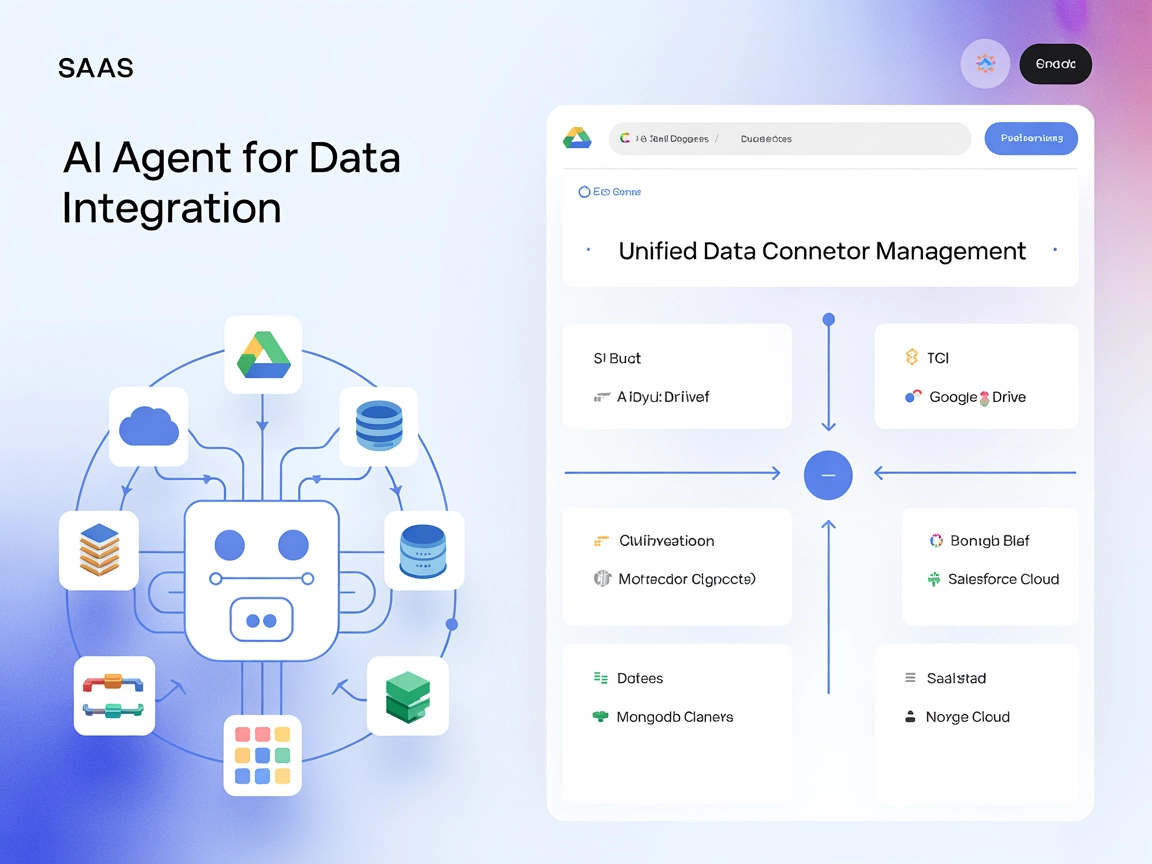

Opname begint met het verbinden met gegevensbronnen waar ongestructureerde content zich bevindt. Moderne integratieplatforms bieden kant-en-klare connectors naar bedrijfsapplicaties als SharePoint, Box, Slack, bestandsopslag, e-mailsystemen en meer. In plaats van maatwerkcode te schrijven voor elke bron, regelen deze connectors authenticatie, paginering en data-extractie automatisch. Hierdoor kunnen data-engineers zich richten op bedrijfslogica in plaats van technische koppelingen. De opnamefase pakt ook de initiële uitdaging aan om te ontdekken waar ongestructureerde data zich bevindt in de organisatie—geen eenvoudige klus in grote bedrijven waar documenten verspreid liggen over tientallen systemen en repositories.

Transformatie is waar de echte intelligentie plaatsvindt. Ruwe documenten worden verwerkt via een serie kant-en-klare operators die veelvoorkomende uitdagingen aanpakken. Tekstextractie haalt leesbare inhoud uit PDF’s, afbeeldingen en andere formaten. Deduplicatie identificeert en verwijdert dubbele documenten die analyses kunnen verstoren of opslag verspillen. Taalannotatie bepaalt de taal van de inhoud, wat meertalige ondersteuning mogelijk maakt. Verwijdering van persoonlijk identificeerbare informatie (PII) haalt gevoelige data zoals burgerservicenummers, creditcardnummers en namen eruit, waardoor wordt voldaan aan privacywetgeving. Chunking splitst grote documenten in kleinere, semantisch betekenisvolle segmenten—een cruciale stap omdat AI-modellen contextvensters hebben en vector databases beter werken met de juiste chunk-grootte. Tot slot zet vectorisatie deze chunks om in embeddings, de numerieke representaties die vector databases nodig hebben. Al deze transformaties gebeuren automatisch, zonder dat het data-engineeringteam diepgaande machine learning-expertise hoeft te hebben.

Laden duwt de verwerkte embeddings in een vector database waar ze toegankelijk worden voor AI-agenten, RAG-systemen, documentclassificatiemodellen, intelligente zoektoepassingen en andere AI-workloads. Het resultaat is een volledig geautomatiseerde pipeline die grote hoeveelheden uiteenlopende content kan verwerken en direct beschikbaar stelt aan AI-systemen.

Een van de krachtigste functies van moderne integratie van ongestructureerde data is delta-verwerking. Wanneer een document verandert, hoeft het systeem niet de hele pipeline opnieuw te draaien. Alleen de wijzigingen (de delta) worden opgehaald en verder verwerkt. Dit houdt pipelines up-to-date op schaal zonder de kostbare herverwerking die anders nodig zou zijn. Voor organisaties met enorme documentrepositories die vaak veranderen, is deze efficiëntiewinst baanbrekend.

Beveiliging en toegangsbeheer zijn ingebouwd in de integratielaag. Natuurlijke access control lists (ACL’s) behouden permissies op documentniveau door de hele pipeline heen, zodat gebruikers en AI-agenten alleen content zien waarvoor ze geautoriseerd zijn. Dit is essentieel voor compliance in gereguleerde sectoren en voor het handhaven van data governance in organisaties met complexe rechtenstructuren. Wanneer een document in het bronsysteem is beperkt tot bepaalde gebruikers, blijven die beperkingen door de hele pipeline en in de vector database gehandhaafd, zodat permissies consistent worden afgedwongen.

Integratie maakt data bruikbaar, governance maakt data betrouwbaar. Governance van ongestructureerde data gaat verder dan alleen het aanleveren van data aan AI-systemen; het zorgt ervoor dat data vindbaar, goed georganiseerd, correct geclassificeerd en compliant is met bedrijfsbeleid en regelgeving. Net zoals gestructureerde data al lang profiteert van data governance-oplossingen—datacatalogi, herkomsttracking, kwaliteitsmonitoring—heeft ongestructureerde data nu vergelijkbare governance-infrastructuur nodig, specifiek ontworpen voor haar unieke eigenschappen.

Een compleet governance-systeem voor ongestructureerde data bestaat doorgaans uit meerdere kerncomponenten. Asset discovery en connectie begint met het identificeren van alle ongestructureerde assets binnen de organisatie via kant-en-klare connectors naar verschillende systemen. Dit levert een compleet overzicht op van waar ongestructureerde data zich bevindt, een essentiële eerste stap waar veel bedrijven mee worstelen. Entiteitsdetectie en verrijking transformeert ruwe bestanden in gestructureerde, analyseerbare data door belangrijke entiteiten als namen, data, onderwerpen en andere relevante informatie te identificeren. Verrijkingspipelines classificeren vervolgens de inhoud, beoordelen de kwaliteit en voegen contextuele metadata toe. Documenten kunnen worden getagd met onderwerpen (bijv. “contract”, “klantfeedback”, “productspecificatie”), gerelateerde personen, resultaten van sentimentanalyse of andere relevante attributen. Deze metadata maakt het eenvoudiger om content te organiseren, interpreteren en terug te vinden.

Validatie en kwaliteitscontrole waarborgen nauwkeurigheid en betrouwbaarheid. Resultaten verschijnen in eenvoudige validatietabellen met configureerbare regels en waarschuwingen die metadata met lage betrouwbaarheid signaleren. Als het systeem onzeker is over een classificatie of extractie, wordt die onzekerheid aan menselijke reviewers getoond, waardoor foutieve data wordt tegengehouden voordat het AI-systemen bereikt. Deze human-in-the-loop aanpak balanceert automatisering met nauwkeurigheid.

Workflow en catalogisering verplaatsen gevalideerde assets via workflows naar een centrale catalogus, waardoor organisatie en vindbaarheid verbeteren. Met technische en contextuele metadata kunnen gebruikers slim zoeken en filteren in alle assets. Een data-analist die op zoek is naar contracten van een specifieke leverancier of een compliance officer die zoekt naar documenten met bepaalde regelgeving, kan nu snel relevante informatie vinden zonder duizenden bestanden handmatig te doorzoeken.

Dataherkomst en auditbaarheid houden bij hoe documenten van bron naar doel bewegen en bieden volledig inzicht in datatransformaties en -bewegingen. Dit is essentieel voor compliance, doordat organisaties kunnen aantonen dat data correct is behandeld en gevoelige informatie adequaat is beschermd. In gereguleerde sectoren kan deze audittrail het verschil betekenen tussen het wel of niet slagen voor een audit.

Samen creëren deze governance-componenten een fundament van vertrouwen. Datateams kunnen betrouwbare, gestructureerde datasets leveren die nauwkeurige AI-uitvoer mogelijk maken en tegelijkertijd voldoen aan regelgeving en bedrijfsbeleid.

FlowHunt erkent dat de kruising van integratie en governance van ongestructureerde data een kritieke bottleneck vormt voor AI-adoptie in het bedrijfsleven. Door zowel de technische als governance-aspecten van het beheer van ongestructureerde data te automatiseren, stelt FlowHunt organisaties in staat productieklare AI-systemen te bouwen zonder wekenlang handmatig data voor te bereiden. De aanpak van FlowHunt combineert intelligente dataintegratie met uitgebreide governance, waardoor datateams zich kunnen richten op bedrijfswaarde in plaats van infrastructuur. Het platform biedt kant-en-klare connectors naar bedrijfssystemen, geautomatiseerde transformatie-operators en governance-workflows die zonder diepgaande technische kennis kunnen worden geconfigureerd. Deze democratisering van ongestructureerde dataverwerking betekent dat organisaties van elke omvang hun bedrijfsdata kunnen inzetten voor AI-agenten en RAG-systemen. Door de tijd van ruwe data naar AI-klare datasets te verkorten van weken naar minuten, helpt FlowHunt organisaties hun AI-initiatieven te versnellen en sneller dan ooit te schalen van prototype naar productie.

De ware kracht ontstaat wanneer integratie en governance van ongestructureerde data samenkomen. Integratie maakt data bruikbaar; governance maakt het betrouwbaar. Samen sluiten ze het betrouwbaarheidsgat dat enterprise AI-systemen historisch heeft geplaagd. Een praktisch voorbeeld: een financiële dienstverlener wil een AI-agent bouwen die leningadviseurs helpt snel kredietrisico’s te beoordelen door klantdocumenten, financiële overzichten en correspondentie te analyseren. Zonder goede integratie en governance zou dit maanden handwerk kosten: tekst uit PDF’s halen, gevoelige informatie verwijderen, documenten organiseren op klant en datum, en handmatig controleren of de data klopt en compleet is. Met geïntegreerde ongestructureerde datapijplijnen en governance wordt dit proces geautomatiseerd. Documenten worden uit meerdere bronnen opgehaald, getransformeerd om PII te verwijderen, opgesplitst in betekenisvolle segmenten en gevectoriseerd. De governance-laag zorgt ervoor dat documenten correct zijn geclassificeerd, gevoelige informatie is verwijderd en alleen bevoegde leningadviseurs toegang hebben tot specifieke klantinformatie. De resulterende embeddings worden geladen in een vector database waarin de AI-agent direct relevante informatie kan ophalen. Wanneer de agent een vraag over een specifieke klant krijgt, zoekt hij in de vector database naar relevante documenten, haalt de meest semantisch vergelijkbare passages op en gebruikt die context voor een nauwkeurige risicoanalyse. Het hele proces dat maanden zou kosten, gebeurt nu real-time, volledig compliant en auditbaar.

Deze architectuur maakt diverse waardevolle use-cases mogelijk, ver buiten alleen AI-agenten. Analytics- en reporting teams kunnen klantgesprekken analyseren op sentimenttrends zonder duizenden uren audio handmatig te beluisteren. Compliance teams kunnen contracten scannen op regelgeving en mogelijke overtredingen. Operationele teams kunnen veldrapporten analyseren om patronen en inefficiënties te ontdekken. Customer success teams kunnen risicoklanten identificeren door supportinteracties te analyseren. Al deze toepassingen worden mogelijk als ongestructureerde data goed geïntegreerd en beheerd is.

De overstap van handmatige data-voorbereiding naar geautomatiseerde ongestructureerde datapijplijnen betekent een fundamentele verandering in hoe bedrijven AI benaderen. Traditioneel volgden AI-projecten een voorspelbaar patroon: data scientists bouwen indrukwekkende prototypes die goed werken in gecontroleerde omgevingen, maar het opschalen naar productie vraagt enorme engineering-inspanning om echte datacomplexiteit, compliance en schaalbaarheid aan te kunnen. Deze kloof tussen prototype en productie is een belangrijke barrière voor AI-adoptie: vaak blijken kosten en complexiteit van opschalen groter dan de verwachte waarde.

Geautomatiseerde integratie en governance van ongestructureerde data veranderen deze rekensom. Door de uitdagingen van datainfrastructuur automatisch op te lossen, kunnen organisaties direct van prototype naar productie. De datapijplijn achter een prototype kan dezelfde zijn als die achter een productiesysteem, alleen opgeschaald voor grotere volumes. Deze continuïteit vermindert risico’s, versnelt time-to-value en maakt AI-projecten economisch aantrekkelijker. Organisaties kunnen nu AI-investeringen rechtvaardigen met snellere terugverdientijden en lagere implementatiekosten.

Het concurrentievoordeel gaat verder dan snelheid en kosten. Organisaties die hun ongestructureerde data succesvol benutten, krijgen toegang tot inzichten en mogelijkheden die concurrenten zonder goede datainfrastructuur niet kunnen evenaren. Een AI-agent die nauwkeurig vragen kan beantwoorden over beleid, producten en klantgeschiedenis, wordt een krachtig instrument voor klantenservice, sales enablement en intern kennisbeheer. Een compliance-systeem dat automatisch contracten kan scannen en risico’s signaleren, wordt een vermenigvuldiger voor juridische teams. Een analytics-systeem dat inzichten uit klantinteracties haalt, wordt een bron van concurrentie-informatie. Deze mogelijkheden stapelen zich op, waardoor het verschil groeit tussen organisaties die investeren in hun datainfrastructuur en zij die dat niet doen.

Een van de belangrijkste redenen waarom bedrijven terughoudend zijn om ongestructureerde data aan AI-systemen te voeren, is het risico op het lekken van gevoelige informatie. Een slecht ontworpen pipeline kan klantdata lekken, bedrijfsgeheimen blootleggen of privacywetgeving schenden. Daarom moeten beveiliging en compliance vanaf het begin ingebouwd zijn in de datainfrastructuur, niet achteraf toegevoegd.

Moderne platformen voor integratie van ongestructureerde data pakken deze zorgen op verschillende manieren aan. PII-verwijdering identificeert en redigeert automatisch gevoelige informatie zoals namen, BSN’s, creditcardnummers en andere persoonsgegevens. Access control lists zorgen dat permissies behouden blijven door de hele pipeline heen, zodat documenten die in het bronsysteem beperkt zijn, dat ook in de vector database blijven. Dataherkomsttracking creëert een audittrail die precies laat zien hoe data is verwerkt en verplaatst, zodat compliance-teams kunnen aantonen dat data correct is behandeld. Encryptie beschermt data tijdens transport en opslag. Compliance monitoring kan documenten of transformaties signaleren die mogelijk bedrijfsbeleid of regelgeving schenden.

Deze beveiligings- en compliance-functies zijn geen luxe, maar essentieel voor bedrijven in gereguleerde sectoren als financiële dienstverlening, gezondheidszorg en overheid. Ze worden ook steeds belangrijker voor elke organisatie die klantdata verwerkt, omdat privacywetgeving als AVG en CCPA strenge eisen stelt aan dataverwerking. Door compliance in de infrastructuur te bouwen, kunnen organisaties hun ongestructureerde data vol vertrouwen inzetten voor AI, zonder angst voor privacy- of datalekken.

De praktische toepassingen van goed geïntegreerde en beheerde ongestructureerde data zijn breed en bestrijken vrijwel elke sector en functie. Customer service en support teams kunnen AI-agenten bouwen die direct toegang hebben tot productdocumentatie, klantgeschiedenis en supporttickets, zodat ze sneller en accurater klantvragen beantwoorden. Sales teams kunnen AI-agenten inzetten om snel concurrentie-informatie, klantgegevens en offertesjablonen te vinden, wat het verkoopproces versnelt. Juridische en compliance teams kunnen AI gebruiken om contracten te scannen, risico’s te signaleren en compliance te waarborgen. HR-teams kunnen AI inzetten om medewerkersfeedback te analyseren, trends te signaleren en werkcultuur te verbeteren. Operationele teams kunnen AI gebruiken om veldrapporten te analyseren, inefficiënties op te sporen en processen te optimaliseren. R&D-teams kunnen AI inzetten om snel technische documentatie, patenten en onderzoeksartikelen te doorzoeken om relevante voorkennis te vinden en dubbel werk te voorkomen.

In al deze gevallen zit de waarde niet in het AI-model zelf, maar in de kwaliteit en toegankelijkheid van de data waar het model toegang toe heeft. Een geavanceerd taalmodel met slechte, incomplete of ontoegankelijke data levert slechte resultaten. Een eenvoudiger model met hoogwaardige, goed georganiseerde, correct beheerde data levert waardevolle inzichten en mogelijkheden.

Naarmate bedrijven verder investeren in AI, zullen zij die begrijpen dat AIsucces afhankelijk is van datasucces, het meeste profiteren. De meest geavanceerde modellen en algoritmen betekenen niets zonder toegang tot kwalitatief hoogwaardige, betrouwbare data. Daarom zijn integratie en governance van ongestructureerde data cruciaal voor elke organisatie die AI serieus neemt.

De weg vooruit bestaat uit verschillende belangrijke stappen. Ten eerste moeten organisaties de huidige situatie in kaart brengen: waar staat ongestructureerde data, in welke formaten, en wat zijn de huidige barrières voor benutting? Ten tweede moeten ze investeren in infrastructuur: platforms en tools implementeren die ongestructureerde data automatisch kunnen integreren en beheren op schaal. Ten derde moeten ze organisatiebrede vaardigheden opbouwen: datateams trainen in het gebruik van deze tools en governancepraktijken opzetten die datakwaliteit en compliance waarborgen. Ten vierde moeten ze beginnen met waardevolle use-cases: specifieke AI-projecten identificeren die duidelijke businesswaarde leveren, en deze als bewijs gebruiken voor bredere investeringen. Tot slot moeten ze itereren en opschalen: leren van de eerste projecten en geleidelijk de scope uitbreiden naarmate vertrouwen en capaciteiten groeien.

Organisaties die dit pad volgen, verwerven een aanzienlijk concurrentievoordeel. Ze kunnen AI-systemen sneller bouwen, met minder risico en meer vertrouwen in nauwkeurigheid en compliance. Ze kunnen inzichten uit hun data halen waar concurrenten niet bij kunnen. Ze kunnen AI-prototypes in maanden in productie brengen, in plaats van jaren. En dat alles terwijl ze voldoen aan de beveiligings-, compliance- en governancestandaarden die moderne bedrijven eisen.

Ervaar hoe FlowHunt uw integratie en governance van ongestructureerde data automatiseert—van opname en transformatie tot laden en compliance—en zo productieklare AI-agenten en RAG-systemen in minuten in plaats van weken mogelijk maakt.

De AI-revolutie in het bedrijfsleven wordt niet gewonnen door organisaties met de meest geavanceerde modellen, maar door die met de beste datainfrastructuur. Meer dan 90% van alle bedrijfsdata bestaat uit ongestructureerde formaten, terwijl minder dan 1% van deze data momenteel AI-systemen aandrijft. Dit is zowel een enorme uitdaging als een buitengewone kans. Door geautomatiseerde integratie en governance van ongestructureerde data te implementeren, kunnen organisaties deze verborgen goudmijn aan data ontsluiten en AI-agenten en RAG-systemen bouwen die niet alleen intelligent zijn, maar ook accuraat, betrouwbaar en compliant. Organisaties die snel deze datainfrastructuur opbouwen, krijgen een aanzienlijk concurrentievoordeel, gaan sneller van AI-prototype naar productie dan hun concurrenten, krijgen toegang tot inzichten die anderen niet hebben en bouwen capaciteiten op die in de tijd exponentieel groeien. De toekomst is aan bedrijven die beseffen dat AIsucces afhankelijk is van datasucces, en die investeren in de infrastructuur, tools en praktijken die nodig zijn om hun ongestructureerde data voor zich te laten werken.

Ongestructureerde data omvat documenten, e-mails, PDF’s, afbeeldingen, audio en video—inhoud die niet netjes in databaserijen past. Meer dan 90% van bedrijfsdata is ongestructureerd, terwijl minder dan 1% vandaag de dag in AI-projecten wordt gebruikt. Dit is een enorme, onbenutte kans voor organisaties om concurrentievoordelen te behalen via AI-agenten en intelligente systemen.

RAG combineert ophalen en genereren door eerst een vector database te doorzoeken op relevante informatie op basis van semantische overeenkomst, en vervolgens die context aan een AI-model te geven voor het genereren van nauwkeurige antwoorden. Vector databases slaan embeddings op—numerieke representaties van tekst—wat snelle, intelligente zoekopdrachten mogelijk maakt die betekenis begrijpen in plaats van alleen trefwoorden.

Integratie transformeert ruwe, rommelige ongestructureerde data in machine-leesbare datasets via ETL-achtige pipelines, waardoor data bruikbaar wordt voor AI. Governance zorgt ervoor dat data vindbaar, georganiseerd, betrouwbaar en compliant is door metadata te extraheren, inhoud te classificeren en herkomst te volgen. Samen creëren ze betrouwbare, productieklare datapijplijnen.

De sleutel is het bouwen van slimme datapijplijnen die integratie en governance combineren. Integratie maakt data bruikbaar; governance maakt het betrouwbaar. Door het automatiseren van de transformatie van ongestructureerde data naar hoogwaardige, gecontexualiseerde datasets, kunnen bedrijven AI-projecten opschalen van proof-of-concept naar betrouwbare, compliant productieomgevingen.

Arshia is een AI Workflow Engineer bij FlowHunt. Met een achtergrond in computerwetenschappen en een passie voor AI, specialiseert zij zich in het creëren van efficiënte workflows die AI-tools integreren in dagelijkse taken, waardoor productiviteit en creativiteit worden verhoogd.

Ontdek hoe FlowHunt de integratie en governance van ongestructureerde data automatiseert om nauwkeurige AI-agenten en RAG-systemen aan te drijven.

Ontdek wat ongestructureerde data is en hoe het zich verhoudt tot gestructureerde data. Leer over de uitdagingen en tools die worden gebruikt voor ongestructure...

Contentverrijking met AI verbetert ruwe, ongestructureerde content door kunstmatige intelligentie toe te passen om betekenisvolle informatie, structuur en inzic...

Integreer FlowHunt met de Unstructured API MCP Server om connectorbeheer te centraliseren, workflows te automatiseren en AI-agenten in staat te stellen data-ope...

Cookie Toestemming

We gebruiken cookies om uw browse-ervaring te verbeteren en ons verkeer te analyseren. See our privacy policy.