Introductie

Wanneer je ChatGPT opent, een prompt typt en op enter drukt, maak je niet zomaar verbinding met een mysterieuze cloud. Achter die eenvoudige interactie schuilt een van de meest complexe, kostbare en energie-intensieve infrastructuren die de mens ooit heeft gebouwd. Elk AI-antwoord dat je ontvangt, wordt aangedreven door enorme datacenters—miljarden kostende faciliteiten gekoeld door lucht en water, die genoeg elektriciteit verbruiken om hele steden van stroom te voorzien. Dit zijn geen abstracte concepten ergens in de cyberspace; het zijn fysieke gebouwen gevuld met gespecialiseerde hardware, geavanceerde koelsystemen en beveiliging op fortniveau. Begrijpen wat er in deze datacenters gebeurt, is essentieel om te snappen hoe moderne AI daadwerkelijk werkt en waarom bedrijven als OpenAI, Google, Microsoft en Meta triljoenen dollars investeren in de bouw ervan. Dit artikel verkent de verborgen ruggengraat van de AI-revolutie, van de basisarchitectuur van datacenters tot de complexe technische uitdagingen, de verbijsterende elektriciteitsvraag en de wereldwijde race om de infrastructuur te bouwen die de volgende generatie kunstmatige intelligentie zal aandrijven.

{{ < youtubevideo videoID=“WNt_1bSODIo” title=“What’s Inside an AI Data Center?” class=“rounded-lg shadow-md” > }}

Wat zijn datacenters en hoe functioneren ze?

Datacenters zijn in wezen fabrieken voor rekenkracht. Hoewel de term “cloud” alomtegenwoordig is in technologische marketing, is het eigenlijk misleidend—er is geen cloud. Wat er wél bestaat, zijn enorme fysieke gebouwen volgespoten met gespecialiseerde computerapparatuur, netwerkstructuur, energiesystemen en koelmechanismen. Je kunt een datacenter zien als een enorm uitvergrote versie van een persoonlijke computer. Net zoals je laptop een CPU, GPU, geheugen, opslag en voeding bevat, heeft een hyperscale datacenter deze componenten, maar dan vermenigvuldigd tot miljarden. De faciliteit beheert en levert data via onderling verbonden systemen van servers, AI-versnellers, opslagarrays en netwerkapparatuur. Deze gebouwen functioneren als kleine steden, met hun eigen stroomopwekking en distributiesystemen, noodgeneratoren, beveiligingsinfrastructuur en klimaatregeling. Het fundamentele doel blijft hetzelfde, of het datacenter nu CPU’s voor algemene computertaken huisvest of GPU’s voor AI-werkbelasting—het verwerkt, slaat op en levert data op immense schaal. Toch zijn het ontwerp, de architectuur en operationele eisen van op AI gerichte datacenters drastisch anders geworden dan bij traditionele datacenters, wat volledig nieuwe benaderingen vraagt voor energiebeheer, koeling en infrastructuurplanning.

Klaar om uw bedrijf te laten groeien?

Start vandaag uw gratis proefperiode en zie binnen enkele dagen resultaten.

Waarom AI-datacenters een fundamentele verschuiving in computerinfrastructuur betekenen

De opkomst van generatieve AI heeft de datacenterindustrie fundamenteel veranderd op manieren die veel verder gaan dan simpelweg bestaande infrastructuur opschalen. Tot eind 2022, toen ChatGPT werd gelanceerd, waren datacenters vooral gericht op algemene computertaken—websites hosten, databases beheren, bedrijfsapplicaties draaien en clouddiensten leveren. De rekeneisen waren relatief voorspelbaar en beheersbaar. Maar de explosieve groei van grote taalmodellen en generatieve AI-systemen heeft een geheel nieuwe categorie computerwerkbelasting gecreëerd die onder totaal andere voorwaarden opereert. Deze AI-systemen zijn afhankelijk van matrixvermenigvuldiging—een wiskundig eenvoudige bewerking die miljarden keren per seconde moet worden uitgevoerd. Deze vereiste heeft de industrie in rap tempo richting gespecialiseerde GPU-hardware geleid, met name de geavanceerde chips van Nvidia, die hier speciaal voor ontworpen zijn. De verschuiving is zo groot dat er sprake is van een daadwerkelijk tekort aan GPU-capaciteit: bedrijven kunnen niet genoeg hardware bemachtigen om aan de vraag te voldoen. Dit heeft geleid tot een ware technologische wapenwedloop, waarbij elk groot techbedrijf honderden miljarden investeert om GPU’s veilig te stellen en een AI-geoptimaliseerde datacenterinfrastructuur op te bouwen. De schaal van deze uitrol is ongekend—alleen al het Stargate-project van OpenAI, Oracle en SoftBank beoogt triljoenen dollars te investeren in AI-infrastructuur in de Verenigde Staten. Dit is geen incrementele upgrade van bestaande systemen; het is een fundamentele herstructurering van de wereldwijde computerinfrastructuur om een nieuw technologisch paradigma te ondersteunen.

De stroomverbruikcrisis: waarom elektriciteit de beperkende factor is

De meest kritieke beperking voor de uitbreiding van AI-datacenters is elektriciteit. In tegenstelling tot traditionele datacenters die misschien 10-15 kilowatt per rack gebruiken, gaan moderne AI-datacenters nu richting 80-120 kilowatt per rack, met Nvidia’s volgende generatie Ruben-systemen die later dit decennium 600 kilowatt per rack kunnen bereiken. Dit is een verhoging van het stroomverbruik per rack met een factor vijf tot tien, wat ongekende uitdagingen creëert voor stroomopwekking, distributie en beheer. Ter illustratie: het Amerikaanse ministerie van Energie schat dat datacenters in 2023 alleen al 4,4% van alle elektriciteit verbruikten, en dit percentage zal naar verwachting oplopen tot 7-12% in 2028. De Electric Reliability Council of Texas (ERCOT) en andere netbeheerders verwachten ongeveer 30 gigawatt aan nieuwe piek-elektriciteitsvraag in 2030, grotendeels door de uitbreiding van datacenters. Voor perspectief: 30 gigawatt is ongeveer gelijk aan het elektriciteitsverbruik van 25-30 miljoen huishoudens, of het vermogen van circa 30 grote kerncentrales. Dit vormt een enorme uitdaging voor nutsbedrijven en regionale elektriciteitsnetten die zijn ontworpen voor een totaal andere tijd en vraag. Het probleem wordt verergerd doordat het elektriciteitsverbruik van AI-datacenters niet gelijkmatig over het land of de tijd verspreid is. Deze faciliteiten vereisen een constante, hoge energiedichtheid dicht bij bepaalde onderstations, wat lokale druk op de infrastructuur veroorzaakt. Bedrijven als Google, Microsoft en OpenAI maken nu strategische keuzes voor de locatie van datacenters op basis van elektriciteitsbeschikbaarheid, niet langer alleen op vastgoedkosten of nabijheid van gebruikers. Dit heeft geleid tot een geografische concentratie van datacenters in regio’s met veel stroomcapaciteit, zoals het noorden van de VS, de Nordics en gebieden met veel waterkracht of kernenergie. De elektriciteitsbeperking is inmiddels zo belangrijk dat het de voornaamste beperkende factor is voor uitbreiding van AI-infrastructuur, belangrijker dan vastgoed, personeel of zelfs GPU-beschikbaarheid.

Schrijf u in voor onze nieuwsbrief

Ontvang gratis de nieuwste tips, trends en aanbiedingen.

Begrijpen van datacenterarchitectuur: de bouwstenen van AI-berekeningen

Een modern AI-datacenter is opgebouwd uit verschillende onderling verbonden systemen, die elk een essentiële functie hebben. Centraal staan de racks—metalen frames met GPU’s en gespecialiseerde AI-versnellers die de daadwerkelijke berekeningen uitvoeren. Deze racks zijn verbonden via snelle netwerkswitches die communicatie met zeer hoge bandbreedte mogelijk maken. Het datacenter bevat ook opslagarrays met petabytes aan informatie—de trainingsdata, modelgewichten en gebruikersdata die AI-systemen nodig hebben. Naast de hardware vereist de faciliteit geavanceerde stroominfrastructuur, waaronder transformatoren, distributiepanelen, ononderbroken stroomvoorzieningen (UPS) en noodgeneratoren. De energiesystemen moeten niet alleen het gemiddelde verbruik aankunnen, maar ook pieken wanneer alles op volle kracht draait. Even essentieel is de koeltechniek, die een van de meest kritieke én complexe aspecten is van modern datacenterontwerp. Koelsystemen moeten de warmte van de apparatuur afvoeren en de optimale temperatuur behouden. Dit gebeurt via een combinatie van luchtbehandelingsunits, vloeistofkoeling, gekoelde watersystemen en soms zelfs directe vloeistofkoeling waarbij het koelmiddel direct over de chips stroomt. De faciliteit beschikt verder over uitgebreide beveiliging: fysieke barrières, toegangscontrole, camerabewaking en cybersecuritymaatregelen tegen zowel fysieke inbraak als digitale aanvallen. Tot slot zijn er redundante systemen voor kritieke functies—noodstroom, noodkoeling, noodnetwerk—om serviceonderbrekingen te minimaliseren en bij storingen door te kunnen draaien.

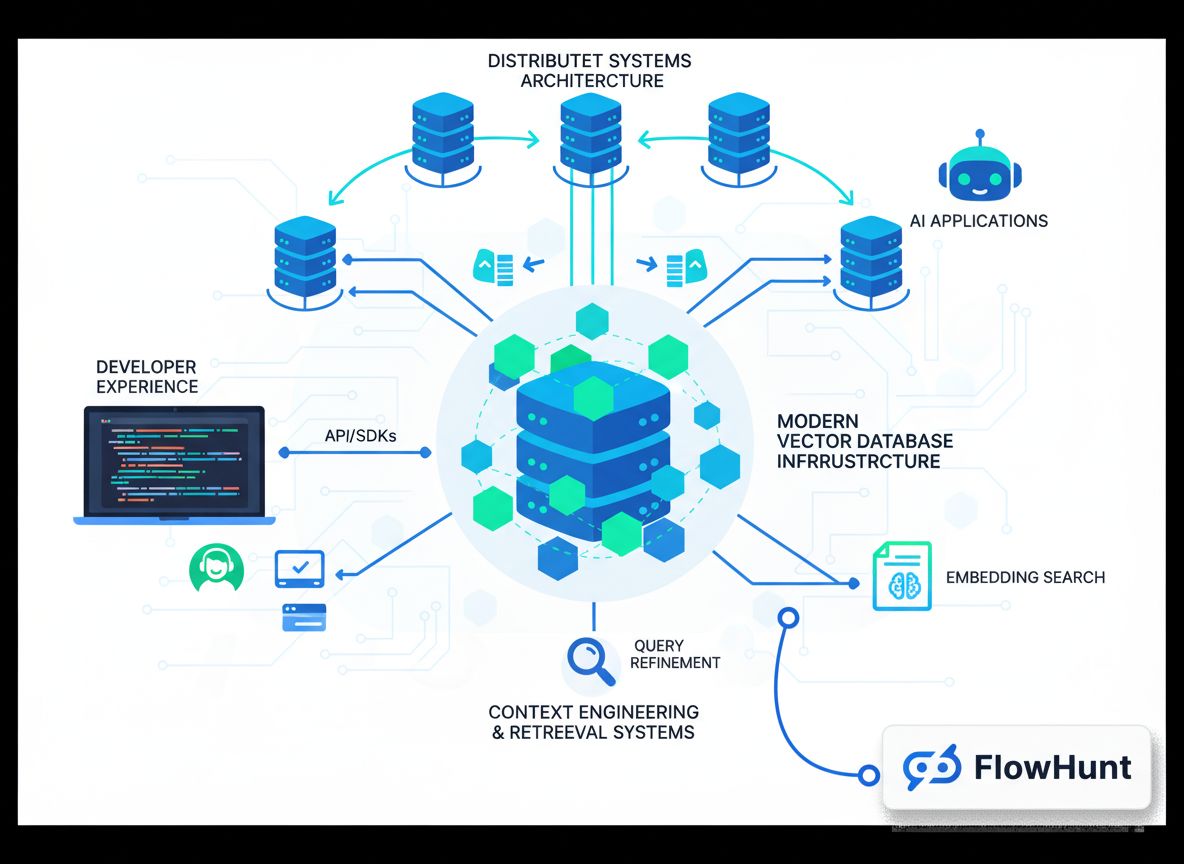

FlowHunt en de automatisering van AI-infrastructuurinzichten

Hoewel FlowHunt zich richt op het automatiseren van AI-contentworkflows in plaats van op het beheer van fysieke infrastructuur, zijn de principes van efficiëntie en optimalisatie die aan datacenterontwerp ten grondslag liggen direct toepasbaar op hoe organisaties hun AI-operaties kunnen stroomlijnen. Net zoals datacenters hun stroomverbruik, koeling en rekencapaciteit moeten optimaliseren, moeten organisaties hun workflows optimaliseren om maximaal waarde uit AI-systemen te halen met zo min mogelijk verspilling. FlowHunt automatiseert de onderzoeks-, contentgeneratie- en publicatieprocessen die anders veel handmatig werk en coördinatie zouden vergen. Door deze processen te automatiseren, verminderen organisaties de rekenoverhead van hun contentactiviteiten, vergelijkbaar met hoe datacenters hun infrastructuur optimaliseren. Het platform helpt teams inzicht te krijgen in en het gebruik van hun AI-workflows te volgen, zodat zichtbaar wordt hoe resources worden benut—net zoals datacenterbeheerders het energie- en koelrendement monitoren. Voor organisaties die AI-producten of -diensten bouwen, is inzicht in de infrastructuureisen en beperkingen van datacenters cruciaal voor gefundeerde keuzes rond uitrol, schaalvergroting en kostenbeheer. De automatiseringsmogelijkheden van FlowHunt helpen teams efficiënter binnen deze beperkingen te werken, zodat ze meer content kunnen genereren, meer onderzoek kunnen doen en vaker kunnen publiceren zonder dat hun rekenverbruik of operationele overhead evenredig toeneemt.

De koeluitdaging: omgaan met extreme warmteontwikkeling

Een van de minst gewaardeerde aspecten van AI-datacenterbeheer is koeling. De enorme dichtheid van berekeningen in moderne AI-datacenters genereert enorme hoeveelheden warmte die van de chips afgevoerd moeten worden om thermische schade te voorkomen en optimale prestaties te behouden. Zonder effectieve koeling zou het silicium letterlijk smelten en zou de hele faciliteit uitvallen. Deze koeluitdaging heeft geleid tot een fundamentele omslag in datacenterontwerp, weg van traditionele luchtkoeling naar geavanceerdere vloeistofkoelingssystemen. Luchtkoeling, waarbij ventilatoren koele lucht over de apparatuur blazen, is de traditionele methode in de meeste datacenters. Maar lucht heeft een relatief lage thermische geleidbaarheid ten opzichte van vloeistoffen, dus is het minder efficiënt voor het koelen van dicht op elkaar geplaatste apparatuur. Naarmate de energiedichtheid toenam, raakte luchtkoeling steeds meer ontoereikend. Vloeistofkoelingssystemen, waarbij water of speciale koelmiddelen direct over of langs de chips stromen, zijn veel efficiënter. Er zijn verschillende benaderingen: gesloten systemen waarin het koelmiddel circuleert zonder contact met de buitenlucht, en open systemen waarbij het koelmiddel aan de omgeving wordt blootgesteld. Gesloten systemen zijn waterzuiniger maar gebruiken mogelijk meer elektriciteit voor het koelen. Open systemen zijn zuiniger qua elektriciteit maar verbruiken meer water. De keuze hangt af van lokale waterbeschikbaarheid, elektriciteitskosten, klimaat en milieuregels. Watergebruikseffectiviteit (WUE) is een belangrijke maatstaf, berekend als liters water per kilowattuur stroomverbruik van de IT-apparatuur. In de sector is WUE gemiddeld 1,9 liter per kilowattuur, maar faciliteiten met volledig gesloten systemen kunnen richting nul watergebruik gaan. Zo verbruikte Google’s datacenter in Council Bluffs, Iowa, in 2023 ongeveer één miljard liter water, wat de immense watervraag van grootschalige AI-faciliteiten onderstreept. Sommige innovatieve centra onderzoeken alternatieve koelmogelijkheden, zoals het benutten van restwarmte voor stadsverwarming (zoals Meta in Denemarken doet, waar jaarlijks 100-165 gigawattuur aan warmte aan lokale netwerken wordt geleverd), gratis koeling door buitenlucht in koude regio’s, of zelfs waterstofkoeling. De koeltechniek vertegenwoordigt een aanzienlijk deel van de kapitaalinvestering en is vaak het meest complexe technische vraagstuk in de ontwerpfase.

De bouwtijd en investeringsschaal

Het bouwen van een hyperscale AI-datacenter is een immense onderneming die zorgvuldige planning, grote kapitaalinvesteringen en coördinatie met veel belanghebbenden vereist. De gebruikelijke tijdlijn van eerste idee tot volledige operatie is 18 tot 30 maanden, verdeeld in verschillende fasen. De eerste fase is planning en haalbaarheidsonderzoek (3-6 maanden). Hierin worden potentiële locaties in kaart gebracht, de lokale stroom- en waterbeschikbaarheid geanalyseerd, regelgeving bekeken en overleg met de gemeenschap gevoerd. Geschikte grond vinden is niet eenvoudig—de faciliteit heeft toegang nodig tot veel stroom, snelle glasvezelverbindingen, voldoende water voor koeling en steun van de lokale overheid. De tweede fase is ontwerp en engineering (6-12 maanden). Architecten en ingenieurs maken gedetailleerde plannen voor de opstelling van racks, energieverdeling, koelinfrastructuur, beveiliging en alle andere gebouwsystemen. Dit gebeurt met veel modellering en simulatie om efficiëntie te waarborgen. De derde fase is vergunningen en goedkeuringen, die overlapt met de ontwerpfase en 6-18 maanden duurt. Dit omvat het verkrijgen van bouwvergunningen, milieugoedkeuringen, aansluitingen op het elektriciteitsnet en andere vereiste toestemmingen. Vooral in gebieden met strenge milieuregels of waar weerstand uit de gemeenschap is, kan dit veel tijd kosten. De vierde fase is de daadwerkelijke bouw (1-2 jaar): het opzetten van het gebouw, alle apparatuur installeren, elektrische en koelsystemen aanleggen en beveiliging opzetten. De laatste fase is testen en ingebruikname (3-6 maanden). Hierin worden alle systemen getest, software geconfigureerd en wordt de faciliteit geleidelijk online gebracht. De bekendste uitzondering op deze tijdlijn is het Colossus-project van XAI, dat in slechts 122 dagen werd voltooid—een ongekende prestatie. De meeste projecten volgen echter de standaardtijdlijn van 18-30 maanden. De kapitaalinvesteringen zijn enorm. Zo beslaat Microsofts Fairwater Supercomputer Campus honderden hectaren, vereist kilometers fundering en duizenden GPU’s met vloeistofkoeling. De totale investering kan makkelijk tientallen miljarden dollars bedragen. Dit weerspiegelt het strategische belang van AI-infrastructuur en de race om GPU-capaciteit en AI-mogelijkheden zo snel mogelijk uit te breiden.

Beveiliging en operationele complexiteit

Eenmaal gebouwd functioneren AI-datacenters met beveiliging op fortniveau en geavanceerde operationele procedures. Ze bevatten apparatuur ter waarde van miljarden dollars en draaien systemen die cruciaal zijn voor grote techbedrijven. Fysieke beveiliging is essentieel. De faciliteiten zijn omgeven door hoge hekken en barrières tegen voertuigen. Toegangspunten zijn streng gecontroleerd met badges, biometrische scanners en bewakers. Bezoekers zijn zeldzaam en moeten vooraf worden goedgekeurd; serverruimtes zijn alleen toegankelijk onder begeleiding. Overal hangen camera’s. De beveiligingsinfrastructuur voorkomt zowel diefstal als sabotage. Cybersecurity is minstens zo belangrijk. De systemen bevatten waardevolle intellectuele eigendom, gebruikersdata en getrainde modellen die jaren onderzoek en miljarden dollars waard zijn. Er worden uiterst geavanceerde cybersecuritymaatregelen toegepast, zoals netwerksegmentatie, indringerdetectie, encryptie en continue monitoring. Elk rack is doorgaans afgesloten in een kooi, en toegang tot kritieke systemen is beperkt tot geautoriseerd personeel. De operationele complexiteit is enorm. Datacenteroperators monitoren voortdurend stroomverbruik, koeling, apparatuurstatus, netwerkprestaties en beveiliging. Ze plannen de werkbelasting om het energieverbruik over de faciliteit te balanceren en overbelasting te voorkomen. Onderhoud wordt zorgvuldig gepland om uitval te minimaliseren. Ze moeten snel reageren op storingen en reparaties uitvoeren. Een grote faciliteit kan tientallen tot honderden mensen in dienst hebben, al kan een volledig geautomatiseerd centrum door een klein team worden beheerd. De procedures zijn sterk gestandaardiseerd en gedocumenteerd, met heldere protocollen voor normale en noodsituaties.

Geografische spreiding en lokale economische impact

De locatiekeuze van AI-datacenters is een strategische beslissing voor grote techbedrijven, gedreven door vooral stroomvoorziening, maar ook door water, klimaat, glasvezel, regelgeving en lokale factoren. Noord-Virginia is uitgegroeid tot de grootste datacentermarkt ter wereld, met vrijwel geen leegstand en gigawatts aan nieuwe capaciteit. Loudoun County, Virginia, is zo afhankelijk van datacenter-inkomsten dat ze ongeveer 38% van het algemene budget uit datacenters halen, waardoor de lokale belastingen voor inwoners omlaag konden. Dit toont het enorme economische voordeel voor lokale gemeenschappen. Maar ook andere regio’s worden aantrekkelijk. Phoenix, Chicago, Oregon en Ohio ontvangen veel datacenterinvesteringen vanwege beschikbare grond, genoeg energie en water. Het noorden van de VS, vooral nabij waterkrachtcentrales of kerncentrales, is extra interessant door schone energie. De Nordics, zoals IJsland en Noorwegen, zijn belangrijke hubs dankzij waterkracht en een koud klimaat, wat de koelkosten drukt. De economische impact is complex. In de bouwfase ontstaat veel werkgelegenheid—bouwvakkers, ingenieurs, projectmanagers. Maar als het centrum draait, is de werkgelegenheid klein: een groot datacenter heeft soms maar enkele tientallen medewerkers, veel minder dan tijdens de bouw. Dit moeten lokale overheden meewegen. De belastingopbrengsten kunnen groot zijn, zoals bij Loudoun County, maar de werkgelegenheid is beperkt. Ook kunnen er milieuzorgen zijn over waterverbruik, stroomvraag en warmteafvoer. De beste projecten zijn transparant over hun milieubelasting, werken samen met nutsbedrijven, besparen water en integreren met de lokale gemeenschap in plaats van losstaand te opereren.

Stroomopwekking en noodsystemen

De energie-infrastructuur rond AI-datacenters is net zo complex als de computerinfrastructuur zelf. Datacenters vragen niet alleen voldoende stroom, maar ook betrouwbare, consistente energie die pieken aankan zonder onderbreking. De meeste grote datacenters zijn aangesloten op het regionale net, maar hebben ook noodstroomvoorziening om bij uitval te blijven draaien. Vrijwel alle grote Amerikaanse datacenters hebben enorme dieselgeneratoren als noodstroom. Deze kunnen de faciliteit bij stroomuitval dagenlang van energie voorzien. Ze worden zelden ingezet, maar bij gebruik veroorzaken ze wel uitstoot. Dit heeft operators ertoe aangezet te kijken naar alternatieve noodstroom: sommige testen batterijopslag die stroom afgeeft bij uitval, anderen proberen gasturbines die schoner zijn dan diesel. Sommige innovatieve faciliteiten experimenteren zelfs met waterstof-brandstofcellen. Op langere termijn wordt gedacht aan kleine kerncentrales op locatie, al is dat nog vooral toekomstmuziek. De relatie tussen datacenters en nutsbedrijven is cruciaal: datacenters zijn enorme, constante belasting voor het elektriciteitsnet en nutsbedrijven moeten hun infrastructuur daarop aanpassen. Bedrijven als Google, Microsoft en OpenAI sluiten vaak langlopende stroomcontracten af. Sommigen investeren ook zelf in zonneparken, windmolens of waterkracht om hun eigen stroom op te wekken en minder afhankelijk te zijn van het net. De keuzes van datacenterexploitanten hebben grote gevolgen voor het regionale energiesysteem en kunnen energiebeleid en investeringen op staats- en nationaal niveau beïnvloeden.

De toekomst van AI-datacenterinfrastructuur

De ontwikkeling van AI-datacenters blijft in een stroomversnelling, aangejaagd door de explosieve groei van AI-toepassingen en de concurrentiedruk om rekenkracht veilig te stellen. De elektriciteitsvraag zal verder stijgen, wat uitdagingen geeft voor stroomopwekking en distributie. Koelvereisten zullen innovatie in thermisch beheer stimuleren. Beveiligingseisen nemen toe naarmate de waarde van de systemen groeit. Enkele trends die de toekomst bepalen: verdere geografische spreiding naar regio’s met voldoende stroom, water en connectiviteit; innovatie in koeling, met vloeistofkoeling als standaard en nieuwe methoden zoals immersie- of tweefasige koeling in ontwikkeling; meer focus op duurzaamheid, met beperking van waterverbruik, CO2-uitstoot en het gebruik van groene energie; verdere consolidatie en specialisatie, met centra die zich richten op training of op inference; en meer automatisering van het beheer, waarbij AI wordt ingezet om stroom, koeling en apparatuurgebruik te optimaliseren. De investeringen in AI-datacenterinfrastructuur zijn ongekend en onderstrepen het strategische belang van AI voor de wereldeconomie. Deze faciliteiten zijn het fysieke fundament van de AI-revolutie, de verborgen ruggengraat achter alle AI-toepassingen en diensten die industrieën en de samenleving transformeren.

{{ < cta-dark-panel

heading=“Versnel uw workflow met FlowHunt”

description=“Ervaar hoe FlowHunt uw AI-content- en SEO-workflows automatiseert — van onderzoek en contentgeneratie tot publicatie en analyse — allemaal op één plek.”

ctaPrimaryText=“Boek een demo”

ctaPrimaryURL=“https://calendly.com/liveagentsession/flowhunt-chatbot-demo"

ctaSecondaryText=“Probeer FlowHunt gratis”

ctaSecondaryURL=“https://app.flowhunt.io/sign-in"

gradientStartColor="#123456”

gradientEndColor="#654321”

gradientId=“827591b1-ce8c-4110-b064-7cb85a0b1217”

}}

De economie van AI-infrastructuur: investering en rendement

De financiële schaal van AI-datacenterinvesteringen is enorm en weerspiegelt het enorme vertrouwen dat bedrijven hebben in de waarde die AI zal opleveren. Het Stargate-project van OpenAI, Oracle en SoftBank beoogt triljoenen dollars te investeren in AI-infrastructuur in de VS. Nvidia heeft toegezegd $100 miljard bij te dragen. Google, Microsoft, Meta en andere grote techbedrijven investeren elk honderden miljarden in hun eigen datacenteruitbreiding. Deze investeringen worden gedaan ondanks forse onzekerheid over het rendement, vanwege het strategische belang van AI en de druk om rekenkracht veilig te stellen. De economie van datacenterexploitatie is complex. De kapitaalkosten zijn enorm—tientallen miljarden voor een grote faciliteit. De operationele kosten zijn ook aanzienlijk, vooral door het stroomverbruik. Een groot AI-datacenter kan continu 100-300 megawatt verbruiken, wat bij gangbare tarieven ($50-100 per megawattuur) neerkomt op $50-300 miljoen per jaar aan alleen elektriciteit. Daarbovenop komen koeling, onderhoud, beveiliging en personeel, waardoor de jaarlijkse operationele kosten gemakkelijk boven $500 miljoen uitkomen voor een grote faciliteit. Deze kosten moeten worden terugverdiend via inkomsten—door rekencapaciteit te verkopen of door de capaciteit intern te gebruiken voor AI-diensten. De prijzen voor rekencapaciteit zijn concurrerend en weerspiegelen de kosten plus winst. Naarmate er meer capaciteit beschikbaar komt, kan de prijsdruk toenemen, waardoor marges onder druk komen te staan. Maar de vraag naar AI-rekenkracht groeit tot dusver sneller dan het aanbod, dus blijven de prijzen voorlopig waarschijnlijk hoog. Het rendement hangt af van het vermogen om de faciliteit volledig te benutten, kosten goed te managen en prijszetting te behouden. Bedrijven die hun eigen datacenters bezitten en intern gebruiken voor AI-diensten, hebben mogelijk een ander economisch model dan bedrijven die capaciteit als dienst verkopen.

Milieuoverwegingen en duurzaamheid

De milieubelasting van de groei van AI-datacenters is aanzienlijk en veelzijdig. Het meest voor de hand liggend is het elektriciteitsverbruik. Naarmate datacenters een groter aandeel van de totale stroomproductie opsouperen, dragen ze bij aan CO2-uitstoot (tenzij ze op groene of nucleaire stroom draaien) en belasten ze het net. Ook het waterverbruik is fors, vooral bij watergekoelde faciliteiten. De geproduceerde warmte wordt soms hergebruikt (zoals bij Meta in Denemarken), maar meestal gewoon afgevoerd. De groeiende impact leidt tot meer aandacht voor duurzaamheid. Veel exploitanten streven naar CO2-neutraliteit of netto nul, vaak door groene stroom in te kopen of zelf op te wekken. Sommige nemen waterbesparende maatregelen, zoals gesloten koelsystemen of droge koeling. Anderen zoeken naar manieren om restwarmte te gebruiken voor stadsverwarming of andere doeleinden. De milieubelasting leidt ook tot nieuwe regelgeving rond watergebruik, uitstoot of milieu-effectrapportages. Sommige regio’s bieden juist incentives voor datacenters op plekken met veel groene stroom. Het spanningsveld tussen de behoefte aan AI-rekenkracht en milieubelasting zal de komende jaren belangrijk blijven. De uitdaging voor de sector is om de groeiende vraag naar AI te combineren met een minimale ecologische voetafdruk.

Conclusie

AI-datacenters vormen een van de grootste infrastructuurprojecten uit de menselijke geschiedenis, vergelijkbaar in schaal en complexiteit met de aanleg van elektriciteitsnetten, telecomnetwerken en transportsystemen. Deze enorme faciliteiten, mogelijk gemaakt door miljardeninvesteringen en geavanceerde techniek, zijn de verborgen ruggengraat van de AI-revolutie. Van het moment dat je een prompt in ChatGPT typt tot het moment dat je een antwoord ontvangt, voltrekt zich een ingewikkelde dans van berekeningen, stroomdistributie, koeling en dataverkeer door deze centra. De uitdagingen zijn immens: voldoende stroom veiligstellen, extreme warmte afvoeren, razendsnel bouwen en dat alles met minimale milieu-impact. Toch blijft de investeringsstroom aanhouden, gedreven door het strategische belang van AI en de wedloop om rekenkracht. Begrijpen wat er in deze datacenters gebeurt—de racks met GPU’s, de geavanceerde koelsystemen, stroomvoorziening, beveiliging—geeft inzicht in hoe moderne AI werkt en waarom de eisen zo hoog zijn. Naarmate AI zich verder ontwikkelt en belangrijker wordt voor de wereldeconomie, zullen de datacenters die deze systemen aandrijven alleen maar belangrijker en complexer worden.