Loggen in AI-workflows

Ontdek het belang van loggen in AI-workflows, hoe FlowHunt gedetailleerde logs mogelijk maakt voor tool-aanroepen en taken, en best practices voor het monitoren...

Dit artikel legt uit hoe je FlowHunt met Langfuse verbindt voor uitgebreide observatie, AI-workflowprestaties traceert en Langfuse-dashboards gebruikt om je FlowHunt-werkruimte te monitoren en optimaliseren.

Naarmate je AI-workflows in FlowHunt opschalen, wordt begrijpen wat er achter de schermen gebeurt steeds belangrijker. Vragen als “Waarom is deze workflow traag?”, “Hoeveel tokens verbruik ik?” of “Waar treden er fouten op?” vereisen gedetailleerd inzicht in je systeem.

Zonder goede observatie is het debuggen van AI-workflows als vliegen zonder zicht — je ziet het resultaat, maar mist de reis. Tracing-tools zoals Langfuse lossen dit op door elke stap van je workflow-uitvoering vast te leggen, wat gedetailleerd inzicht geeft in prestaties, kosten en gedrag.

Dit artikel legt uit hoe je FlowHunt naadloos met Langfuse verbindt en zo uitgebreide observatie mogelijk maakt voor al je AI-workflows. Je leert uitvoeringstrajecten te traceren, tokengebruik te monitoren, knelpunten te identificeren en prestatiegegevens te visualiseren — allemaal in één centraal dashboard.

Aan het eind beschik je over volledig inzicht in je FlowHunt-werkruimte, waarmee je workflows optimaliseert, kosten verlaagt en betrouwbaarheid waarborgt.

Observatie is het instrumenteren van je systeem om de interne staat te begrijpen via externe uitkomsten — vooral traces, statistieken en logs.

Voor FlowHunt-gebruikers die AI-workflows draaien, biedt observatie inzicht in:

Zonder observatie wordt het oplossen van problemen reactief en tijdrovend. Met observatie krijg je proactief inzicht waarmee je continu kunt optimaliseren en snel storingen kunt oplossen.

Langfuse is een open-source observatie- en analyseplatform dat speciaal is ontwikkeld voor LLM-toepassingen. Het legt gedetailleerde traces van AI-workflowuitvoeringen vast, waardoor ontwikkelaars en teams het inzicht krijgen dat nodig is om hun AI-systemen te debuggen, monitoren en optimaliseren.

Belangrijkste functies van Langfuse zijn:

Door Langfuse met FlowHunt te verbinden, zet je ruwe uitvoeringsgegevens om in bruikbare inzichten — je ontdekt wat werkt, wat niet, en waar je moet optimaliseren.

Na het volgen van deze handleiding kun je:

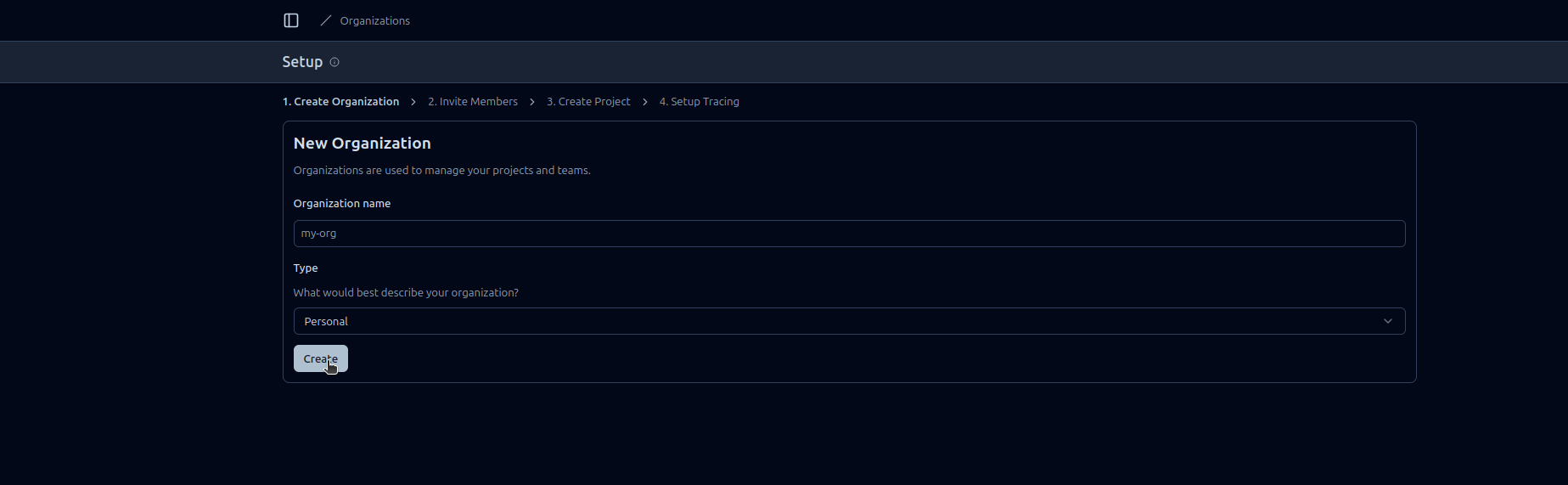

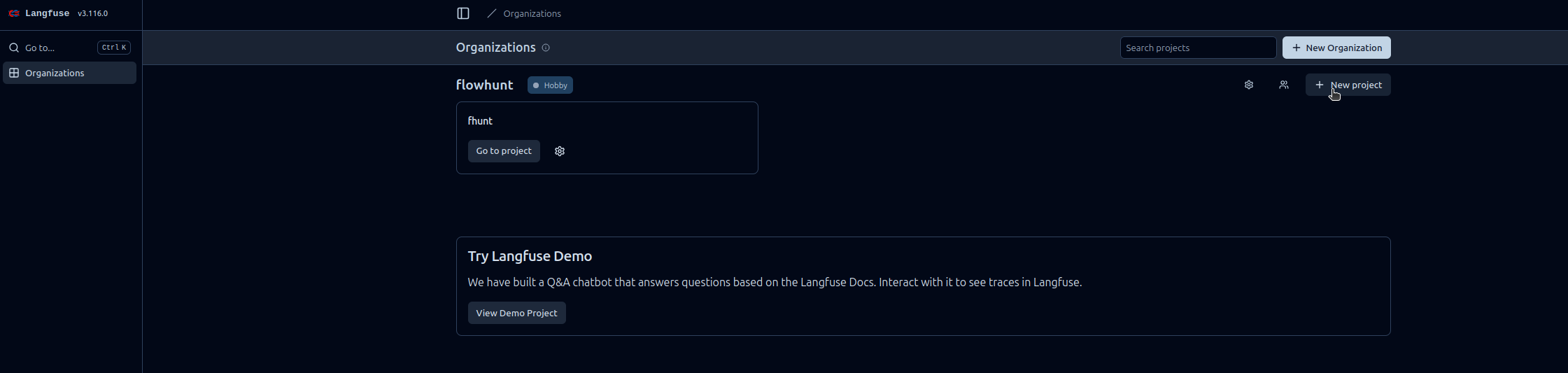

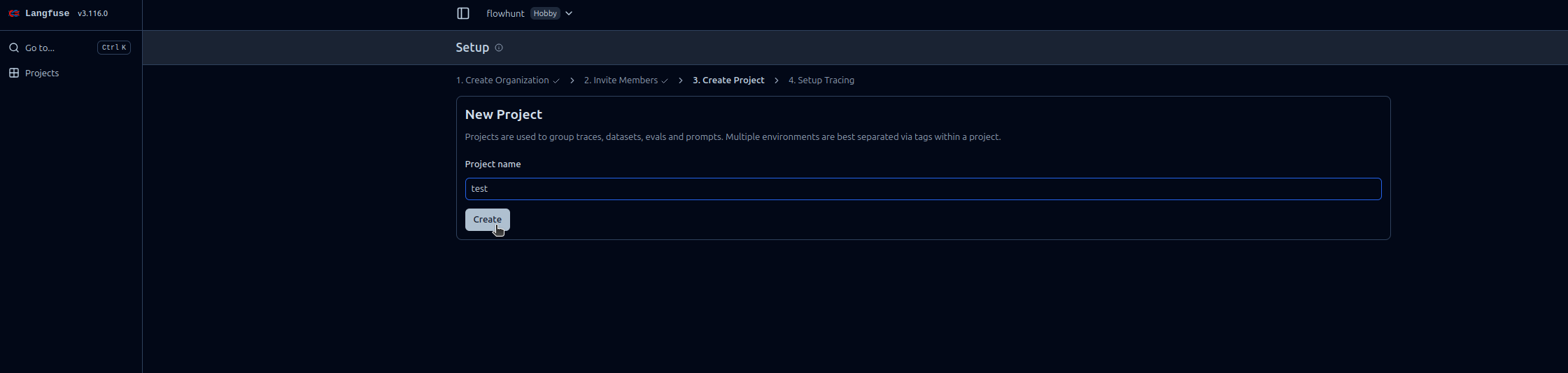

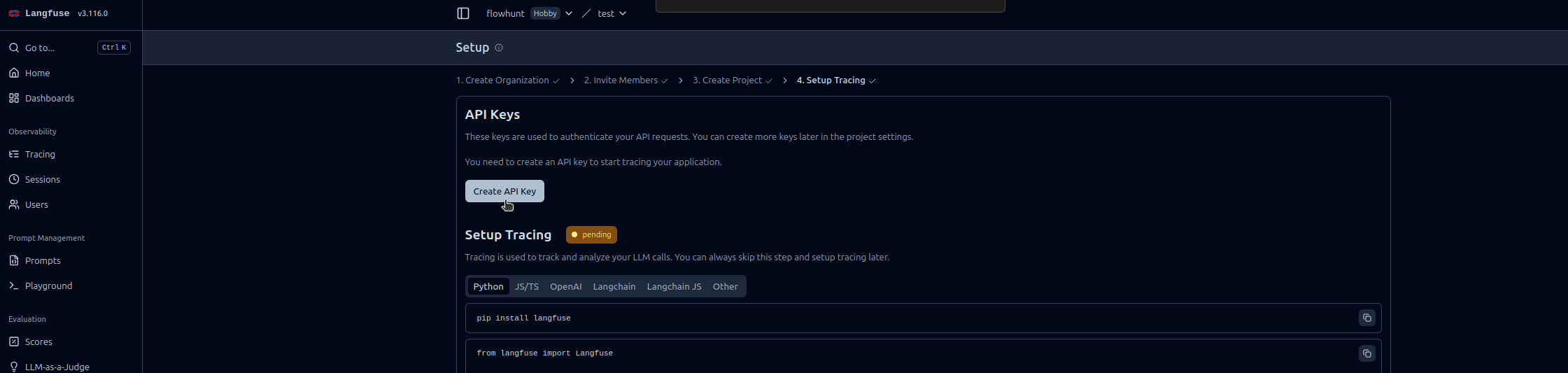

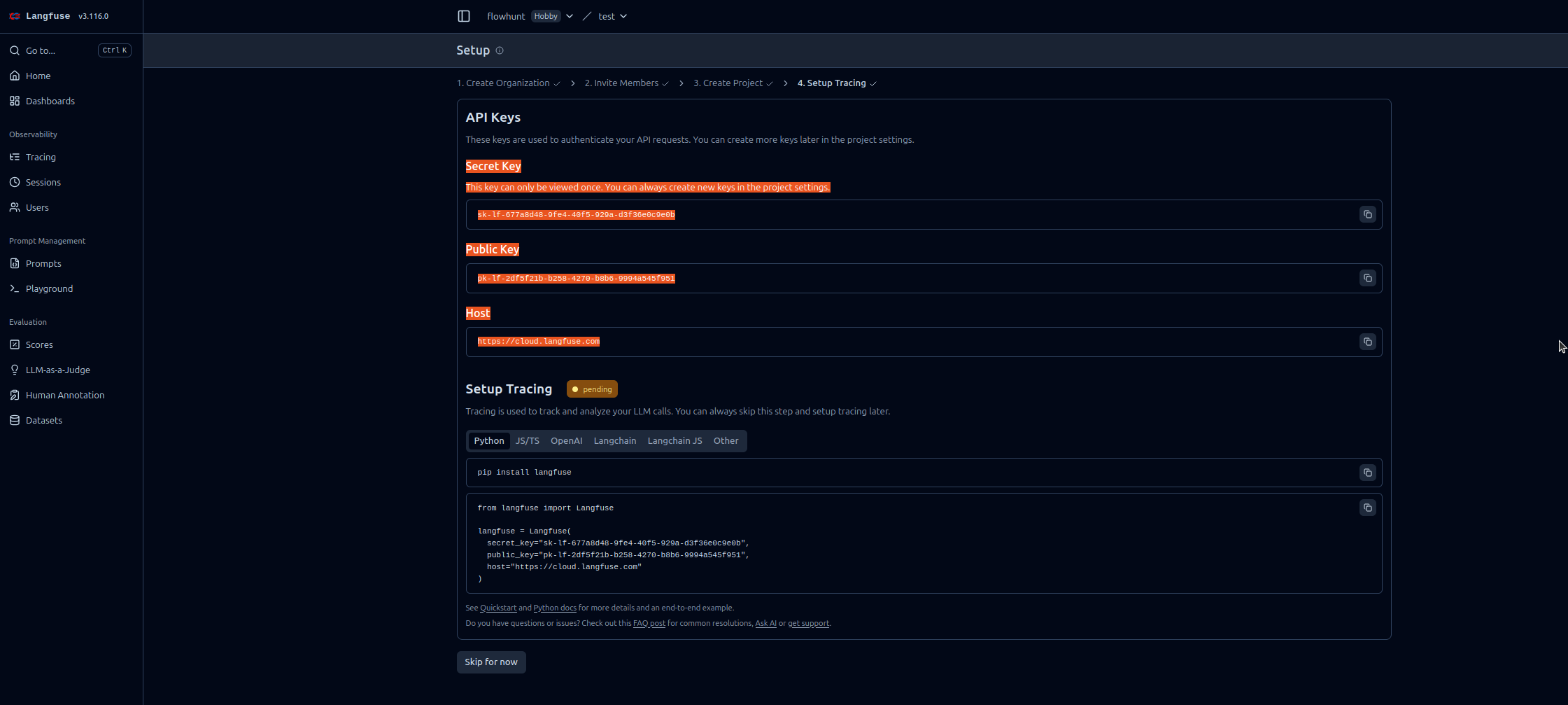

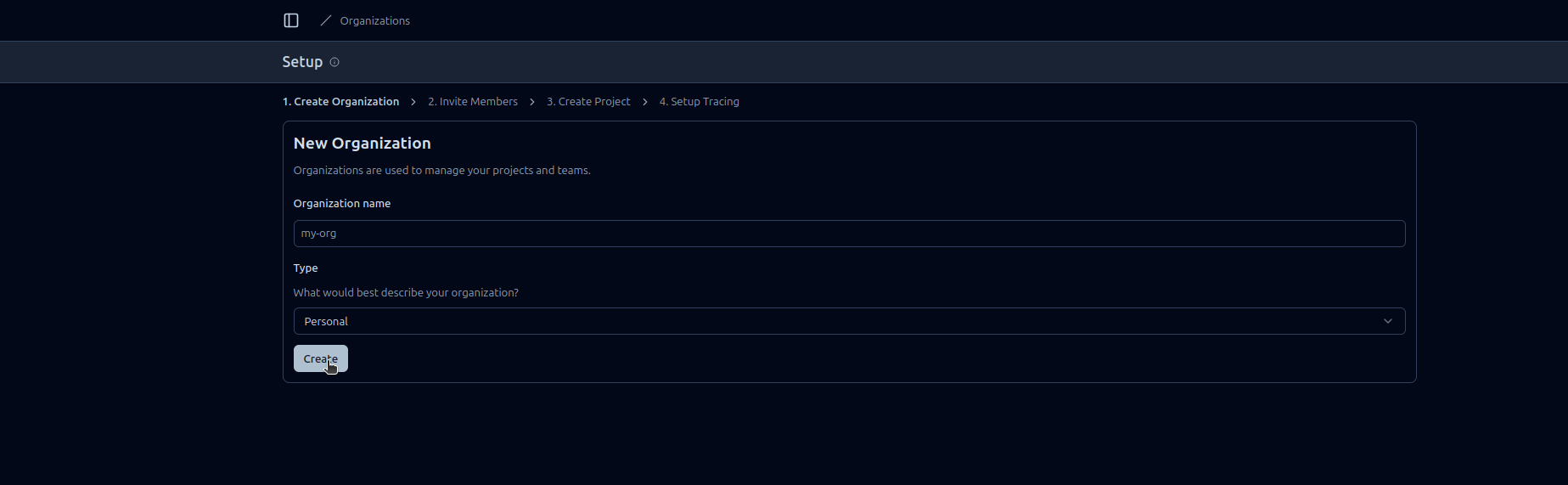

Volg deze stappen om FlowHunt Observatie in Langfuse in te schakelen:

https://cloud.langfuse.com)

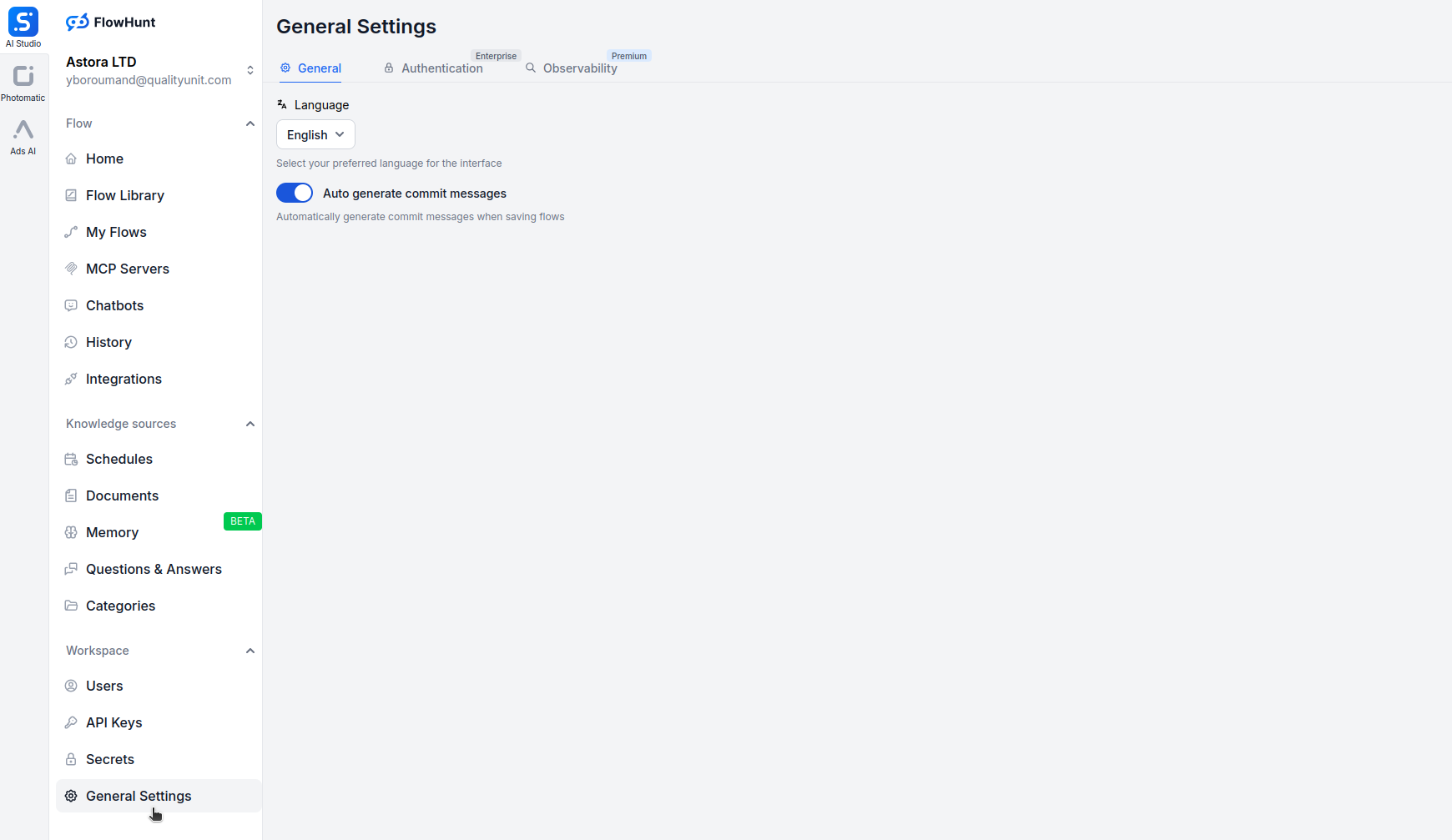

Open app.flowhunt.io in je browser.

Navigeer naar Algemene Instellingen (meestal bereikbaar via de zijbalk of het hoofdmenu).

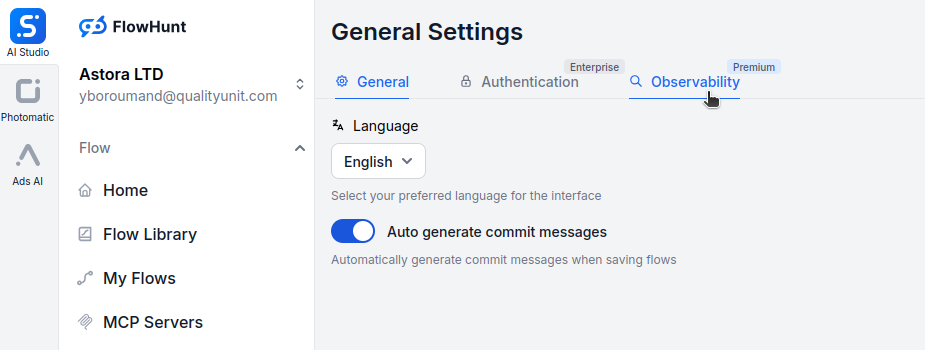

Scroll naar beneden en klik op het tabblad Observatie.

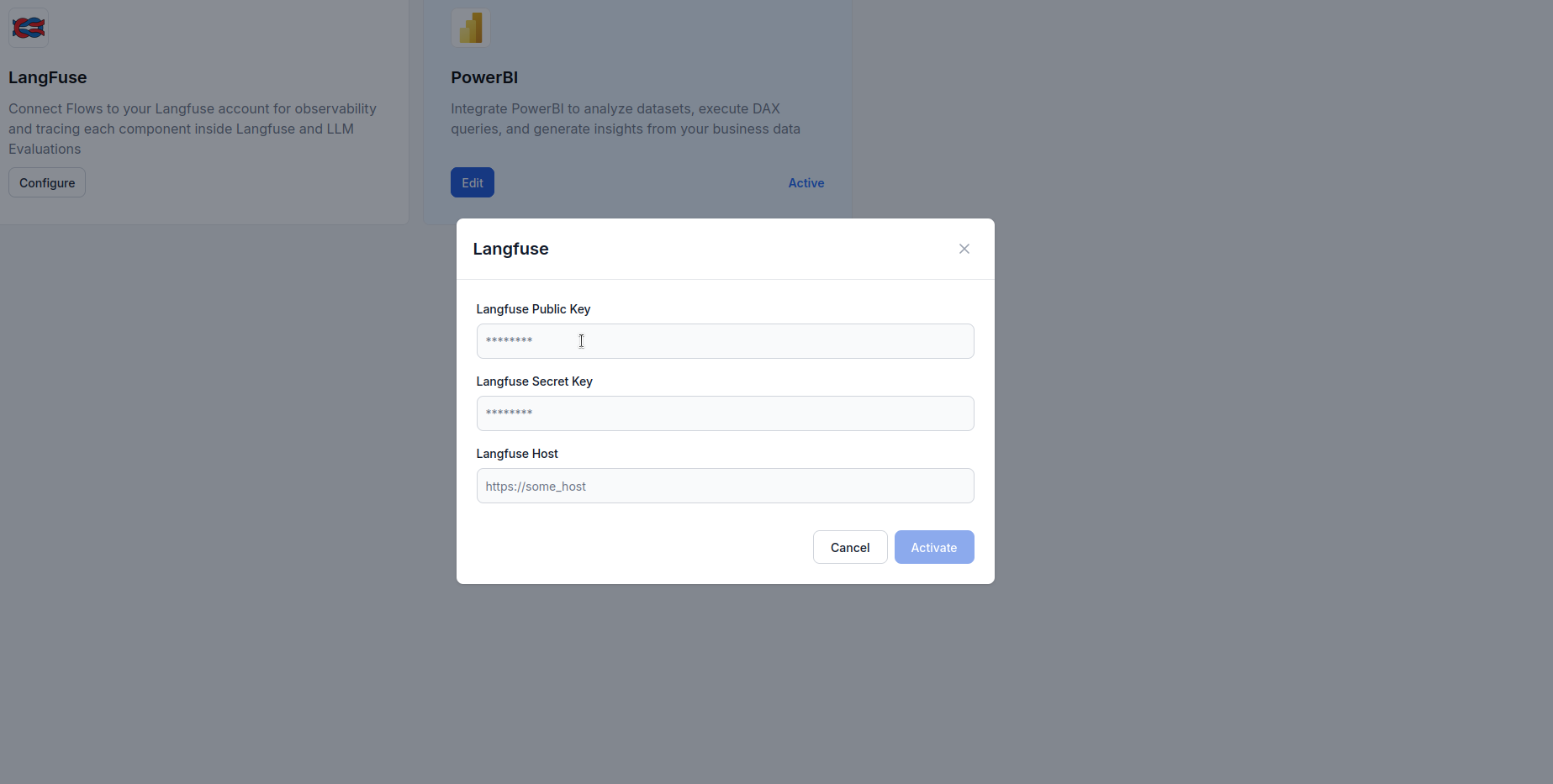

Zoek het Langfuse-vak en klik op Configure.

https://cloud.langfuse.com)

Zodra FlowHunt is verbonden met Langfuse, krijg je toegang tot krachtige visualisatie- en analysefuncties. Dit zijn voorbeelden van inzichten die je kunt genereren:

Bekijk een gedetailleerde tijdlijn van elke workflowuitvoering, met daarin:

Dit helpt knelpunten te vinden en workflowgedrag tot in detail te begrijpen.

Monitor het tokenverbruik over workflows:

Zo kun je kosten optimaliseren door tokenintensieve bewerkingen te identificeren.

Volg belangrijke prestatie-indicatoren:

Deze metrics helpen om SLA’s te waarborgen en gebruikerservaring te optimaliseren.

Fouten identificeren en diagnosticeren:

Dit versnelt troubleshooting en verhoogt de betrouwbaarheid.

Voor conversatie-AI-agents kun je bijhouden:

Dit helpt om agentgedrag en gebruikerservaring te optimaliseren.

Vergelijk prestaties bij verschillende LLM-providers:

Zo kun je modellen selecteren op basis van daadwerkelijke gebruiksgegevens.

De integratie van FlowHunt met Langfuse verandert je AI-workflows van black boxes in transparante, optimaliseerbare systemen. Dankzij uitgebreide tracing krijg je inzicht in elke uitvoeringsstap, zodat je datagedreven beslissingen kunt nemen over prestaties, kosten en betrouwbaarheid.

De Langfuse-observatie-integratie maakt monitoring eenvoudig — van simpele API-sleutelinstellingen tot rijke, bruikbare dashboards die precies laten zien hoe je workflows zich in productie gedragen.

Nu je FlowHunt-werkruimte is verbonden met Langfuse, heb je de basis voor continue verbetering: identificeer knelpunten, optimaliseer tokengebruik, verlaag latentie en zorg dat je AI-systemen maximale waarde leveren, met volledig vertrouwen.

Observatie in FlowHunt verwijst naar het vermogen om AI-workflows, agents en automatiseringen in realtime te monitoren, te traceren en te analyseren. Het helpt gebruikers knelpunten te detecteren, tokengebruik bij te houden, latentie te meten en datagedreven optimalisatiebeslissingen te nemen.

Langfuse is een open-source LLM-engineeringsplatform ontworpen voor tracing, monitoring en analyse van AI-toepassingen. Wanneer het wordt geïntegreerd met FlowHunt, biedt het gedetailleerd inzicht in workflow-uitvoering, tokenverbruik, modelprestaties en foutopsporing.

Nee, de integratie is eenvoudig. Je hoeft alleen een Langfuse-account aan te maken, API-sleutels te genereren en deze in de observatie-instellingen van FlowHunt te plakken. Er is geen codering vereist.

Zodra je bent verbonden, kun je uitvoeringstraces, tokengebruik, modelkosten, latentie, foutpercentages, workflowprestaties in de tijd en gedetailleerde stap-voor-stap analyses van je AI-agent-interacties volgen.

Langfuse biedt een gratis pakket dat basis tracing en observatiefuncties bevat. Voor grotere teams en geavanceerde analyses zijn er betaalde abonnementen met extra mogelijkheden.

Ontdek het belang van loggen in AI-workflows, hoe FlowHunt gedetailleerde logs mogelijk maakt voor tool-aanroepen en taken, en best practices voor het monitoren...

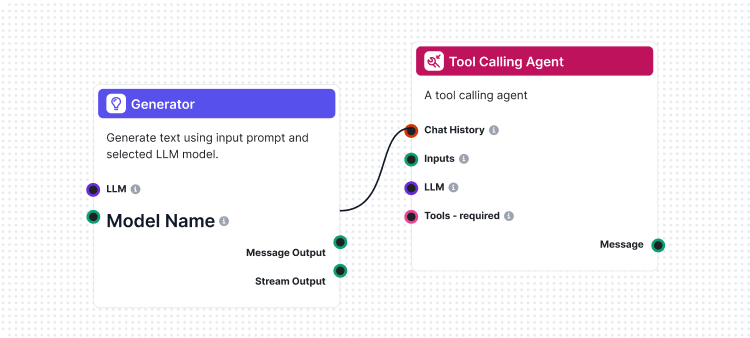

Flows zijn het brein achter alles in FlowHunt. Leer hoe je ze bouwt met een no-code visuele builder: van het plaatsen van het eerste component tot website-integ...

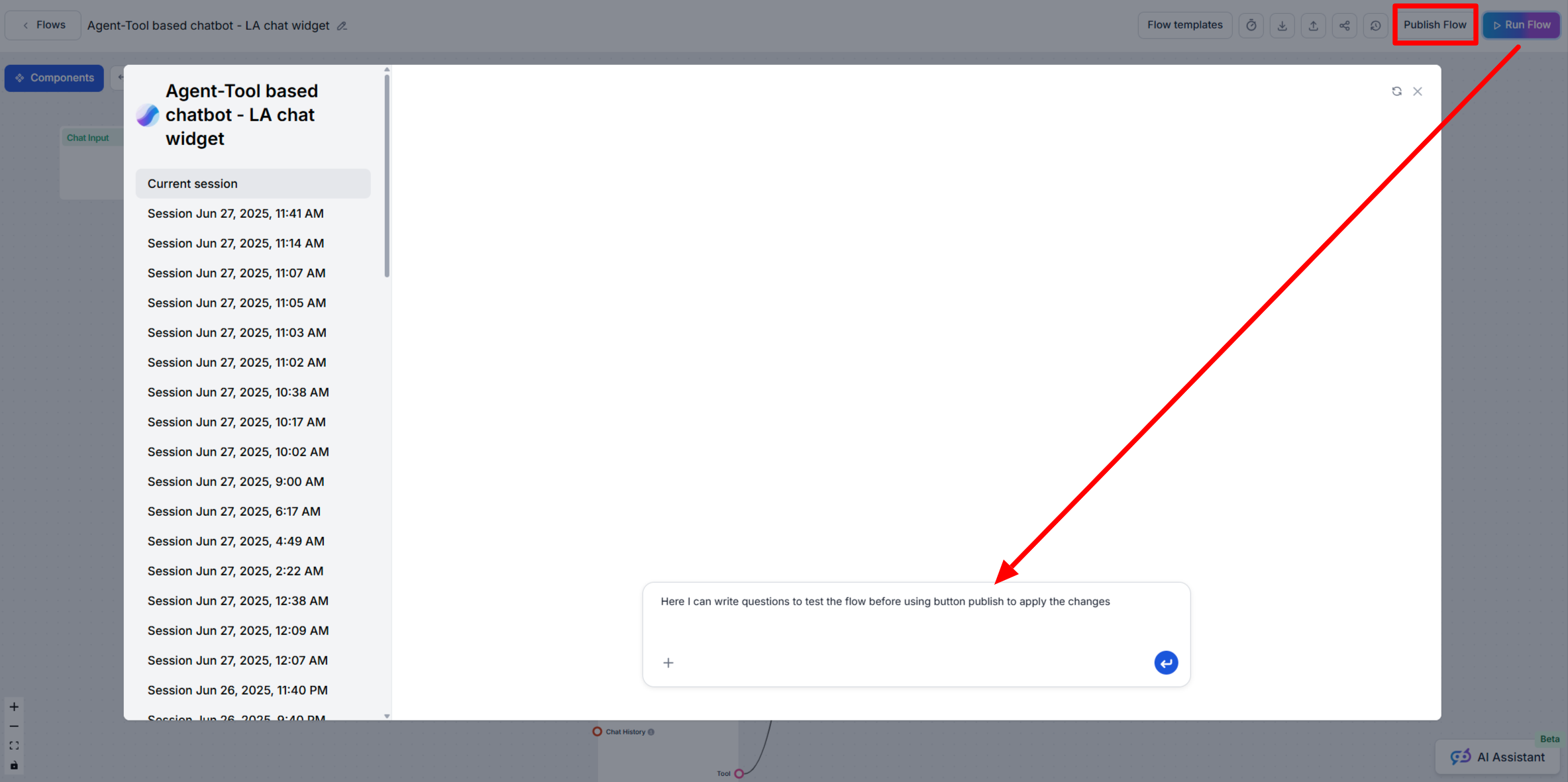

Leer wanneer je de functies Run Flow en Publish Flow in FlowHunt AIStudio gebruikt om je AI-workflows veilig te testen en uit te rollen.

Cookie Toestemming

We gebruiken cookies om uw browse-ervaring te verbeteren en ons verkeer te analyseren. See our privacy policy.