Gdzie i jak zacząć z AI w e-commerce: Praktyczny plan działania

Praktyczne ramy wdrażania AI w e-commerce od CMO Quality Unit. Dowiedz się, od czego zacząć, jakie są typowe wyzwania, strategie przygotowania treści i realisty...

Przewodnik technicznego założyciela po implementacji protokołów handlu AI (UCP, ACP, AP2), opanowaniu podstaw technicznego SEO i generowaniu treści zoptymalizowanych zarówno pod tradycyjne wyszukiwarki, jak i cytowania AI.

Viktor Zeman był współzałożycielem Quality Unit ponad dwie dekady temu i prowadził rozwój oraz globalny wzrost pakietu produktów, w tym FlowHunt. Od 2024 roku koncentruje się specjalnie na FlowHunt i pomocy firmom we wdrażaniu praktycznych rozwiązań AI, automatyzacji i nowoczesnych środowisk pracy opartych na AI. Jego prezentacja na E-commerce Mastermind zagłębiła się w trzy kluczowe obszary technicznej implementacji AI w e-commerce.

Prezentacja szczegółowo opisała konkretne protokoły, implementacje techniczne i strategie treści testowane w produktach Quality Unit i bazie klientów. To, co następuje, to techniczny plan działania Viktora, jak uczynić strony e-commerce wykrywalnymi przez systemy AI, funkcjonalnymi w handlu mediowanym przez AI i konkurencyjnymi, gdy wyszukiwanie przesuwa się ze słów kluczowych na cytowania AI.

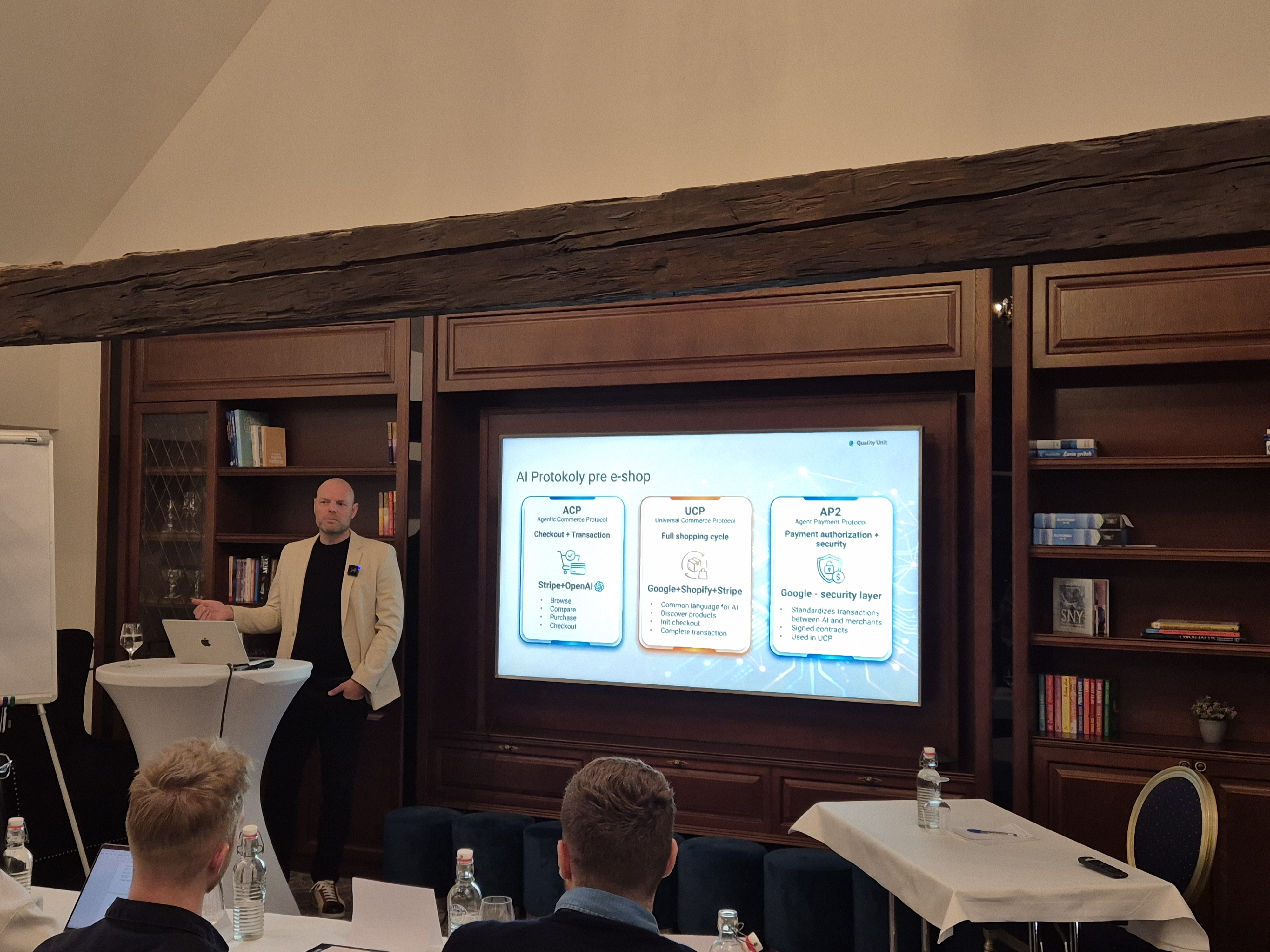

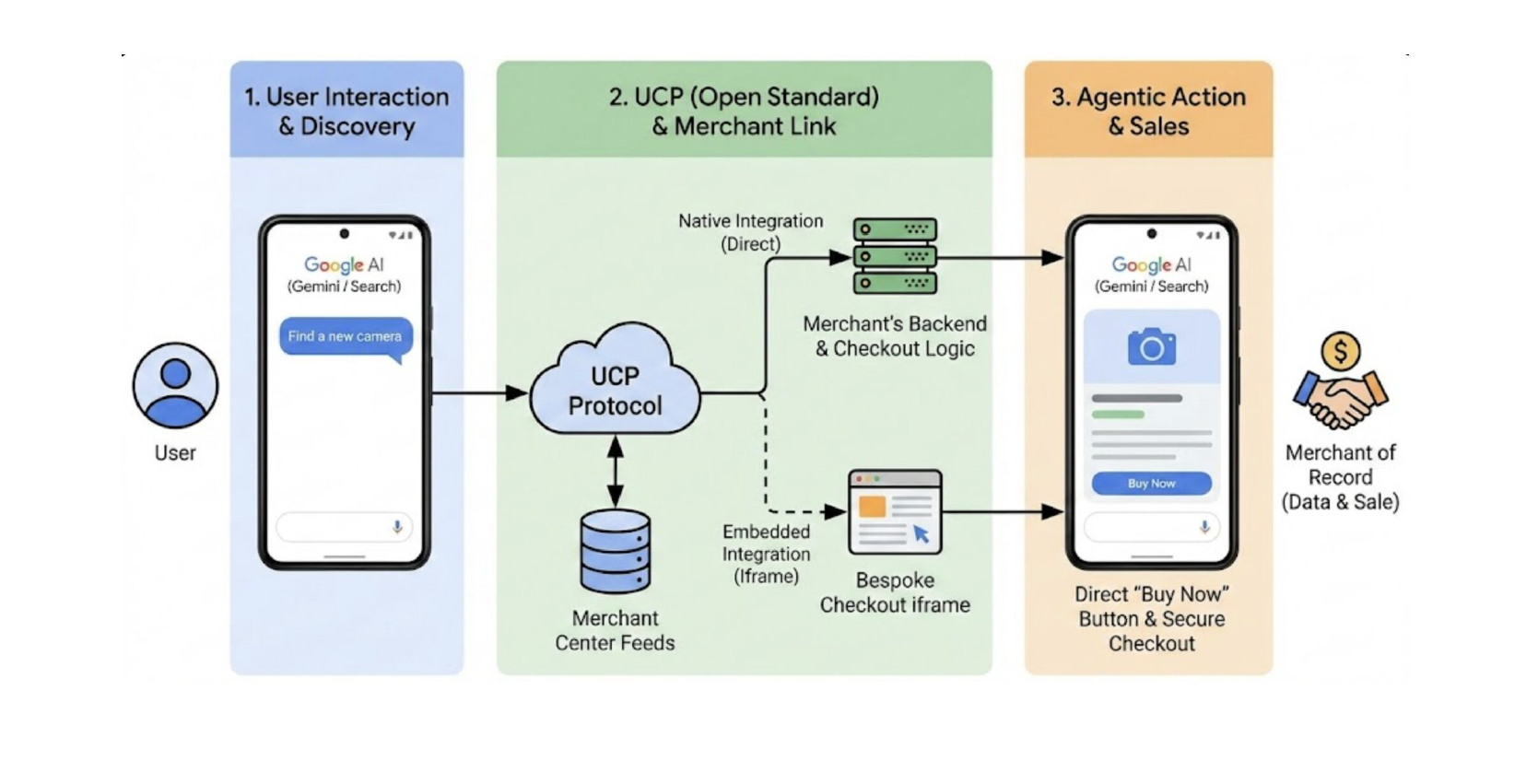

Viktor położył fundamenty, wprowadzając standaryzowane protokoły, które umożliwiają AI interakcję z systemami e-commerce w imieniu użytkowników.

Główne platformy, takie jak Shopify, Salesforce Commerce Cloud czy BigCommerce, już zaczęły wdrażać części tych protokołów. Podobnie zrobiły procesory płatności Stripe, PayPal i Checkout.com. To wyraźnie pokazuje, że kompatybilność z handlem AI staje się konkurencyjną bazą.

Universal Commerce Protocol (UCP) umożliwia asystentom AI odkrywanie produktów, porównywanie opcji, inicjowanie procesu zakupu i finalizowanie transakcji bez opuszczania przez użytkowników interfejsu AI. UCP jest już wdrożony w Shopify, Salesforce Commerce Cloud, BigCommerce i głównych procesorach płatności.

Agentic Commerce Protocol (ACP), współpraca między Stripe i OpenAI, koncentruje się specjalnie na bezpieczeństwie transakcji i prostocie w interfejsach konwersacyjnych. Podczas gdy UCP zajmuje się szerszym cyklem zakupowym, ACP specjalizuje się w procesie zakupu, ponieważ umożliwia finalizację zakupu bezpośrednio w interfejsach czatu.

Agent Payment Protocol (AP2), opracowany przez Google, zapewnia ramy bezpieczeństwa, które sprawiają, że transakcje mediowane przez AI są godne zaufania poprzez podpisywanie transakcji, uwierzytelnianie sprzedawców i autoryzację płatności. AP2 integruje się z UCP, aby zapewnić warstwę zaufania, która czyni autonomiczne zakupy AI rzeczywistością.

Aby Twój e-sklep stał się kompatybilny z zakupami kierowanymi przez AI, a tym samym rekomendowany przez platformy AI, musisz udostępnić dane czytelne maszynowo na wielu poziomach:

Produkty muszą być opisane przy użyciu standardów, takich jak:

schema.org: Daj AI ustrukturyzowane dane, które może odczytać i zrozumiećPozwala to systemom AI interpretować produkty bez dwuznaczności, w tym warianty, ceny, dostępność i ograniczenia wysyłki. To fundament, którego systemy AI używają do zrozumienia, co sprzedajesz.

Agenci AI nie oceniają tylko produktów, oceniają również, czy sprzedawcy są godni zaufania i dobrze pasują do użytkownika. Dlatego kluczowe informacje o Twojej firmie muszą być jasne i dostępne:

Wiele z tych danych już istnieje w systemach takich jak Google Merchant Center, ale muszą być kompletne, dokładne i konsekwentnie utrzymywane.

Jednym z mniej widocznych, ale krytycznych komponentów jest manifest handlowy. To zazwyczaj plik JSON hostowany w domenie sprzedawcy.

Ten manifest definiuje obsługiwane wersje protokołów, dostępne usługi, procedury obsługi płatności i możliwości finalizacji zakupu, pomagając Agentom AI zrozumieć, jak działa Twój sklep.

Zaimplementuj trzy krytyczne punkty końcowe:

Zaimplementuj wspomniany wcześniej Agent Payment Protocol dla bezpiecznej obsługi transakcji.

Dla platform bez natywnego wsparcia UCP, MCP zapewnia ścieżkę integracji. Zeman podkreślił rosnące znaczenie MCP jako warstwy łączącej między agentami AI a istniejącymi systemami.

Opracowanie niestandardowego serwera MCP umożliwia tworzenie precyzyjnych promptów dostosowanych do konkretnych przypadków użycia i wysyłanie izolowanych wywołań API z odpowiednim ograniczaniem szybkości. W ten sposób możesz mieć pewność, że Twoja implementacja AI będzie bezpieczna, kontrolowana i jak najtańsza.

Przykład: Chatbot zintegrowany z MCP e-commerce i dostawcą wysyłki (np. Chameleon) umożliwia klientom nie tylko zapytanie o status zamówienia, ale także śledzenie dostawy w czasie rzeczywistym, wszystko w ramach jednej rozmowy.

Drugim tematem implementacji, który Viktor omówił, było techniczne SEO. Zadbał o podkreślenie, że kamieniem węgielnym SEO nie są słowa kluczowe. To “infrastruktura, do której mogą uzyskać dostęp i zaufać zarówno wyszukiwarki, jak i systemy AI”. Ponieważ wolne i niewiarygodne strony są porzucane zarówno przez użytkowników, jak i crawlery.

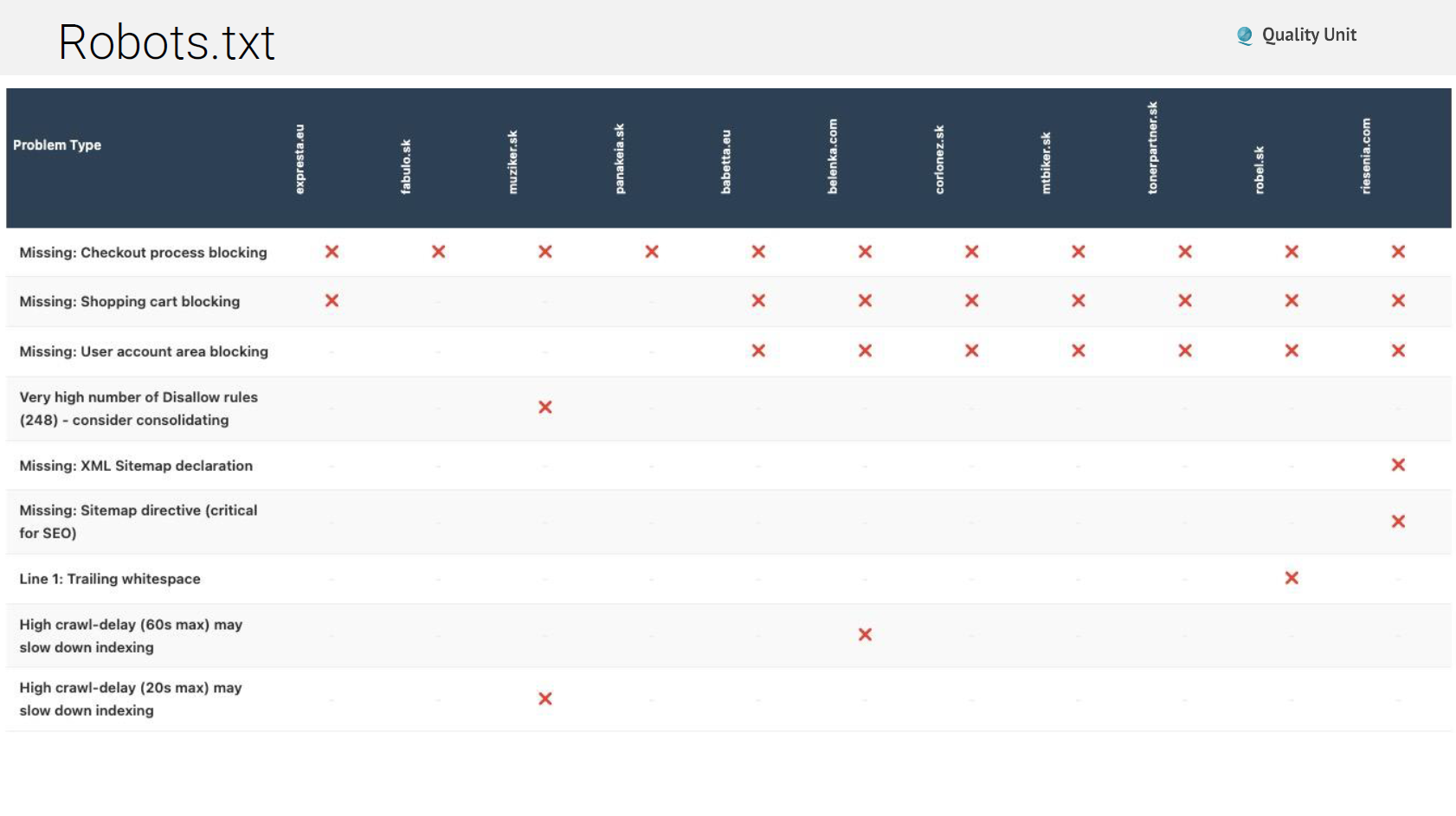

Pomimo bycia 30-letnim standardem, robots.txt pozostaje często źle skonfigurowany. Typowe problemy obejmują:

Nieistniejący robots.txt: Niektóre strony zwracają strony błędów lub komunikaty o konserwacji zamiast odpowiednich plików robots.txt, dezorientując crawlery co do tego, co jest dozwolone.

Zablokowane boty AI: Blokowanie crawlerów AI uniemożliwia cytowanie Twoich treści w odpowiedziach AI. Chociaż możesz chcieć zablokować niektóre boty, całkowite blokowanie eliminuje widoczność AI.

Brakujące dyrektywy mapy witryny: Robots.txt powinien odwoływać się do Twoich map witryn XML, prowadząc crawlery do kompletnego odkrywania treści.

Błędy składniowe: Końcowe przecinki w znakach wieloznacznych (Disallow: /?pv=*,) powodują błędy parsowania w niektórych crawlerach, tworząc niezamierzone blokowanie.

Zablokowana wartościowa treść: Czasami strony blokują treści, które faktycznie chcą indeksować, zwykle poprzez zbyt szerokie reguły ze znakami wieloznacznymi.

Mapy witryn XML informują wyszukiwarki i systemy AI, jakie treści istnieją i jak są zorganizowane. Typowe problemy w tym obszarze obejmują:

Problemy z nagłówkami cache: Nieprawidłowe nagłówki cache mogą uniemożliwić prawidłową aktualizację map witryn, pozostawiając crawlery z nieaktualnymi listami treści.

Niekompletne pokrycie URL: Mapy witryn generowane przez wtyczki często pomijają niestandardowe typy postów, taksonomie lub strony dynamiczne, pozostawiając znaczną treść nieodkrytą.

Problemy z ograniczaniem szybkości: Niektóre strony implementują agresywne ograniczanie szybkości, które całkowicie blokuje pobieranie mapy witryny, zwracając błędy 429 po zaledwie 10 URL.

Linki do stron 404: Mapy witryn zawierające martwe linki marnują budżet crawlera i sygnalizują słabą konserwację strony.

Odpowiednie nagłówki cache HTTP dramatycznie poprawiają wydajność dla powracających odwiedzających i zmniejszają obciążenie serwera. Jednak wiele stron całkowicie to źle konfiguruje. Dyrektywy Cache-Control mają znaczenie:

Viktor podkreślił sprawdzanie nagłówków cache dla wszystkich typów zasobów: HTML, CSS, JavaScript, obrazów, czcionek i odpowiedzi API.

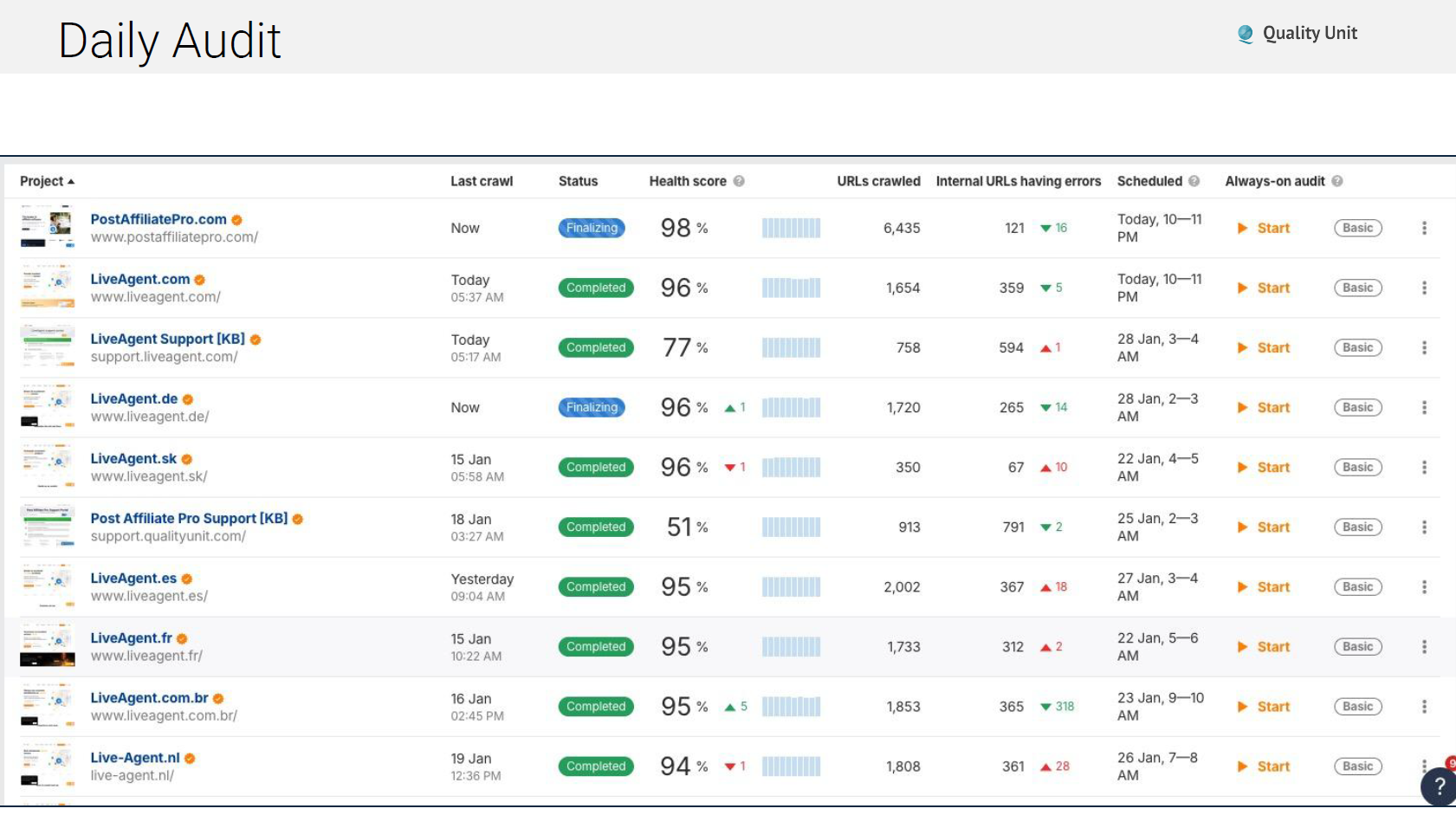

Problemy techniczne pojawiają się nieustannie i dlatego nasz zespół przeprowadza zautomatyzowane codzienne audyty sprawdzające:

Korzystanie z narzędzi takich jak Ahrefs do zautomatyzowanego monitorowania zapewnia, że problemy są wykrywane i naprawiane, zanim narosną w poważne straty ruchu:

Core Web Vitals Google bezpośrednio wpływają na rankingi. Powinieneś skupić się głównie na tych dwóch krytycznych narzędziach: PageSpeed Insights dostarcza dane laboratoryjne pokazujące potencjalną wydajność w kontrolowanych warunkach. Chrome User Experience Report (CrUX) dostarcza dane z rzeczywistego świata od rzeczywistych użytkowników odwiedzających Twoją stronę.

Trzy krytyczne metryki do obserwacji to:

Oznaczenie Schema.org przekształca HTML w ustrukturyzowane dane czytelne maszynowo. Zarówno tradycyjne wyszukiwarki, jak i systemy AI polegają na schema, aby zrozumieć kontekst treści i relacje.

Podstawowe typy schema dla e-commerce:

Typowe błędy implementacji schema obejmują:

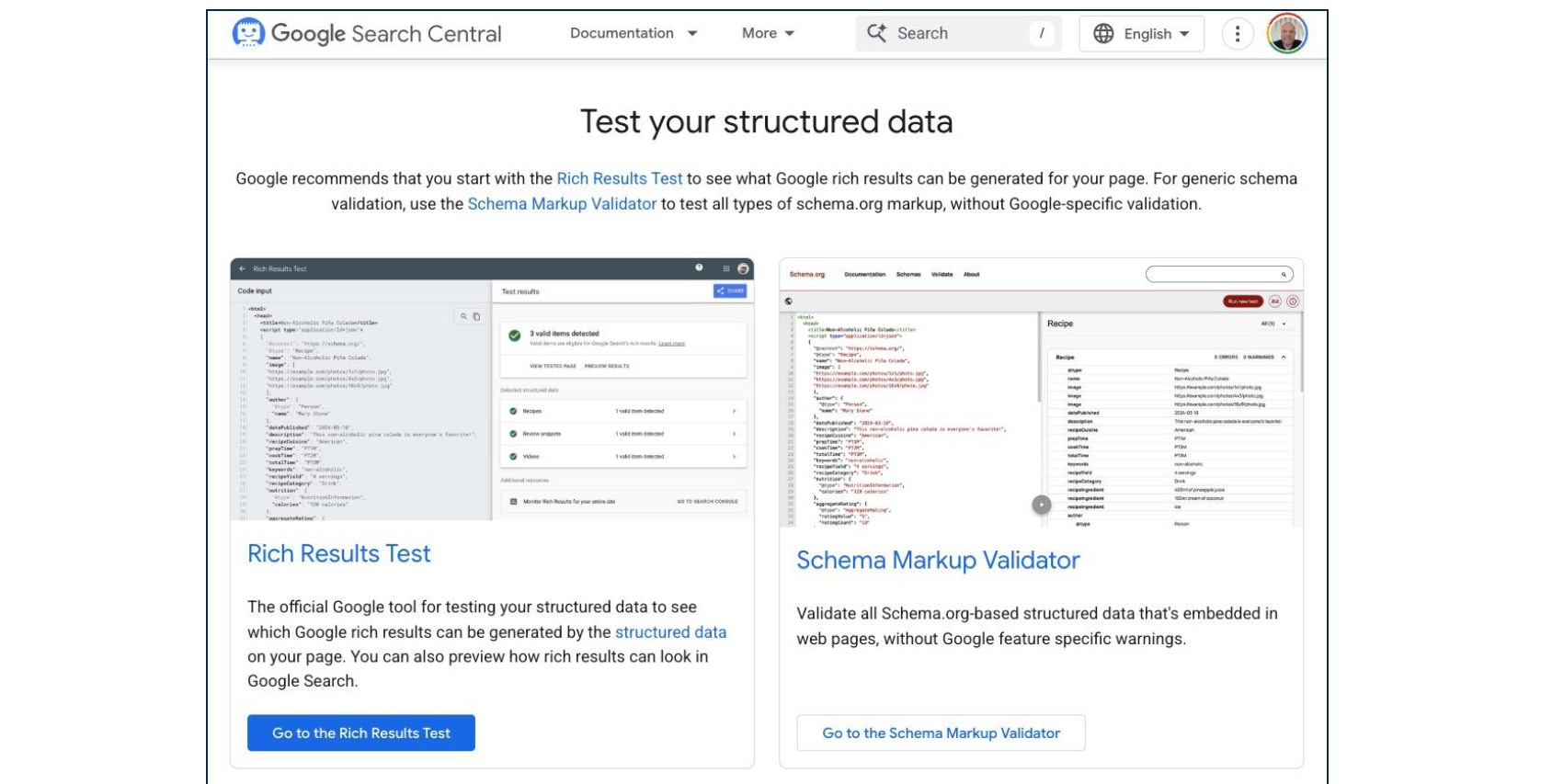

Regularna walidacja poprzez Google Rich Results Test zapewnia, że schema pozostaje prawidłowo ustrukturyzowane i kompletne.

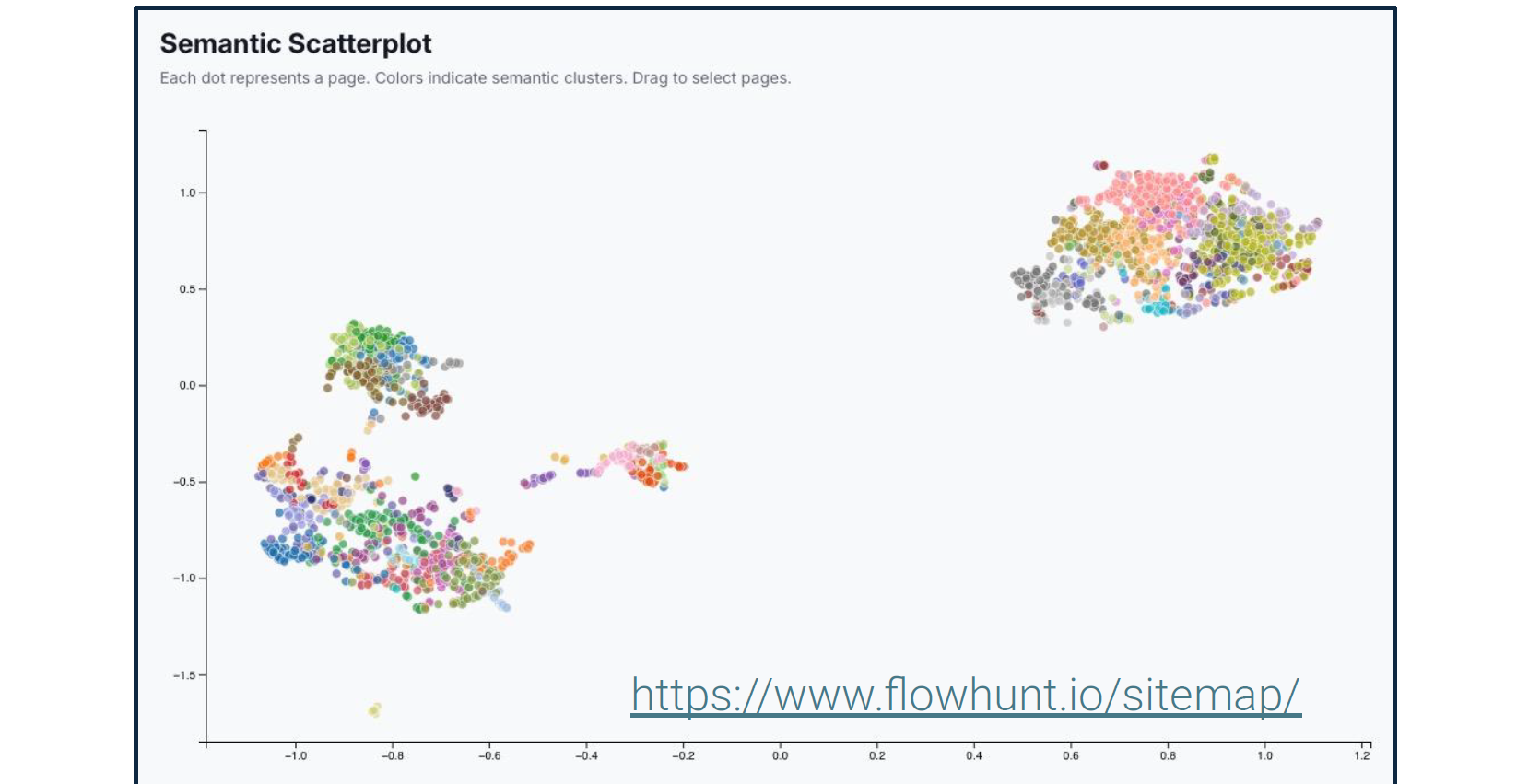

Viktor wielokrotnie podkreślał, że SEO nie polega już na słowach kluczowych. Szczegółowo opisał narzędzia analizy semantycznej, które ujawniają, jak wyszukiwarki i systemy AI rozumieją znaczenie Twojej treści, a nie tylko słowa.

Te narzędzia wizualizują relacje encji, pokrycie tematów i połączenia semantyczne w Twojej treści. Systemy AI używają tych relacji do określenia, kiedy Twoja treść odpowiada na konkretne zapytania, nawet gdy dokładne słowa kluczowe nie pojawiają się.

Podczas gdy tradycyjne SEO pytało: “Czy ta strona zawiera odpowiednie słowa kluczowe?” Nowoczesne SEO pyta: “Czy ta strona demonstruje wiedzę specjalistyczną o istotnych encjach i ich relacjach?”

“Google nie dba o to, czy mówisz, że jesteś ‘Najszybszym warsztatem naprawy telefonów w Bratysławie’. Pyta, czy Twoja strona pokazuje wiedzę specjalistyczną o encji ’telefon’ w relacji do encji ’naprawa’ i ‘Bratysława’. Czy inne źródła potwierdzają wiedzę specjalistyczną o tych encjach? Na przykład recenzje lub natywne reklamy. Czy zachowanie użytkownika, takie jak czas spędzony na stronie, sygnalizuje, że treść jest istotna?” - Viktor Zeman

Dalej podkreśla, że powinieneś zacząć od szybkich zwycięstw, takich jak naprawienie niektórych problemów technicznego SEO. Wyniki powinny pojawić się w mgnieniu oka. Dopiero gdy AI i wyszukiwarki będą mogły prawidłowo odczytywać i rozumieć Twoją stronę, nadejdzie czas na rozpoczęcie tworzenia treści bogatych w słowa kluczowe.

Viktor zakwestionował konwencjonalną mądrość dotyczącą budowania linków, argumentując, że struktura linków wewnętrznych zasługuje na znacznie więcej uwagi, niż większość stron jej poświęca.

Dystrybucja PageRank: Google (i coraz częściej systemy AI) przepływa autorytetem poprzez linki. Twoja wewnętrzna struktura linków określa, które strony otrzymują ten autorytet.

Koncentracja link juice: Linki ze stron o wysokim ruchu przynoszą większą wartość niż linki ze stron rzadko odwiedzanych. Strategiczne linkowanie wewnętrzne wzmacnia wpływ Twojej najpopularniejszej treści.

Kontekst poprzez tekst kotwicy: Słowa używane w linkach sygnalizują relacje tematyczne zarówno wyszukiwarkom, jak i systemom AI.

Hierarchia umiejscowienia: Linki w głównej treści mają większą wagę niż linki w stopce lub nawigacji.

Na naszych stronach nie walczymy z wiatrakami, próbując skalować i utrzymywać spójne ręczne linki wewnętrzne. Zamiast tego wdrożyliśmy zautomatyzowane linkowanie wewnętrzne na dużą skalę. Ta automatyzacja uwzględnia:

Rezultatem jest kompleksowa struktura linków wewnętrznych, której utrzymanie ręcznie byłoby niemożliwe, zapewniając jednocześnie, że każdy element treści łączy się logicznie z powiązanymi tematami.

Podejście Viktora do generowania treści AI koncentruje się na systematycznej strukturze, a nie na doraźnym tworzeniu artykułów.

Przed generowaniem treści zrozum, jak systemy AI obecnie omawiają Twoją branżę: Krok 1: Generuj prompty testowe - Utwórz ponad 500 pytań reprezentujących sposób, w jaki użytkownicy mogą zadawać pytania systemom AI o tematy w Twojej domenie. Krok 2: Analizuj odpowiedzi AI - Użyj narzędzi takich jak AmICited.com, aby zobaczyć, które źródła systemy AI obecnie cytują, odpowiadając na te prompty.

To ujawni:

Krok 3: Zidentyfikuj luki - Znajdź pytania, na które systemy AI dostarczają słabe odpowiedzi lub cytują słabe źródła. Te reprezentują możliwości stania się autorytatywnym cytowaniem.

Opisy produktów zoptymalizowane pod AI przynoszą korzyści trzem krytycznym kanałom:

Zamiast ogólnej “treści blogowej”, Viktor opowiada się za tworzeniem wyspecjalizowanych agentów AI do generowania każdego odrębnego typu postu, każdy z określonymi elementami i strukturą. Na przykład słownik, listy kontrolne, posty instruktażowe, dokumentacja funkcji, ale także wielokrotnego użytku frameworki blogowe, takie jak analiza, spostrzeżenia, komentarz branżowy.

Chociaż ogólny Agent AI z naprawdę dobrym promptem może trafić złoto za pierwszym razem, to nie jest to, czego potrzebujesz. Szukasz skali i powtarzalnych dokładnych przepływów pracy. Pisanie nowych promptów dla agentów za każdym razem, mając nadzieję, że zadziałają, a następnie zapisywanie promptów w notatniku nie da ci tego. Ręczne kopiowanie tego samego promptu, aby uzyskać pojedyncze wyjście, nie będzie skalowalne.

To, co musisz zrobić, to stworzyć wysoce wyspecjalizowanego Agenta AI, który będzie działał bezbłędnie konsekwentnie i na dużą skalę. Każdy typ postu wymaga dedykowanego agenta AI skonfigurowanego z określonymi szablonami promptów, regułami formatowania i wymaganiami strukturalnymi.

Obejmuje to jasne zdefiniowanie każdej sekcji typu postu. Na przykład dla elementu tytułu Viktor zaleca dodanie tej struktury do promptu:

Viktor krótko nakreślił dokładny proces, którego używa nasz zespół:

Generuj bibliotekę promptów: Utwórz ponad 500 promptów reprezentujących zapytania użytkowników w Twojej domenie, używając AmICited.com lub podobnych narzędzi.

Analizuj wzorce cytowań: Zrozum obecne zachowanie AI dla tych promptów i znajdź możliwości. Dowiedz się, co jest cytowane, czego brakuje, co jest słabe.

Buduj wyspecjalizowanych agentów: Utwórz agentów AI w FlowHunt (lub podobnych platformach) dla każdego typu postu z określonymi elementami i ograniczeniami.

Generuj systematycznie: Produkuj treści na dużą skalę, używając wyspecjalizowanych agentów dla każdego typu postu, utrzymując spójną strukturę i jakość.

Implementuj linkowanie semantyczne: Użyj algorytmów podobieństwa semantycznego, aby automatycznie sugerować i tworzyć połączenia powiązanych artykułów.

Monitoruj i udoskonalaj: Śledź, które treści są cytowane przez systemy AI i udoskonalaj swoje podejście na podstawie rzeczywistych danych o cytowaniach.

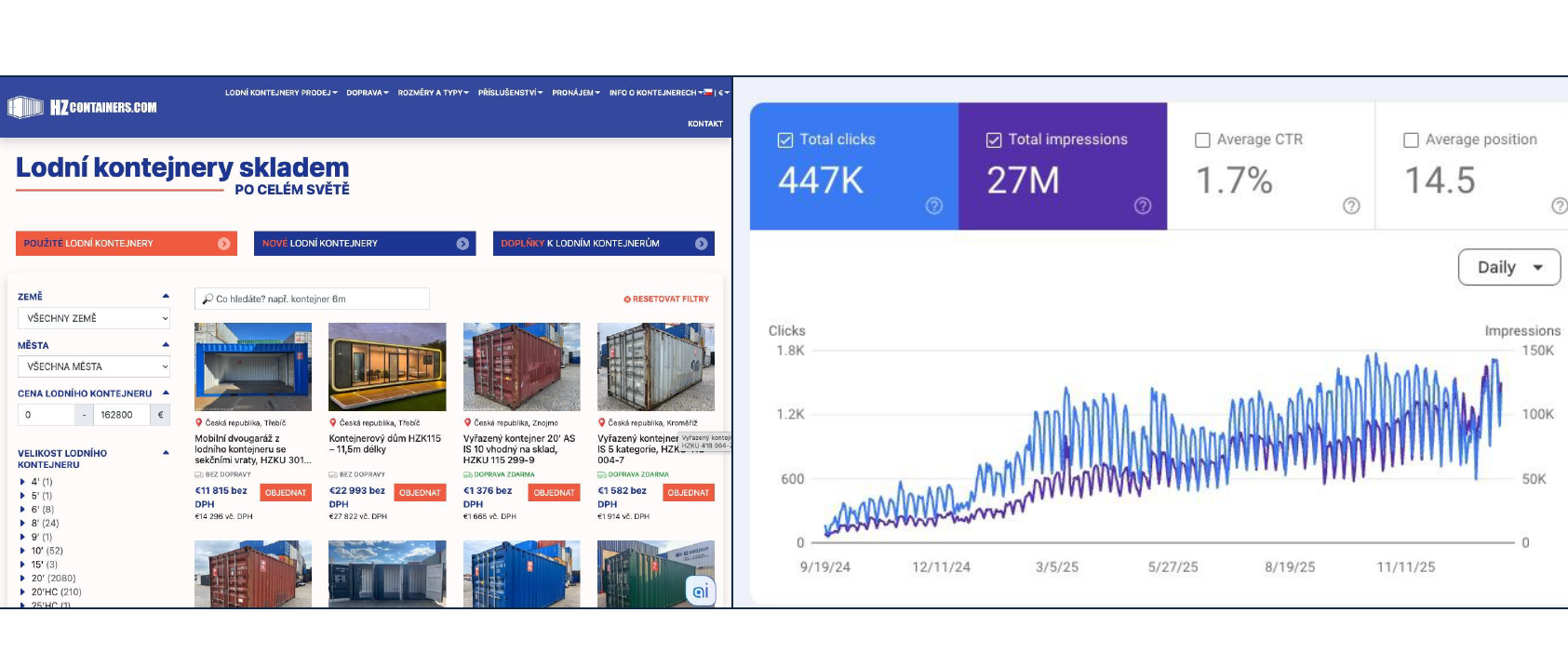

Wzrost ruchu o 18 000% (180x) od stycznia do września 2025, dostarczając 2000 kontenerów. Podejście opiera się na fundamentach technicznego SEO, kompleksowej treści odpowiadającej na wszystkie pytania, odpowiednim oznakowaniu schema, ustrukturyzowanych typach postów i zautomatyzowanym linkowaniu wewnętrznym. Bez wypychania słów kluczowych czy schematów linkowania.

Viktor podkreślił fundamentalną transformację zachodzącą w sposobie, w jaki ludzie znajdują i oceniają produkty online. Google bierze pod uwagę setki czynników rankingowych. Oto tylko częściowa lista ilustrująca złożoność:

Rzeczywistość jest taka, że każda poprawa przyczynia się tylko do promila (tysięcznych) zysku. Osiągnięcie znaczących popraw w rankingu zajmuje miesiące ciągłej optymalizacji w dziesiątkach czynników jednocześnie. Tradycyjne SEO pozostaje ważne, ale reprezentuje żmudne, przyrostowe podejście do widoczności.

Generative Engine Optimization koncentruje się na cytowaniu przez systemy AI, gdy użytkownicy zadają pytania istotne dla Twojej firmy.

Kluczowe różnice w porównaniu z tradycyjnym SEO:

Oto szybki przegląd kluczowych narzędzi i mapy drogowej implementacji.

Viktor zalecił konkretną sekwencję implementacji: Faza 1: Fundament Techniczny (Tygodnie 1-4) • Audyt i optymalizacja infrastruktury • Konfiguracja Robots.txt i mapy witryny • Implementacja nagłówków cache • Poprawa Core Web Vitals • Oznaczenie Schema.org dla istniejących stron Faza 2: Struktura Treści (Tygodnie 5-8) • Zdefiniuj typy postów i ich elementy • Utwórz wyspecjalizowanych agentów AI dla każdego typu • Ustanów automatyzację linkowania wewnętrznego • Implementuj systemy podobieństwa semantycznego Faza 3: Generowanie Treści (Tygodnie 9-16) • Generuj bibliotekę promptów (ponad 500 promptów) • Analizuj obecne wzorce cytowań • Rozpocznij systematyczne tworzenie treści • Monitoruj wydajność cytowań AI • Udoskonalaj na podstawie danych Faza 4: Implementacja Protokołów (W toku) • Implementuj UCP/ACP/AP2, jeśli dotyczy • Opracuj niestandardowe serwery MCP dla integracji • Testuj funkcjonalność handlu AI • Rozszerzaj w oparciu o adopcję

To nie jest strategia szybkiego zwycięstwa. Techniczne SEO, kompleksowa treść i implementacja protokołów AI wymagają ciągłych inwestycji przez miesiące.

Jednak wyniki się kumulują. Każdy element prawidłowo ustrukturyzowanej treści zwiększa Twój autorytet. Każda poprawa techniczna zwiększa efektywność wszystkich Twoich treści. Każde cytowanie przez systemy AI zwiększa prawdopodobieństwo przyszłych cytowań. Pytanie nie brzmi, czy inwestować w tę infrastrukturę—ale czy przewodzić transformacji, czy podążać później, gdy konkurenci już ustanowili autorytet w odkrywaniu mediowanym przez AI.

Dla technicznych liderów e-commerce ten framework oferuje jasność. Musisz zacząć od budowania odpowiednich fundamentów technicznych, implementacji protokołów handlu AI, systematycznego strukturyzowania treści i optymalizacji zarówno pod tradycyjne wyszukiwanie, jak i cytowania AI jednocześnie. Infrastruktura, którą budujesz dzisiaj, określa wykrywalność, gdy użytkownicy pytają systemy AI o rekomendacje jutro.

Prezentacja techniczna Viktora uzupełnia perspektywy strategiczne i operacyjne z wcześniejszych części serii konferencyjnej.

Mapa drogowa implementacji Michala Lichnera ustanowiła, gdzie skupić implementację AI i jak systematycznie przygotować treści. Prezentacja Zemana dostarcza infrastruktury technicznej, która czyni tę treść wykrywalną i funkcjonalną.

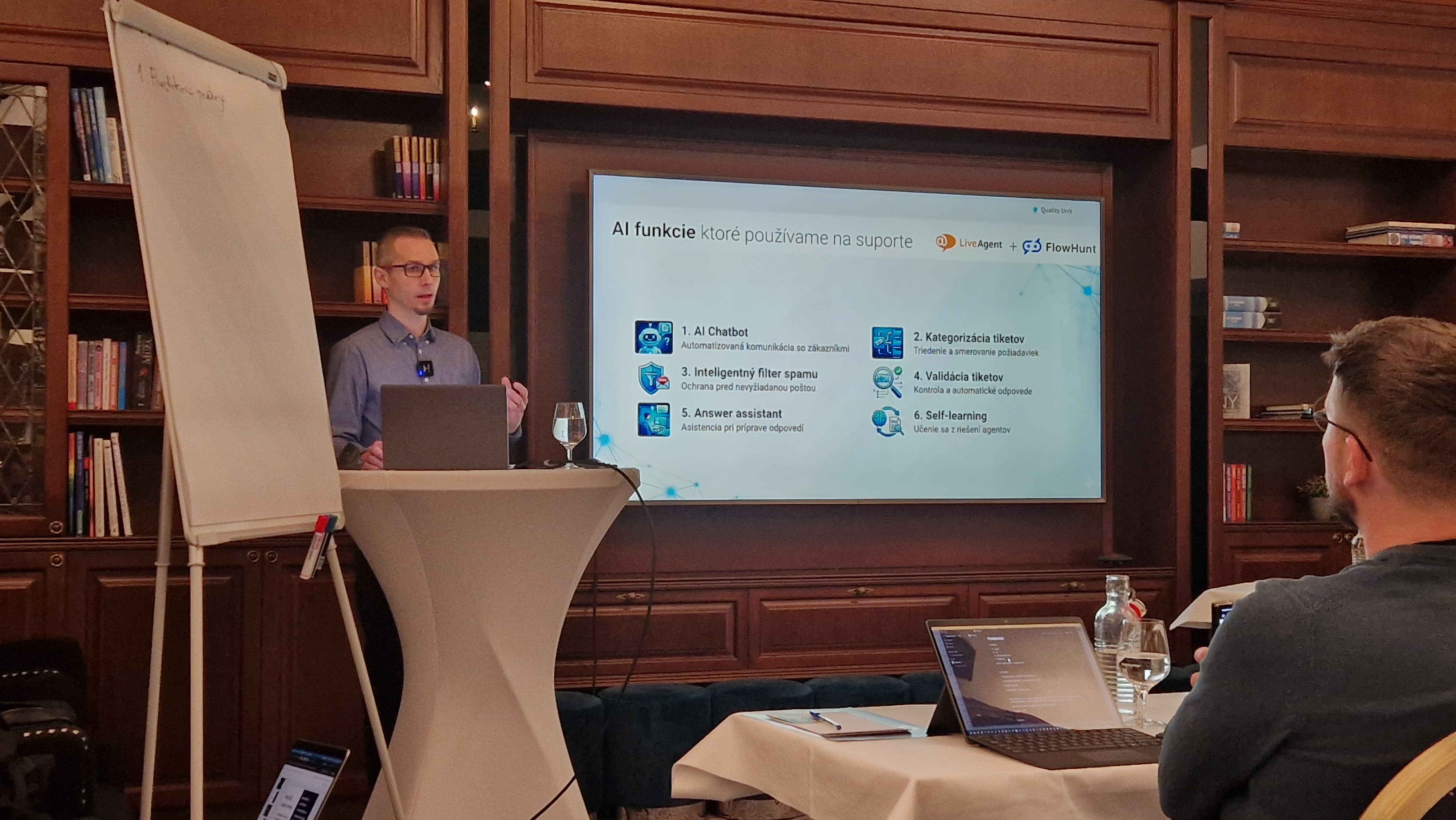

Automatyzacja wsparcia Jozefa Štofiry pokazuje dokładny zestaw narzędzi, których używamy do automatyzacji żmudnej pracy wsparcia, od filtrowania i kategoryzacji, po wzbogacanie danych, asystenta odpowiedzi i przekazywanie człowiekowi.

Razem te trzy perspektywy tworzą kompletny obraz: planowanie strategiczne, infrastruktura techniczna i wykonanie operacyjne dla e-commerce w środowisku handlu mediowanego przez AI.

Protokoły handlu AI, takie jak UCP (Universal Commerce Protocol), ACP (Agentic Commerce Protocol) i AP2 (Agent Payment Protocol), standaryzują sposób, w jaki systemy AI wchodzą w interakcje z platformami e-commerce. Umożliwiają one asystentom AI przeglądanie produktów, porównywanie opcji, inicjowanie procesu zakupu i finalizowanie transakcji w imieniu użytkowników, czyniąc Twój sklep dostępnym poprzez doświadczenia zakupowe mediowane przez AI.

SEO (Search Engine Optimization) koncentruje się na pozycjonowaniu w tradycyjnych wyszukiwarkach, takich jak Google, poprzez optymalizację słów kluczowych i linki zwrotne. GEO (Generative Engine Optimization) koncentruje się na cytowaniu przez systemy AI, takie jak ChatGPT i Perplexity, poprzez ustrukturyzowane treści, jasne definicje encji i wyczerpujące odpowiedzi. Nowoczesny e-commerce potrzebuje obu: SEO dla obecnego ruchu, GEO dla przyszłego odkrywania mediowanego przez AI.

Priorytetowe podstawy obejmują: szybką, bezpieczną infrastrukturę z CDN; prawidłowo skonfigurowane pliki robots.txt i mapy witryn; poprawne nagłówki cache; regularne audyty techniczne; optymalizację Core Web Vitals; kompleksowe oznaczenia schema.org dla encji; semantyczną strukturę treści; oraz zautomatyzowane linkowanie wewnętrzne. Te elementy tworzą fundament, którego potrzebują zarówno tradycyjne wyszukiwarki, jak i systemy AI, aby prawidłowo rozumieć i indeksować Twoje treści.

Zacznij od wygenerowania ponad 500 promptów za pomocą narzędzi takich jak AmICited.com, aby zrozumieć, jak systemy AI obecnie omawiają Twoją branżę. Utwórz wyspecjalizowanych agentów AI dla każdego typu treści (słownik, instrukcje, listy kontrolne, opisy produktów) z określonymi elementami i regułami formatowania. Użyj podobieństwa semantycznego do sugestii powiązanych artykułów. Generuj treści, które wyczerpująco odpowiadają na wszystkie potencjalne pytania odwiedzających, zamiast celować w wąskie słowa kluczowe.

Arshia jest Inżynierką Przepływów Pracy AI w FlowHunt. Z wykształceniem informatycznym i pasją do sztucznej inteligencji, specjalizuje się w tworzeniu wydajnych przepływów pracy, które integrują narzędzia AI z codziennymi zadaniami, zwiększając produktywność i kreatywność.

Buduj agentów AI, którzy generują treści zoptymalizowane pod SEO, wdrażają ulepszenia technicznego SEO i tworzą integracje protokołów AI—wszystko w wizualnym konstruktorze przepływów pracy FlowHunt.

Praktyczne ramy wdrażania AI w e-commerce od CMO Quality Unit. Dowiedz się, od czego zacząć, jakie są typowe wyzwania, strategie przygotowania treści i realisty...

Techniczne omówienie sześciu funkcji AI, które zmniejszyły obciążenie obsługi o 48,5%. Poznaj konkretne problemy, które rozwiązuje każda z nich, podejście do im...

Dowiedz się, jak stworzyć menedżera Shopify napędzanego sztuczną inteligencją, wykorzystując integrację serwera MCP FlowHunt do automatyzacji zarządzania produk...

Zgoda na Pliki Cookie

Używamy plików cookie, aby poprawić jakość przeglądania i analizować nasz ruch. See our privacy policy.