Generowanie tekstu

Generowanie tekstu za pomocą dużych modeli językowych (LLM) odnosi się do zaawansowanego wykorzystania modeli uczenia maszynowego do tworzenia tekstu podobnego ...

Odkryj, jak Jamba 3B od AI21 łączy mechanizmy uwagi transformera z modelami przestrzeni stanów, osiągając niespotykaną wydajność i możliwości obsługi długich kontekstów na urządzeniach brzegowych, co kształtuje przyszłość dużych modeli językowych.

Krajobraz dużych modeli językowych przeszedł w ostatnich latach ogromną transformację — naukowcy i firmy nieustannie poszukują sposobów na poprawę wydajności bez utraty jakości działania. Wprowadzenie Jamba 3B przez AI21 to istotny kamień milowy w tej ewolucji — model hybrydowy, który łączy moc mechanizmów uwagi transformera z modelami przestrzeni stanów, osiągając niespotykane dotąd korzyści wydajnościowe. To przełomowe osiągnięcie pojawia się w kluczowym momencie, gdy wymagania obliczeniowe związane ze szkoleniem i wdrażaniem dużych modeli językowych stały się poważnym ograniczeniem dla organizacji na całym świecie. W tym kompleksowym przewodniku przyjrzymy się innowacjom technicznym stojącym za Jamba 3B, zrozumiemy, dlaczego architektury hybrydowe wyznaczają przyszłość modeli językowych oraz przeanalizujemy, jak takie podejście zmienia możliwości wdrażania AI w różnorodnych środowiskach obliczeniowych.

AI21 zostało założone ponad siedem lat temu przez Ori Levy’ego, Yoava Shohama oraz Amnona Shashuę z wizjonerskim założeniem, które przyświecało wszystkim ich kolejnym działaniom: głębokie uczenie, choć niezwykle potężne i użyteczne, nie jest wystarczające samo w sobie. Filozofia założycielska firmy skupiała się na łączeniu klasycznej sztucznej inteligencji z nowoczesnym podejściem głębokiego uczenia, tworząc systemy potrafiące korzystać z zalet obu paradygmatów. To podejście okazało się prorocze — firma rozpoczęła działalność tuż przed premierą GPT-3, co umożliwiło jej idealną obserwację i czynny udział w rewolucyjnych zmianach przekształcających całą branżę AI. Od pierwszych dni w 2018 roku AI21 angażowało się w szkolenie modeli, utrzymując podwójny nacisk na rygor naukowy i praktyczne zastosowania. To zbalansowane podejście stało się cechą charakterystyczną firmy, odróżniając ją od konkurentów, którzy często stawiali wyłącznie na czystą naukę lub natychmiastową komercjalizację.

Przez całą swoją historię AI21 konsekwentnie łączyło najnowsze badania z realnymi aplikacjami. Firma stworzyła Wordtune — aplikację, która zdobyła istotną pozycję na rynku i była poligonem doświadczalnym dla badań nad modelami językowymi. Gdy pojawił się GPT-3, AI21 odpowiedziało, trenując własny model Jurassic-1, który osiągnął wyniki porównywalne, a nawet nieco lepsze niż oferta OpenAI. Ten wczesny sukces ugruntował pozycję AI21 jako poważnego gracza na rynku dużych modeli językowych, ale ambicje firmy sięgały znacznie dalej niż tylko dorównanie istniejącym rozwiązaniom. Zespół dostrzegł, że przyszłość AI wymaga nie tylko większych modeli, lecz przede wszystkim mądrzejszych architektur, które zapewnią lepsze wyniki przy większej wydajności. Ta intuicja ostatecznie doprowadziła do rozwoju Jamba — przełomowej linii modeli hybrydowych, które podważyły tradycyjne podejście do konstrukcji modeli językowych.

Hybrydowe modele językowe stanowią fundamentalne odejście od czystej architektury transformera, która zdominowała branżę od czasu premiery GPT-2 i kolejnych modeli. Tradycyjne modele oparte na transformerach całkowicie polegają na mechanizmie uwagi, w którym każdy token w sekwencji może „zwracać uwagę” na każdy inny token. Choć takie podejście okazało się niezwykle skuteczne w rozumieniu i generowaniu języka, wiąże się z wysokimi kosztami obliczeniowymi: mechanizm uwagi ma złożoność kwadratową względem długości sekwencji, co oznacza, że podwojenie okna kontekstu skutkuje czterokrotnym wzrostem wymagań obliczeniowych. Dodatkowo, bufor klucz-wartość wymagany dla uwagi rośnie liniowo wraz z długością sekwencji, co prowadzi do wąskich gardeł pamięciowych przy coraz większych oknach kontekstu. Te ograniczenia stały się kluczowym wyzwaniem dla współczesnych zastosowań, szczególnie tych wymagających przetwarzania długiego kontekstu, personalizacji, zapamiętywania oraz agentowego rozumowania.

Modele hybrydowe rozwiązują te problemy, łącząc uwagę transformera z modelami przestrzeni stanów, przede wszystkim Mamba, która oferuje złożoność liniową względem długości sekwencji. Zamiast całkowicie zastępować uwagę — co skutkowałoby utratą zdolności rozumowania, będących główną zaletą transformerów — architektury hybrydowe stosują uwagę selektywnie, zazwyczaj w proporcji 1:8, gdzie tylko jedna z ośmiu warstw wykorzystuje pełną uwagę, a pozostałe warstwy korzystają z wydajniejszych modeli przestrzeni stanów. Takie strategiczne połączenie pozwala zachować zdolność modelu do realizacji złożonych zadań wymagających globalnej świadomości kontekstu, przy jednoczesnym znacznym ograniczeniu kosztów obliczeniowych i wymagań pamięciowych dla większości przetwarzania. W rezultacie model utrzymuje lub wręcz poprawia wyniki na większości benchmarków, zużywając przy tym znacznie mniej zasobów podczas trenowania i inferencji. Ten wzrost wydajności nie jest jedynie marginalną poprawą — to fundamentalna zmiana, która pozwala wdrażać modele na urządzeniach brzegowych, w środowiskach z ograniczoną pamięcią oraz na skalę wcześniej uznawaną za niepraktyczną.

Droga do hybrydowej architektury Jamba nie była z góry wytyczona — wynikła z uważnych eksperymentów i gotowości do eksplorowania niekonwencjonalnych podejść. Zespół AI21 początkowo pracował nad J3, trzecią wersją linii Jurassic, z zamiarem wdrożenia architektury mixture-of-experts (MoE). Główną motywacją dla MoE było znaczące ograniczenie kosztów trenowania poprzez rozdzielenie obliczeń między wiele sieci ekspertów, czyniąc budżet szkoleniowy bardziej przystępnym. Jednak zespół chciał także, by model mógł być efektywnie wdrażany podczas inferencji, dlatego zaprojektował J3 w kilku wersjach — jedną mieszczącą się na pojedynczym GPU z 80 GB pamięci (np. A100 lub H100) oraz większą, mieszczącą się w pojedynczym podzie. Skupienie się na efektywności inferencji od początku okazało się kluczowe dla późniejszego przełomu.

Podczas badań ablacyjnych Barak Lenz, CTO AI21, natrafił na publikację o Mamba, polecaną przez kilku współpracowników. W przeciwieństwie do wcześniejszych prac nad modelami przestrzeni stanów, które nie rokowały najlepiej, publikacja o Mamba wyróżniała się rygorystycznym podejściem do porównań i ewaluacji. Zamiast zestawiać wyniki ze starymi bazami, autorzy porównywali Mambę bezpośrednio z najnowszymi architekturami uwagi, w szczególności z ulepszeniami wprowadzonymi przez Llama (optymalizacje layer normalization, funkcji aktywacji i inne detale architektoniczne eliminujące niestabilności trenowania). Publikacja nie tylko dokonywała uczciwych porównań ze stanem techniki, ale także udostępniała własne kernela i kod, demonstrując rzeczywiste zaangażowanie we wdrożenia praktyczne. Zaciekawiony tym podejściem, Lenz zachęcił zespół inżynierów do testowania Mamba na ich rozbudowanej platformie ewaluacyjnej, zawierającej już setki zróżnicowanych zadań i benchmarków.

Początkowe wyniki były obiecujące, lecz ujawniły istotne ograniczenia. Mamba dorównywała modelom opartym na uwadze w metrykach perplexity i na większości zadań, jednak w niektórych obszarach wypadała gorzej — szczególnie w few-shot learning wymagającym szybkiej adaptacji do nowych wzorców. Przyczyny tych niedostatków zespół upatrywał w braku mechanizmu uwagi — niektóre zadania rozumowania i rozpoznawania wzorców czerpią korzyści z globalnej świadomości kontekstu, jaką zapewnia uwaga. Zamiast zaakceptować to ograniczenie, zespół zaczął eksperymentować z architekturami hybrydowymi, przeplatając warstwy uwagi z warstwami Mamba, by sprawdzić, czy uda się uzyskać zalety obu podejść. Wyniki przerosły oczekiwania — nie tylko wyeliminowano spadek wydajności obserwowany w czystych modelach Mamba, ale także zaobserwowano poprawę względem „czystych” transformerów. To odkrycie stało się katalizatorem rozwoju Jamba.

Przygotowanie Jamba wymagało rozwiązania szeregu problemów technicznych na niespotykaną dotąd skalę. Gdy AI21 rozpoczęło szkolenie Jamba Mini — pierwszego modelu z linii hybrydowej — Mamba nigdy wcześniej nie była skalowana powyżej 3 miliardów parametrów. Hybrydowy model zespołu miał docelowo osiągnąć 13 miliardów aktywnych parametrów i około 52 miliardów parametrów ogółem (licząc komponenty mixture-of-experts). Stanowiło to ogromne wyzwanie skalowalności, wymuszając debugowanie i optymalizację architektury na niespotykaną dotąd skalę. Sam proces optymalizacji stał się ciekawym wyzwaniem inżynierskim — zespół musiał drobiazgowo analizować zachowanie modelu, identyfikować wąskie gardła i wdrażać rozwiązania umożliwiające efektywne trenowanie hybrydowej architektury na taką skalę.

Jedną z kluczowych decyzji było określenie optymalnej proporcji warstw uwagi do warstw przestrzeni stanów oraz ich rozmieszczenia w modelu. Po szeroko zakrojonych badaniach ablacyjnych AI21 ustaliło, że proporcja 1:8 (jedna z ośmiu warstw wykorzystuje uwagę, pozostałe siedem — Mamba) zapewnia najlepszy balans pomiędzy wydajnością a skutecznością. Co ciekawe, znaczenie miało także rozmieszczenie warstw uwagi. Testowano ich umieszczanie na początku, w środku i na końcu modelu, odkrywając, że środkowa pozycja daje zdecydowanie lepsze rezultaty niż skrajne. Bardziej agresywne proporcje, np. 1:6, przynosiły jedynie marginalne korzyści mieszczące się w granicach odchylenia standardowego wyników i nie uzasadniały dodatkowych kosztów obliczeniowych, szczególnie że każda warstwa transformera dodaje kwadratowe koszty do bufora klucz-wartość przy długich kontekstach.

Zyski wydajnościowe z tej architektury są wielowymiarowe. Podczas treningu podejście hybrydowe obniża wymagania obliczeniowe względem czystych transformerów, czyniąc szkolenie modeli na dużą skalę bardziej opłacalnym. W inferencji korzyści są jeszcze większe, szczególnie dla aplikacji wymagających długiego kontekstu. Choć Mamba ma wyższy koszt stały dla krótkich sekwencji w porównaniu do uwagi, ten niekorzystny efekt zanika, a nawet się odwraca wraz ze wzrostem długości sekwencji. W zastosowaniach wymagających długiego kontekstu — agentowych, RAG, personalizacji z pamięcią i wielu innych — architektura hybrydowa daje zdecydowanie lepsze właściwości wydajnościowe. Liniowe skalowanie pamięci Mamba oznacza, że podwojenie okna kontekstu podwaja wymagania pamięciowe, podczas gdy przy czystej uwadze podwojenie kontekstu oznacza czterokrotny wzrost wymagań. To fundamentalna różnica, której znaczenie rośnie wraz z rozwojem aplikacji wymagających długotrwałej spójności rozumowania i pamięci na przestrzeni długich interakcji.

W miarę jak organizacje coraz częściej wdrażają zaawansowane modele językowe, takie jak Jamba 3B, staje się kluczowe wyzwanie: jak zintegrować je z produkcyjnymi przepływami pracy. FlowHunt wychodzi naprzeciw temu wyzwaniu, oferując kompleksową platformę do automatyzacji przepływów AI — od wyboru i testowania modelu, przez wdrożenie, aż po monitoring. Korzyści wydajnościowe uzyskane dzięki modelom hybrydowym, takim jak Jamba 3B, są w pełni wykorzystywane dopiero wtedy, gdy towarzyszy im inteligentna automatyzacja procesów wdrożeniowych i testowych. FlowHunt pozwala budować zaawansowane systemy AI, wykorzystujące możliwości Jamba 3B, a jednocześnie zachować pełną kontrolę i transparentność na każdym etapie. Automatyzując rutynowe zadania wdrożeniowe i monitorujące, FlowHunt umożliwia zespołom skupienie się na strategicznych aspektach integracji AI, gwarantując, że oszczędności obliczeniowe wynikające z nowoczesnych architektur przekładają się na realną wartość biznesową.

Połączenie wydajnych modeli i inteligentnej automatyzacji przepływów daje efekt synergii. Zespoły mogą wdrażać Jamba 3B na urządzeniach brzegowych oraz w środowiskach z ograniczoną pamięcią, mając pewność, że narzędzia monitorujące i optymalizacyjne FlowHunt zapewnią stałą wydajność. Dla przedsiębiorstw budujących systemy AI wymagające długiego kontekstu, personalizacji czy agentowego rozumowania, FlowHunt dostarcza infrastrukturę do efektywnego zarządzania złożonymi przepływami. Automatyzacja testowania, wdrażania i monitoringu umożliwia szybkie iteracje — eksperymentowanie z różnymi konfiguracjami modeli i strategii wdrożeń bez zbędnych nakładów pracy manualnej. Jest to szczególnie cenne dla organizacji eksplorujących możliwości modeli hybrydowych, ponieważ pozwala benchmarkować różne architektury i konfiguracje, by znaleźć optymalny balans dla danego zastosowania.

Wprowadzenie Jamba 3B to ważny krok na drodze do udostępnienia zaawansowanych możliwości AI szerszemu gronu aplikacji i scenariuszy wdrożeniowych. W przeciwieństwie do poprzednich modeli Jamba, projektowanych pod kątem maksymalnej wydajności na dużą skalę, Jamba 3B została specjalnie zoptymalizowana pod urządzenia brzegowe i środowiska z ograniczoną pamięcią. Oznaczenie „3B” odnosi się do rozmiaru modelu — około 3 miliardy parametrów — dzięki czemu jest wystarczająco mały, by działać na sprzęcie konsumenckim, jednocześnie zachowując zalety wydajnościowe architektury hybrydowej. To kluczowa zmiana, która demokratyzuje dostęp do zaawansowanych możliwości modeli językowych, umożliwiając wdrożenia dotychczas niemożliwe z powodu ograniczeń obliczeniowych. Deweloperzy mogą teraz wdrażać zaawansowane modele językowe na urządzeniach mobilnych, IoT, systemach wbudowanych i innych platformach edge computing bez poświęcania zdolności rozumowania i obsługi długiego kontekstu, które czynią współczesne modele językowe wartościowymi.

Najważniejszą cechą Jamba 3B jest obsługa długich okien kontekstowych przy możliwości wdrożenia na urządzeniach brzegowych. Taka kombinacja była dotychczas niemożliwa przy czystych architekturach transformerowych — kwadratowa złożoność uwagi sprawiała, że wydłużanie kontekstu na urządzeniach brzegowych błyskawicznie wyczerpywało dostępną pamięć. Hybrydowa architektura Jamba 3B zasadniczo zmienia to równanie. Liniowa złożoność warstw Mamba umożliwia wydłużanie kontekstu bez wykładniczego wzrostu użycia pamięci, który jest zmorą modeli czysto opartych na uwadze. W zastosowaniach wymagających personalizacji, zapamiętywania, retrieval-augmented generation i agentowego rozumowania, ta możliwość jest przełomowa. Urządzenie brzegowe z Jamba 3B może podtrzymywać spójny kontekst przez długie interakcje, umożliwiając zaawansowane aplikacje dotychczas zarezerwowane dla modeli chmurowych. To fundamentalna zmiana pod względem prywatności, opóźnień i kosztów — aplikacje mogą teraz przetwarzać wrażliwe dane lokalnie, odpowiadać na zapytania z minimalnym opóźnieniem i działać bez kosztów chmury obliczeniowej.

Patrząc na rynek mini modeli, Jamba 3B wyróżnia się jako jedyny model hybrydowy w tej klasie rozmiarowej. Większość dostępnych mini modeli opiera się na czystej architekturze transformera, a więc dziedziczy te same ograniczenia wydajnościowe, co ich więksi kuzyni. Hybrydowe podejście Jamba 3B daje jej wyraźną przewagę pod względem obsługi długiego kontekstu i efektywności obliczeniowej. Model osiąga to nie przez kompromisy architektoniczne zmniejszające możliwości, lecz dzięki fundamentalnym zyskom wydajnościowym hybrydowego rozwiązania. To czyni Jamba 3B idealnym wyborem dla aplikacji, które muszą balansować między rozmiarem modelu a jego możliwościami, zwłaszcza gdy wymagane jest długie okno kontekstu na urządzeniach brzegowych.

Pomimo oczywistych zalet modeli hybrydowych, do ich powszechnego wdrożenia wciąż prowadzą przeszkody. Przemysł AI przez lata optymalizował sprzęt i oprogramowanie właśnie pod kątem transformera i mechanizmu uwagi. Każda licząca się platforma sprzętowa — od GPU NVIDIA po dedykowane akceleratory AI — posiada własne kernela i usprawnienia dla operacji uwagi. Optymalizacje te są efektem lat pracy inżynierskiej i ogromnych inwestycji, by uczynić uwagę możliwie najefektywniejszą na danym sprzęcie. W przeciwieństwie do nich, modele przestrzeni stanów, takie jak Mamba, to stosunkowo nowa technologia — choć istnieją dla nich dedykowane kernela, optymalizacje te nie są jeszcze tak dojrzałe ani szeroko dostępne na różnych platformach sprzętowych. To właśnie tę sytuację Barak Lenz nazywa „loterią sprzętową” — przewagi wydajnościowe modeli hybrydowych mogą być znacznie ograniczone, jeśli dana platforma sprzętowa nie posiada zoptymalizowanych implementacji operacji modeli przestrzeni stanów.

Ta luka w optymalizacji sprzętowej stanowi rzeczywistą barierę, ale nie jest nie do pokonania i prawdopodobnie z czasem będzie się zmniejszać. W miarę jak coraz więcej firm doceni zalety modeli hybrydowych i architektur przestrzeni stanów, producenci sprzętu będą mieli coraz większą motywację do inwestowania w ich optymalizację. NVIDIA już rozpoczęła udostępnianie modeli hybrydowych, podążają za nią kolejne firmy, co sugeruje, że branża dostrzega długoterminowe znaczenie tych architektur. Co więcej, przewagi wydajnościowe modeli hybrydowych są na tyle znaczące, że nawet bez pełnej optymalizacji sprzętowej często przewyższają modele oparte wyłącznie na uwadze. Kwadratowa złożoność uwagi jest bowiem tak fundamentalnym ograniczeniem, że nawet po latach optymalizacji nie dorówna liniowej złożoności modeli przestrzeni stanów przy długich sekwencjach. Wraz ze wzrostem długości sekwencji — co jest nieuniknionym trendem — przewagi hybryd stają się coraz bardziej bezdyskusyjne.

Poza pracami AI21 nad modelami hybrydowymi, w całej branży wyraźnie rysuje się trend do stosowania uwagi selektywnie, a nie w każdej warstwie. Nawet firmy nie wdrażające pełnych architektur hybrydowych zauważają, że pełna uwaga w każdej warstwie jest zbędna i nieefektywna. Wiele najnowszych modeli korzysta z tzw. sliding window attention, gdzie każdy token może „zwracać uwagę” tylko na ograniczone okno sąsiadujących tokenów, a nie na całą sekwencję. Podejście to zmniejsza złożoność uwagi z kwadratowej do liniowej względem rozmiaru okna, choć wciąż wymaga więcej mocy obliczeniowej niż modele przestrzeni stanów. Fakt, że niezależni badacze, tacy jak Noam Shazir, doszli do podobnych wniosków o optymalnej proporcji uwagi — konkretnie 1:8 uwagi lokalnej do globalnej — potwierdza, że nie jest to przypadkowa obserwacja, lecz fundamentalna właściwość struktur modeli językowych.

Zbieżność wyników różnych zespołów badawczych i firm sugeruje, że branża zbliża się do nowego konsensusu w kwestii optymalnej architektury modeli. Zamiast dominującego od czasów GPT-2 podejścia czysto transformerowego, przyszłość należeć będzie prawdopodobnie do modeli stosujących uwagę selektywnie — czy to przez architektury hybrydowe, jak Jamba, czy przez inne rozwiązania typu sliding window attention. Szczegóły implementacyjne mogą się różnić, ale zasadnicza idea pozostaje taka sama: pełna uwaga w każdej warstwie jest nieefektywna i niepotrzebna. Ta zmiana oznacza dojrzewanie dziedziny AI — odejście od początkowej fascynacji transformerami ku bardziej świadomemu stosowaniu różnych mechanizmów tam, gdzie faktycznie są potrzebne. Dla praktyków i organizacji budujących systemy AI oznacza to ważną konsekwencję: w przyszłości budowane i wdrażane modele będą efektywniejsze niż obecne, otwierając nowe zastosowania, które dziś są niepraktyczne z powodu ograniczeń obliczeniowych.

Przekonaj się, jak FlowHunt automatyzuje Twoje treści AI i procesy SEO — od badań i generowania treści po publikację i analitykę — wszystko w jednym miejscu.

Poza pojedynczymi modelami AI21 od lat rozwija koncepcję systemów AI wykraczających poza proste wykorzystanie modeli językowych. Firma wypuściła Jarvis — wczesny system AI, który próbował korzystać z narzędzi i zewnętrznych zasobów, by zwiększyć możliwości modelu językowego. Prace te poprzedziły szeroko zakrojone wdrożenia tool-use w modelach językowych i były inspiracją dla późniejszych frameworków, takich jak LangChain. Fundamentalny wniosek był taki, że same modele językowe, choć potężne, nie wystarczą do wielu realnych zastosowań. By połączyć głębokie uczenie z klasyczną AI, systemy muszą potrafić korzystać z narzędzi zewnętrznych, baz danych, wykonywać kod i realizować inne operacje wymagające większego rygoru i determinizmu niż czysta inferencja sieci neuronowej.

Maestro, oferta AI21 dla biznesu, reprezentuje ewolucję tego podejścia w kierunku systemu gotowego do zastosowań produkcyjnych. Zamiast wdrażać tylko model językowy i liczyć na to, że wygeneruje użyteczne odpowiedzi, Maestro dostarcza framework do budowy systemów AI, które mogą niezawodnie realizować złożone zadania, łącząc możliwości modeli językowych z obsługą narzędzi, retrievem czy innymi technikami klasycznej AI. Takie podejście jest szczególnie ważne w zastosowaniach biznesowych, gdzie kluczowe są niezawodność, dokładność i możliwość audytu. Model językowy może wygenerować odpowiedź przekonującą, ale błędną, podczas gdy system AI, który weryfikuje wyniki w zewnętrznych źródłach i korzysta z narzędzi do realizacji konkretnych zadań, zapewnia znacznie większą niezawodność. Wdrażanie systemów AI w przedsiębiorstwach następowało wolniej niż oczekiwano, ale sytuacja się zmienia, gdy organizacje dostrzegają wartość AI w automatyzacji skomplikowanych procesów i decyzji.

Moment tej zmiany jest ważny. Gdy generatywna AI po raz pierwszy trafiła do mainstreamu, wiele organizacji koncentrowało się na prostych zastosowaniach, takich jak generowanie treści czy chatboty obsługi klienta. Takie aplikacje często wystarczało obsłużyć modelem językowym z minimalną infrastrukturą. Jednak wraz z nabieraniem doświadczenia przez organizacje i identyfikacją bardziej zaawansowanych przypadków użycia, ograniczenia czystych modeli językowych stały się widoczne. Zastosowania wymagające długiego kontekstu, personalizacji, pamięci i agentowego rozumowania zyskują na strukturze, jaką dają systemy AI. Co więcej, wydajność modeli takich jak Jamba 3B sprawia, że wdrożenie zaawansowanych systemów AI na urządzeniach brzegowych i w środowiskach z ograniczonymi zasobami staje się coraz bardziej praktyczne. Połączenie wydajniejszych modeli z coraz bardziej zaawansowanymi systemami tworzy nowe możliwości wdrożeniowe AI w przedsiębiorstwach.

Dla deweloperów i organizacji planujących wykorzystanie zaawansowanych modeli językowych w swoich aplikacjach pojawienie się Jamba 3B i architektur hybrydowych niesie kilka istotnych wniosków. Po pierwsze, sugeruje to, że era wyłącznie transformerów może dobiegać końca — przynajmniej w nowych wdrożeniach. Choć istniejące modele transformerowe będą nadal stosowane i ulepszane, nowo powstające modele coraz częściej będą wykorzystywać architektury hybrydowe lub selektywną uwagę. Oznacza to, że deweloperzy powinni już teraz zapoznawać się z tymi nowościami, rozumieć ich cechy, przewagi i ograniczenia. Po drugie, zyski wydajnościowe modeli hybrydowych otwierają możliwość wdrażania zaawansowanych modeli językowych w scenariuszach dotąd niemożliwych — na urządzeniach brzegowych, w aplikacjach mobilnych i innych środowiskach o ograniczonych zasobach. Otwiera to nowe perspektywy dla aplikacji lokalnie przetwarzających dane, zapewniających prywatność i błyskawiczną reakcję.

Po trzecie, możliwości długiego kontekstu modeli takich jak Jamba 3B pozwalają na wdrażanie nowych wzorców aplikacyjnych, dotąd niepraktycznych. Aplikacje mogą teraz utrzymywać spójny kontekst na przestrzeni długich interakcji, ofer

Hybrydowy LLM łączy mechanizmy uwagi transformera z modelami przestrzeni stanów, takimi jak Mamba. W przeciwieństwie do czystych modeli transformerowych, które w całości opierają się na uwadze (co skutkuje złożonością obliczeniową kwadratową), modele hybrydowe stosują uwagę selektywnie – zazwyczaj w proporcji 1:8 – wykorzystując liniową złożoność modeli przestrzeni stanów w większości warstw. Takie podejście pozwala utrzymać wysoką jakość działania przy znacznym ograniczeniu kosztów obliczeniowych i wymagań pamięciowych.

Jamba 3B jest zoptymalizowana pod urządzenia brzegowe, ponieważ zapewnia możliwości przetwarzania długiego kontekstu przy zachowaniu rozmiaru umożliwiającego działanie w środowiskach z ograniczoną pamięcią. Wydajność architektury hybrydowej sprawia, że model mieści się na pojedynczych GPU lub urządzeniach brzegowych, nie tracąc przy tym zdolności obsługi rozległych okien kontekstowych, co czyni go idealnym dla aplikacji AI na urządzeniach lokalnych.

W wyniku szeroko zakrojonych badań ablacyjnych AI21 odkryło, że stosowanie uwagi tylko w 1 z każdych 8 warstw (pozostałe 7 wykorzystuje Mambę) zapewnia optymalny kompromis pomiędzy wydajnością a efektywnością. Warstwy uwagi są strategicznie umieszczane w środku modelu, a nie na początku czy końcu, co empirycznie daje lepsze rezultaty. Taka proporcja minimalizuje kwadratowy koszt uwagi, przy zachowaniu zdolności modelu do realizacji złożonych zadań wymagających dedukcji.

Modele hybrydowe oferują kilka kluczowych zalet: znacząco niższe koszty trenowania dzięki mniejszym wymaganiom obliczeniowym, lepszą wydajność w aplikacjach wymagających długiego kontekstu, liniowe skalowanie pamięci zamiast kwadratowego oraz utrzymanie lub poprawę wyników w większości testów porównawczych. Umożliwiają także wdrażanie na urządzeniach brzegowych i w środowiskach z ograniczoną pamięcią, zachowując przy tym zdolności dedukcyjne cenione w dużych modelach językowych.

Arshia jest Inżynierką Przepływów Pracy AI w FlowHunt. Z wykształceniem informatycznym i pasją do sztucznej inteligencji, specjalizuje się w tworzeniu wydajnych przepływów pracy, które integrują narzędzia AI z codziennymi zadaniami, zwiększając produktywność i kreatywność.

Usprawnij wdrażanie, testowanie i optymalizację modeli AI dzięki inteligentnej platformie automatyzacji FlowHunt.

Generowanie tekstu za pomocą dużych modeli językowych (LLM) odnosi się do zaawansowanego wykorzystania modeli uczenia maszynowego do tworzenia tekstu podobnego ...

Duży model językowy (LLM) to rodzaj sztucznej inteligencji, trenowany na ogromnych zbiorach tekstowych, aby rozumieć, generować i przetwarzać ludzki język. LLM-...

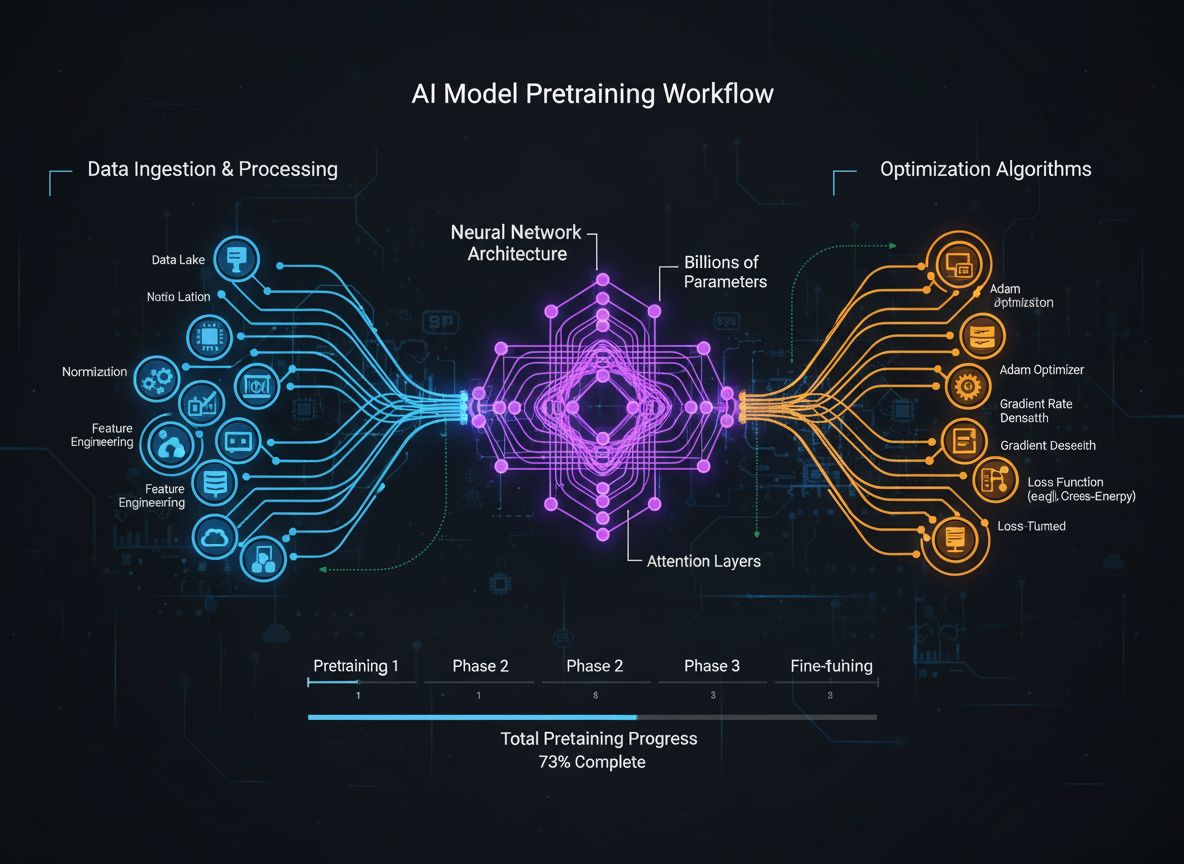

Kompleksowy przewodnik po nowoczesnych strategiach pretrenowania modeli językowych, technikach kuracji danych i metodach optymalizacji wykorzystywanych przez Hu...

Zgoda na Pliki Cookie

Używamy plików cookie, aby poprawić jakość przeglądania i analizować nasz ruch. See our privacy policy.