Czym jest Google Gemini AI Chatbot?

Dowiedz się, czym jest Google Gemini, jak działa i jak wypada w porównaniu z ChatGPT. Poznaj jego multimodalne możliwości, ceny oraz zastosowania w praktyce na ...

Odkryj, jak Google I/O 2025 wprowadza Erę Gemini dzięki aktualizacjom napędzanym AI w całym ekosystemie Google i zobacz, jak FlowHunt udostępnia najnowszy model Gemini 2.5 Flash w Twoich projektach AI.

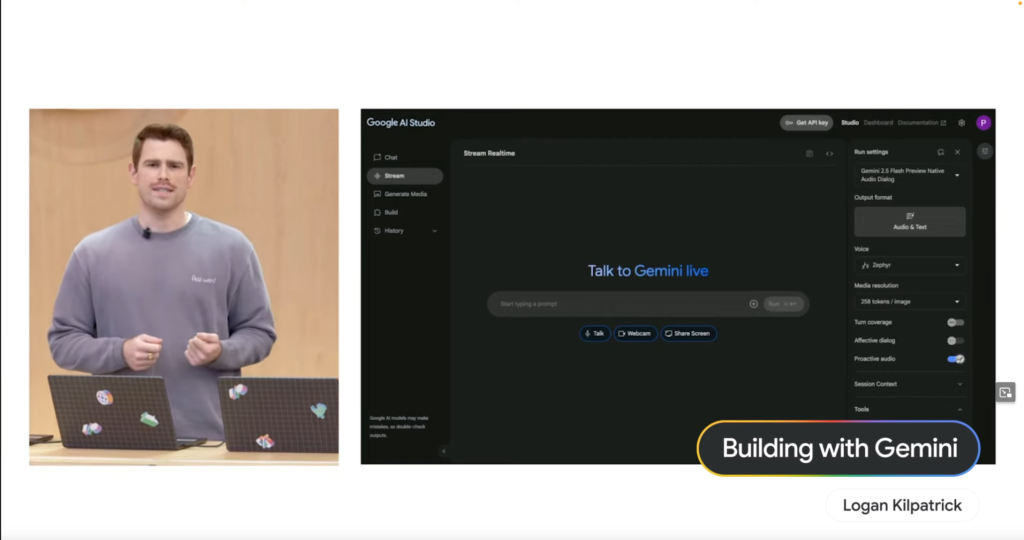

Logan Kilpatrick rozpoczął, pokazując, jak Project Astra ma na celu uczynić interakcję z AI całkowicie naturalną. Wiele z tych możliwości jest teraz dostępnych przez Live API, napędzane nowym natynym modelem audio Gemini 2.5 Flash. Model ten lepiej ignoruje przypadkowe dźwięki i natywnie obsługuje 24 języki, torując drogę do bardziej intuicyjnych i responsywnych doświadczeń AI.

Paige Bailey zaprezentowała siłę budowania z Gemini poprzez demo „Keynote Companion”. Korzystając z Google AI Studio, pokazała, jak AI rozumie polecenia głosowe, współdziała z danymi na żywo (np. pokazując Shoreline Amphitheatre na mapie), a nawet wykonuje złożone wyszukiwania, takie jak znajdowanie kawiarni z Wi-Fi w pobliżu – wszystko w konwersacyjnym przepływie. To podkreśla imponujące możliwości multimodalne Gemini.

Adaptacyjność z założenia: Compose i Android XR

Diana Wong podkreśliła zaangażowanie Google w ułatwienie budowania adaptacyjnych UI. Nowe funkcje w bibliotece Compose Adaptive Layouts, takie jak Pane Expansion, pomagają deweloperom tworzyć aplikacje płynnie dostosowujące się do różnych rozmiarów ekranów i form. Ta filozofia adaptacyjności rozciąga się na Android XR, platformę rozszerzonej rzeczywistości stworzoną we współpracy z Samsungiem. Deweloperzy mogą już teraz budować na nadchodzące headsety jak Project Moohan, mając pewność, że ich adaptacyjne aplikacje będą gotowe na tę nową, immersyjną rzeczywistość.

Inteligentniejsze kodowanie: Agenci AI w Android Studio

Florina Muntenescu zaprezentowała przełom dla deweloperów Androida: nowego agenta AI, który wkrótce pojawi się w Android Studio. Agent ten został zaprojektowany, by pomagać przy żmudnych zadaniach, takich jak aktualizacje wersji. W przekonującym demo agent AI przeanalizował stary projekt, zidentyfikował błędy kompilacji i wykorzystał Gemini do znalezienia rozwiązania, iterując aż do pomyślnej kompilacji. To zapowiada znaczne usprawnienie procesu tworzenia oprogramowania.

Uproszczone Web UI: Nowe możliwości dla złożonych elementów

Una Kravets wyróżniła nowe możliwości sieciowe, które upraszczają tworzenie powszechnych, a zarazem zaskakująco złożonych elementów UI. Programistom łatwiej będzie budować solidne i dostępne komponenty, takie jak karuzele czy hover cards, poprawiając doświadczenia użytkowników na całym webie.

Gemini Nano w sieci: Uwolnione multimodalne API AI

Addy Osmani ogłosił, że Gemini Nano odblokowuje nowe możliwości multimodalne bezpośrednio w sieci. Nowe wbudowane multimodalne API AI pozwolą użytkownikom korzystać z Gemini, używając zarówno wejścia audio, jak i obrazu. Demo „Cinemal” pokazało to, umożliwiając użytkownikowi zrobienie zdjęcia biletu kamerą internetową, a AI na urządzeniu natychmiast odnalazło jego sektor na mapie teatru – to potężny przykład przetwarzania na urządzeniu.

David East pokazał, jak Firebase integruje AI, by przyspieszyć tworzenie aplikacji. Programiści mogą teraz przenosić swoje projekty z Figma do Firebase Studio przy wsparciu Builder.io. Co imponujące, eksport z Figmy nie jest po prostu monolitycznym zrzutem kodu – generuje dobrze wydzielone, indywidualne komponenty React. Używając Gemini w Firebase Studio, David pokazał, jak łatwo może poprosić AI o dodanie funkcji, np. przycisku „Dodaj do koszyka” na stronie produktu, co AI natychmiast wykonało, aktualizując kod i podgląd na żywo.

Gemma 3n: Potężne AI na zaledwie 2GB RAM

Gus Martins przyniósł ekscytujące wieści dla społeczności open-source, ogłaszając Gemma 3n. Ten niezwykle wydajny model może działać na zaledwie 2GB RAM, co czyni go dużo szybszym i lżejszym dla urządzeń mobilnych w porównaniu do Gemma 3. Co ważne, Gemma 3n obsługuje teraz rozumienie dźwięku, czyniąc go naprawdę multimodalnym.

SignGemma: Przełamywanie barier komunikacyjnych

Google przesuwa także granice dostępności dzięki SignGemma. Ta nowa rodzina modeli została wytrenowana do tłumaczenia języka migowego (obecnie skupionego na American Sign Language – ASL) na tekst języka mówionego, otwierając nowe możliwości komunikacji i integracji.

Zainspirowały Cię niesamowite postępy AI na Google I/O? Chcesz zacząć tworzyć zaawansowanych Agentów AI, którzy rozumieją, wnioskują i działają?

FlowHunt to platforma zasilana AI, która pozwala tworzyć potężnych Agentów AI bez konieczności bycia ekspertem od uczenia maszynowego. Projektuj złożone przepływy, integruj różne narzędzia i wdrażaj inteligentnych agentów z łatwością.

A najlepsze? Jak podkreśliła moc nowych modeli na keynote, FlowHunt już obsługuje przełomowy Gemini 2.5 Flash! Oznacza to, że możesz natychmiast zacząć korzystać z jego szybkości, wydajności i ulepszonych możliwości audio, by budować jeszcze potężniejszych i bardziej responsywnych Agentów AI.

Wypróbuj nowe modele wdrożone w FlowHunt w mniej niż 24 godziny – już teraz!

Google I/O 2025 podkreśla przejście firmy do AI-native przyszłości, z modelami Gemini w centrum nowych produktów i funkcji w Androidzie, internecie oraz narzędziach deweloperskich.

Gemini 2.5 Flash to najnowszy natywny model audio AI Google, oferujący szybkie, wydajne i wielojęzyczne przetwarzanie dźwięku, dostępny teraz dla deweloperów i zintegrowany z platformami takimi jak FlowHunt.

Gemma 3n to wydajny model AI działający przy zaledwie 2GB RAM z multimodalnymi (audio) możliwościami. SignGemma to rodzina modeli tłumaczących język migowy, skupiająca się na ASL, na tekst języka mówionego.

FlowHunt obsługuje już Gemini 2.5 Flash, umożliwiając użytkownikom tworzenie zaawansowanych Agentów AI z ulepszonymi możliwościami audio i multimodalnymi, bez konieczności znajomości uczenia maszynowego.

Android wprowadził adaptacyjne UI, wsparcie XR oraz agentów AI w Android Studio dla inteligentniejszego kodowania. W internecie Gemini Nano umożliwia multimodalne API AI dla wejścia audio i obrazu bezpośrednio w przeglądarkach.

Yasha jest utalentowanym programistą specjalizującym się w Pythonie, Javie i uczeniu maszynowym. Yasha pisze artykuły techniczne o AI, inżynierii promptów i tworzeniu chatbotów.

Doświadcz mocy nowego modelu Gemini 2.5 Flash w FlowHunt i twórz kolejną generację Agentów AI z zaawansowanymi multimodalnymi możliwościami.

Dowiedz się, czym jest Google Gemini, jak działa i jak wypada w porównaniu z ChatGPT. Poznaj jego multimodalne możliwości, ceny oraz zastosowania w praktyce na ...

Gemini Flash 2.0 wyznacza nowe standardy w AI dzięki zwiększonej wydajności, szybkości i możliwościom multimodalnym. Poznaj jego potencjał w praktycznych zastos...

Odkryj, dlaczego Gemini 3 Flash od Google rewolucjonizuje AI dzięki lepszej wydajności, niższym kosztom i szybszemu działaniu – nawet przewyższając Gemini 3 Pro...