Metaprompt

Metaprompt w sztucznej inteligencji to instrukcja wysokiego poziomu zaprojektowana do generowania lub ulepszania innych promptów dla dużych modeli językowych (L...

Opanuj optymalizację promptów dla AI, tworząc jasne, bogate w kontekst prompty, by zwiększyć jakość wyników, zmniejszyć koszty i skrócić czas przetwarzania. Poznaj techniki dla inteligentniejszych workflow AI.

Optymalizacja promptów oznacza udoskonalanie wejścia, które przekazujesz modelowi AI, aby uzyskać możliwie najdokładniejsze i najbardziej efektywne odpowiedzi. To nie tylko kwestia jasnej komunikacji — zoptymalizowane prompty zmniejszają też obciążenie obliczeniowe, co przekłada się na szybsze przetwarzanie i niższe koszty. Niezależnie od tego, czy tworzysz zapytania do chatbotów obsługi klienta, czy generujesz złożone raporty, sposób, w jaki konstruujesz i formułujesz prompty, ma znaczenie.

Czy próbowałeś kiedyś poprosić AI o napisanie meta opisu? Prawdopodobnie Twój pierwszy prompt wyglądał mniej więcej tak:

Napisz mi meta opis na temat optymalizacji promptów.

Ten prompt jest nieprawidłowy z kilku powodów. Jeśli nie określisz wymaganej przez Google długości 140 znaków, AI znacznie ją przekroczy. Jeśli długość będzie odpowiednia, często użyje innego stylu lub opis będzie zbyt szczegółowy i nudny, by ktoś w niego kliknął. Wreszcie, bez możliwości przeczytania Twojego artykułu, AI może wygenerować jedynie ogólne meta opisy.

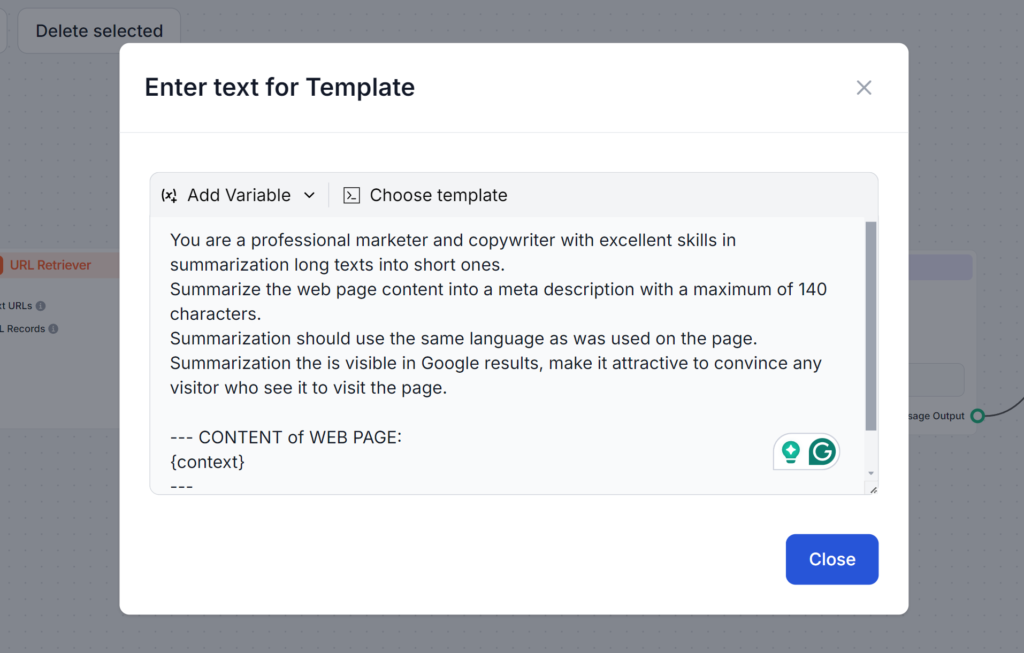

Zobacz poniższy prompt. Jest dłuższy i wykorzystuje kilka technik, których nauczysz się w tym wpisie. Ten prompt dobrze rozwiązuje wszystkie potencjalne problemy, zapewniając, że od razu otrzymasz dokładny rezultat, jakiego potrzebujesz:

Tokeny to podstawowe jednostki tekstu, które przetwarzają modele AI. Modele rozbijają tekst na te tokeny. Jeden token może stanowić pojedyncze słowo, kilka słów, a nawet fragment słowa. Więcej tokenów zwykle oznacza wolniejsze odpowiedzi i wyższe koszty przetwarzania. Dlatego zrozumienie działania tokenów jest kluczowe, aby tworzyć lepsze prompty i zapewnić ich opłacalność oraz szybkość działania.

Dlaczego tokeny są ważne:

Na przykład:

W przypadku promptu o dużej liczbie tokenów AI ma za zadanie omówić wszystkie możliwe opcje, natomiast prompt z mniejszą liczbą tokenów prosi o proste podsumowanie. Widząc podsumowanie, możesz je rozwinąć w zależności od potrzeb, osiągając zamierzony cel szybciej i taniej.

Tworzenie skutecznych promptów wymaga połączenia jasności, kontekstu i kreatywności. Warto eksperymentować z różnymi formatami, by znaleźć najskuteczniejsze sposoby komunikacji z AI. Oto kilka kluczowych technik:

Niejasne prompty mogą zdezorientować model. Dobrze skonstruowany prompt zapewnia, że AI zrozumie Twoją intencję.

Przykład:

Dodanie istotnych szczegółów pomaga AI generować odpowiedzi dopasowane do Twoich potrzeb.

Przykład:

Dodanie przykładów pomaga AI zrozumieć oczekiwany format lub ton wypowiedzi.

Przykład:

Stosowanie standaryzowanych szablonów dla podobnych zadań zapewnia spójność i oszczędza czas.

Przykładowy szablon do tworzenia bloga:

“Napisz wpis na bloga o długości [liczba słów] na temat [temat], skupiając się na [konkretne szczegóły]. Użyj przyjaznego tonu i dodaj [słowa kluczowe].”

Istnieje kilka zaawansowanych strategii, które pozwolą Ci wynieść prompty na wyższy poziom. Techniki te wykraczają poza podstawową jasność i strukturę, umożliwiając realizację bardziej złożonych zadań, integrację dynamicznych danych i personalizację odpowiedzi AI do określonych dziedzin lub potrzeb. Oto krótki przegląd każdej z nich wraz z praktycznymi przykładami.

Few-shot learning polega na podaniu kilku przykładów w promptcie, aby pomóc AI zrozumieć oczekiwany schemat lub format. Dzięki temu model może generalizować z minimalną ilością danych, co sprawdza się przy nowych lub nieznanych zadaniach.

Wystarczy dodać kilka przykładów do promptu, by model wiedział, czego oczekujesz.

Przykładowy prompt:

Przetłumacz poniższe zwroty na francuski:

Łańcuchowanie promptów polega na rozbiciu złożonego zadania na mniejsze, łatwiejsze do wykonania kroki, które następują po sobie. Pozwala to AI systematycznie rozwiązywać wieloetapowe problemy, zapewniając precyzję i jasność wyników.

Przykładowy prompt:

Kontekstowe wyszukiwanie polega na włączeniu do promptu aktualnych, istotnych informacji poprzez odwołanie się do zewnętrznych źródeł lub podsumowanie kluczowych danych. Dzięki temu AI ma dostęp do najświeższych i trafnych danych, by generować lepsze odpowiedzi.

Przykład:

“Na podstawie danych z tego raportu [wstaw link], podsumuj najważniejsze wnioski dotyczące trendów w energetyce odnawialnej.”

Fine-tuning z embeddingami polega na dostosowaniu modelu AI do określonych zadań lub dziedzin za pomocą specjalistycznych reprezentacji danych. Taka personalizacja zwiększa trafność i dokładność odpowiedzi w zastosowaniach branżowych lub niszowych.

Zarządzanie zużyciem tokenów pozwala kontrolować szybkość i opłacalność przetwarzania danych przez AI. Ograniczając liczbę przetwarzanych tokenów, możesz obniżyć koszty i uzyskać szybsze odpowiedzi bez utraty jakości. Oto kilka metod skutecznego zarządzania tokenami:

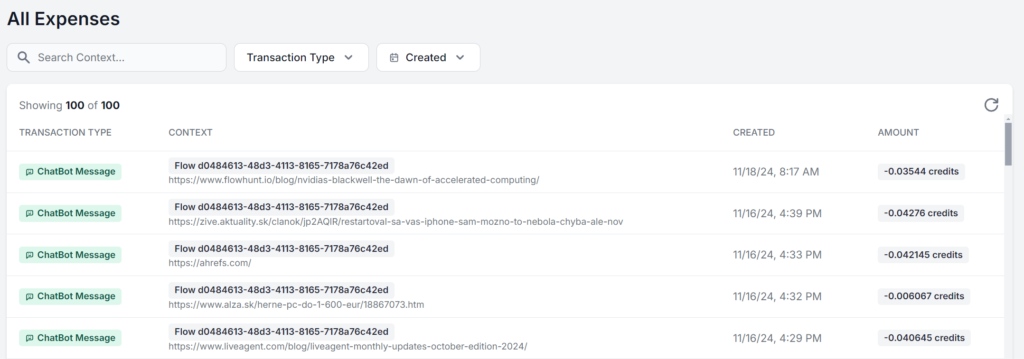

Optymalizacja nie kończy się na napisaniu lepszego promptu. Regularnie monitoruj wydajność i wprowadzaj ulepszenia na podstawie otrzymanego feedbacku. Ciągłe śledzenie pozwala stopniowo udoskonalać prompty i podejmować świadome decyzje.

Skup się na tych obszarach:

Najlepiej korzystać z interfejsu, który pozwala analizować zużycie tokenów dla każdego promptu. Oto przykład: ten sam workflow AI FlowHunt uruchomiony 5 razy, gdzie zmienia się tylko materiał źródłowy. Różnica w opłatach to tylko grosze, lecz przy większej liczbie operacji zaczyna być zauważalna:

Niezależnie od tego, czy chcesz po prostu jak najlepiej wykorzystać darmowe limity modeli AI, czy budujesz skalowalną strategię AI, optymalizacja promptów jest kluczowa dla każdego użytkownika AI. Dzięki tym technikom możesz korzystać z AI efektywnie, uzyskiwać dokładne wyniki i obniżać koszty.

Wraz z rozwojem technologii AI, rola jasnej i zoptymalizowanej komunikacji z modelami będzie tylko rosła. Zacznij eksperymentować z tymi strategiami już dziś za darmo. FlowHunt pozwala budować z różnymi modelami AI i funkcjami na jednym dashboardzie, zapewniając zoptymalizowane i wydajne workflow AI dla dowolnego zadania. Wypróbuj 14-dniowy darmowy okres testowy !

Optymalizacja promptów polega na udoskonalaniu wejścia, które przekazujesz modelowi AI, aby uzyskać jak najdokładniejsze i najbardziej wydajne odpowiedzi. Zoptymalizowane prompty zmniejszają obciążenie obliczeniowe, prowadząc do szybszego przetwarzania i niższych kosztów.

Liczba tokenów wpływa zarówno na szybkość, jak i koszt wyników AI. Mniej tokenów oznacza szybsze odpowiedzi i niższe koszty, a zwięzłe prompty pomagają modelom skupić się na istotnych szczegółach.

Zaawansowane techniki obejmują few-shot learning, łańcuchowanie promptów, kontekstowe wyszukiwanie oraz fine-tuning z wykorzystaniem embeddingów. Metody te pomagają rozwiązywać złożone zadania, integrować dynamiczne dane i dostosowywać odpowiedzi do konkretnych potrzeb.

Monitoruj dokładność odpowiedzi, zużycie tokenów i czas przetwarzania. Regularne śledzenie i iteracja na podstawie feedbacku pomagają udoskonalać prompty i utrzymywać wydajność.

FlowHunt udostępnia narzędzia i dashboard do budowania, testowania oraz optymalizacji promptów AI, pozwalając eksperymentować z różnymi modelami i strategiami dla wydajnych workflow AI.

Maria jest copywriterką w FlowHunt. Językowa pasjonatka aktywna w społecznościach literackich, doskonale zdaje sobie sprawę, że AI zmienia sposób, w jaki piszemy. Zamiast się temu opierać, stara się pomóc zdefiniować doskonałą równowagę między procesami opartymi na AI a niezastąpioną wartością ludzkiej kreatywności.

Zacznij budować zoptymalizowane workflow AI z FlowHunt. Eksperymentuj z inżynierią promptów i zwiększ swoją produktywność.

Metaprompt w sztucznej inteligencji to instrukcja wysokiego poziomu zaprojektowana do generowania lub ulepszania innych promptów dla dużych modeli językowych (L...

Inżynieria promptów to praktyka projektowania i udoskonalania poleceń dla generatywnych modeli AI w celu uzyskania optymalnych wyników. Obejmuje to tworzenie pr...

Dowiedz się, dlaczego prompt engineering błyskawicznie staje się niezbędną umiejętnością każdego profesjonalisty, jak przekształca produktywność w pracy i jak z...

Zgoda na Pliki Cookie

Używamy plików cookie, aby poprawić jakość przeglądania i analizować nasz ruch. See our privacy policy.