Dane niestrukturyzowane

Dowiedz się, czym są dane niestrukturyzowane i jak wypadają na tle danych strukturyzowanych. Poznaj wyzwania oraz narzędzia wykorzystywane do pracy z danymi nie...

Dowiedz się, jak integracja i zarządzanie danymi niestrukturalnymi przekształca dane przedsiębiorstwa w zestawy danych gotowe do AI, napędzając dokładne systemy RAG oraz inteligentnych agentów na dużą skalę.

Sukces nowoczesnych agentów AI zależy od jednego, często pomijanego czynnika: jakości i dostępności danych, które je zasilają. Organizacje inwestują w najnowocześniejsze modele językowe i zaawansowane algorytmy, ale prawdziwym wąskim gardłem okazuje się sposób zarządzania danymi przedsiębiorstwa. Ponad 90% danych firmowych istnieje w formatach niestrukturalnych — umowy, PDF-y, e-maile, transkrypcje, obrazy, audio i wideo — a mniej niż 1% z nich trafia dziś do projektów generatywnej AI. To zarówno ogromne wyzwanie, jak i wyjątkowa szansa. Różnica między systemami AI, które halucynują i podają niedokładne odpowiedzi, a tymi, które dostarczają wiarygodne, kontekstowe odpowiedzi, często sprowadza się do tego, jak dobrze organizacja potrafi integrować, zarządzać i wykorzystywać dane niestrukturalne. W tym kompleksowym przewodniku pokażemy, jak integracja i zarządzanie danymi niestrukturalnymi pozwala odblokować złoto ukryte w danych firmy, umożliwiając budowę agentów AI i systemów Retrieval-Augmented Generation (RAG), które są nie tylko inteligentne, ale także godne zaufania i zgodne z regulacjami.

Największym problemem przedsiębiorstw jest dziś to, że większość ich wartościowych danych istnieje w formatach, do których tradycyjne systemy nie były przystosowane. W przeciwieństwie do danych strukturalnych przechowywanych w bazach danych — gdzie informacje są uporządkowane w wierszach i kolumnach — dane niestrukturalne są rozproszone po wielu systemach, niespójne w formacie, często zawierają wrażliwe informacje. Umowa może zawierać dane osobowe (PII) wymieszane z kluczowymi warunkami biznesowymi. W wątku e-mailowym ważne decyzje mogą być ukryte pomiędzy codziennymi rozmowami. Transkrypcje wsparcia klienta mogą ujawniać emocje i poziom zadowolenia ukryte w języku naturalnym. Ta różnorodność i złożoność sprawiają, że dane niestrukturalne to jednocześnie najcenniejszy i najtrudniejszy do wykorzystania zasób firmy. Gdy zespoły data engineering próbują ręcznie przetwarzać te treści, czeka je tygodnie żmudnej pracy: przeszukiwanie rozproszonych dokumentów, identyfikacja i usuwanie wrażliwych informacji, łączenie niestandardowych skryptów do przygotowania danych pod systemy AI. Takie podejście jest czasochłonne i podatne na błędy, co tworzy wąskie gardła hamujące skalowanie inicjatyw AI. Problem staje się jeszcze poważniejszy, gdy w grę wchodzą wymogi zgodności — firmy muszą mieć pewność, że wrażliwe informacje są właściwie obsługiwane, śledzić pochodzenie danych na potrzeby audytu oraz zapewnić, że użytkownicy i agenci AI mają dostęp tylko do informacji, do których są uprawnieni.

Wiele firm uważa, że porażki agentów AI biorą się ze słabych modeli lub niewystarczającej mocy obliczeniowej. W rzeczywistości głównym winowajcą jest nieadekwatna infrastruktura danych. Zaawansowany model językowy jest tylko tak dobry, jak informacje, do których ma dostęp. Gdy agent AI nie ma dostępu do wysokiej jakości, dobrze zorganizowanych danych firmowych, musi polegać na ogólnej wiedzy z danych treningowych lub, co gorsza, zgadywać, co prowadzi do halucynacji. Dane publiczne — czyli te dostępne w Internecie — są już zawarte w modelach bazowych, dlatego prawdziwą przewagę konkurencyjną daje firmom umiejętność odblokowania i wykorzystania własnych, specyficznych danych. Wyobraźmy sobie agenta AI do obsługi klienta, który musi odpowiadać na pytania o polityki firmy, specyfikacje produktów czy historię klienta. Bez dostępu do dobrze zintegrowanych i zarządzanych dokumentów wewnętrznych, agent nie dostarczy precyzyjnych, kontekstowych odpowiedzi. Może generować prawdopodobnie brzmiące, ale błędne informacje, szkodząc zaufaniu klientów i reputacji marki. Podobnie system AI służący do identyfikowania ryzyk prawnych w umowach lub analizowania wzorców operacyjnych w raportach terenowych wymaga czystych, uporządkowanych i poprawnie sklasyfikowanych danych. Różnica między “posiadaniem danych” a “posiadaniem użytecznych danych” to miejsce, gdzie większość firm napotyka na trudności. Dlatego integracja i zarządzanie danymi niestrukturalnymi to nie dodatki, a podstawowe elementy każdej poważnej strategii AI.

Bazy danych wektorowych to fundamentalna zmiana w sposobie przechowywania i wyszukiwania informacji na potrzeby AI. Tradycyjne bazy polegają na dokładnym dopasowaniu słów kluczowych, podczas gdy bazy wektorowe operują na embeddingach — wielowymiarowych, numerycznych reprezentacjach tekstu, obrazów czy innych treści, które oddają znaczenie semantyczne. Dokument zamieniony w embedding staje się punktem w wielowymiarowej przestrzeni, gdzie podobne treści grupują się blisko siebie. Pozwala to na wyszukiwanie semantyczne: znajdujemy informacje na podstawie znaczenia, a nie tylko słów kluczowych. Przykładowo, zapytanie o “świadczenia pracownicze” może zwrócić dokumenty o “pakietach wynagrodzeń” czy “ubezpieczeniach zdrowotnych”, bo te pojęcia są powiązane semantycznie, nawet jeśli nie mają wspólnych słów. Bazy wektorowe napędzają systemy Retrieval-Augmented Generation (RAG), uznane za złoty standard w budowie agentów AI wymagających dostępu do wiedzy przedsiębiorstwa. W systemie RAG, gdy użytkownik zadaje pytanie, system najpierw przeszukuje bazę wektorową pod kątem odpowiednich dokumentów lub fragmentów, a następnie przekazuje uzyskany kontekst do modelu językowego, który generuje dokładną odpowiedź. Ten dwuetapowy proces — najpierw wyszukiwanie, potem generowanie — znacząco poprawia dokładność w porównaniu do zadawania pytań samemu modelowi. Baza wektorowa działa jak zewnętrzna pamięć firmy, pozwalając agentom AI korzystać z aktualnych, firmowych informacji bez konieczności ponownego trenowania modelu. Ta architektura jest bezcenna przy tworzeniu asystentów branżowych, botów wsparcia klienta czy systemów wiedzy wewnętrznej, które muszą być na bieżąco z dynamicznymi informacjami.

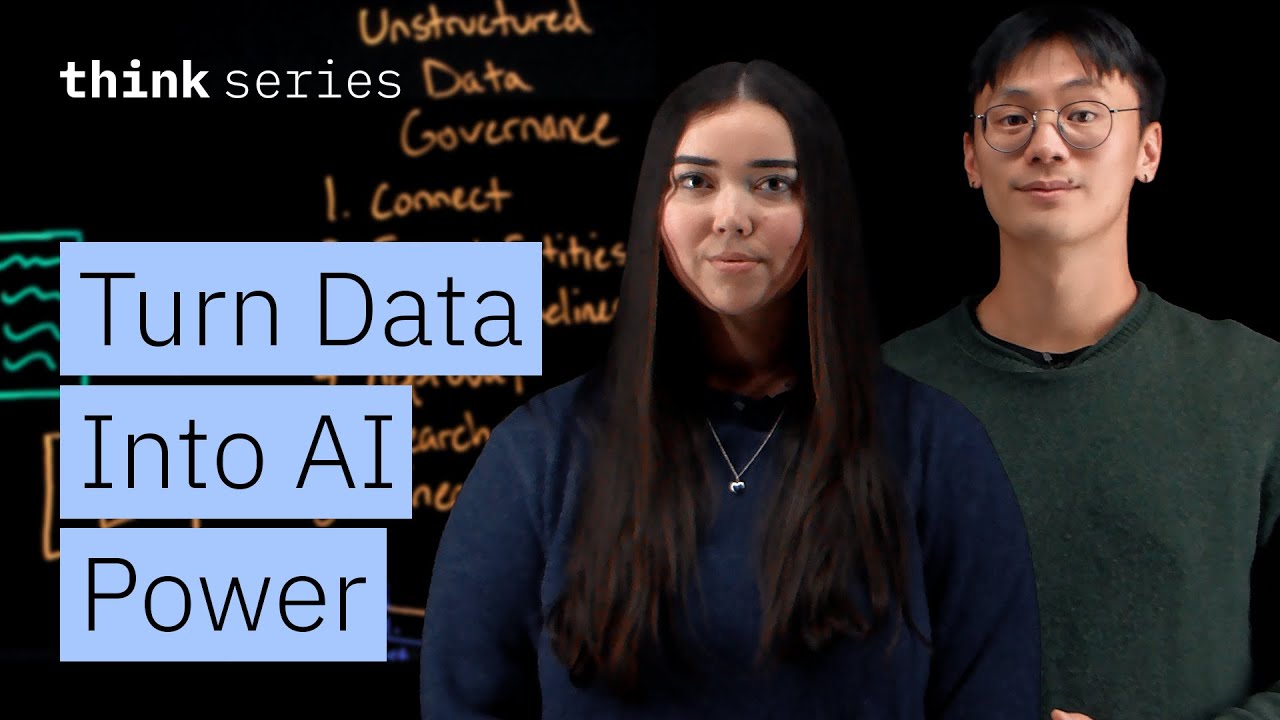

Integracja danych niestrukturalnych to proces przekształcania nieuporządkowanych, surowych treści w strukturalne, maszynowo czytelne zestawy danych dla AI. To jak rozszerzenie znanych zasad potoków ETL (Extract, Transform, Load), od lat fundamentu hurtowni danych, na nową modalność: dokumenty, e-maile, czaty, audio i wideo. Tak jak klasyczne potoki ETL automatyzują pobieranie, przetwarzanie i przygotowanie danych strukturalnych z baz i API, potoki integracji niestrukturalnej radzą sobie z różnorodnością formatów na dużą skalę. Siła tego podejścia leży w automatyzacji i powtarzalności. To, co kiedyś wymagało tygodni pisania skryptów i ręcznej obsługi, teraz można wykonać w kilka minut dzięki gotowym konektorom i operatorom. Typowy potok integracji niestrukturalnej obejmuje trzy główne etapy: pobieranie, przetwarzanie i ładowanie.

Pobieranie zaczyna się od łączenia się ze źródłami, gdzie znajdują się treści niestrukturalne. Nowoczesne platformy oferują gotowe konektory do systemów takich jak SharePoint, Box, Slack, magazyny plików, systemy pocztowe i inne. Zamiast pisać własny kod do każdego źródła, konektory obsługują uwierzytelnianie, stronicowanie i ekstrakcję danych automatycznie. Dzięki temu inżynierowie danych mogą skupić się na logice biznesowej, a nie na integracji. Ten etap rozwiązuje też problem odkrywania, gdzie w firmie rozproszone są dane niestrukturalne — co w dużych organizacjach nie jest trywialne.

Przetwarzanie to moment, w którym pojawia się prawdziwa inteligencja. Surowe dokumenty trafiają do serii gotowych operatorów rozwiązujących typowe wyzwania danych niestrukturalnych. Ekstrakcja tekstu wydobywa czytelną treść z PDF-ów, obrazów i innych formatów. Deduplikacja usuwa duplikaty, które mogłyby zaburzać analizę lub marnować miejsce. Adnotacja językowa identyfikuje język treści, umożliwiając obsługę wielojęzyczną. Usuwanie PII pozbywa się wrażliwych danych, takich jak numery PESEL, karty kredytowe czy nazwiska, zapewniając zgodność z przepisami o prywatności. Dzielenie na fragmenty rozbija duże dokumenty na mniejsze, semantycznie spójne segmenty — to kluczowe, bo modele AI mają ograniczone okna kontekstu, a bazy wektorowe lepiej działają na odpowiednio podzielonych danych. Na koniec wektoryzacja zamienia te fragmenty w embeddingi, czyli numeryczne reprezentacje wymagane przez bazy wektorowe. Wszystko to odbywa się automatycznie, bez konieczności angażowania ekspertów od machine learningu.

Ładowanie przesyła przetworzone embeddingi do bazy wektorowej, gdzie stają się dostępne dla agentów AI, systemów RAG, modeli klasyfikacji dokumentów, inteligentnego wyszukiwania i innych zastosowań AI. Efektem jest w pełni zautomatyzowany potok, który może szybko przetwarzać duże ilości różnorodnych treści i od razu udostępniać je systemom AI.

Jedną z najważniejszych funkcji nowoczesnej integracji niestrukturalnej jest przetwarzanie przyrostowe (delta processing). Gdy dokument się zmienia, nie trzeba uruchamiać całego potoku od nowa — system wykrywa tylko różnice i przekazuje je dalej. Dzięki temu potoki są zawsze aktualne na dużą skalę, bez kosztownego przetwarzania całości. W firmach z ogromnymi repozytoriami dokumentów, które często się zmieniają, taka efektywność jest przełomowa.

Bezpieczeństwo i kontrola dostępu są wbudowane w warstwę integracyjną. Natywne listy kontroli dostępu (ACL) zachowują uprawnienia do dokumentów na każdym etapie, gwarantując, że użytkownicy i agenci AI widzą tylko te treści, do których mają prawo. To kluczowe dla zgodności w branżach regulowanych i dla utrzymania ładu w firmach z rozbudowaną strukturą uprawnień. Jeśli dokument w źródle jest ograniczony do wybranych osób, te ograniczenia podążają za nim przez cały potok i do bazy wektorowej, zapewniając konsekwentne egzekwowanie uprawnień.

Integracja sprawia, że dane są użyteczne, a zarządzanie — że są godne zaufania. Zarządzanie danymi niestrukturalnymi to nie tylko dostarczenie ich do systemów AI; to także zapewnienie, że dane są odkrywalne, uporządkowane, poprawnie sklasyfikowane i zgodne z politykami firmy oraz wymogami regulacyjnymi. Tak jak dane strukturalne od lat korzystają z narzędzi do zarządzania — katalogów, śledzenia pochodzenia, monitorowania jakości — tak dane niestrukturalne potrzebują teraz własnej, dostosowanej do ich specyfiki infrastruktury.

Kompleksowy system zarządzania danymi niestrukturalnymi zwykle obejmuje kilka kluczowych komponentów. Odkrywanie zasobów i podłączanie zaczyna się od identyfikacji wszystkich niestrukturalnych zasobów firmy przy użyciu gotowych konektorów do różnych systemów. Tworzy to pełną inwentaryzację lokalizacji danych niestrukturalnych — podstawowy krok, z którym wiele firm ma trudności. Ekstrakcja i wzbogacanie encji przekształca surowe pliki w strukturalne, analizowalne dane, identyfikując kluczowe encje, takie jak nazwiska, daty, tematy i inne istotne informacje. Potoki wzbogacania klasyfikują treści, oceniają jakość i dodają metadane kontekstowe. Dokumenty mogą być tagowane tematycznie (np. “umowa”, “opinia klienta”, “specyfikacja produktu”), powiązane z osobami, wynikami analizy sentymentu czy innymi atrybutami. Te metadane ułatwiają porządkowanie, interpretację i wyszukiwanie treści.

Walidacja i kontrola jakości zapewniają dokładność i wiarygodność. Wyniki pojawiają się w prostych tabelach walidacyjnych z konfigurowalnymi regułami i alertami flagującymi metadane o niskiej pewności. Jeśli system nie jest pewny klasyfikacji lub ekstrakcji, sygnalizuje to recenzentom, zapobiegając wpuszczaniu błędnych danych do systemów AI. Takie podejście human-in-the-loop łączy automatyzację z precyzją.

Workflow i katalogowanie przesuwają zweryfikowane zasoby do centralnego katalogu, poprawiając organizację i odkrywalność. Dzięki technicznym i kontekstowym metadanym użytkownicy mogą inteligentnie przeszukiwać i filtrować wszystkie zasoby. Analityk danych szukający umów z konkretnym dostawcą czy compliance officer poszukujący dokumentów z określonymi wymogami regulacyjnymi może szybko znaleźć potrzebne informacje zamiast przeszukiwać tysiące plików.

Śledzenie pochodzenia danych i audytowalność dają pełną widoczność przepływu dokumentów od źródła do celu, ze wszystkimi transformacjami. To kluczowe dla zgodności i możliwość wykazania, że dane były odpowiednio chronione i przetwarzane. W branżach regulowanych taka ścieżka audytu może przesądzić o wyniku kontroli.

Te elementy zarządzania tworzą fundament zaufania. Zespoły danych mogą dostarczać niezawodne, strukturalne zbiory danych umożliwiające dokładne wyniki modeli AI, przy zachowaniu zgodności z przepisami i politykami firmy.

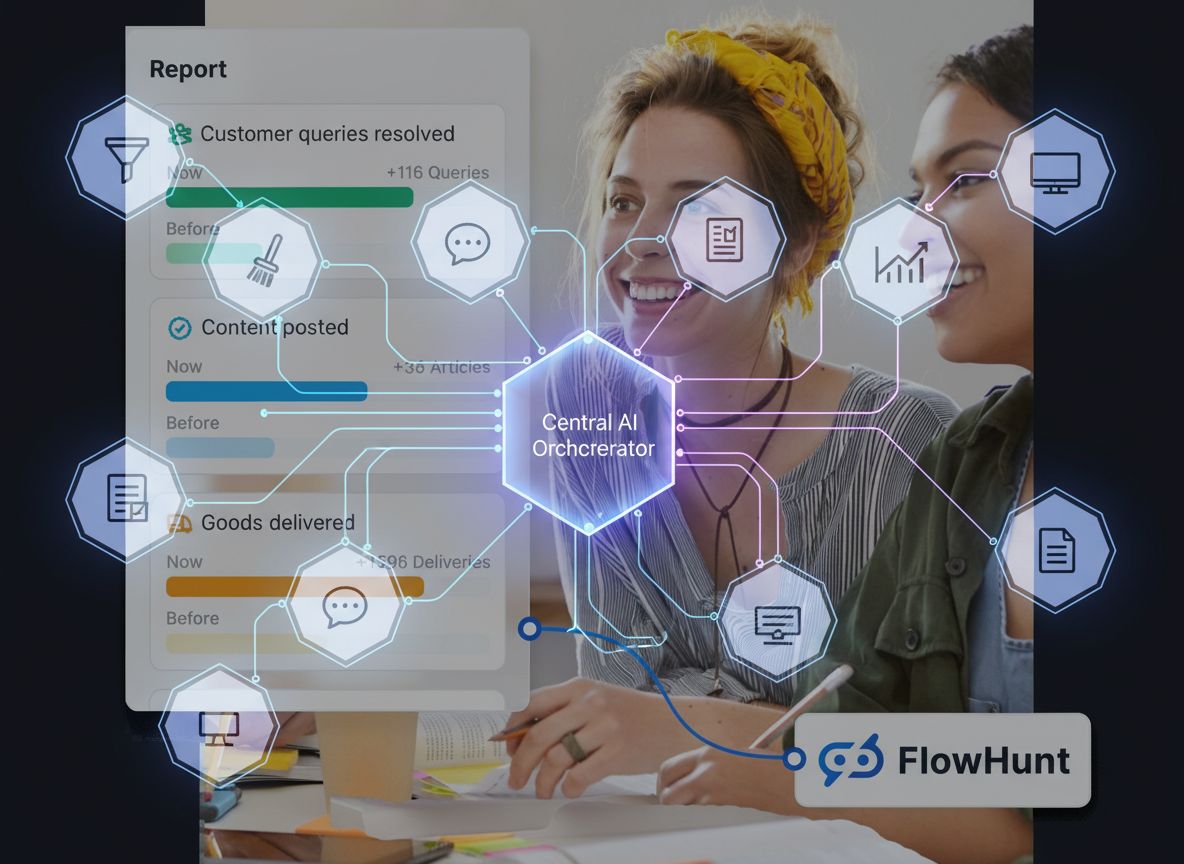

FlowHunt dostrzega, że przecięcie integracji i zarządzania danymi niestrukturalnymi to kluczowe wąskie gardło w adopcji AI przez przedsiębiorstwa. Automatyzując zarówno aspekty techniczne, jak i zarządcze, FlowHunt pozwala budować produkcyjne systemy AI bez tygodni ręcznego przygotowywania danych, które zwykle poprzedzają projekty AI. Podejście FlowHunt łączy inteligentną integrację danych z kompleksowym zarządzaniem, dzięki czemu zespoły danych mogą skupić się na wartości biznesowej, a nie na infrastrukturze. Platforma oferuje gotowe konektory do systemów firmowych, zautomatyzowane operatory transformacji i workflow zarządcze, które można konfigurować bez głębokiej wiedzy technicznej. Ta demokratyzacja zarządzania danymi niestrukturalnymi oznacza, że firmy każdej wielkości mogą wykorzystywać swoje dane do zasilania agentów AI i systemów RAG. Skracając czas od surowych danych do zbiorów gotowych pod AI z tygodni do minut, FlowHunt przyspiesza inicjatywy AI i umożliwia szybkie przejście od prototypów do systemów produkcyjnych.

Prawdziwa moc pojawia się, gdy integracja i zarządzanie danymi niestrukturalnymi działają razem. Integracja czyni dane użytecznymi, zarządzanie — wiarygodnymi. Razem zamykają lukę jakościową, która historycznie była zmorą systemów AI w firmach. Przykład: firma finansowa chce zbudować agenta AI, który pomoże analitykom ocenić ryzyko kredytowe na podstawie dokumentów klientów, sprawozdań finansowych i korespondencji historycznej. Bez integracji i zarządzania oznaczałoby to miesiące pracy: wyciąganie tekstu z PDF-ów, usuwanie danych wrażliwych, porządkowanie dokumentów według klientów i dat, ręczna walidacja kompletności i poprawności. Dzięki zintegrowanym potokom i warstwie governance proces jest zautomatyzowany. Dokumenty są pobierane z wielu źródeł, przetwarzane w celu usunięcia PII, dzielone na segmenty, wektoryzowane. Warstwa governance dba o poprawną klasyfikację, usunięcie danych wrażliwych i ograniczenie dostępu tylko do uprawnionych analityków. Embeddingi trafiają do bazy wektorowej, gdzie agent AI może natychmiast odnaleźć istotne informacje. Gdy agent dostaje zapytanie o konkretnego klienta, przeszukuje bazę pod kątem odpowiednich dokumentów, wybiera najbardziej pasujące fragmenty i na ich podstawie generuje ocenę ryzyka. Cały proces, który trwałby miesiące, teraz odbywa się w czasie rzeczywistym, z pełną zgodnością i możliwością audytu.

Ta architektura otwiera szereg zastosowań wykraczających poza samych agentów AI. Zespoły analityczne mogą analizować sentyment w rozmowach z klientami bez odsłuchiwania tysięcy godzin nagrań. Działy compliance mogą przeszukiwać umowy pod kątem ryzyk regulacyjnych i potencjalnych naruszeń. Zespoły operacyjne analizują raporty terenowe by wykrywać wzorce i nieefektywności. Zespoły obsługi klienta identyfikują klientów zagrożonych odejściem na podstawie analiz interakcji. Wszystko to staje się możliwe, gdy dane niestrukturalne są poprawnie zintegrowane i zarządzane.

Przejście z ręcznego przygotowania danych do automatycznych potoków niestrukturalnych to zasadnicza zmiana w podejściu firm do AI. Historycznie projekty AI przebiegały według schematu: data scientist buduje imponujący prototyp, ale skalowanie go do produkcji wymaga ogromnego wysiłku inżynieryjnego, by opanować złożoność danych, wymogi compliance i skalę. Ta luka między prototypem a produkcją była główną barierą adopcji AI — koszt i złożoność wdrożenia przewyższały oczekiwane korzyści.

Automatyzacja integracji i zarządzania danymi niestrukturalnymi zmienia ten bilans. Radząc sobie automatycznie z wyzwaniami infrastruktury danych, platformy te pozwalają płynnie przejść od prototypu do produkcji. Potok danych, który napędza prototyp, może być tym samym, który działa w produkcji — wystarczy go przeskalować. To ogranicza ryzyko, skraca czas do wartości biznesowej i czyni projekty AI bardziej opłacalnymi. Firmy mogą teraz uzasadniać inwestycje w AI krótszym okresem zwrotu i niższymi kosztami wdrożenia.

Przewaga konkurencyjna wykracza poza szybkość i koszty. Organizacje, które efektywnie wykorzystują swoje dane niestrukturalne, uzyskują dostęp do wniosków i możliwości nieosiągalnych dla tych, które nie mają odpowiedniej infrastruktury. Agent AI, który precyzyjnie odpowiada na pytania o polityki, produkty i historię klienta, to potężne narzędzie dla obsługi klienta, sprzedaży i zarządzania wiedzą. System compliance, który automatycznie skanuje umowy i wskazuje ryzyka, jest mnożnikiem siły dla działów prawnych i zgodności. System analityczny wydobywający wnioski z interakcji z klientami staje się źródłem przewagi konkurencyjnej. Te możliwości narastają z czasem, tworząc coraz większą przepaść między firmami, które zainwestowały w infrastrukturę danych, a tymi, które tego nie zrobiły.

Jednym z głównych powodów, dla których firmy obawiały się udostępniać dane niestrukturalne systemom AI, jest ryzyko ujawnienia informacji wrażliwych. Źle zaprojektowany potok może przypadkowo ujawnić dane klientów, tajemnice firmy lub naruszyć regulacje o prywatności. Dlatego bezpieczeństwo i compliance muszą być fundamentem infrastruktury danych, a nie dodatkiem na końcu.

Nowoczesne platformy integracji niestrukturalnej rozwiązują te problemy na wiele sposobów. Usuwanie PII automatycznie wykrywa i zamazuje dane wrażliwe jak nazwiska, PESEL, numery kart i inne dane osobowe. Listy kontroli dostępu zapewniają, że uprawnienia są zachowane na każdym etapie, a dokumenty ograniczone w źródle pozostaną ograniczone także w bazie wektorowej. Śledzenie pochodzenia danych tworzy audytowalną ścieżkę, pokazując krok po kroku, jak dane były przetwarzane, co pozwala działom compliance wykazać właściwe obchodzenie się z danymi. Szyfrowanie chroni dane w tranzycie i w spoczynku. Monitoring zgodności może flagować dokumenty lub transformacje mogące naruszać polityki firmy lub przepisy.

Funkcje bezpieczeństwa i zgodności to nie dodatki, ale konieczność dla firm z branż regulowanych jak finanse, zdrowie czy sektor publiczny. Są też coraz ważniejsze dla każdej firmy przetwarzającej dane klientów, bo przepisy jak RODO czy CCPA narzucają rygorystyczne wymagania. Dzięki wbudowanej zgodności firmy mogą bezpiecznie wykorzystywać dane niestrukturalne w AI bez obaw o naruszenia prawa czy bezpieczeństwa.

Zastosowania dobrze zintegrowanych i zarządzanych danych niestrukturalnych są szerokie i dotyczą niemal każdej branży i funkcji. Obsługa klienta może budować agentów AI z natychmiastowym dostępem do dokumentacji produktów, historii klienta i zgłoszeń, oferując szybsze i dokładniejsze odpowiedzi. Działy sprzedaży mogą używać agentów AI do szybkiego dostępu do informacji o konkurencji, klientach czy szablonach ofert, przyspieszając proces sprzedaży. Działy prawne i compliance mogą automatycznie skanować umowy pod kątem ryzyk i zgodności z przepisami. HR może analizować opinie pracowników, wykrywać trendy i poprawiać kulturę organizacyjną. Zespoły operacyjne mogą analizować raporty terenowe, wykrywać nieefektywności i optymalizować procesy. R&D może błyskawicznie przeszukiwać dokumentację techniczną, patenty czy publikacje naukowe, by odnaleźć istotne prace i uniknąć dublowania badań.

W każdym z tych przypadków wartość pochodzi nie z samego modelu AI, lecz z jakości i dostępności danych, do których model ma dostęp. Zaawansowany model językowy z dostępem do kiepskich, niepełnych czy niedostępnych danych wygeneruje słabe wyniki. Prostszy model z dostępem do wysokiej jakości, dobrze zarządzanych danych wygeneruje cenne wnioski i możliwości.

W miarę jak firmy inwestują w AI, sukces odniosą te, które zrozumieją, że powodzenie AI zależy od jakości danych. Nawet najdoskonalsze modele i algorytmy są bezużyteczne bez dostępu do wysokiej jakości, wiarygodnych danych. Dlatego integracja i zarządzanie danymi niestrukturalnymi stały się kluczowymi kompetencjami każdej organizacji poważnie myślącej o AI.

Droga do sukcesu obejmuje kilka kroków. Najpierw firmy muszą ocenić stan obecny: gdzie są dane niestrukturalne, w jakich formatach, jakie są bariery w ich wykorzystaniu? Następnie powinny zainwestować w infrastrukturę: wdrożyć platformy i narzędzia do automatycznej integracji i zarządzania danymi na dużą skalę. Kolejny krok to budowa kompetencji organizacyjnych: szkolenie zespołów danych w obsłudze nowych narzędzi i wdrożenie praktyk governance zapewniających jakość i zgodność. Następnie należy zacząć od najcenniejszych przypadków użycia: wybrać projekty AI o jasnej wartości biznesowej i na nich oprzeć decyzję o dalszych inwestycjach. Wreszcie, trzeba iterować i skalować: wyciągać wnioski z pierwszych projektów i stopniowo rozszerzać zakres inicjatyw AI w miarę wzrostu kompetencji i zaufania.

Firmy, które pójdą tą drogą, zyskają wyraźną przewagę. Zbudują systemy AI szybciej, mniejszym kosztem i z większą pewnością co do dokładności i zgodności. Uzyskają dostęp do wniosków niedostępnych dla konkurencji. Przejdą od prototypów AI do systemów produkcyjnych w miesiące, a nie lata. I zrobią to wszystko, utrzymując wymagane przez nowoczesne przedsiębiorstwa standardy bezpieczeństwa i zarządzania.

Przekonaj się, jak FlowHunt automatyzuje integrację i zarządzanie danymi niestrukturalnymi — od pobierania i przetwarzania po ładowanie i zgodność — umożliwiając budowę produkcyjnych agentów AI i systemów RAG w kilka minut zamiast tygodni.

Rewolucja AI w przedsiębiorstwach nie wygrają ci, którzy mają najdoskonalsze modele, lecz ci, którzy mają najlepszą infrastrukturę danych. Ponad 90% firmowych danych to dane niestrukturalne, a dziś mniej niż 1% z nich zasila systemy AI. To zarówno ogromne wyzwanie, jak i niezwykła szansa. Wdrażając automatyczną integrację i zarządzanie danymi niestrukturalnymi, firmy mogą odblokować te ukryte zasoby i stworzyć agentów AI oraz systemy RAG, które są nie tylko inteligentne, ale też dokładne, godne zaufania i zgodne z przepisami. Organizacje, które szybko zbudują taką infrastrukturę danych, uzyskają przewagę konkurencyjną, przeskoczą od prototypów do systemów produkcyjnych szybciej niż konkurenci, uzyskają dostęp do wniosków niedostępnych dla innych i zbudują kompetencje, które będą się kumulować z czasem. Przyszłość należy do tych firm, które zrozumieją, że sukces AI zależy od sukcesu w danych — i odpowiednio zainwestują w infrastrukturę, narzędzia i praktyki, które sprawią, że ich dane niestrukturalne zaczną dla nich pracować.

Dane niestrukturalne obejmują dokumenty, e-maile, pliki PDF, obrazy, audio i wideo — treści, które nie mieszczą się w uporządkowanych wierszach bazy danych. Ponad 90% danych w przedsiębiorstwach to dane niestrukturalne, a mniej niż 1% z nich trafia dziś do projektów AI. To ogromna, niewykorzystana szansa na zdobycie przewagi konkurencyjnej dzięki agentom AI i inteligentnym systemom.

RAG łączy wyszukiwanie i generowanie, najpierw przeszukując bazę danych wektorowych pod kątem istotnych informacji na podstawie podobieństwa semantycznego, a następnie przekazując ten kontekst do modelu AI, który generuje dokładne odpowiedzi. Bazy danych wektorowych przechowują embeddingi — numeryczne reprezentacje tekstu — umożliwiając szybkie, inteligentne wyszukiwanie oparte na znaczeniu, a nie tylko na słowach kluczowych.

Integracja przekształca surowe, nieuporządkowane dane niestrukturalne w zestawy danych czytelne dla maszyn za pomocą potoków ETL, czyniąc je użytecznymi dla AI. Zarządzanie zapewnia, że dane są wykrywalne, uporządkowane, godne zaufania i zgodne z przepisami poprzez wydobywanie metadanych, klasyfikowanie treści i śledzenie pochodzenia. Razem tworzą niezawodne, produkcyjne potoki danych.

Kluczem jest budowa inteligentnych potoków danych łączących integrację i zarządzanie. Integracja sprawia, że dane są użyteczne; zarządzanie — że są godne zaufania. Automatyzując przekształcanie niestrukturalnych danych w wysokiej jakości, kontekstualizowane zbiory danych, przedsiębiorstwa mogą skalować projekty AI od proof-of-concept do niezawodnych, zgodnych z przepisami systemów produkcyjnych.

Arshia jest Inżynierką Przepływów Pracy AI w FlowHunt. Z wykształceniem informatycznym i pasją do sztucznej inteligencji, specjalizuje się w tworzeniu wydajnych przepływów pracy, które integrują narzędzia AI z codziennymi zadaniami, zwiększając produktywność i kreatywność.

Odkryj, jak FlowHunt automatyzuje integrację i zarządzanie danymi niestrukturalnymi, napędzając dokładnych agentów AI i systemy RAG.

Dowiedz się, czym są dane niestrukturyzowane i jak wypadają na tle danych strukturyzowanych. Poznaj wyzwania oraz narzędzia wykorzystywane do pracy z danymi nie...

Połącz FlowHunt z Createve AI Nexus, aby zjednoczyć agentów AI, zautomatyzować przepływy pracy w przedsiębiorstwie oraz umożliwić integrację systemów w czasie r...

Dowiedz się, jak budować gotowe do produkcji systemy AI z wieloma agentami, korzystając z otwartego frameworka Strands od AWS. Odkryj, jak tworzyć wyspecjalizow...

Zgoda na Pliki Cookie

Używamy plików cookie, aby poprawić jakość przeglądania i analizować nasz ruch. See our privacy policy.