Przewodnik rozwoju dla serwerów MCP

Dowiedz się, jak zbudować i wdrożyć serwer Model Context Protocol (MCP), aby połączyć modele AI z zewnętrznymi narzędziami i źródłami danych. Przewodnik krok po...

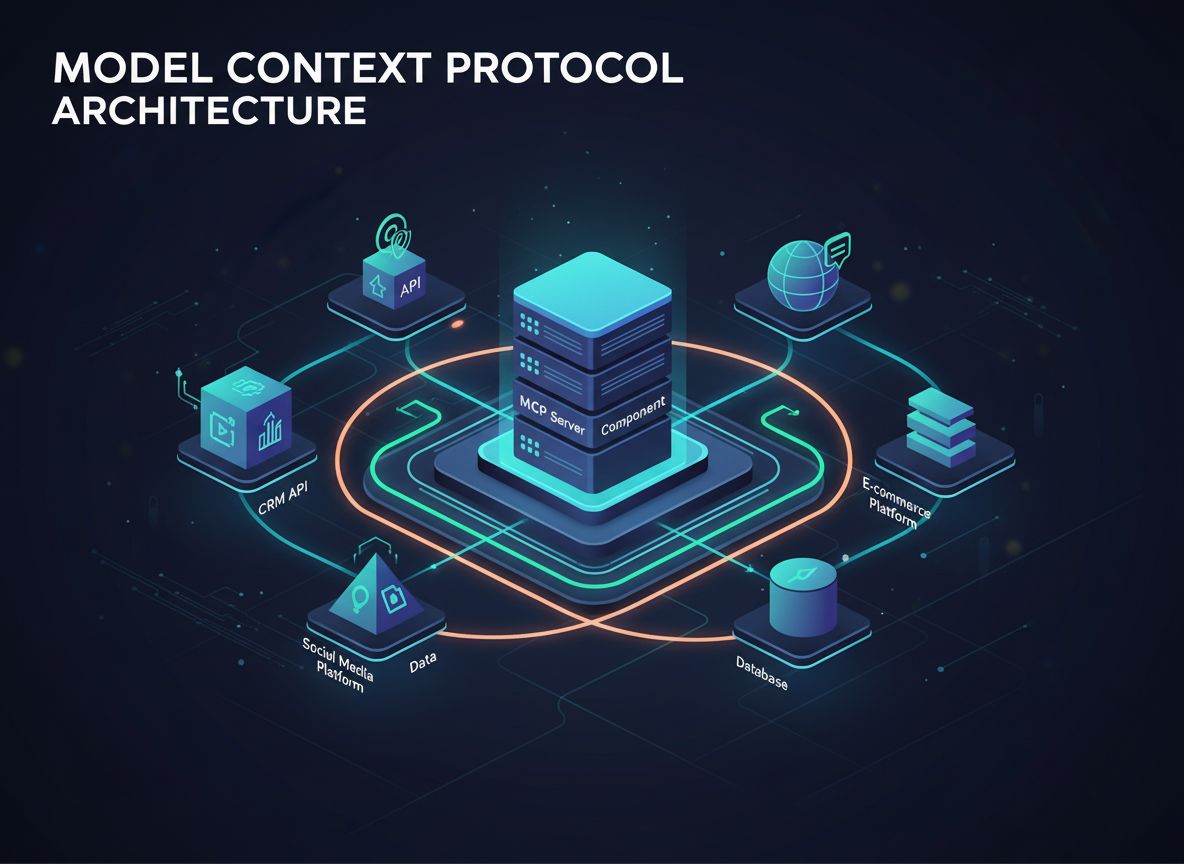

Dowiedz się, czym są serwery MCP (Model Context Protocol), jak działają i dlaczego rewolucjonizują integrację AI. Odkryj, jak MCP upraszcza łączenie agentów AI z narzędziami, źródłami danych i API.

Szybki rozwój sztucznej inteligencji spowodował niespotykane wcześniej zapotrzebowanie na płynną integrację modeli AI z systemami zewnętrznymi. Jednak deweloperzy i przedsiębiorstwa od dawna borykają się z podstawowym wyzwaniem: połączenie wielu dużych modeli językowych (LLM) z licznymi narzędziami, API i źródłami danych wymaga budowania i utrzymywania niezliczonych niestandardowych integracji. Ta złożoność utrudniała rozwój naprawdę zaawansowanych agentów AI, którzy mogliby uzyskiwać dostęp do rzeczywistych informacji i wykonywać znaczące działania. Z pomocą przychodzi Model Context Protocol (MCP) — rewolucyjny, otwarty standard, który fundamentalnie zmienia sposób, w jaki aplikacje AI łączą się ze światem. W tym kompleksowym przewodniku wyjaśnimy, czym są serwery MCP, jak działają, dlaczego są ważne i jak zmieniają oblicze automatyzacji oraz integracji AI.

Model Context Protocol to zmiana paradygmatu w sposobie, w jaki systemy sztucznej inteligencji wchodzą w interakcje z danymi i narzędziami zewnętrznymi. U podstaw MCP leży otwarty standard, który zapewnia jednolity, ustandaryzowany sposób łączenia aplikacji AI z systemami zewnętrznymi. Można to porównać do uniwersalnego adaptera lub, jak często mówi się w branży, „portu USB-C dla aplikacji AI”. Tak jak USB-C zapewnia standardowe złącze, które działa z niezliczonymi urządzeniami niezależnie od producenta, tak MCP zapewnia ustandaryzowany protokół, który działa z różnymi modelami AI i systemami zewnętrznymi. Ta standaryzacja eliminuje konieczność tworzenia dedykowanych, jednorazowych integracji pomiędzy każdym LLM a każdym narzędziem lub źródłem danych. Przed MCP deweloperzy mierzyli się z wykładniczym wzrostem złożoności wraz z dodawaniem kolejnych modeli AI lub systemów zewnętrznych. MCP fundamentalnie upraszcza tę architekturę, tworząc jeden, spójny interfejs, z którego mogą korzystać wszystkie aplikacje AI i systemy zewnętrzne.

Protokół został opracowany przez firmę Anthropic i udostępniony jako inicjatywa open-source, aby rozwiązać kluczowy problem w ekosystemie deweloperów AI. Zamiast zmuszać deweloperów do wynajdowania koła na nowo dla każdej kombinacji modelu AI i systemu zewnętrznego, MCP zapewnia ustandaryzowaną ramę, która drastycznie skraca czas tworzenia, zmniejsza koszty utrzymania i złożoność integracji. Takie podejście spotkało się z entuzjazmem wśród deweloperów, ponieważ uznaje zasadniczą prawdę: przyszłość AI to nie izolowane chatboty, lecz inteligentni agenci, którzy mogą płynnie uzyskiwać dostęp do informacji, wchodzić w interakcje z systemami i wykonywać działania w całym stosie technologicznym organizacji.

Zanim zagłębimy się, jak działa MCP, warto zrozumieć problem, który rozwiązuje — wyzwanie towarzyszące rozwojowi AI od początku pojawienia się potężnych modeli językowych. Chodzi o tzw. „problem NxM”, gdzie N oznacza liczbę dostępnych LLM, a M liczbę narzędzi, API i źródeł danych, które organizacje chcą połączyć z tymi modelami. Bez ustandaryzowanego protokołu każdy LLM wymaga własnego kodu integracyjnego dla każdego narzędzia, co daje w sumie N razy M punktów integracji. Powoduje to wykładniczy wzrost złożoności, który staje się coraz trudniejszy do opanowania wraz ze skalowaniem inicjatyw AI.

Rozważmy praktyczny przykład: firma chce korzystać zarówno z Claude, jak i ChatGPT, aby obsługiwać swoją stronę WordPress, środowisko Notion, kalendarz Google i wewnętrzną bazę danych. Bez MCP deweloperzy musieliby stworzyć osiem oddzielnych integracji — jedną dla Claude z WordPressem, jedną dla Claude z Notion, jedną dla Claude z Google Calendar, jedną dla Claude z bazą danych i cały proces powtórzyć dla ChatGPT. Każda integracja to niestandardowy kod, testy i bieżąca konserwacja. Jeśli firma zdecyduje się później dodać trzeci model AI lub piąte źródło danych, liczba integracji rośnie wykładniczo. Ta powtarzalność powoduje liczne problemy: zespoły deweloperskie ciągle rozwiązują te same wyzwania integracyjne, utrzymanie staje się koszmarem, a niespójne implementacje prowadzą do nieprzewidywalnych zachowań i złych doświadczeń użytkowników.

MCP rozwiązuje ten problem, eliminując związek NxM. Zamiast wymagać N×M integracji, MCP pozwala budować N+M połączeń. Każdy LLM łączy się z protokołem MCP tylko raz, a każde narzędzie lub źródło danych udostępnia się przez serwer MCP tylko raz. Ten liniowy układ drastycznie zmniejsza złożoność i koszty utrzymania. Gdy pojawia się nowy model AI, wystarczy zaimplementować obsługę MCP, aby uzyskać dostęp do wszystkich istniejących serwerów MCP. Podobnie, gdy trzeba zintegrować nowe narzędzie lub źródło danych, wystarczy udostępnić interfejs serwera MCP, aby stało się dostępne dla wszystkich kompatybilnych aplikacji AI. To eleganckie rozwiązanie ma ogromne znaczenie dla budowy i skalowania infrastruktury AI w organizacji.

Serwer MCP to zasadniczo zbiór narzędzi, API i baz wiedzy zebranych pod jednym, ustandaryzowanym interfejsem. Zamiast zmuszać agenta AI do łączenia się z dwudziestoma różnymi endpointami API i zarządzania dwudziestoma oddzielnymi schematami autoryzacji, serwer MCP konsoliduje je w jeden spójny komponent. Takie podejście architektoniczne znacząco upraszcza proces integracji i czyni agentów AI znacznie bardziej wydajnymi w odkrywaniu i wykorzystywaniu potrzebnych narzędzi.

Aby zobaczyć, jak to działa w praktyce, rozważmy serwer MCP dla WordPressa. Zamiast aby agent AI musiał znać i łączyć się z oddzielnymi punktami API REST dla postów, stron, mediów, użytkowników, kategorii, tagów, komentarzy i wtyczek, serwer MCP dla WordPressa udostępnia wszystkie te możliwości przez jeden interfejs. Serwer MCP zawiera wiele narzędzi — utwórz post, wylistuj posty, pobierz post, usuń post, utwórz stronę, wylistuj strony itd. — każde z wyraźnym tytułem i opisem. Gdy agent AI musi wykonać akcję, odpytuje serwer MCP, który zwraca listę dostępnych narzędzi wraz z ich opisami. Agent może następnie inteligentnie wybrać odpowiednie narzędzie na podstawie żądania użytkownika i wykonać je bez znajomości złożoności API.

Architektura MCP składa się z kilku kluczowych komponentów działających wspólnie. Po pierwsze, jest klient MCP, czyli zazwyczaj aplikacja AI lub agent, który musi uzyskać dostęp do narzędzi i danych zewnętrznych. Klient inicjuje połączenia i wysyła żądania narzędzi i zasobów. Po drugie, jest serwer MCP, który udostępnia narzędzia, zasoby i funkcje przez ustandaryzowany interfejs MCP. Serwer obsługuje faktyczną integrację z systemami zewnętrznymi i zarządza wykonywaniem narzędzi. Po trzecie, jest sam protokół, który definiuje sposób komunikacji klientów i serwerów, w tym format żądań, odpowiedzi i obsługę błędów. Taka trójdzielna architektura pozwala zachować przejrzystość i skalowalność całego systemu.

Jednym z najbardziej eleganckich aspektów MCP jest sposób obsługi odkrywania i uruchamiania narzędzi. Każde narzędzie udostępnione przez serwer MCP zawiera nie tylko samo narzędzie, ale także metadane — nazwę, opis, parametry i oczekiwane wyniki. Gdy agent AI łączy się z serwerem MCP, otrzymuje te metadane, co pozwala agentowi zrozumieć, jakie narzędzia są dostępne i kiedy ich użyć. To fundamentalnie różni się od tradycyjnej integracji API, gdzie deweloperzy muszą ręcznie konfigurować każdy endpoint i uczyć model AI jego możliwości. Dzięki MCP proces odkrywania jest automatyczny i ustandaryzowany, co ułatwia agentom AI szybkie znajdowanie i wykorzystywanie odpowiednich narzędzi dla dowolnego zadania.

FlowHunt dostrzega przełomowy potencjał serwerów MCP w automatyzacji AI i zapewnił kompleksowe wsparcie dla integracji MCP w swojej platformie. Wykorzystując serwery MCP, FlowHunt pozwala użytkownikom budować zaawansowane przepływy AI, które płynnie uzyskują dostęp do wielu narzędzi i źródeł danych bez tradycyjnej złożoności ręcznej konfiguracji API. Ta integracja to znaczący postęp w sposobie, w jaki organizacje mogą automatyzować procesy biznesowe wykorzystując agentów AI.

W FlowHunt użytkownicy mogą łatwo dodać serwery MCP do swoich przepływów, uzyskując natychmiastowy dostęp do wszystkich narzędzi i funkcji oferowanych przez te serwery. Przykładowo, dodając serwer MCP dla WordPressa do przepływu w FlowHunt, użytkownik od razu zyskuje możliwość tworzenia postów, zarządzania stronami, obsługi mediów, zarządzania użytkownikami i wykonywania dziesiątek innych operacji WordPress — wszystko bez ręcznej konfiguracji każdego API. To znacząco przyspiesza tworzenie przepływów i redukuje bariery techniczne w budowie potężnej automatyzacji AI. Podejście FlowHunt do integracji MCP pokazuje, jak protokół umożliwia nową generację platform automatyzacji AI, które stawiają na prostotę i szybkość wdrożenia bez utraty mocy i elastyczności.

Wsparcie platformy dla serwerów MCP wykracza poza prosty dostęp do narzędzi. FlowHunt umożliwia łańczenie wielu serwerów MCP w złożonych przepływach, pozwalając agentom AI orkiestrację działań w wielu systemach w odpowiedzi na żądania użytkownika lub automatyczne wyzwalacze. Ta możliwość całkowicie zmienia możliwości automatyzacji AI, umożliwiając scenariusze takie jak automatyczne tworzenie postów WordPress na podstawie treści wygenerowanych przez agenta AI, aktualizowanie baz Notion danymi z różnych źródeł czy synchronizację danych między wieloma platformami w czasie rzeczywistym. Dzięki ukryciu złożoności integracji serwerów MCP, FlowHunt pozwala użytkownikom skupić się na projektowaniu inteligentnych przepływów zamiast walczyć z technikaliami integracyjnymi.

Teoretyczne zalety serwerów MCP przekładają się na konkretne, wymierne korzyści w praktyce. Organizacje wdrażające architekturę opartą na MCP zgłaszają znaczne skrócenie czasu wdrożenia — niektóre zespoły osiągają integracje o 50-70% szybciej w porównaniu do tradycyjnych, niestandardowych podejść API. To przyspieszenie wynika z eliminacji powielanych prac i standaryzacji implementacji MCP. Gdy deweloper musi dodać nowe narzędzie do przepływu AI, nie zaczyna już od zera — korzysta z istniejącego serwera MCP, który został już zbudowany, przetestowany i udokumentowany przez twórców narzędzia lub społeczność.

Utrzymanie to kolejny obszar, gdzie MCP daje wymierne korzyści. W tradycyjnej architekturze, gdy API się zmienia lub pojawia się nowa wersja, deweloperzy muszą aktualizować niestandardowy kod integracyjny w wielu aplikacjach i modelach AI. W MCP główny ciężar utrzymania spada na opiekunów serwera MCP, którzy aktualizują serwer tylko raz, aby odzwierciedlić zmiany w API. Wszystkie aplikacje korzystające z tego serwera automatycznie korzystają z aktualizacji bez konieczności zmiany własnego kodu. Taki scentralizowany model utrzymania drastycznie ogranicza koszty operacyjne i pozwala zespołom skupić się na tworzeniu nowych funkcji zamiast utrzymywać istniejące integracje.

Z perspektywy końcowego użytkownika serwery MCP umożliwiają tworzenie bardziej zaawansowanych i responsywnych aplikacji AI. Użytkownicy mogą poprosić swoich agentów AI o wykonanie złożonych zadań obejmujących wiele systemów — „Utwórz nowy wpis na blogu w WordPress na podstawie tego dokumentu Notion i opublikuj go w social media” — a agent wykona te zadania płynnie, ponieważ wszystkie potrzebne narzędzia są dostępne przez ustandaryzowane interfejsy MCP. To tworzy bardziej naturalne i potężne doświadczenie użytkownika, w którym agenci AI są prawdziwymi asystentami rozumiejącymi i obsługującymi całą technologiczną rzeczywistość użytkownika, a nie tylko izolowane narzędzia o wąskim zastosowaniu.

Dla deweloperów zainteresowanych budową własnych serwerów MCP, protokół oferuje jasne, dobrze udokumentowane ramy do udostępniania narzędzi i zasobów. Tworzenie serwera MCP polega na zdefiniowaniu narzędzi, które mają być udostępnione, określeniu ich parametrów i wartości zwracanych oraz implementacji logiki uruchamianej po ich wywołaniu. Specyfikacja MCP zawiera szczegółowe wskazówki, jak taki kod zorganizować i jak obsługiwać komunikację z klientami MCP. Dzięki temu deweloperzy nie muszą wymyślać nowych wzorców dla każdego serwera — mogą korzystać ze sprawdzonych praktyk i skupić się na konkretnej funkcjonalności, którą ich serwer ma zapewnić.

Model wdrożenia serwerów MCP jest elastyczny i obsługuje różne architektury. Serwery mogą działać jako niezależne procesy na komputerze dewelopera, być wdrażane w chmurze lub osadzone w większych aplikacjach. To pozwala organizacjom dobierać strategie wdrożenia zgodnie z istniejącą infrastrukturą i wymaganiami bezpieczeństwa. Niektóre firmy uruchamiają serwery MCP lokalnie do testów, a następnie wdrażają je w chmurze produkcyjnie. Inne osadzają je bezpośrednio w aplikacjach, aby zapewnić lokalny dostęp do narzędzi bez zewnętrznych połączeń sieciowych. Ta architektoniczna elastyczność jest jedną z przyczyn szybkiej adopcji MCP przez deweloperów.

Kwestie bezpieczeństwa są kluczowe przy budowaniu i wdrażaniu serwerów MCP, szczególnie jeśli udostępniają one dostęp do wrażliwych systemów lub danych. Specyfikacja MCP zawiera wytyczne dotyczące uwierzytelniania, autoryzacji i bezpiecznej komunikacji pomiędzy klientami a serwerami. Tworząc serwery MCP, deweloperzy muszą starannie przemyśleć, kto i do jakich narzędzi ma mieć dostęp, i wdrożyć odpowiednie mechanizmy kontroli dostępu. Przykładowo, serwer MCP dla WordPressa może ograniczyć operacje takie jak usuwanie postów czy modyfikacja uprawnień użytkowników wyłącznie do uwierzytelnionych użytkowników o odpowiednich rolach. Podobnie serwer MCP dla bazy danych może ograniczyć możliwości zapytań, aby zapobiec nieautoryzowanemu dostępowi do danych. Te kwestie bezpieczeństwa nie są unikalne dla MCP, lecz standaryzacja protokołu ułatwia ich konsekwentne wdrożenie w różnych serwerach.

Ekosystem MCP rozwija się dynamicznie od czasu wprowadzenia protokołu — deweloperzy i firmy tworzą serwery MCP dla imponującej liczby narzędzi i platform. Oficjalny rejestr MCP prezentuje serwery dla popularnych platform, takich jak WordPress, Notion, Google Calendar, GitHub, Slack i wiele innych. Rosnący ekosystem oznacza, że organizacje często mogą znaleźć już gotowe serwery MCP dla używanych narzędzi, eliminując konieczność budowy integracji od zera. Dla narzędzi, dla których serwery MCP nie istnieją, ustandaryzowany protokół ułatwia deweloperom ich stworzenie.

Różnorodność dostępnych serwerów MCP pokazuje elastyczność protokołu. Niektóre serwery udostępniają proste, tylko do odczytu API — na przykład pozwalają agentom AI przeszukiwać i pobierać informacje z bazy wiedzy. Inne oferują pełne możliwości CRUD (Create, Read, Update, Delete), umożliwiając agentom AI wprowadzanie istotnych zmian w systemach zewnętrznych. Jeszcze inne udostępniają specjalistyczne funkcje, takie jak generowanie obrazów, analiza danych czy wykonywanie kodu. Ta różnorodność odzwierciedla fakt, że różne organizacje mają różne potrzeby, a elastyczna architektura MCP je uwzględnia, zachowując spójny interfejs.

Ogromną rolę w rozwoju ekosystemu MCP odgrywa społeczność. Deweloperzy tworzą serwery dla niszowych narzędzi i platform, wiedząc, że nawet jeśli dane narzędzie nie jest powszechnie używane, dostępność serwera MCP bardzo ułatwia integrację z AI dla organizacji z niego korzystających. Takie podejście społecznościowe tworzy efekt kuli śnieżnej — dostępność serwerów MCP zachęca kolejne firmy do wdrażania architektury opartej na MCP, co z kolei motywuje deweloperów do tworzenia kolejnych serwerów. Efektem jest szybko rosnący ekosystem czyniący MCP coraz bardziej wartościowym w miarę, jak więcej narzędzi i platform zyskuje wsparcie MCP.

Wraz ze wzrostem zaawansowania organizacji w wykorzystaniu AI, serwery MCP umożliwiają coraz bardziej złożone i potężne przepływy pracy. Przykładem może być orkiestracja wielu systemów — agenci AI koordynują działania na różnych platformach w odpowiedzi na polecenia użytkownika lub automatyczne wyzwalacze. Przykładowo, zespół marketingu może korzystać z agenta AI monitorującego wzmianki w social media, tworzącego wpisy WordPress na podstawie trendów, aktualizującego bazę Notion z kalendarzami treści i planującego publikacje na kilku platformach — wszystko skoordynowane przez jednego agenta AI korzystającego z wielu serwerów MCP.

Innym zaawansowanym zastosowaniem jest agregacja i analiza danych. Organizacje mogą tworzyć serwery MCP udostępniające dane z kilku systemów wewnętrznych, pozwalając agentom AI zbierać informacje z różnych źródeł, analizować je i generować wnioski. Przykładowo, firma finansowa może stworzyć serwery MCP udostępniające dane z systemu księgowego, CRM i dostawców danych rynkowych, umożliwiając agentowi AI analizę rentowności klientów, trendów rynkowych i wyników finansowych w zintegrowany sposób. Dzięki temu AI staje się nie tylko narzędziem do pracy na izolowanych danych, lecz prawdziwą platformą business intelligence obejmującą całą organizację.

Personalizacja i świadomość kontekstu to kolejny kierunek rozwoju aplikacji opartych na MCP. Udostępniając dane użytkownika, preferencje i historię przez serwery MCP, aplikacje mogą przekazywać agentom AI bogaty kontekst dotyczący konkretnej osoby. Umożliwia to dostarczanie wysoce spersonalizowanych doświadczeń — AI pamięta preferencje użytkownika, rozumie jego cele i dostosowuje odpowiedzi. Przykładowo, agent obsługi klienta może korzystać z serwerów MCP udostępniających historię zakupów, zgłoszenia i preferencje klienta, zapewniając spersonalizowaną pomoc uwzględniającą indywidualną sytuację i historię.

Aby w pełni docenić wartość MCP, warto porównać go z tradycyjnymi metodami integracji aplikacji AI z systemami zewnętrznymi. W klasycznych architekturach deweloperzy ręcznie konfigurują każdą integrację API, pisząc niestandardowy kod do obsługi uwierzytelniania, formatowania żądań, obsługi błędów i parsowania odpowiedzi. To podejście sprawdza się przy prostych integracjach, ale staje się coraz trudniejsze wraz ze wzrostem liczby systemów do połączenia. Każda nowa integracja wymaga poznania dokumentacji konkretnego API, jego ograniczeń i napisania dedykowanego kodu.

Tradycyjna integracja API generuje także duże wyzwania związane z utrzymaniem. Gdy API się zmienia, deweloperzy muszą aktualizować swój kod integracyjny. Gdy pojawia się nowa wersja API, muszą zdecydować o aktualizacji i obsłużyć ewentualne zmiany. Gdy organizacja chce dodać nowy model AI do swojego stosu, deweloperzy muszą odtworzyć wszystkie integracje API dla tego nowego modelu. Te wyzwania narastają z czasem, generując dług technologiczny, który spowalnia rozwój i zwiększa koszty operacyjne.

MCP rozwiązuje te problemy poprzez standaryzację i abstrakcję. Zamiast pisać kod dla każdego API, deweloperzy implementują protokół MCP tylko raz dla każdego narzędzia lub źródła danych. Dzięki temu wszystkie aplikacje AI automatycznie zyskują dostęp do wszystkich serwerów MCP bez potrzeby niestandardowej integracji. Gdy API się zmienia, opiekunowie serwera MCP aktualizują go, a wszystkie korzystające z niego aplikacje automatycznie korzystają z aktualizacji. Gdy pojawia się nowy model AI, wystarczy jednokrotnie zaimplementować obsługę MCP, by uzyskać dostęp do wszystkich istniejących serwerów. Takie podejście fundamentalnie zmienia ekonomię integracji AI, czyniąc ją znacznie bardziej wydajną i skalowalną.

Ekosystem MCP rozwija się bardzo dynamicznie, a trwające prace koncentrują się na poszerzaniu możliwości, poprawie wydajności i obsłudze nowych zastosowań. Jeden z obszarów rozwoju to wsparcie dla przesyłania danych w czasie rzeczywistym i architektur zdarzeniowych. W miarę wzrostu zaawansowania aplikacji AI, możliwość natychmiastowego wysyłania powiadomień przez serwery MCP do klientów staje się coraz bardziej cenna. Wyobraź sobie agenta AI, który otrzymuje powiadomienia w czasie rzeczywistym o zdarzeniach w systemach zewnętrznych i reaguje natychmiast, zamiast czekać na kolejne odpytywanie. Takie możliwości otwierają nowe scenariusze reaktywnych, zdarzeniowych przepływów AI.

Kolejnym kierunkiem rozwoju jest wsparcie dla złożonych, wieloetapowych operacji. Obecne implementacje MCP dobrze radzą sobie z pojedynczymi wywołaniami narzędzi, ale rośnie zainteresowanie umożliwieniem serwerom MCP udostępniania operacji wyższego poziomu, obejmujących wiele kroków i złożoną logikę. Pozwoliłoby to agentom AI na wywoływanie złożonych operacji, takich jak „zmigruj tę stronę WordPress na nowego hosta” czy „scal te trzy bazy danych w jeden magazyn”, podczas gdy serwer MCP zajmie się całą złożonością. Taki rozwój jeszcze bardziej odciąży deweloperów od szczegółów technicznych i pozwoli agentom AI działać na wyższym poziomie abstrakcji.

Bezpieczeństwo i zarządzanie to kolejny istotny obszar dla społeczności MCP. Wraz z rosnącą liczbą serwerów MCP mających dostęp do wrażliwych systemów i danych, potrzeba solidnych mechanizmów bezpieczeństwa, rejestrowania i zarządzania staje się kluczowa. Społeczność intensywnie pracuje nad standardami uwierzytelniania, autoryzacji, szyfrowania i śledzenia dostępu, które umożliwią bezpieczne wdrażanie serwerów MCP także w środowiskach korporacyjnych podlegających ścisłym regulacjom, jak finanse, zdrowie czy sektor publiczny.

Dla organizacji rozważających wdrożenie MCP, kilka praktycznych wskazówek powinno kształtować strategię implementacji. Po pierwsze, przeanalizuj swój obecny stos technologiczny i zidentyfikuj narzędzia oraz systemy, które najbardziej skorzystają na integracji przez MCP. Priorytetowo potraktuj systemy często używane przez wiele aplikacji lub wymagające złożonych integracji — tam MCP przyniesie największą wartość. Po drugie, sprawdź, czy serwery MCP dla tych systemów już istnieją. Jeśli tak, możesz z nich skorzystać od razu. Jeśli nie, oceń, czy budowa własnych serwerów MCP jest wykonalna przy dostępnych zasobach i kompetencjach.

Po trzecie, przemyśl architekturę wdrożenia i wymagania bezpieczeństwa. Zdecyduj, czy serwery MCP powinny działać lokalnie, w chmurze czy być osadzane w aplikacjach. Zastanów się, jak obsłużysz uwierzytelnianie i autoryzację, zwłaszcza jeśli serwery MCP uzyskują dostęp do wrażliwych systemów lub danych. Po czwarte, planuj stopniowe wdrożenie zamiast próbować przenieść całą architekturę integracyjną na MCP od razu. Zacznij od pilotażowego projektu dla konkretnego przepływu lub zastosowania. Pozwoli to zespołowi zdobyć doświadczenie, zidentyfikować wyzwania i dopracować podejście przed szerszym wdrożeniem.

Na koniec zainwestuj w szkolenia i dokumentację dla zespołu deweloperskiego. Choć MCP jest przyjazny deweloperom, warto zrozumieć jego architekturę, najlepsze praktyki budowy serwerów MCP i sposób ich integracji z aplikacjami. W sieci dostępnych jest wiele materiałów — oficjalna dokumentacja, poradniki społeczności i przykładowe implementacje. Zbudowanie tej bazy wiedzy przyspieszy efektywne wykorzystanie MCP w Twojej organizacji.

Model Context Protocol to fundamentalna zmiana w sposobie, w jaki aplikacje AI łączą się z systemami i źródłami danych. Zapewniając ustandaryzowany, uniwersalny interfejs dla integracji AI-system, MCP eliminuje wykładniczą złożoność tradycyjnych integracji API. Protokół rozwiązuje problem NxM, drastycznie skraca czas wdrożenia i koszty utrzymania oraz pozwala organizacjom budować bardziej zaawansowane aplikacje AI, które płynnie korzystają z całego ekosystemu technologicznego. W miarę rozwoju ekosystemu MCP, poszerzania dostępnych serwerów i rozbudowy protokołu, MCP ma szansę stać się standardem integracji AI w każdej branży. Firmy, które wdrożą MCP wcześnie, zyskają przewagę konkurencyjną dzięki możliwości szybkiego budowania i wdrażania zaawansowanych rozwiązań automatyzacji AI. Niezależnie czy budujesz aplikacje AI, tworzysz narzędzia i platformy, czy zarządzasz infrastrukturą IT — zrozumienie i wykorzystanie serwerów MCP będzie coraz ważniejsze, by utrzymać konkurencyjność w przyszłości napędzanej przez AI.

Przekonaj się, jak FlowHunt automatyzuje Twoje treści AI i procesy SEO — od researchu i tworzenia treści po publikację i analitykę — wszystko w jednym miejscu. Wykorzystaj serwery MCP, by płynnie połączyć cały swój stos technologiczny.

MCP to skrót od Model Context Protocol. Jest to otwarty standard opracowany przez Anthropic, który zapewnia ustandaryzowany sposób łączenia aplikacji AI, takich jak Claude i ChatGPT, z systemami zewnętrznymi, źródłami danych i narzędziami.

Problem NxM odnosi się do złożoności integracji N różnych LLM z M różnymi narzędziami i źródłami danych. MCP rozwiązuje ten problem, zapewniając uniwersalny standard, eliminując konieczność tworzenia niestandardowych integracji pomiędzy każdą kombinacją LLM i narzędzi. Zamiast N×M integracji, potrzebujesz tylko N+M połączeń.

Serwery MCP skracają czas i złożoność wdrożenia, zapewniają dostęp do ekosystemu źródeł danych i narzędzi, eliminują powielanie prac integracyjnych, zmniejszają koszty utrzymania oraz umożliwiają tworzenie bardziej zaawansowanych aplikacji AI mających dostęp do danych w czasie rzeczywistym i mogących wykonywać akcje w imieniu użytkowników.

Tak, MCP zostało zaprojektowane jako rozwiązanie niezależne od modelu. Współpracuje z różnymi aplikacjami AI, w tym Claude, ChatGPT i innymi LLM. Ta uniwersalna kompatybilność jest jedną z głównych zalet standardu MCP.

Serwery MCP mogą integrować praktycznie każdy system zewnętrzny, w tym API, bazy danych, bazy wiedzy, systemy plików, usługi internetowe i narzędzia specjalistyczne. Typowe przykłady to WordPress, Google Calendar, Notion, Figma, Blender oraz bazy danych w przedsiębiorstwach.

Arshia jest Inżynierką Przepływów Pracy AI w FlowHunt. Z wykształceniem informatycznym i pasją do sztucznej inteligencji, specjalizuje się w tworzeniu wydajnych przepływów pracy, które integrują narzędzia AI z codziennymi zadaniami, zwiększając produktywność i kreatywność.

Integruj serwery MCP płynnie w swoje przepływy automatyzacji AI. Połącz swoje narzędzia, źródła danych i API bez skomplikowanej konfiguracji.

Dowiedz się, jak zbudować i wdrożyć serwer Model Context Protocol (MCP), aby połączyć modele AI z zewnętrznymi narzędziami i źródłami danych. Przewodnik krok po...

Poznaj kompleksowe przykłady serwerów MCP i dowiedz się, jak budować, wdrażać i integrować serwery Model Context Protocol, aby zwiększyć możliwości agentów AI w...

Serwer Model Context Protocol (MCP) łączy asystentów AI z zewnętrznymi źródłami danych, API i usługami, umożliwiając płynną integrację złożonych przepływów prac...

Zgoda na Pliki Cookie

Używamy plików cookie, aby poprawić jakość przeglądania i analizować nasz ruch. See our privacy policy.