Jak Zbudować Chatbota AI: Kompletny Przewodnik Krok po Kroku

Dowiedz się, jak zbudować chatbota AI od podstaw dzięki naszemu kompleksowemu przewodnikowi. Poznaj najlepsze narzędzia, frameworki oraz proces krok po kroku, a...

Dowiedz się, jak chatboty AI przetwarzają język naturalny, rozumieją intencje użytkowników i generują inteligentne odpowiedzi. Poznaj NLP, uczenie maszynowe i architekturę chatbotów w ujęciu technicznym.

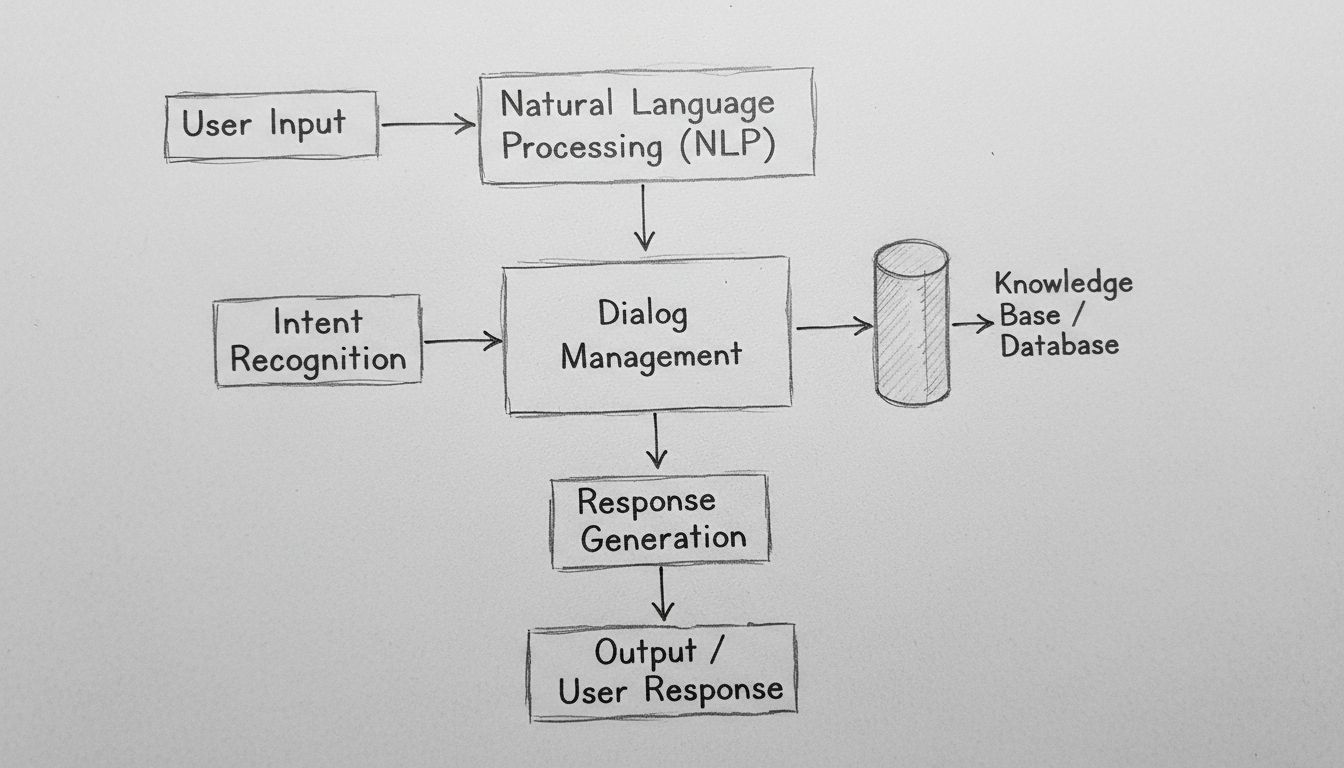

Chatboty AI działają poprzez przetwarzanie wejścia w języku naturalnym za pomocą algorytmów NLP, rozpoznawanie intencji użytkownika, dostęp do baz wiedzy i generowanie kontekstowo trafnych odpowiedzi przy użyciu modeli uczenia maszynowego. Nowoczesne chatboty łączą tokenizację, ekstrakcję encji, zarządzanie dialogiem i sieci neuronowe, by na dużą skalę symulować rozmowy zbliżone do ludzkich.

Chatboty AI to zaawansowane połączenie przetwarzania języka naturalnego, uczenia maszynowego oraz systemów zarządzania dialogiem, które współpracują, by symulować rozmowę z człowiekiem. Gdy wchodzisz w interakcję ze współczesnym chatbotem AI, korzystasz z wielowarstwowego systemu technologicznego, który przetwarza Twoje wejście przez kilka odrębnych etapów, zanim udzieli odpowiedzi. Architektura tych systemów przeszła ogromną ewolucję – od prostych drzew decyzyjnych opartych na regułach do złożonych sieci neuronowych zdolnych rozumieć kontekst, niuanse czy nawet emocje. Zrozumienie ich działania wymaga przyjrzenia się każdemu elementowi tego procesu i dostrzeżenia, jak współpracują, tworząc płynne doświadczenia konwersacyjne.

Podróż każdej wiadomości użytkownika przez chatbota AI rozpoczyna się od przetwarzania wejścia – kluczowej fazy, która przekształca surowy tekst w ustrukturyzowane dane możliwe do analizy przez system. Gdy wpisujesz wiadomość typu „Muszę zresetować hasło”, chatbot nie rozumie od razu Twojej intencji – najpierw musi rozłożyć wiadomość na łatwiejsze do analizy elementy. Ten proces, zwany tokenizacją, dzieli zdanie na pojedyncze słowa lub znaczące jednostki, czyli tokeny. System zamienia „Muszę zresetować hasło” na tokeny: [“Muszę”, “zresetować”, “hasło”]. Ten z pozoru prosty krok stanowi podstawę, bo pozwala chatbotowi analizować każdy element językowy osobno, przy jednoczesnym zachowaniu świadomości relacji pomiędzy nimi w obrębie zdania.

Po tokenizacji system stosuje normalizację, czyli standaryzację tekstu poprzez zamianę na małe litery, usunięcie znaków interpunkcyjnych i korektę typowych literówek. Dzięki temu „Reset hasła”, „reset hasła” i „reser hasła” zostaną rozpoznane jako to samo zagadnienie. Chatbot usuwa też stop words – powszechne słowa, takie jak „i”, „jest”, „do”, które niosą niewielkie znaczenie semantyczne. Ich odfiltrowanie pozwala systemowi skoncentrować zasoby obliczeniowe na słowach kluczowych. Dodatkowo, system wykonuje tagowanie części mowy (part-of-speech tagging), rozpoznając czy dane słowo pełni funkcję rzeczownika, czasownika, przymiotnika itd. To rozumienie gramatyczne pomaga chatbotowi ustalić, że „zresetować” jest czasownikiem w Twojej wiadomości, co kluczowe dla ustalenia, czego rzeczywiście oczekujesz.

Przetwarzanie języka naturalnego (NLP) to technologiczna podstawa, która umożliwia chatbotom rozumienie ludzkiego języka na poziomie semantycznym. NLP obejmuje wiele powiązanych technik, które wspólnie wyodrębniają znaczenie z tekstu. Rozpoznawanie nazwanych encji (NER) identyfikuje w Twojej wiadomości konkretne byty – nazwy własne, daty, miejsca, nazwy produktów czy inne istotne informacje. W przykładzie resetowania hasła NER wykryje „hasło” jako encję systemową powiązaną z bazą wiedzy chatbota. Ta funkcja staje się jeszcze silniejsza w bardziej złożonych sytuacjach: jeśli napiszesz „Chcę zarezerwować lot z Warszawy do Londynu na 15 grudnia”, NER wyodrębni miasto początkowe, docelowe i datę – wszystkie kluczowe dane do realizacji żądania.

Analiza sentymentu to kolejny ważny element NLP, pozwalający chatbotom wykrywać emocjonalny ton Twojej wiadomości. Klient piszący „Czekam już trzy godziny i wciąż nie dostałem zamówienia” wyraża frustrację, którą chatbot powinien rozpoznać, by dostosować ton odpowiedzi i odpowiednio potraktować sprawę. Nowoczesna analiza sentymentu wykorzystuje modele uczenia maszynowego wytrenowane na tysiącach przykładów, by klasyfikować tekst jako pozytywny, negatywny lub neutralny, a coraz częściej – by wykrywać bardziej złożone emocje, jak złość, zdezorientowanie czy satysfakcja. Ta emocjonalna inteligencja pozwala chatbotom odpowiadać z empatią i odpowiednią pilnością, znacząco poprawiając wskaźniki zadowolenia klientów.

Po wstępnym przetworzeniu tekstu chatbot musi określić, czego właściwie chce użytkownik – czyli rozpoznać jego intencję. Rozpoznawanie intencji to jeden z najważniejszych elementów architektury chatbota, ponieważ łączy to, co użytkownik mówi, z tym, co zamierza osiągnąć. System wykorzystuje klasyfikatory uczenia maszynowego, wytrenowane na tysiącach przykładowych konwersacji, by przypisywać wypowiedzi użytkowników do predefiniowanych intencji. Przykładowo, frazy „Zapomniałem hasła”, „Jak zresetować hasło?”, „Nie mogę się zalogować” i „Moje konto jest zablokowane” mogą prowadzić do tej samej intencji „resetowanie_hasła”, mimo różnych sformułowań.

Równolegle system wykonuje ekstrakcję encji, identyfikując w wiadomości użytkownika konkretne dane istotne do realizacji żądania. Jeśli klient napisze „Chcę przejść na plan premium”, system wyodrębni dwie kluczowe encje: akcję („przejść”) i cel („plan premium”). Wyekstrahowane encje stanowią parametry, które ukierunkowują generowanie odpowiedzi przez chatbota. Zaawansowane chatboty stosują analizę zależności gramatycznych (dependency parsing), by zrozumieć relacje pomiędzy słowami – rozpoznać, które rzeczowniki są podmiotami, które dopełnieniami itp. Takie głębsze rozumienie składni pozwala chatbotowi obsługiwać złożone, wielokrotnie złożone zdania i niejednoznaczne sformułowania, które zdezorientowałyby prostsze systemy.

Zarządzanie dialogiem to „mózg” chatbota, odpowiedzialny za utrzymywanie kontekstu rozmowy i dobieranie właściwych odpowiedzi. W przeciwieństwie do prostych systemów wyszukiwania, zaawansowane menedżery dialogu utrzymują stan konwersacji, śledząc, o czym już rozmawiano, jakie informacje zostały zebrane i jaki jest obecny cel użytkownika. Ta świadomość kontekstu umożliwia naturalne, płynne rozmowy, w których chatbot pamięta poprzednie wymiany i odpowiednio się do nich odnosi. Jeśli zapytasz „Jaka jest pogoda w Londynie?”, a potem „A co jutro?”, menedżer dialogu rozumie, że „jutro” dotyczy pogody w Londynie, a nie w innym miejscu.

Menedżer dialogu realizuje zarządzanie kontekstem poprzez przechowywanie istotnych informacji w ustrukturyzowanej formie przez całą rozmowę. Może to być np. informacja o koncie użytkownika, poprzednich prośbach, preferencjach i aktualnym temacie konwersacji. Zaawansowane systemy wykorzystują automaty stanu lub hierarchiczne sieci zadań, by modelować przebieg rozmowy – określając, które stany są osiągalne z innych i jakie przejścia są dozwolone. Przykładowo, chatbot obsługi klienta może mieć stany: „powitanie”, „identyfikacja problemu”, „rozwiązywanie problemu”, „eskalacja”, „rozwiązanie”. Menedżer dialogu czuwa, by rozmowa przebiegała logicznie, a nie przeskakiwała chaotycznie między wątkami.

Nowoczesne chatboty AI nie generują odpowiedzi wyłącznie w oparciu o dane treningowe – korzystają z baz wiedzy zawierających aktualne, wiarygodne informacje dotyczące organizacji. Ta integracja jest kluczowa dla zachowania poprawności i aktualności odpowiedzi. Gdy klient pyta „Jakie jest moje saldo?”, chatbot musi pobrać rzeczywiste dane z systemu bankowego, a nie generować prawdopodobnie brzmiącą liczbę. Podobnie, na pytanie „Jakie są godziny otwarcia sklepu?” chatbot sięga do bazy informacji firmowych, by podać aktualne godziny, zamiast polegać na potencjalnie przestarzałych danych treningowych.

Retrieval-Augmented Generation (RAG) to zaawansowane podejście do integracji wiedzy, które w 2025 roku zyskuje na znaczeniu. Systemy RAG najpierw wyszukują odpowiednie dokumenty lub informacje w bazie wiedzy na podstawie zapytania użytkownika, a następnie wykorzystują te dane do wygenerowania kontekstowej odpowiedzi. Takie dwustopniowe podejście znacząco zwiększa trafność odpowiedzi względem czysto generatywnych metod. Przykładowo, jeśli klient pyta o funkcję produktu, system RAG pobiera dokumentację produktu, wyodrębnia właściwą sekcję i generuje odpowiedź opartą na rzeczywistym dokumencie, zamiast polegać na potencjalnie „halucynowanych” informacjach. Takie rozwiązanie szczególnie doceniane jest w środowiskach korporacyjnych, gdzie liczą się precyzja i zgodność z regulacjami.

Po zrozumieniu intencji użytkownika i zebraniu potrzebnych informacji, chatbot musi wygenerować odpowiednią odpowiedź. Generowanie odpowiedzi może odbywać się na różne sposoby, z których każdy ma swoje zalety i ograniczenia. Generowanie szablonowe wykorzystuje zdefiniowane wcześniej wzorce z miejscami na zmienne. Przykładowo, szablon może brzmieć „Twoje zamówienie nr [NUMER_ZAMÓWIENIA] zostanie dostarczone [DATA_DOSTAWY]”. Takie podejście jest bardzo przewidywalne i niezawodne, ale ograniczone pod względem naturalności.

Generowanie oparte na regułach stosuje określone zasady językowe do budowy odpowiedzi w oparciu o rozpoznaną intencję i wyodrębnione encje. Reguły mogą np. wskazywać, że dla intencji „resetowanie_hasła” odpowiedź powinna zawierać komunikat potwierdzający, link do strony resetowania i instrukcje dla użytkownika. To podejście daje większą elastyczność niż szablony, zachowując przy tym przewidywalność, choć wymaga rozbudowanej inżynierii reguł dla bardziej złożonych przypadków.

Generowanie oparte na sieciach neuronowych, napędzane dużymi modelami językowymi (LLM), to najnowocześniejsze rozwiązanie w tej dziedzinie. Systemy te wykorzystują głębokie sieci neuronowe, takie jak Transformatory, do generowania nowych, kontekstowo trafnych odpowiedzi, które brzmią niezwykle naturalnie. Współczesne LLM są trenowane na miliardach tokenów tekstu, ucząc się statystycznych wzorców rządzących językiem i powiązań pomiędzy pojęciami. Generując odpowiedź, modele te przewidują najbardziej prawdopodobne kolejne słowo na podstawie dotychczasowej sekwencji, powtarzając tę operację do uzyskania pełnego zdania. Zaletą tego rozwiązania jest elastyczność i naturalność; wadą – ryzyko „halucynacji”, czyli generowania prawdopodobnie brzmiących, lecz nieprawdziwych informacji.

Uczenie maszynowe to mechanizm, dzięki któremu chatboty stają się coraz lepsze. W przeciwieństwie do statycznych systemów opartych na sztywnych regułach, nowoczesne chatboty uczą się z każdej interakcji, stopniowo udoskonalając zrozumienie wzorców językowych i intencji użytkowników. Uczenie nadzorowane polega na trenowaniu chatbota na oznaczonych przykładach, gdzie człowiek przypisuje prawidłową intencję i encje do tysięcy wiadomości użytkowników. Algorytm uczy się rozpoznawać wzorce odróżniające jedną intencję od innej, budując model pozwalający z wysoką skutecznością klasyfikować nowe, nieznane wiadomości.

Uczenie przez wzmacnianie pozwala chatbotom optymalizować odpowiedzi w oparciu o informację zwrotną od użytkowników. Gdy użytkownik wyrazi zadowolenie z odpowiedzi (jawnie lub przez kontynuowanie rozmowy), system wzmacnia wzorce prowadzące do takiej odpowiedzi. Jeśli użytkownik wyrazi niezadowolenie lub przerwie rozmowę, system uczy się unikać podobnych schematów w przyszłości. Ta pętla sprzężenia zwrotnego napędza ciągłe doskonalenie chatbota. Zaawansowane systemy stosują uczenie z udziałem człowieka („human-in-the-loop”), gdzie trudne rozmowy są przeglądane przez ludzi, którzy wprowadzają poprawki, a system uczy się na ich podstawie, co znacznie przyspiesza rozwój względem czysto automatycznego uczenia.

Duże modele językowe (LLM) fundamentalnie zmieniły możliwości chatbotów od 2023 roku. Modele trenowane na setkach miliardów tokenów tekstu rozwijają zaawansowane zrozumienie języka, kontekstu i wiedzy dziedzinowej. Takie modele jak GPT-4, Claude czy Gemini potrafią prowadzić zniuansowane rozmowy, rozumieć złożone instrukcje i generować spójne, kontekstowo trafne odpowiedzi na różnorodne tematy. Siła LLM wynika z architektury transformer, która dzięki mechanizmom uwagi rozumie powiązania pomiędzy odległymi słowami w zdaniu, pozwalając zachować kontekst nawet w długich rozmowach.

LLM mają jednak ograniczenia, które muszą być adresowane przez organizacje. Potrafią halucynować – generować błędne, lecz przekonująco brzmiące informacje. Mogą mieć trudności z bardzo świeżymi danymi, których nie było w zbiorze treningowym. Mogą przenosić do odpowiedzi uprzedzenia obecne w zbiorach uczących. By temu zaradzić, coraz powszechniej stosuje się dostrajanie (fine-tuning) do specyficznych domen oraz inżynierię promptów (prompt engineering), aby ukierunkować modele na pożądane zachowania. Podejście FlowHunt do budowy chatbotów wykorzystuje te zaawansowane modele, jednocześnie zapewniając mechanizmy kontroli i integracji ze źródłami wiedzy dla zachowania rzetelności.

| Aspekt | Chatboty oparte na regułach | Chatboty z AI | Chatboty oparte na LLM |

|---|---|---|---|

| Technologia | Drzewa decyzyjne, dopasowanie wzorców | NLP, algorytmy ML, rozpoznawanie intencji | Duże modele językowe, transformatory |

| Elastyczność | Ograniczona do zdefiniowanych reguł | Adaptuje się do różnych sformułowań | Wysoce elastyczny, obsługuje nowe zapytania |

| Dokładność | Wysoka w określonych przypadkach | Dobra przy odpowiednim treningu | Doskonała, wymaga jednak zabezpieczeń |

| Uczenie się | Brak możliwości uczenia | Uczy się na podstawie interakcji | Uczy się przez dostrajanie i feedback |

| Ryzyko halucynacji | Brak | Minimalne | Wymaga strategii ograniczających |

| Czas wdrożenia | Szybki | Średni | Szybki z platformami jak FlowHunt |

| Utrzymanie | Wysokie (aktualizacja reguł) | Średnie | Średnie (aktualizacje modelu, monitoring) |

| Koszt | Niski | Średni | Średni do wysokiego |

| Najlepsze zastosowania | Proste FAQ, kierowanie zgłoszeń | Obsługa klienta, kwalifikacja leadów | Złożone wnioskowanie, generowanie treści |

Współczesne chatboty wykorzystują architekturę transformerów, czyli sieci neuronowe, które zrewolucjonizowały przetwarzanie języka naturalnego. Transformatory korzystają z mechanizmów uwagi pozwalających modelom skupić się na istotnych fragmentach wejścia podczas generowania każdego słowa odpowiedzi. Przetwarzając zdanie „Dyrektor banku martwił się erozją brzegu rzeki”, mechanizm uwagi pomaga modelowi zrozumieć, że pierwszy „bank” oznacza instytucję finansową, a drugi – brzeg rzeki, bazując na kontekście. Takie kontekstowe rozumienie jest znacznie lepsze od starszych metod przetwarzających tekst sekwencyjnie bez tej świadomości.

Wielogłowicowa uwaga (multi-head attention) rozwija tę koncepcję, pozwalając modelowi jednocześnie analizować różne aspekty wejścia. Jedna głowa uwagi może koncentrować się na relacjach gramatycznych, inna na semantycznych, kolejna na strukturze dyskursu. To równoległe przetwarzanie różnych zjawisk językowych pozwala budować bogate, zniuansowane reprezentacje znaczenia. Kodowanie pozycyjne (positional encoding) w transformerach umożliwia modelowi zrozumienie kolejności słów, mimo równoległego przetwarzania, co ma kluczowe znaczenie w językach, gdzie kolejność niesie istotne znaczenie.

FlowHunt to nowoczesne podejście do tworzenia chatbotów, które ukrywa większość złożoności technicznej, zapewniając jednocześnie dostęp do potężnych funkcji AI. Zamiast budować infrastrukturę chatbota od podstaw, FlowHunt oferuje wizualny kreator, w którym nietechniczni użytkownicy mogą projektować przebieg rozmów, łącząc komponenty reprezentujące różne funkcje chatbota. Platforma obsługuje przetwarzanie NLP, rozpoznawanie intencji i generowanie odpowiedzi, pozwalając zespołom skupić się na projektowaniu doświadczenia i integracji z systemami biznesowymi.

Funkcja Źródła wiedzy w FlowHunt umożliwia chatbotom dostęp do aktualnych informacji z dokumentów, stron internetowych i baz danych, implementując zasady RAG dla zapewnienia rzetelności. Możliwość budowania Agentów AI pozwala tworzyć autonomiczne systemy, które nie tylko prowadzą rozmowy, ale także wykonują działania – aktualizują bazy danych, wysyłają maile, rezerwują spotkania czy uruchamiają procesy. To znaczący krok naprzód względem tradycyjnych chatbotów, które jedynie udzielają informacji – systemy FlowHunt mogą faktycznie wykonywać zadania za użytkownika. Rozbudowane integracje platformy pozwalają łączyć chatboty z CRM, helpdeskiem czy aplikacjami biznesowymi, zapewniając płynny przepływ danych i realizację działań.

Skuteczne wdrożenie chatbota wymaga monitorowania kluczowych metryk pokazujących, czy system realizuje cele biznesowe. Dokładność rozpoznawania intencji mierzy, jaki procent wiadomości użytkowników jest poprawnie klasyfikowany. Dokładność ekstrakcji encji sprawdza, czy system prawidłowo identyfikuje istotne dane. Wskaźniki satysfakcji użytkowników, zbierane np. w ankietach po rozmowie, pokazują, czy użytkownik uznał interakcję za pomocną. Wskaźnik zakończonych rozmów mierzy, jaki procent konwersacji kończy się rozwiązaniem problemu bez przekazania do agenta.

Opóźnienie odpowiedzi mierzy czas generowania odpowiedzi przez chatbota – kluczowe dla doświadczenia użytkownika, bo zwłoki powyżej kilku sekund znacznie obniżają zadowolenie. Wskaźnik eskalacji pokazuje, jaki procent rozmów wymaga przekazania do człowieka – niższy zwykle oznacza lepszą skuteczność chatbota. Koszt na rozmowę ocenia ekonomiczną efektywność, porównując koszt obsługi AI z kosztami obsługi przez agenta. Organizacje powinny ustalić wartości wyjściowe tych wskaźników przed wdrożeniem, a następnie stale je monitorować, by identyfikować możliwości poprawy i zapewnić ciągłą wartość biznesową chatbota wraz ze zmianami w sposobie jego użycia.

Chatboty często przetwarzają wrażliwe dane: osobowe, finansowe czy poufne informacje biznesowe. Szyfrowanie danych chroni przesyłane informacje przed przechwyceniem. Mechanizmy uwierzytelniania weryfikują, czy użytkownik jest tym, za kogo się podaje, zanim uzyska dostęp do poufnych danych. Kontrole dostępu zapewniają, że chatboty mają dostęp tylko do tych danych, które są niezbędne do realizacji ich funkcji (zasada minimalnych uprawnień). Organizacje muszą wdrażać rejestrowanie zdarzeń („audit logging”) dla wszystkich interakcji chatbotów na potrzeby zgodności i bezpieczeństwa.

Zasady privacy by design powinny przyświecać tworzeniu chatbotów – minimalizując zbieranie danych osobowych, ograniczając czas ich przechowywania i zapewniając użytkownikom wiedzę, jakie dane są gromadzone i w jaki sposób wykorzystywane. Zgodność z przepisami takimi jak RODO, CCPA czy regulacjami branżowymi (np. HIPAA, PCI-DSS) jest niezbędna. Organizacje powinny przeprowadzać oceny bezpieczeństwa swoich chatbotów, by wykrywać podatności i wdrażać odpowiednie środki zaradcze. Odpowiedzialność za bezpieczeństwo wykracza poza samą platformę chatbota – obejmuje również źródła wiedzy, integracje i systemy zaplecza, z których korzysta chatbot.

Technologia chatbotów rozwija się w błyskawicznym tempie. Chatboty multimodalne, które przetwarzają i generują tekst, głos, obrazy oraz wideo jednocześnie, to kolejny duży krok. Użytkownicy będą coraz częściej wchodzić w interakcje z chatbotami w preferowanym trybie – głosowo (np. w sytuacjach bez użycia rąk), obrazowo (np. pytania o produkt na zdjęciu), wideo (np. prezentacje złożonych czynności). Inteligencja emocjonalna chatbotów wyjdzie poza prostą detekcję sentymentu, pozwalając na zniuansowane rozpoznawanie stanu emocjonalnego użytkownika i odpowiednie reagowanie. Chatboty będą rozpoznawały, kiedy użytkownik jest sfrustrowany, zdezorientowany lub zadowolony i odpowiednio dostosowywały styl komunikacji.

Proaktywna pomoc to kolejne rozwijane rozwiązanie, w którym chatboty przewidują potrzeby użytkownika jeszcze przed zadaniem pytania. Zamiast biernie czekać na zapytania, będą wykrywać wzorce świadczące o potencjalnym problemie i same oferować wsparcie. Personalizacja stanie się coraz bardziej zaawansowana – chatboty będą dostosowywać styl komunikacji, rekomendacje i zakres pomocy na podstawie indywidualnych preferencji, historii i kontekstu użytkownika. Integracja z systemami autonomicznymi pozwoli chatbotom koordynować działania z robotami, urządzeniami IoT i innymi systemami automatyzacji, by realizować złożone zadania wymagające współpracy wielu narzędzi.

Zrozumienie działania chatbotów AI pokazuje, dlaczego stały się one kluczowym narzędziem biznesowym w wielu branżach. Zaawansowane połączenie przetwarzania języka naturalnego, uczenia maszynowego, zarządzania dialogiem i integracji wiedzy pozwala chatbotom realizować coraz bardziej złożone zadania przy zachowaniu naturalnych, ludzkich interakcji. Organizacje, które skutecznie wdrażają chatboty – korzystając z platform takich jak FlowHunt, które ukrywają złożoność techniczną, zapewniając jednocześnie zaawansowane możliwości – zyskują przewagę konkurencyjną dzięki wyższej satysfakcji klientów, niższym kosztom operacyjnym i szybszym odpowiedziom.

Technologia nadal rozwija się w szybkim tempie – postęp w dużych modelach językowych, multimodalności i agentach autonomicznych stale poszerza możliwości chatbotów. Wdrażanie chatbotów powinno być traktowane nie jako jednorazowy projekt, lecz jako kompetencja stale udoskonalana dzięki ciągłemu uczeniu, optymalizacji i rozwojowi. Najlepsze wdrożenia łączą potężną technologię AI z przemyślanym projektem konwersacji, odpowiednimi zabezpieczeniami zapewniającymi rzetelność i bezpieczeństwo oraz integracją z systemami biznesowymi, które pozwalają chatbotom podejmować realne działania. W 2025 roku i później chatboty będą coraz częściej głównym interfejsem kontaktu klientów i pracowników z organizacją, czyniąc inwestycje w tę technologię strategicznie kluczowymi dla sukcesu biznesowego.

Przestań ręcznie obsługiwać powtarzalne zapytania klientów. Kreator chatbotów AI FlowHunt bez kodowania pozwala tworzyć inteligentne, autonomiczne chatboty, które obsługują klientów, generują leady i wspierają 24/7. Wdrożenie w kilka minut, nie tygodni.

Dowiedz się, jak zbudować chatbota AI od podstaw dzięki naszemu kompleksowemu przewodnikowi. Poznaj najlepsze narzędzia, frameworki oraz proces krok po kroku, a...

Opanuj korzystanie z AI chatbota dzięki naszemu kompleksowemu przewodnikowi. Poznaj skuteczne techniki promptowania, najlepsze praktyki oraz dowiedz się, jak w ...

Dowiedz się, jak zbudować chatbota AI na Discordzie krok po kroku, poznaj metody integracji API, obsługę błędów, najlepsze praktyki bezpieczeństwa oraz zaawanso...

Zgoda na Pliki Cookie

Używamy plików cookie, aby poprawić jakość przeglądania i analizować nasz ruch. See our privacy policy.