Obserwowalność FlowHunt w PowerBI

Dowiedz się, jak zintegrować FlowHunt z PowerBI, skonfigurować ustawienia obserwowalności i wizualizować metryki swojego workspace FlowHunt bezpośrednio na dash...

Ten artykuł wyjaśnia, jak połączyć FlowHunt z Langfuse, aby uzyskać kompleksową obserwowalność, śledzić wydajność przepływów pracy AI oraz korzystać z pulpitów Langfuse do monitorowania i optymalizacji środowiska FlowHunt.

Wraz ze skalowaniem się Twoich przepływów AI w FlowHunt, zrozumienie co dzieje się „pod maską” staje się kluczowe. Pytania takie jak “Dlaczego ten przepływ działa wolno?”, “Ile tokenów zużywam?” czy “Gdzie pojawiają się błędy?” wymagają szczegółowej widoczności w systemie.

Bez właściwej obserwowalności debugowanie przepływów AI to jak lot na ślepo — widzisz efekt, ale nie znasz drogi. Narzędzia do śledzenia, takie jak Langfuse, rozwiązują ten problem, rejestrując każdy krok wykonywania przepływu i dostarczając szczegółowych wglądów w wydajność, koszty i zachowanie.

Ten artykuł wyjaśnia, jak płynnie połączyć FlowHunt z Langfuse, aby uzyskać kompleksową obserwowalność wszystkich przepływów AI. Nauczysz się śledzić ścieżki wykonania, monitorować zużycie tokenów, identyfikować wąskie gardła i wizualizować metryki wydajności — wszystko na jednym, centralnym pulpicie.

Po lekturze uzyskasz pełną widoczność swojego środowiska FlowHunt, co pozwoli Ci optymalizować przepływy, obniżać koszty i zapewniać niezawodność.

Obserwowalność to praktyka instrumentowania systemu, aby zrozumieć jego stan wewnętrzny na podstawie zewnętrznych danych — głównie śladów, metryk i logów.

Dla użytkowników FlowHunt wdrażających przepływy AI obserwowalność zapewnia wgląd m.in. w:

Brak obserwowalności sprawia, że diagnozowanie problemów jest reaktywne i czasochłonne. Dzięki niej zyskujesz proaktywne wglądy pozwalające na ciągłą optymalizację i szybkie rozwiązywanie problemów.

Langfuse to otwartoźródłowa platforma do obserwowalności i analityki stworzona z myślą o aplikacjach opartych na LLM. Rejestruje szczegółowe ślady realizacji przepływów pracy AI, zapewniając deweloperom i zespołom wgląd niezbędny do debugowania, monitorowania i optymalizacji systemów AI.

Kluczowe funkcje Langfuse to m.in.:

Podłączając Langfuse do FlowHunt, zamieniasz surowe dane wykonawcze w praktyczną wiedzę — rozpoznajesz, co działa, co nie działa i gdzie należy skupić wysiłki optymalizacyjne.

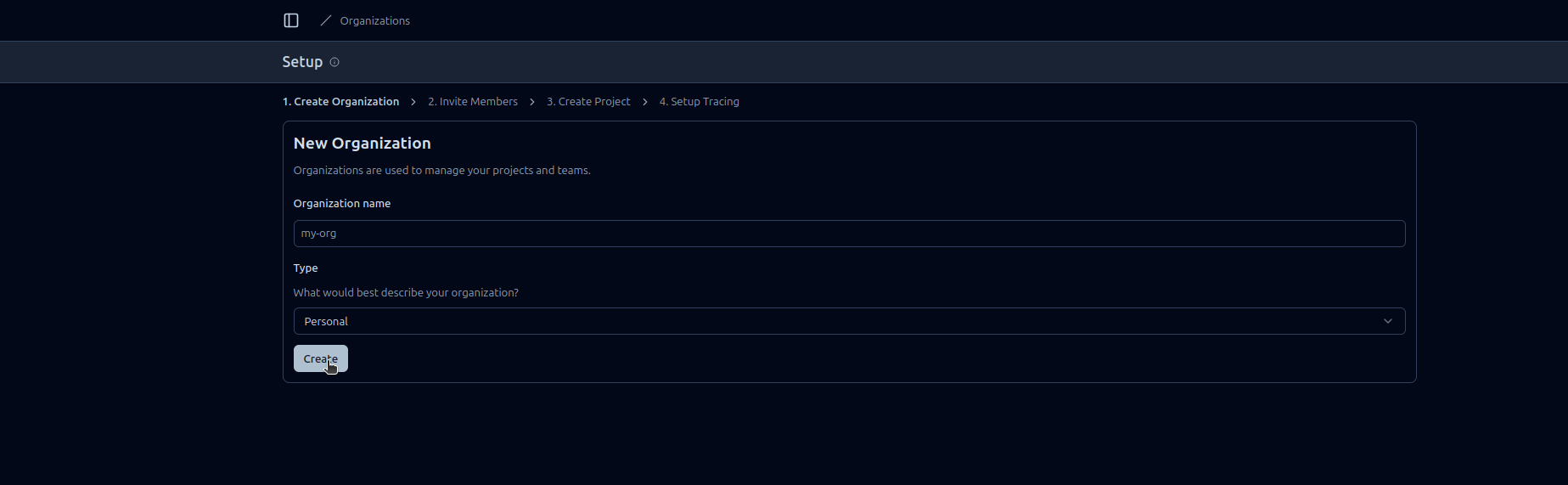

Przechodząc krok po kroku przez ten poradnik:

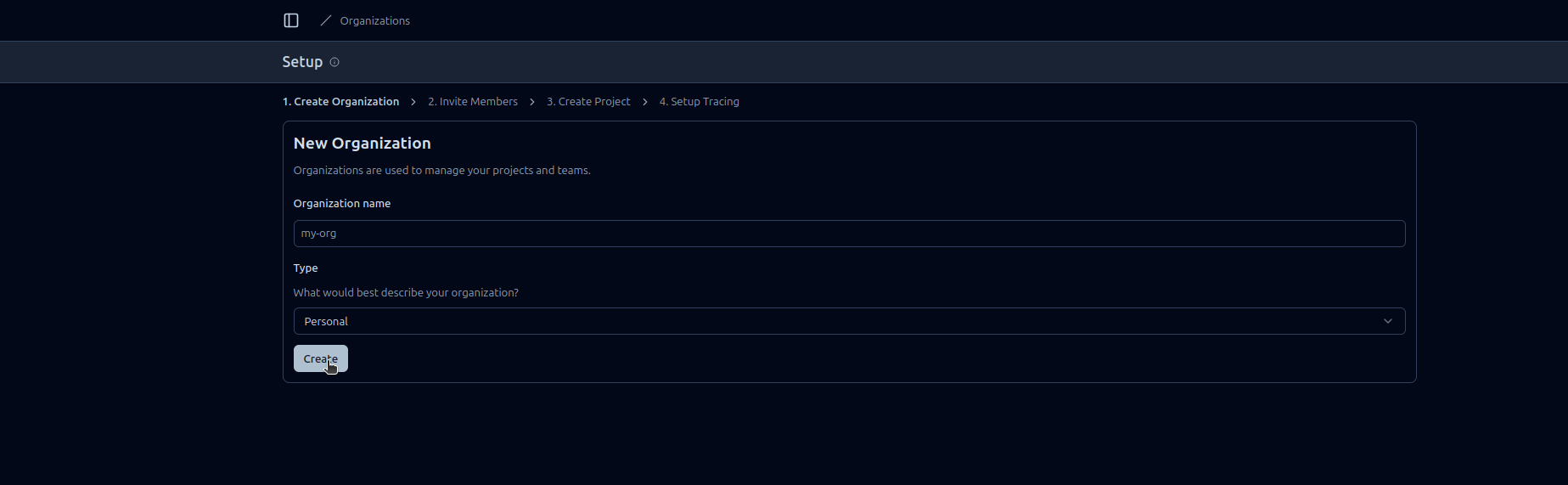

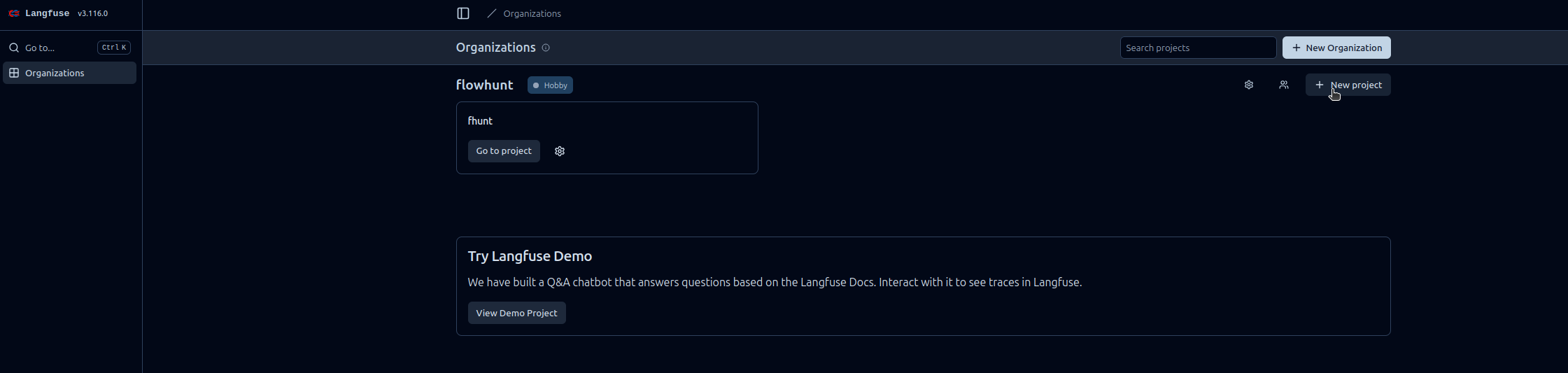

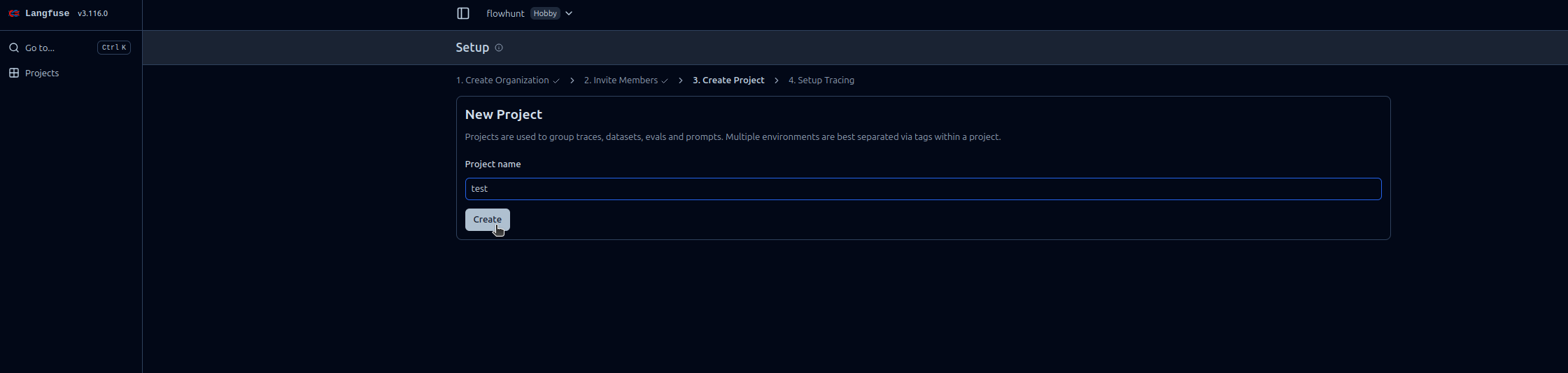

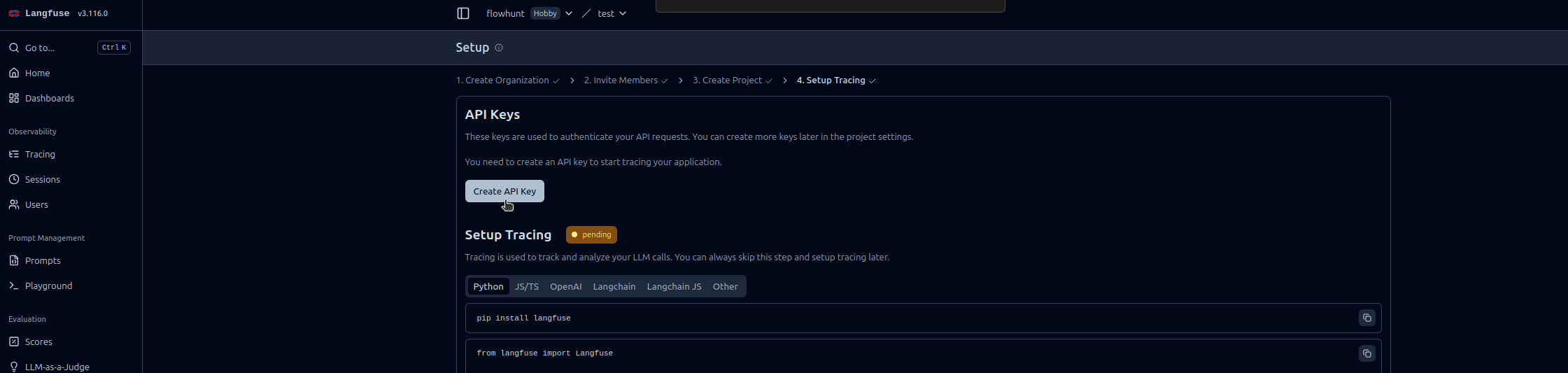

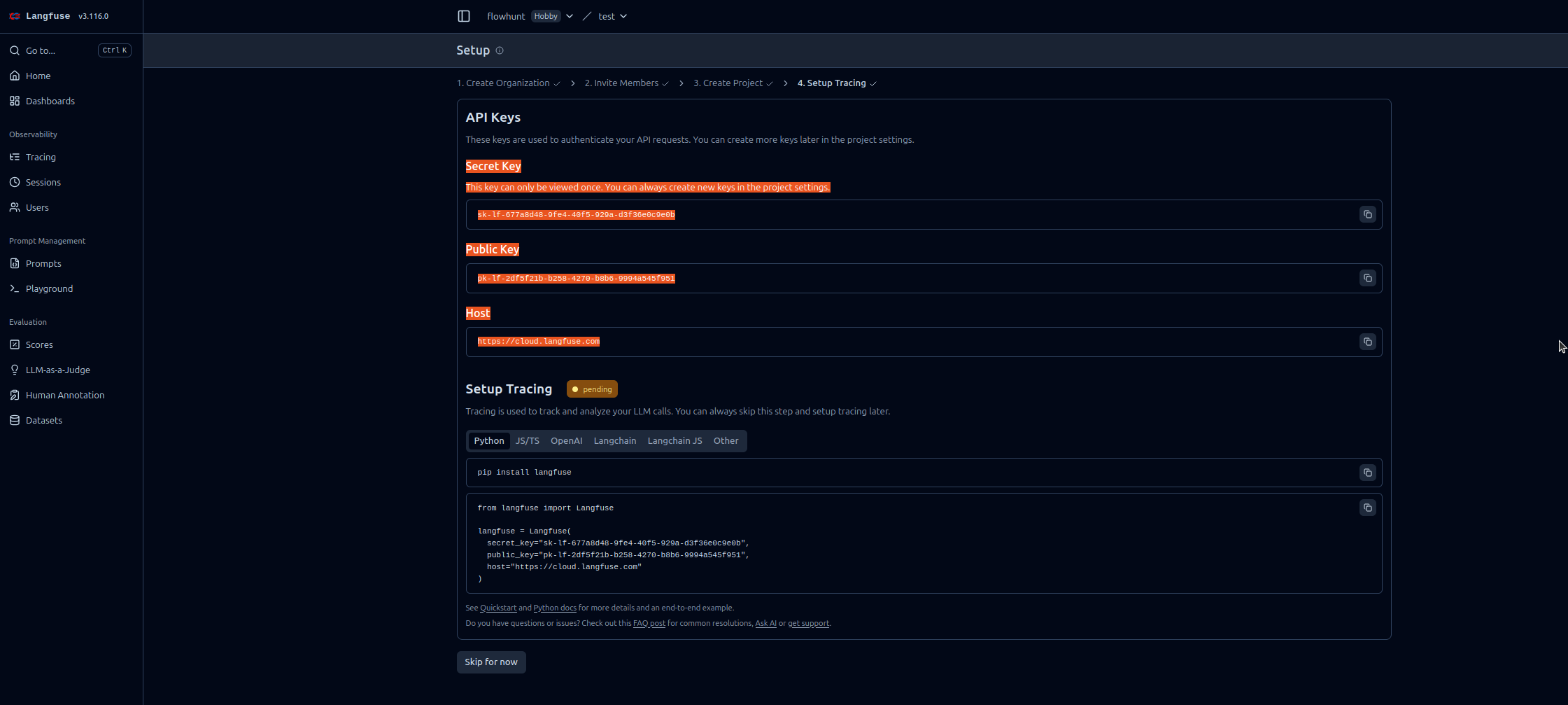

Wykonaj poniższe kroki, aby włączyć obserwowalność FlowHunt w Langfuse:

https://cloud.langfuse.com)

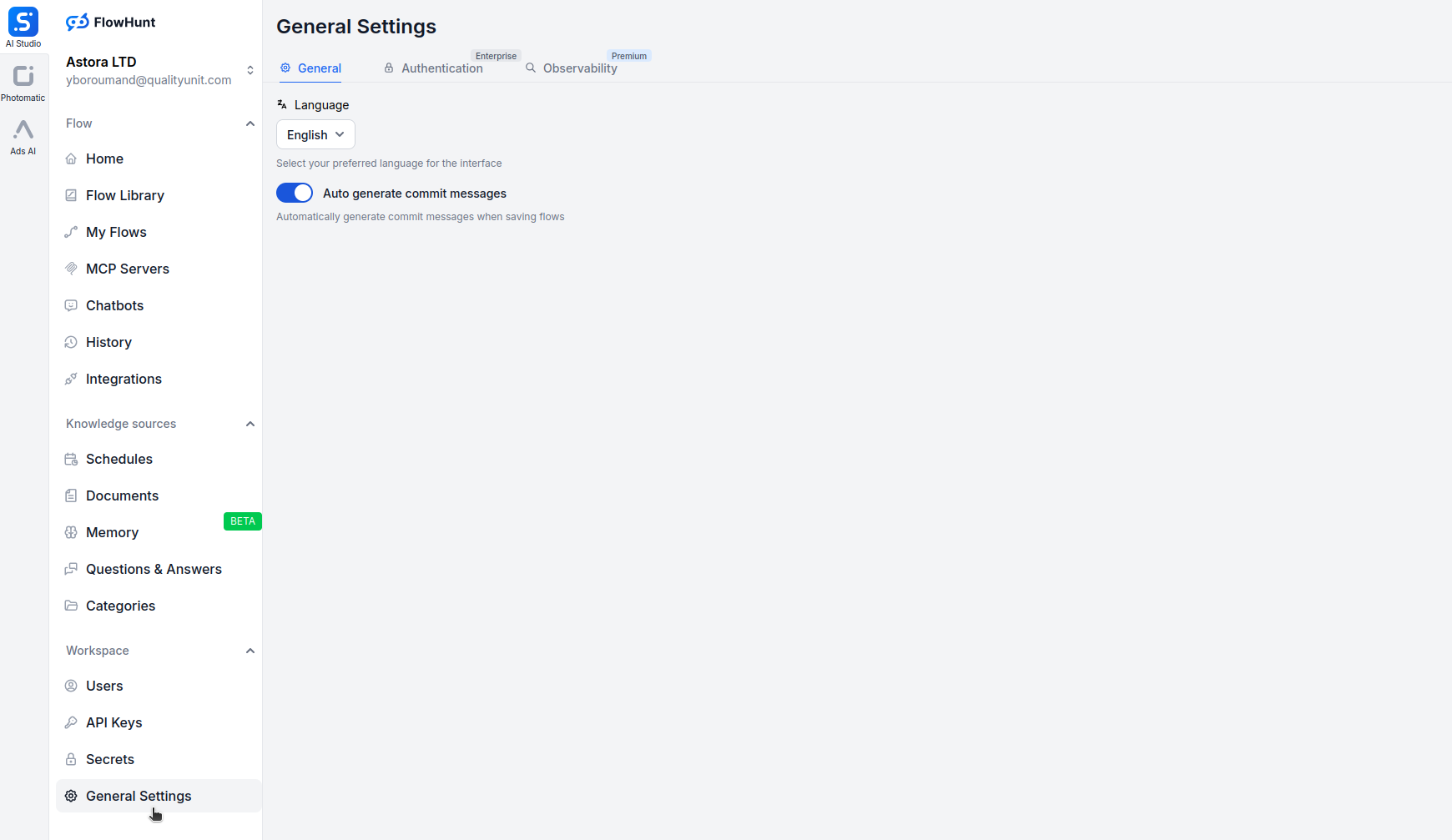

Otwórz app.flowhunt.io w przeglądarce.

Przejdź do Ustawień ogólnych (zazwyczaj dostępnych z paska bocznego lub górnego menu).

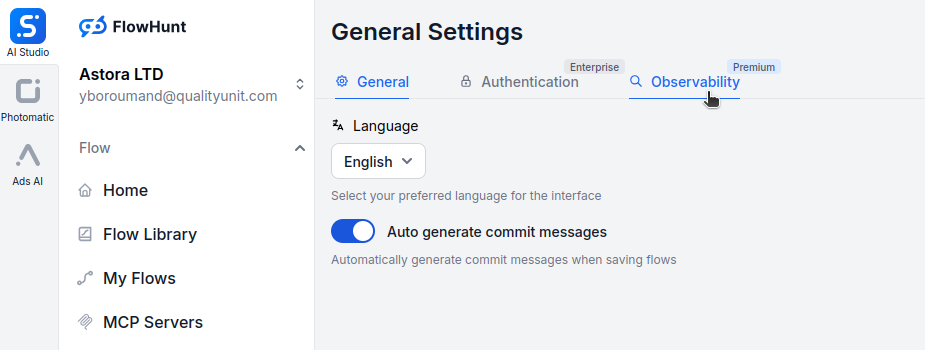

Przewiń na dół i kliknij w zakładkę Obserwowalność.

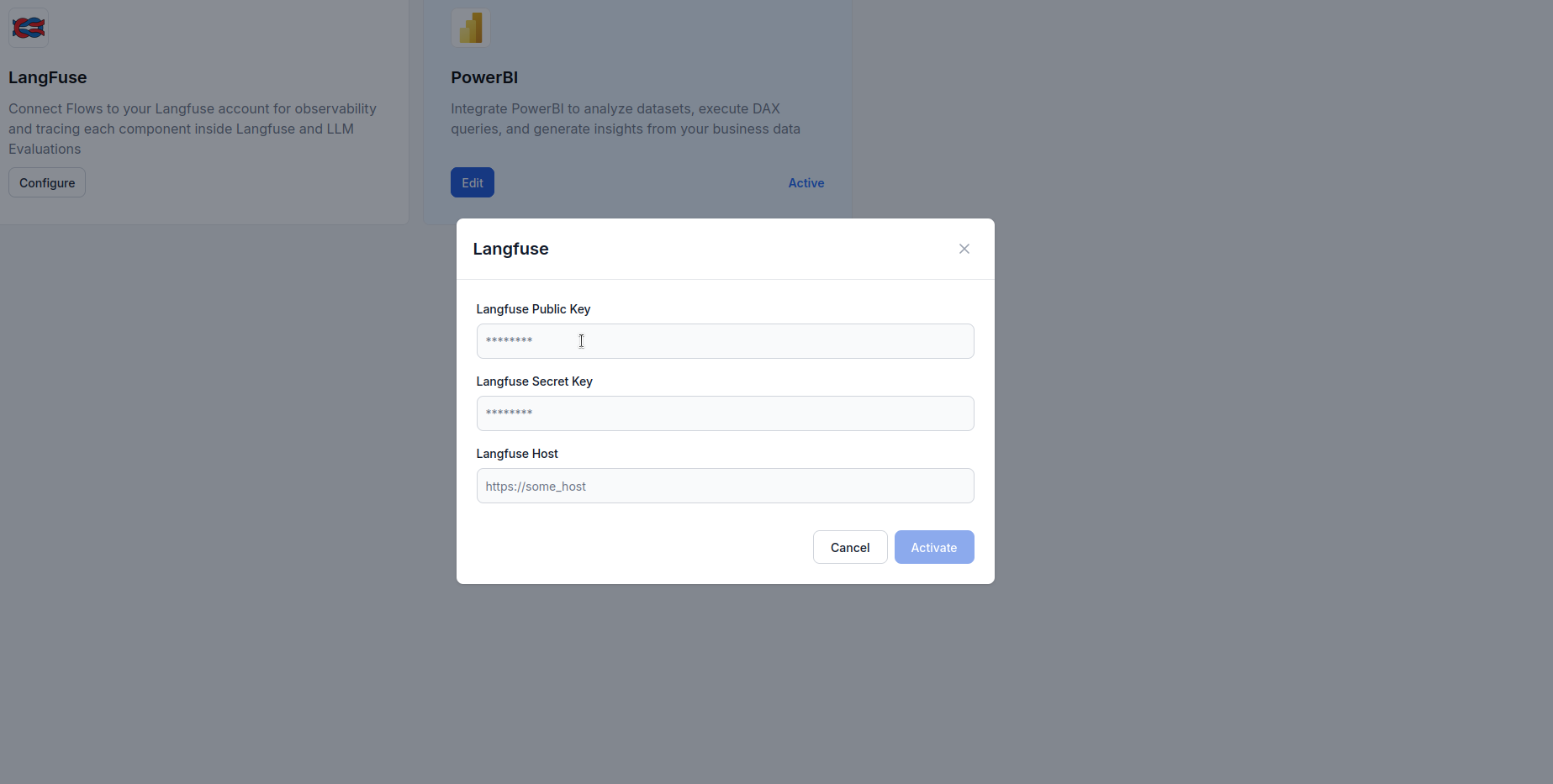

Znajdź sekcję Langfuse i kliknij Konfiguruj.

https://cloud.langfuse.com)

Po połączeniu FlowHunt z Langfuse zyskujesz dostęp do zaawansowanych narzędzi wizualizacji i analityki. Oto przykłady wglądów, które możesz uzyskać:

Zobacz szczegółową oś czasu każdego przepływu, pokazującą:

Umożliwia to identyfikację wąskich gardeł i zrozumienie zachowania przepływu na najniższym poziomie.

Monitoruj zużycie tokenów w różnych przepływach:

Pozwala to optymalizować koszty, wskazując operacje generujące największe zużycie tokenów.

Śledź kluczowe wskaźniki:

Te dane pomagają utrzymywać SLA i optymalizować doświadczenie użytkownika.

Identyfikuj i diagnozuj awarie:

Przyspiesza to rozwiązywanie problemów i zwiększa niezawodność.

Dla agentów konwersacyjnych AI śledź:

Pomaga to optymalizować zachowanie agenta i doświadczenie użytkownika.

Porównuj wydajność różnych dostawców LLM:

Pomaga to podejmować decyzje o wyborze modelu na podstawie rzeczywistych danych.

Integracja FlowHunt z Langfuse zamienia przepływy AI z „czarnych skrzynek” w przejrzyste i optymalizowalne systemy. Dzięki kompleksowemu śledzeniu zyskujesz wgląd w każdy krok realizacji, co umożliwia podejmowanie decyzji opartych na danych w zakresie wydajności, kosztów i niezawodności.

Integracja obserwowalności Langfuse sprawia, że monitorowanie jest proste — od szybkiej konfiguracji klucza API po bogate, praktyczne pulpity pokazujące dokładnie, jak Twoje przepływy zachowują się na produkcji.

Teraz, gdy Twoje środowisko FlowHunt jest podłączone do Langfuse, masz fundament do ciągłego doskonalenia: identyfikuj wąskie gardła, optymalizuj zużycie tokenów, redukuj opóźnienia i zapewnij, że Twoje systemy AI dostarczają maksymalną wartość z pełną pewnością.

Obserwowalność w FlowHunt oznacza możliwość monitorowania, śledzenia i analizowania, jak przepływy pracy AI, agenci oraz automatyzacje działają w czasie rzeczywistym. Pomaga użytkownikom wykrywać wąskie gardła, śledzić zużycie tokenów, mierzyć opóźnienia i podejmować decyzje optymalizacyjne oparte na danych.

Langfuse to otwartoźródłowa platforma inżynierii LLM zaprojektowana do śledzenia, monitorowania i analizowania aplikacji AI. Po integracji z FlowHunt zapewnia szczegółowe wglądy w realizację przepływów, zużycie tokenów, wydajność modeli oraz śledzenie błędów.

Nie, integracja jest prosta. Wystarczy założyć konto Langfuse, wygenerować klucze API i wkleić je w ustawieniach obserwowalności FlowHunt. Programowanie nie jest wymagane.

Po połączeniu możesz śledzić ślady wykonania, zużycie tokenów, koszty modeli, metryki opóźnień, wskaźniki błędów, wydajność przepływów w czasie oraz szczegółowe rozbicia krok po kroku interakcji agentów AI.

Langfuse oferuje darmowy poziom zawierający podstawowe funkcje śledzenia i obserwowalności. Dla większych zespołów i zaawansowanej analityki Langfuse udostępnia płatne plany z dodatkowymi możliwościami.

Dowiedz się, jak zintegrować FlowHunt z PowerBI, skonfigurować ustawienia obserwowalności i wizualizować metryki swojego workspace FlowHunt bezpośrednio na dash...

Poznaj znaczenie logowania w przepływach pracy AI, dowiedz się, jak FlowHunt umożliwia szczegółowe logi wywołań narzędzi i zadań oraz najlepsze praktyki monitor...

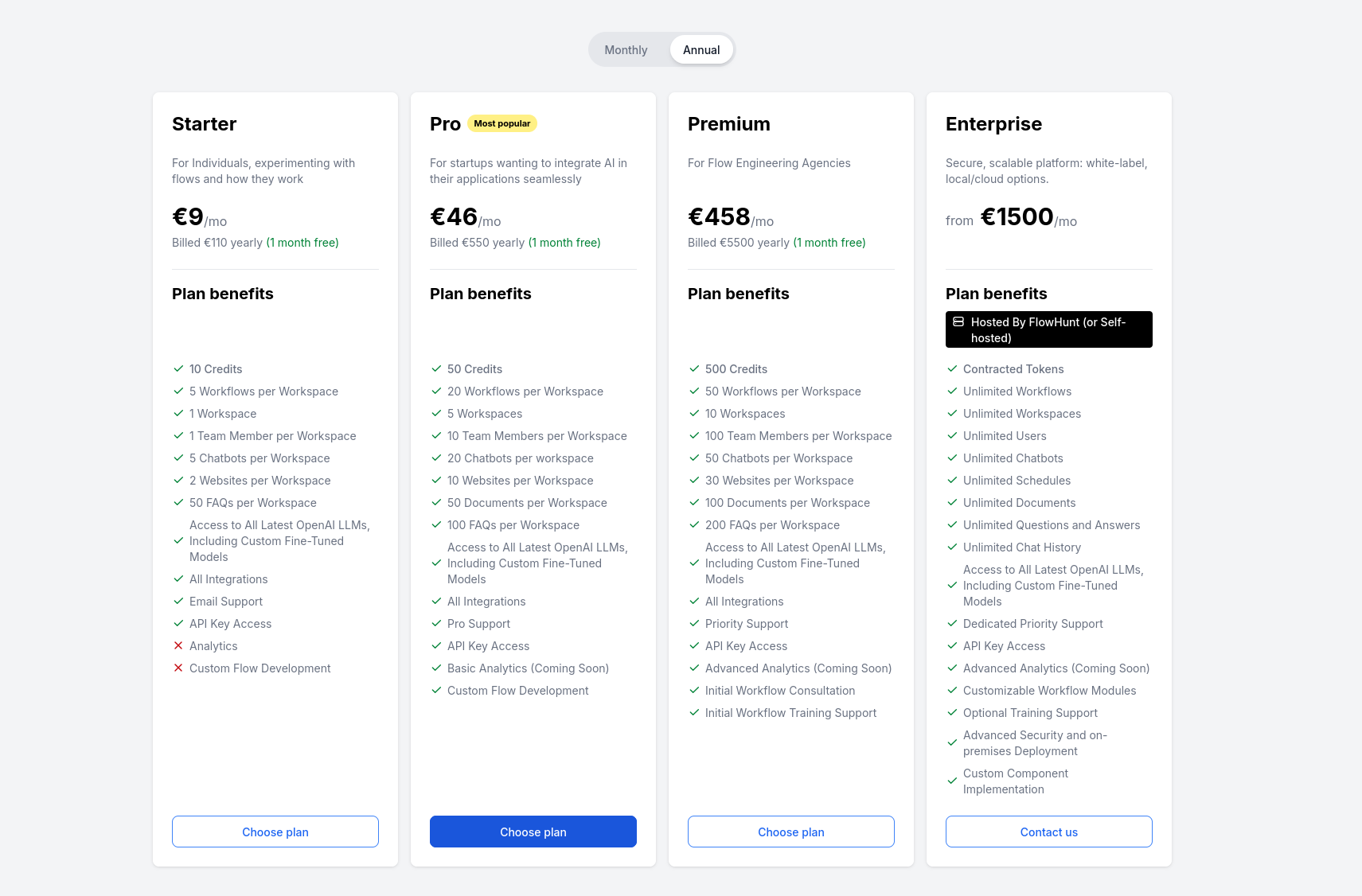

Kompleksowy przewodnik po cenniku FlowHunt, obejmujący zasady działania kredytów i interakcji, wpływ złożoności na koszty oraz co dzieje się z niewykorzystanymi...