DeepSeek MCP Server

Serwer DeepSeek MCP działa jako bezpieczny proxy, łącząc zaawansowane modele językowe DeepSeek z aplikacjami kompatybilnymi z MCP, takimi jak Claude Desktop czy...

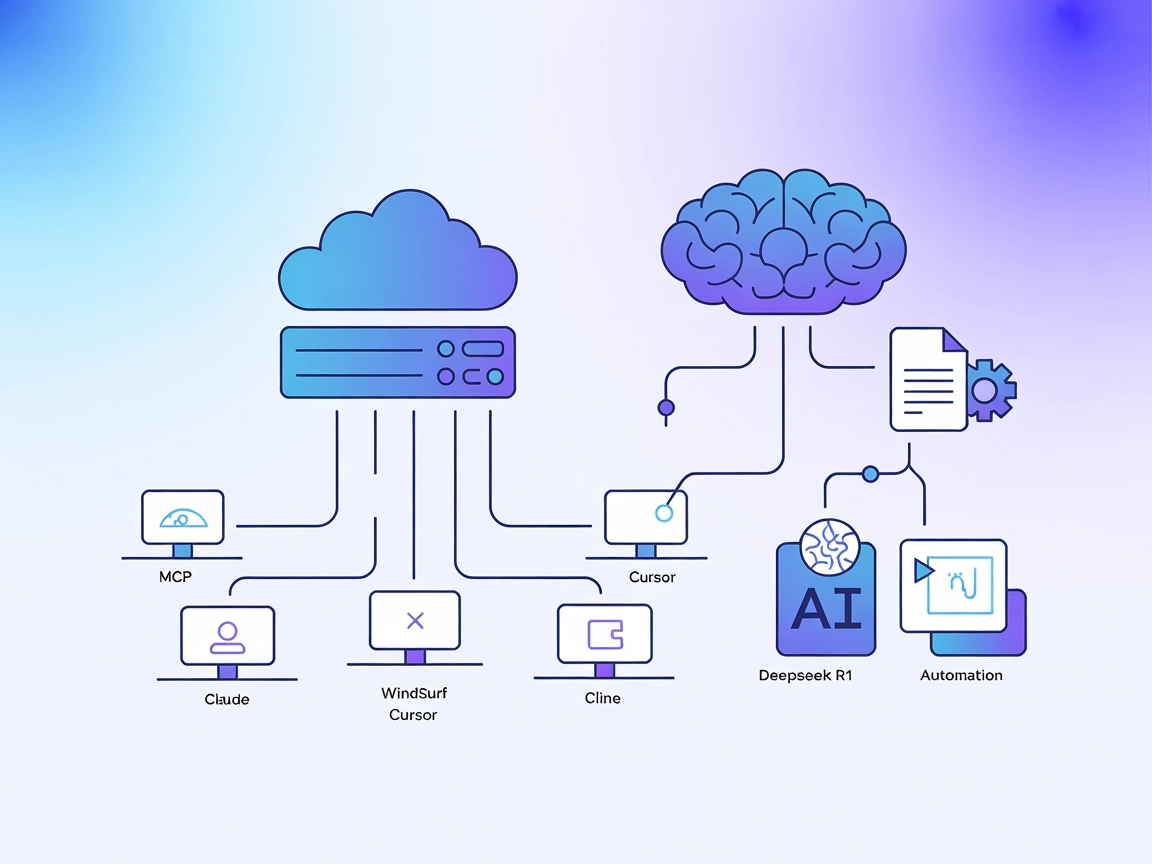

Zintegruj modele DeepSeek zoptymalizowane pod kątem kontekstu i wnioskowania z Twoimi workflow AI dzięki Deepseek R1 MCP Server do zaawansowanych zadań językowych i automatyzacji.

FlowHunt zapewnia dodatkową warstwę bezpieczeństwa między Twoimi systemami wewnętrznymi a narzędziami AI, dając Ci szczegółową kontrolę nad tym, które narzędzia są dostępne z Twoich serwerów MCP. Serwery MCP hostowane w naszej infrastrukturze można bezproblemowo zintegrować z chatbotem FlowHunt oraz popularnymi platformami AI, takimi jak ChatGPT, Claude i różne edytory AI.

Serwer Deepseek R1 MCP to implementacja Model Context Protocol (MCP) zaprojektowana do połączenia Claude Desktop z zaawansowanymi modelami językowymi DeepSeek, takimi jak Deepseek R1 i DeepSeek V3. Działając jako pomost między asystentami AI a potężnymi modelami DeepSeek zoptymalizowanymi pod kątem wnioskowania (z oknem kontekstowym 8192 tokenów), serwer ten umożliwia agentom AI wykonywanie zaawansowanych zadań rozumienia i generowania języka naturalnego. Programiści mogą wykorzystać Deepseek R1 MCP Server do płynnej integracji tych modeli z własnymi workflow, ułatwiając zaawansowane generowanie tekstu, wnioskowanie i interakcję z zewnętrznymi źródłami danych lub API w obsługiwanych platformach. Implementacja koncentruje się na zapewnieniu stabilnej, niezawodnej i wydajnej integracji przy użyciu Node.js/TypeScript dla optymalnej kompatybilności i bezpieczeństwa typów.

W repozytorium nie udokumentowano żadnych szablonów promptów.

W repozytorium nie udokumentowano żadnych jawnych zasobów MCP.

git clone https://github.com/66julienmartin/MCP-server-Deepseek_R1.git

cd deepseek-r1-mcp

npm install

.env.exemple do .env i ustaw swój klucz API DeepSeek.{

"mcpServers": {

"deepseek_r1": {

"command": "node",

"args": ["/path/to/deepseek-r1-mcp/build/index.js"],

"env": {

"DEEPSEEK_API_KEY": "twój-klucz-api"

}

}

}

}

{

"mcpServers": {

"deepseek_r1": {

"command": "node",

"args": ["/path/to/deepseek-r1-mcp/build/index.js"],

"env": {

"DEEPSEEK_API_KEY": "twój-klucz-api"

}

}

}

}

{

"mcpServers": {

"deepseek_r1": {

"command": "node",

"args": ["/path/to/deepseek-r1-mcp/build/index.js"],

"env": {

"DEEPSEEK_API_KEY": "twój-klucz-api"

}

}

}

}

{

"mcpServers": {

"deepseek_r1": {

"command": "node",

"args": ["/path/to/deepseek-r1-mcp/build/index.js"],

"env": {

"DEEPSEEK_API_KEY": "twój-klucz-api"

}

}

}

}

Używaj zmiennych środowiskowych w konfiguracji, aby bezpiecznie przechowywać klucze API:

{

"mcpServers": {

"deepseek_r1": {

"command": "node",

"args": ["/path/to/deepseek-r1-mcp/build/index.js"],

"env": {

"DEEPSEEK_API_KEY": "twój-klucz-api"

}

}

}

}

Używanie MCP w FlowHunt

Aby zintegrować serwery MCP z workflow FlowHunt, zacznij od dodania komponentu MCP do flow i połącz go z agentem AI:

Kliknij komponent MCP, aby otworzyć panel konfiguracji. W sekcji konfiguracji MCP wklej dane serwera MCP w tym formacie JSON:

{

"deepseek_r1": {

"transport": "streamable_http",

"url": "https://twojserwermcp.przyklad/sciezka_do_mcp/url"

}

}

Po skonfigurowaniu agent AI może korzystać z tego MCP jako narzędzia ze wszystkimi jego funkcjonalnościami i możliwościami. Pamiętaj, by zmienić “deepseek_r1” na faktyczną nazwę swojego serwera MCP oraz podmienić URL na adres swojego MCP.

| Sekcja | Dostępność | Szczegóły/Uwagi |

|---|---|---|

| Przegląd | ✅ | |

| Lista szablonów promptów | ⛔ | Brak udokumentowanych szablonów |

| Lista zasobów | ⛔ | Brak jawnych zasobów MCP |

| Lista narzędzi | ✅ | Zaawansowane narzędzie do generowania tekstu |

| Zabezpieczanie kluczy API | ✅ | Używanie zmiennych środowiskowych w configu |

| Obsługa sampling-u (mniej istotne) | ⛔ | Brak dokumentacji |

| Obsługuje Roots | ⛔ | Brak dokumentacji |

Na podstawie dostępnej dokumentacji Deepseek R1 MCP Server oferuje czystą, ukierunkowaną implementację, którą łatwo skonfigurować i używać, ale brakuje dokumentacji dla promptów, zasobów oraz zaawansowanych funkcji MCP jak roots czy sampling. Czyni to rozwiązanie bardzo praktycznym do generowania tekstu, choć mniej rozbudowanym pod kątem skomplikowanych workflow.

| Posiada LICENCJĘ | ✅ (MIT) |

|---|---|

| Ma przynajmniej jedno narzędzie | ✅ |

| Liczba forków | 12 |

| Liczba gwiazdek | 58 |

To serwer Model Context Protocol (MCP), który działa jako most między Claude Desktop (lub innymi platformami) a zaawansowanymi modelami językowymi DeepSeek (R1, V3), umożliwiając rozszerzone generowanie tekstu, wnioskowanie i automatyzację w Twoich workflow AI.

Serwer wspiera Deepseek R1 i DeepSeek V3 — oba modele są zoptymalizowane pod kątem dużych okien kontekstowych i złożonych zadań wnioskowania.

Przypadki użycia to zaawansowane generowanie tekstu (długie formy, techniczne lub kreatywne), zadania logiczne, bezproblemowe rozszerzenie możliwości asystenta AI w Claude Desktop oraz automatyzacja tworzenia treści lub zarządzania wiedzą przez API.

Zawsze używaj zmiennych środowiskowych w konfiguracji serwera MCP, by zapobiec przypadkowemu ujawnieniu klucza API DeepSeek.

W repozytorium nie udokumentowano szablonów promptów ani jawnych zasobów MCP; serwer nastawiony jest na bezpośredni dostęp do modeli i integrację.

DeepSeek R1 oferuje okno kontekstowe 8192 tokenów, co pozwala obsłużyć obszerne i złożone zadania.

Tak, jest na licencji MIT i dostępny na GitHubie.

Odblokuj zaawansowane generowanie tekstu i wnioskowanie, łącząc FlowHunt lub Claude Desktop z potężnymi modelami DeepSeek R1. Zacznij budować inteligentniejsze workflow już dziś.

Serwer DeepSeek MCP działa jako bezpieczny proxy, łącząc zaawansowane modele językowe DeepSeek z aplikacjami kompatybilnymi z MCP, takimi jak Claude Desktop czy...

Serwer DeepSeek MCP integruje zaawansowane modele językowe DeepSeek z aplikacjami zgodnymi z MCP, zapewniając bezpieczny, zanonimizowany dostęp do API i umożliw...

Deepseek Thinker MCP Server integruje rozumowanie modelu Deepseek z klientami AI obsługującymi MCP, takimi jak Claude Desktop, zapewniając zaawansowane łańcuchy...

Zgoda na Pliki Cookie

Używamy plików cookie, aby poprawić jakość przeglądania i analizować nasz ruch. See our privacy policy.