DeepSeek MCP Server

Serwer DeepSeek MCP działa jako bezpieczny proxy, łącząc zaawansowane modele językowe DeepSeek z aplikacjami kompatybilnymi z MCP, takimi jak Claude Desktop czy...

Wprowadź transparentne rozumowanie i łańcuchy myślowe Deepseek do swoich asystentów obsługujących MCP z obsługą wdrożeń zarówno w chmurze, jak i lokalnie.

FlowHunt zapewnia dodatkową warstwę bezpieczeństwa między Twoimi systemami wewnętrznymi a narzędziami AI, dając Ci szczegółową kontrolę nad tym, które narzędzia są dostępne z Twoich serwerów MCP. Serwery MCP hostowane w naszej infrastrukturze można bezproblemowo zintegrować z chatbotem FlowHunt oraz popularnymi platformami AI, takimi jak ChatGPT, Claude i różne edytory AI.

Deepseek Thinker MCP Server działa jako dostawca Model Context Protocol (MCP), dostarczając treści rozumowania modelu Deepseek do klientów AI obsługujących MCP, takich jak Claude Desktop. Umożliwia asystentom AI dostęp do procesów myślowych i wyników rozumowania Deepseek zarówno poprzez usługę API Deepseek, jak i z lokalnego serwera Ollama. Integrując ten serwer, deweloperzy mogą wzbogacić swoje przepływy pracy AI o ukierunkowane rozumowanie, wykorzystując zarówno możliwości inferencji w chmurze, jak i lokalnie. Serwer ten jest szczególnie przydatny w scenariuszach, gdzie wymagane są szczegółowe łańcuchy rozumowania (chain-of-thought, CoT), które wspierają dalsze zadania AI, co czyni go cennym narzędziem do zaawansowanego rozwoju, debugowania i wzbogacania agentów AI.

W repozytorium ani dokumentacji nie wspomniano o jawnych szablonach promptów.

Dokumentacja ani kod źródłowy nie zawierają szczegółowych zasobów MCP.

originPrompt (string) — Oryginalny prompt użytkownika.windsurf_config.json).mcpServers:{

"deepseek-thinker": {

"command": "npx",

"args": [

"-y",

"deepseek-thinker-mcp"

],

"env": {

"API_KEY": "<Your API Key>",

"BASE_URL": "<Your Base URL>"

}

}

}

claude_desktop_config.json.{

"mcpServers": {

"deepseek-thinker": {

"command": "npx",

"args": [

"-y",

"deepseek-thinker-mcp"

],

"env": {

"API_KEY": "<Your API Key>",

"BASE_URL": "<Your Base URL>"

}

}

}

}

{

"mcpServers": {

"deepseek-thinker": {

"command": "npx",

"args": [

"-y",

"deepseek-thinker-mcp"

],

"env": {

"API_KEY": "<Your API Key>",

"BASE_URL": "<Your Base URL>"

}

}

}

}

{

"mcpServers": {

"deepseek-thinker": {

"command": "npx",

"args": [

"-y",

"deepseek-thinker-mcp"

],

"env": {

"API_KEY": "<Your API Key>",

"BASE_URL": "<Your Base URL>"

}

}

}

}

Na wszystkich platformach klucze API i wartości wrażliwe powinny być przekazywane za pomocą zmiennych środowiskowych w sekcji env. Przykład:

{

"mcpServers": {

"deepseek-thinker": {

"command": "npx",

"args": [

"-y",

"deepseek-thinker-mcp"

],

"env": {

"API_KEY": "<Your API Key>",

"BASE_URL": "<Your Base URL>"

}

}

}

}

Dla trybu lokalnego Ollama ustaw USE_OLLAMA na "true" w obiekcie env:

"env": {

"USE_OLLAMA": "true"

}

Użycie MCP w FlowHunt

Aby zintegrować serwery MCP ze swoim przepływem FlowHunt, zacznij od dodania komponentu MCP do przepływu i połącz go z agentem AI:

Kliknij komponent MCP, aby otworzyć panel konfiguracji. W sekcji konfiguracyjnej systemu MCP wprowadź dane serwera MCP w tym formacie JSON:

{

"deepseek-thinker": {

"transport": "streamable_http",

"url": "https://yourmcpserver.example/pathtothemcp/url"

}

}

Po skonfigurowaniu agent AI będzie mógł korzystać z MCP jako narzędzia ze wszystkimi jego funkcjami i możliwościami. Pamiętaj, aby zamienić “deepseek-thinker” na faktyczną nazwę swojego serwera MCP i ustawić poprawny URL.

| Sekcja | Dostępność | Szczegóły/Uwagi |

|---|---|---|

| Przegląd | ✅ | |

| Lista promptów | ⛔ | Brak udokumentowanych szablonów promptów |

| Lista zasobów | ⛔ | Brak jawnych zasobów MCP |

| Lista narzędzi | ✅ | Narzędzie get-deepseek-thinker |

| Bezpieczeństwo kluczy API | ✅ | Zmienne środowiskowe w konfiguracji |

| Wsparcie dla sampling (mniej istotne w ocenie) | ⛔ | Nie wspomniano |

Na podstawie poniższych dwóch tabel Deepseek Thinker MCP Server zapewnia wyspecjalizowane narzędzie do integracji rozumowania, jest łatwy w konfiguracji, ale brakuje mu szczegółowych szablonów promptów i jawnych definicji zasobów. Projekt jest open source, ma umiarkowaną popularność i wspiera bezpieczne zarządzanie poświadczeniami. Otrzymuje 6/10 za kompletność i użyteczność jako serwer MCP.

| Czy posiada LICENSE | ⛔ (Nie wykryto pliku LICENSE) |

|---|---|

| Czy posiada narzędzie | ✅ |

| Liczba forków | 12 |

| Liczba gwiazdek | 51 |

To serwer Model Context Protocol, który wprowadza rozumowanie modelu Deepseek do klientów AI obsługujących MCP, oferując łańcuchy myślowe i transparentne myślenie modelu dla zaawansowanych przepływów pracy AI i debugowania.

Udostępnia narzędzie 'get-deepseek-thinker' do wykonywania rozumowania przy użyciu modelu Deepseek i zwrotu uporządkowanych wyników rozumowania.

Tak, Deepseek Thinker obsługuje zarówno inferencję w chmurze, jak i lokalnie (Ollama). Aby uruchomić tryb lokalny, ustaw zmienną środowiskową 'USE_OLLAMA' na 'true'.

Klucze API i wartości wrażliwe powinny być przechowywane w sekcji 'env' konfiguracji serwera MCP jako zmienne środowiskowe, a nie zakodowane na stałe w plikach źródłowych.

Limity są określane przez bazowy model Deepseek lub API; przekroczenie ich może spowodować obcięcie odpowiedzi lub błędy, więc odpowiednio dostosuj konfigurację i wejścia.

Obecna dokumentacja Deepseek Thinker MCP Server nie zawiera jawnych szablonów promptów ani dodatkowych zasobów MCP.

Zintegruj Deepseek Thinker MCP Server, aby wyposażyć agentów AI w szczegółowe możliwości rozumowania i usprawnić przepływy pracy deweloperskiej.

Serwer DeepSeek MCP działa jako bezpieczny proxy, łącząc zaawansowane modele językowe DeepSeek z aplikacjami kompatybilnymi z MCP, takimi jak Claude Desktop czy...

Serwer DeepSeek MCP integruje zaawansowane modele językowe DeepSeek z aplikacjami zgodnymi z MCP, zapewniając bezpieczny, zanonimizowany dostęp do API i umożliw...

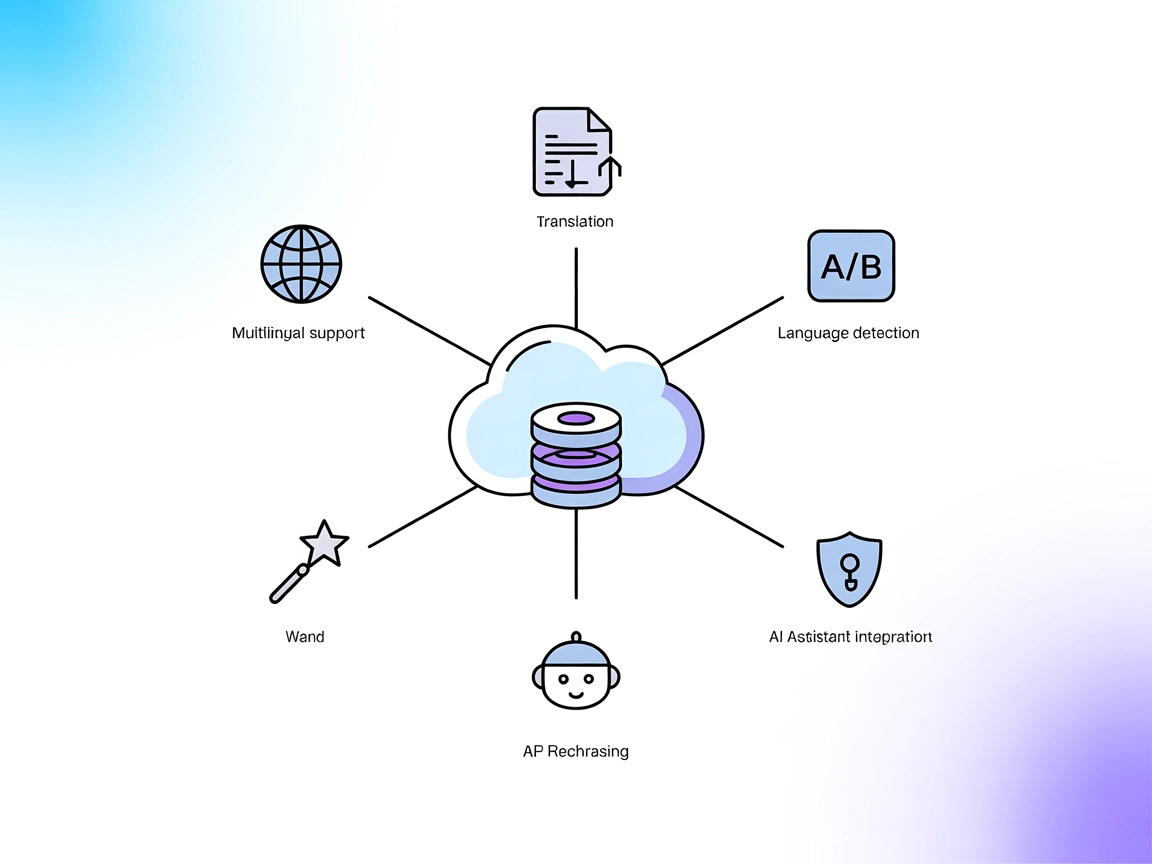

DeepL MCP Server integruje zaawansowane tłumaczenie, parafrazowanie oraz wykrywanie języków w przepływach pracy AI za pomocą API DeepL. Umożliwia FlowHunt i inn...

Zgoda na Pliki Cookie

Używamy plików cookie, aby poprawić jakość przeglądania i analizować nasz ruch. See our privacy policy.