Serwer Model Context Protocol (MCP)

Serwer Model Context Protocol (MCP) łączy asystentów AI z zewnętrznymi źródłami danych, API i usługami, umożliwiając płynną integrację złożonych przepływów prac...

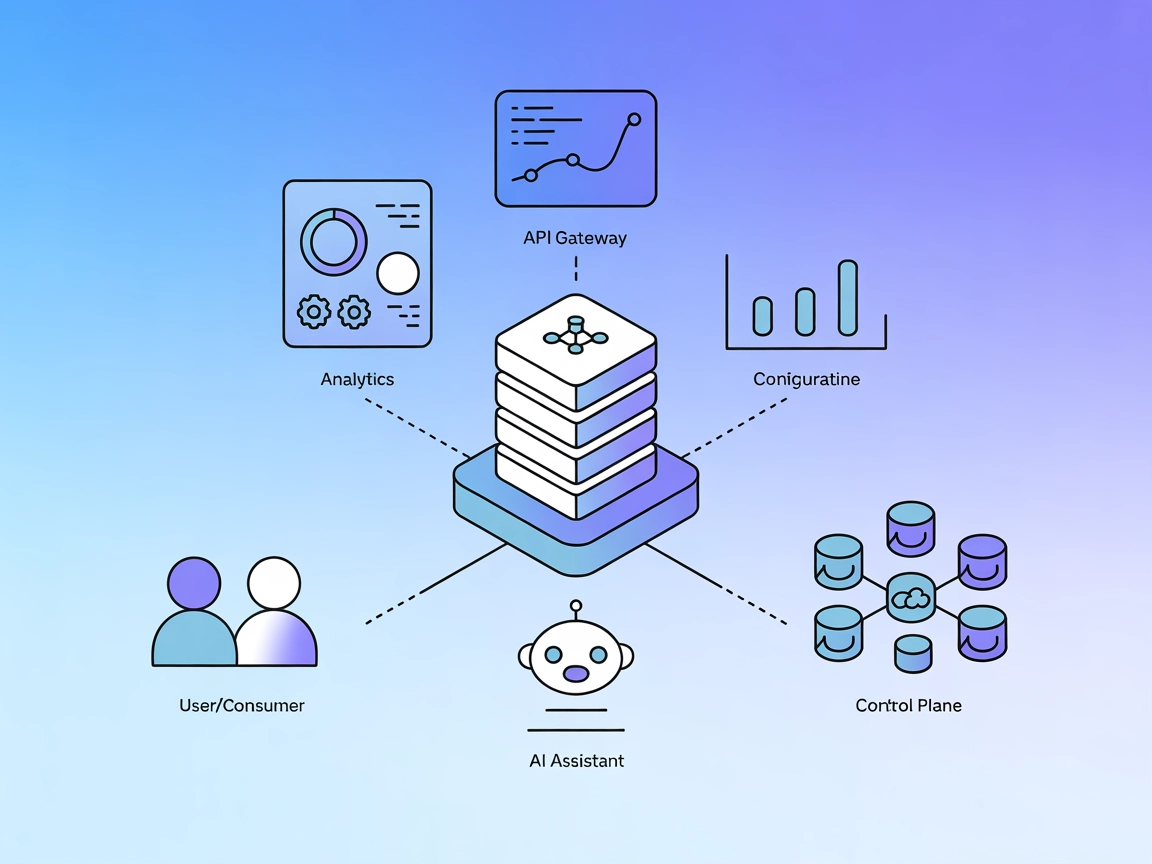

Połącz swoje przepływy pracy AI z API Gateway Kong Konnect, aby uzyskać analitykę w czasie rzeczywistym, audyt konfiguracji i zarządzanie płaszczyzną kontrolną przy użyciu serwera Kong Konnect MCP.

FlowHunt zapewnia dodatkową warstwę bezpieczeństwa między Twoimi systemami wewnętrznymi a narzędziami AI, dając Ci szczegółową kontrolę nad tym, które narzędzia są dostępne z Twoich serwerów MCP. Serwery MCP hostowane w naszej infrastrukturze można bezproblemowo zintegrować z chatbotem FlowHunt oraz popularnymi platformami AI, takimi jak ChatGPT, Claude i różne edytory AI.

Serwer Kong Konnect MCP to serwer Model Context Protocol (MCP), który umożliwia asystentom AI, takim jak Claude, bezpośrednią interakcję z API Gateway Kong Konnect. Ten serwer działa jako pomost, umożliwiając narzędziom opartym na AI zapytania i analizę konfiguracji gateway, ruchu oraz analityki za pomocą języka naturalnego. Programiści mogą za jego pomocą pobierać dane analityczne, przeglądać konfiguracje API gateway oraz zarządzać płaszczyznami kontrolnymi – wszystko za pośrednictwem standaryzowanych narzędzi MCP. Dzięki integracji zewnętrznych źródeł danych, takich jak API Kong Konnect, z przepływami pracy AI, ten serwer MCP usprawnia zadania takie jak monitorowanie ruchu, audyt konfiguracji czy zarządzanie usługami API, podnosząc efektywność i inteligencję pracy deweloperskiej i operacyjnej.

Zapytania o żądania API

Zapytuj i analizuj żądania do Kong API Gateway z możliwością filtrowania m.in. po zakresie czasu, kodach statusu, metodach HTTP, ID konsumenta i innych.

Pobierz żądania konsumenta

Analizuj żądania API wykonane przez konkretnego konsumenta, filtrowane według ID konsumenta i zakresu czasu.

Analityka i raportowanie API

Programiści oraz zespoły operacyjne mogą korzystać z serwera do pobierania szczegółowych danych analitycznych dotyczących żądań API, z możliwością filtrowania po kodach statusu, metodach, konsumentach, usługach i innych dla kompleksowego monitoringu.

Analiza zachowań konsumentów

Analizuj żądania i zachowania poszczególnych konsumentów, co pomaga w obsłudze, rozliczeniach lub audytach bezpieczeństwa.

Audyt konfiguracji gateway

Wypisz i sprawdzaj usługi, trasy, konsumentów i wtyczki, aby audytować i weryfikować konfiguracje API gateway.

Zarządzanie płaszczyzną kontrolną

Zarządzaj i przeglądaj płaszczyzny kontrolne oraz ich grupy, upraszczając administrację rozproszonymi bramkami API.

Operacje wspierane przez AI

Umożliwiaj asystentom AI wykonywanie zapytań i diagnostyki w czasie rzeczywistym na infrastrukturze API, zmniejszając ręczną pracę i przyspieszając reakcję na incydenty.

git clone https://github.com/Kong/mcp-konnect.git

cd mcp-konnect

npm install

npm run build

export KONNECT_ACCESS_TOKEN=twoj_api_key

export KONNECT_REGION=us

windsurf.json):{

"mcpServers": {

"kong-konnect": {

"command": "npx",

"args": ["@kong/mcp-konnect@latest"],

"env": {

"KONNECT_ACCESS_TOKEN": "${KONNECT_ACCESS_TOKEN}",

"KONNECT_REGION": "us"

}

}

}

}

{

"mcpServers": {

"kong-konnect": {

"command": "npx",

"args": ["@kong/mcp-konnect@latest"],

"env": {

"KONNECT_ACCESS_TOKEN": "${KONNECT_ACCESS_TOKEN}",

"KONNECT_REGION": "us"

}

}

}

}

{

"mcpServers": {

"kong-konnect": {

"command": "npx",

"args": ["@kong/mcp-konnect@latest"],

"env": {

"KONNECT_ACCESS_TOKEN": "${KONNECT_ACCESS_TOKEN}",

"KONNECT_REGION": "us"

}

}

}

}

{

"mcpServers": {

"kong-konnect": {

"command": "npx",

"args": ["@kong/mcp-konnect@latest"],

"env": {

"KONNECT_ACCESS_TOKEN": "${KONNECT_ACCESS_TOKEN}",

"KONNECT_REGION": "us"

}

}

}

}

Uwaga:

Zawsze zabezpieczaj klucze API, korzystając ze zmiennych środowiskowych. Przykład:

{

"mcpServers": {

"kong-konnect": {

"command": "npx",

"args": ["@kong/mcp-konnect@latest"],

"env": {

"KONNECT_ACCESS_TOKEN": "${KONNECT_ACCESS_TOKEN}",

"KONNECT_REGION": "us"

},

"inputs": {

"KONNECT_ACCESS_TOKEN": "env:KONNECT_ACCESS_TOKEN"

}

}

}

}

Użycie MCP w FlowHunt

Aby zintegrować serwery MCP z przepływem pracy FlowHunt, zacznij od dodania komponentu MCP do swojego przepływu i połącz go z agentem AI:

Kliknij komponent MCP, aby otworzyć panel konfiguracji. W sekcji konfiguracji systemu MCP wstaw dane swojego serwera MCP w tym formacie JSON:

{

"kong-konnect": {

"transport": "streamable_http",

"url": "https://yourmcpserver.example/pathtothemcp/url"

}

}

Po skonfigurowaniu agent AI może już korzystać z tego MCP jako narzędzia ze wszystkimi jego funkcjami i możliwościami. Pamiętaj, aby zmienić “kong-konnect” na faktyczną nazwę swojego serwera MCP i podać własny adres URL serwera MCP.

| Sekcja | Dostępność | Szczegóły/Uwagi |

|---|---|---|

| Przegląd | ✅ | Zawarty w README |

| Lista promptów | ⛔ | Brak udokumentowanych promptów |

| Lista zasobów | ⛔ | Brak udokumentowanych zasobów |

| Lista narzędzi | ✅ | Narzędzia analityczne i konfiguracyjne podsumowane w README |

| Zabezpieczanie kluczy API | ✅ | Użycie zmiennych środowiskowych opisane |

| Obsługa samplowania (mniej istotne w ocenie) | ⛔ | Nie wspomniano |

Na podstawie powyższego, serwer Kong Konnect MCP jest projektem w toku, ale już udostępnia odpowiednie narzędzia do analityki i konfiguracji. Brakuje jednak dokumentacji zasobów i promptów oraz informacji o obsłudze roots czy samplowania. Projekt jest open source, dość aktywny i ma przejrzyste instrukcje konfiguracji.

Serwer Kong Konnect MCP dobrze integruje się z przepływami AI do operacji i analityki API. Brak dokumentacji promptów i zasobów oraz brak wzmianki o roots czy samplowaniu ogranicza jednak jego kompletność. Mimo to jest funkcjonalnym i wartościowym MCP w swojej dziedzinie.

Ocena: 6/10

| Posiada LICENCJĘ | ✅ (Apache-2.0) |

|---|---|

| Posiada przynajmniej jedno narzędzie | ✅ |

| Liczba forków | 11 |

| Liczba gwiazdek | 30 |

Serwer Kong Konnect MCP umożliwia asystentom AI bezpośrednią interakcję z API Gateway Kong Konnect, pozwalając na analitykę w czasie rzeczywistym, audyty konfiguracji i zarządzanie płaszczyzną kontrolną poprzez zapytania w języku naturalnym.

Kluczowe zastosowania to analityka i raportowanie API, analiza zachowań konsumentów, audyt konfiguracji gateway, zarządzanie płaszczyzną kontrolną oraz umożliwienie operacji DevOps opartych o AI.

Przechowuj swój klucz API Kong Konnect w zmiennych środowiskowych (np. KONNECT_ACCESS_TOKEN) w konfiguracji, aby zachować bezpieczeństwo danych uwierzytelniających.

Dodaj komponent MCP w swoim przepływie FlowHunt, otwórz jego konfigurację i podaj dane serwera w formacie JSON. Pozwala to agentowi AI na dostęp do wszystkich funkcji MCP.

Tak, jest open-source na licencji Apache-2.0.

Daj swoim agentom AI możliwość wykonywania analityki API, zarządzania konfiguracją oraz diagnostyki w czasie rzeczywistym na Kong Konnect dzięki integracji z MCP Server.

Serwer Model Context Protocol (MCP) łączy asystentów AI z zewnętrznymi źródłami danych, API i usługami, umożliwiając płynną integrację złożonych przepływów prac...

Serwer Confluent MCP umożliwia asystentom AI interakcję z API Confluent Cloud, pozwalając na zarządzanie tematami Kafka, konektorami i zadaniami Flink SQL w nat...

Serwer Consul MCP łączy asystentów AI i narzędzia deweloperskie z potężnymi API HashiCorp Consul do wykrywania usług, sprawdzania stanu i przechowywania klucz-w...

Zgoda na Pliki Cookie

Używamy plików cookie, aby poprawić jakość przeglądania i analizować nasz ruch. See our privacy policy.