DeepL MCP Server

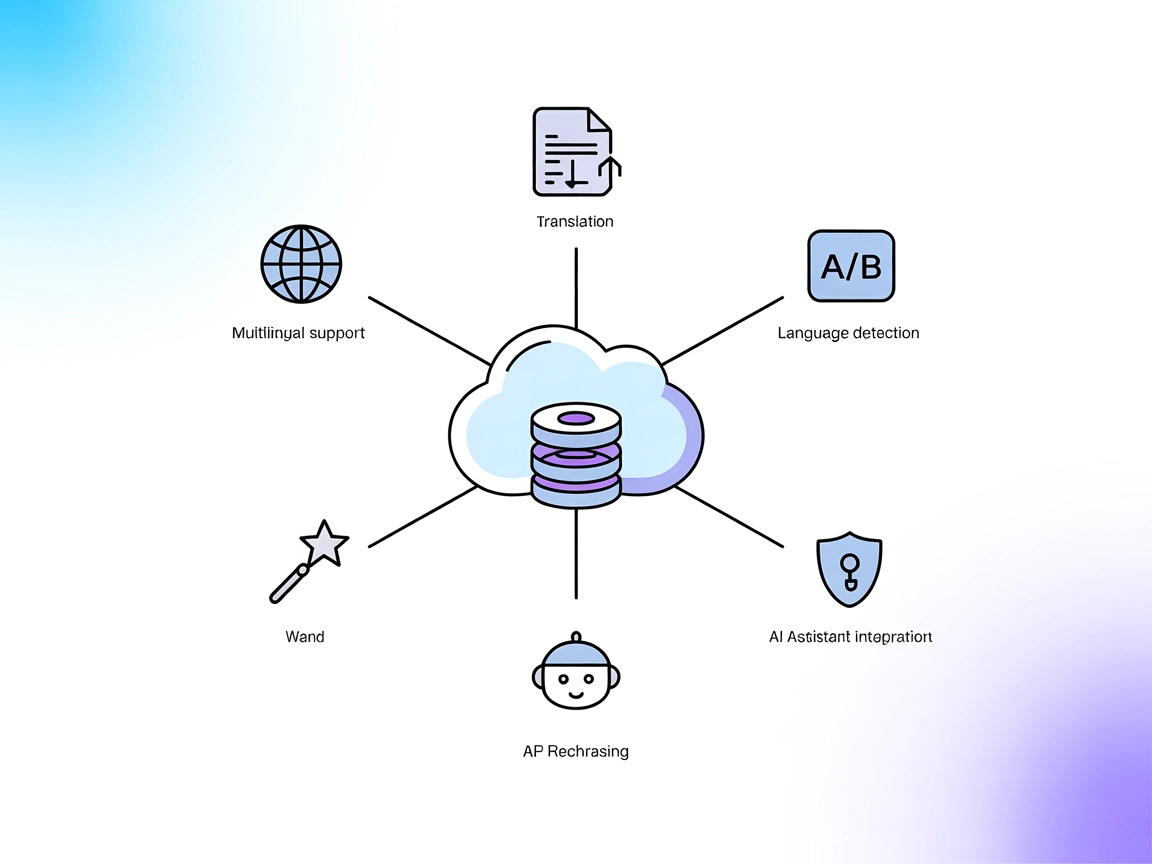

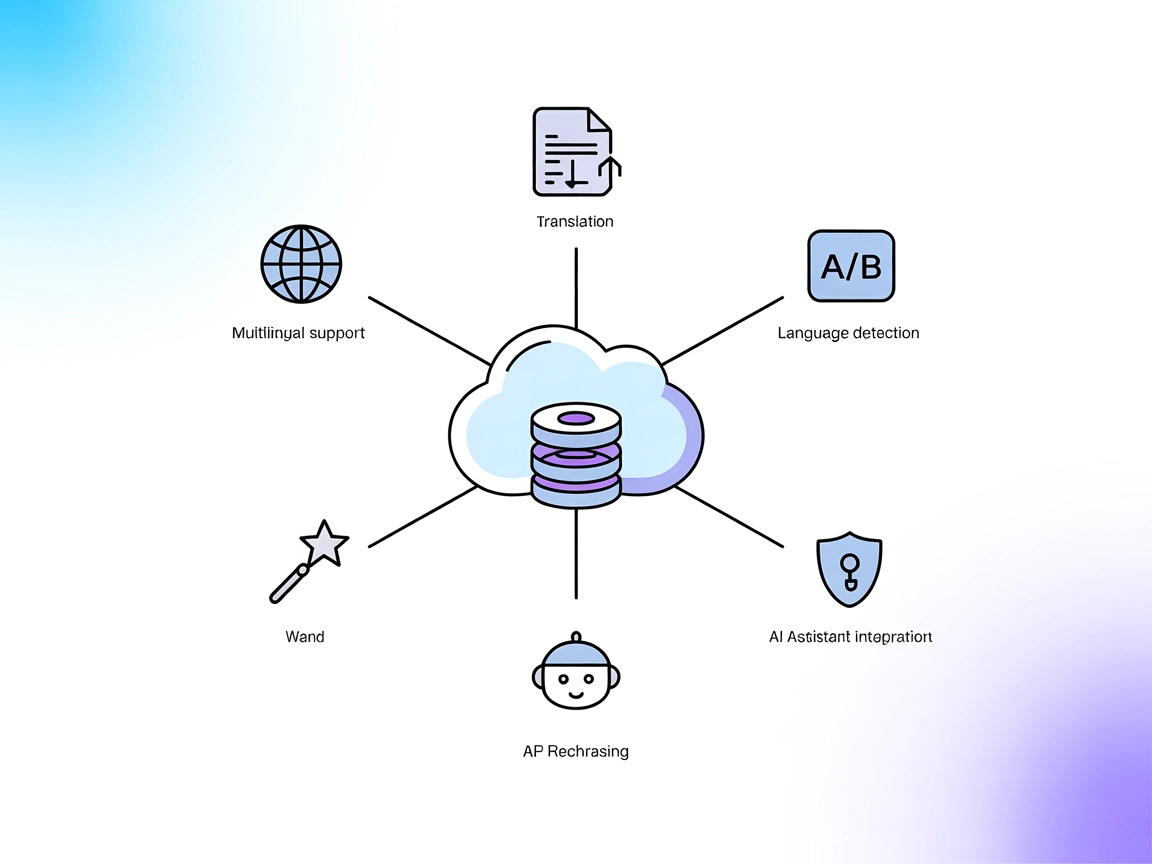

DeepL MCP Server integruje zaawansowane tłumaczenie, parafrazowanie oraz wykrywanie języków w przepływach pracy AI za pomocą API DeepL. Umożliwia FlowHunt i inn...

Połącz swoich agentów AI z zewnętrznymi API i zasobami za pomocą lingo.dev MCP Server, usprawniając dostęp i standaryzując interakcje w FlowHunt.

FlowHunt zapewnia dodatkową warstwę bezpieczeństwa między Twoimi systemami wewnętrznymi a narzędziami AI, dając Ci szczegółową kontrolę nad tym, które narzędzia są dostępne z Twoich serwerów MCP. Serwery MCP hostowane w naszej infrastrukturze można bezproblemowo zintegrować z chatbotem FlowHunt oraz popularnymi platformami AI, takimi jak ChatGPT, Claude i różne edytory AI.

lingo.dev MCP (Model Context Protocol) Server działa jako most między asystentami AI a szerokim zakresem zewnętrznych źródeł danych, API i usług. Dzięki udostępnianiu strukturalnych zasobów, szablonów promptów i wykonywalnych narzędzi, umożliwia modelom AI wykonywanie zaawansowanych zadań, takich jak zapytania do baz danych, zarządzanie plikami czy interakcje z API. Serwer ten usprawnia przepływy pracy deweloperów, ułatwiając standaryzację i współdzielenie typowych interakcji LLM (Large Language Model), upraszczając wszystko od eksploracji kodu po pobieranie danych w czasie rzeczywistym w środowiskach opartych na AI.

Użycie MCP w FlowHunt

Aby zintegrować serwery MCP ze swoim przepływem w FlowHunt, rozpocznij od dodania komponentu MCP do swojego przepływu i połączenia go z agentem AI:

Kliknij na komponent MCP, aby otworzyć panel konfiguracji. W sekcji konfiguracji systemu MCP wklej dane swojego serwera MCP używając tego formatu JSON:

{

"MCP-name": {

"transport": "streamable_http",

"url": "https://yourmcpserver.example/pathtothemcp/url"

}

}

Po skonfigurowaniu agent AI może już korzystać z tego MCP jako narzędzia z dostępem do wszystkich jego funkcji i możliwości. Pamiętaj, aby zamienić “MCP-name” na faktyczną nazwę swojego serwera MCP (np. “github-mcp”, “weather-api” itp.) oraz podać własny URL serwera MCP.

| Sekcja | Dostępność | Szczegóły/Uwagi |

|---|---|---|

| Przegląd | ✅ | |

| Lista promptów | ⛔ | |

| Lista zasobów | ⛔ | |

| Lista narzędzi | ⛔ | |

| Zabezpieczenie kluczy API | ⛔ | |

| Wsparcie próbkowania (mniej istotne w ocenie) | ⛔ |

Wśród dostępnych i brakujących informacji, ta dokumentacja MCP zawiera jedynie bardzo skrócony przegląd, bez szczegółów technicznych, promptów, narzędzi czy zasobów.

Na podstawie dostępnych informacji w przekazanym pliku, dokumentacja repozytorium lingo.dev MCP jest minimalna i brakuje jej praktycznej oraz technicznej treści, która pozwoliłaby deweloperom szybko zrozumieć, skonfigurować lub wykorzystać serwer MCP. Przydatność tej dokumentacji oceniamy dość nisko.

| Posiada LICENSE | |

|---|---|

| Ma przynajmniej jedno narzędzie | |

| Liczba Forków | |

| Liczba Gwiazdek |

lingo.dev MCP Server działa jako most między asystentami AI a zewnętrznymi źródłami danych, API i usługami, udostępniając strukturalne zasoby i narzędzia dla zaawansowanych przepływów pracy LLM.

Dodaj komponent MCP do swojego przepływu w FlowHunt, otwórz panel konfiguracji i wprowadź dane swojego serwera MCP w sekcji konfiguracji systemu MCP, używając odpowiedniego formatu JSON.

Typowe zastosowania obejmują zapytania do baz danych, zarządzanie plikami i interakcję z API w środowiskach opartych na AI, usprawniając i standaryzując przepływy pracy deweloperów.

Nie, obecna dokumentacja jest minimalna i nie zawiera treści technicznych, takich jak prompt, lista narzędzi czy zasobów.

Zastosuj najlepsze praktyki zarządzania zmiennymi środowiskowymi, aby przechowywać poufne informacje w bezpieczny sposób, ponieważ dostarczona dokumentacja tego nie obejmuje.

Zwiększ możliwości swojego agenta AI, łącząc go z zewnętrznymi zasobami i API za pomocą lingo.dev MCP Server w środowisku FlowHunt.

DeepL MCP Server integruje zaawansowane tłumaczenie, parafrazowanie oraz wykrywanie języków w przepływach pracy AI za pomocą API DeepL. Umożliwia FlowHunt i inn...

Serwer Patronus MCP usprawnia ocenę i eksperymentowanie z LLM dla deweloperów i badaczy, zapewniając automatyzację, przetwarzanie wsadowe i solidną infrastruktu...

Zintegruj zaawansowane funkcje orkiestracji MLOps i LLMOps ZenML w przepływach swojego asystenta AI za pomocą ZenML MCP Server. Umożliwiaj zarządzanie pipeline’...

Zgoda na Pliki Cookie

Używamy plików cookie, aby poprawić jakość przeglądania i analizować nasz ruch. See our privacy policy.