OpenAPI Schema Explorer MCP Server

Serwer OpenAPI Schema Explorer MCP umożliwia wydajny, strukturalny dostęp do specyfikacji OpenAPI/Swagger jako zasobów MCP, łącząc asystentów AI i deweloperów z...

Udostępniaj i przeszukuj schematy OpenAPI dzięki LLM. Natychmiast wyświetlaj endpointy, pobieraj schematy i usprawniaj procesy API z OpenAPI Schema MCP Server.

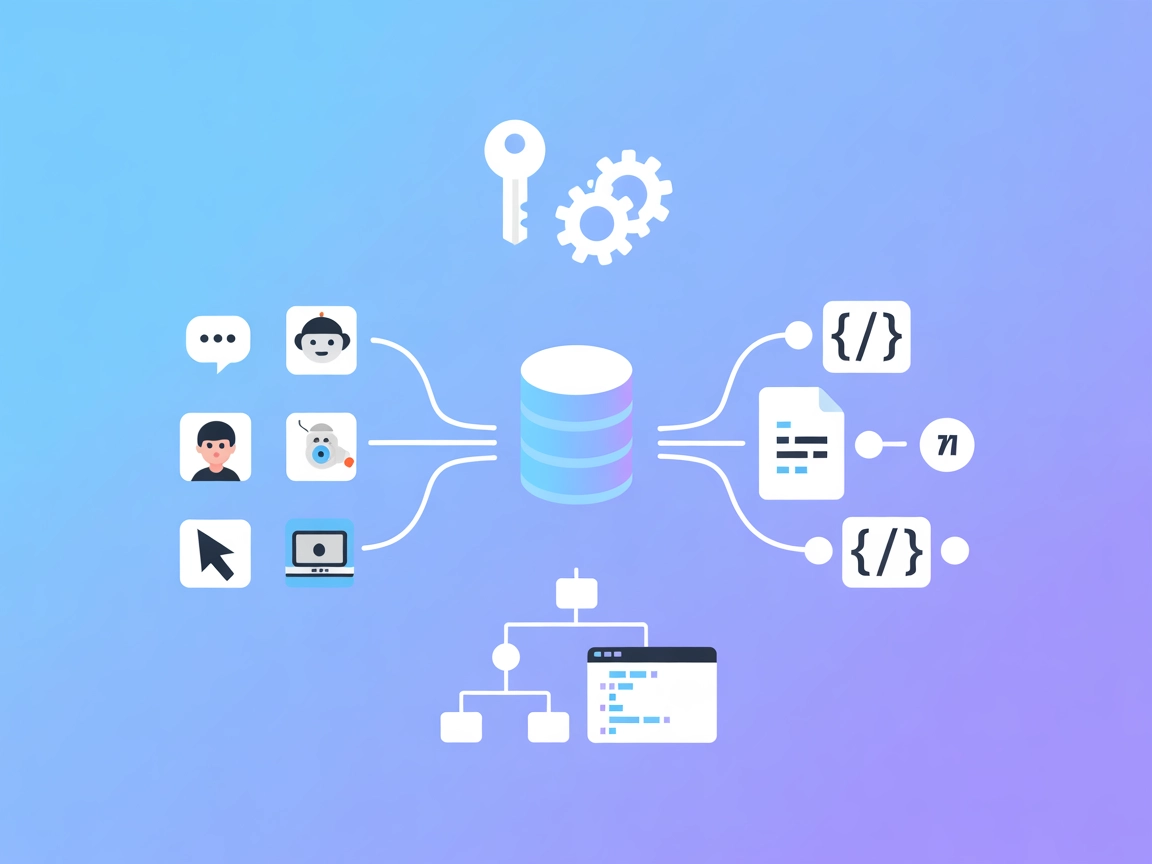

FlowHunt zapewnia dodatkową warstwę bezpieczeństwa między Twoimi systemami wewnętrznymi a narzędziami AI, dając Ci szczegółową kontrolę nad tym, które narzędzia są dostępne z Twoich serwerów MCP. Serwery MCP hostowane w naszej infrastrukturze można bezproblemowo zintegrować z chatbotem FlowHunt oraz popularnymi platformami AI, takimi jak ChatGPT, Claude i różne edytory AI.

OpenAPI Schema MCP Server to serwer Model Context Protocol (MCP) zaprojektowany do udostępniania informacji o schemacie OpenAPI dużym modelom językowym (LLM), takim jak Claude. Dzięki strukturalnemu dostępowi do specyfikacji OpenAPI serwer umożliwia asystentom AI eksplorację i zrozumienie API, w tym ich endpointów, parametrów, schematów żądań i odpowiedzi oraz wielu innych elementów. To pozwala deweloperom i narzędziom AI zapytywać struktury API, przeszukiwać specyfikacje oraz pobierać szczegółowe definicje schematów, co usprawnia pracę z integracją API, dokumentacją i generowaniem kodu. Serwer obsługuje ładowanie plików OpenAPI w formacie JSON lub YAML oraz zwraca wyniki w YAML dla lepszej czytelności przez LLM.

W repozytorium nie udokumentowano jawnych szablonów promptów.

W repozytorium nie opisano jawnych zasobów.

Serwer OpenAPI Schema MCP udostępnia następujące narzędzia dla LLM:

Nie podano instrukcji konfiguracji dla Windsurf.

npx są zainstalowane.~/Library/Application Support/Claude/claude_desktop_config.json$env:AppData\Claude\claude_desktop_config.jsonmcpServers:{

"mcpServers": {

"OpenAPI Schema": {

"command": "npx",

"args": ["-y", "mcp-openapi-schema", "/ABSOLUTE/PATH/TO/openapi.yaml"]

}

}

}

Nie podano instrukcji konfiguracji dla Cursor.

npx są zainstalowane.claude mcp add openapi-schema npx -y mcp-openapi-schema

claude mcp add petstore-api npx -y mcp-openapi-schema ~/Projects/petstore.yaml

claude mcp list

claude mcp get openapi-schema

claude mcp remove openapi-schema

Nie podano informacji o zabezpieczaniu kluczy API ani korzystaniu ze zmiennych środowiskowych.

Użycie MCP w FlowHunt

Aby zintegrować serwery MCP w swoim przepływie FlowHunt, rozpocznij od dodania komponentu MCP do przepływu i połączenia go z agentem AI:

Kliknij komponent MCP, aby otworzyć panel konfiguracji. W sekcji konfiguracji systemu MCP wklej szczegóły serwera MCP w tym formacie JSON:

{

"MCP-name": {

"transport": "streamable_http",

"url": "https://yourmcpserver.example/pathtothemcp/url"

}

}

Po skonfigurowaniu agent AI może korzystać z tego MCP jako narzędzia z dostępem do wszystkich jego funkcji i możliwości. Pamiętaj, aby zmienić “MCP-name” na rzeczywistą nazwę swojego serwera MCP (np. “github-mcp”, “weather-api” itd.) oraz zastąpić URL własnym adresem serwera MCP.

| Sekcja | Dostępność | Szczegóły/Uwagi |

|---|---|---|

| Przegląd | ✅ | |

| Lista promptów | ⛔ | Brak udokumentowanych szablonów promptów |

| Lista zasobów | ⛔ | Brak jawnie opisanych zasobów |

| Lista narzędzi | ✅ | 10 udokumentowanych narzędzi do schematów API |

| Zabezpieczanie kluczy API | ⛔ | Nie wspomniano |

| Wsparcie próbkowania (mniej istotne) | ⛔ | Nie wspomniano |

Na podstawie dostępnej dokumentacji, serwer OpenAPI Schema MCP jest mocno wyspecjalizowany do eksploracji OpenAPI przez LLM, oferując rozbudowany zestaw narzędzi, ale brakuje mu dokumentacji promptów, zasobów, obsługi kluczy API oraz zaawansowanych funkcji MCP. W zastosowaniach OpenAPI jest solidny; w zakresie szerszych funkcji MCP – ograniczony.

| Posiada LICENCJĘ | ⛔ |

|---|---|

| Ma przynajmniej jedno narzędzie | ✅ |

| Liczba Forków | 9 |

| Liczba Gwiazdek | 30 |

Ocena:

Oceniam ten serwer MCP na 6/10. Choć jest dobrze zdefiniowany pod kątem eksploracji schematów OpenAPI i oferuje solidny zestaw narzędzi, brakuje dokumentacji szablonów promptów MCP, jawnych definicji zasobów, dobrych praktyk bezpieczeństwa oraz wsparcia dla roots lub próbkowania. Brak LICENCJI to także poważne ograniczenie dla otwartej współpracy.

To serwer Model Context Protocol, który zapewnia modelom językowym (LLM) strukturalny dostęp do specyfikacji OpenAPI, umożliwiając zaawansowaną eksplorację API, dokumentację i generowanie kodu.

Oferuje narzędzia do wyświetlania endpointów, pobierania schematów endpointów i komponentów, pobierania schematów żądań i odpowiedzi, wyświetlania schematów bezpieczeństwa, wyszukiwania schematów oraz pozyskiwania przykładów — wszystko dostępne programatycznie dla LLM.

Przykłady użycia to eksploracja API, automatyczne generowanie kodu, dokumentacja API, przegląd bezpieczeństwa, wyszukiwanie i analiza schematów, a także wsparcie dla narzędzi do testowania API.

Tak, serwer może ładować pliki OpenAPI zarówno w formacie JSON, jak i YAML oraz zwraca wyniki w YAML dla lepszej czytelności przez LLM.

Nie, bieżąca dokumentacja nie zawiera szablonów promptów ani jawnych definicji zasobów.

Nie, bieżąca dokumentacja nie obejmuje zabezpieczania kluczy API ani korzystania ze zmiennych środowiskowych.

Brakuje szablonów promptów, jawnej dokumentacji zasobów, obsługi kluczy API, wsparcia próbkowania i nie określono licencji, co ogranicza otwartą współpracę.

Umożliw swoim agentom AI programatyczne rozumienie, dokumentowanie i testowanie API. Zintegruj OpenAPI Schema MCP Server w swoich przepływach, aby uzyskać płynny dostęp i automatyzację API.

Serwer OpenAPI Schema Explorer MCP umożliwia wydajny, strukturalny dostęp do specyfikacji OpenAPI/Swagger jako zasobów MCP, łącząc asystentów AI i deweloperów z...

OpenAPI MCP Server łączy asystentów AI z możliwością eksploracji i zrozumienia specyfikacji OpenAPI, oferując szczegółowy kontekst API, podsumowania i informacj...

Serwer GraphQL Schema MCP umożliwia asystentom AI i programistom eksplorację, analizę i dokumentowanie schematów GraphQL w sposób programowy. Dzięki zestawowi s...

Zgoda na Pliki Cookie

Używamy plików cookie, aby poprawić jakość przeglądania i analizować nasz ruch. See our privacy policy.