Dappier MCP Server

Dappier MCP Server łączy asystentów AI z wyszukiwarką internetową w czasie rzeczywistym oraz danymi premium od zaufanych marek medialnych, umożliwiając agentom ...

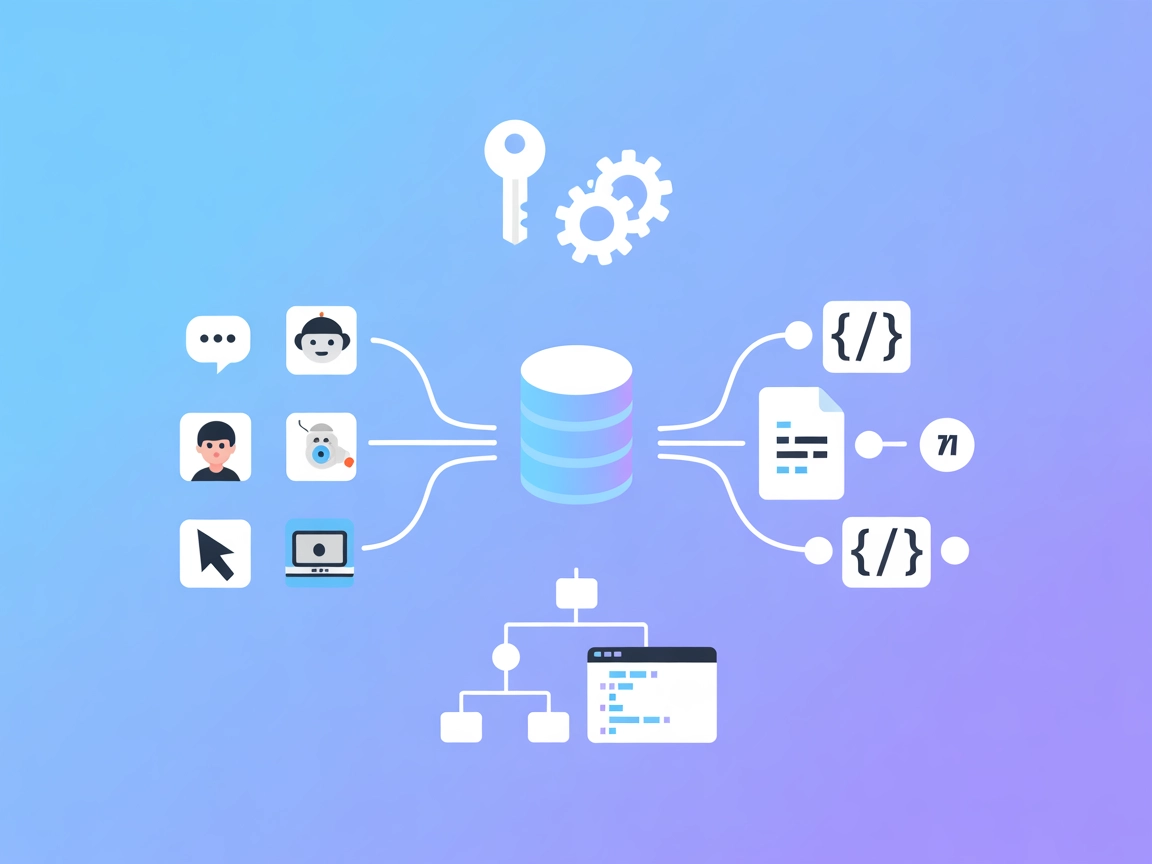

Udostępnij każde API zgodne z OpenAPI jako narzędzia dostępne dla AI Twoich agentów. Tyk Dashboard MCP Server pozwala łatwo automatyzować, testować i zarządzać API w workflow napędzanych LLM.

FlowHunt zapewnia dodatkową warstwę bezpieczeństwa między Twoimi systemami wewnętrznymi a narzędziami AI, dając Ci szczegółową kontrolę nad tym, które narzędzia są dostępne z Twoich serwerów MCP. Serwery MCP hostowane w naszej infrastrukturze można bezproblemowo zintegrować z chatbotem FlowHunt oraz popularnymi platformami AI, takimi jak ChatGPT, Claude i różne edytory AI.

Tyk Dashboard MCP Server to dynamiczne narzędzie zaprojektowane do przekształcania specyfikacji OpenAPI lub Swagger w dostępne serwery MCP (Model Context Protocol). Dzięki temu asystenci AI mogą bezpośrednio komunikować się z REST API, udostępniając endpointy API jako narzędzia usprawniające workflow deweloperskie. Tyk Dashboard MCP Server umożliwia płynną integrację zewnętrznych API z klientami opartymi o AI, zapewniając automatyczne wsparcie dla zapytań, uwierzytelniania oraz obsługi parametrów. Dzięki dynamicznemu ładowaniu, wsparciu nakładek (overlays) i możliwości niestandardowego mapowania, idealnie nadaje się do udostępniania dowolnego REST API agentom napędzanym LLM. Programiści mogą natychmiast udostępnić swoje API do zapytań, zarządzania plikami i innych akcji automatycznych, usprawniając integrację i redukując ręczną pracę.

W repozytorium ani w dokumentacji nie podano informacji o szablonach promptów do wielokrotnego użycia.

W dostępnej dokumentacji ani kodzie nie wymieniono żadnych zasobów MCP wprost.

Nie podano instrukcji konfiguracji dla Windsurf.

~/Library/Application Support/Claude/claude_desktop_config.json%APPDATA%\Claude\claude_desktop_config.json{

"mcpServers": {

"api-tools": {

"command": "npx",

"args": [

"-y",

"@tyktechnologies/api-to-mcp",

"--spec",

"https://petstore3.swagger.io/api/v3/openapi.json"

],

"enabled": true

}

}

}

Brak instrukcji konfiguracji dla Cursor.

Brak instrukcji konfiguracji dla Cline.

Serwer obsługuje przekazywanie niestandardowych nagłówków HTTP przez zmienne środowiskowe i CLI, ale brak jest przykładu zabezpieczenia kluczy API w konfiguracji. Użytkownicy powinni zapewnić ładowanie wrażliwych kluczy przez zmienne środowiskowe w systemie lub konfiguracji wdrożenia.

Przykład (koncepcyjny):

{

"mcpServers": {

"api-tools": {

"env": {

"API_KEY": "your_api_key"

},

"inputs": {

"header": "Authorization: Bearer ${API_KEY}"

}

}

}

}

Uwaga: Dostosuj zgodnie z własnym środowiskiem i polityką bezpieczeństwa.

Użycie MCP w FlowHunt

Aby zintegrować serwery MCP w swoim workflow FlowHunt, rozpocznij od dodania komponentu MCP do flow i podłączenia go do swojego agenta AI:

Kliknij komponent MCP, aby otworzyć panel konfiguracji. W sekcji konfiguracji systemowej MCP wklej dane swojego serwera MCP w tym formacie JSON:

{

"MCP-name": {

"transport": "streamable_http",

"url": "https://yourmcpserver.example/pathtothemcp/url"

}

}

Po zapisaniu konfiguracji agent AI może korzystać z tego MCP jako narzędzia ze wszystkimi jego funkcjami i możliwościami. Pamiętaj, aby zmienić “MCP-name” na faktyczną nazwę swojego serwera MCP (np. “github-mcp”, “weather-api” itp.) oraz podać własny adres URL serwera MCP.

| Sekcja | Dostępność | Szczegóły/Uwagi |

|---|---|---|

| Przegląd | ✅ | Zawarty w README.md i opisie projektu |

| Lista promptów | ⛔ | Nie wspomniano o szablonach promptów |

| Lista zasobów | ⛔ | Brak wymienionych zasobów MCP |

| Lista narzędzi | ✅ | Operacje OpenAPI jako narzędzia |

| Zabezpieczanie kluczy API | ✅ | Obsługa poprzez zmienne środowiskowe i nagłówki, brak szczegółowej dokumentacji |

| Wsparcie sampling-u (mniej istotne w ocenie) | ⛔ | Brak dowodów na wsparcie sampling-u |

Wsparcie dla rootów: Obecność katalogu .roo sugeruje możliwość wsparcia root boundaries, ale nie jest to opisane w dokumentacji.

Na podstawie powyższych tabel, Tyk Dashboard MCP Server oferuje solidny sposób na przekształcenie endpointów OpenAPI w narzędzia dostępne dla AI. Brakuje jednak dokumentacji/przykładów szablonów promptów, jawnych zasobów MCP i szczegółów dla części platform. Wsparcie sampling-u i rootów nie jest jasno opisane. Całościowo ten serwer MCP wypada dobrze pod względem narzędzi i licencjonowania, ale mógłby mieć bogatszą dokumentację i zakres funkcji.

| Dostępna LICENCJA | ✅ (MIT) |

|---|---|

| Co najmniej jedno narzędzie | ✅ |

| Liczba forków | 9 |

| Liczba gwiazdek | 1 |

OCENA: 6/10

Przekształca specyfikacje OpenAPI lub Swagger w serwery MCP, udostępniając endpointy REST API jako narzędzia dla agentów zasilanych AI. Dzięki temu LLM mogą obsługiwać, automatyzować i zarządzać API.

Szczegółowe instrukcje podano dla Claude Desktop. Inne platformy (Windsurf, Cursor, Cline) nie są opisane, ale mogą być obsłużone przez własną konfigurację.

Każda operacja (GET, POST, PUT, DELETE itd.) ze specyfikacji OpenAPI jest dostępna jako narzędzie MCP dla agenta AI, z obsługą parametrów, uwierzytelniania oraz metadanych operacji.

Klucze API powinny być przekazywane przez zmienne środowiskowe i niestandardowe nagłówki w konfiguracji. Dane wrażliwe nie powinny być wpisywane na stałe i należy stosować dobre praktyki bezpieczeństwa.

Integracja API dla asystentów AI, automatyzacja testowania API, szybkie prototypowanie workflow, wewnętrzne narzędzia API oraz tworzenie ustandaryzowanych interfejsów AI-API przy minimalnym nakładzie pracy.

Natychmiast zamień swoje endpointy OpenAPI w narzędzia dostępne dla AI. Przyspiesz automatyzację, testowanie i prototypowanie, łącząc swoje API z asystentami AI FlowHunt.

Dappier MCP Server łączy asystentów AI z wyszukiwarką internetową w czasie rzeczywistym oraz danymi premium od zaufanych marek medialnych, umożliwiając agentom ...

Serwer Model Context Protocol (MCP) łączy asystentów AI z zewnętrznymi źródłami danych, API i usługami, umożliwiając płynną integrację złożonych przepływów prac...

OpenAPI MCP Server łączy asystentów AI z możliwością eksploracji i zrozumienia specyfikacji OpenAPI, oferując szczegółowy kontekst API, podsumowania i informacj...

Zgoda na Pliki Cookie

Używamy plików cookie, aby poprawić jakość przeglądania i analizować nasz ruch. See our privacy policy.